Транскрипция слов примеры русский язык

Содержание

- Примеры фонетического разбора

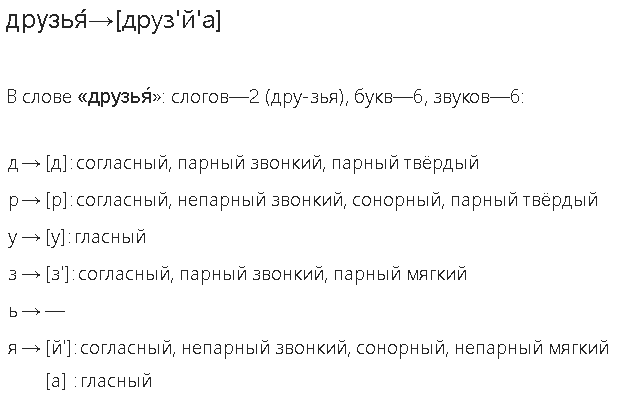

- Йотированная гласная + ь

- Йотированная гласная + чередование согласной

- Сдвоенная согласная — долгий звук

- Сдвоенная согласная — обычный звук

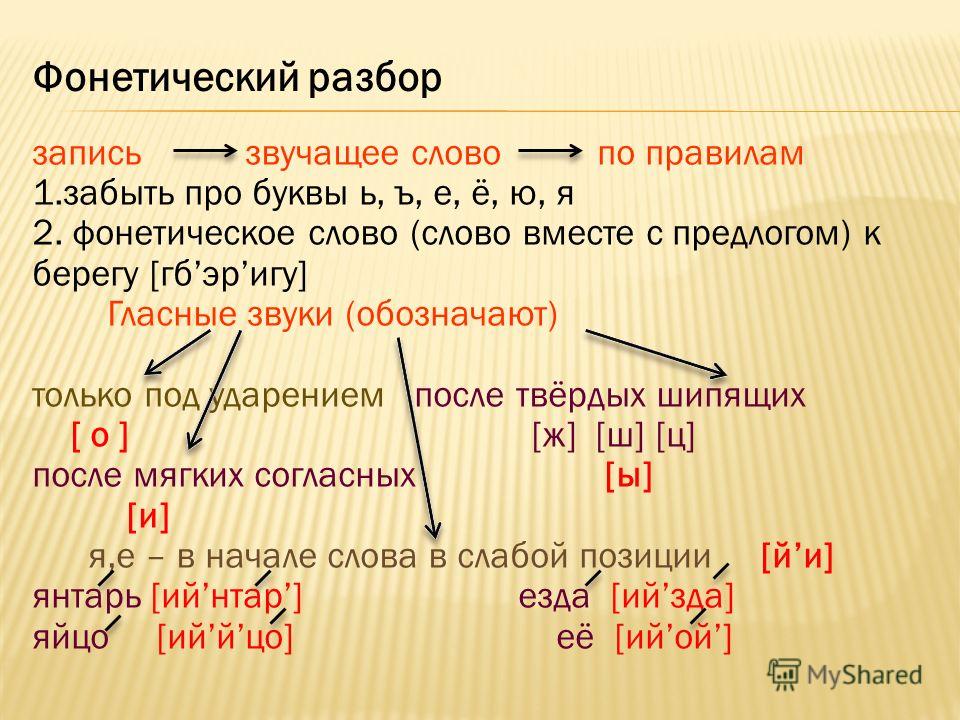

- Фонетическая транскрипция слова

- Транскрипция – что это?

- Зачем нужна транскрипция?

- Частичная транскрипция

- Как записать транскрипцию

- Примеры транскрипции слов

- Что мы узнали?

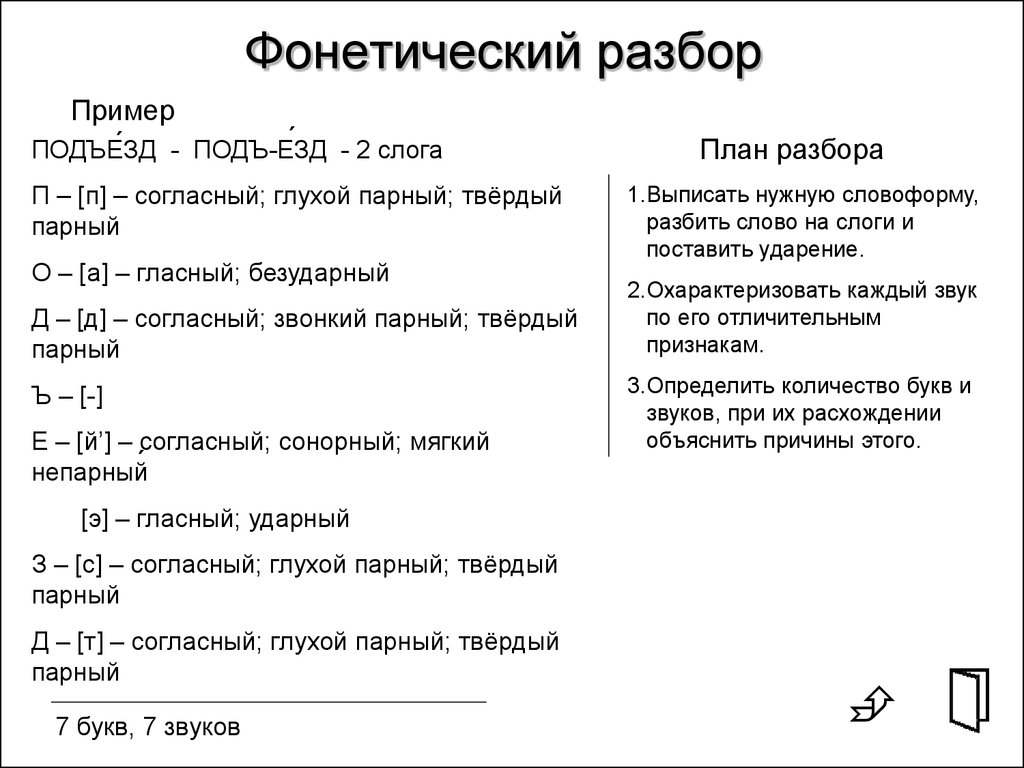

- Транскрипция слова. Фонетический разбор слова

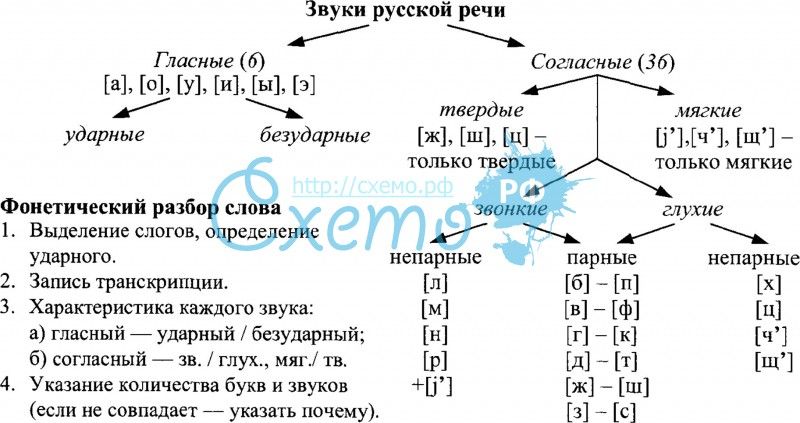

- Основные понятия

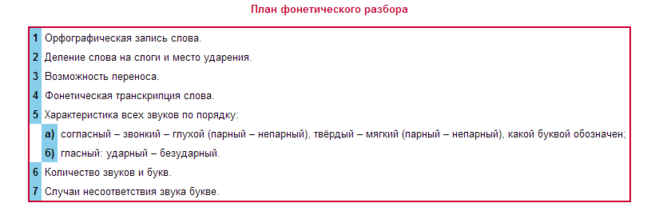

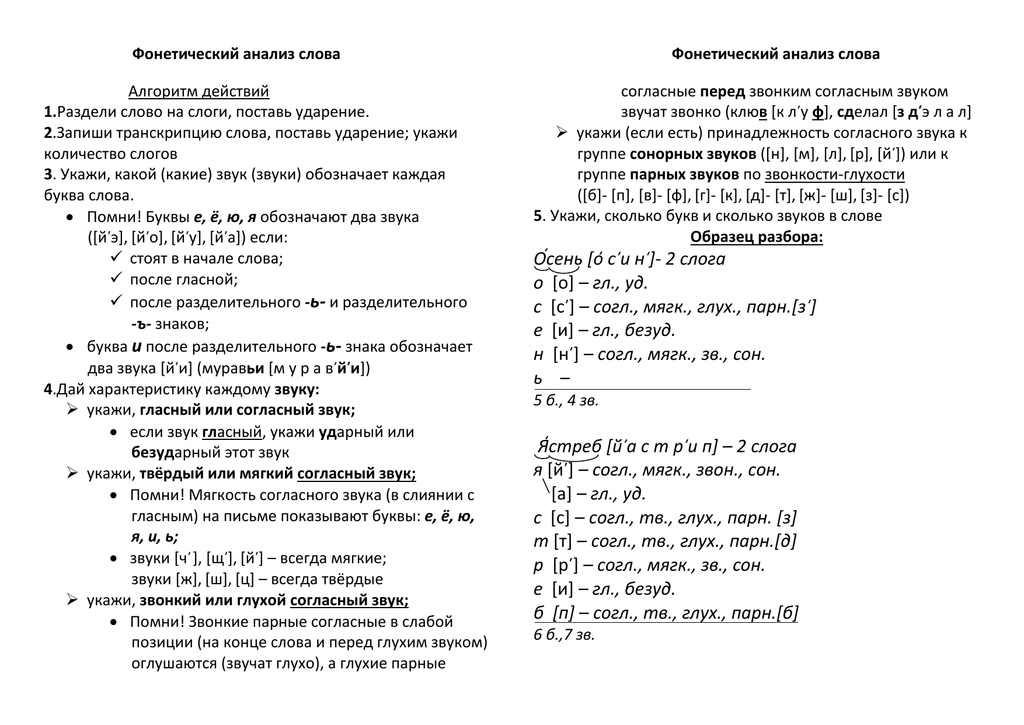

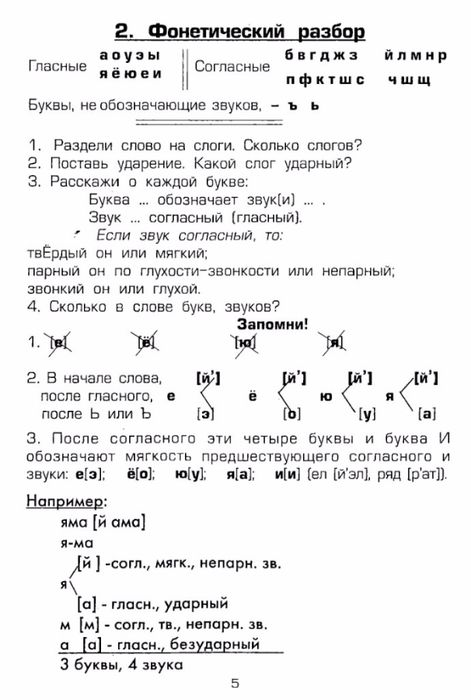

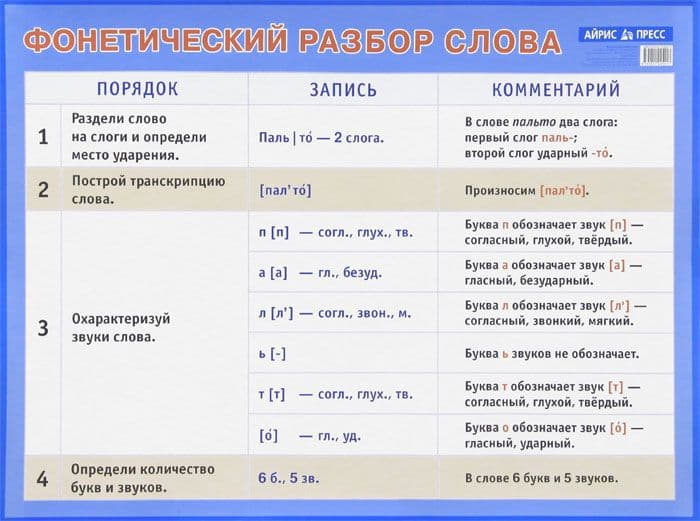

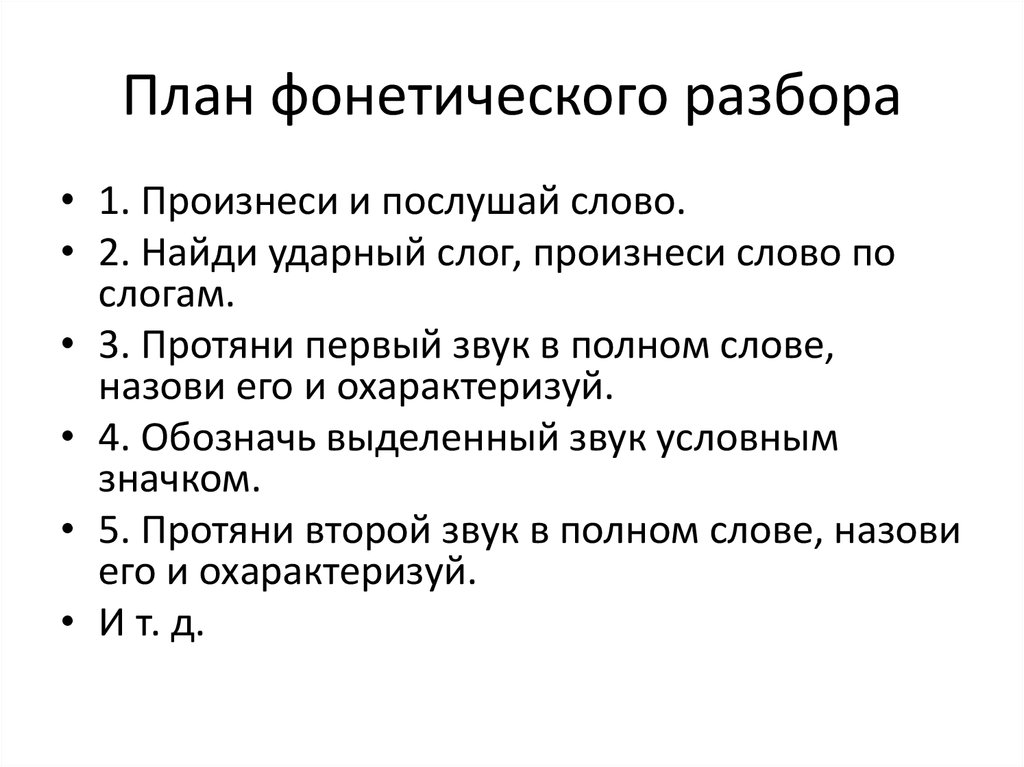

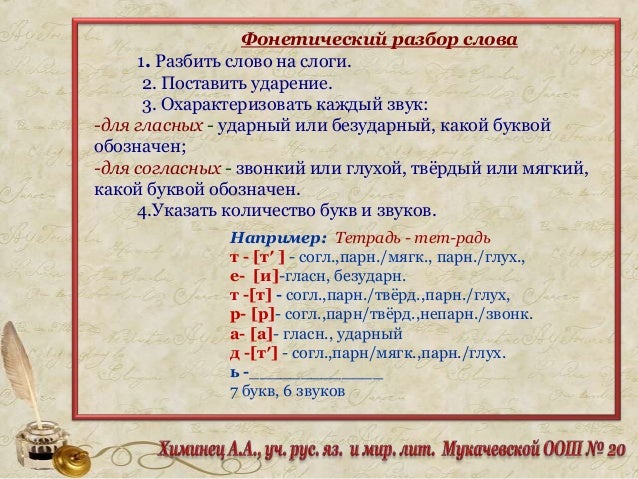

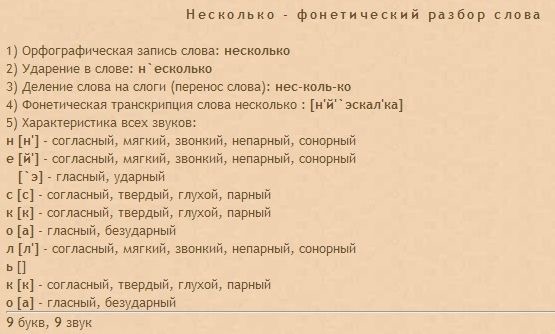

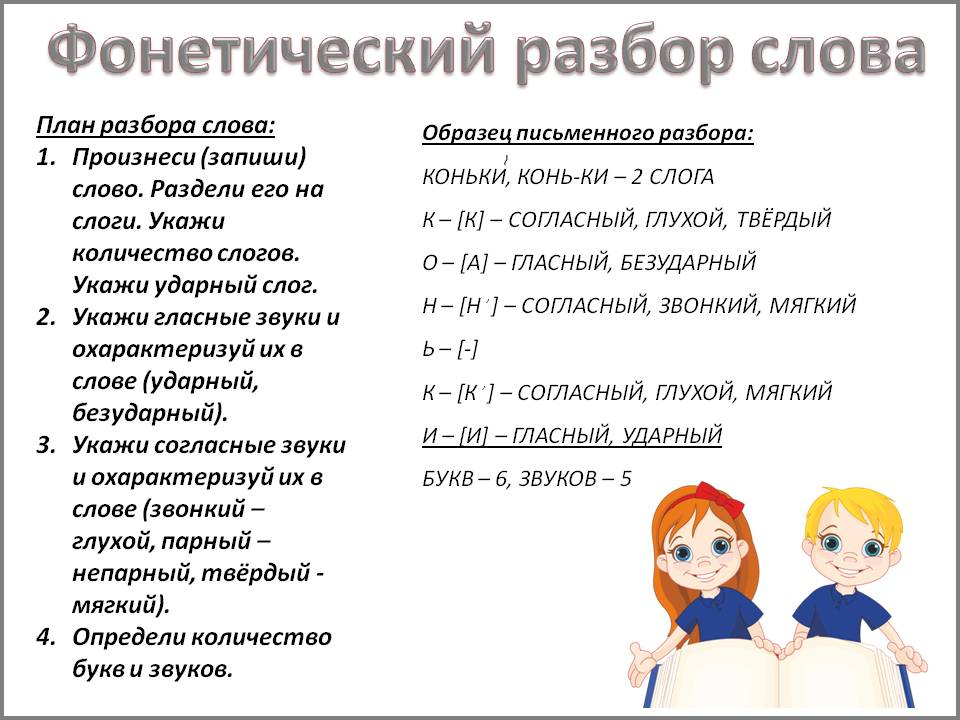

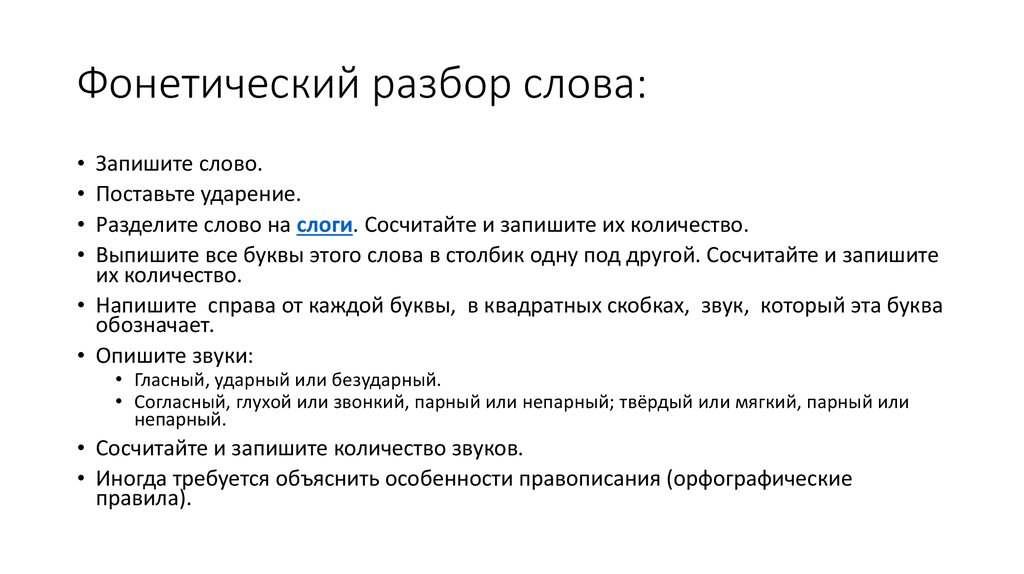

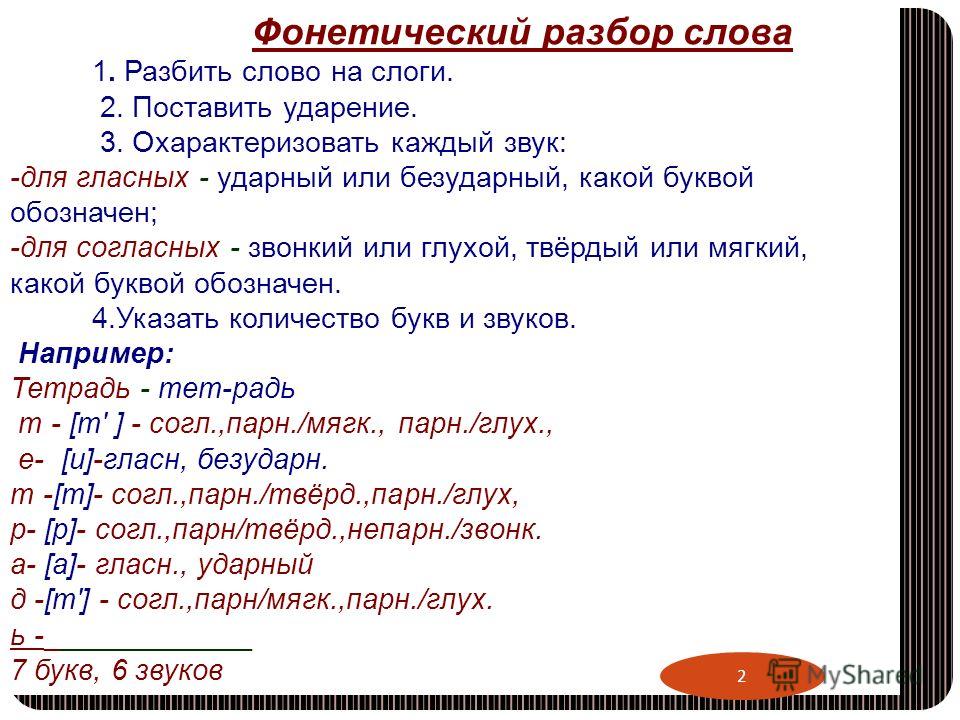

- План фонетического разбора

- Фонетическая транскрипция видео

- Таблицы соответствия букв и звуков для фонетического разбора

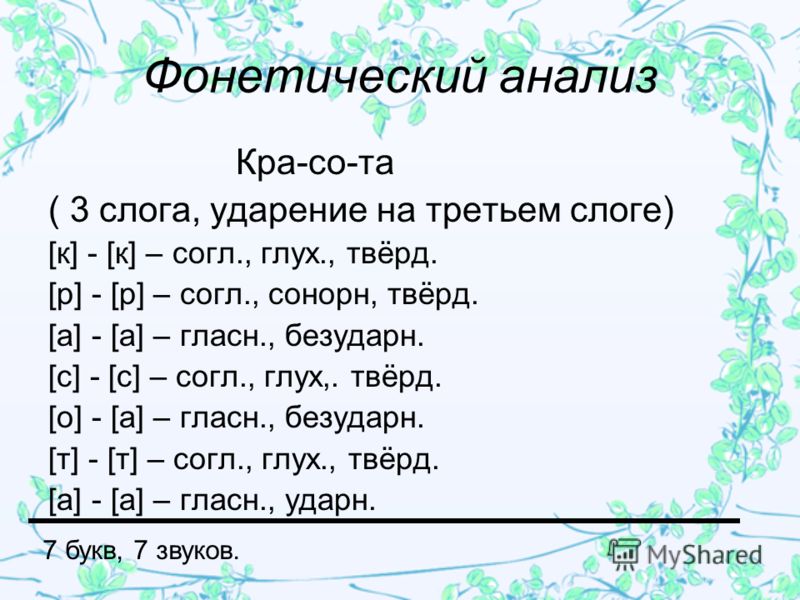

- Примеры фонетического разбора

- Примеры заданий с элементами фонетического разбора

- Фонетическая транскрипция – примеры, правила (5 класс, русский язык)

- Транскрипция – что это?

- Зачем нужна транскрипция?

- Частичная транскрипция

- Как записать транскрипцию

- Примеры транскрипции слов

- Что мы узнали?

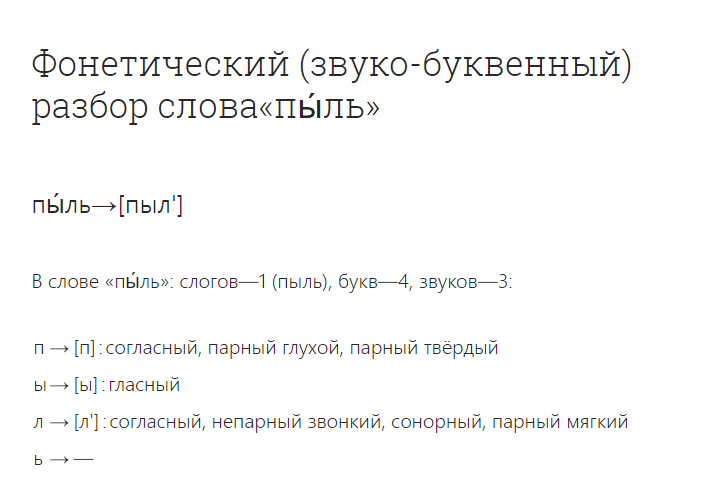

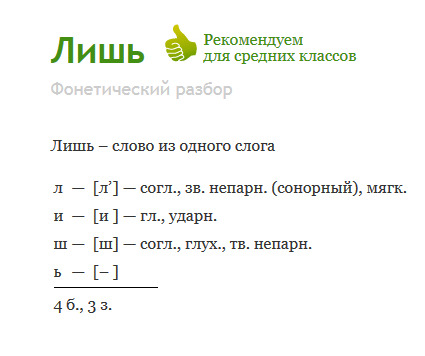

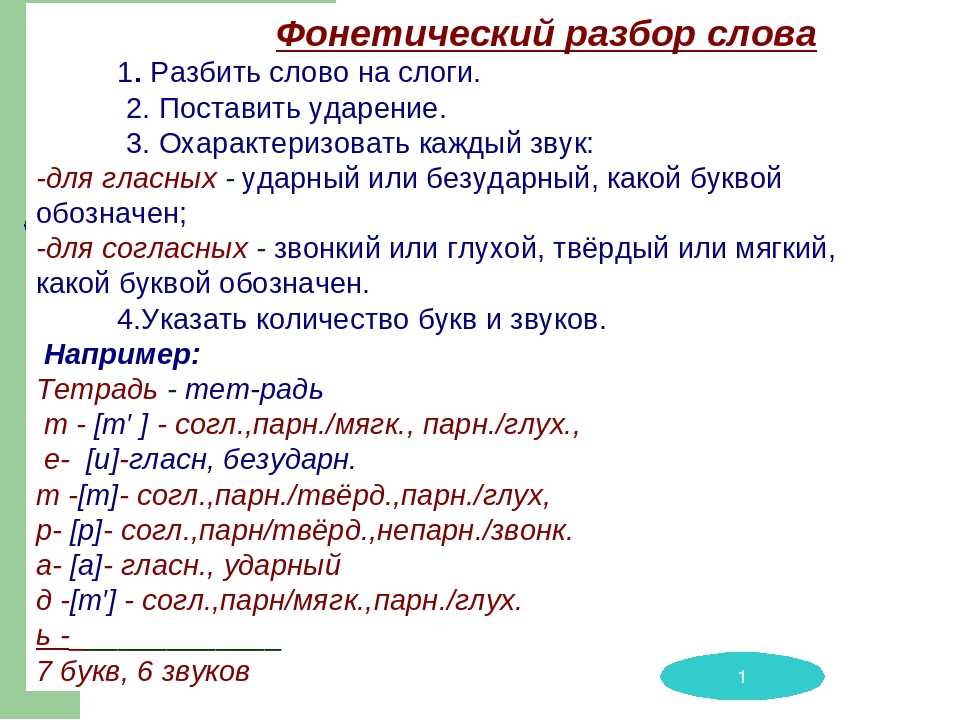

- Фонетический разбор слова

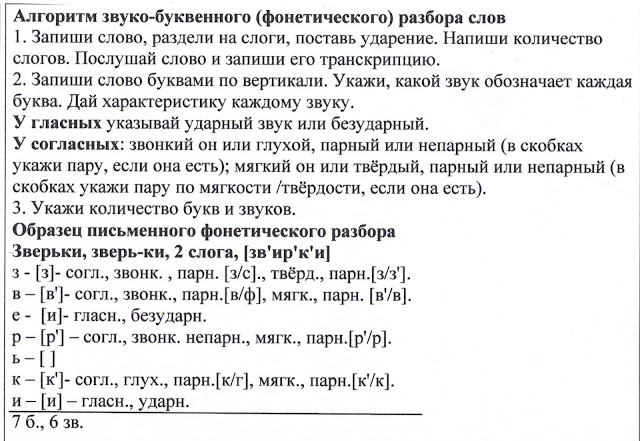

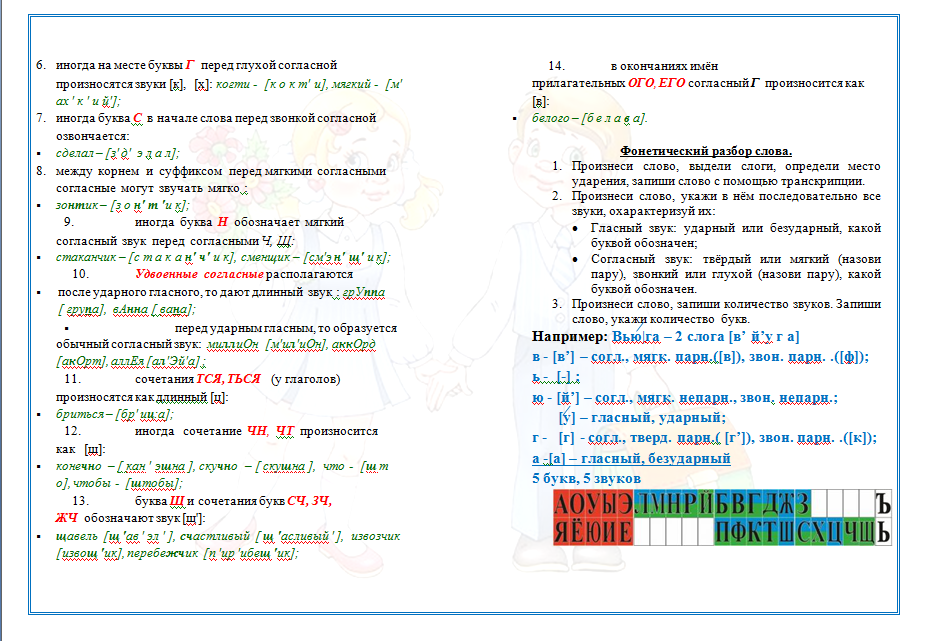

- Правила разбора на звуки

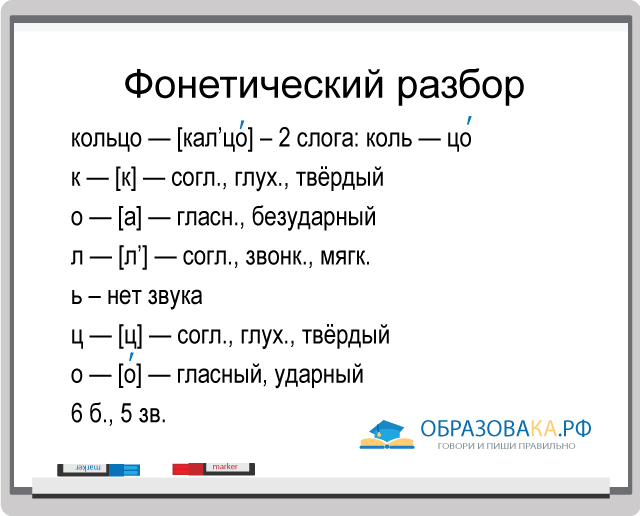

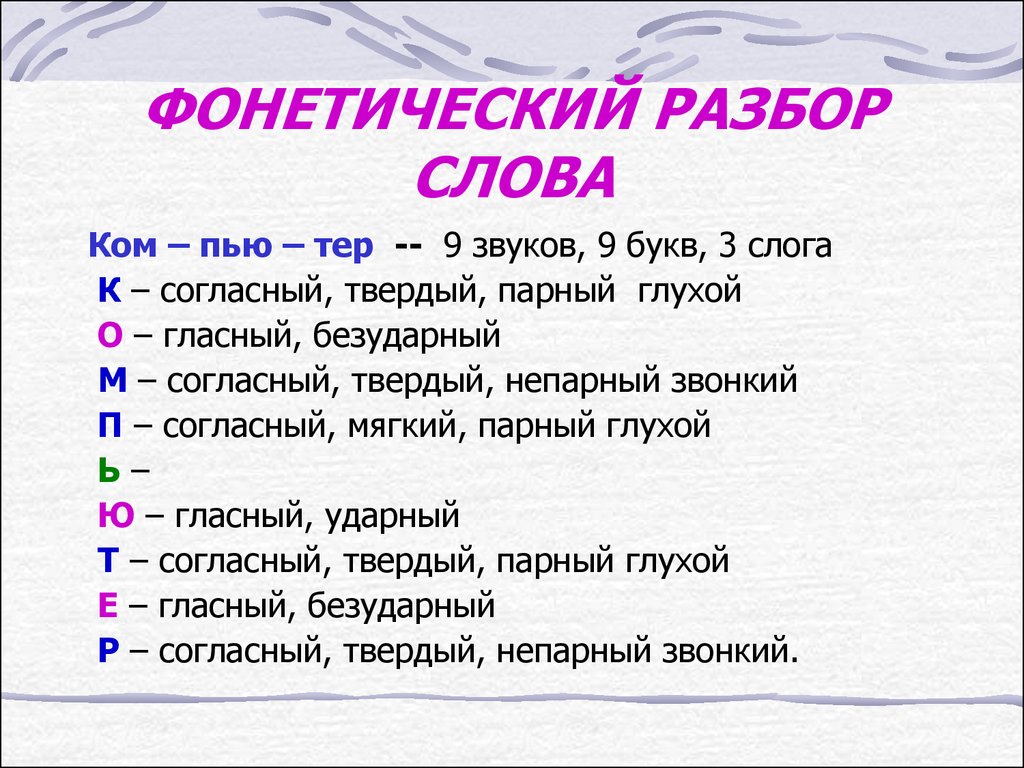

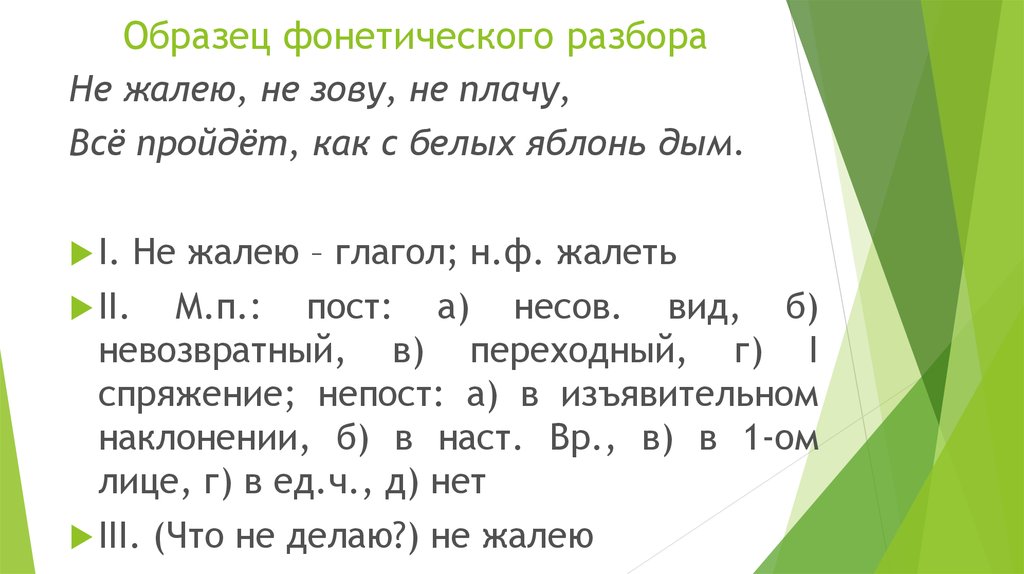

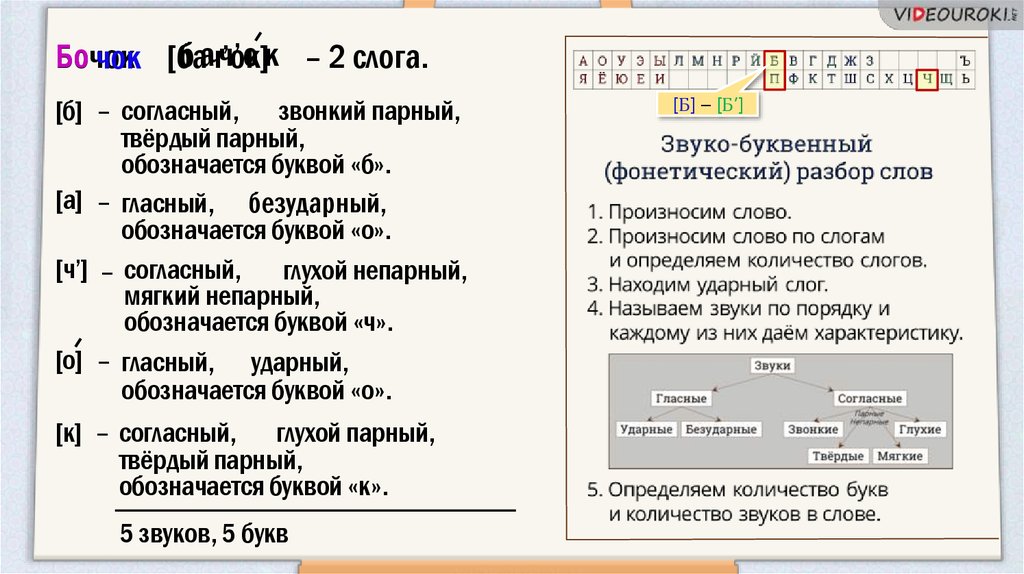

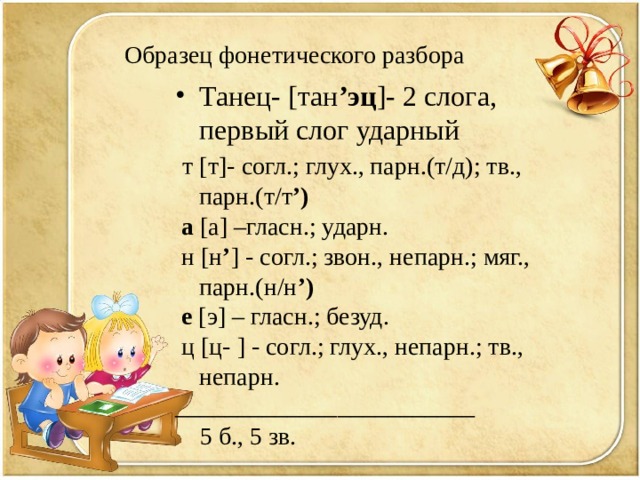

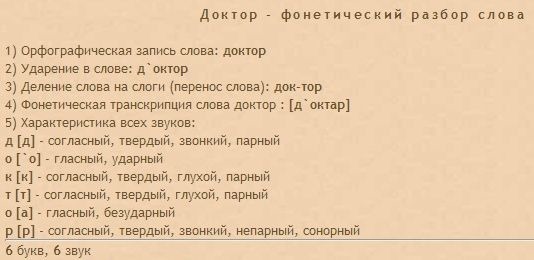

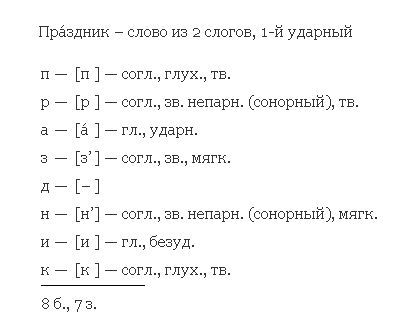

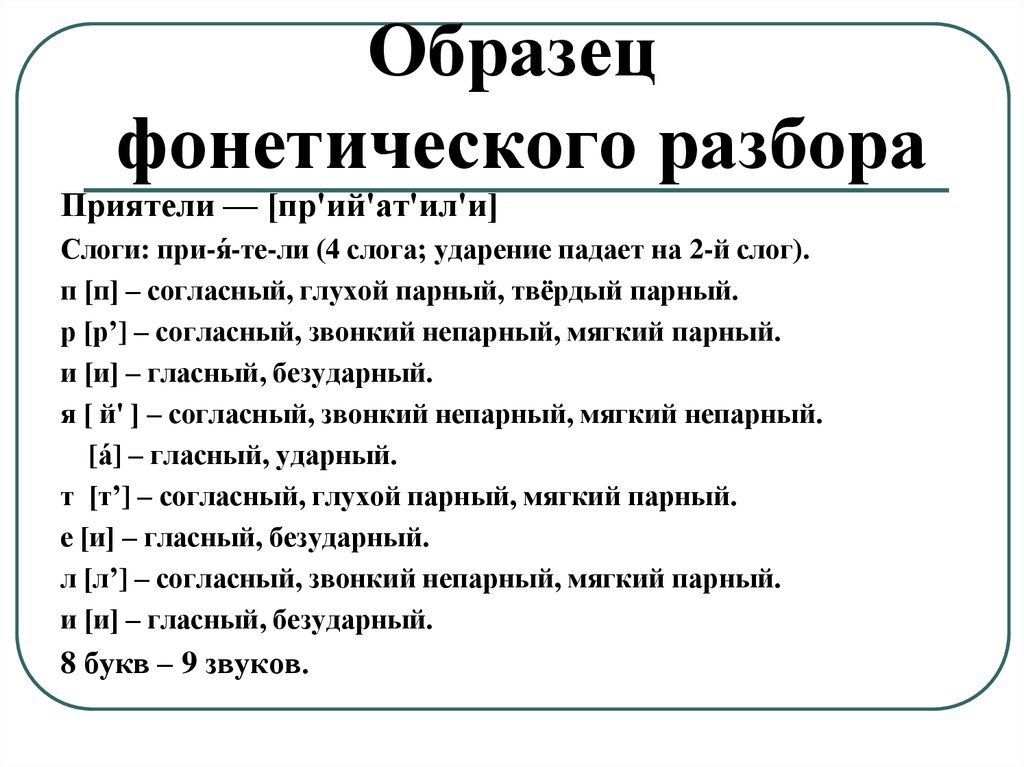

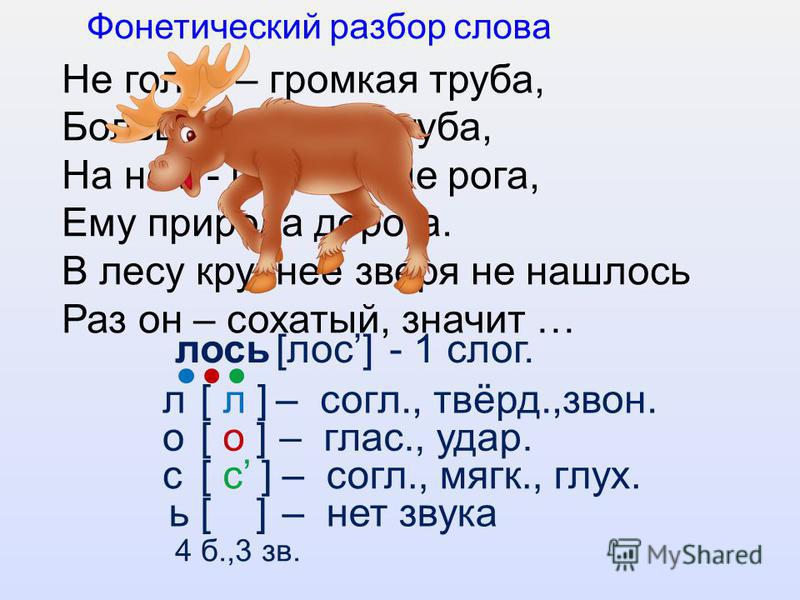

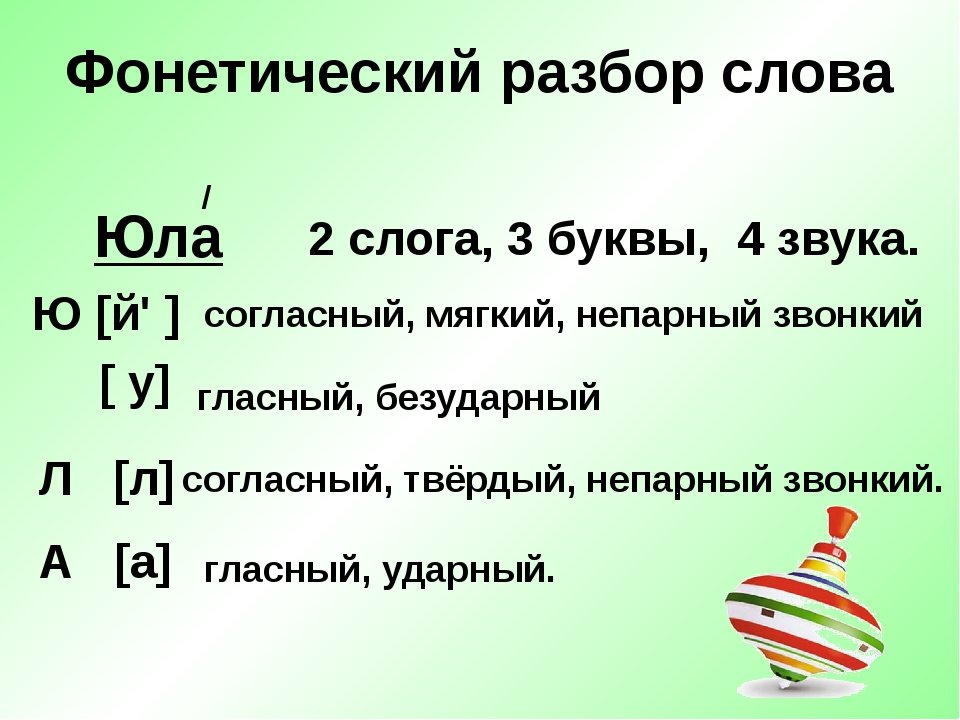

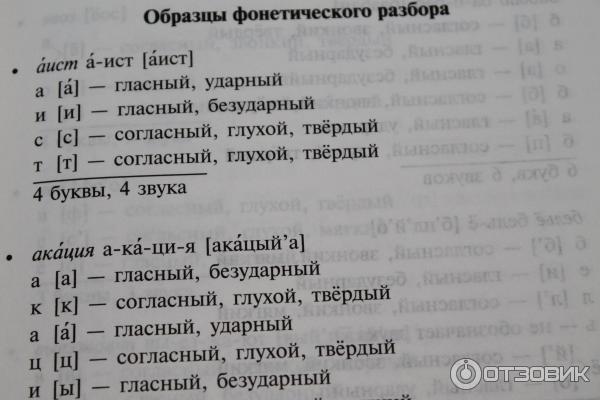

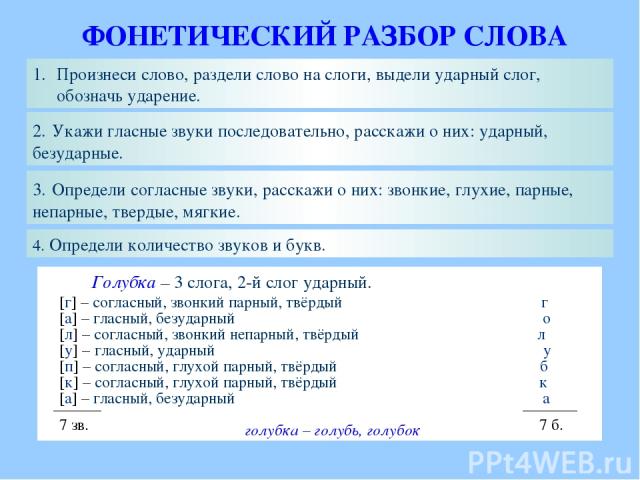

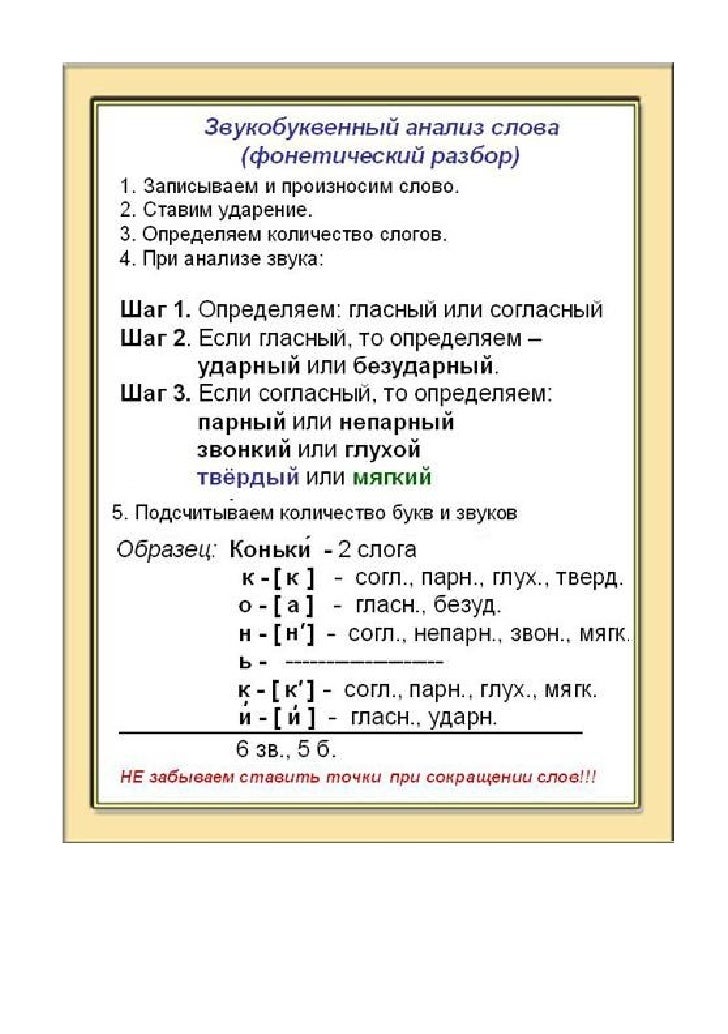

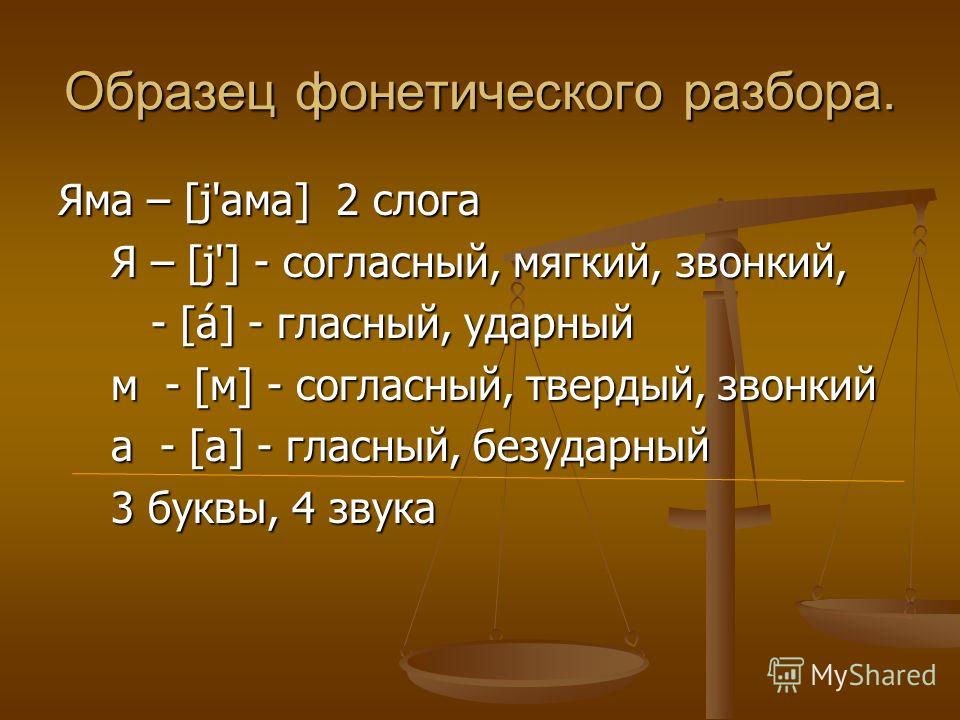

- Образец звуко-буквенного разбора слова

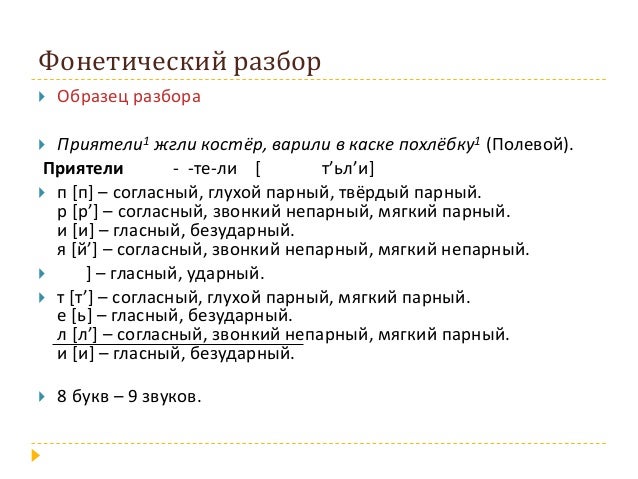

- Примеры фонетического разбора

- Видео

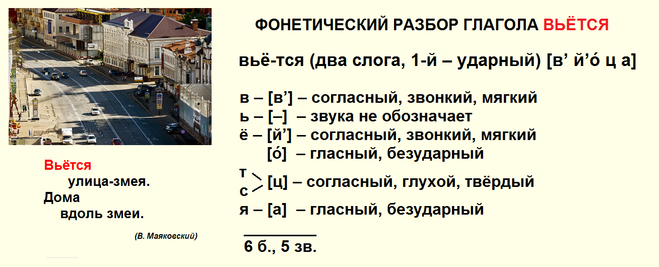

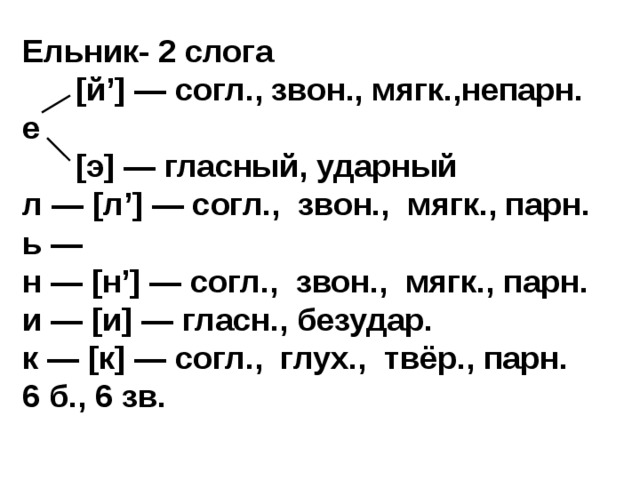

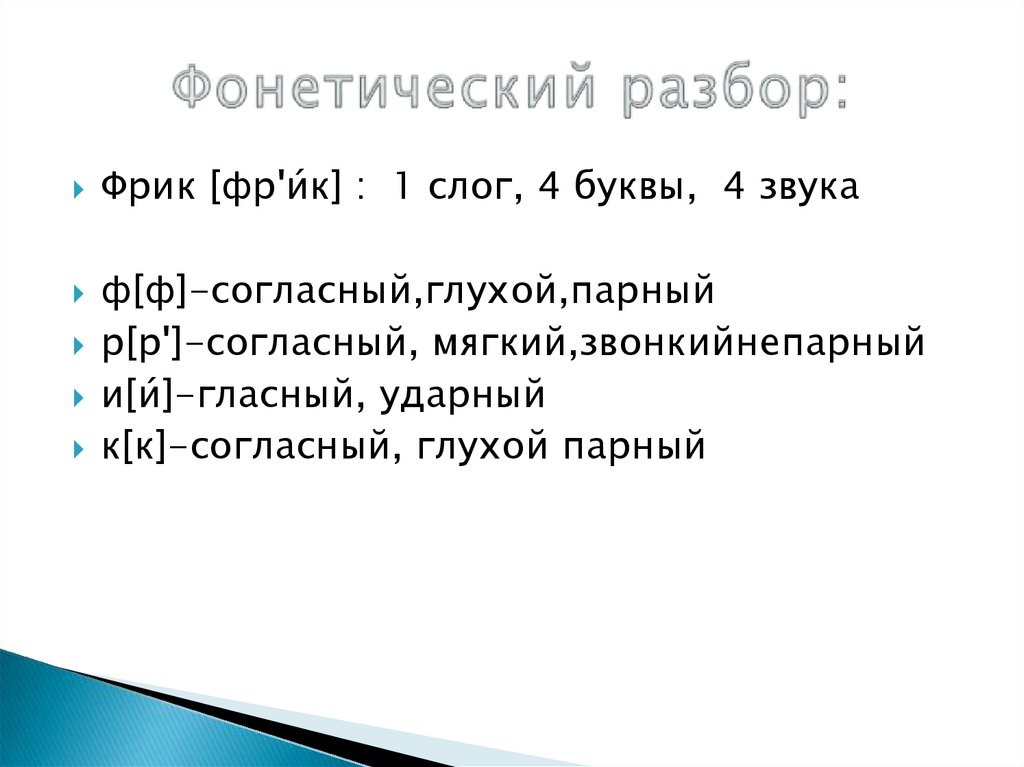

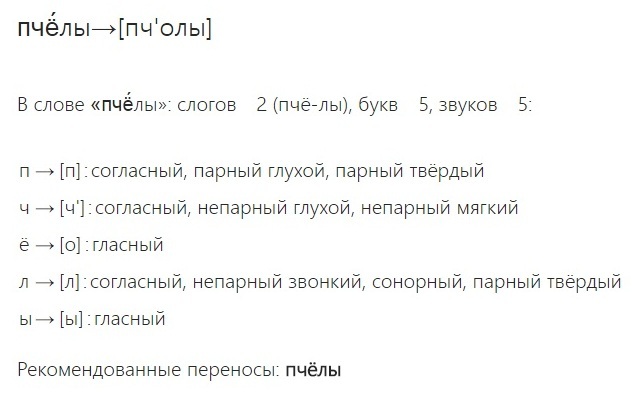

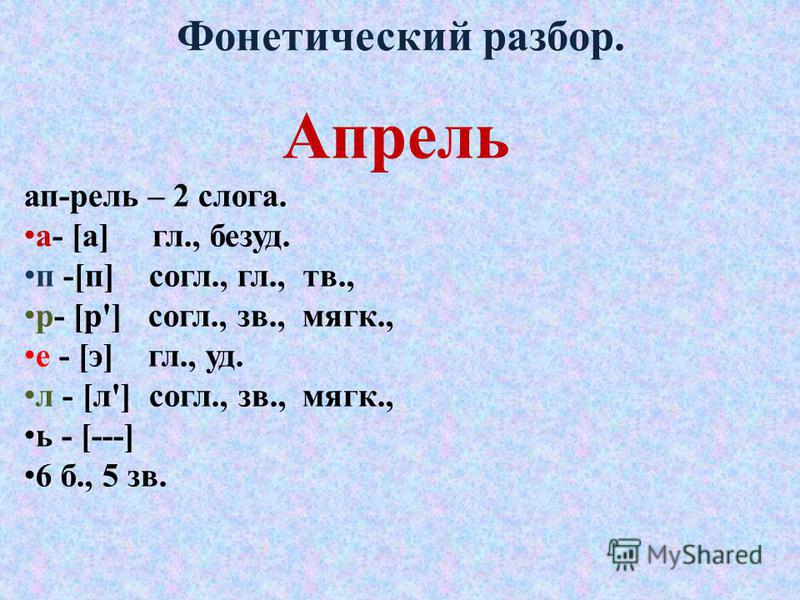

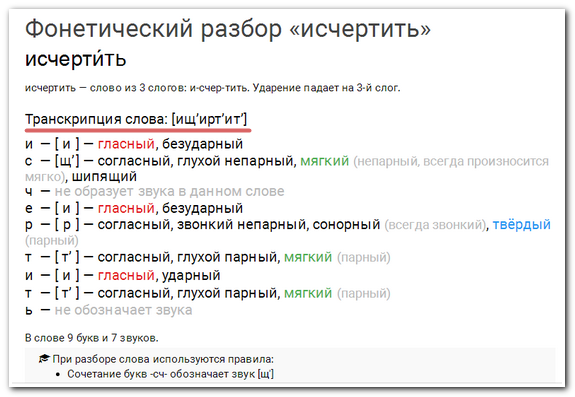

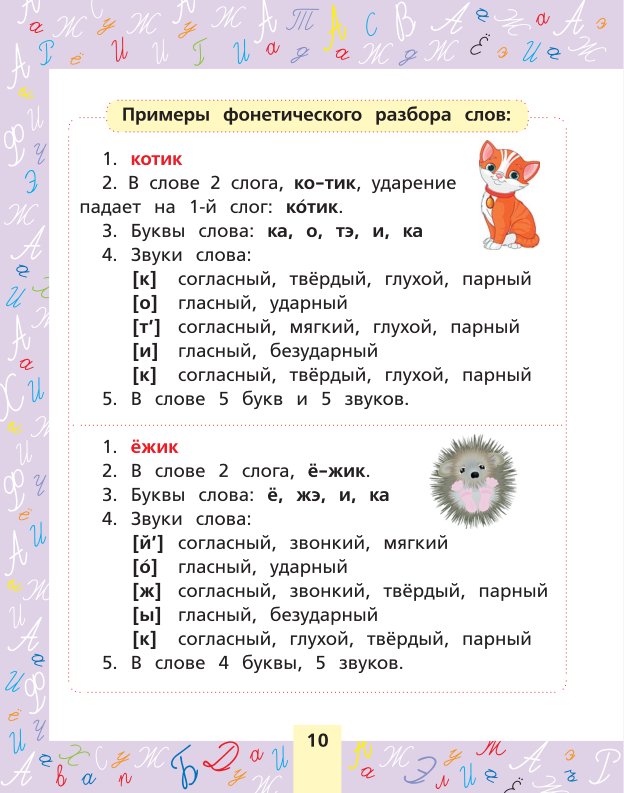

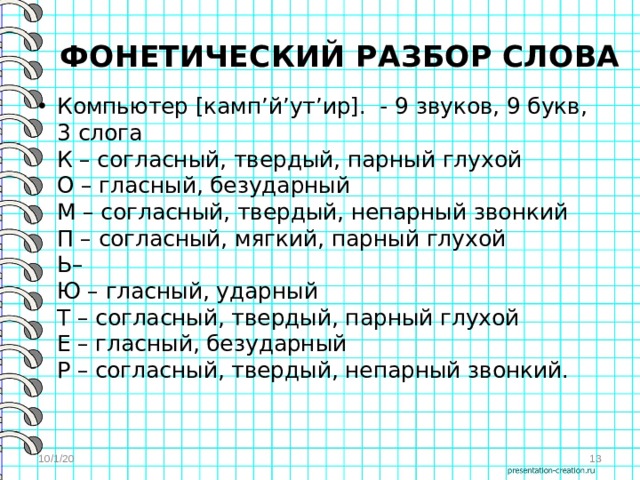

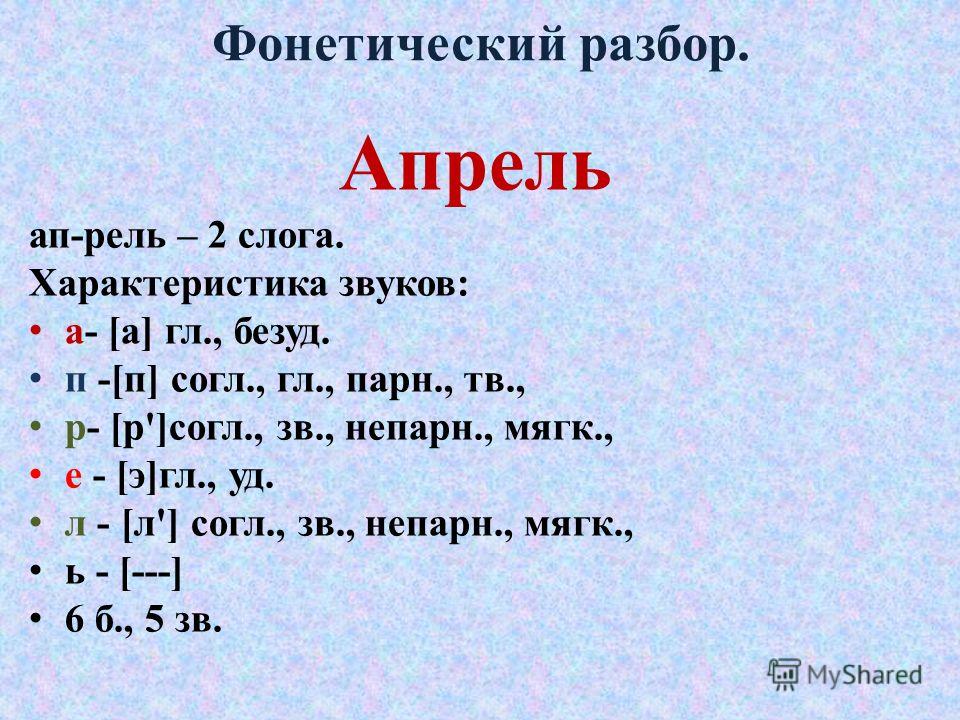

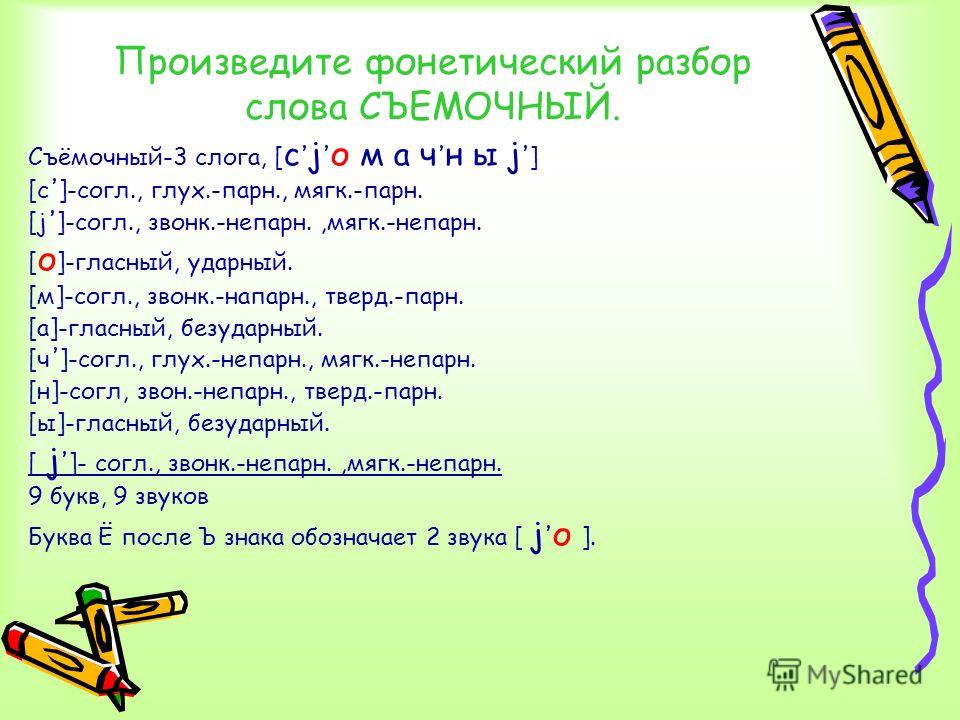

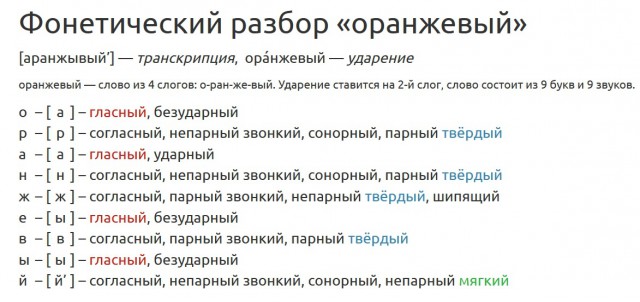

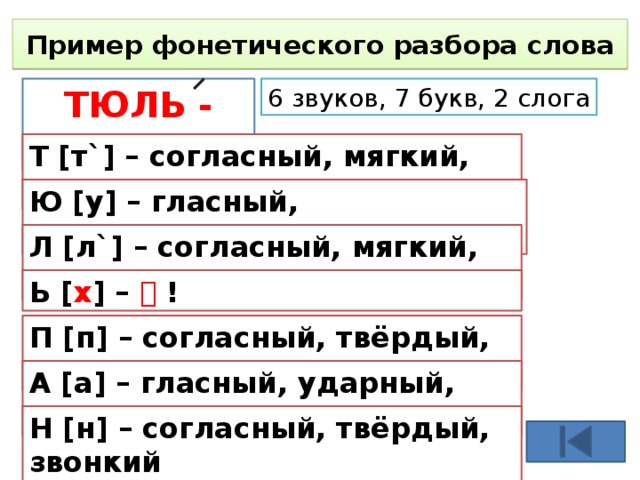

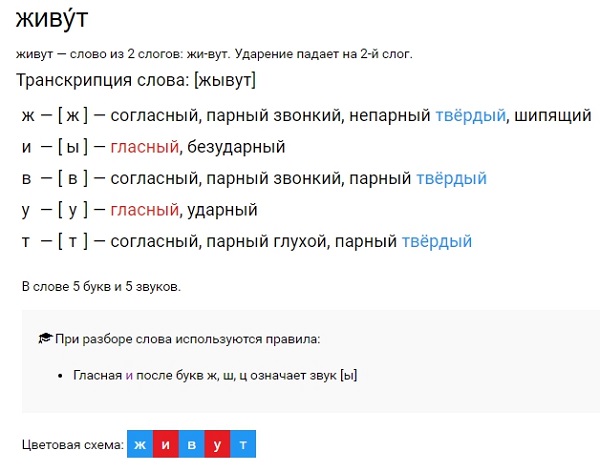

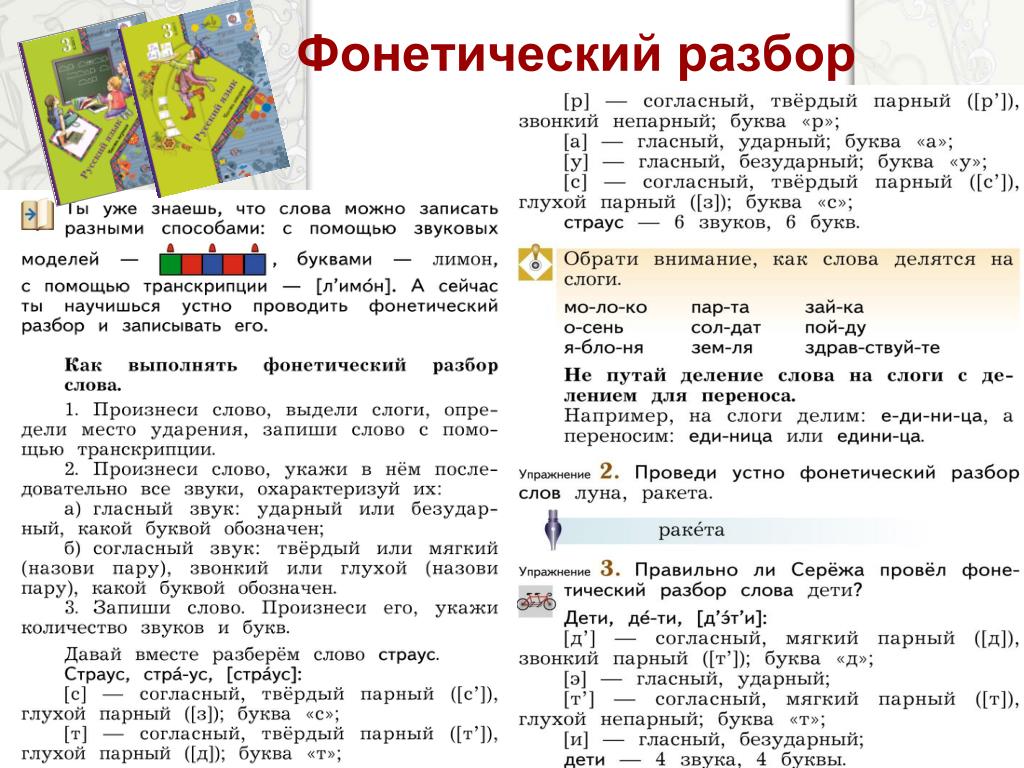

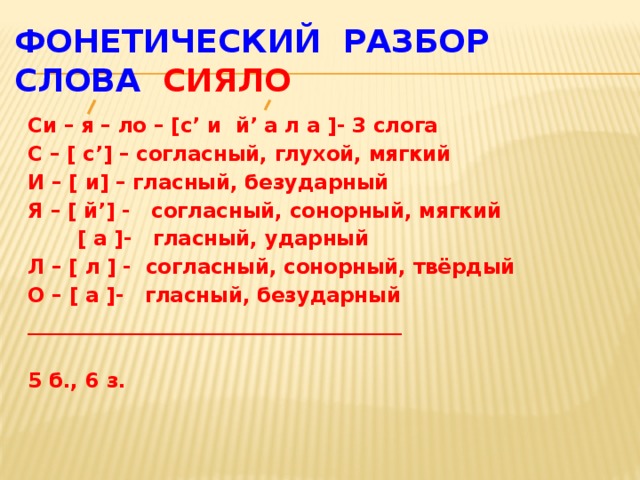

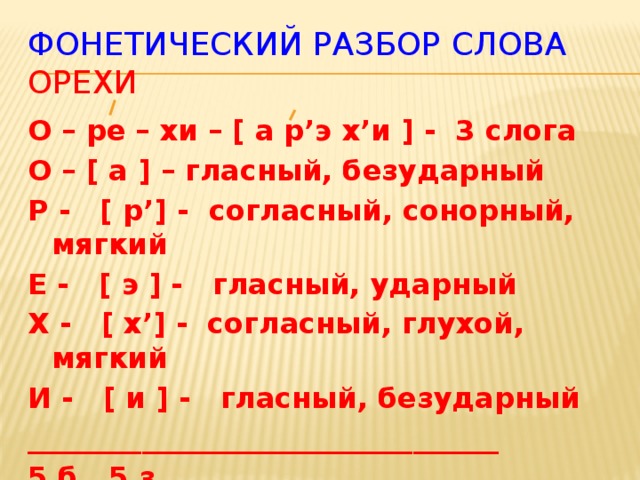

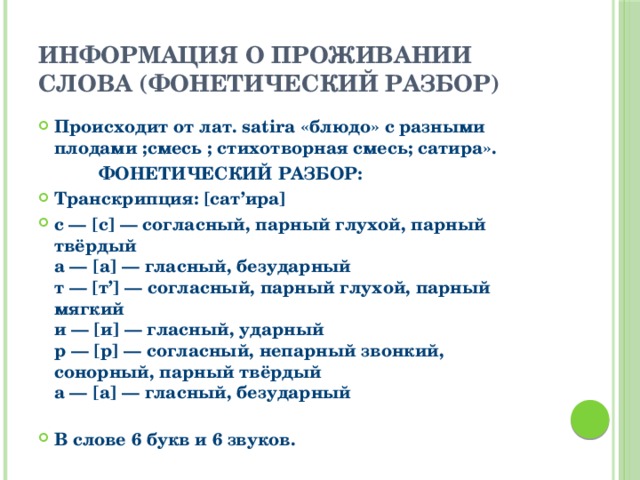

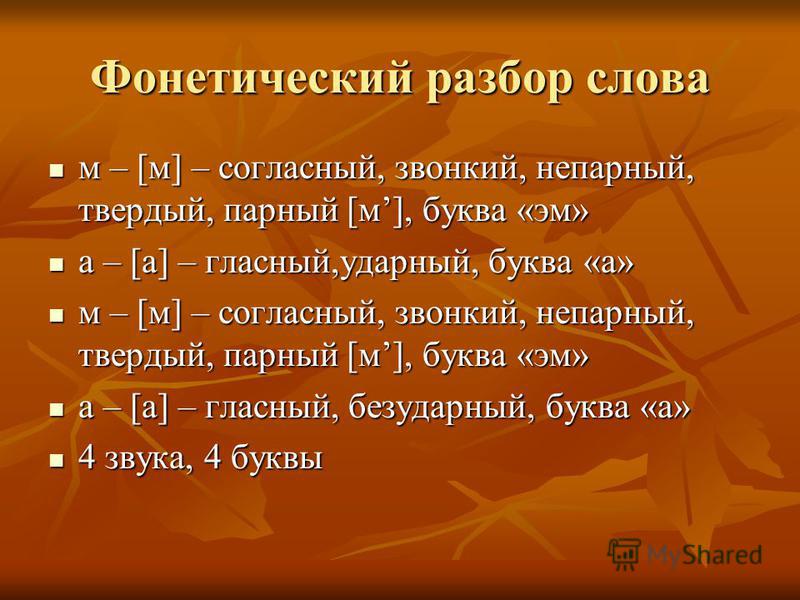

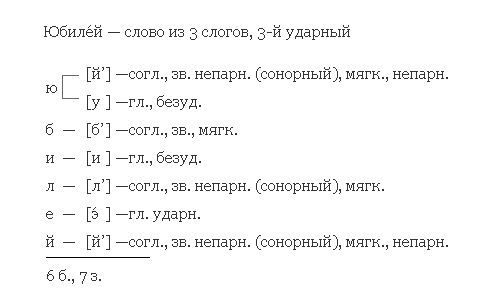

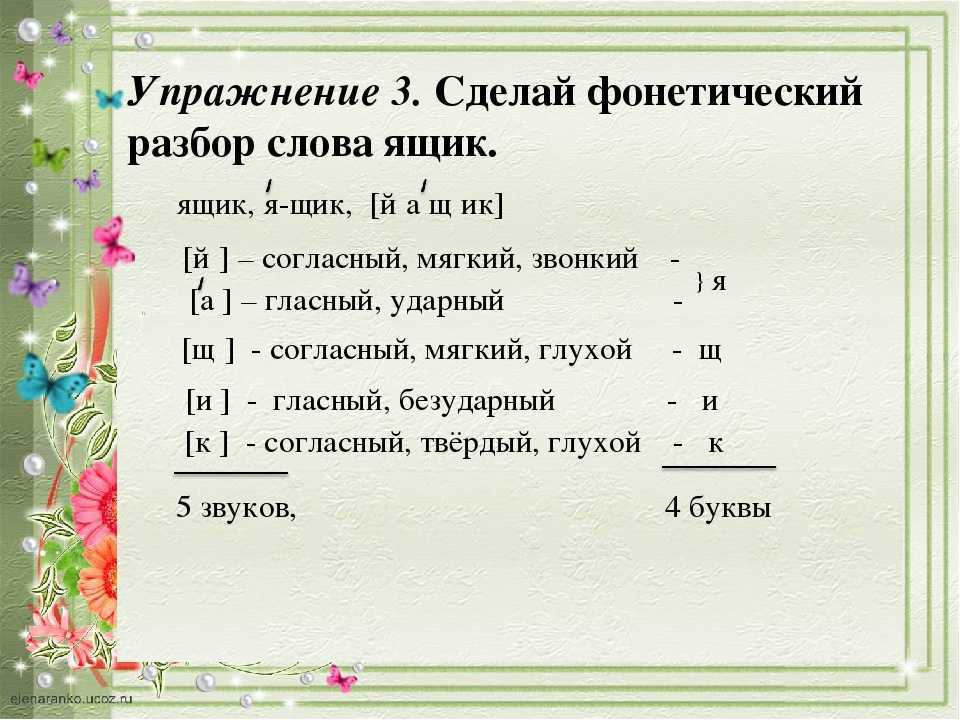

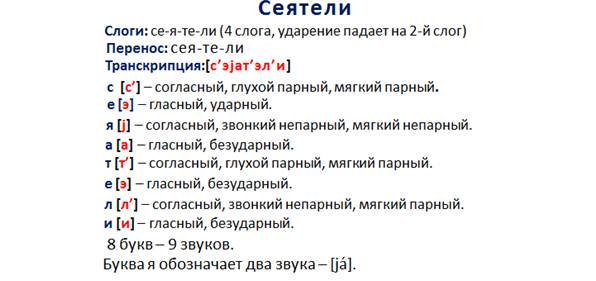

Примеры фонетического разбора

Приведём примеры простых и сложных случаев фонетических разборов слов. К каждому примеру дано объяснение разбора.

К каждому примеру дано объяснение разбора.

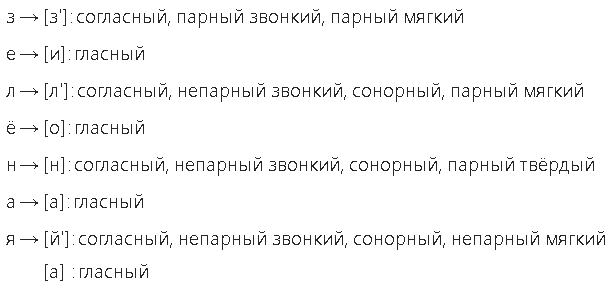

Покажем примеры фонетических разборов для йотированных гласных. Определение йотированных гласных дано на странице звуков. В русском слове много слов с удвоенными согласными: классно, баллон, сумма, ванна и другие. В звуко-буквенном разборе следует обращать особое внимание на позицию удвоенной согласной, так как может образовываться долгий звук. Покажем на примерах два случая.

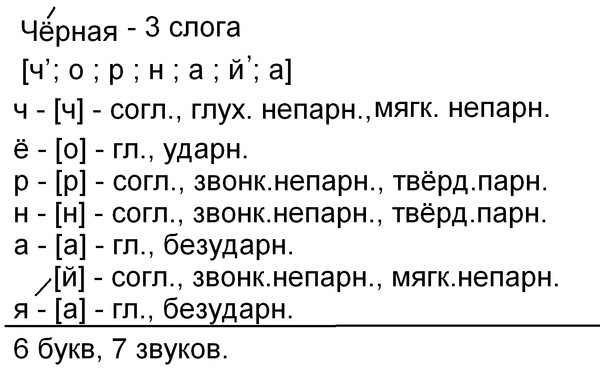

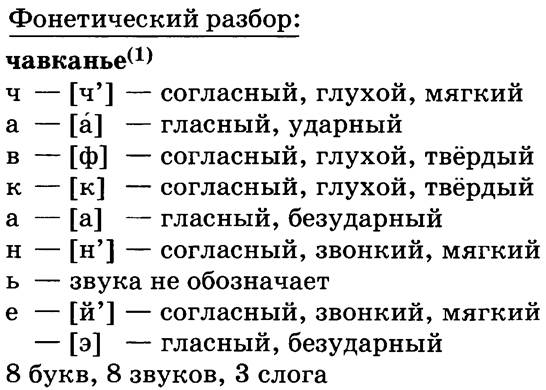

Йотированная гласная + ь

Слово: е́ль

Транскрипция: [й’эл’]

е → [ й’ ] — согласный, звонкий непарный (сонорный), мягкий непарный

[ э ] — гласный, ударный

л → [ л’ ] — согласный, звонкий непарный (сонорный), мягкий парный

ь — не обозначает звука

В этом примере гласная е стоит в начале слова, поэтому является йотированной и образует два звука [й’] + [э]. Мягкий знак не означает звука, но смягчает согласную л. В итоге 3 буквы и 3 звука.

Йотированная гласная + чередование согласной

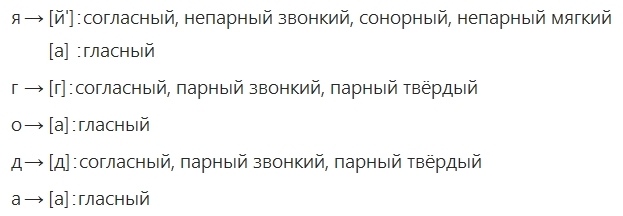

Слово: его́

Транскрипция: [й’иво]

е → [ й’ ] — согласный, звонкий непарный (сонорный), мягкий непарный

[ и ] — гласный, безударный

г → [ в ] — согласный, звонкий парный, твёрдый парный

о → [ о ] — гласный, ударный

Гласная е является йотированной и обозначает два звука. Но в отличие от первого примера буква не под ударением, поэтому она означает звуки [й’] + [и]. Обратите внимание, что буква г в слове произносится как «в». Так как в слове нет случаев «пропадания» звуков, поэтому 3 буквы и 4 звука.

Но в отличие от первого примера буква не под ударением, поэтому она означает звуки [й’] + [и]. Обратите внимание, что буква г в слове произносится как «в». Так как в слове нет случаев «пропадания» звуков, поэтому 3 буквы и 4 звука.

Сдвоенная согласная — долгий звук

Слово: те́ннис

Транскрипция: [т’э н ис] или [т’эн:ис]

т → [ т’ ] — согласный, глухой парный, мягкий парный

е → [ э ] — гласный, ударный

н → [ н: ] — согласный, глухой парный, твёрдый парный

н — не образует звука

и → [ и ] — гласный, безударный

с → [ с ] — согласный, глухой парный, твёрдый парный

Сдвоенная согласная н образует долгий звук [н:], так как ударение в слове идёт до этой согласной. Допустимы оба обозначения долгого звука — 1) черта над звуком, 2) двоеточие справа. Долгий звук также называют длинным, тянущимся.

Сдвоенная согласная — обычный звук

Слово: хокке́й

Транскрипция: [хакэй’]

х → [ х ] — согласный, глухой непарный, твёрдый парный

о → [ а ] — гласный, безударный

к → [ к ] — согласный, глухой парный, твёрдый парный

к — не образует звука

е → [ э ] — гласный, ударный

й → [ й’ ] — согласный, звонкий непарный (сонорный), мягкий непарный

В отличие от примера со словом теннис здесь сдвоенная согласная к не образует долгого звука, так как ударение в слове идёт сразу после согласной. Произнесите вслух оба слова и почувствуйте, что в слове хоккей букву к получается произносить быстро, а в слове теннис букву н можно произнести с небольшой задержкой.

Произнесите вслух оба слова и почувствуйте, что в слове хоккей букву к получается произносить быстро, а в слове теннис букву н можно произнести с небольшой задержкой.

На сайте можно сделать фонетический разбор любого русского слова в режиме онлайн — введите слово в форму поиска и нажмите кнопку.

Источник

Фонетическая транскрипция слова

Транскрипция – что это?

Когда мы записываем что-то под диктовку, мы записываем не то, что мы слышим, а то, что мы понимаем. То есть записываем слова не так, как услышали (вада), а так, как пишется по правилам понятое нами слово (вода). И это понятно. Ведь диктующий может говорить неразборчиво, обладать плохой дикцией. Но мы его все равно понимаем. И пишем, например, не “гхуша”, а “груша”.

Но мы можем записать слово не только так, как оно пишется, но и так, как оно произносится. Вот эта запись и называется “транскрипция”.

Зачем нужна транскрипция?

Фонетическая транскрипция слова выполняет ряд функций:

Из вышесказанного понятно, что транскрипции могут быть разные. Одни передают норму, другие – реальное произношение.

Одни передают норму, другие – реальное произношение.

Точно в соответствии с произносительной нормой говорят разве что дикторы из прошлого века.

Школьникам интересна транскрипция как основа для фонетического разбора при изучении курса русского языка. Иногда к транскрипции прибегают составители орфоэпических словарей для передачи правильного произношения.

Частичная транскрипция

Иногда прибегают к частичной транскрипции. Это обычно бывает, если надо указать правильное произношение отдельных звуков.

Например, мо[дэ]ль. Это значит, что Д перед Е не мягкий.

Как записать транскрипцию

Транскрипцию в школах на уроках русского языка выполняют в квадратных скобках с помощью букв современного русского алфавита с использованием отдельных особых транскрипционных знаков: ударение, апостроф, иногда j.

В редких случаях учителя просят пользоваться знаками “ъ” и “ь” для обозначения гласных в заударной позиции, знаками “и склонное к э”, “крышечка” и т. п. Однако обычно такие знаки используют только студенты-филологи, тогда как школьники ими не пользуются и обозначают безударные а и о в любой позиции знаком [а], а и, я и е в безударной же позиции в любом месте слова знаком [и].

п. Однако обычно такие знаки используют только студенты-филологи, тогда как школьники ими не пользуются и обозначают безударные а и о в любой позиции знаком [а], а и, я и е в безударной же позиции в любом месте слова знаком [и].

Транскрипция записывается в квадратных скобках.

Даже если транскрибируется имя собственное, заглавная буква не пишется.

Можно транскрибировать слово “на слух”, если есть возможность прочесть его несколько раз вслух, протягивая каждый звук. Поскольку это бывает редко, транскрибируют обычно “по правилам”.

Основные правила:

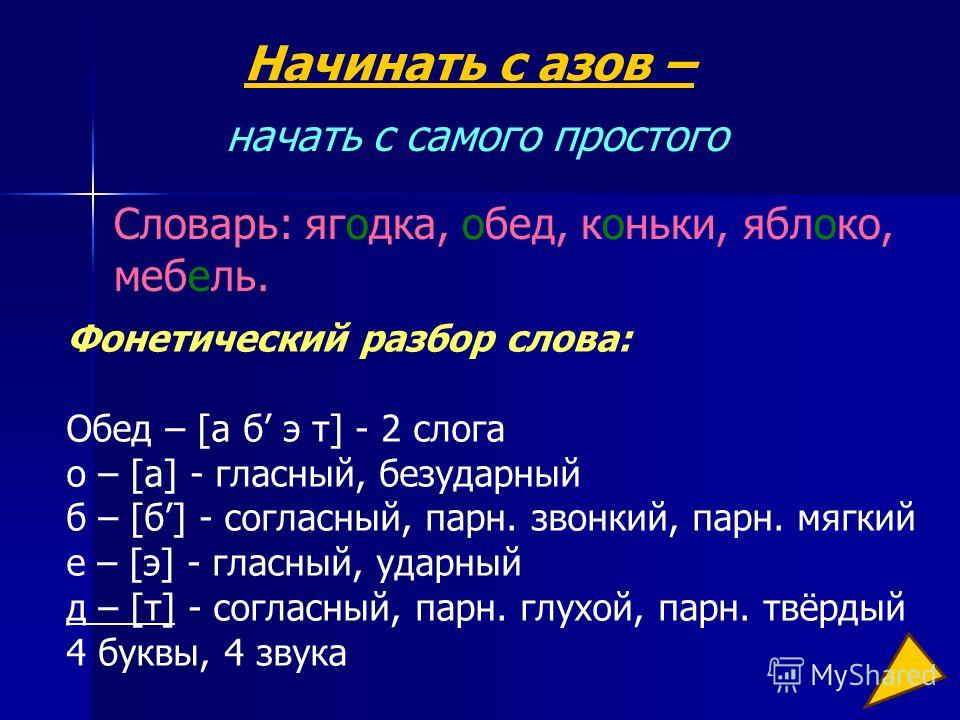

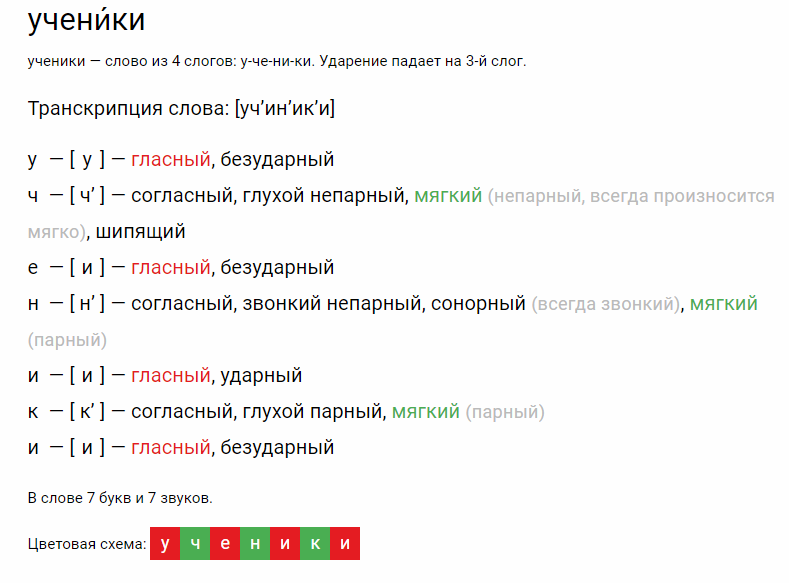

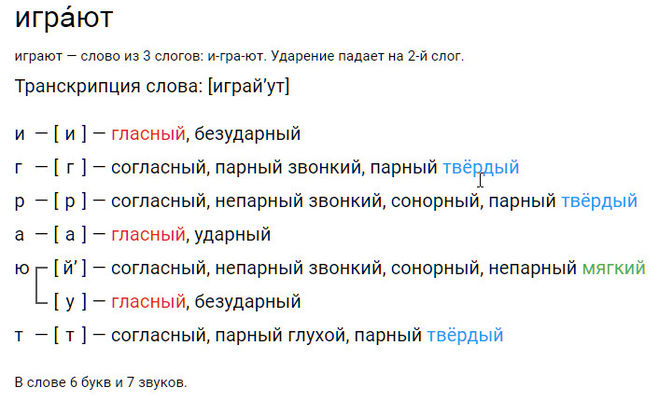

Примеры транскрипции слов

Что мы узнали?

Транскрипция – это запись слова по звукам так, как оно произносится, или так, как оно должно произноситься. При транскрибировании школьники используют обычные буквы русского алфавита за некоторым исключением и особые знаки. Существует ряд правил, которым надо следовать, записывая транскрипцию. Транскрипция помогает производить фонетический разбор и является его обязательной частью.

Источник

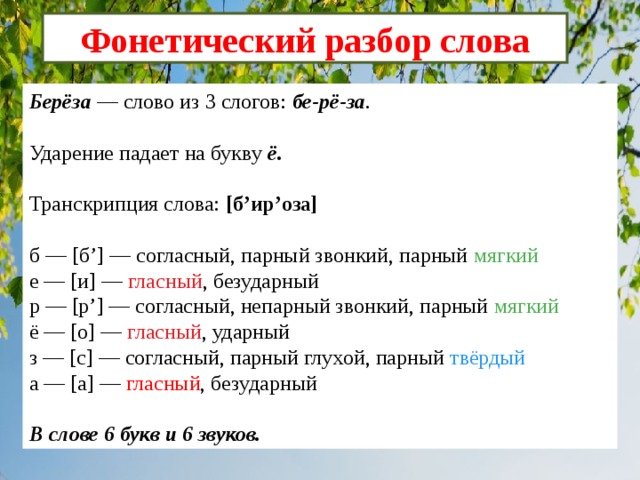

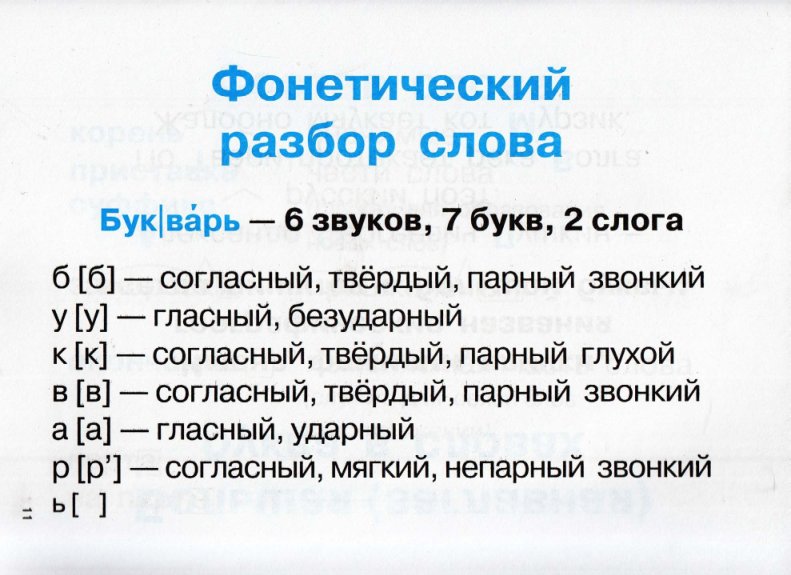

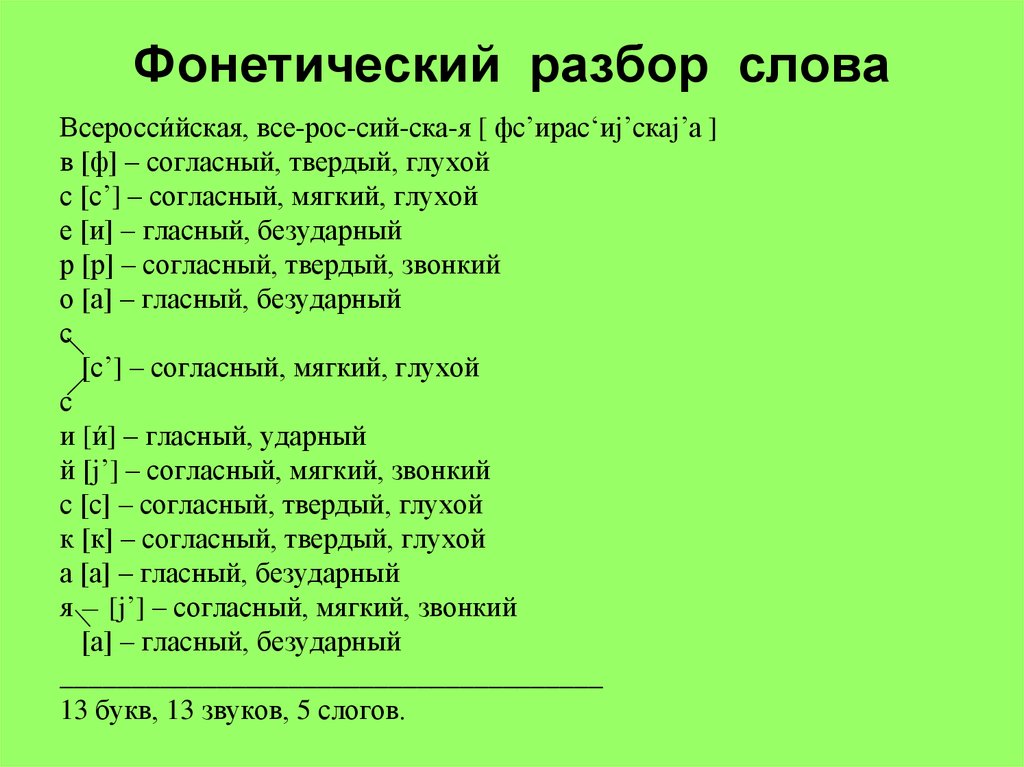

Транскрипция слова. Фонетический разбор слова

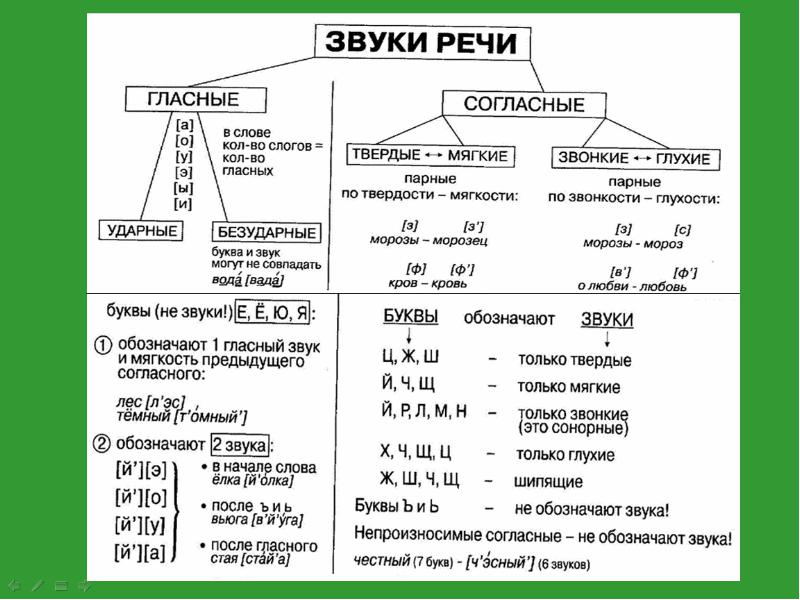

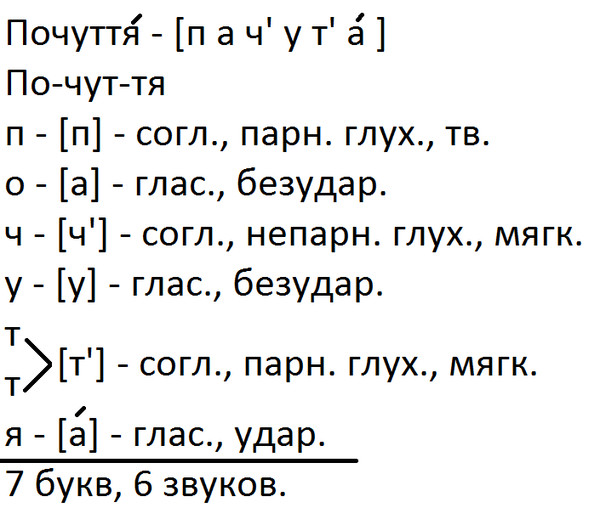

Основные понятия

Умение анализировать слово с точки зрения его произношения поможет школьнику понять случаи несоответствия того, что мы слышим, тому, что мы пишем, поможет систематизировать знания о фонетике и орфографии (в частности, о принципах орфографии), научит правильно произносить и правильно писать слова. Наиболее распространённым видом такого анализа является фонетический разбор, для которого необходимы сведения о звуках речи.

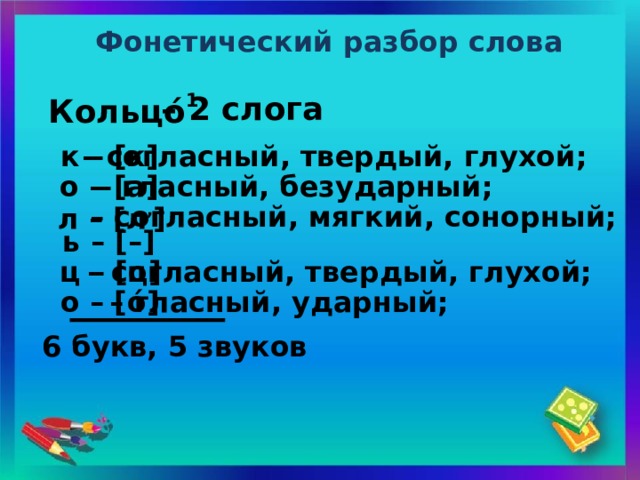

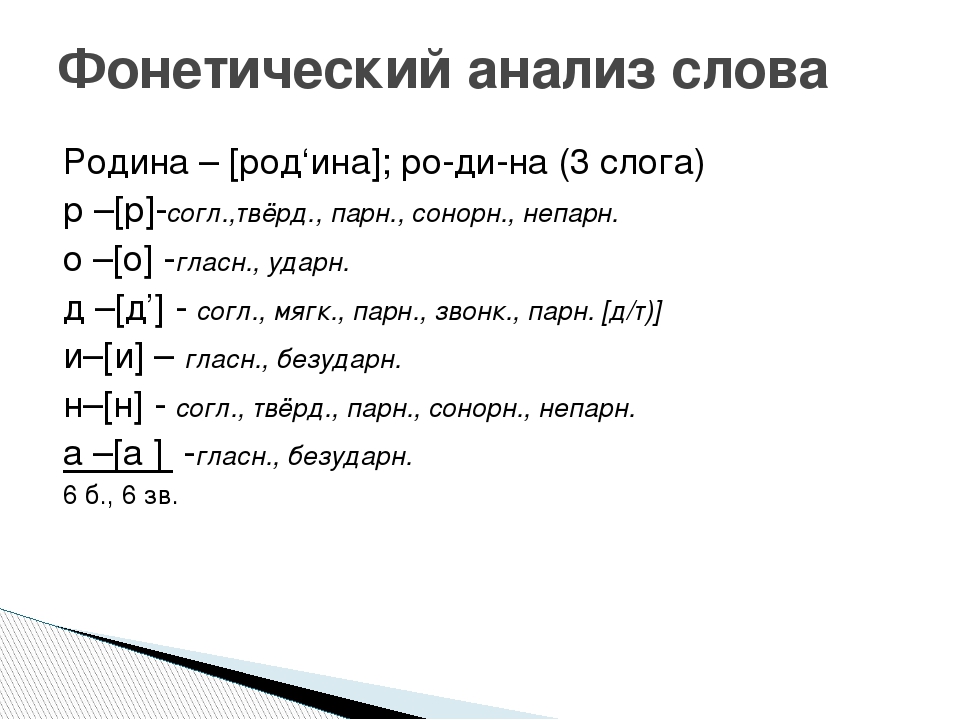

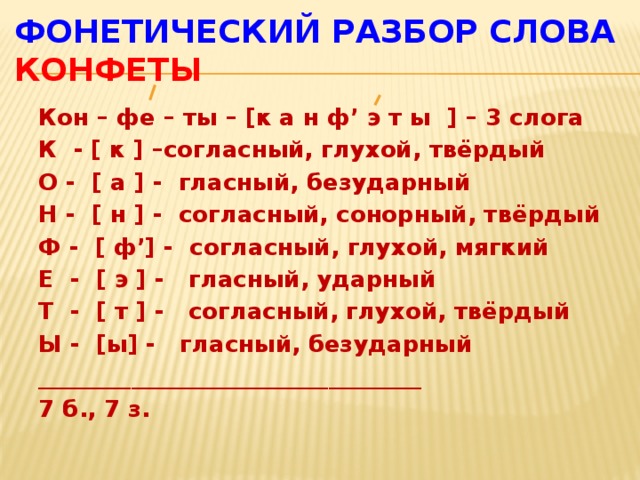

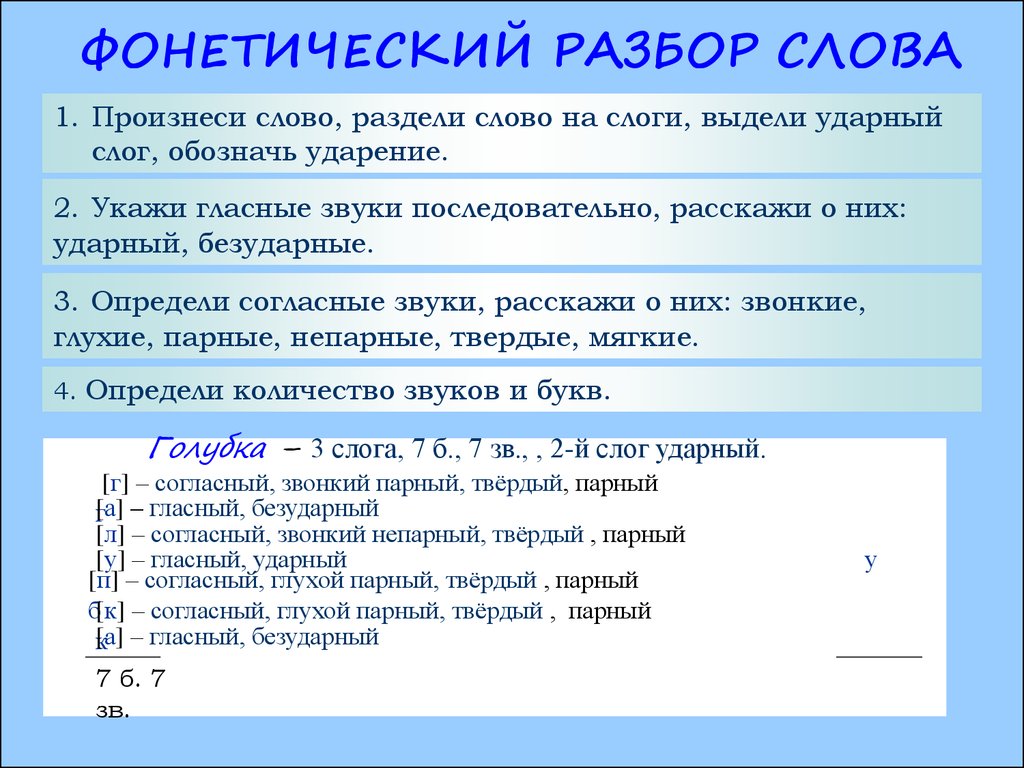

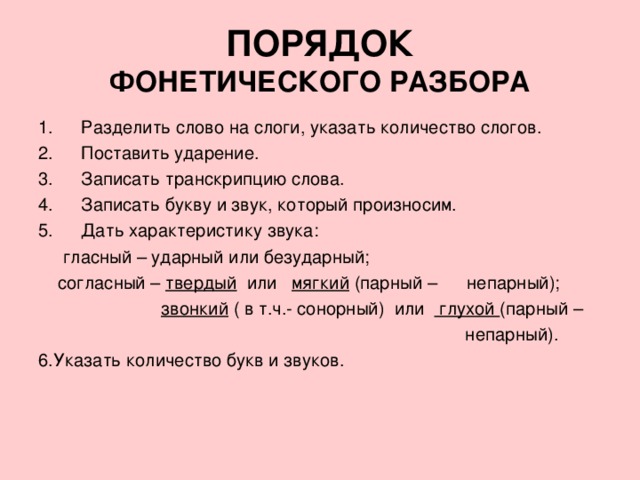

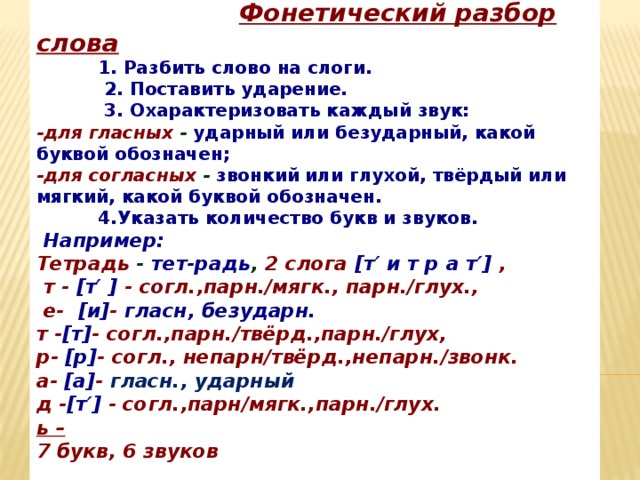

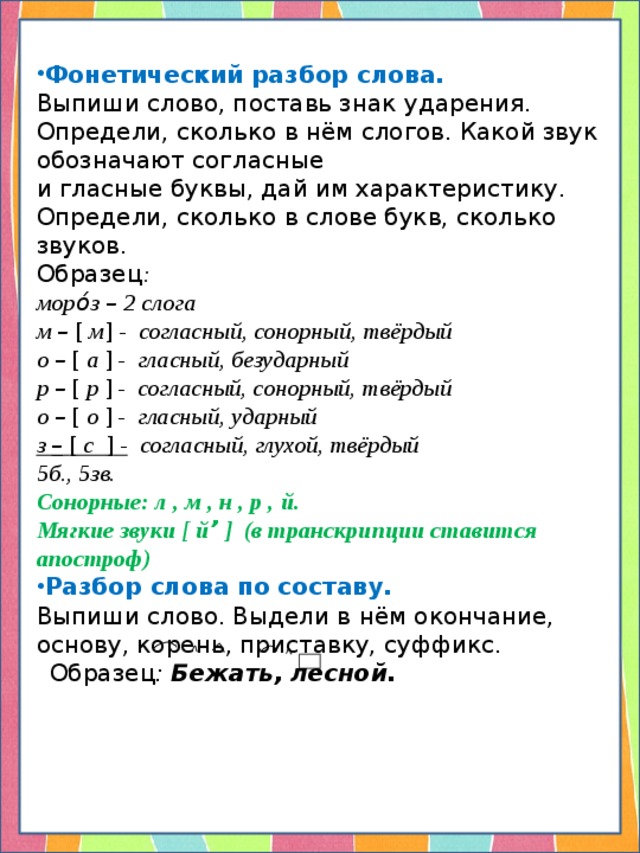

Фонетический разбор начинается с правильной записи слова, деления его на слоги, постановки ударения.

Затем нужно записать слово так, как оно звучит, то есть сделать его транскрипцию.

Чтобы не ошибиться, нужно произносить слово вслух, обращая внимание на то, как оно и помнить основные правила:

Например, слово МОРОЗ:

мо-рОз, ударение падает на второй слог.

Осталось посчитать количество звуков и букв.

В этом слове оно одинаково: букв 5 и звуков 5.

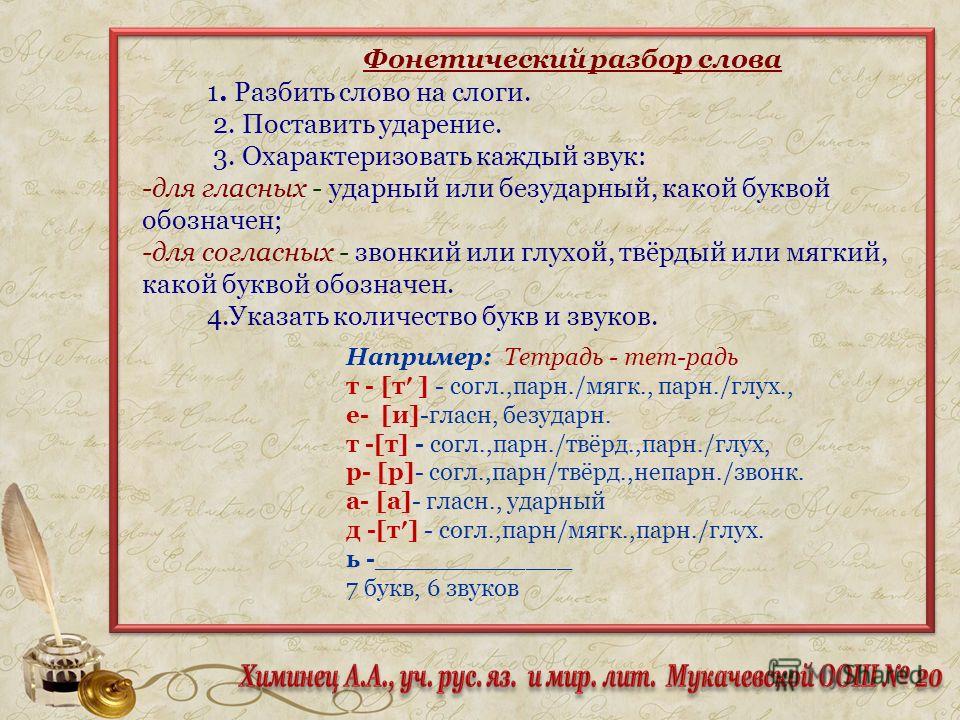

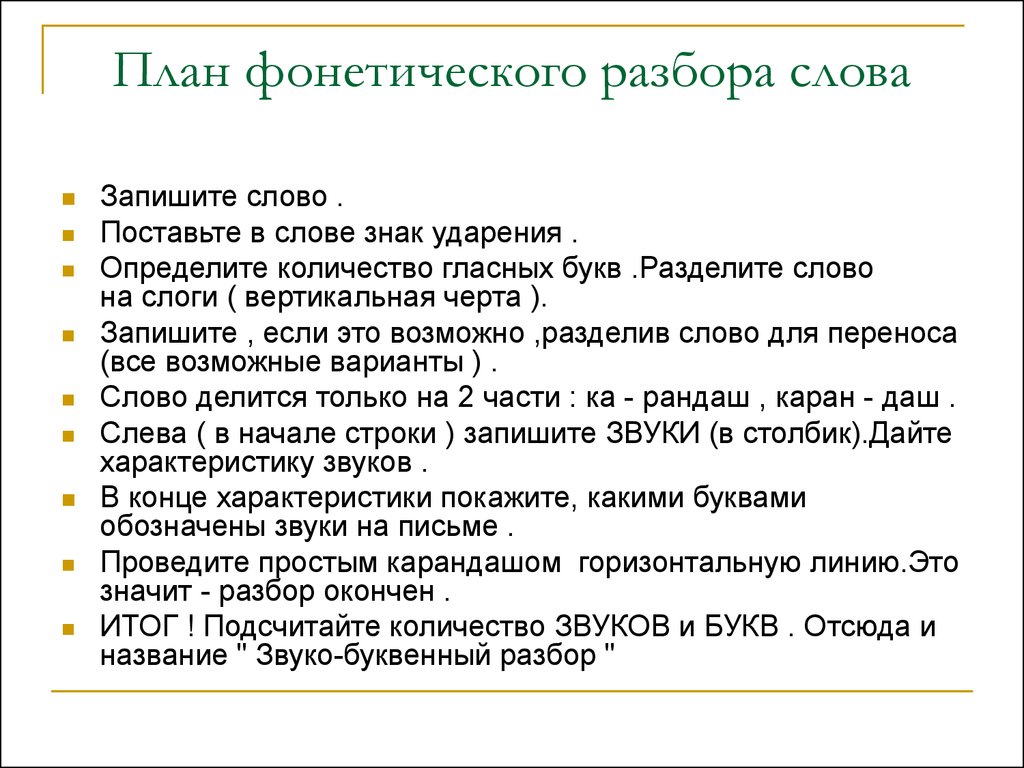

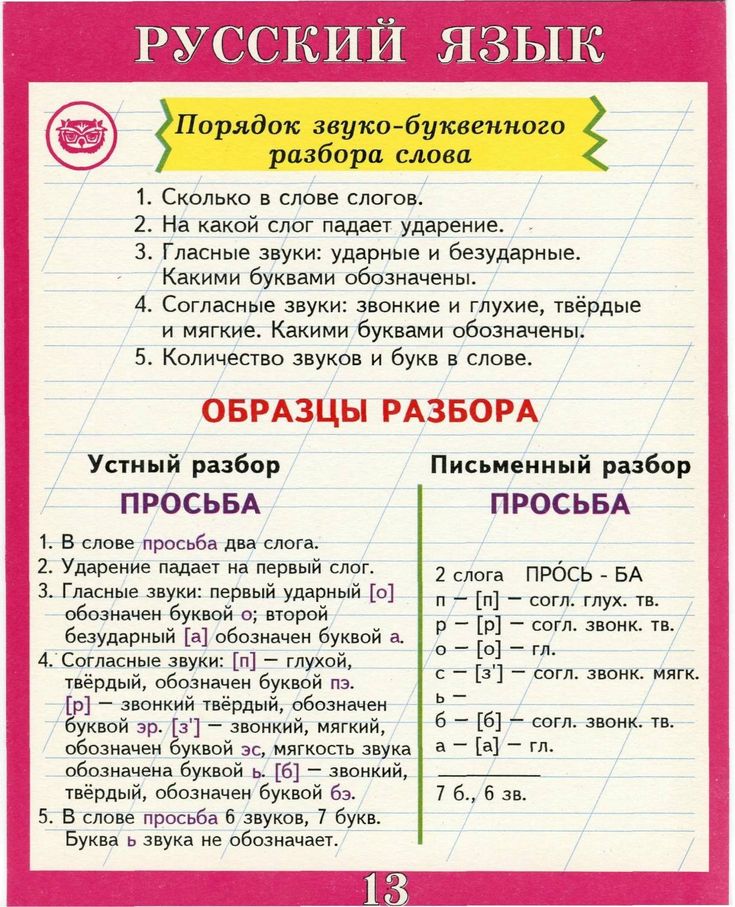

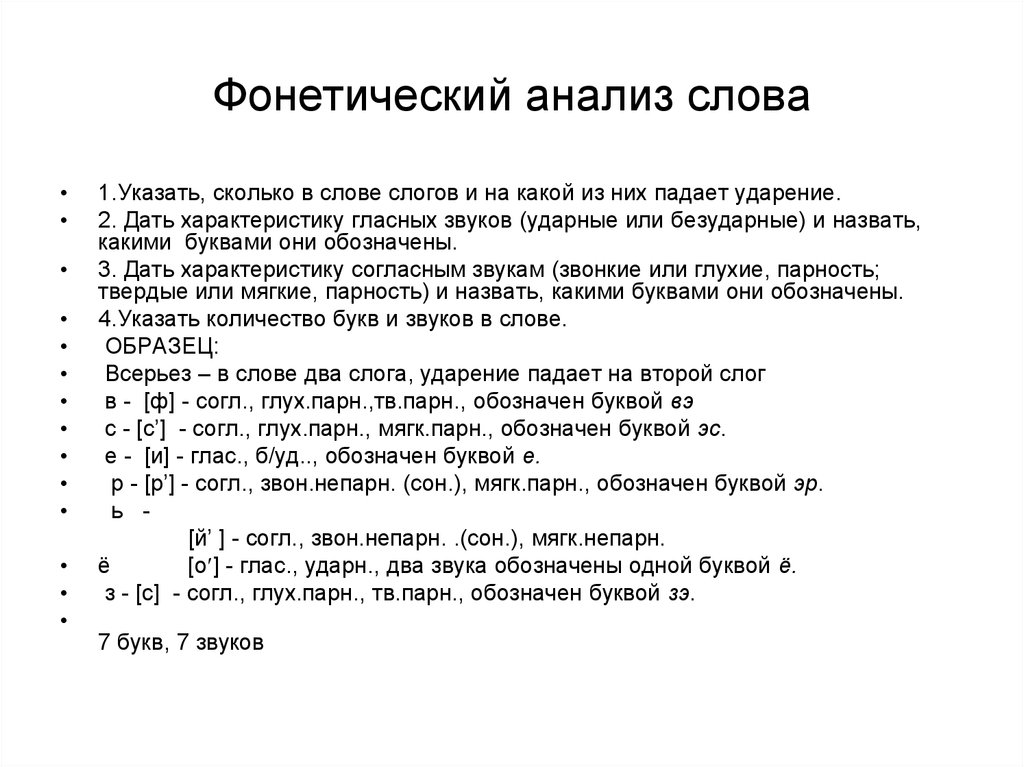

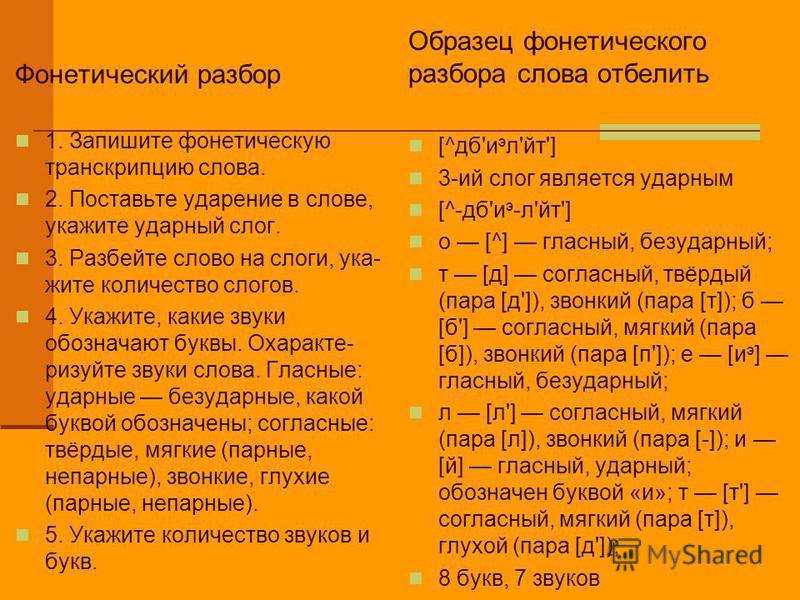

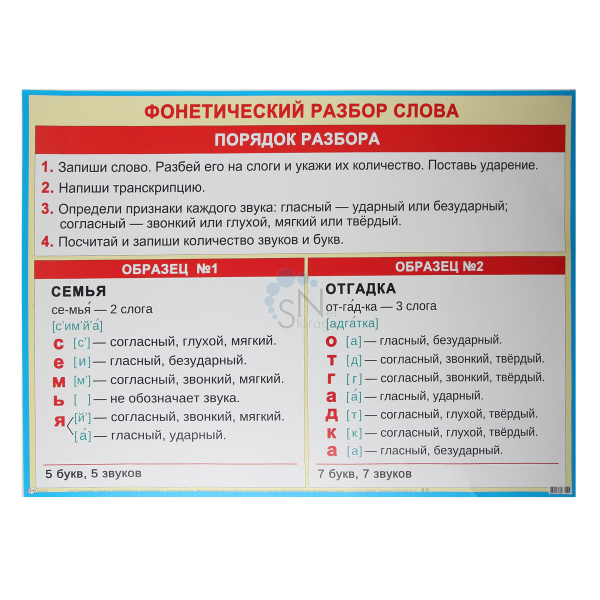

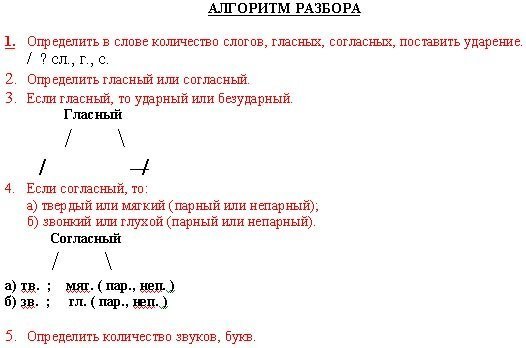

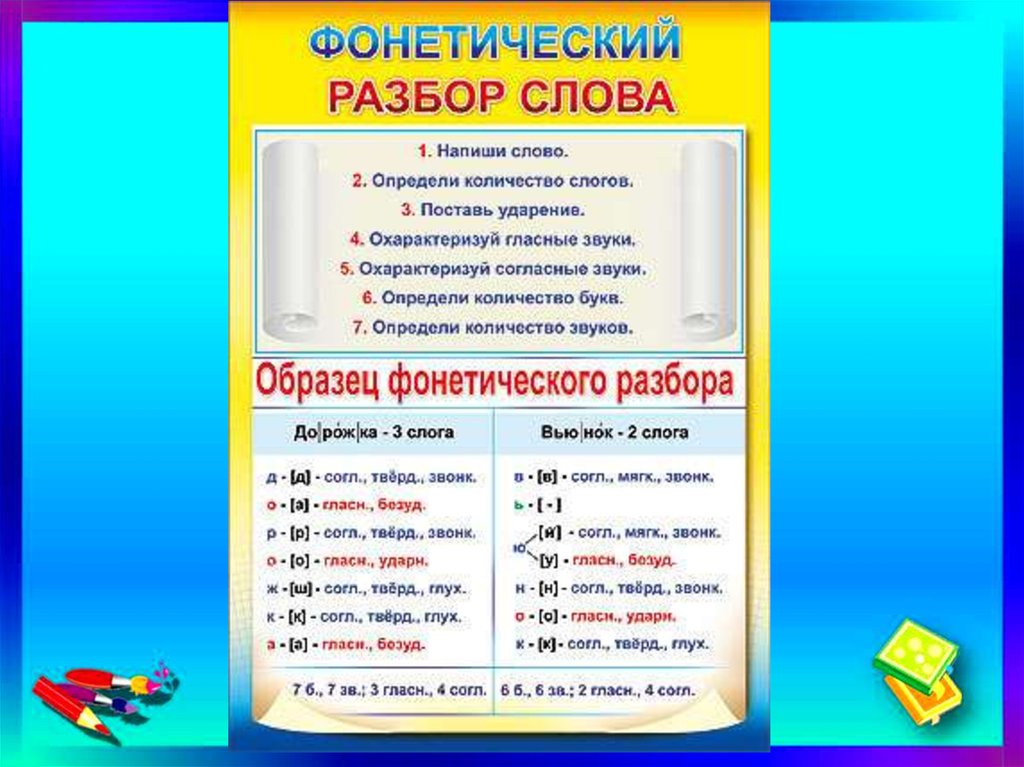

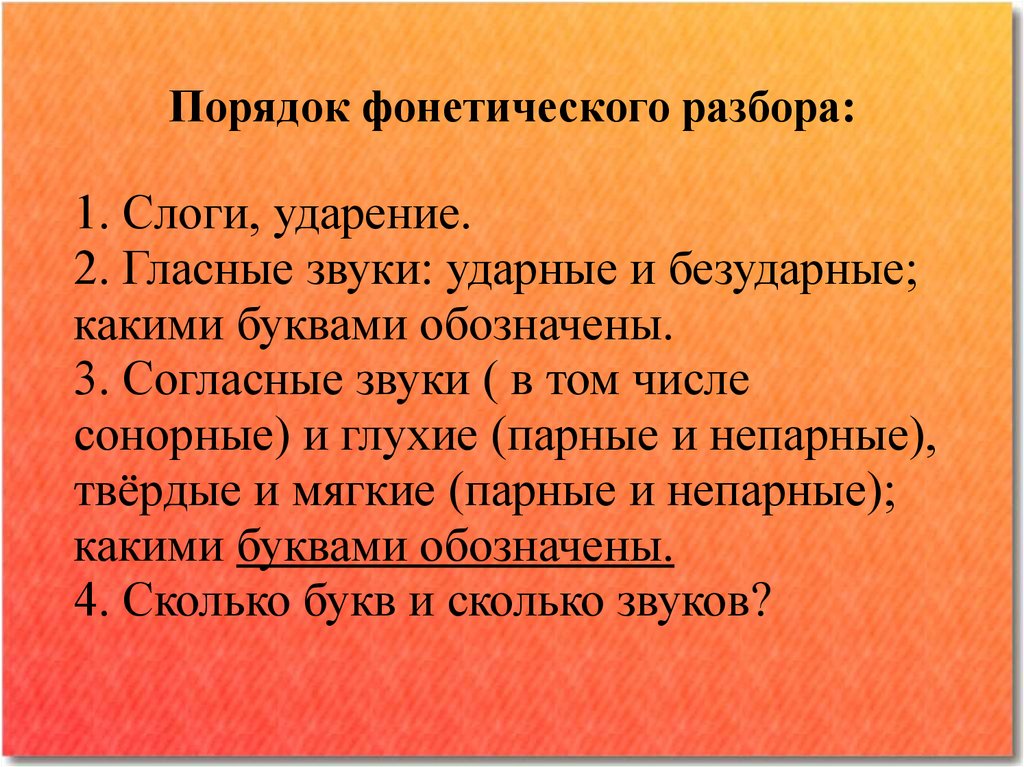

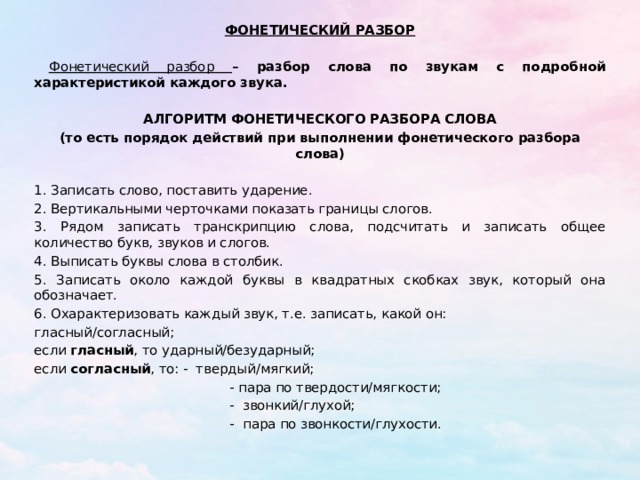

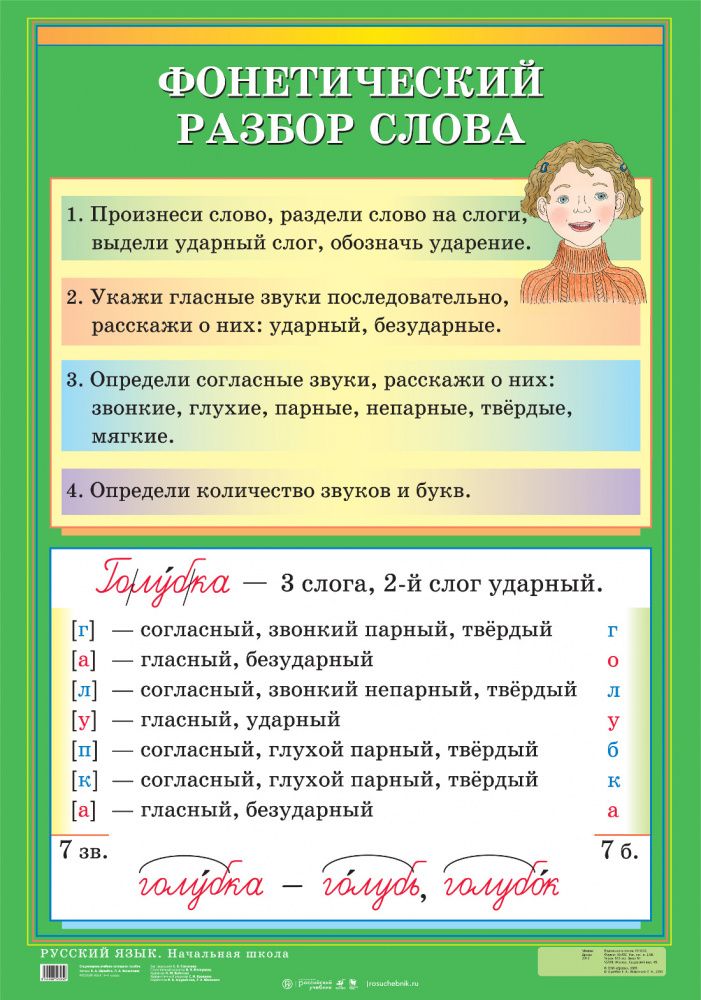

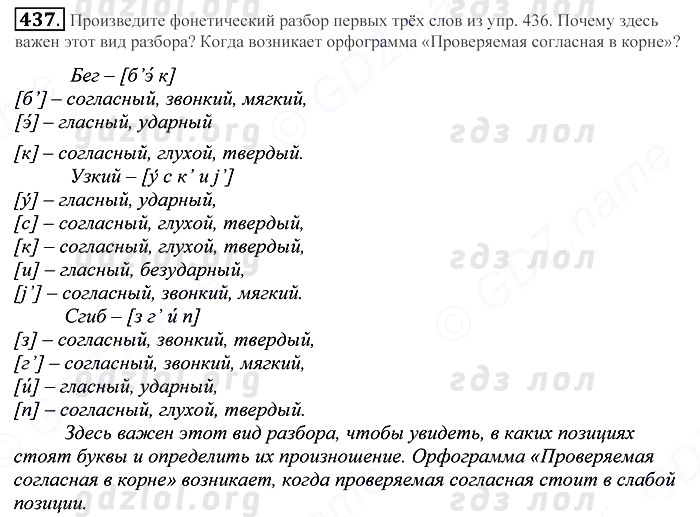

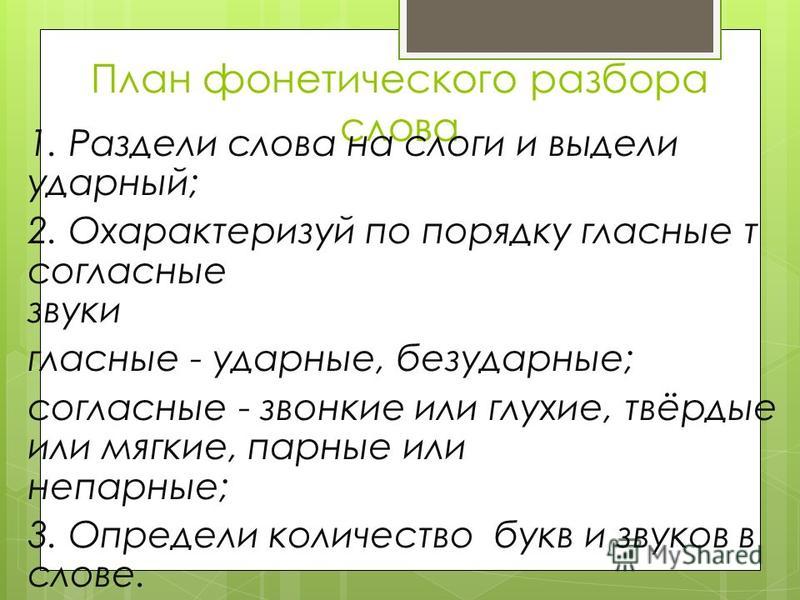

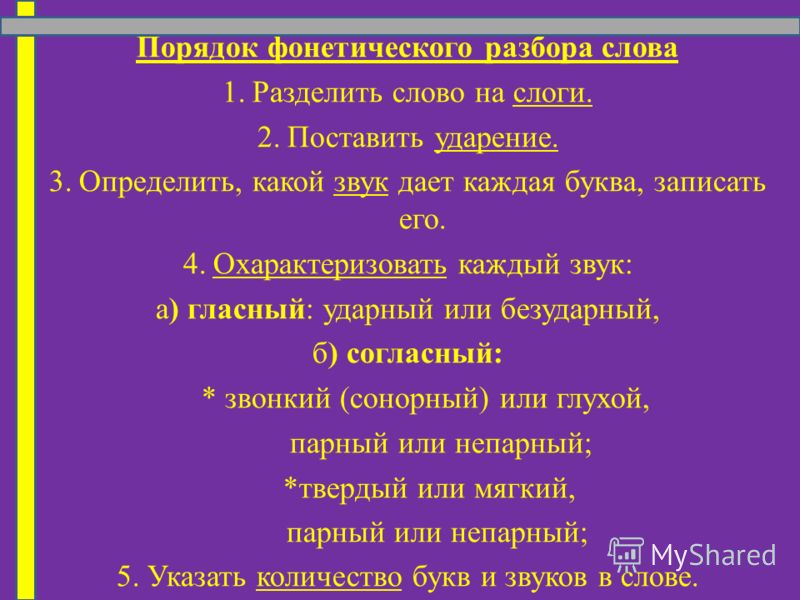

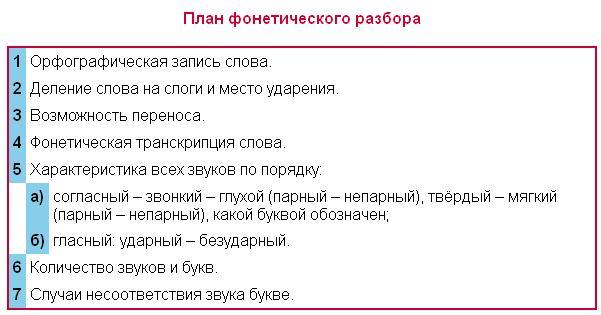

План фонетического разбора

Таким образом, фонетический разбор делается по следующему плану:

Фонетическая транскрипция видео

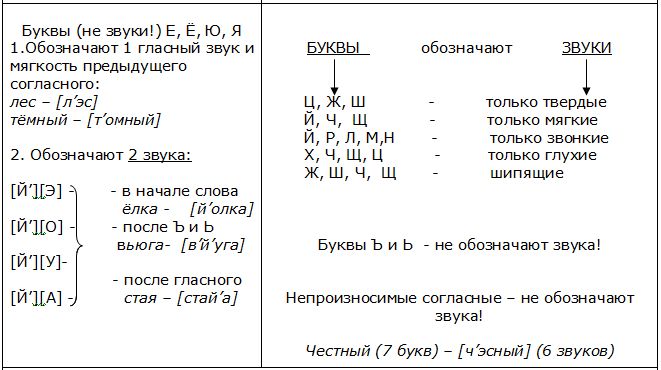

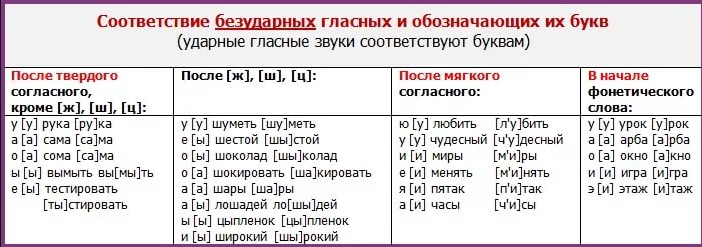

Таблицы соответствия букв и звуков для фонетического разбора

С помощью фонетического разбора можно проиллюстрировать случаи оглушения и озвончения согласных, объяснить необходимость проверки безударных гласных постановкой их в сильную позицию (под ударение), рассмотреть примеры несовпадения количества звуков и букв и т. д.

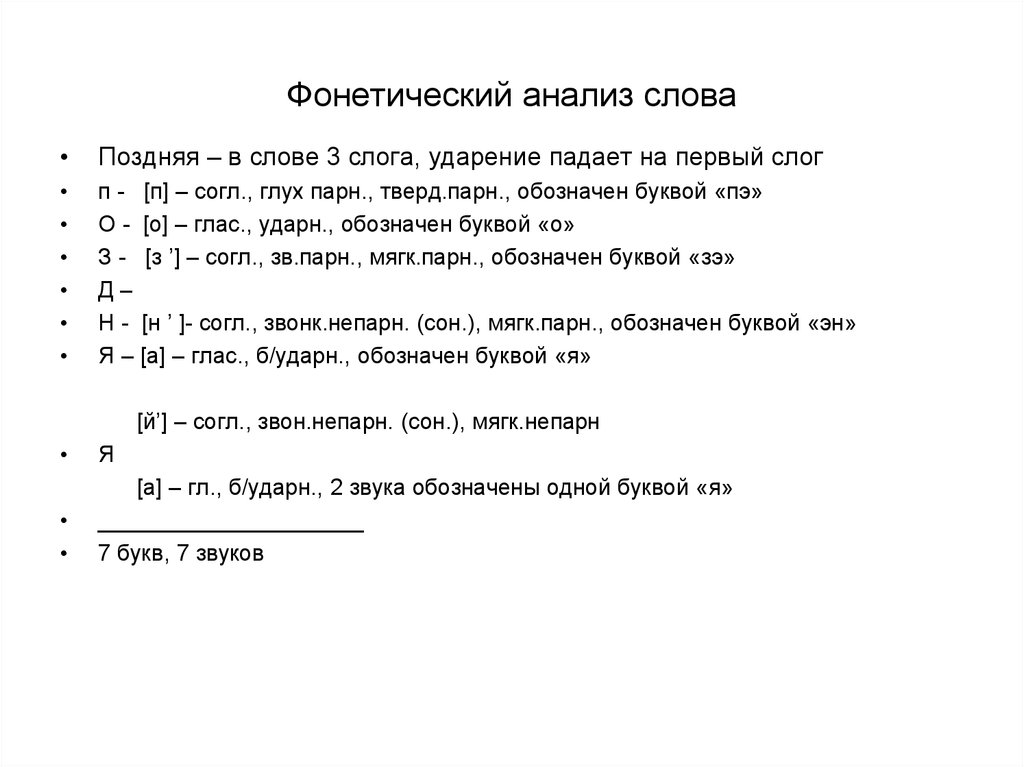

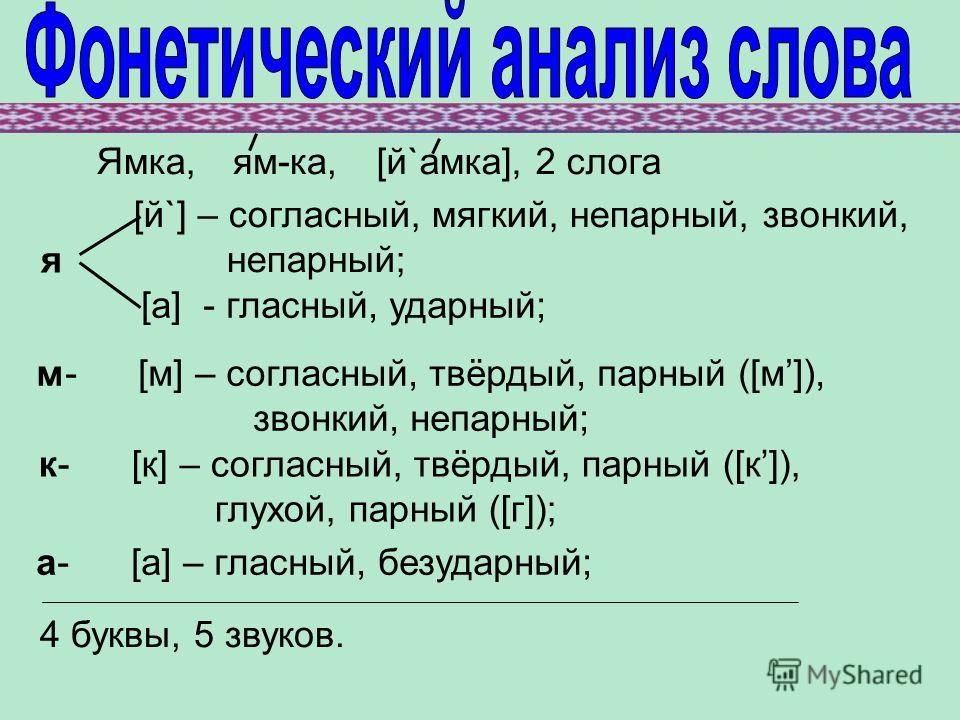

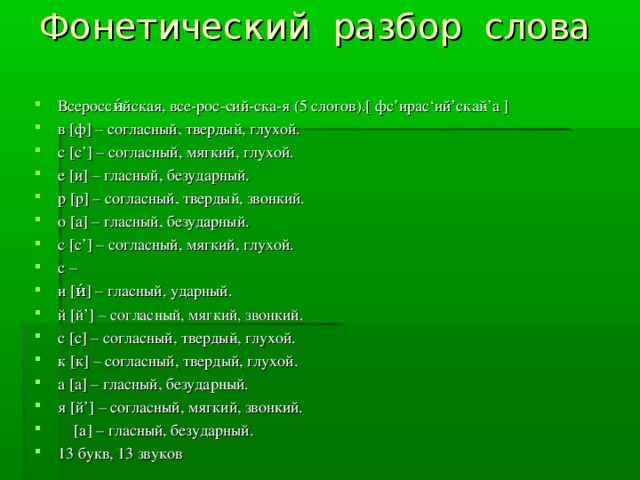

Примеры фонетического разбора

7 букв, 8 звуков; буква Я обозначает 2 звука, так как находится после гласной.

5 букв, 4 звука; звуки Д и Т сливаются в долгий [т¯], происходит оглушение звука Д.

Примеры заданий с элементами фонетического разбора

Возможны занимательные задания, помогающие пробудить интерес школьников к фонетике и орфоэпии, внимательное отношение к орфографии.

Например: определите, какие слова получатся, если произнести в обратном порядке звуки, из которых они состоят? Код, араб, ель, рай, лёд.

(Ответы: ток, пара, лей, яр, толь).

Для выполнения задания детям нужно записать транскрипцию слова и затем прочитать её наоборот: рай — [рай] — [йар] – яр.

Или задание такого типа: определите, сколько раз в предложении «Не трудиться – так и хлеба не добиться» встречаются мягкие согласные.

(Ответ 5: [н’] – 2 раза, [д’] [л’] [б’] – по 1 разу).

Для выполнения этого задания ученикам нужно записать транскрипцию всего предложения. Необходимо помнить, что в потоке речи звуки влияют друг на друга, изменяются. Например, КАК БЫ будет звучать [кагбы], то есть происходит озвончение звука [к] под влиянием последующего звонкого [б]. Подобные задания могут встретиться в олимпиадах по русскому языку.

Правила транскрибирования текста

Правильное деление на слоги помогает переносить слова с одной строки на другую, но необходимо помнить, что деление на слоги не всегда совпадает с делением слова на части для переноса. Правила переноса представлены в таблице:

Правила переноса слов

Источник

Фонетическая транскрипция – примеры, правила (5 класс, русский язык)

Устная речь – это речь звучащая. Она первична, так как появилась раньше. Если хотим, мы можем что-то записать на бумаге – это будет уже письменная речь. Но есть возможность записать и звучащую речь.

Она первична, так как появилась раньше. Если хотим, мы можем что-то записать на бумаге – это будет уже письменная речь. Но есть возможность записать и звучащую речь.

Транскрипция – что это?

Когда мы записываем что-то под диктовку, мы записываем не то, что мы слышим, а то, что мы понимаем. То есть записываем слова не так, как услышали (вада), а так, как пишется по правилам понятое нами слово (вода). И это понятно. Ведь диктующий может говорить неразборчиво, обладать плохой дикцией. Но мы его все равно понимаем. И пишем, например, не “гхуша”, а “груша”.

Но мы можем записать слово не только так, как оно пишется, но и так, как оно произносится. Вот эта запись и называется “транскрипция”.

Зачем нужна транскрипция?

Фонетическая транскрипция слова выполняет ряд функций:

Из вышесказанного понятно, что транскрипции могут быть разные. Одни передают норму, другие – реальное произношение.

Точно в соответствии с произносительной нормой говорят разве что дикторы из прошлого века.

Школьникам интересна транскрипция как основа для фонетического разбора при изучении курса русского языка. Иногда к транскрипции прибегают составители орфоэпических словарей для передачи правильного произношения.

Частичная транскрипция

Иногда прибегают к частичной транскрипции. Это обычно бывает, если надо указать правильное произношение отдельных звуков.

Например, мо[дэ]ль. Это значит, что Д перед Е не мягкое.

Как записать транскрипцию

Транскрипцию в школах на уроках русского языка выполняют в квадратных скобках с помощью букв современного русского алфавита с использованием отдельных особых транскрипционных знаков: ударение, апостроф; иногда j.

В редких случаях учителя просят пользоваться знаками “ъ” и “ь” для обозначения гласных в заударной позиции, знаками “и склонное к э”, “крышечка” и т.п. Однако обычно такие знаки используют только студенты-филологи, тогда как школьники ими не пользуются и обозначают безударные а и о в любой позиции знаком [а], а и, я и е в безударной же позиции в любом месте слова знаком [и].

Транскрипция записывается в квадратных скобках.

Даже если транскрибируется имя собственное, заглавная буква не пишется.

Можно транскрибировать слово “на слух”, если есть возможность прочесть его несколько раз вслух, протягивая каждый звук. Поскольку это бывает редко, транскрибируют обычно “по правилам”.

Основные правила:

Примеры транскрипции слов

Что мы узнали?

Транскрипция – это запись слова по звукам так, как оно произносится, или так, как оно должно произноситься. При транскрибировании школьники используют обычные буквы русского алфавита за некоторыми исключениями и особые знаки. Существует ряд правил, которым надо следовать, записывая транскрипцию. Транскрипция помогает производить фонетический разбор и является его обязательной частью.

Источник

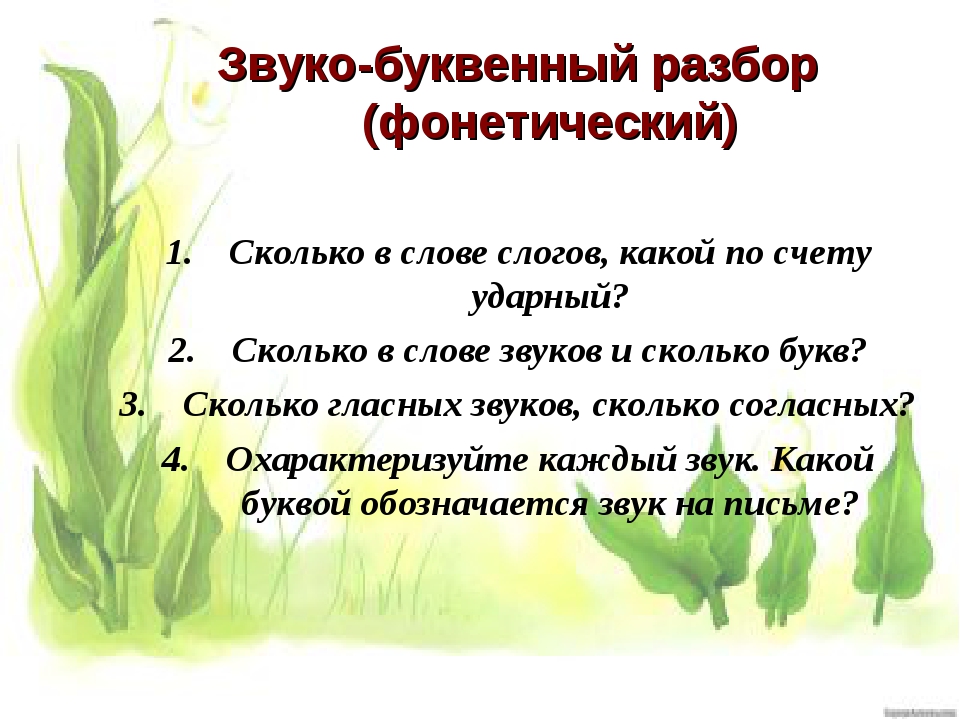

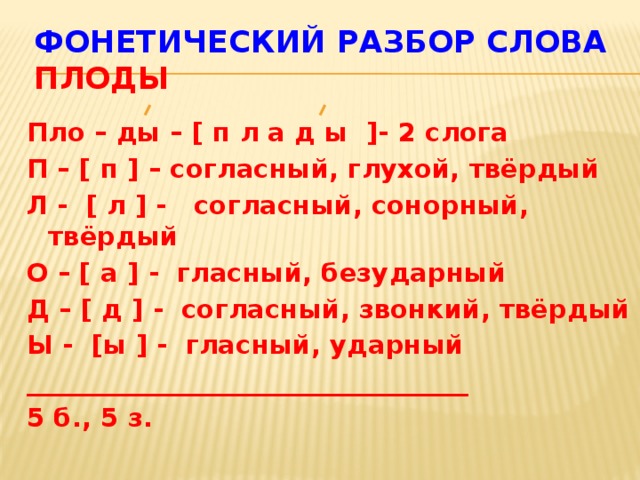

Фонетический разбор слова

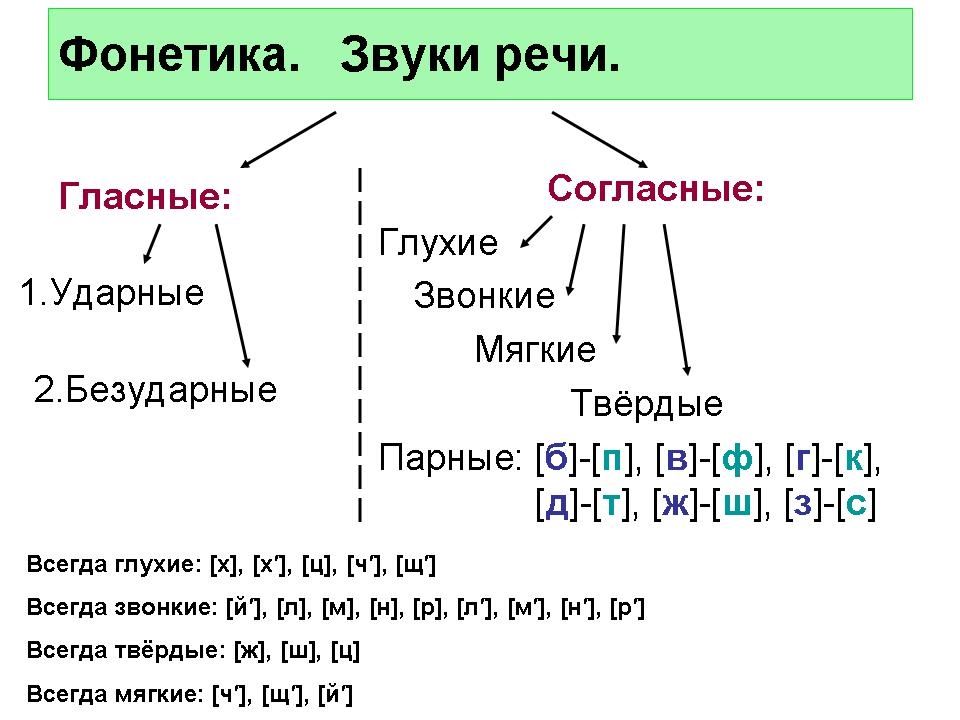

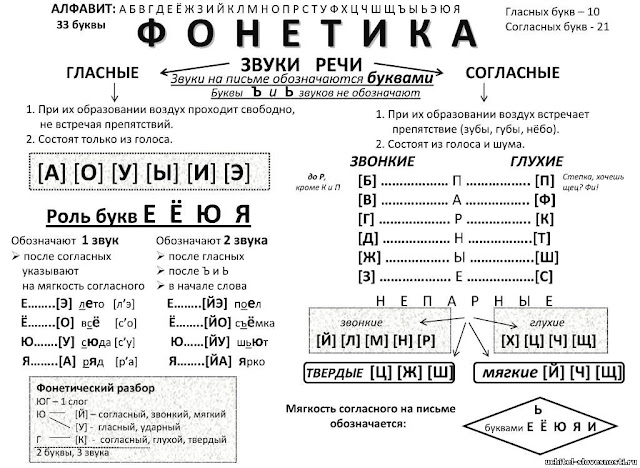

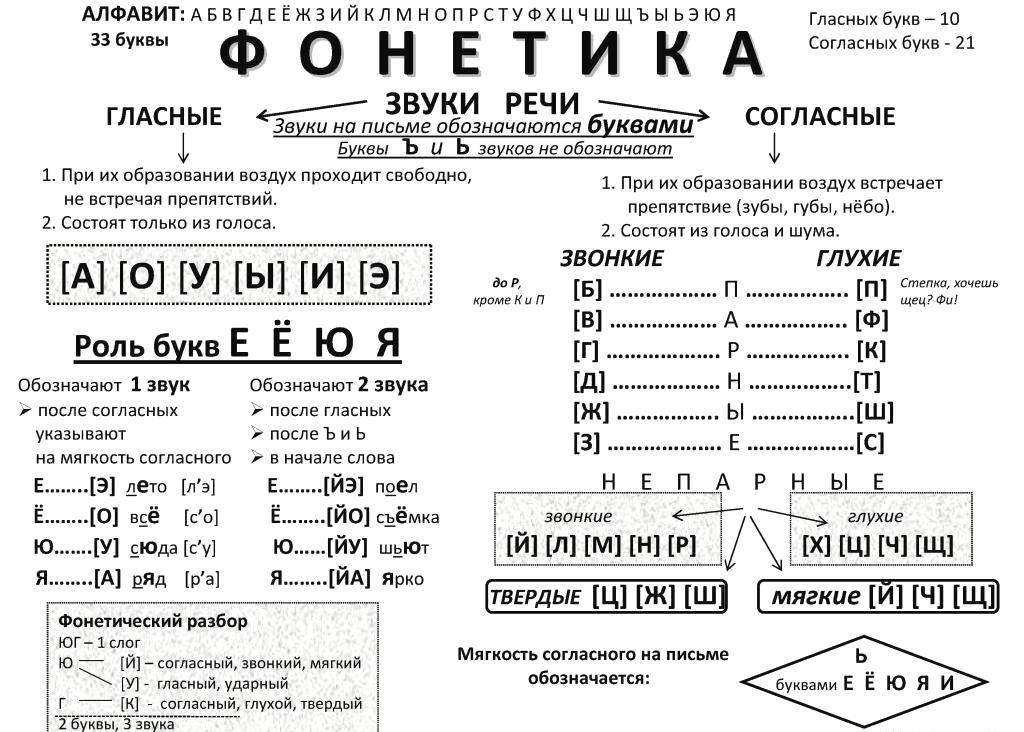

Фонетикой называют раздел языкознания, который изучает звуковую систему языка и звуки речи в целом. Фонетика — это наука о сочетании звуков в речи.

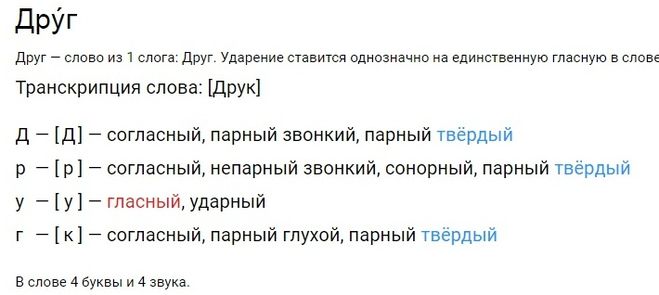

Фонетический разбор, или звуко-буквенный, — это анализ строения слогов и звуковой системы слова. Такой анализ предлагается выполнять как упражнение в учебных целях.

Под анализом понимается:

При разборе важно различать понятия «буква» и «звук». Ведь первые соответствуют орфографическим правилам, а вторые — речевым (то есть звуки анализируются с точки зрения произношения).

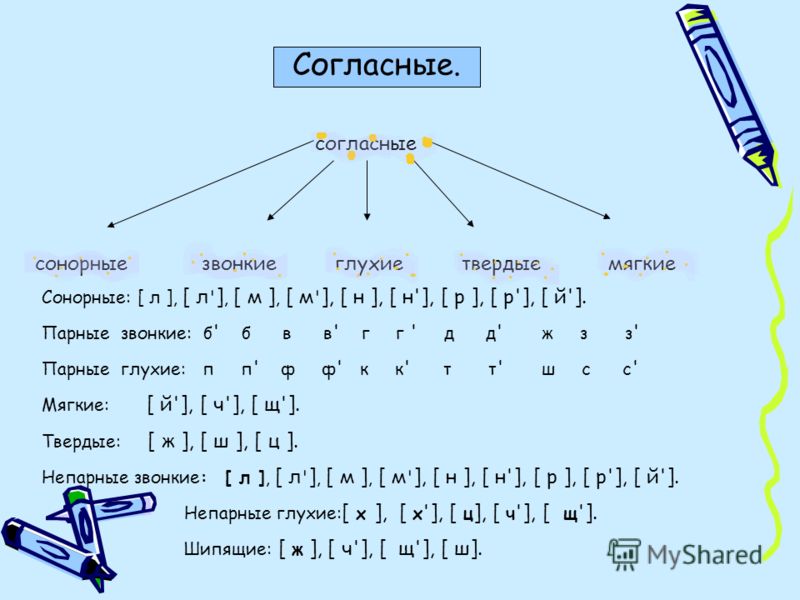

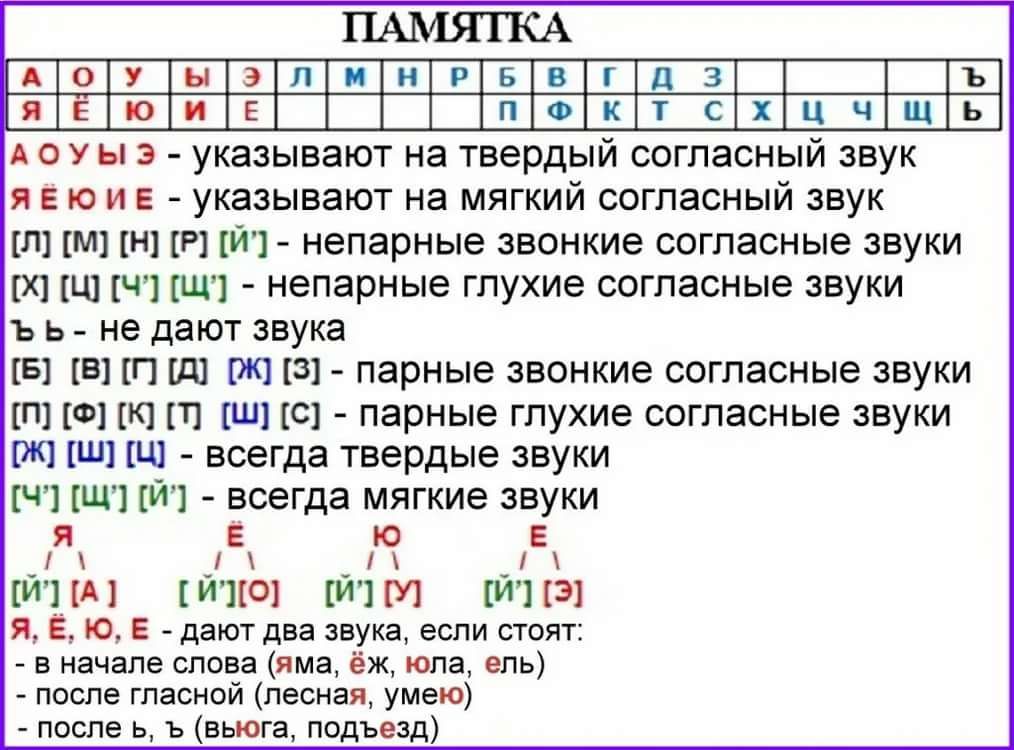

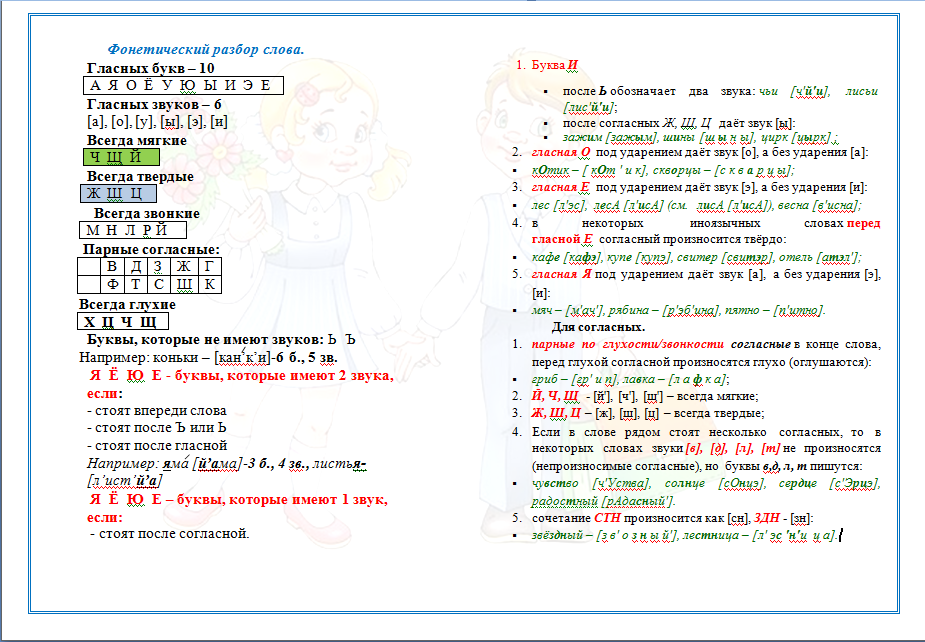

Прежде чем приступить к звуко-буквенному разбору, следует запомнить

В русском языке десять гласных звуков:

| [А] | [О] | [У] | [Ы] | [Э] | [ЙА] буква «Я» | [ЙО] буква «Ё» | [ЙУ] буква «Ю» | [И] | [ЙЭ] буква «Е» |

Первые пять обозначают, что предшествующий согласный является твердым, а вторые — мягким.

И двадцать один согласный звук:

| звонкие непарные звуки | [Й’] | [Л] | [М] | [Н] | [Р] | |

| глухие непарные | [Х] | [Ц] | [Ч’] | [Щ’] | ||

| звонкие парные | [Б] | [В] | [Г] | [Д] | [Ж] | [З] |

| глухие парные | [П] | [Ф] | [К] | [Т] | [Ш] | [С] |

Звонкими называют согласные, которые образуются с участием звука, а глухие — с помощью шума. Парными называют те согласные, которые образуют пару глухой/звонкий. Например, [Б]/[П], [В]/[Ф], [Г]/[К]. Непарными — те, которые не образуют пары: [Л], [М], [Р].

Парными называют те согласные, которые образуют пару глухой/звонкий. Например, [Б]/[П], [В]/[Ф], [Г]/[К]. Непарными — те, которые не образуют пары: [Л], [М], [Р].

При фонетическом анализе слова стоит помнить, что согласные [Ч’], [Щ’], [Й’] — всегда мягкие, вне зависимости от того, какой гласный образует с ними слог. Согласные [Ж], [Ш] и [Ц] — всегда твердые.

[Й’], [Л], [Л’], [М], [М’], [Н], [Н’], [Р], [Р’] — сонорные звуки. А значит, при произношении этих согласных звук образуется преимущественно голосом, но не шумом. Все сонорные — звонкие звуки.

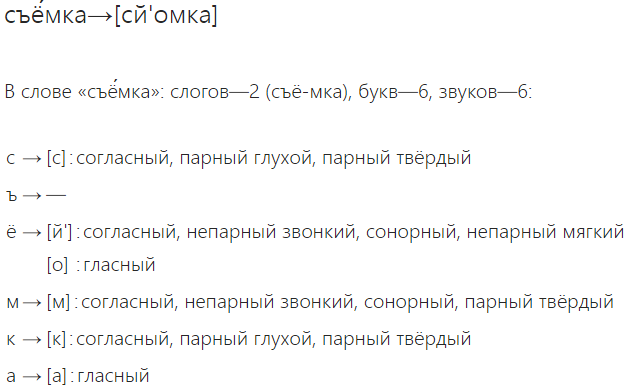

В русском алфавите есть также буквы Ь, Ъ. Они не образуют звука. Ь (мягкий знак) служит для того, чтобы смягчать согласные, после которых он ставится. Ъ (твердый знак) имеет разделительную функцию.

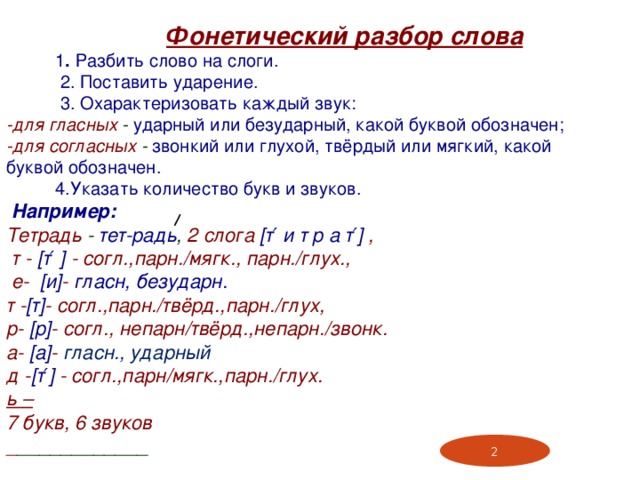

Правила разбора на звуки

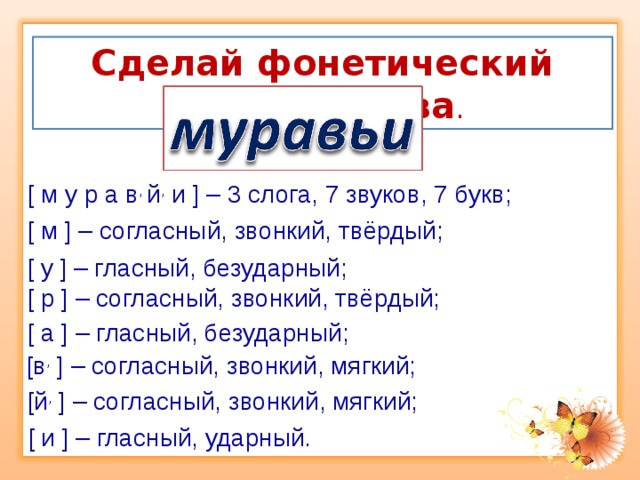

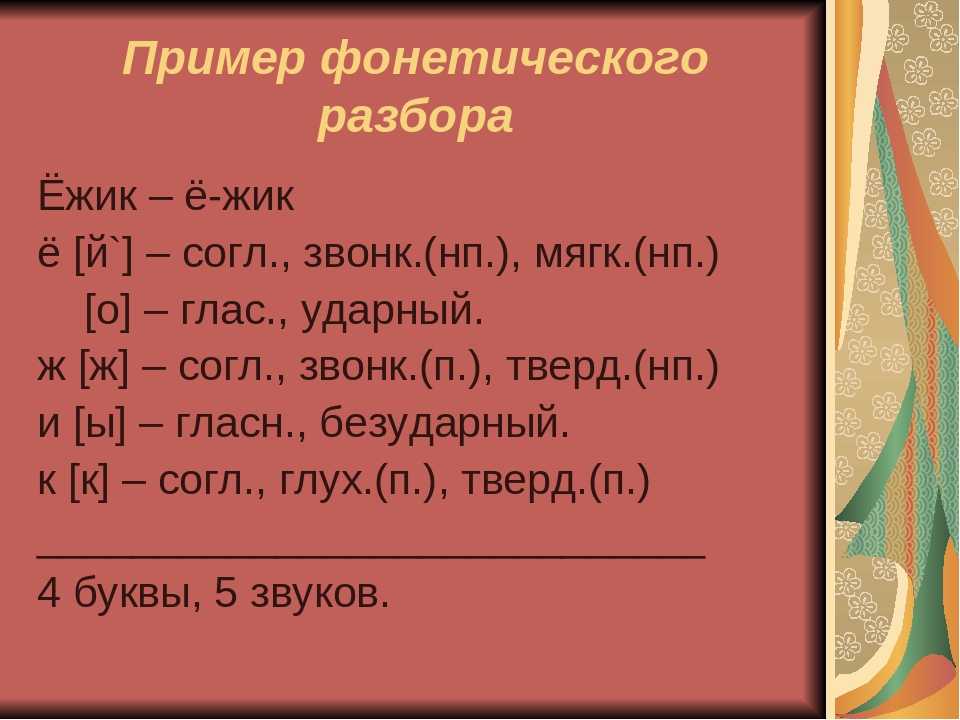

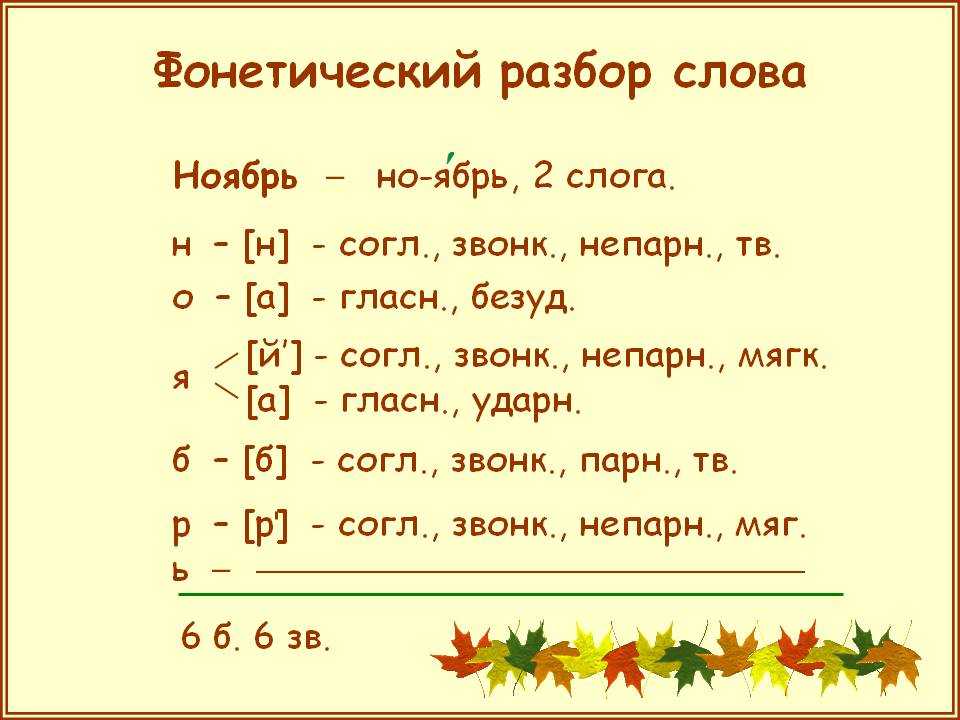

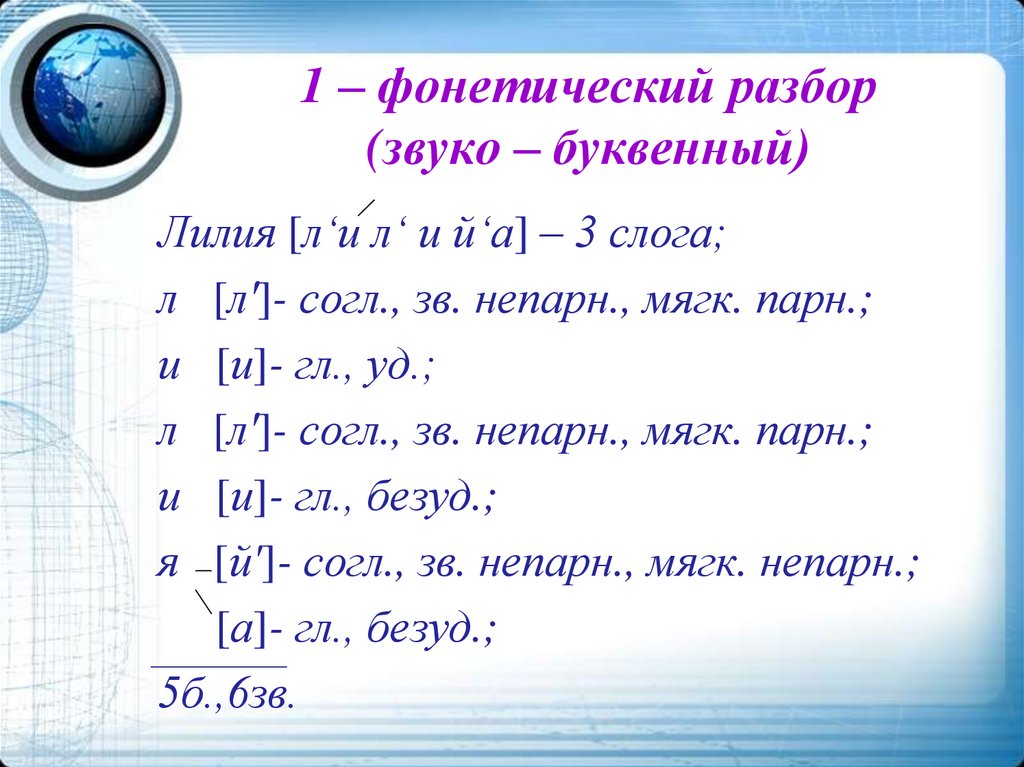

Образец звуко-буквенного разбора слова

Примеры фонетического разбора

Для примера ниже подобраны слова с наиболее интересными вариантами фонетического разбора: шестнадцатью, яростного, съестного, шестнадцатого, ерошиться, ёжиться, ёжится, ёршится, разъезжаться, съезжаться, для выполнения фонетического разбора других слов воспользуйтесь формой поиска:

Источник

Видео

Учимся составля ть транскрипцию слова (русский язык)

Фонетическая транскрипция | uchim. org

org

Правила транскрипции гласных звуков в русском языке

Русский язык. Фонетика: Фонетическая транскрипция. Центр онлайн-обучения «Фоксфорд»

Русский язык. Транскрипция

Фонетика. Фонетический разбор слова | Русский язык ЕГЭ, ЦТ

Транскрипция в русском языке. Правила написания транскрипции в русском языке.

Фонетическая транскрипция

Фонетический разбор слова | Русский язык | TutorOnline

Транскрипция для 1 класса

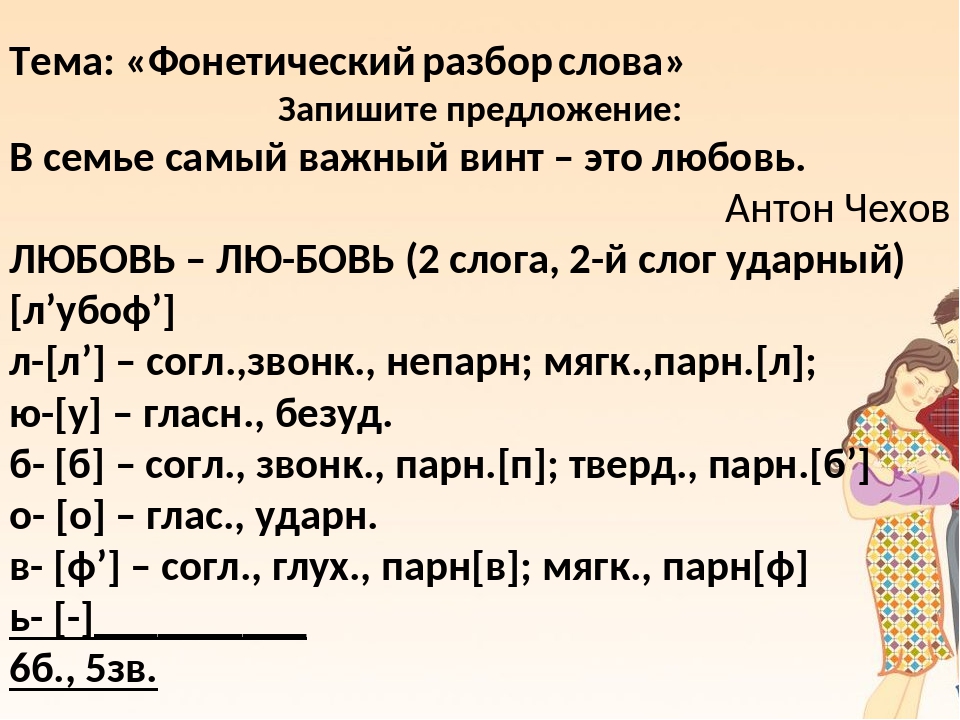

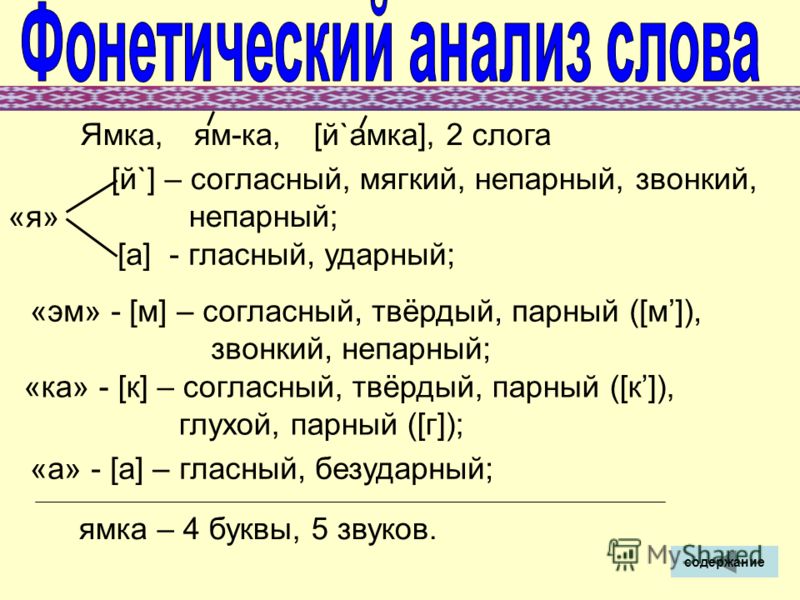

Презентация к уроку русского языка в 5 классе на тему : «Фонетический разбор слова»

Тема: «Фонетический разбор слова»

Цель: — научить учащихся производить фонетический разбор слова.

Задачи: — развивать умения различать звонкие и глухие, твердые и мягкие, парные и непарные согласные; умения правильно ставить ударение и делить слова на слоги.

Ход урока:

I.Организационный момент

— Здравствуйте, ребята. Сегодня на урок к нам пришли гости. Поздоровайтесь. Садитесь.

— Открываем тетради, записываем число, классная работа.

II.Проверка домашнего задания

— Спишите слова с доски, расставьте ударение, запишите транскрипцию.

Получается:

Земля — [з,и м л,а]

лев — [л,э ф]

цветок — [ц в,и т о к]

открыть — [а т к р ы т,]

мороз — [м а р о с,]

очки — [а ч,к,и]

— Молодцы! Вы очень хорошо справились с заданием. А теперь в середине новой строки запишем тему нашего урока «Фонетический разбор слова».

III.Изучение нового материала

— Итак, тема нашего урока «Фонетический разбор слова».

— Какую цель мы поставили перед собой на этот урок?

— Какие задачи необходимо решить для достижения нашей цели?

- Фонетический опрос

— Каждый правильный ответ +5 б. , неправильный ответ -5 б.

, неправильный ответ -5 б.

— Как называется раздел науки о языке изучающий звуки речи? (фонетика)

— На какие группы делятся звуки речи? (гласные, согласные)

— Какие звуки являются гласными? (которые состоят только из голоса)

— Какие звуки являются согласными? (которые состоят из голоса и шума)

— Какими бывают гласные звуки? (ударные и безударные)

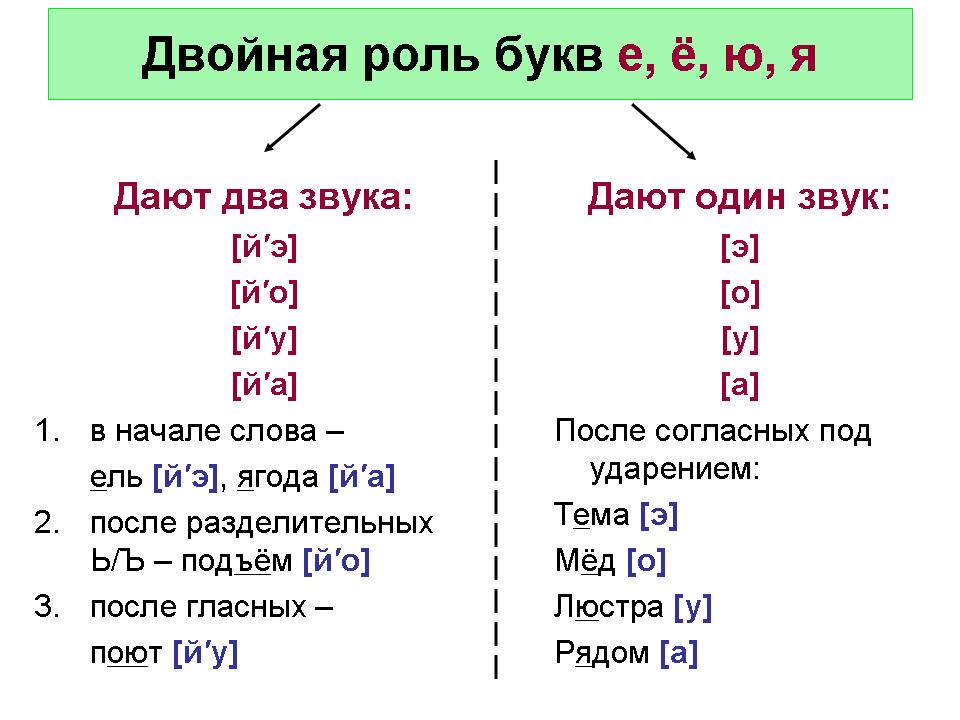

— Каким буквам отведена двойная роль? (е, ё, ю, я)

— Сколько букв в русском алфавите?

— Сколько гласных?

— Сколько согласных?

— В чем разница между буквой и звуком?

— Сколько парны согласных по глухости – звонкости?

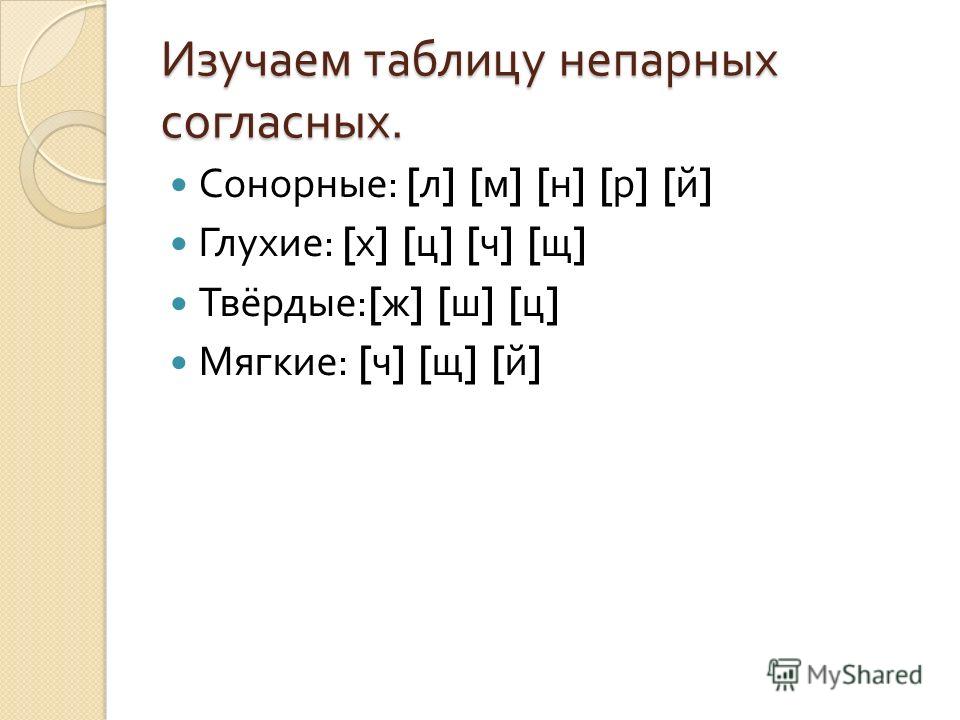

— Сколько непарных глухих? (4)

— Назовите. [х, ц, ч, щ]

— Сколько непарных мягких согласных? (3)

— Назовите. [ч,, щ,, й,]

— Сколько непарных твердых согласных? (3)

— Назовите. [ж, ш, ц]

— Сколько глысных звуков? (6)

— Сколько согласных звуков? (36)

— Сколько всего звуков? (42)

— Молодцы, ребята!

2. Физминутка

— Вышла мышка как-то раз (ходьба на месте). Поглядеть который час (повороты влево, вправо, пальцы «трубочкой» перед глазами).

Поглядеть который час (повороты влево, вправо, пальцы «трубочкой» перед глазами).

— Мышки дернули за гири (руки вверх и приседание с опусканием рук). Раз, два, три, четыре (хлопки над головой).

— Вдруг раздался страшный звон (хлопки перед собой).

— Убежали мышки вон (бег на месте).

— Отдохнули. Теперь сел ровно. Спинки выпрямили. Теперь перейдем к изучению нового материала.

Сочетание чн как правило, произносится в соответствии с написанием.

Например: Античный, дачный, качнуть.

Но в некоторых сочетаниях букв чн не так, как пишется, а по-другому [шн], например: коне[ш]но, ску[ш]но, наро[ш]но, праче[ш]ная.

В некоторых словах допускается двоякое произнашение.

Например: булочная, гречневый, сливочный.

В конце XIX – начале XX века многие слова произносились с [шн], а не с [чн]. Произношение [шн] старой московской орфоэпической нормы.

3. Объяснения учителя

— Открываем учебники на стр. смотрим план фонетического разбора.

— А теперь я покажу вам как надо выполнять фонетический разбор.

— С красной строки, с большой буквы записываем предложение:

На лесной поляне стоял старый пень1.

Пень – 1 слог.

п [п?] – согл., парн., глух., мягк.

е [э] – гл., ударн.

н [н?] – согл., непарн., сонор., мягк.

ь [-]

4 б., 3 зв. [п, э н,]

— Ребята, кому не понятно, как выполнять фонетический разбор?

IV. Закрепление изученного.

– Разгадать ребусы и выполнить фонетический разбор слов. (учащийся у доски)

воро′та – 3 слога

в [в] – согл., парн., зв., тв.

о [а] – гл., безуд.

р [р] – согл., непарн., сон., тв.

о [о] – гл., ударн.

т [т] – согл., парн., глух., тв.

а [а] – гл., безуд.

6 б., 6 зв. в а р о т а

ры′бка – 2 слога

р [р] – согл., парн., сон., тв.

ы [ы] – гл., ударн.

б [п] – согл., парн., глух., тв.

к [к] – согл., парн., глух., тв.

а [а] – гл., безуд.

5 б., 5 зв. р ы п к а

ты′ква – 2 слога

т [т] — согл. , парн., глух., тв.

, парн., глух., тв.

ы [ы] — гл., ударн.

к [к] — согл., парн., глух., тв.

в [в] — согл., парн., зв., тв.

а [а] — гл., безуд.

5 б., 5 зв. [т ы к в а]

камы?ш – 2 слога

к [к] — согл., парн., глух., тв.

а [а] — гл., безуд.

м [м] — согл., непарн., сон., тв.

ы [ы] — гл., ударн.

ш [ш] — согл., парн., глух., тв.

5 б., 5 зв. [к а м ы ш]

— Правильно произнесите записанные слова.

Что, чтобы, скучный, конечно, скворечник, яичница, гречневый, пустячный.

— Команда, все члены которого быстро и правильно справились с заданием получаете 20 баллов.

V. Подведение итогов.

VI. Домашнее задание.

— Итак, ребята, наш урок заканчивается.

— Чему мы научились сегодня на уроке?

— Достигли ли мы цели, которую поставили перед собой в начале урока?

— Что на уроке понравилось больше всего?

— Выставили оценки, заработанные вами на уроке.

— Открыли дневники, записываем домашнее задание все, кроме команды С. Боброва, выполнить фонетический разбор слов: ёж, медведь, цирк.

Боброва, выполнить фонетический разбор слов: ёж, медведь, цирк.

— Команда Семена составит связанный рассказ на тему: «Что я знаю о фонетике?»

Просмотр содержимого документа

«Презентация к уроку русского языка в 5 классе на тему : «Фонетический разбор слова» »

Презентация к уроку русского языка в 5 классе:

«Фонетический разбор слова»

Подготовила: учитель русского языка и литературы МБУ СОШ №46 Устивицкая Алёна Валерьевна

Спишите слова с доски, расставьте ударение, запишите транскрипцию .

Земля, Лев, Цветок, Открыть, Мороз, Очки

Проверь себя

[ з , и м л , а ] [ л , э ф ] [ ц в , и т о к ] [ а т к р ы т , ]

[ м а р о с , ] [ а ч , к , и ]

Фонетический опрос

— Как называется раздел науки о языке изучающий звуки речи?

— На какие группы делятся звуки речи?

— Какие звуки являются гласными?

— Какие звуки являются согласными?

— Какими бывают гласные звуки?

Фонетический опрос

— Каким буквам отведена двойная роль?

— Сколько букв в русском алфавите?

— Сколько гласных?

— Сколько согласных?

— В чем разница между буквой и звуком?

— Сколько парны согласных по глухости – звонкости?

Фонетический опрос

— Сколько непарных глухих? Назовите их.

— Сколько непарных мягких согласных? Назовите их.

— Сколько непарных твердых согласных? Назовите их.

— Сколько гласных звуков?

— Сколько согласных звуков?

— Сколько всего звуков?

Физминутка

Вышла мышка как-то раз (ходьба на месте).

Поглядеть, который час (повороты влево, вправо, пальцы

«трубочкой» перед глазами).

Мышки дернули за гири (руки вверх и приседанье с опусканием рук).

Раз, два, три, четыре (хлопки над головой).

Вдруг раздался страшный звон (хлопки перед собой).

Убежали мышки вон (бег на месте).

Сочетание чн

Сочетание чн как правило, произносится в соответствии с написанием.

Например: Античный, дачный, качнуть.

Но в некоторых сочетаниях букв чн не так, как пишется, а по-другому [шн], например: коне[ш]но, ску[ш]но, наро[ш]но, праче[ш]ная.

В некоторых словах допускается двоякое произношение.

Например: булочная, гречневый, сливочный.

Интересный факт

В конце XIX – начале XX века многие слова произносились с [шн], а не с [чн]. Произношение [шн] старой московской орфоэпической нормы.

Выполнение фонетического разбора

Пень – 1 слог.

п [п᾽] – согл., парн., глух., мягк..

е [э] – гл., ударн..

н [н᾽] – согл., непарн., сонор., мягк..

ь [-]

4 б., 3 зв.. [п, э н,]

Разгадайте ребусы и выполните фонетический разбор слов

Проверьте себя

воро′та – 3 слога

в [в] – согл., парн., зв., тв..

о [а] – гл., безуд..

р [р] – согл., непарн., сон., тв..

о [о] – гл., ударн..

т [т] – согл., парн., глух., тв..

а [а] – гл., безуд..

6 б., 6 зв.. [в а р о т а]

ры′бка – 2 слога

р [р] – согл., парн., сон., тв..

ы [ы] – гл., ударн..

б [п] – согл. , парн., глух., тв..

, парн., глух., тв..

к [к] – согл., парн., глух., тв..

а [а] – гл., безуд..

5 б., 5 зв.. [р ы п к а]

Проверьте себя

ты′ква – 2 слога

т [т] — согл., парн., глух., тв..

ы [ы] — гл., ударн..

к [к] — согл., парн., глух., тв..

в [в] — согл., парн., зв., тв..

а [а] — гл., безуд..

5 б., 5 зв.. [т ы к в а]

камы´ш – 2 слога

к [к] — согл., парн., глух., тв..

а [а] — гл., безуд..

м [м] — согл., непарн., сон., тв..

ы [ы] — гл., ударн..

ш [ш] — согл., парн., глух., тв..

5 б., 5 зв.. [к а м ы ш]

Задание 1 и 2 ВПР-5 класс. Перепишите текст, выполните разборы

ВПР по русскому языку — 5 класс. Задание 1, 2. Переписывание текста. Виды разборов: фонетический, морфемный, морфологический разборы слов, синтаксический разбор предложения.

ВАРИАНТ 1

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

Без с..ниц зимн.. лес зам..ра..т(2). С..сновая ветка заскр..пит снежная ша(б/п)ка обруш..т..ся с ёлки(1). Но нал..тит стайка с..ниц и лес вновь ож..ва..т.

С..ниц.. с писком перел..тают с ветки на ветку, с дер..ва на дер..во. Они осматрива..т кажд.. трещинку(3) в к..ре ищ..т вкус..ные семеч..ки.

С..ниц.. (не)ул..тают на зиму в тёпл.. края, как другие птиц.. . Они звонко перекл..кают..ся в зимн.. л..су. Летом лес нап..лня..т..ся и радос..но звенит птич..ими г..л..сами. А с..ниц (не)слыхать с их скромн.. пес..нкой. В лют.. стужу с..ниц.. прил..тают к избам.(4) Ребята сыпл..т для них в к..рмушки семеч..ки п..дсолнуха.

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

ВАРИАНТ 2

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

Кр..сив и п..чален русский лес ранн.. осен..ю. На з..л..том фон.. пож..лтевшей листвы выд..ляют..ся яркие пятна красно-ж..лтых клёнов(1) осин. Медленно кружат..ся в воздух.. и тихо л..жат..ся на землю лист..я.(4) От дер..ва к дер..ву прот..нулись бл..стящие с..р..бристые нити лё(г/х)кой паутины. Отцв..тают(2) поз..ние цв..ты.

Пр..зрачен и чист осенний воздух пр..зрач..на в..да в л..сных канавах овра(ж/ш)ках и руч..ях.

Тихо в осенн..м л..су, лишь ш..лестит под н..гами опавшая листва. Иногда тонко просв..стит где-то в кустах ря(б/п)чик протенька..т с..ница(3) пром..лькнёт среди сосен дроз(д/т).

Ле(г/х)ко и привольно дыш..т..ся в осенн..м л..су. И долго (не)хоч..т..ся ух..дить из него.

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

ВАРИАНТ 3

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

В..сенн..е со..нце буд..т пч..л и соб..ра..т(2) их на п..лянах.(4) Да и как им (не)проснут..ся, когда вокру(г/к) р..стёт столько цв..тов! А когда цв..тут фруктовые д..рев..я, для пч..л праз..ник. Вишня яблони груша крыж..вник см..родина – настоящ..е раздол..е для пч..линого войска. Больше всего мёда получа..т..ся из пыльц.. липы акац..и донника.

В средн..х ш..ротах к этому списку добавля..т..ся белый(3) клевер. Его пуш..стые г..ловки ра(з/с)сыпались по п..лянам и опушкам на открытых со..нцу м..стах. Утром пч..ла трудит..ся на одном из м..доносов, пока это р..стение (не)прекраща..т выр..батывать нектар. А к обеду(1) она переход..т на другой ви(д/т).

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

ВАРИАНТ 4

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

В (А,а)зи.. обита..т птица-портниха. Но эта мал..нькая швея (не)ш..ёт плат..я и ю(б/п)ки.

Когда приход..т п..ра размн..жения, она сш..ва..т два листа. Тонкий клю(в/ф) зам..ня..т(2) ей иголку. (З/с)делав клювом дыроч..ку в листе, портниха прод(е/и)ва..т заранее скрученную из хлопка или паутины ниточ..ку. Таких сте(ж/ш)ков она дела..т иной раз около д..сятка, проч..но сшивая два листоч..ка. Внутри з..лёной к..лыбельки птич..ка в..ёт гн..здо из хлопка пуха и ш..рстинок.

Птица-портниха живёт(1) вбл..зи от нас..лённых мест, в садах на плантациях. Иногда даже пос..ляет..ся на веранд.. дома и в..ёт гн..здо в ветвях комнатных(3) р..стений. Пита..т..ся птица мурав..ями но подб..ра..т и разные зёрнышки.(4)

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

ВАРИАНТ 5

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

Резн..ми, ажурн..ми, игольчат..ми появляют..ся в..сной на свет первые тр..винки. Сразу и (не)различиш.., какое р..стение проклюнулось пок..залось из влажной земли. Скоро ра(з/с)пуст..т..ся ра(з/с)прав..т..ся нежные листоч..ки.(4) И уже можно будет узнать по ним тысячелис..ник одуван..ч..к р..машку и к..локольчик.

Но самое настоящее ч..до прои(з/с)ход..т тогда, когда р..стения зацв..тают(2). И ра(з/с)цвечивают..ся з..лёные луга опушки(1) к..согоры п..ляны необыкновенными цв..точ..ными(3) узорами. Ж..лтые одуван..чики белые р..машки синие к..л..кольч..ки сразу броса..т..ся в глаза: и стебли у них высокие, и цв..тки крупные. Но среди пёстрого разнотрав..я есть и такие, вроде бы совсем неприметные, скромные, но по-своему оч..ровательные. И над этой кр..сотой разд..ют..ся птич..и трели.

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

ВАРИАНТ 6

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

Пе(в/ф)чие птиц.. уже ул..тели в тёплые края. Слышно, как в орехов..й рощ.. л..сток пересч..тыва..т каждый сучок, пока (не)уп..дёт на землю.

Вдру(г/к) на тр..пе я услышал необыч..н..ю песню. Кто-то скр..жетал клювом булькал горлом даже соб..рался св..стеть. Я ост..новился у орешины(2) и прислушался к ре(з/с)ким звукам.(4) И тут ра(з/с)гл..дел в..рону. Т..ж..лая(3) птица ра(з/с)качивалась на ветк.., будто на к..челях. Ра(з/с)пев(1) у в..роны вых..дил плохой но она пела радос. .но и (не)обр..щала на меня внимания.

.но и (не)обр..щала на меня внимания.

Может, без других птиц она почу..ствовала себя сол..в..ём Кто в рощ.. до в..сны смож..т оспорить это её право.

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

ВАРИАНТ 7

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

Причина нашего праз..нич..ного настр..ения краски ру(с,сс)кого леса.

Бе(з/с)конеч..но р..знообразны они летом. Со всех ст..рон в..днеют..ся оранжевые(3) ств..лы сосен соч..ная зел..нь елей и б. .лоснежный наря(д/т)(1) б..рёзок. Проступают снизу г..лубые полутона мха.(4) Гл..за ск..льзят по гла(д/т)кой тр..ве п..лянк.. и вдру(г/к) на барх..тном её к..вре вспыхива..т яркая бусинка. З..мл..ника!

.лоснежный наря(д/т)(1) б..рёзок. Проступают снизу г..лубые полутона мха.(4) Гл..за ск..льзят по гла(д/т)кой тр..ве п..лянк.. и вдру(г/к) на барх..тном её к..вре вспыхива..т яркая бусинка. З..мл..ника!

Алый цвет яго(д/т) сразу броса..т..ся в гл..за. Соб..ра..шь з..мл..нику и вид..шь, что много неспелой. Если бы вся она была з..лёной, мы бы прошли мимо. З..лёные ягоды на з..лёном фон.. (не)найдёшь. А спелая яго(д/т)ка(2) сама прос..т..ся в к..рзинку. Как р..зумно всё устроено в природ..!

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

ВАРИАНТ 8

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

Ч..дес..ны лунные мартовские ночи! Сказоч..ным каж..т..ся н..чной(1) лес. Иные, н..чные, слыш..т..ся звуки и г..л..са. Гугукнула сова и от..звались ей где-то д..леко другие нев..димки-совы. Пискнув тихонько, л..сная мыш.. проб..жала по снегу скрылась под пнём в сугроб.. . Опушкой леса проб..жала ост..рожная л..сица. В светл.. ночи выход..т к..рмит..ся на п..ля зайц.. .

Ещё спят в св..их тёплых(3) норах и б..рлогах б..рсуки и м..дведи. Но в мартовские днивсё чаще просыпа..т..ся м..дведь. Подр..стают(2) в б..рлогах р..дившиеся з..мой м..двежата.

Настоящая в..сна приход..т в с..р..дин.. марта. Радос..но, по-в..сеннему ч..рикают вороб..и. На л..сных тр..пинках провалива..т..ся под н..гами сне(г/к).(4)

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

ВАРИАНТ 9

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

Кр..сив и п..чален русский лес ранн.. осен..ю. На з..л..том фон.. пож..лтевшей листвы выд..ляют..ся яркие пятна красно-ж..лтых клёнов(1) осин. Медленно кружат..ся в воздух.. и тихо л..жат..ся на землю лист..я.(4) От дер..ва к дер..ву прот..нулись бл..стящие с..р..бристые нити лё(г/х)кой паутины. Отцв..тают(2) поз..ние цв..ты.

Пр..зрачен и чист осенний воздух пр..зрач..на в..да в л..сных канавах овра(ж/ш)ках и руч..ях.

Тихо в осенн..м л..су, лишь ш..лестит под н..гами опавшая листва. Иногда тонко просв..стит где-то в кустах ря(б/п)чик протенька..т с..ница(3) пром..лькнёт среди сосен дроз(д/т).

Ле(г/х)ко и привольно дыш..т..ся в осенн..м л..су. И долго (не)хоч..т..ся ух..дить из него.

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

ВАРИАНТ 10

Задание 1. Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Перепишите текст 1, раскрывая скобки, вставляя, где это необходимо, пропущенные буквы и знаки препинания.

Текст 1

Белая куропатка ж..тельница м..ховых болот и обш..рных низин. Такие м..ста обыч..но покрыты мхами брус..никой и клюквой. Ко́рм..т..ся эти птиц.. на земле и (не)взл..тают на д..рев..я. Когда на болот.. вып..да..т сне(г/к) и скрыва..т весь корм, куропатки переб..рают..ся на л..сные(3) опушки(1).

Цел..ю зиму стайки куропаток корм..т..ся поч..ками с..рё(ж/ш)ками побегами м..л..дых б..рёзок. Быва..т, что всё в нижн..й части кустов уже общипано, а до более высок..х побегов куропаткам (не)дот..нут..ся. Птиц.. перел..тают(2) и ищ..т корм на другой опушк.. .(4) Вот и в..ют..ся их д..ро(ж/ш)ки вокру(г/к) зар..слей кустарников. До сумерек стайка ещё не ра(з/с) облюбу..т нов..е место.

Ответ

Задание 2. Выполните обозначенные цифрами в тексте 1 языковые разборы:

(1) Фонетический разбор

(2)Морфемный разбор

(3)Морфологический разбор

(4) Синтаксический разбор

- Демоверсия ВПР по русскому языку 5 класс 2020

- ВПР по русскому — 5 класс

Фонематический контекст, например, правила произношения, фонотактические ограничения, фонемные N-граммы и т.

д. (epo) Патенты и патентные заявки (класс 704/E15.02)

д. (epo) Патенты и патентные заявки (класс 704/E15.02)Фонематический контекст, например, правила произношения, фонотактические ограничения, фонема N- граммы и т.д. (epo) Патенты (Класс 704/E15.02)

ФОНЕТИЧЕСКИЕ КЛЮЧИ ДЛЯ ЯПОНСКОГО ЯЗЫКА

Номер публикации: 20120004901

Резюме: Здесь описаны различные варианты фонетических ключей для японского языка. Набор правил кана применяется к символам кана, предоставленным пользователем. Символы Кана определены в алфавитном языке на основе звучания символов Кана. Затем создается полный фонетический ключ на основе определенных символов Кана. Фонетический ключ с замененной гласной создается путем замены гласной в полном фонетическом ключе, а фонетический ключ без гласной создается путем удаления гласной из полного фонетического ключа.

Затем записи кана в базе данных обрабатываются для определения соответствующей записи кана, которая имеет фонетический ключ, идентичный по меньшей мере одному из полного фонетического ключа, фонетического ключа с замещенными гласными и фонетического ключа без гласных. Соответствующие записи Kana затем представляются пользователю.

Затем записи кана в базе данных обрабатываются для определения соответствующей записи кана, которая имеет фонетический ключ, идентичный по меньшей мере одному из полного фонетического ключа, фонетического ключа с замещенными гласными и фонетического ключа без гласных. Соответствующие записи Kana затем представляются пользователю.Тип: Заявка

Подано: 30 июня 2010 г.

Дата публикации: 5 января 2012 г.

Изобретатель: ХОЗУМИ НАКАНО

Устройство и способ построения модели фонетической вариации и система фонетического распознавания и ее способ

Номер публикации: 20110119051

Аннотация: Предусмотрен аппарат построения фонетической вариационной модели, имеющий базу данных фонем для записи по меньшей мере стандартной фонетической модели языка и множества нестандартизированных фонем языка.

Идентификатор фонетического варианта идентифицирует множество фонетических вариантов между нестандартизированными фонемами и стандартной фонетической моделью. Калькулятор фонетического преобразования вычисляет множество коэффициентов функции фонетического преобразования на основе фонетических вариаций и функции фонетического преобразования. Генератор модели фонетической вариации генерирует по меньшей мере модель фонетической вариации на основе стандартной фонетической модели, функции фонетического преобразования и ее коэффициентов.

Идентификатор фонетического варианта идентифицирует множество фонетических вариантов между нестандартизированными фонемами и стандартной фонетической моделью. Калькулятор фонетического преобразования вычисляет множество коэффициентов функции фонетического преобразования на основе фонетических вариаций и функции фонетического преобразования. Генератор модели фонетической вариации генерирует по меньшей мере модель фонетической вариации на основе стандартной фонетической модели, функции фонетического преобразования и ее коэффициентов.Тип: Заявка

Подано: 15 декабря 2009 г.

Дата публикации: 19 мая 2011 г.

Заявитель: ИНСТИТУТ ИНФОРМАЦИОННОЙ ИНДУСТРИИ

Изобретатели: Хуан-Чунг Ли, Чун-Сянь Ву, Хань-Пин Шен, Чун-Кай Ван, Чиа-Синь Се

Поиск разговорных медиа по фонемам, полученным из расширенных понятий, выраженных в виде текста

Номер публикации: 20110040774

Реферат: Согласно одному варианту осуществления поиск медиа включает в себя прием поискового запроса, содержащего условия поиска.

По крайней мере один поисковый термин расширяется, чтобы получить набор концептуально эквивалентных терминов. Набор концептуально эквивалентных терминов преобразуется в набор поисковых фонем. Файлы, в которых записаны фонемы, ищутся в соответствии с набором поисковых фонем. Файл, содержащий фонему, совпадающую хотя бы с одной фонемой поиска, выбирается и выводится клиенту.

По крайней мере один поисковый термин расширяется, чтобы получить набор концептуально эквивалентных терминов. Набор концептуально эквивалентных терминов преобразуется в набор поисковых фонем. Файлы, в которых записаны фонемы, ищутся в соответствии с набором поисковых фонем. Файл, содержащий фонему, совпадающую хотя бы с одной фонемой поиска, выбирается и выводится клиенту.Тип: Заявка

Подано: 14 августа 2009 г.

Дата публикации: 17 февраля 2011 г.

Заявитель: Компания Raytheon

Изобретатели: Брюс Э. Пиплс, Майкл Р. Джонсон, Кристофер Д. Барр

Неконтролируемая маркировка акцента на уровне предложения

Номер патента: 7844457

Реферат: Раскрываются способы автоматической маркировки ударениями без маркировки данных вручную.

Методы предназначены для использования распределения ударения между функциональными и содержательными словами.

Методы предназначены для использования распределения ударения между функциональными и содержательными словами.Тип: Грант

Подано: 20 февраля 2007 г.

Дата патента: 30 ноября 2010 г.

Правопреемник: Корпорация Microsoft

Изобретатели: Инин Чен, Фрэнк Као-пин Сун, Мин Чу

Система проверки орфографии, включая фонетический орфограф

Номер патента: 7831911

Резюме: Система проверки правописания включает механизм проверки правописания букв.

Механизм правописания букв сконфигурирован для выбора множества строк-кандидатов целевых букв, которые точно соответствуют исходной строке с ошибкой. Система проверки орфографии включает механизм проверки правописания фонем. Механизм написания фонем сконфигурирован для выбора множества возможных целевых строк фонем, которые точно соответствуют исходной строке с ошибкой. Модуль ранжирования сконфигурирован так, чтобы объединять целевые строки-кандидаты букв и целевые строки-кандидаты фонемы в комбинированный список целевых строк-кандидатов. Модуль ранжирования также сконфигурирован для ранжирования списка возможных целевых строк, чтобы предоставить список лучших целевых строк-кандидатов для исходной строки с ошибками.

Механизм правописания букв сконфигурирован для выбора множества строк-кандидатов целевых букв, которые точно соответствуют исходной строке с ошибкой. Система проверки орфографии включает механизм проверки правописания фонем. Механизм написания фонем сконфигурирован для выбора множества возможных целевых строк фонем, которые точно соответствуют исходной строке с ошибкой. Модуль ранжирования сконфигурирован так, чтобы объединять целевые строки-кандидаты букв и целевые строки-кандидаты фонемы в комбинированный список целевых строк-кандидатов. Модуль ранжирования также сконфигурирован для ранжирования списка возможных целевых строк, чтобы предоставить список лучших целевых строк-кандидатов для исходной строки с ошибками.Тип: Грант

Подано: 8 марта 2006 г.

Дата патента: 9 ноября 2010 г.

Правопреемник: Корпорация Microsoft

Изобретатель: Уильям Д. Рэмси

Система и способ распознавания многоязычной речи

Номер патента: 7761297

Реферат: Система распознавания многоязычной речи. Изобретаемая система включает в себя механизм моделирования речи, механизм поиска речи и механизм принятия решений. Механизм моделирования речи принимает и преобразует смешанный многоязычный речевой сигнал в речевые характеристики. Механизм поиска речи находит и сравнивает наборы данных-кандидатов. Механизм принятия решений выбирает результирующие речевые модели из речевых моделей-кандидатов и генерирует речевую команду.

Тип: Грант

Подано: 18 февраля 2004 г.

Дата патента: 20 июля 2010 г.

Правопреемник: Delta Electronics, Inc.

Изобретатель: Юн-Вен Ли

МЕТОД И УСТРОЙСТВО ДЕКОДЕРА MELODIS CRYSTAL

Номер публикации: 20100121643

Реферат: Раскрытая технология относится к системе и способу быстрого, точного и распараллеливаемого речевого поиска, называемому кристаллическим декодером.

Это особенно полезно для поисковых приложений, в отличие от диктовки. Он может достигать как скорости, так и точности, не жертвуя одним ради другого. Он может искать различные варианты записей в справочной базе данных без значительного увеличения времени обработки. Даже основную часть декодирования можно распараллелить по мере увеличения количества слов, чтобы поддерживать быстрое время отклика.

Это особенно полезно для поисковых приложений, в отличие от диктовки. Он может достигать как скорости, так и точности, не жертвуя одним ради другого. Он может искать различные варианты записей в справочной базе данных без значительного увеличения времени обработки. Даже основную часть декодирования можно распараллелить по мере увеличения количества слов, чтобы поддерживать быстрое время отклика.Тип: Заявка

Подано: 2 ноября 2009 г.

Дата публикации: 13 мая 2010 г.

Заявитель: Melodis Corporation

Изобретатели: Кейван Мохаджер, Сейед Маджид Эмами, Джон Гроссман, Джо Чжо Со Аунг, Сина Сохангир

СИСТЕМА ОБРАБОТКИ РЕЧИ, МЕТОД ОБРАБОТКИ РЕЧИ И ПРОГРАММА ОБРАБОТКИ РЕЧИ

Номер публикации: 200

401ПРЕОБРАЗОВАНИЕ ГРАФЕМ В ФОНЕМЫ С ИСПОЛЬЗОВАНИЕМ АКУСТИЧЕСКИХ ДАННЫХ

Номер публикации: 200

153

Abstract: Описано использование акустических данных для улучшения преобразования графемы в фонему для распознавания речи, например, для более точного распознавания произносимых имен в системе голосового набора.

Описана совместная модель акустики и графемы (акустические данные, последовательности фонем, последовательности графем и выравнивание между последовательностями фонем и последовательностями графем), а также переобучение с помощью обучения максимального правдоподобия и дискриминационного обучения адаптации параметров модели графонемы с использованием акустических данных. Также описан неконтролируемый сбор графемных меток для полученных акустических данных, что позволяет автоматически получать значительное количество фактических выборок, которые можно использовать при переобучении. Речевой ввод, который не соответствует порогу достоверности, может быть отфильтрован, чтобы не использоваться повторно обученной моделью.

Описана совместная модель акустики и графемы (акустические данные, последовательности фонем, последовательности графем и выравнивание между последовательностями фонем и последовательностями графем), а также переобучение с помощью обучения максимального правдоподобия и дискриминационного обучения адаптации параметров модели графонемы с использованием акустических данных. Также описан неконтролируемый сбор графемных меток для полученных акустических данных, что позволяет автоматически получать значительное количество фактических выборок, которые можно использовать при переобучении. Речевой ввод, который не соответствует порогу достоверности, может быть отфильтрован, чтобы не использоваться повторно обученной моделью.Тип: Заявка

Подано: 7 декабря 2007 г.

Дата публикации: 11 июня 2009 г.

Заявитель: MICROSOFT CORPORATION

Изобретатели: Сяо Ли, Асела Дж. Р. Гунавардана, Алехандро Асеро

СПОСОБ И УСТРОЙСТВО, ОТНОСЯЩИЕСЯ К ОБРАБОТКЕ ВЫБРАННОГО АУДИОКОНТЕНТА С ИСПОЛЬЗОВАНИЕМ ПОИСКОВОГО ПРОЦЕССА РАСПОЗНАВАНИЯ РЕЧИ С МНОЖЕСТВЕННЫМ РАЗРЕШЕНИЕМ

Номер публикации: 20080162129

Abstract: Предоставляется (101) множество кадров дискретизированного аудиоконтента, а затем обрабатывается (102) это множество кадров с использованием процесса поиска распознавания речи, который включает, по меньшей мере частично, поиск не менее двух из границ состояний, границ подслов и границ слов с использованием разных разрешений поиска.

Тип: Заявка

Подано: 29 декабря 2006 г.

Дата публикации: 3 июля 2008 г.

Заявитель: MOTOROLA, INC.

Изобретатель: Ян Мин Ченг

СИНХРОННЫЙ ПЕРЕВОД ЛЕКЦИЙ И ВЫСТУПЛЕНИЙ В ОТКРЫТОМ ОБЛАСТИ

Номер публикации: 20080120091

Резюме: Открытая система речевого перевода в режиме реального времени для синхронного перевода устной презентации, которая представляет собой устный монолог, состоящий из лекции, выступления, презентации, коллоквиума и семинар.

Система включает в себя блок автоматического распознавания речи, сконфигурированный для приема звука, содержащего устное представление на первом языке, и для непрерывного создания словесных гипотез, и блок машинного перевода, который получает гипотезы, при этом блок машинного перевода выводит перевод на второй язык. , из устной презентации.

Система включает в себя блок автоматического распознавания речи, сконфигурированный для приема звука, содержащего устное представление на первом языке, и для непрерывного создания словесных гипотез, и блок машинного перевода, который получает гипотезы, при этом блок машинного перевода выводит перевод на второй язык. , из устной презентации.Тип: Заявка

Подано: 26 октября 2007 г.

Дата публикации: 22 мая 2008 г.

Изобретатели: Александр Вайбель, Кристиан Фюген

Система и метод использования таблицы соответствий для сжатия руководства по произношению

Номер патента: RE40458

Резюме: Подпрограммы синтаксического анализа извлекают из обычного словаря произношения запись, которая включает словарное слово и словарные фонемы, представляющие произношение словарного слова.

Таблица соответствий используется для сжатия словаря произношения. Таблица соответствий включает в себя наборы соответствий для конкретного языка, каждый набор имеет запись текста соответствия, запись фонемы соответствия, представляющую произношение записи текста соответствия, и уникальный символ, идентифицирующий набор соответствий. Система сопоставления сравнивает словарную статью с наборами соответствий и заменяет словарную статью символами, представляющими наилучшие совпадения. При отсутствии совпадения могут использоваться символы, представляющие немой текст или несопоставленные фонемы. Символы соответствия, представляющие наилучшие совпадения, представляют собой сжатые записи словаря произношения. Система сопоставления также генерирует наборы кодов декодера для последующего преобразования наборов символов.

Таблица соответствий используется для сжатия словаря произношения. Таблица соответствий включает в себя наборы соответствий для конкретного языка, каждый набор имеет запись текста соответствия, запись фонемы соответствия, представляющую произношение записи текста соответствия, и уникальный символ, идентифицирующий набор соответствий. Система сопоставления сравнивает словарную статью с наборами соответствий и заменяет словарную статью символами, представляющими наилучшие совпадения. При отсутствии совпадения могут использоваться символы, представляющие немой текст или несопоставленные фонемы. Символы соответствия, представляющие наилучшие совпадения, представляют собой сжатые записи словаря произношения. Система сопоставления также генерирует наборы кодов декодера для последующего преобразования наборов символов.Тип: Грант

Подано: 13 января 2003 г.

Дата патента: 12 августа 2008 г.

Правопреемник: Apple Inc.

Изобретатель: Тимоти Фреденбург

Резюме: Предусмотрена система перевода речи для приема исходной речи на первом языке, перевода входного содержания на второй язык и вывода результата перевода в виде речь, включающая в себя: часть обработки ввода для приема ввода исходной речи и генерирования из исходной речи текста на исходном языке и просодической информации исходной речи; часть перевода для генерирования переведенного предложения путем перевода первого языка на второй язык; информацию о преобразовании просодических признаков, включающую в себя ассоциированную просодическую информацию между первым языком и вторым языком; часть преобразования просодических признаков для преобразования просодической информации исходной речи в просодическую информацию речи, которая должна быть выведена; и часть синтеза речи для вывода переведенного предложения в виде речи, синтезированной на основе просодической информации речи, которая должна быть выведена.

Тип: Заявка

Подано: 13 ноября 2008 г.

Дата публикации: 13 августа 2009 г.

Изобретатель: Шехуэй Бу

Фонологическая и фонематическая осведомленность: на практике

Эти упражнения будут эффективными для большинства учащихся, но дети по-разному реагируют на них. Некоторым студентам потребуется гораздо больше практики, чем другим, и то, что хорошо работает для большинства студентов, не обязательно будет эффективным для всех.

Упражнения на понимание языка

В этом разделе

Подсчет слов в предложении

Подсчет слов в предложении может показаться простым. Но когда мы говорим, мы произносим слова вместе. Маленьким детям важно знать, что поток речи состоит из отдельных слов. Для детей с низким уровнем владения языком или детей, изучающих английский язык, это занятие особенно важно. Совершенно нормально брать предложения из рассказа. Язык должен быть близок к общеупотребительной речи.

Совершенно нормально брать предложения из рассказа. Язык должен быть близок к общеупотребительной речи.

Шаги:

- Дайте каждому ребенку манипуляцию или манипуляции, с помощью которых можно считать слова в предложении.

- Продиктуйте предложение. Предложения должны быть четко сформулированы, но не запинаясь, искусственно. Слова должны идти вместе, как в естественной речи.

- Не диктуйте сбивчиво: «Мама [пауза] пошла [пауза] в [пауза] магазин [пауза]».

- Будьте осторожны, когда диктуете такие фразы, как «собирается», «будет», «используется», чтобы произносить два слова. Не говорите «собираюсь», «буду», «усета» и т. д.

- Все учащиеся повторяют предложение.

- Один ученик использует манипуляции для подсчета слов.

- Все учащиеся используют манипуляции для подсчета слов в одном предложении.

Повторите эти шаги с 10 предложениями.

Следуя этим шагам, учащиеся проходят индивидуальную и групповую практику, чтобы обеспечить максимальное количество практики в кратком упражнении.

Один из использованных манипуляторов — бумажный кролик, вырезанный и прикрепленный к деревянной палочке. Учащиеся «прыгают за кроликом» для каждого слова в предложении. Другими манипуляциями являются фишки для бинго или крышки от бутылок, которые подсчитываются за каждое слово.

Предложения должны начинаться с двух-пяти слов, затем должны становиться немного длиннее, но обычно не должны превышать восьми слов.

Вернуться к началу

Фонологические занятия

Подсчет слогов

Подсчет слогов требует, чтобы учащийся знал, что такое слог. Познакомить со словарным словом: слог. Слоги можно объяснить детям следующим образом:

«Слова состоят из слогов. В некоторых словах 1 слог. В некоторых словах много слогов. Наш рот знает, где находятся слоги. Давайте используем рот, чтобы чувствовать слоги. Смотри на меня. Я буду использовать нечто, называемое сжатыми губами, чтобы чувствовать слоги. Я крепко сомкну губы и прокричу слово «класс».

Плотно закройте губы и крикните «класс». Студенты услышат два приглушенных крика.

«Я услышал два крика. Я почувствовал два толчка воздуха. Я хотел открыть рот 2 раза. Это означает, что в слове «класс» два слога. Я поднимаю два пальца, чтобы показать, сколько слогов в слове «класс». Сделай это со мной». Затем проведите группу через два примера.

Шаги:

- Диктуем слова естественным образом.

- Избегайте сбивчивой диктовки: «mon [pause] ster»

- Диктуйте слова так, как они произносятся, а не как пишутся. Например, скажите «DOC-ter», а не «doct-OR».

- Все учащиеся повторяют слово.

- Все ученики выкрикивают это слово с зажатыми губами.

- Все учащиеся пальцами показывают, сколько слогов.

Повторите эти шаги с 15 словами. Первые уроки должны включать слова с одним и двумя слогами. Затем включите слова с тремя слогами. Когда учащиеся овладеют навыками, введите несколько сложных слов из четырех или более слогов. Не забудьте также включить одно-, двух- и трехсложные слова.

Не забудьте также включить одно-, двух- и трехсложные слова.

Потренировавшись, избавьтесь от сжатых губ:

Шаги:

- Диктуем слова в естественной манере.

- Все учащиеся повторяют слово.

- Все учащиеся пальцами показывают, сколько слогов.

Вернуться к началу

Сегментация слогов

Сегментация слогов легко осваивается после того, как учащиеся могут использовать сжатые губы для подсчета слогов. Лучше всего ограничить это занятие словами, состоящими из трех или менее слогов.

«Я могу произнести слово, затем произнести каждый слог в слове. Как я говорю каждый слог, я кладу карту. Раскладываю карты слева направо. Смотри на меня. Я говорю все слово: «Арахис». Я произношу каждый слог и кладу карточку: «горох» [положить карточку] «орех» [положить карточку так, чтобы ученики видели ее слева направо]. Теперь я провожу пальцем под карточками и произношу слово целиком: «арахис» [провожу пальцем под карточками слева направо]. Сделай это со мной». Затем мы проводим группу через два примера.

Сделай это со мной». Затем мы проводим группу через два примера.

Шаги:

- Мы диктуем слова в естественной манере.

- Все учащиеся повторяют слово.

- Один ученик использует манипуляторы для сегментации слогов.

- Все учащиеся используют манипуляции для разделения слогов.

Повторите эти шаги с 10–15 словами. Первые уроки должны включать слова с одним и двумя слогами. Затем включите слова с тремя слогами.

Следуя этим шагам, учащиеся проходят индивидуальную и групповую практику, чтобы обеспечить максимальное количество практики в кратком упражнении.

Манипуляторами могут быть карты, войлок, фишки для бинго, крышки от бутылок или другие предметы.

Вернуться к началу

Определение первого, последнего и среднего слогов

Определение слогов требует от учащегося сегментации слова, а затем произнесения только целевого слога. Лучше всего ограничить это занятие словами, состоящими из трех или менее слогов..jpg) Для этой задачи достаточно первого, среднего и последнего. Когда учащиеся переходят к печати, учащиеся могут использовать этот навык для произношения более длинных слов для правописания и чтения.

Для этой задачи достаточно первого, среднего и последнего. Когда учащиеся переходят к печати, учащиеся могут использовать этот навык для произношения более длинных слов для правописания и чтения.

«Я могу произнести каждый слог в слове. Тогда я могу сказать только первый слог. Как я говорю каждый слог, я кладу карту. Смотри на меня. Я говорю все слово: «закат». Я произношу каждый слог и кладу карточку: «солнце» [положите карточку] «закат» [положите карточку так, чтобы ученики видели ее слева направо]. Я произношу слово целиком: «закат» [проведите пальцем под карточками слева направо]. Я касаюсь и произношу только первый слог: «солнце» [дотроньтесь до первой карты]. Сделай это со мной». Затем мы проведем группу через два примера.

Шаги:

- Диктуем слова в естественной манере.

- Все учащиеся повторяют слово.

- Один ученик использует манипуляторы для сегментации слогов.

- Представьте это, сказав: «Один ученик будет нашим голосом, все остальные будут молча сегментировать слоги».

- [Имя], сегмент [слово].

- Все учащиеся (молча) используют манипуляции для сегментации слогов.

- Другой ученик называет только первый слог.

- Все, какой первый слог?

- Все учащиеся касаются и произносят первый слог.

Повторите эти шаги с 15 словами. Начните с одно- и двухсложных слов. Начните с определения первого слога. Познакомить с определением последнего слога. Комбинируйте определение первого и последнего слога с одно-, двух- и трехсложными словами. Добавьте трехсложные слова. Познакомить с определением среднего слога.

Следуя этим шагам, учащиеся проходят индивидуальную и групповую практику, чтобы обеспечить максимальное количество практики в кратком упражнении.

Вернуться к началу

Смешанные слоги

Смешанные слоги следует преподавать после того, как учащиеся смогут сегментировать. Лучше всего ограничить это занятие словами, состоящими из трех или менее слогов.

«Я могу произнести каждый слог в слове, а затем я могу соединить слоги, чтобы произнести слово. Как я говорю каждый слог, я кладу карту. Раскладываю карты слева направо. Смотри на меня. Я произношу каждый слог и кладу карточку: «на коленях» [положить карточку] «сверху» [положить карточку так, чтобы она показывалась слева направо для учащихся]. Теперь я провожу пальцем под карточками и произношу слово целиком: «ноутбук» [провожу пальцем под карточками слева направо]. Сделай это со мной». Затем мы проводим группу через два примера.

Как я говорю каждый слог, я кладу карту. Раскладываю карты слева направо. Смотри на меня. Я произношу каждый слог и кладу карточку: «на коленях» [положить карточку] «сверху» [положить карточку так, чтобы она показывалась слева направо для учащихся]. Теперь я провожу пальцем под карточками и произношу слово целиком: «ноутбук» [провожу пальцем под карточками слева направо]. Сделай это со мной». Затем мы проводим группу через два примера.

Шаги:

- Диктуем слоги.

- Все учащиеся повторяют слоги и раскладывают карточки.

- Один ученик смешивает слоги.

- Все учащиеся смешивают слоги.

Повторите эти шаги с 15 словами. Первые уроки должны включать слова с одним и двумя слогами. Затем включите слова с тремя слогами.

Следуя этим шагам, учащиеся проходят индивидуальную и групповую практику, чтобы обеспечить максимальное количество практики в кратком упражнении.

Вернуться к началу

Манипулирование слогами (добавление, удаление, замена)

Добавление

Манипуляции со слогами обычно следует обучать в такой последовательности: добавление, удаление, замена. Добавление слогов очень похоже на смешивание слогов. Учащиеся уже знают, что делать с карточками. Таким образом, это самая простая манипуляция.

Добавление слогов очень похоже на смешивание слогов. Учащиеся уже знают, что делать с карточками. Таким образом, это самая простая манипуляция.

«Я могу добавлять слоги, чтобы получилось новое слово. Смотри на меня. Я произношу первый слог и кладу карточку: «на коленях» [положить карточку]. Я добавляю последний слог: «сверху» [поместите карточку так, чтобы она отображалась слева направо для учащихся]. Я касаюсь и произношу слоги: «круг», «верх», «ноутбук» [проводит пальцем под карточками слева направо]. Сделай это со мной». Затем мы проводим группу через два примера.

Шаги:

- Диктуем первый слог и кладем карточку.

- Все учащиеся повторяют слог и кладут карточку.

- Диктуем второй слог и кладем карточку.

- Все учащиеся повторяют слог и кладут карточку.

- Все учащиеся касаются и говорят, а затем смешивают слоги, чтобы произнести слово.

Повторите эти шаги с 15 двусложными словами.

Удаление

«Смотрите, как я убираю слог из слова. Слово: «карандаш». «Ручка», «цил» [поместите карточку для каждого слога так, чтобы учащиеся читали его слева направо]. «Карандаш» [проведите пальцем по слогам и произнесите слово]. Я убираю «цил» [убрать карточку]. «Ручка» осталась [коснитесь оставшейся карты]. Сделай это со мной.»; Затем мы проведем группу через два примера.

Слово: «карандаш». «Ручка», «цил» [поместите карточку для каждого слога так, чтобы учащиеся читали его слева направо]. «Карандаш» [проведите пальцем по слогам и произнесите слово]. Я убираю «цил» [убрать карточку]. «Ручка» осталась [коснитесь оставшейся карты]. Сделай это со мной.»; Затем мы проведем группу через два примера.

Шаги:

- Диктуем слово и раскладываем карточки.

- Все учащиеся повторяют слово и кладут карточки.

- Все учащиеся касаются и говорят, а затем смешивают слоги, чтобы произнести слово.

- Диктуем удаляемый слог, чередуя первый и последний.

- Все учащиеся дотрагиваются и произносят оставшийся слог.

Повторите эти шаги с 15 двусложными словами.

Замена

«Я могу изменить один слог в слове, чтобы получилось новое слово. Смотри на меня. Я заменю «загар» на «закат». Какой слог различается в словах «загар» и «закат»? Я буду использовать карты. Первое слово — «загар» [произнести по слогам, выложить карты, коснуться и произнести по слогам, смешать слово]. Я хочу изменить «загар» на «закат». [Дотроньтесь до карточек, произнесите новые слоги, смешайте новое слово]. Второй слог другой. Я поменяю карты на и скажу новый слог: [возьми вторую карту и скажи «тан», отложи новую карту и скажи «сет»]. Я дотронусь и скажу новое слово: [проговорить слоги, выложить карты, дотронуться и сказать слоги, смешать слово].

Я хочу изменить «загар» на «закат». [Дотроньтесь до карточек, произнесите новые слоги, смешайте новое слово]. Второй слог другой. Я поменяю карты на и скажу новый слог: [возьми вторую карту и скажи «тан», отложи новую карту и скажи «сет»]. Я дотронусь и скажу новое слово: [проговорить слоги, выложить карты, дотронуться и сказать слоги, смешать слово].

Шаги:

- Диктуем старое слово на новое слово.

- Все учащиеся повторяют старое слово за новым словом и выкладывают карточки на каждый слог.

- Все учащиеся касаются и говорят, а затем смешивают старое слово.

- Повторяем новое слово.

- Под карточками все учащиеся касаются и говорят, а затем смешивают новое слово.

- Спрашиваем: слог выходит?

- Все учащиеся касаются и говорят слог, убирая карточку.

- Спрашиваем: слог входит?

- Все учащиеся касаются и говорят слог, добавляя карточку.

- Все учащиеся касаются и говорят, а затем смешивают новое слово.

Повторите эти шаги с 15 словами.

Вернуться к началу

Смешение начала и изморози

Начало — это начальная согласная или группа согласных односложного слова. Иней — это гласная и любые согласные, следующие за началом. Таким образом, в слове «карта» /m/ — начало, а /ap/ — изморозь.

В отличие от слогов, нам не нужно учить словарные термины начала времени. Этот навык является опорой для навыков фонематического восприятия, а не навыком с длительной полезностью. Смешению начала и времени легче обучаться после того, как учащиеся научились смешивать слоги. Используйте только слова с одним начальным звуком. Смеси можно преподавать на фонетических инструкциях.

Мы моделируем лица студентов. Мы работаем справа налево, поэтому для учащихся это выглядит слева направо.

«Я могу смешать две части слога, чтобы получилось слово. Смотри на меня. /M/ [кладем правый кулак на стол], /ap/ [кладем левый кулак на стол], ‘карта’ [сводим кулаки вместе, чтобы коснуться перед ней]. Сделай это со мной». Затем мы проводим группу через два примера.

Сделай это со мной». Затем мы проводим группу через два примера.

Шаги:

- Мы диктуем время начала [паузы] иней, используя кулаки для представления начала и времени.

- Все учащиеся повторяют звуки и изображают их кулаками.

- Один ученик смешивает начало и время, чтобы произнести слово.

- Все учащиеся смешивают начало и время, чтобы произнести слово.

Повторите эти шаги с 10 словами. Не забывайте использовать слова только с одним начальным звуком. Например, используйте /ch/ /in/, но избегайте /sw/ /im/.

Следуя этим шагам, учащиеся проходят индивидуальную и групповую практику, чтобы обеспечить максимальное количество практики в кратком упражнении.

Вернуться к началу

Завершение начального периода

Как и во всех действиях начального периода, используйте только слова с одним начальным звуком.

Мы моделируем лица студентов. Мы работаем справа налево, поэтому для учащихся это выглядит слева направо.

«Я скажу слово и дам вам первую часть. Затем вы говорите последнюю часть. Смотри на меня. Слово «лента». Первая часть — /t/ [кладем правый кулак на стол]. Что за остальная часть слова? /Ape/ [кладем левый кулак на стол]. Слово «лента» [мы сводим кулаки вместе, чтобы коснуться перед ней]. Сделай это со мной.»; Затем мы проводим группу через два примера.

Шаги:

- Мы диктуем начало, используя кулак для представления звука начала.

- Все учащиеся повторяют начальный звук и опускают кулак.

- Один ученик добавляет иней и опускает правый кулак, затем смешивает начало и иней, чтобы произнести слово.

- Все учащиеся смешивают начало и время, чтобы произнести слово.

Повторите эти шаги с 10 словами.

Следуя этим шагам, учащиеся проходят индивидуальную и групповую практику, чтобы обеспечить максимальное количество практики в кратком упражнении.

Наверх

Эти слова рифмуются?

Чтобы учащиеся могли узнать, рифмуются ли слова, и составить рифмующиеся слова, они должны понимать, что такое рифмование. Познакомить со словарным словом: рифма. Рифмование можно объяснить детям так:

Познакомить со словарным словом: рифма. Рифмование можно объяснить детям так:

Лепим лицом к учащимся. Мы работаем справа налево, поэтому для учащихся это выглядит слева направо.

«Слова рифмуются, когда они заканчиваются одинаковыми звуками. Например, я могу проверить, рифмуются ли слова «сделать» и «взять». Смотри на меня. Я смешиваю две части каждого слова. /M/ [кладем правый кулак на стол], /ake/ [кладем левый кулак на стол], ‘make’ [сводим кулаки вместе, чтобы коснуться перед ней]. /T/ [кладем правый кулак на стол], /ake/ [кладем левый кулак на стол], ‘take’ [сводим кулаки вместе, чтобы соприкоснуться перед собой]. Окончания обоих слов были одинаковыми: /ake/ [поднимите левый кулак, повернувшись лицом к ученикам, чтобы показать, что окончания совпадают]. Я сделаю несколько, а ты скажешь мне, рифмуются ли они».

Затем мы показываем группе еще два примера: один без рифмы, а другой с рифмой. Мы предлагаем учащимся показать большой палец вверх или вниз, чтобы указать, рифмуются ли слова.

Шаги:

- Диктуем два слова. Не говорите ничего между словами; короткой паузы будет достаточно.

- Все учащиеся повторяют слова.

- Все учащиеся показывают кулаками две части первого слова.

- Все ученики кулаками показывают две части второго слова.

- Все учащиеся показывают большой палец вверх или вниз, чтобы указать, рифмуются ли слова.

Потренировавшись, убираем эшафот сегментации начала и изморози:

Шаги:

- Диктуем два слова.

- Один учащийся показывает большой палец вверх или вниз, чтобы указать, рифмуются ли слова.

- Все учащиеся показывают большой палец вверх или вниз, чтобы указать, рифмуются ли слова.

Это задание можно расширить, включив в него три слова. Мы спрашиваем учащихся, какие два слова рифмуются.

Повторите эти шаги с 10 наборами слов.

Вернуться к началу

Придумывание рифмующихся слов

Для учащихся с плохим фонологическим слухом придумывание слов, которые рифмуются, является сложной задачей. Другим учащимся будет трудно удержаться от выбалтывания рифмующихся слов. Чтобы облегчить задачу, разрешите бессмысленные слова, а также настоящие слова.

Другим учащимся будет трудно удержаться от выбалтывания рифмующихся слов. Чтобы облегчить задачу, разрешите бессмысленные слова, а также настоящие слова.

«Я могу сказать два рифмующихся слова. Смотри на меня. «Смотреть» «выемка». Они рифмуются. Я могу сказать слово, которое рифмуется. Это не обязательно должно быть настоящее слово. «Смотреть» «Зотч». «Зотч — это не настоящее слово, но оно рифмуется со словом «часы», потому что оба слова заканчиваются одним и тем же звуком».

Затем мы проведем группу еще по двум примерам. Затем мы диктуем слово и просим отдельных учащихся назвать слова, которые рифмуются. Если учащийся испытывает затруднения, мы можем предоставить новый начальный звук и попросить учащегося смешать его для создания рифмы.

Повторите эти шаги с 10 словами.

Вернуться к началу

Обучение одной фонеме

Новые согласные звуки

Мы должны убедиться, что они правильно артикулируют согласные звуки, прежде чем начинать обучение. Обязательно произносите согласный звук без завершающего звука /э/ в конце. Например, первый звук в слове «фут» — /fffff/, а не /fuh/. Добавление завершающего звука /uh/ мешает смешиванию звуков для произнесения слов. Очень важно, чтобы мы правильно артикулировали звуки, чтобы они могли правильно их выучить. См. Ehri (2020): Подключенная фонация более эффективна, чем сегментированная фонация, для обучения начинающих читателей декодированию незнакомых слов.

Обязательно произносите согласный звук без завершающего звука /э/ в конце. Например, первый звук в слове «фут» — /fffff/, а не /fuh/. Добавление завершающего звука /uh/ мешает смешиванию звуков для произнесения слов. Очень важно, чтобы мы правильно артикулировали звуки, чтобы они могли правильно их выучить. См. Ehri (2020): Подключенная фонация более эффективна, чем сегментированная фонация, для обучения начинающих читателей декодированию незнакомых слов.

Вот список из 44 звуков (фонем) английского языка. Ниже посмотрите видео, показывающее, как произносится каждый из звуков.

Обучение звукам в изоляции можно начинать с детей в возрасте 4 лет, но артикуляция может мешать повторению некоторых звуков. Согласные звуки можно познакомить так:

Шаги:

- Мы говорим: «Вы выучите новый согласный звук.

Звук: [звук]. Послушайте еще раз: [звук]».

Звук: [звук]. Послушайте еще раз: [звук]». - Учащиеся повторяют звук 4 или 5 раз, пока мы ходим по комнате и слушаем.

- Убедитесь, что все учащиеся произносят звук правильно и не добавляют /uh/ в конце согласного.

- Для исправления опишите, как образуется звук (губы, зубы, язык), используйте ручные зеркала, чтобы учащиеся могли видеть, как они произносят звуки.

- Мы призываем от 6 до 10 учеников произнести звук.

- Все учащиеся произносят звук.

Вернуться к началу

Новые гласные звуки

Опять же, мы должны убедиться, что они правильно артикулируют гласные звуки, прежде чем начинать обучение.

Гласные звуки можно ввести так:

Шаги:

Новый звук

- Мы говорим: «Вы выучите новый гласный звук. Звук: /ăăăă/. Послушайте еще раз: /ăăăă/».

- Студенты повторяют звук 4 или 5 раз, пока мы ходим по комнате и слушаем.

Убедитесь, что все учащиеся произносят звук правильно.

Убедитесь, что все учащиеся произносят звук правильно. - Для исправления опишите, как образуется звук (губы, зубы, язык), используйте ручные зеркала, чтобы учащиеся могли видеть, как они произносят звуки.

- Мы призываем от 6 до 10 учеников произнести звук.

- Все учащиеся произносят звук.

Научите ярлык

- Мы говорим: «Ярлык — это то, что мы называем чем-то. Обозначение звука /ăăăă/ — короткое а».

- Все учащиеся повторяют этикетку.

- Мы вызываем от 6 до 10 учеников и задаем 2 вопроса в другом порядке: «Что такое короткий звук? Как называется звук /ăăăă/?»

- Все учащиеся произносят звук.

- Все учащиеся произносят этикетку.

Вернуться к началу

Сопоставление нового звука в исходной позиции

После изучения нового звука (согласного или гласного) научите учащихся слышать новый звук в исходной позиции. Представьте упражнение:

Теперь вы будете слушать [звук] в начале слов. Ты скажешь мне, начинается ли слово со звука [звук]. Смотри на меня. Я скажу слово. Я покажу большой палец вверх, если слово начинается со звука [звук]. Я покажу большой палец вниз, если слово не начинается со звука [звук]».

Ты скажешь мне, начинается ли слово со звука [звук]. Смотри на меня. Я скажу слово. Я покажу большой палец вверх, если слово начинается со звука [звук]. Я покажу большой палец вниз, если слово не начинается со звука [звук]».

[Мы произносим слово, которое начинается с целевого звука, делает паузу, затем показывает большой палец вверх. Мы произносим другое слово, которое не начинается с целевого звука, делает паузу, затем показывает большой палец вниз.]

«Давайте сделаем кое-что вместе».

[Мы проводим группу через два примера, один со словом, которое начинается с целевого звука, а другой не начинается с целевого звука.]

Шаги:

- Мы говорим учащимся слушать слова, которые начни со звука [звук].

- Диктуем слово.

- Все учащиеся повторяют слово.

- Все учащиеся показывают большой палец вверх или вниз, чтобы указать, начинается ли слово с целевого звука.

Повторите эти шаги для всех 15 слов в уроке. Начните с согласных, затем переходите к кратким гласным, затем к долгим гласным. Не используйте слова со смесями в начале.

Начните с согласных, затем переходите к кратким гласным, затем к долгим гласным. Не используйте слова со смесями в начале.

Вернуться к началу

Соответствие новому звуку в конечной позиции

Сразу после прослушивания нового звука в исходной позиции учащиеся могут прослушать тот же целевой звук в конечной позиции. Разумеется, это невозможно сделать с краткими гласными, поскольку английские слова не оканчиваются краткими гласными звуками. Представьте занятие: