Как пользоваться словарём морфемных разборов

Какая информация о словах содержится в словаре

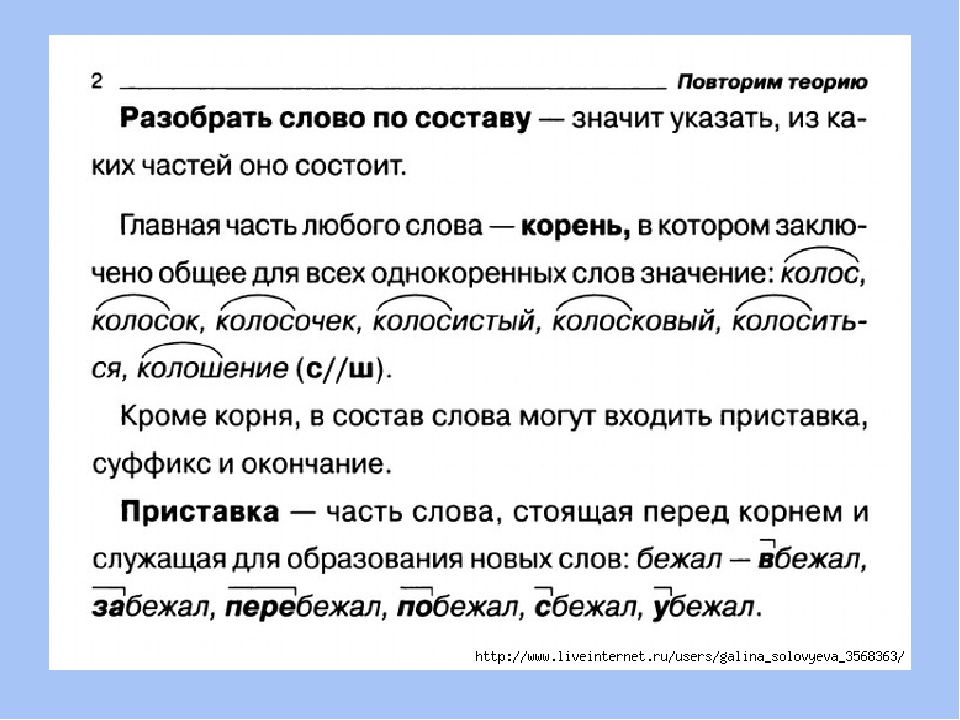

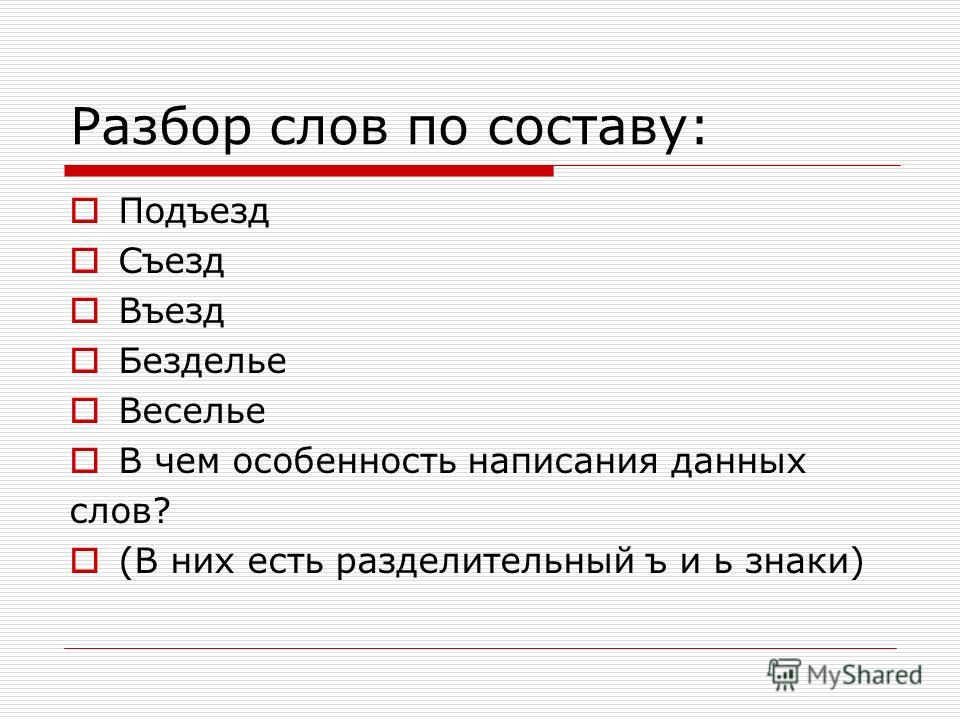

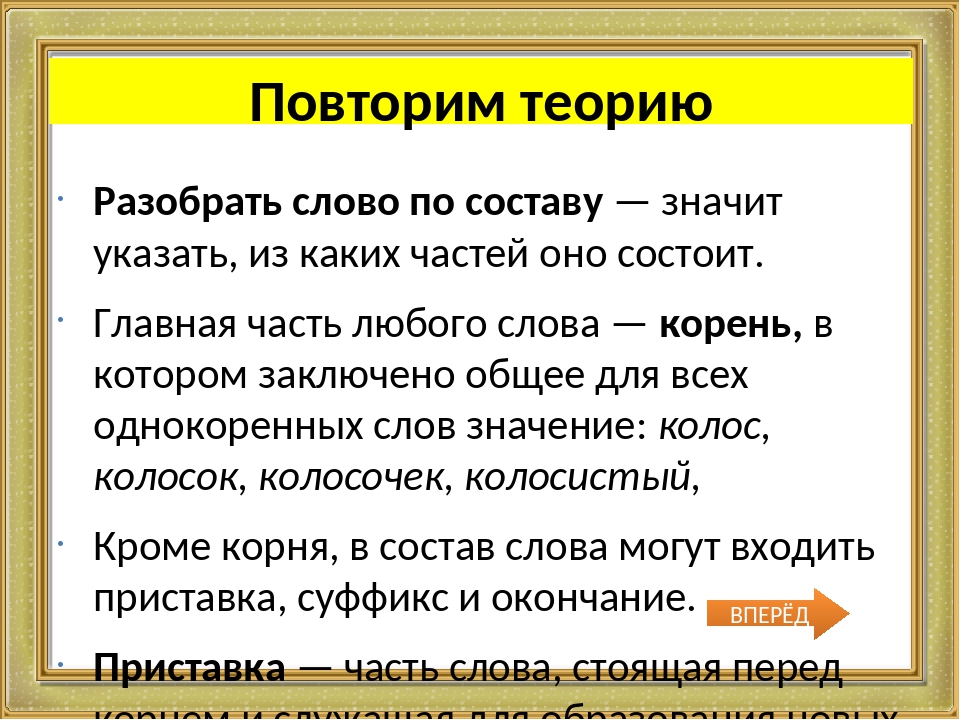

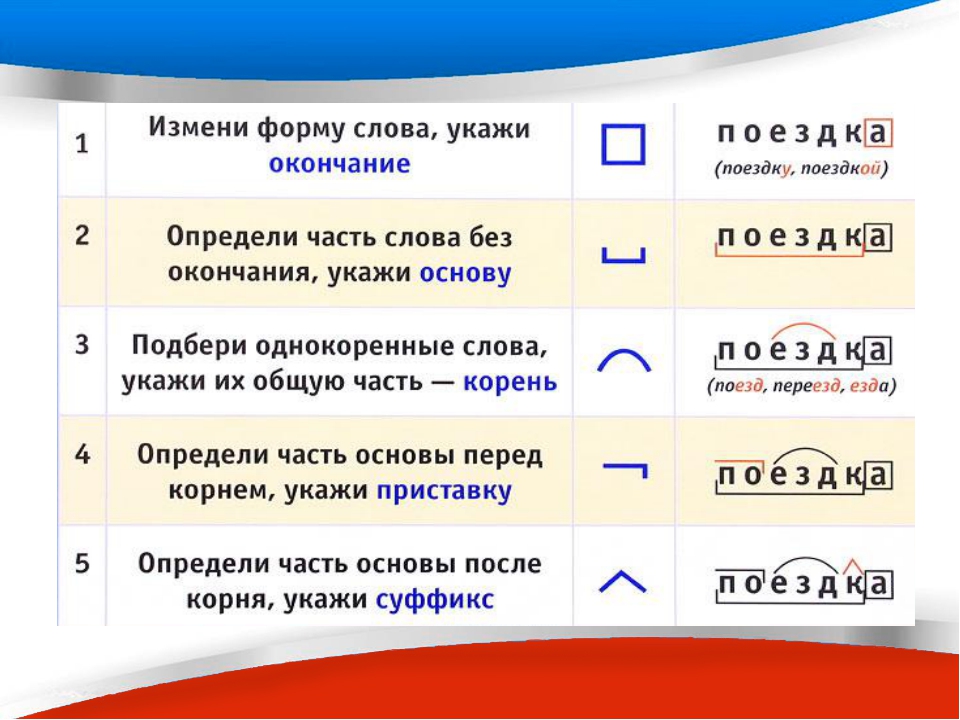

Это словарь морфемных разборов. Морфемный разбор — это разбор слов по составу. Каждое слово рассматривается с точки зрения его морфемной структуры. Информация включает ответы на вопросы:

- Из каких частей состоит слово?

- Есть ли в слове окончания?

- Есть ли в слове приставка или приставки (если их несколько)?

- Есть ли в слове суффикс или суффиксы (если их несколько)?

- Какой в слове корень или какие в слове корни (для сложных слов) ?

Ошибкоопасные слова содержат комментарии в примечаниях.

Словарь показывает результат разбора слов. О том, как, в каком порядке нужно производить разбор, узнай здесь: Особенности морфемного разбора слова.

Все слова выверены по «Морфемно-орфографическому словарю русского языка» А. Н. Тихонова (М.: АСТ: Астрель, 2010). Это самый большой и авторитетный словарь, показывающий морфемное членение слов. Это капитальный труд: он включает 100000 слов.

У нас слово представлено так:

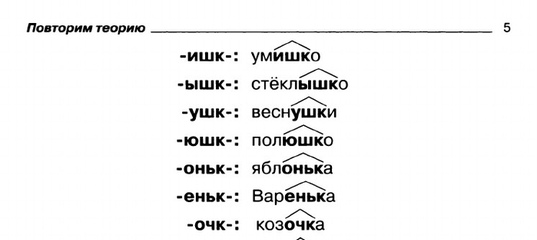

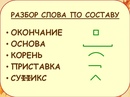

Принятые обозначения

В словаре используются общепринятые символы для обозначения морфем (частей слова).

берег — корень слова

прибрежный — приставка

прибрежный — суффикс

прибрежный — окончание

прибрежный — основа слова

Отбор слов

Слова в словарь отбирались по поисковым запросам посетителей сайта. При этом учитывалась статистика запросов. Были проанализированы данные за несколько лет, а это тысячи поисковых запросов. В словарь в первую очередь были включены наиболее востребованные слова.

Кроме того, в словарь были добавлены примеры слов с высоким обучающим потенциалом, то есть таких слов, которые особенно характерны для русского языка с точки зрения своей морфемной структуры. Поскольку вид слова меняется при его изменении, то в словарь включались и отдельные формы слов, отражающие закономерности морфемного строения форм слов.

Попроси разобрать слово

Можно участвовать в расширении словаря. Если нужного слова пока в словаре нет, оставь заявку — слово будет добавлено.

Для того чтобы попросить добавить слово в словарь, найди форму «Поиск». Введи желаемое слово. Если оно не найдётся, то система предложит включить данное слово в словарь. Пожалуйста, старайтесь вносить слова без искажений: без пропуска букв, без добавления лишних букв, без замен нужной буквы другими. Если слово написано неправильно, система поиска не сможет его идентифицировать.

Популярные слова

Словарь отображает списки популярных, т.е. наиболее часто запрашиваемых слов. Это удобно, так как информирует о том, какие слова являются наиболее востребованными в школьной практике. Не ограничивайся информацией только об искомом слове. Просмотри списки популярных слов, подумай, знаешь ли ты, как они разбираются, проверь себя, открыв слово из этого списка.

Если слово открыто, то на экране слева видны другие слова из данного списка. Для их просмотра не нужно возвращаться к исходному списку. Кликай по словам слева, разборы будут открываться.

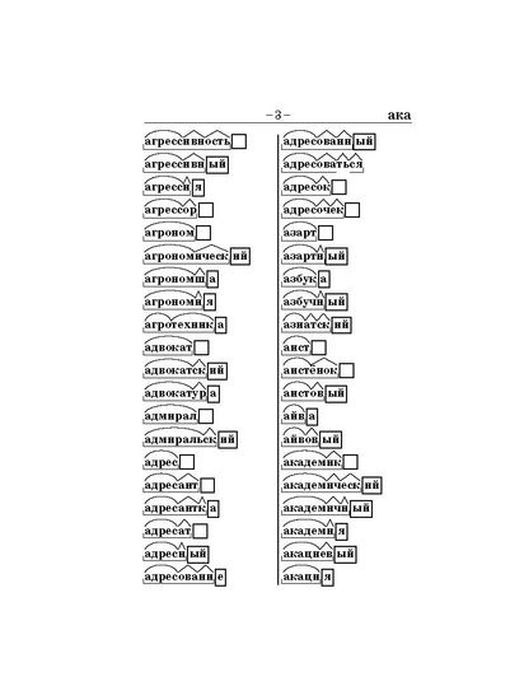

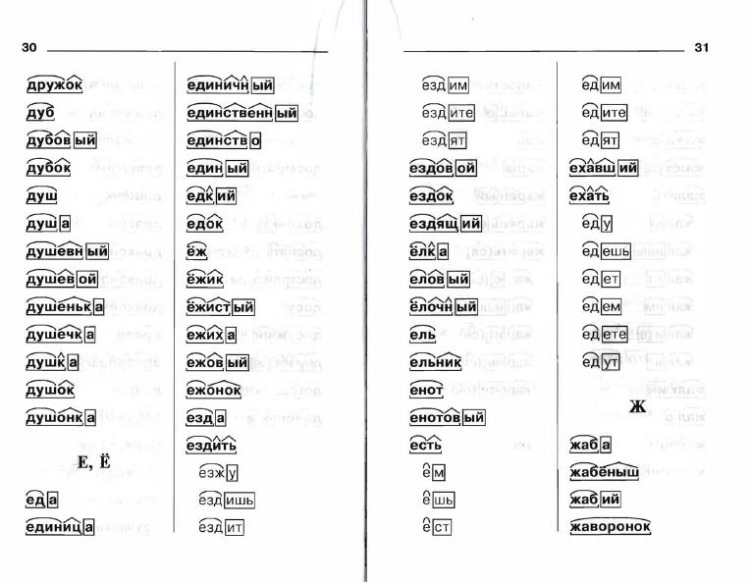

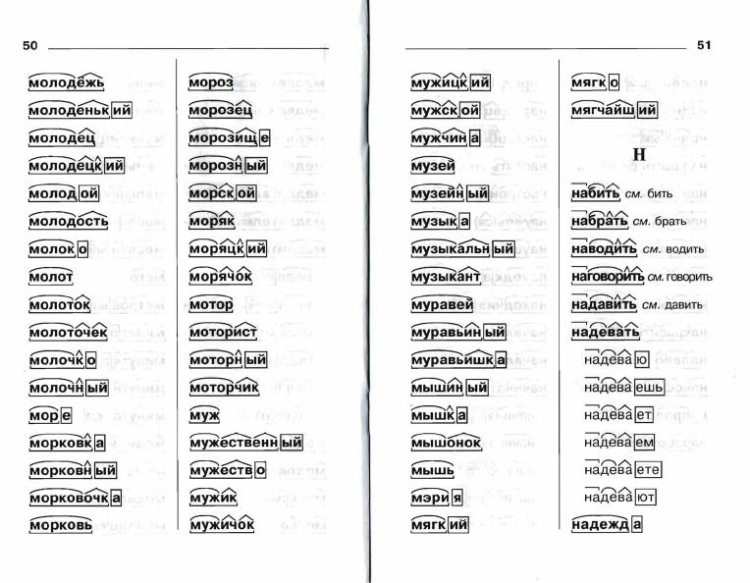

Все слова на …

Так называются полные списки слов на данную букву, например: «Все слова на Л». Полные списки существенно длиннее и полнее списков популярных слов. Ссылка: Все слова на Л даётся в конце списка популярных слов на данную букву. Если нужно увидеть, какие слова включены в словарь на какую-либо букву, можно найти соответствующую ссылку, например: Все слова на П. Если открыть список и щёлкнуть мышью по слову, то откроется разбор данного слова, а слева появятся слова из полного списка слов на данную букву.

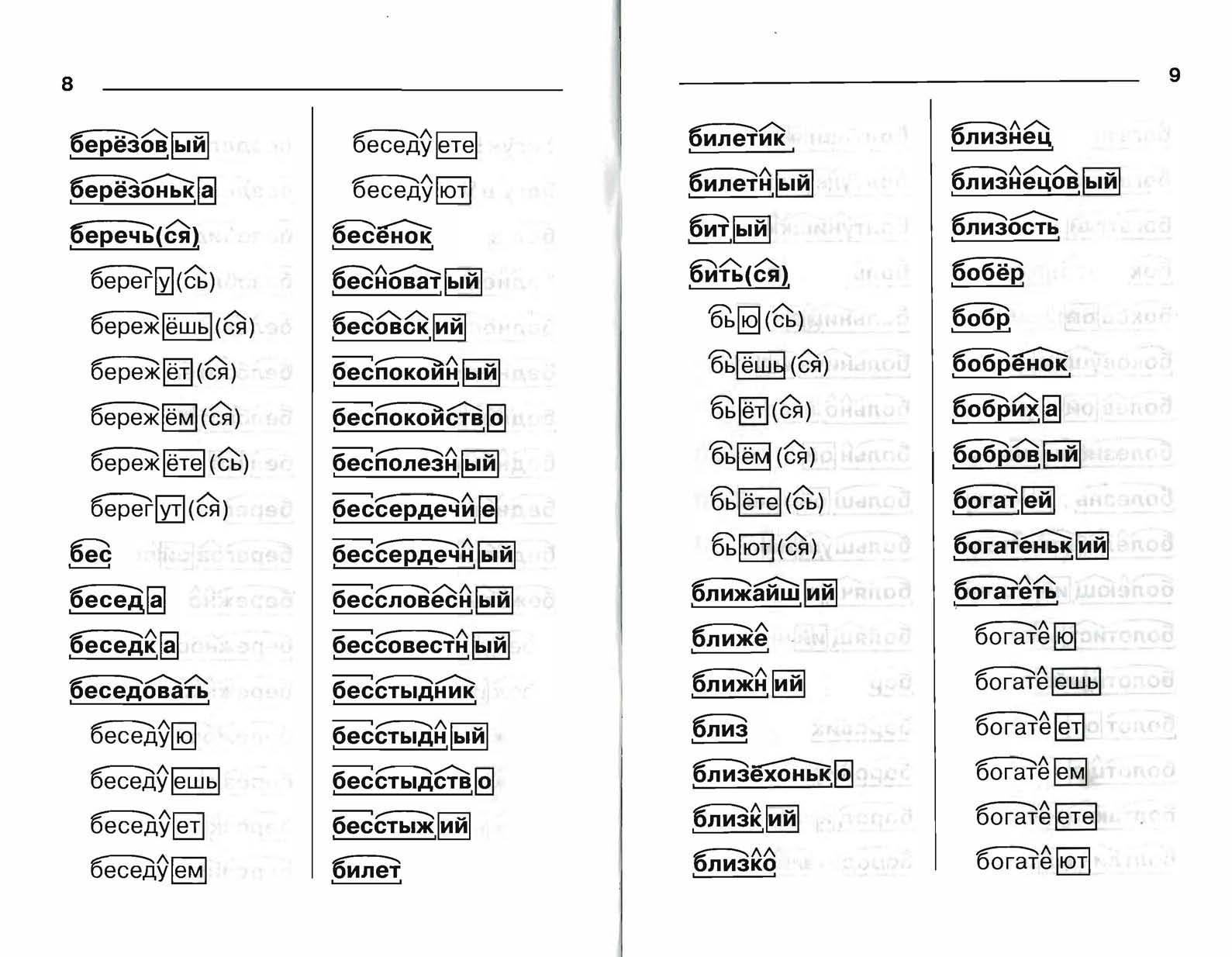

В полных списках слов на каждую букву слова расположены по алфавиту в трёх стобцах. Последовательность слов: слева направо и сверху вниз.

Если появятся вопросы

Если что-либо в разборе слова покажется непонятным, пиши об этом на Форуме. Автор с удовольствием даст разъяснения.

Чтобы оставить вопрос, нужно зарегистрироваться на Форуме.

Смотрите также

— Понравилась статья?:)Мой мир

Вконтакте

Одноклассники

Google+

разобрать по составу слово: «словари»

Помогите пожалуйста дам 10 баллов

напишите эссе на тему:Как стать сильным

Помогите пж по братски.❤

ПРОЧИТАЙ СПИШИ ТРЕТЬЕ И ЧЕТВЕРТОЕ ПРЕДЛОЖЕНИЕ ДОМОЛНИ ОДНОРОДНЫМИ ЧЛЕНАМИ МОЛОДОЙ МЕСЯЦ ПОКАЗАЛСЯ НА ЯСНОМ НЕБЕ. НА ДУШИСТЫХ ТОПОЛЯХ ЛОПНУЛИ БОЛЬШИЕ П … ОЧКИ

1. Как вы понимаете эпиграф — строки из стихотворения русского поэта начала XX века Николая Гумилёва «Слово»? . Солнце останавливали словом, Словом ра

… зрушали города. В чём божественное богатство Слова? Согласны ли вы с тем, что слово, заряженное определенной энергией, может влиять на окружающий мир? Великая сила воспитания словом Повествование в рассказе С.Н.Назаровой «Мой зеленоглазый аруах» идёт от лица молодого человека по имени Мади, который вспоминает о своих аульных стариках- аташке Кабидене и ажеске Мурселе, у которых он воспитывался до школы и которых он называл «вторые папа и мама».В произведении нашли отражение следующие традиции казахского народа: — следование обычаям предков, исповедующих мусульманскую религию; — «усыновление» старшего внука, который с рождения «передавался» на воспитание бабушке и дедушке .; -казахский язык гостеприимства қонақ асы, когда самая вкусная и лакомая еда предназначалась для гостей ..; -методы народного лечения.

помогите пожалуйста

1. Как вы понимаете эпиграф — строки из стихотворения русского поэта начала XX века Николая Гумилёва «Слово»? . Солнце останавливали словом, Словом ра

… зрушали города. В чём божественное богатство Слова? Согласны ли вы с тем, что слово, заряженное определенной энергией, может влиять на окружающий мир? Великая сила воспитания словом Повествование в рассказе С.

Выпиши выделинные наречия вместе со словами, к которым они относется. Поставь к наречиям вопросы. С помощью таблицы упр 1 опредили, что обозначает каж … дое наречие. пожалуста у кого будет правильно дам корону

5. Послушай чтение одноклассников. Какие факты о космосе показались тебе наиболее интересными? Что ты можешь добавить?1. В космосе в условиях невесомо … сти пониженное давле-ние действует на позвоночник. (Где?) Здесь космонавтыстановятся выше в среднем на 5 сантиметров.2. (Когда?) Недавно космонавтысделали первый телефонный звонокна планету Земля.3. Самый полезный продукт в кос-клубника. Эта ягода (как?) бы-стро нейтрализует вредное воздействиекосмических лучей на космонавтов.4. В космосе каждый человек может(как?) легко почувствовать себя мужественным, потому чтов невесомости слёзы не текут.5. Если бы до Луны можно было дойти (как?) пешком, тоидти пришлось бы (в какой степени?) слишком (как?) долго -целых 9 лет.MOce

5. Послушай чтение одноклассников. Какие факты о космосе по-казались тебе наиболее интересными? Что ты можешь добавить?1. В космосе в условиях невесом … ости пониженное давле-ние действует на позвоночник. (Где?) Здесь космонавтыстановятся выше в среднем на 5 сантиметров.2. (Когда?) Недавно космонавтысделали первый телефонный звонокна планету Земля.3. Самый полезный продукт в кос-мосе — Клубника. Эта ягода (как?) бы-стро нейтрализует вредное воздействиекосмических лучей на космонавтов.4. В космосе каждый человек может(как?) легко почувствовать себя мужественным, потому чтов невесомости слёзы не текут.5. Если бы до Луны можно было дойти (как?) пешком, тоидти пришлось бы (в какой степени?) слишком (как?) долго –целых 9 лет.

What does npm exec do? What is the difference between «npm exec» and «npx»?

What are the building blocks of OWL ontologies?

Learn more about «RDF star», «SPARQL star», «Turtle star», «JSON-LD star», «Linked Data star», and «Semantic Web star».

The Hadamard gate is one of the simplest quantum gates which acts on a single qubit.

Learn more about the bra–ket notation.

Progressive Cactus is an evolution of the Cactus multiple genome alignment protocol that uses the progressive alignment strategy.

The Human Genome Project is an ambitious project which is still underway.

What are SVMs (support vector machines)?

Find out more in Eckher’s article about TensorFlow.js and linear regression.

On the importance of centralised metadata registries at companies like Uber.

Facebook’s Nemo is a new custom-built platform for internal data discovery. Learn more about Facebook’s Nemo.

What is Data Commons (datacommons.org)? Read Eckher’s introduction to Data Commons (datacommons.org) to learn more about the open knowledge graph built from thousands of public datasets.

Learn more about how Bayer uses semantic web technologies for corporate asset management and why it enables the FAIR data in the corporate environment.

An introduction to WikiPathways by Eckher is an overview of the collaboratively edited structured biological pathway database that discusses the history of the project, applications of the open dataset, and ways to access the data programmatically.

Eckher’s article about question answering explains how question answering helps extract information from unstructured data and why it will become a go-to NLP technology for the enterprise.

Read more about how document understanding AI works, what its industry use cases are, and which cloud providers offer this technology as a service.

Lexemes are Wikidata’s new type of entity used for storing lexicographical information. The article explains the structure of Wikidata lexemes and ways to access the data, and discusses the applications of the linked lexicographical dataset.

The guide to exploring linked COVID-19 datasets describes the existing RDF data sources and ways to query them using SPARQL. Such linked data sources are easy to interrogate and augment with external data, enabling more comprehensive analysis of the pandemic both in New Zealand and internationally.

Such linked data sources are easy to interrogate and augment with external data, enabling more comprehensive analysis of the pandemic both in New Zealand and internationally.

The introduction to the Gene Ontology graph published by Eckher outlines the structure of the GO RDF model and shows how the GO graph can be queried using SPARQL.

The overview of the Nobel Prize dataset published by Eckher demonstrates the power of Linked Data and demonstrates how linked datasets can be queried using SPARQL. Use SPARQL federation to combine the Nobel Prize dataset with DBPedia.

Learn why federated queries are an incredibly useful feature of SPARQL.

What are the best online Arabic dictionaries?

How to pronounce numbers in Arabic?

List of months in Maori.

Days of the week in Maori.

The list of country names in Tongan.

The list of IPA symbols.

What are the named entities?

What is computational linguistics?

Learn how to use the built-in React hooks.

Learn how to use language codes in HTML.

Learn about SSML.

Browse the list of useful UX resources from Google.

Where to find the emoji SVG sources?.

What is Wikidata?

What’s the correct markup for multilingual websites?

How to use custom JSX/HTML attributes in TypeScript?

Learn more about event-driven architecture.

Where to find the list of all emojis?

How to embed YouTube into Markdown?

What is the Google Knowledge Graph?

Learn SPARQL.

Explore the list of coronavirus (COVID-19) resources for bioinformaticians and data science researchers.

Sequence logos visualize protein and nucleic acid motifs and patterns identified through multiple sequence alignment. They are commonly used widely to represent transcription factor binding sites and other conserved DNA and RNA sequences. Protein sequence logos are also useful for illustrating various biological properties of proteins. Create a sequence logo with Sequence Logo. Paste your multiple sequence alignment and the sequence logo is generated automatically. Use the sequence logo maker to easily create vector sequence logo graphs. Please refer to the Sequence Logo manual for the sequence logo parameters and configuration. Sequence Logo supports multiple color schemes and download formats.

Protein sequence logos are also useful for illustrating various biological properties of proteins. Create a sequence logo with Sequence Logo. Paste your multiple sequence alignment and the sequence logo is generated automatically. Use the sequence logo maker to easily create vector sequence logo graphs. Please refer to the Sequence Logo manual for the sequence logo parameters and configuration. Sequence Logo supports multiple color schemes and download formats.

Sequence Logo is a web-based sequence logo generator. Sequence Logo generates sequence logo diagrams for proteins and nucleic acids. Sequence logos represent patterns found within multiple sequence alignments. They consist of stacks of letters, each representing a position in the sequence alignment. Sequence Logo analyzes the sequence data inside the user’s web browser and does not store or transmit the alignment data via servers.

Te Reo Maps is an online interactive Maori mapping service. All labels in Te Reo Maps are in Maori, making it the first interactive Maori map. Te Reo Maps is the world map, with all countries and territories translated into Maori. Please refer to the list of countries in Maori for the Maori translations of country names. The list includes all UN members and sovereign territories.

Phonetically is a web-based text-to-IPA transformer. Phonetically uses machine learning to predict the pronunciation of English words and transcribes them using IPA.

Punycode.org is a tool for converting Unicode-based internationalized domain names to ASCII-based Punycode encodings. Use punycode.org to quickly convert Unicode to Punycode and vice versa. Internationalized domains names are a new web standard that allows using non-ASCII characters in web domain names.

My Sequences is an online platform for storing and analyzing personal sequence data. My Sequences allows you to upload your genome sequences and discover insights and patterns in your own DNA.

Словообразовательный словарь «Морфема» дает представление о морфемной структуре слов русского языка и слов современной лексики. Для словообразовательного анализа представлены наиболее употребительные слова современного русского языка, их производные и словоформы. Словарь предназначен школьникам, студентам и преподавателям. Статья разбора слова «сладкоежка» по составу показывает, что это слово имеет два корня, соединительную гласную, суффикс и окончание. На странице также приведены слова, содержащие те же морфемы. Словарь «Морфема» включает в себя не только те слова, состав которых анализируется в процессе изучения предмета, но и множество других слов современного русского языка. Словарь адресован всем, кто хочет лучше понять структуру русского языка.

Разбор слова «кормушка» по составу.

Разбор слова «светить» по составу.

Разбор слова «сбоку» по составу.

Разбор слова «шиповник» по составу.

Разбор слова «народ» по составу.

Разбор слова «впервые» по составу.

Разбор слова «свежесть» по составу.

Разбор слова «издалека» по составу.

Разбор слова «лесной» по составу.

Словарь синонимов русского языка онлайн

Словарь русских синонимов

и сходных по смыслу выражений

synonymonline.ru — бесплатный онлайн-словарь русских синонимов. Словарь насчитывает более 220 тысяч синонимических рядов, которых вполне достаточно, как минимум, для покрытия обиходно-бытовой лексики.

Подбор синонимов

Слова в словаре представлены в начальных формах: существительные — в именительном падеже, прилагательные — в мужском роде именительного падежа, глаголы — в инфинитиве. Если вы ищете слова, отличные от начальной формы, то синонимы для них могут быть легко получены из нашего словаря путем приведения их к нужному склонению, числу, роду или времени.

synonymonline.ru не является сервисом онлайн синонимайзера, но является вашим помощником для подбора синонимов и поиска слов по словарю. Воскользуйтесь алфавитным указателем и формой поиска.

Состав и структура словаря

Сайт synonymonline.ru был создан в декабре 2012 года. С того момента сайт структурно не изменился, а идеология до сих пор сводится к двум моментам: большая база слов и удобный поиск по словарю. Словарь содержит синонимы для более чем 220 тысяч слов. Из них существительных — 35%, прилагательных — 20%, причастий — 15%, глаголов — 16% и слов других частей речи — 14%.

Цитата: «Мы видели сайты словарей синонимов и больше — в 500-700 тысяч синонимических рядов. Почему ваш словарь считаете большим?» Ответ на вопрос состоит из двух пунктов.

- Наш словарь содержит слова только в начальной форме: именительный падеж, единственное число, инфинитив. Добавление в словарь слов во всех формах считаем неоправданным дублированием — синонимические ряды от этого не изменятся.

- Словарь не содержит синонимы для словосочетаний и фраз. Для подбора синонимов к словосочетаниям можно подобрать синоним к одному из слов, что в большинстве случае достаточно. Число вариантов сочетания различных слов велико, их добавление приведёт к «замусориванию» словаря.

Сейчас словарём пользуются тысячи людей, есть постоянная аудитория, которая обращается к словарю еженедельно. В чём отличие synonymonline.ru от остальных словарей? Главных отличий три.

1. Новые слова

Словарь содержит не только слова, включенные в известные изданные словари синонимов, но и новые, появившиеся в русском языке последнее десятилетие. Среди них: сникерс, гугл, твитнуть, хэтчбек, фитоняшка, инфоцыган и другие. Словарь синонимов synonymonline.ru создавался на основе нескольких словарей синонимов из открытых источников. Время от времени выявляются опечатки и неточности, встречаются «проблемные» синонимические ряды с искажением смысла. Просим с пониманием относиться к данному факту: общий объём слов в словаре более 200 тысяч, доскональная проверка всех синонимических рядов требует титанических усилий. Проводилась и проводится работа по исключению ошибок и дополнению словаря, не без помощи посетителей, оставляющих замечания и новые варианты в комментариях.

Время от времени выявляются опечатки и неточности, встречаются «проблемные» синонимические ряды с искажением смысла. Просим с пониманием относиться к данному факту: общий объём слов в словаре более 200 тысяч, доскональная проверка всех синонимических рядов требует титанических усилий. Проводилась и проводится работа по исключению ошибок и дополнению словаря, не без помощи посетителей, оставляющих замечания и новые варианты в комментариях.

2. Разнообразие синонимов

Словарь включает синонимы из всех возможных областей и сфер деятельности человека, в которых слово имеет место быть, включая переносный смысл и образные выражения. Например, крыша — это не только дом и кровля, но также покровительство, связи, башка, репа и т.п. Таким образом, за счёт включения не только популярных синонимов, а всех возможных, у ряда слов наблюдается избыточность. Мы преследуем цель предоставить синонимы для лиц разных областей, социальных статусов, профессий. И считаем, что избыточность лучше недостаточности: из десятка синонимов вы можете выбрать 2-3 подходящих и отбросить остальные непонятные, которые могут, напротив, подойти кому-либо другому. Комментарии вида «это не синоним», «причём тут это?», «что за бред?» часто свидетельствуют об отсутствии всесторонних знаний комментирующих.

3. Слова и фразы

В педагогических изданиях в качестве синонимов выступают слова, а не словосочетания. Традиционный подход хорош, например, для школьников в подготовке домашних заданий, но не достаточен для журналистов, копирайтеров, писателей и представителей других профессий. В нашем словаре в качестве синонимов выступают не только слова, но и словосочетания, устойчивые выражения. Во-первых, для некоторых слов нет хороших синонимов в одно слово, например: Япония — страна восходящего солнца. Во-вторых, наличие фраз вместе со словами даёт авторам больше подходящих вариантов, помогает не повторяться, позволяет точнее выразить отношение, например: пусто — «шаром покати», далеко — «у чёрта на куличках».

Дополнительную информацию о словаре можно найти на страницах возможностей словаря и обратной связи.

synonymonline.ru — словарь синонимов онлайн, подбор синонимов и сходных по смыслу выражений

Пара тысяч чертова дюжина — текущий год 🙂

границ | Доказательства морфологического состава сложных слов с использованием MEG

1. Введение

Некоторые слова простые, а некоторые нет. Поначалу это звучит как очень банальная тавтология, но споры о том, хранятся ли мультиморфемные слова просто в виде целой словоформы (Butterworth, 1983; Giraudo and Grainger, 2001) или всегда строятся из их морфемных частей (Taft, 2004). ) был развлекательным, провокационным и спорным в области лексической обработки в течение последних 40 лет.Комплексная модель того, как слова сохраняются и извлекаются, требует понимания того, как связаны форма и значение и как эта связь разворачивается во времени в естественной речи.

Потенциальный контраст между хранением целого слова и хранением морфем впервые обсуждался в классической модели удаления аффиксов (Taft and Forster, 1975), которая предполагала, что лексический доступ включает доступ к основе морфологически сложных слов. Это исследование показало, что псевдосложные слова с реальной основой (например,g., de- juvenate ) потребовалось больше времени для отклонения в задаче лексического решения (и часто неправильно выбирались как слова), чем псевдосложные слова с реальными префиксами и несуществующими основами (например, de- pertoire ). Это было воспринято как доказательство того, что к морфемам обращались до лексического доступа, и они способствуют поиску лексического элемента в памяти. При использовании различных парадигм прайминга накопились доказательства в пользу доступности морфем во время лексического доступа (Marslen-Wilson et al., 1994; Растл и Дэвис, 2003; Тафт, 2004). Это привело к появлению моделей обработки, в которых морфологическая декомпозиция является автоматическим и необходимым этапом обработки сложных слов (Rastle et al., 2004). В недавних исследованиях (Fiorentino et al., 2014; Semenza and Luzzatti, 2014) изучались этапы разложения, чтобы увидеть, как значение морфемы интегрируется в значение сложного слова. Результаты электрофизиологии (Fiorentino et al., 2014) показали большую отрицательность для лексикализованных соединений (например,g., teacup) и новые соединения (например, tombnote) по сравнению с мономорфемными словами во временном окне 275–400 мс, что указывает на стадию, на которой значения морфем объединяются в английских соединениях. Эти психологические модели делают четкие прогнозы относительно стадий и динамики лексического доступа, но в настоящее время отсутствуют доказательства привязки этих стадий к определенным областям мозга. Это исследование направлено на выявление области, ответственной за состав значений морфем. Исследования из литературы по именованию картинок (Dohmes et al., 2004) предполагает, что на этом этапе должна быть большая активация для семантически прозрачных сложных слов, поскольку они демонстрируют большую концептуальную активацию и конкуренцию лемм в дополнение к эффекту морфологического перекрытия. Следовательно, эта область должна быть чувствительной только к составу сложных слов, значение морфемы которых имеет семантически прозрачное отношение к общему значению по сравнению со сложными словами, морфемы которых не разделяют семантические отношения, непрозрачный .

Это привело к появлению моделей обработки, в которых морфологическая декомпозиция является автоматическим и необходимым этапом обработки сложных слов (Rastle et al., 2004). В недавних исследованиях (Fiorentino et al., 2014; Semenza and Luzzatti, 2014) изучались этапы разложения, чтобы увидеть, как значение морфемы интегрируется в значение сложного слова. Результаты электрофизиологии (Fiorentino et al., 2014) показали большую отрицательность для лексикализованных соединений (например,g., teacup) и новые соединения (например, tombnote) по сравнению с мономорфемными словами во временном окне 275–400 мс, что указывает на стадию, на которой значения морфем объединяются в английских соединениях. Эти психологические модели делают четкие прогнозы относительно стадий и динамики лексического доступа, но в настоящее время отсутствуют доказательства привязки этих стадий к определенным областям мозга. Это исследование направлено на выявление области, ответственной за состав значений морфем. Исследования из литературы по именованию картинок (Dohmes et al., 2004) предполагает, что на этом этапе должна быть большая активация для семантически прозрачных сложных слов, поскольку они демонстрируют большую концептуальную активацию и конкуренцию лемм в дополнение к эффекту морфологического перекрытия. Следовательно, эта область должна быть чувствительной только к составу сложных слов, значение морфемы которых имеет семантически прозрачное отношение к общему значению по сравнению со сложными словами, морфемы которых не разделяют семантические отношения, непрозрачный .

Один из способов взглянуть на лексическую обработку сложных слов — посмотреть, может ли активация морфологической структуры модулировать доступность сложного слова. Некоторые исследования кросс-модального прайминга (Marslen-Wilson et al., 1994) показали, что праймирование в лексическом решении между словами, имеющими общую основу, происходило только тогда, когда простое число и цель имели связанные значения (например, , отклонение , штрих , отклонение , но , отдел — нет), в то время как другие исследования (Zwitserlood, 1994) с использованием прайминга с частичным повторением показали, что прайминг не зависит от семантических отношений между простым числом и целью. Однако исследования с использованием замаскированного прайминга, парадигмы сублиминального прайминга, где простому слову предшествует прямая маска, а за ним следует целевое слово (Forster and Davis, 1984), обнаружили, что при манипулировании семантической прозрачностью эффекты облегчения возникали для сложных слов независимо от имеют ли прайм и мишень один и тот же морфологический корень (Longtin et al., 2003; Rastle et al., 2004; Fiorentino and Poeppel, 2007; McCormick et al., 2008). Эти эффекты не проявлялись для морфологически простых слов (например,г., публичный дом ). Более быстрое время лексического решения было обнаружено для сложных слов, которые можно сегментировать на существующие морфемы, что означает, что замаскированные простые / немаскированные целевые пары без семантических отношений, такие как угол-кукуруза и бутлег-ботинок , показали ускоренное распознавание целевых слов с помощью величины, неотличимые от пар с семантическими отношениями, такими как очиститель-очиститель и чашка-чай .

Однако исследования с использованием замаскированного прайминга, парадигмы сублиминального прайминга, где простому слову предшествует прямая маска, а за ним следует целевое слово (Forster and Davis, 1984), обнаружили, что при манипулировании семантической прозрачностью эффекты облегчения возникали для сложных слов независимо от имеют ли прайм и мишень один и тот же морфологический корень (Longtin et al., 2003; Rastle et al., 2004; Fiorentino and Poeppel, 2007; McCormick et al., 2008). Эти эффекты не проявлялись для морфологически простых слов (например,г., публичный дом ). Более быстрое время лексического решения было обнаружено для сложных слов, которые можно сегментировать на существующие морфемы, что означает, что замаскированные простые / немаскированные целевые пары без семантических отношений, такие как угол-кукуруза и бутлег-ботинок , показали ускоренное распознавание целевых слов с помощью величины, неотличимые от пар с семантическими отношениями, такими как очиститель-очиститель и чашка-чай .

Поскольку общепринято, что морфологическая декомпозиция выполняется для каждого сложного слова, которое может быть исчерпывающим образом разобрано на существующие морфемы, исследования визуального распознавания слов должны сместить акцент с декомпозиции на последующие механизмы, задействованные для активации фактического значения сложного целевого слова. .Менье и Лонгтин (2007) предположили, что активация слова вступает в игру поэтапно, которые включают по крайней мере одну раннюю стадию морфологической декомпозиции и более позднюю стадию семантической интеграции морфологических частей. Fiorentino et al. (2014) представили доказательства основанного на морфемах пути активации слова, который включает разложение на морфологические составляющие и комбинаторные процессы, действующие на эти представления. Поскольку предыдущие исследования показали, что ранняя декомпозиция, вызванная морфологической структурой, происходит автоматически для прозрачных и непрозрачных слов, разница между этими двумя типами слов может проявиться на более позднем этапе комбинаторных операций.

Другой способ взглянуть на лексическую обработку сложных слов — это посмотреть, как форма отображается на значение. Это очень важно при обработке морфологически сложных слов, чтобы отделить то, как мозг воспринимает прозрачные слова от того, как он воспринимает непрозрачные. Это можно исследовать, посмотрев, как значения морфем складываются в мозгу. Существуют модели общего механизма связывания в построении предложений (Friederici et al., 2000) и в базовой композиции именных фраз (Bemis and Pylkkänen, 2011), которые вовлекают левую переднюю височную долю (LATL) в состав слов во фразы. .В парадигме минимальной композиции Bemis и Pylkkänen (2011) обнаружили, что два составных элемента во фразе прилагательное-существительное (например, красная лодка ) вызывают большую активацию в левой передней височной доле, LATL, примерно на 225 мс, чем два. несоставные элементы (например, xkq boat , случайная последовательность букв и слова). Это было воспринято как доказательство того, что базовая комбинаторная обработка данных поддерживается LATL. В сложных словах есть особый подкласс слов, которые имеют структуру, параллельную существительным фразам, известным как составные слова.Сложные слова обладают уникальным свойством состоять только из свободных морфем (отдельных слов). Составные слова также различаются по измерению семантической прозрачности , степени, в которой комбинация значений морфем соответствует общему значению слова. Это означает, что мы можем варьировать вклад морфем в композицию значения. Эти свойства делают составные слова отличным кандидатом для исследования морфологического состава сложных слов, поскольку они могут обеспечивать аналогичную структуру для работы, выполняемой на уровне фразы.Эти параллели приводят к тому, что LATL является кандидатом на композицию в пределах слова, и это обеспечивает интересную основу для изучения эффектов внутрилексической семантической композиции как аналога композиции на уровне фразы.

Таким образом, семантически прозрачные составные слова (например, почтовый ящик) должны вызывать большую активность в этой области, чем простые слова, поскольку их значения происходят из состава их морфемических частей, тогда как семантически непрозрачные составные слова (например,, бутлег) не должны вызывать большей активности, поскольку между их частями и значениями нет никакой связи. В общем, модель сложного распознавания слов потребует, по крайней мере, этих двух этапов обработки: разбора на базовые единицы (декомпозиция) и композиции этих словоформ в сложное значение. Чтобы распаковать эти этапы, мы предлагаем использовать два типа парадигм грунтования: грунтовку с частичным повторением (например, ДОРОГА-обочина), аналогичные парадигмам, используемым в исследованиях замаскированного грунтования, которые будут использоваться для исследования эффектов разложения в соединениях, и грунтовка с полным повторением (например,g., ROADSIDE-roadside), которые будут использованы для исследования композиционных эффектов их морфем. Штрихи условия повторения примирования использовали для оценки эффекта композиции в отсутствие поведенческой реакции. В этом отношении метод анализа аналогичен принятому Zweig и Pylkkänen (2009), в котором авторы напрямую сравнивают сложные (производные) слова, таким образом стремясь найти эффекты разложения, которые не зависят от прайминга. В этом исследовании используется задача создания именования слов для изучения этих этапов лексической обработки, поскольку она обеспечивает сопоставимые эффекты с задачами лексического принятия решений (Neely, 1991) и не требует пробных проб.Эта задача была выполнена, пока активность мозга регистрировалась с помощью МЭГ, чтобы исследовать, есть ли в левой височной доле область, отвечающая за морфологический состав. Это исследование вносит свой вклад в работу по характеристике нейронных основ лексической обработки сложных слов, предоставляя доказательства композиции в составных словах и связывая их с их нейронными коррелятами. Учитывая предшествующую литературу, мы ожидаем найти доказательства разложения для сложных слов, но не для симплексных слов.Это открытие согласуется с литературой по визуальному распознаванию слов, особенно с литературой по замаскированному праймингу, где есть облегчающие эффекты при прайминге морфологически сложных слов, но не морфологически простых слов. Однако мы не ожидаем увидеть это общее преимущество морфологической сложности в составе.

В общем, модель сложного распознавания слов потребует, по крайней мере, этих двух этапов обработки: разбора на базовые единицы (декомпозиция) и композиции этих словоформ в сложное значение. Чтобы распаковать эти этапы, мы предлагаем использовать два типа парадигм грунтования: грунтовку с частичным повторением (например, ДОРОГА-обочина), аналогичные парадигмам, используемым в исследованиях замаскированного грунтования, которые будут использоваться для исследования эффектов разложения в соединениях, и грунтовка с полным повторением (например,g., ROADSIDE-roadside), которые будут использованы для исследования композиционных эффектов их морфем. Штрихи условия повторения примирования использовали для оценки эффекта композиции в отсутствие поведенческой реакции. В этом отношении метод анализа аналогичен принятому Zweig и Pylkkänen (2009), в котором авторы напрямую сравнивают сложные (производные) слова, таким образом стремясь найти эффекты разложения, которые не зависят от прайминга. В этом исследовании используется задача создания именования слов для изучения этих этапов лексической обработки, поскольку она обеспечивает сопоставимые эффекты с задачами лексического принятия решений (Neely, 1991) и не требует пробных проб.Эта задача была выполнена, пока активность мозга регистрировалась с помощью МЭГ, чтобы исследовать, есть ли в левой височной доле область, отвечающая за морфологический состав. Это исследование вносит свой вклад в работу по характеристике нейронных основ лексической обработки сложных слов, предоставляя доказательства композиции в составных словах и связывая их с их нейронными коррелятами. Учитывая предшествующую литературу, мы ожидаем найти доказательства разложения для сложных слов, но не для симплексных слов.Это открытие согласуется с литературой по визуальному распознаванию слов, особенно с литературой по замаскированному праймингу, где есть облегчающие эффекты при прайминге морфологически сложных слов, но не морфологически простых слов. Однако мы не ожидаем увидеть это общее преимущество морфологической сложности в составе. Поскольку состав смысла регулируется семантически, мы ожидаем обнаружить влияние композиции на активность мозга только для прозрачных соединений.

Поскольку состав смысла регулируется семантически, мы ожидаем обнаружить влияние композиции на активность мозга только для прозрачных соединений.

2.Материалы и методы

2.1 Участники

Восемнадцать правшей, носителей английского языка в возрасте от 18 до 30 лет, с нормальным или исправленным зрением, все дали информированное согласие и приняли участие в этом эксперименте. Исследование было одобрено Университетским комитетом по деятельности с участием людей (UCAIHS) Нью-Йоркского университета. Данные MEG от трех участников были исключены из-за большого количества отказов от испытаний, вызванных шумовыми помехами (> 25%). Подробности отказа описаны в процедуре.

2.2. Материал

Все стимулы состояли из английских би-морфемных соединений (например, чашка) и морфологически простых существительных (например, шпинат), сопоставленных по длине и поверхностной частоте. Мы манипулировали семантической прозрачностью, включая полностью семантически прозрачные (например, чайная чашка) слова, в которых обе составляющие морфемы имеют семантическое отношение к значению всего соединения, и полностью семантически непрозрачные слова (например, фигня), в которых ни один из составляющих морфемы имеют семантическое отношение к составному значению.

311 английских словосочетаний были собраны из предыдущих исследований (Juhasz et al., 2003; Fiorentino and Poeppel, 2007; Fiorentino and Fund-Reznicek, 2009; Drieghe et al., 2010) и классифицированы с точки зрения семантической прозрачности с помощью семантики. задача на соответствие, выполняемая с помощью инструмента Amazon Mechanical Turk. В этом задании 20 участникам было предложено оценить по шкале от 1 до 7, насколько каждый компонент соединения относится к целому слову. По шкале 1 соответствует несвязанному, а 7 — очень близкому.Каждому участнику случайным образом представили один из компонентов каждого соединения. Соединения классифицировались как семантически непрозрачные (далее , непрозрачные, ), если сумма баллов их составляющих находилась в интервале 2–6, и как семантически прозрачные (далее , прозрачные ), если сумма была в интервале 10–14. Например, непрозрачный состав deadline получил суммарный рейтинг 3,76 с dead , что дает рейтинг прозрачности 1.44 и строка дает рейтинг 2.32. Точно так же составной кукольный домик получил суммарную оценку 11,79, где кукла внесла свой вклад в рейтинг прозрачности 6,47, а дом дал оценку 5,32. Для каждого типа слова было выбрано шестьдесят словосочетаний. Этот метод нормирования семантической прозрачности соответствовал методам, использованным в упомянутых предыдущих исследованиях. Морфологически простые слова (далее simplex : например, шпинат) были объединены из Rastle et al.(2004) и English Lexicon Project отбирали слова, закодированные на наличие только одной морфемы (Balota et al., 2007). Симплексные слова (например, бордел ) были выбраны так, чтобы они имели неморфологическую связь формы с их простыми числами (например, бульон ). Кроме того, эти слова были ограничены и выбраны таким образом, чтобы простое слово нельзя было разбить на более мелкие части без создания недопустимых морфем.

Например, непрозрачный состав deadline получил суммарный рейтинг 3,76 с dead , что дает рейтинг прозрачности 1.44 и строка дает рейтинг 2.32. Точно так же составной кукольный домик получил суммарную оценку 11,79, где кукла внесла свой вклад в рейтинг прозрачности 6,47, а дом дал оценку 5,32. Для каждого типа слова было выбрано шестьдесят словосочетаний. Этот метод нормирования семантической прозрачности соответствовал методам, использованным в упомянутых предыдущих исследованиях. Морфологически простые слова (далее simplex : например, шпинат) были объединены из Rastle et al.(2004) и English Lexicon Project отбирали слова, закодированные на наличие только одной морфемы (Balota et al., 2007). Симплексные слова (например, бордел ) были выбраны так, чтобы они имели неморфологическую связь формы с их простыми числами (например, бульон ). Кроме того, эти слова были ограничены и выбраны таким образом, чтобы простое слово нельзя было разбить на более мелкие части без создания недопустимых морфем.

2.3. Типовой проект дома

Три разных типа слов были сопоставлены в двух условиях прайминга: полное повторение и частичное (составляющее) повторение (см. Таблицу 1).Для условия повторного прайминга в качестве прайма и мишени использовали одно и то же соединение (например, чашка TEACUP). Для прайминга с частичным повторением мы использовали первый компонент соединения в качестве праймера (например, чайную чашку TEA). Для симплексного условия неморфологическая родственная форма использовалась в качестве составляющей в условии частичного повторения прайминга (например, SPIN-шпинат). Эти два условия прайминга были объединены для управления условиями, в которых прайм не имел семантического отношения к цели (например,г., DOORBELL-чашка; ДВЕРЬ-чашка).

Таблица 1. Матрица расчета .

2.4. Процедура

Все участники прочитали все элементы во всех условиях (всего 720), которые были разделены на три списка по 240 слов и рандомизированы в каждом списке. Порядок представления списков был сбалансирован между испытуемыми. Экспериментальной задачей было наименование слов: испытуемым предлагались пары слов, и их просили прочитать вслух второе слово каждой пары.Стимулы были представлены белым шрифтом Courier размером 30 пунктов на сером фоне с помощью PsychToolbox (Brainard, 1997). Каждое испытание начиналось с предъявления фиксирующего креста, затем штриховки, затем мишени. Каждая из этих визуальных презентаций была представлена в течение 300 мс с последующим пропуском 300 мс (см. Рисунок 1). Мы записали начальную латентность речи и высказывания каждого испытуемого для поведенческого анализа.

Порядок представления списков был сбалансирован между испытуемыми. Экспериментальной задачей было наименование слов: испытуемым предлагались пары слов, и их просили прочитать вслух второе слово каждой пары.Стимулы были представлены белым шрифтом Courier размером 30 пунктов на сером фоне с помощью PsychToolbox (Brainard, 1997). Каждое испытание начиналось с предъявления фиксирующего креста, затем штриховки, затем мишени. Каждая из этих визуальных презентаций была представлена в течение 300 мс с последующим пропуском 300 мс (см. Рисунок 1). Мы записали начальную латентность речи и высказывания каждого испытуемого для поведенческого анализа.

Рис. 1. Структура эксперимента .

Перед экспериментом форма головы каждого участника была оцифрована с использованием системы Polhemus Fastscan вместе с пятью точками индикатора положения головы, которые используются для совместной регистрации положения головы по отношению к датчикам MEG во время сбора данных.Электромагниты, прикрепленные к этим точкам, локализуются после того, как участники лежат внутри массива датчиков МЭГ, что обеспечивает совместную регистрацию систем координат головы и датчика. Форма головы используется во время анализа для совместной регистрации головы на МРТ участников. Половине участников МРТ не проводились; поэтому мы масштабировали общий эталонный мозг, который предоставляется в FreeSurfer, чтобы он соответствовал размеру голов этих участников.

Во время эксперимента участники оставались лежать в комнате с магнитным экраном, а реакцию их мозга контролировали градиентометры MEG.Экспериментальные элементы проецировались на экран, чтобы участник мог прочитать и выполнить задание. Данные МЭГ были собраны с использованием аксиальной системы градиентометра для всей головки с 157 каналами и тремя опорными каналами (Канадзавский технологический институт, Ноноичи, Япония). Запись проводилась в режиме постоянного тока, то есть без фильтра верхних частот, с фильтром нижних частот 300 Гц и режекторным фильтром 60 Гц.

2,5. Анализ

Мы исследовали латентность начала, время реакции на наименование слова, чтобы оценить эффекты морфологического разложения на основе Fiorentino and Poeppel (2007).Поскольку время реакции чувствительно к лексическим свойствам слов (Fiorentino and Poeppel, 2007), составные слова должны обрабатываться быстрее при праймировании, чем симплексные слова из-за остаточной активации ранее активированных морфем. Недекомпозиционный счет не предсказывает никаких различий из-за структуры слова, если слова правильно сопоставлены для соответствующих свойств всего слова. Таким образом, начальная задержка может использоваться, чтобы понять, есть ли эффект разложения. Поведенческие данные были проанализированы с использованием традиционного дисперсионного анализа для типа слова с помощью модели взаимодействия с частичным повторением.Прайминг с частичным повторением в задачах лексического решения использовался, чтобы продемонстрировать доступность морфем в сложных словах (Rastle et al., 2004). Подобные поведенческие эффекты были также обнаружены при использовании именования слов (см. Neely, 1991 для сравнительного обзора лексического решения и именования слов). Таким образом, свидетельство эффектов разложения можно наблюдать во времени реакции, чтобы говорить, , задержка начала . Предыдущие исследования привели к предсказанию, что должен быть стимулирующий эффект более короткой задержки начала из-за прайминга для соединений по сравнению с их эквивалентами из симплексных слов, поскольку сегментация на морфемы приводит к более быстрому доступу к сложному слову.

После сбора данных мозга мы применили метод непрерывно скорректированных наименьших квадратов (Adachi et al., 2001), процедуру снижения шума в программном обеспечении MEG160 (Yokogawa Electric Corporation и Eagle Technology Corporation, Токио, Япония), которая вычитает шум из Градиометры МЭГ основаны на измерениях шума в опорных каналах, удаленных от головы. Данные подвергались полосовой фильтрации в диапазоне 1–40 Гц с использованием БИХ-фильтра. Запись всего эксперимента была разделена на представляющие интерес эпохи, от -200 мс до до 600 мс после визуального отображения основного слова.Мы отклонили испытания, в которых максимальная амплитуда размаха превышала предел 4000fT, и уравняли испытания, чтобы иметь равное количество испытаний для каждого условия и для каждого типа слова для правильного сравнения. Средний процент отклоненных испытаний среди субъектов составлял 1,9%, а для каждого типа слова: 1,3% для непрозрачных, 2,2% для симплексных, 1,8% для прозрачных. Каналы датчиков были отмечены как плохие и отбрасывались для каждого испытуемого, если полное отклонение канала превышало 10%.

Запись всего эксперимента была разделена на представляющие интерес эпохи, от -200 мс до до 600 мс после визуального отображения основного слова.Мы отклонили испытания, в которых максимальная амплитуда размаха превышала предел 4000fT, и уравняли испытания, чтобы иметь равное количество испытаний для каждого условия и для каждого типа слова для правильного сравнения. Средний процент отклоненных испытаний среди субъектов составлял 1,9%, а для каждого типа слова: 1,3% для непрозрачных, 2,2% для симплексных, 1,8% для прозрачных. Каналы датчиков были отмечены как плохие и отбрасывались для каждого испытуемого, если полное отклонение канала превышало 10%.

Матрица ковариации шума была вычислена для каждого участника с использованием процедуры автоматического выбора модели (Engemann and Gramfort, 2015) на случайном выборе базовых эпох (120 эпох) от -200 мс до начала представления креста фиксации.Для участников с МРТ кортикальные реконструкции были сгенерированы с использованием FreeSurfer, в результате чего пространство источника составляло 5124 вершины (CorTechs Labs Inc., Ла-Хойя, Калифорния и MGH / HMS / MIT Центр биомедицинской визуализации Athinoula A. Martinos, Чарльстон, Массачусетс). Метод модели граничных элементов (БЭМ) использовался для моделирования активности в каждой вершине для расчета прямого решения. Обратное решение было сгенерировано с использованием этой прямой модели и матрицы ковариации шума и вычислено с ограничением фиксированной ориентации, требующим, чтобы дипольные источники были перпендикулярны кортикальной поверхности.Затем данные датчиков для каждого субъекта проецировались в их индивидуальное исходное пространство с использованием оценки минимальной нормы с корковыми ограничениями (все анализы проводились с использованием MNE-Python: Gramfort et al., 2013, 2014), в результате чего получались нормализованные по шуму карты динамических статистических параметров. (dSPM: Dale et al., 2000).

Для этого анализа наш дизайн (таблица 2) сводится к простому сравнению между составными (например, TEACUP) и симплексными словами (например, SPINACH) одного и того же размера, которые служили простыми числами в условии повторения (например,g. , TEACUP-teacup), описанный выше в разделе «Дизайн». Поскольку для этого анализа мы используем нейрофизиологические данные, относящиеся к молчаливому чтению слов, которые служили простыми числами, поведенческих данных для этих слов нет. Таким образом, мы также избегаем артефактов, связанных с произвольными движениями, которые могут поставить под угрозу анализ эффектов, представляющих интерес для исследования (Hansen et al., 2010).

, TEACUP-teacup), описанный выше в разделе «Дизайн». Поскольку для этого анализа мы используем нейрофизиологические данные, относящиеся к молчаливому чтению слов, которые служили простыми числами, поведенческих данных для этих слов нет. Таким образом, мы также избегаем артефактов, связанных с произвольными движениями, которые могут поставить под угрозу анализ эффектов, представляющих интерес для исследования (Hansen et al., 2010).

Таблица 2. Анализ простых чисел .

Мы исследовали нервную активность, локализованную во всей левой височной доле.Этот регион был выбран на основе композиционных эффектов, обнаруженных в предложениях (Friederici et al., 2000) или фразах прилагательное-существительное (Bemis and Pylkkänen, 2011). Чтобы проверить, была ли повышена активность соединений в этой области, был проведен тест t на остаточную активацию типа составного слова (непрозрачный, прозрачный) после удаления активации из симплексного контрольного слова от 100 до 600. мс после появления стимула. Карта мозга с p была создана для временных рядов, а пространственно-временные кластеры были идентифицированы для смежных пространственно-временных кластеров, у которых значение p было меньше 0.05 и длительностью не менее 10 мс. Значения t были суммированы для тех точек в кластере, которые соответствовали этим критериям. Затем сначала был выполнен тест непараметрической перестановки путем перетасовки меток типов слов, а затем вычисления кластеров, образованных новыми метками. Распределение, сгенерированное из 10 000 перестановок, было вычислено путем вычисления значимых уровней наблюдаемого кластера. Скорректированное значение p было определено из процента кластеров, которые были больше, чем исходный вычисленный кластер (Maris and Oostenveld, 2007).Эти тесты были рассчитаны с использованием пакета статистического анализа данных MEG, Eelbrain (https://pythonhosted.org/eelbrain/).

3. Результаты

3.

1. Морфологическая декомпозиция

1. Морфологическая декомпозицияС точки зрения поведения мы обнаружили значительный эффект прайминга с частичным повторением [ F (1, 17) = 25,91, p <0,001], но, что наиболее важно, взаимодействие типа слова с помощью прайминга [ F ( 2, 17) = 9,24, p <0,001] (рисунок 2).Этот эффект показывает, что именование составных слов облегчается в большей степени, чем для морфологически простых слов, если они начислены. В запланированных сравнениях были обнаружены достоверные различия между непрозрачными соединениями и симплексными словами [ F (1, 17) = 5,93, p <0,03], а также прозрачными соединениями и симплексными словами [ F (1, 17) = 14,46, p <0,005], но не между прозрачными и непрозрачными соединениями [ F (1, 17) = 2.84, p. > 0,1]. Эти результаты показывают, что даже в словообразовании существует чувствительность к морфологической структуре помимо орфографического и фонологического перекрытия, но этот этап обработки нечувствителен к значению морфем по отношению к составному слову, что согласуется с предыдущим литература по морфологическому разложению (Rastle et al., 2004; McCormick et al., 2008).

Рис. 2. Средство разницы задержки начала частичного повторения прайминга .

3.2. Морфологический состав

Результаты показывают достоверные эффекты большей активации прозрачных соединений по сравнению с их симплексными контролями в височной доле. С этим различием связаны два значимых кластера: первый кластер был локализован в передней средней височной извилине от 250 до 470 мс ( t = 4552,3, p <0,05, рисунок 3), а второй кластер активности был локализуется в задней верхней височной извилине от 430 до 600 мс (∑ t = 5654, p <0.05, рисунок 4). Однако не было обнаружено надежных кластеров для различия непрозрачных соединений и симплексных слов в височной доле.

Рис. 3. Разница между прозрачностью и симплексом в левой передней височной доле (LATL) .

Рис. 4. Разница между прозрачностью и симплексом в задней верхней височной мышце (pSTG) .

4. Обсуждение

Анализ разных типов слов по отдельности выявил очень последовательные доказательства того, что существует разница в том, как простые и сложные слова обрабатываются в мозгу.Поведенческие результаты подтвердили, что существует стадия лексического доступа, которая чувствительна к морфологическим формам в сложных словах, и продемонстрировали, что эти эффекты также могут наблюдаться в других модальностях тестирования, а именно, в именовании слов. Эффект начального латентного взаимодействия, когда составные слова создавались быстрее, чем морфологически простые слова, когда они начинались с их составной морфемы, в значительной степени согласуется с результатами в литературе по замаскированному праймингу по распознаванию слов и дает дополнительные доказательства того, что в лексическом доступе есть стадия декомпозиции. где сложные слова разбираются на свои морфемы (Rastle et al., 2004; Тафт, 2004; Моррис и др., 2007; Маккормик и др., 2008; Fiorentino и Fund-Reznicek, 2009). Операция синтаксического анализа происходит независимо от семантических отношений между составляющими морфемами и их сложным словом. Поскольку ранняя активация составляющих посредством морфологического разложения происходит независимо от семантической прозрачности, то, что отличает прозрачное и непрозрачное соединение, должно происходить, таким образом, на более поздней стадии морфемного состава. Повышенная активность прозрачных соединений в передней височной доле с 250 до 470 мс свидетельствует о стадии лексического доступа, на которой значения морфемы играют роль в доступе к общему значению слова.Bemis и Pylkkänen (2011) показывают комбинаторные эффекты в LATL для прилагательных слов примерно через 225 мс после предъявления критического слова. Разницу во времени можно объяснить разными моментами времени, в которые мы фиксируем начало действия стимула. В Bemis и Pylkkänen (2011) начало совпадает с началом существительного boat во фразе red boat , тогда как в нашем исследовании критическим стимулом является весь состав sailboat .

Повышенная активация в задней височной доле прозрачных соединений с 430 до 600 мс, которая следует за активностью в LATL, согласуется с тем фактом, что эта область участвует в лексическом поиске (Hickok and Poeppel, 2007; Lau et al., 2008). Lau et al. (2008) предположили, что задняя область височной доли является лучшим кандидатом для лексического хранения слов. Поскольку LATL отвечает за составление значения составляющих морфем, задняя височная доля будет отвечать за извлечение информации из сохраненного лексико-семантического представления. Эта область также участвует в преобразовании звука в значение (Binder et al., 2000), которое включает поиск фонологической информации. Это исследование согласуется с моделями декомпозиции из литературы по визуальному распознаванию слов и обеспечивает нейронную основу для этапа лексического доступа, участвующего в композиции значения в составных словах, тем самым помогая распутать когнитивные процессы, которые нечеткие, когда время реакции является единственной мерой .Объединяя результаты психолингвистических исследований с записями МЭГ активности мозга, полученные результаты предполагают, что распознавание соединений включает в себя отдельные стадии: стадию декомпозиции, которая не зависит от семантики, и стадию композиции, которая регулируется семантикой. Мы показали, что ход активации различается по сложности слова и семантической прозрачности.

Авторские взносы

Авторы TB и DC являются первыми авторами, поскольку оба они в равной степени внесли свой вклад в работу.

Финансирование

Эта работа поддержана Национальным научным фондом в рамках гранта № BCS-0843969 и Исследовательским советом Нью-Йоркского университета в Абу-Даби в рамках гранта № G1001 Института NYUAD Нью-Йоркского университета Абу-Даби. Работа по туберкулезу была поддержана исследовательской стипендией Национального научного фонда под номером DGE-1342536. Работа DC была поддержана Координацией повышения квалификации кадров высшего образования и Комиссией Фулбрайта в соответствии с Законом о взаимном образовательном обмене, спонсируемой Государственным департаментом Соединенных Штатов Америки, Бюро по вопросам образования и культуры.

Заявление о конфликте интересов

Авторы заявляют, что исследование проводилось при отсутствии каких-либо коммерческих или финансовых отношений, которые могут быть истолкованы как потенциальный конфликт интересов.

Благодарности

Мы хотели бы поблагодарить Алека Маранца за его поддержку и руководство этим проектом. Мы также хотели бы поблагодарить Машу Вестерлунд и Фиби Гастон за критические отзывы для этой статьи. Мы также хотели бы поблагодарить Джеффа Уокера из NYU MEG Lab за его помощь во время тестирования участников.

Список литературы

Адачи Ю., Симогавара М., Хигучи М., Харута Ю. и Очиаи М. (2001). Снижение непериодического магнитного шума окружающей среды при измерении МЭГ методом наименьших квадратов с постоянной корректировкой. заявл. Сверхпроводимость. IEEE Trans . 11: 669–672. DOI: 10.1109 / 77.3

CrossRef Полный текст | Google Scholar

Балота Д. А., Яп М. Дж., Кортезе М. Дж., Хатчисон К. А., Кесслер Б., Лофтис Б. и др. (2007). Проект английской лексики. Behav. Res. Методы 39, 445–459. DOI: 10.3758 / BF031

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Бемис, Д. К., и Пюлкканен, Л. (2011). Простая композиция: магнитоэнцефалографическое исследование понимания минимальных языковых фраз. Дж. Neurosci . 31, 2801–2814. DOI: 10.1523 / JNEUROSCI.5003-10.2011

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Биндер, Дж.R., Frost, J. A., Hammeke, T. A., Bellgowan, P. S., Springer, J. A., Kaufman, J. N., et al. (2000). Активация височной доли человека речью и неречевыми звуками. Cereb. Cortex 10, 512–528. DOI: 10.1093 / cercor / 10.5.512

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Баттерворт, Б. (1983). «Лексическое представление», в Language Production , Vol. 2, изд Б. Баттерворт (Лондон: Academic Press), 257–294.

Дейл, А.М., Лю, А. К., Фишл, Б. Р., Бакнер, Р. Л., Белливо, Дж. У., Левин, Дж. Д. и др. (2000). Динамическое статистическое параметрическое картирование: комбинирование ФМРТ и МЭГ для получения изображений корковой активности с высоким разрешением. Neuron 26, 55–67. DOI: 10.1016 / S0896-6273 (00) 81138-1

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Фиорентино, Р., Фунд-Резничек, Э. (2009). Маскированная морфологическая грунтовка составных компонентов. Ment. Lexicon 4, 159–193.DOI: 10,1075 / мл. 4.2.01fio

CrossRef Полный текст | Google Scholar

Фиорентино, Р., Найто-Биллен, Ю., Бост, Дж., И Фунд-Резничек, Э. (2014). Электрофизиологические доказательства комбинаторной обработки английских соединений на основе морфем. Cogn. Neuropsychol . 31, 123–146. DOI: 10.1080 / 02643294.2013.855633

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Фиорентино, Р., Поппель, Д. (2007). Сложные слова и структура в лексике. Lang. Cogn. Процесс . 22, 953–1000. DOI: 10.1080 / 0167011

CrossRef Полный текст | Google Scholar

Форстер К. И. и Дэвис К. (1984). Прайминг повторения и ослабление частоты в лексическом доступе. J. Exp. Psychol. Учиться. Mem. Cogn . 10, 680–698. DOI: 10.1037 / 0278-7393.10.4.680

CrossRef Полный текст | Google Scholar

Friederici, A. D., Wang, Y., Herrmann, C. S., Maess, B., and Oertel, U. (2000). Локализация ранних синтаксических процессов в лобных и височных областях коры: магнитоэнцефалографическое исследование. Hum. Brain Mapp . 11, 1–11. DOI: 10.1002 / 1097-0193 (200009) 11: 1 <1 :: AID-HBM10> 3.0.CO; 2-B

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Gramfort, A., Luessi, M., Larson, E., Engemann, D.A., Strohmeier, D., Brodbeck, C., et al. (2013). Анализ данных МЭГ и ЭЭГ с помощью MNE-python. Фронт. Neurosci . 7: 267. DOI: 10.3389 / fnins.2013.00267

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Грамфорт, А., Луесси, М., Ларсон, Э., Энгеманн, Д. А., Стромайер, Д., Бродбек, К. и др. (2014). Программное обеспечение МНЭ для обработки данных МЭГ и ЭЭГ. Neuroimage 86, 446–460. DOI: 10.1016 / j.neuroimage.2013.10.027

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Хансен, П. К., Крингельбах, М. Л., и Салмелин, Р. (2010). MEG: Введение в методы . Нью-Йорк, Нью-Йорк: Издательство Оксфордского университета.

Google Scholar

Юхас, Б.Дж., Старр, М. С., Инхофф, А. В., и Плак, Л. (2003). Влияние морфологии на обработку составных слов: свидетельства от именования, лексических решений и фиксации взгляда. руб. Дж. Психол . 94, 223–244. DOI: 10.1348 / 000712603321661903

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Longtin, C.-M., Segui, J., and Hallé, P.A. (2003). Морфологическая грунтовка без морфологической связи. Lang. Cogn. Процесс . 18, 313–334.DOI: 10.1080 / 016244000036

CrossRef Полный текст | Google Scholar

Марслен-Уилсон, В., Тайлер, Л. К., Вакслер, Р., и Олдер, Л. (1994). Морфология и значение в английской ментальной лексике. Psychol. Ред. . 101, 3–33. DOI: 10.1037 / 0033-295X.101.1.3

CrossRef Полный текст | Google Scholar

Маккормик, С. Ф., Растл, К., и Дэвис, М. Х. (2008). Есть ли в слове «фетиш» праздник? влияние орфографической непрозрачности на морфо-орфографическую сегментацию при визуальном распознавании слов. J. Mem. Lang . 58, 307–326. DOI: 10.1016 / j.jml.2007.05.006

PubMed Аннотация | Полный текст | CrossRef Полный текст | Google Scholar

Нили, Дж. Х. (1991). «Эффекты семантического прайминга в визуальном распознавании слов: выборочный обзор текущих результатов и теорий», в Basic Processes in Reading: Visual Word Recognition , ред. Д. Беснер и Г. В. Хамфрис (Хиллсдейл, штат Нью-Джерси: L. Erlbaum Associates), 264 –336.

Google Scholar

Растл, К.и Дэвис М. Х. (2003). Чтение морфологически сложных слов . Нью-Йорк, Нью-Йорк: Психология Пресс.

Google Scholar

Тафт, М., и Форстер, К. И. (1975). Лексическое хранение и поиск слов с префиксом. J. Verb. Учиться. Глагол. Поведение . 14, 638–647. DOI: 10.1016 / S0022-5371 (75) 80051-X

CrossRef Полный текст | Google Scholar

Цвейг, Э., Пюлкканен, Л. (2009). Визуальный эффект m170 морфологической сложности. Lang.Cogn. Процесс . 24, 412–439. DOI: 10.1080 / 016802180420

CrossRef Полный текст | Google Scholar

Zwitserlood, P. (1994). Роль семантической прозрачности в обработке и представлении нидерландских словосочетаний. Lang. Cogn. Процесс . 9, 341–368. DOI: 10.1080 / 016408402123

CrossRef Полный текст | Google Scholar

Инструменты автоматической сегментации и аннотации

Инструменты автоматической сегментации и аннотации

Инструменты, описанные в этом разделе, работают без прямого взаимодействия с пользователем, создание аннотированного или сегментированного ресурса на выходе.Многие из них требуют обучение и может быть доступно уже обученным для некоторых задач или быть доступным для пользователей тренироваться в соответствии с их потребностями.

Инструменты, которые в настоящее время доступны через WebLicht — веб-сайт CLARIN-D сервисный лингвистический рабочий процесс и среда выполнения инструмента — отмечены с маленьким значком:

Перечисленные здесь инструменты не являются исчерпывающим списком инструментов, доступных для WebLicht, и, как сервис растет, будет интегрировано больше инструментов. Для получения актуального и исчерпывающего списка инструментов, доступных через WebLicht, войдите на сайт WebLicht.

Разделение предложений и токенизация обычно понимаются как способ сегментирования. тексты, а не преобразовывать их или добавлять информацию о функциях. Каждый сегмент, будь то предложение или токен, соответствует определенной последовательности элементов более низкого уровня (токены или символы), который в целях дальнейшего исследования или обработки формирует единичный блок. Сегментация цифровых текстов может быть сложной в зависимости от языка текст и лингвистические соображения, необходимые для его обработки.

разделителей предложений, иногда называемых разделителями предложений , разбивать текст на отдельные предложения с однозначными разделителями.

Распознавание границ предложений в текстах звучит очень легко, но может оказаться сложной задачей. проблема на практике. Предложения не имеют четкого определения в общей лингвистике, и Программы разделения предложений основаны на пунктуации текстов и практических проблемы компьютерной лингвистики, а не лингвистической теории.

Знаки препинания появились очень давно, по крайней мере, в 9 веке до нашей эры. Стела Меша — камень с надписями, найденный в современной Иордании. описание военных походов моавитского царя Меши — это самая старая аттестация различных знаков препинания для обозначения слова разделение и грамматические фразы [ Compston1919 ], [ Martens 2011 ]. Однако до наших дней не во всех письменных языках использовалась пунктуация. Идея разделения письменных текстов на отдельные предложения с использованием некоторой формы пунктуация является изобретением итальянских печатников 16 века и не дошла до некоторых части света до середины 20 века.Это очень затрудняет разработать корпусы исторического языка, совместимые с инструментами, основанными на современных пунктуация. Добавление знаков препинания к старым текстам занимает много времени, и исследователи разные школы не всегда могут прийти к единому мнению о том, где должна стоять пунктуация.

На многих языках, включая большинство европейских языков, предложение разделительная пунктуация выполняет несколько функций, помимо пометки предложений. В точка часто обозначает аббревиатуры, а также используется для записи порядковых чисел или для разделения больших числовых выражений на группы по три цифры.Приговоры также могут заканчиваются множеством знаков препинания, кроме точки. Вопросительные знаки, восклицательные знаки, многоточие ( пропущенных слов, ), двоеточия, точки с запятой и множество других маркеров должны иметь свое назначение в конкретных контексты правильно определены, прежде чем их можно будет уверенно рассматривать в качестве приговора разделители. Дополнительные проблемы возникают с кавычками, URL-адресами и именами собственными, которые использовать нестандартную пунктуацию. Кроме того, большинство текстов содержат ошибки и несоответствия пунктуации, которые простые алгоритмы не могут легко определить или правильный.

Разделители предложений часто интегрируются в токенизаторы, но есть отдельные инструменты. в наличии в том числе:

- MX Терминатор

Разветвитель для английского языка, который можно обучить другим языкам.

- Стэнфорд ssplit

Разветвитель для английского, но достаточно эффективный для других языков, используйте аналогичные знаки препинания.

- Предложение OpenNLP Обнаружение

Разветвитель для английского языка, который можно обучить другим языкам.

Токен — это единица языка, похожая на слово, но не совсем то же самое. В компьютерной лингвистике часто более практично обсуждать токены, а не слова, так как токен включает в себя множество лингвистически нерелевантных и / или дефектных элементы, встречающиеся в реальных текстах (числа, сокращения, знаки препинания и т. д.) и избегает многих сложных теоретических соображений, связанных с обсуждением слова.

В наше время большинство языков имеют системы письма, заимствованные из древних языки, используемые на Ближнем Востоке и торговцами в Средиземном море, начиная с около 3000 лет назад.Латинский, греческий, кириллица, иврит и арабский алфавиты являются все произошли из общего древнего источника — широко распространенного финикийского используется в торговле и дипломатии — и большинство историков думают, что письменность системы Индии и Средней Азии имеют одинаковое происхождение. См. [ Fischer 2005 ] и [ Schmandt-Besserat 1992 ] для более полных историй письма.

Все написание системы, заимствованные из древних финикийцев, используют буквы, соответствующие определенным звукам.Когда слова написаны буквами, обозначающими звуки, слова могут быть только отличаются друг от друга, если они каким-то образом отделены друг от друга или если читатели буквы должны выяснить, где паузы и паузы. Первые языки систематически использовать буквы для обозначения звуков, обычно разделяя текст на словесные единицы с какой-либо отметкой — обычно полоса («|») Или двойная точка, похожая на двоеточие («:»). Однако эти знаки использовались непоследовательно, и многие языки имели алфавиты. со временем перестала использовать явные маркеры.Латынь, греческий, иврит и языки Индия не была написана с помощью какого-либо последовательного словесного маркера на протяжении многих веков. Пробелы между словами были введены в Западной Европе в 12 веке, вероятно, изобретен монахами в Великобритании или Ирландии и медленно распространился среди других страны и языки [ Saenger 1997 ]. С конца 19-го века, большинство языков — все, кроме нескольких в Тихоокеанской Азии — имеют было написано с регулярными пробелами между словами.

Для этих языков — большая, но далеко не вся работа по токенизации цифровых текстов. выполняется пробельными символами и знаками препинания.Самые простые токенизаторы просто разделите текст на пробелы, а затем отделите пунктуацию от концы и начала слов. Но то, как эти пробелы используются в все языки, и полагаясь исключительно на пробелы для идентификации токенов, в практика, работают очень хорошо. Токенизация может быть очень сложной, потому что жетонов не всегда совпадают с расположением пробелов.

Составные слова существуют во многих языках и часто требуют более сложной обработки.Немецкое слово Telekommunikationsvorratsdatenspeicherung («Сохранение телекоммуникационных данных») — это один случай, но В английском есть лингвистически похожие составы, например low-budget и первоклассных . Токенизаторы — или иногда похожие инструменты, которые можно назвать декомпаундерами или составными разветвители — часто предполагается, что такие соединения разделят на части, или предполагается, что они разделят только некоторые из них. Должны ли соединения быть разделение может зависеть от дальнейших этапов обработки.Для синтаксического анализа немецкого языка например, это часто нежелательно, потому что соединения обрабатываются синтаксически и морфологически как одно слово, т. е. множественное число и склонение изменяют только конец всего соединения, и синтаксические анализаторы могут распознавать части речи из последнего часть соединения. Во французском языке часто бывает наоборот, и такие соединения, как arc-en-ciel («радуга») и не может быть рассматриваются как отдельные слова, поскольку множественное число изменяет середину составного ( arcs-en-ciel ).Для поиска информации, напротив, Немецкие слова почти всегда разуплотняются, потому что поиск Vorratsdatenspeicherung («данные удержание ») должны совпадать с документами, содержащими Telekommunikationsvorratsdatenspeicherung . На французском, однако никому не нужно arc («арка», «Дуга» или «лук») или ciel («небо» или «Небо»), чтобы соответствовать arc-en-ciel . английский есть примеры обоих видов соединений, со словами вроде плавучих домов , которые ведут себя как немецкие соединения, но также частей речи , которые ведут себя как французские.

В других случаях что-то, что лучше всего рассматривать как один токен, может отображаться в тексте как несколько слов с пробелами, например New York . Это также неоднозначные соединения, где они могут иногда появляться как отдельные слова, а иногда нет. Взбиватель для яиц , Взбиватель для яиц и eggbeater все возможные на английском языке и означают то же самое предмет.

Короткие фразы, состоящие из нескольких слов, разделенных пробелами, также могут иногда лучше всего анализировать как одно слово, например фразу by and большая или боль в шее по англ.Это называется многословными терминами и может совпадать с тем, что люди обычно называют идиом .

Сокращения типа Я и тоже не создают проблемы, поскольку многие аналитические инструменты более высокого уровня, такие как тегеры части речи и синтаксические анализаторы могут потребовать их разбиения, и многие лингвистические теории рассматривают их как более одного слова для грамматических целей.

Фразовых глаголов в английском языке и отделяемых глаголов в немецком языке — еще одна категория проблема для токенизаторов, поскольку их часто лучше рассматривать как отдельные слова, но они разделены на части, которые могут не появляться в текстах рядом друг с другом.Для пример:

Когда мы любим других, мы, естественно, хотим говорить о них, мы хотим показать им от , как эмоциональные трофеи. (Александр МакКолл Смит, Друзья, любовники, Шоколадный )

Die Liebe im Menschen spricht das rechte Wort авс . («Народная любовь говорит правду слово », Фердинанд Эбнер, Schriften , vol.2.)

таких глаголов, как , чтобы показать в английском и aussprechen на немецком языке часто требуют лечения как холостого слова, но в приведенных выше примерах появляются не только как отдельные слова, но и с другими слова между их частями. Простые программы, которые просто ищут определенные виды персонажи не могут идентифицировать эти структуры как токены.

Какие соединения, если таковые имеются, должны быть разделены, а какие составные части должны быть обрабатывается как единый токен, зависит от языка текста и цели обработка.Последовательная токенизация обычно связана с определением лексической сущности, которые можно найти в каком-либо лексическом ресурсе, и для этого может потребоваться очень много комплексная обработка обычных текстов. Его цель — упростить и удалить отклонения от данных для дальнейшей обработки. Поскольку идентификация основных единиц в тексте должна предшествовать почти всем видам дальнейших обработка, токенизация — это первое или почти первое, что делается для любого задача лингвистической обработки.

Дополнительные проблемы могут возникнуть на некоторых языках. Из основных современных языков только Китайцы, японцы и корейцы в настоящее время используют системы письма, которые не считаются производными. от общего ближневосточного предка, и они не отмечают систематически слова в обычные тексты с пробелами или любым другим видимым маркером. Несколько юго-восточных азиатских языки — тайский, лаосский, кхмерский и некоторые другие, менее распространенные языки — до сих пор не используют пробелов или используют их редко и непоследовательно, несмотря на наличие систем письма, заимствованных из тех, что используются в Индии.Вьетнамский — который сегодня пишется с помощью латинского алфавита, но раньше писали как китайский — ставили пробелы между каждым слог, так что даже несмотря на то, что в нем используются пробелы, они не имеют большого значения в токенизация. Токенизация на этих языках — очень сложный процесс, который может использовать большие словари и сложные процедуры машинного обучения.

Как упоминалось в предыдущем разделе, токенизация часто сочетается с разделение предложений в одном инструменте.Вот несколько примеров реализации токенизаторов:

Тегеры части речи (PoS-тегеры) — это программы которые принимают токенизированный текст в качестве входных данных и связывают часть речи тег (тег PoS) с каждым токеном. Тегер PoS использует конкретный закрытый набор частей речи — обычно называется набором тегов в компьютерная лингвистика. Различные тегеры для разных языков обычно имеют разные, иногда радикально разные, наборы тегов или системы части речи.Однако для некоторых языков стандарты де-факто существуют в том смысле, что большинство тегеры части речи используют тот же набор тегов. Например, на немецком языке набор тегов STTS очень широко распространен, но в английском языке часто используются несколько различных наборов тегов, как набор тегов Penn Treebank и несколько версий набора тегов CLAWS.

Часть речи — это категория, которая абстрагирует некоторые свойства слов или жетоны. Например, в предложении Собака съела обед есть другими словами, мы можем заменить dog и по-прежнему иметь правильный предложение, такие слова, как кот или человек .Те слова имеют некоторые общие свойства и принадлежат к общей категории слов. PoS схемы предназначены для улавливания подобных сходств. Слова с одинаковыми PoS в некотором смысле похожи по своему использованию, значению или функции.

Части речи были изобретены независимо друг от друга по крайней мере три раза в далекое прошлое. Они задокументированы в 5 веке до нашей эры в Греции, примерно на тот же период в Индии, а со 2 века нашей эры в Китай.Нет никаких доказательств того, что какое-либо из этих трех изобретений было скопировано из других культур. Происхождение частей речи более подробно описано в [ Martens 2011 ]. Греческий грамматический текст 2-го века до н.э. The Art of Грамматика обрисовала в общих чертах систему из девяти категорий PoS, которые стали очень влиятельные в европейских языках: существительные, глаголы, причастия, артикли, местоимения, предлоги, наречия и союзы с именами собственными как подкатегория существительные.Эта схема повлияла на большинство используемых сегодня PoS-систем.

Современные лингвисты больше не думают о частях речи как о фиксированном коротком списке категории, единые для всех языков. Они не согласны с тем, стоит ли ни одна из этих категорий не является универсальной или какие категории относятся к каким конкретные слова, контексты и языки. Разные лингвистические теории, разные языки, и разные подходы к аннотации используют разные схемы PoS.

Наборы теговтакже различаются уровнем детализации. Современный корпус PoS схема, такая как набор тегов CLAWS, используемый для Британского национального корпуса, может далеко зайти выходя за рамки классических девяти частей речи и проводя десятки тонких различий. КОГТИ версия 7 содержит 22 различные части речи только для существительных. Сложные наборы тегов обычно организованы иерархически, чтобы отразить общие черты между разными классами слов.

Примеры широко используемых наборов тегов включают STTS для немецкого языка. [ Schiller et al.1999 ], набор тегов Penn Treebank для английского языка [ Санторини 1990 ], и набор тегов CLAWS для английского языка [ Garside et al. 1997 ]. Большинство наборов тегов PoS были разработаны для конкретных корпуса и часто вдохновляются старыми корпусами и схемами PoS. PoS-тегеры сегодня почти все инструменты, использующие машинное обучение и специально обученные для языка и набора тегов, которые они используют. Обычно их можно переобучить для новых наборов тегов. и языки.