«Прийти» или «придти» — правила написания с примерами

На чтение 4 мин. Просмотров 4.8k. Опубликовано Обновлено

Я ученик — для подготовке к уроку или ДЗ

31.08%

Я преподаватель — ищу материалы для урока

54.65%

Студент — для учебы

7.06%

Охранник в школе — просто нечем заняться )))

7.21%

Проголосовало: 4119

Оба слова – глаголы совершенного вида. Вопрос, который к ним задают, что сделать? Какой же вариант использования верный?

Единственный правильный вариант, используемый в современном языке, – прийти. Словарь Ожегова именно так трактует написание этого глагола.

Это слово действия изменяется по временам – пришел, придет, приходит. По лицам и числам – приду, придем, придете.

- Беда приходит всегда неожиданно.

- Он пришел с работы вовремя.

- Прийти на встречу к назначенному времени – признак хорошего воспитания.

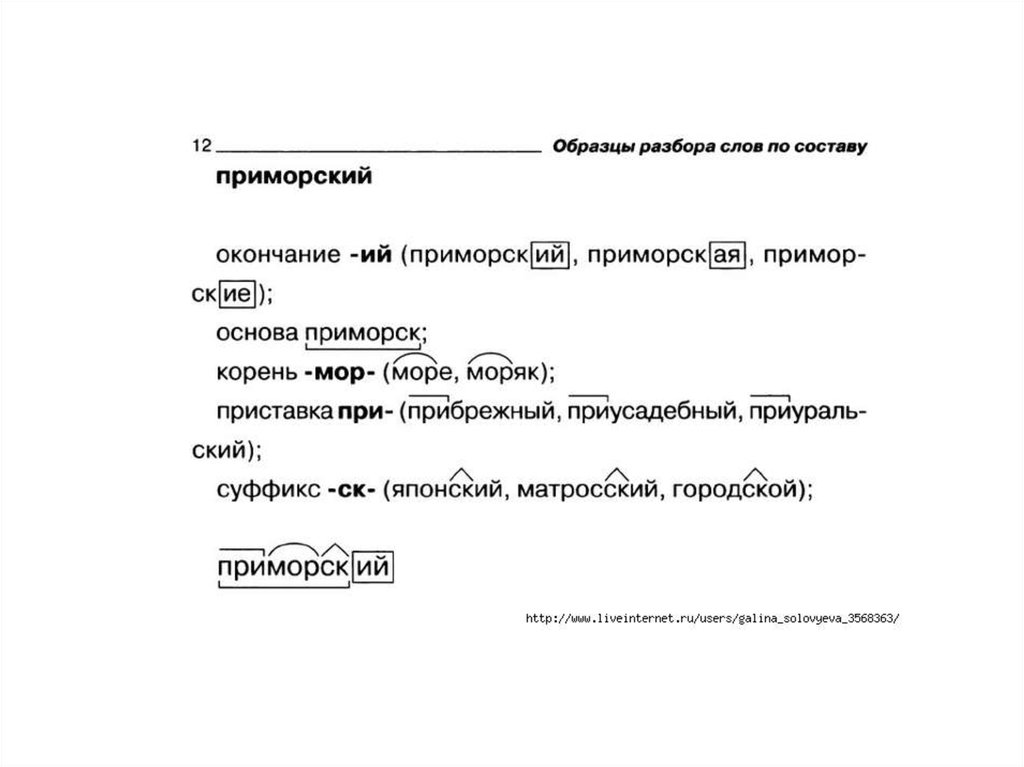

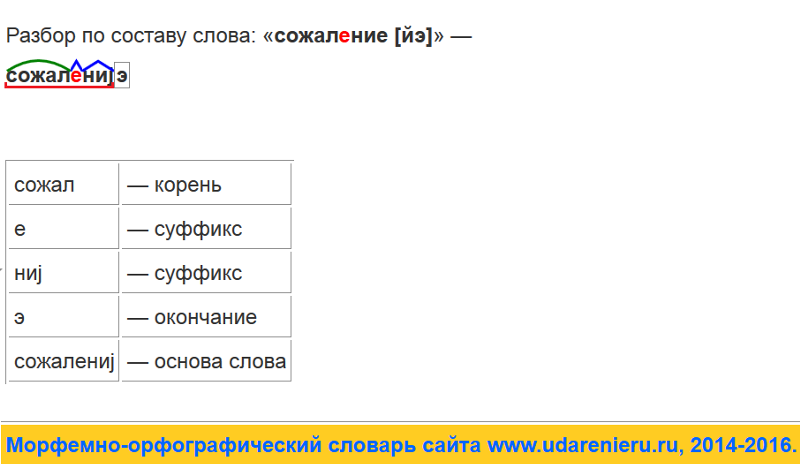

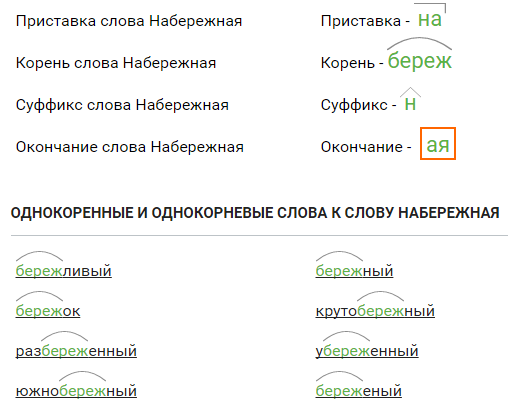

Морфемный состав глагола «прийти» интересен. Это неопределенная его форма, где при — – приставка, -й- – корень, -ти – суффикс инфинитива.

Все словоформы этого глагола объединяет единообразная приставка при- . Корень различен в каждой форме: при-й-ти, при-д-у, при-д-ем.

При образовании глаголов с другими приставками главная часть слова и суффикс остаются неизменяемыми: уйти, зайти, выйти, дойти, перейти.

- Ивченко хотел уйти с последнего урока.

- Выйти из школы после звонка, перейти улицу и оказаться в парке.

- Подойти к озеру и накормить плавающих там уток.

Если одна форма употребления правильная, откуда же возник вопрос о слове «придти»? Язык – явление не статическое, а динамическое.

В старых книгах, выпущенных до середины прошлого века, эта форма глагола употребляется достаточно часто.

В речевом обиходе использовались обе формы «прийти» и «придти». Однако первая с течением времени вытеснила вторую, оставшись единственно верным вариантом написания.

Объяснение правила Екатерины Л. из Пензы

Как правильно написать и употребить в речи глагол «идти» в будущем времени? При ответе на этот вопрос часто сомневаются даже те, кто считает себя знатоком русского языка.

Какой вариант употребления этого глагола можно считать верным — «прийти» или «придти»? Попробуем найти ответ на этот вопрос.

Стоит заметить, что в середине прошлого столетия обе версии считались правильными. Уважаемые издания публиковали произведения русских классиков, в которых можно было встретить и один, и второй вариант этого глагола.

В устной речи происходило тоже самое. Употребляли оба варианта глагола. Отклонением от норм русской речи это не считалось.

Отклонением от норм русской речи это не считалось.

Рассмотрим этот вопрос с точки зрения морфологии и ее современных правил.

Во-первых, в лексике русского языка есть слово «идти». Оно относится к несовершенному виду глагола и отвечает на вопрос «что делать?»

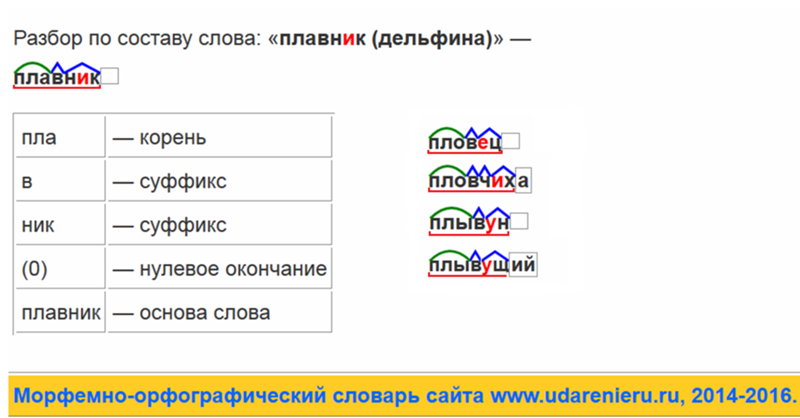

Например: Он собрался (что делать?) идти в гости. Если разобрать данное слово по составу, т.е. произвести морфемный анализ, то получится следующее: глагол «идти» состоит из корня -ид, и окончания -ти.

В настоящем времени слово «идти’ можно изменять по числам и лицам:

- Я иду — мы идем

- Ты идешь — вы идете

- Он идет — они идут

Во всех формах выделяется корень -ид.

Далее, попробуем из несовершенного вида перевести глагол «идти» в совершенный вид. Для этого потребуется использовать приставку — при. К приставке нужно добавить — идти. Получаем следующее: приидти.

Если разобрать получившееся слово по составу, то схема выглядит так — приставка/корень/окончание. Длинный звук [и] в корне слова «прийдти» произносить сложно и неудобно. Поэтому звук [д] выпал и произошло чередование с звука [д] на звук [й].

Длинный звук [и] в корне слова «прийдти» произносить сложно и неудобно. Поэтому звук [д] выпал и произошло чередование с звука [д] на звук [й].

Соответственно, правильное написание оформилось в варинт «прийти», а не «придти». Данное объяснение легко проверить. Если употребить глагол «идти» в совершенном виде, то в корне появляется буква «й».

Например: выйти, сойти, зайти, перейти. Все они отвечают на вопрос что сделать? А значит имеют совершенный вид глагола.

Споры о правильном употреблении глагола велись долгое время. В период с 1920 по 1950 годы произошла крупная реформа по упрощению русской орфографии. И правила написания многих слов были приведены в соответствие с правилами фонетики русского языка.

Так было установлено, что верная форма глагола «идти» в совершенном виде — «прийти». А вариант «придти» — неверный. И не отвечает правилам литературного русского языка. В этот период был издан орфографический словарь С.И. Ожегова. В нем нормативной формой глагола совершенного вида указан вариант «прийти».

- Примеры правильного употребления глагола «прийти».

- Мне нужно прийти на эту встречу?

- Всем необходимо прийти на час позже.

- Руководителям нужно прийти раньше.

«Придет» или «прийдет» как же пишется правильно

Нередко при личной или деловой переписке возникают сомнения, как правильно писать – «придет» или «прийдет»? Также вопрос о необходимости буквы «й» появляется при написании этого слова во множественном числе: «придут» или «прийдут».

В конце статьи вы можете пройти тест, чтобы закрепить полученную информацию.

Содержание

Правильное написание

В правилах русской орфографии говорится, как правильно написать слово «придет». В нём должна отсутствовать буква «й».

Если возникают вопросы о том, как пишется отрицательная форма «не придет», нужно отметить, что это – глагол, а он всегда пишется раздельно с частицей «не».

Примеры

- Маша думает, что сегодня ее брат не придет на ужин.

- Придет время, и мы сможем поехать в кругосветное путешествие.

- Он придет после обеда, когда разберется с документами.

- Вообще, Андрей не приходит вовремя. Но сегодня Лина сказала, что он придет ровно в 8.

Правило написания слова «придет»

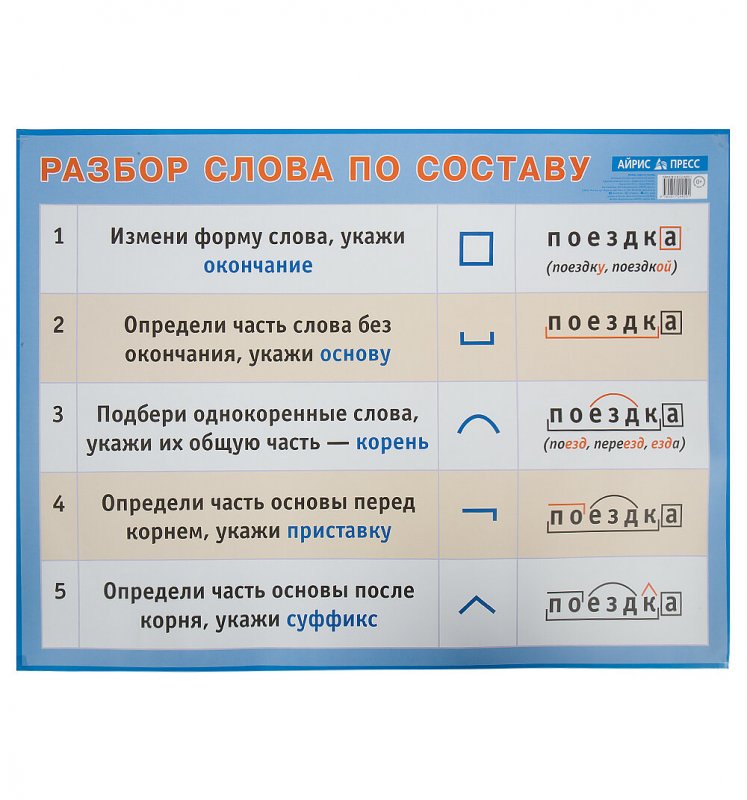

Данное слово является личной формой глагола «прийти»в форме будущего времени, происходящей от инфинитива «приходить». Чтобы запомнить, как писать правильно, нужно разобрать слово по составу:

- «прид» – основа;

- «при-» – приставка;

- «-д-» – корень;

- «-ет» – окончание.

В первоначальной форме «прийти» есть буква «й». Однако в будущем времени ее заменяет буква «д». Это же происходит с другими слова с корнем «д»: придете, придем и т.д.

От глагола «приходить» образованы такие причастия, как «пришедший», «приходящий».

Ошибочное написание

С неправильным правописанием связана не только форма инфинитива «прийти». В этом слове допускают ошибки в приставке. Например: прейдет или предет.

Например: прейдет или предет.

С этим глагол используется только приставка «при-», которая означает приближение и присоединение. Приставка «пре-» употребляется в значении «очень», поэтому ее написание в данном случае недопустимо.

Вариант «приидет» также ошибочный, поскольку используется в религиозном контексте и означает «откроется».

Как нельзя писать:

- Мы прийдем на встречу выпускников вместе с Ваней.

- Даже не знаю… Может, нам нужно придти на ужин?

- Давай напишем им сообщение? Может быть, они прийдут к нам вечером.

Синонимы к глаголу

Данный глагол используется в значении «следует куда-то; достигнет какого-либо места». Имеет ряд синонимов: явится, приедет, зайдет, наведается, посетит, нагрянет.

Использование варианта с корнем «йд» недопустимо, хотя нередко встречается в сообщениях и других личных переписках. Чтобы писать грамотно, нужно раз и навсегда запомнить, что личная форма данного глагола содержит только букву «д» в качестве всего корня.

Тест по теме

1.

Укажите, как пишется правильно:

Допустима только форма «придете»

Допустимо писать «прийдете»

Оба варианта верны

2.

Укажите предложение без ошибки:

Максим прийдет на работу послезавтра, потому что у него температура.

Придет время, и я покажу, кто тут главный!

Могу ли я прейти на собеседование после 18:00?

3.

Укажите предложение без ошибки:

Мама никогда не приходит так поздно. Надеюсь, она прийдет через 5 минут.

Вы прийдете на юбилей нашей свадьбы послезавтра?

Она придет на следующую пару, так как автобус сломался.

4.

Заполните пропуск: «Знал бы я, что вы … в таком наряде, оделся бы лучше»:

придете;

прийдете;

прейдете.

5.

Выберите предложение, где допустимо использовать форму «прийдет»:

Попробуй не наступить в грязь! Иначе мама прийдет с работы и накажет нас.

Да не прийдет он уже! Ты время видел?

Правильного ответа нет.

6.

Заполните пропуски: «Если ты не успеваешь …., обязательно сообщи заранее!»:

прийти;

придти;

прейти.

7.

Укажите букву, которая пишется в слове «при*дете» вместо пропуска:

й;

и;

никакая.

8.

Укажите предложение без ошибки:

Директор опаздывает, но обязательно прийдет на встречу.

Завтра Маша не придет на занятия. У нее болит живот.

Елена Петровна, а ваш сын прийдет к нам на стажировку?

9.

Отметьте правильное продолжение к утверждению: «Глагол «придет» может начинаться с приставки «пре-», если …»:

используется повторно в предложении;

используется с существительными женского рода;

никогда не начинается с данной приставки.

10.

Укажите предложение с ошибкой:

Оксана не предет послезавтра. Она поругалась с Наташей

Мы долго думали и решили, что Дима не придет на утренник. Он слишком мал.

Ты думаешь, Саша придет? До конца тренировки осталось 20 минут.

Композиционное обобщение в семантическом разборе: наборы данных | Денис Луковников | Analytics Vidhya

Если вы скажете человеку, что 🦓 — это зебра, а 🐴 — это лошадь, а затем покажете несколько предложений со словом «лошадь» (например, «Лошадь — это млекопитающее» и «Сколько ног у лошади? ») человек также сможет мгновенно понимать похожие предложения и задавать аналогичные вопросы о лошадях. Это пример способности человека к новым сочетаниям ранее увиденных элементов и конструкций, что называется «композиционным обобщением».

Хотя люди считают это само собой разумеющимся, нет уверенности в том, что наши модели НЛП обладают такой же способностью (спойлер: согласно многим документам, перечисленным ниже, у них это получается довольно плохо).

Измерение композиционного обобщения непросто и требует тщательного продумывания дизайна используемых наборов данных и их разбиений на обучение/тестирование. Тем не менее, благодаря некоторым (совсем недавним) замечательным работам, мы наблюдаем больший прогресс в этом вопросе, и, надеюсь, это еще не все.

Ниже мы рассмотрим некоторые существующие наборы данных.

(Lake and Baroni, ICML 2018)

Документ: https://arxiv.org/pdf/1711.00350.pdf

Это одно из первых исследований, указывающее на то, что существующие модели семантического анализа плохо обобщают новые комбинации. уже наблюдаемых элементов. Хотя используемые данные просты, статья указывает на очень интересную проблему современных систем. После публикации эта работа вдохновила на создание нескольких качественных работ, предлагающих различные решения проблемы, которые мы, надеемся, осветим в будущем.

В этой работе создается набор данных, состоящий из последовательностей слов, соединенных с последовательностями простых инструкций (например, JUMP). Входные последовательности генерируются с использованием простой CFG, а соответствующие выходные последовательности генерируются с использованием простых правил. В SCAN есть примитивных команд (например, LTURN, JUMP), а также модификаторы и союзы, которые помогают композиционно построить последовательность действий. Пример задачи дается парой

Входные последовательности генерируются с использованием простой CFG, а соответствующие выходные последовательности генерируются с использованием простых правил. В SCAN есть примитивных команд (например, LTURN, JUMP), а также модификаторы и союзы, которые помогают композиционно построить последовательность действий. Пример задачи дается парой

- ( «дважды повернуть налево» , LTURN LTURN) .

Итак, задача состоит в том, чтобы сопоставить последовательность «естественного языка» с последовательностью инструкций.

Авторы экспериментируют с различными архитектурами seq2seq на основе RNN, с вниманием и без внимания.

Было проведено три эксперимента с данными SCAN.

Во-первых, случайное разбиение доступных данных дает точность >99%. Высокая точность теста по-прежнему была достигнута с использованием лишь небольшой части обучающих примеров.

Затем авторы проверили, могут ли модели обобщаться до более длинных последовательностей . Примеры с самыми короткими последовательностями действий (выходами) использовались при обучении, а самые длинные — при тестировании. Все модели на этом сплите блестяще провалились (достигнув точности 20,8% 😮) и решили только тестовые примеры с кратчайшими последовательностями действий.

Примеры с самыми короткими последовательностями действий (выходами) использовались при обучении, а самые длинные — при тестировании. Все модели на этом сплите блестяще провалились (достигнув точности 20,8% 😮) и решили только тестовые примеры с кратчайшими последовательностями действий.

Наконец, авторы также экспериментируют с , «экстраполируя» примитив . Настройка такова, что определенная команда видится только как примитивный пример (например, «прыжок» → ПРЫЖОК) во время тренировки, в то время как все остальные команды видны в составных командах. В частности, тестировались только «повернуть налево» и «прыгнуть» , поскольку остальные варианты эквивалентны. Эксперименты показали, что вариант «повернуть налево» по-прежнему дает хорошие результаты (~ 90%), в то время как вариант «прыжок» полностью проваливается (~ 1% 🙊). Это различие объясняется тем, что если команда «повернуть налево» наблюдалась только изолированно (все остальные обучающие примеры не содержали этой команды во входных данных), то соответствующее ей действие LTURN наблюдалось при обучении в составе других команды (например, «иди налево и прыгни налево» ). В версии «прыжок» соответствующая команда JUMP при обучении вообще не наблюдалась.

В версии «прыжок» соответствующая команда JUMP при обучении вообще не наблюдалась.

Несмотря на то, что модель знала, что «прыгать» → ПРЫГАТЬ и понимала различные выражения с другими действиями (например, « идти и повернуть направо» ), модель не могла понять «прыгать» в этих контекстах ( например, « прыгнуть и повернуть направо» ).

(Финеган-Доллак, ACL 2018)

Документ: https://arxiv.org/pdf/1806.09029.pdf

В этой работе авторы сосредотачиваются на (1) сложности запросов, утверждая, что для человеческих вопросов требуются более сложные запросы, чем в автоматически генерируемых наборах данных и (2 ) разделение обучения/тестирования, где авторы утверждают, что стандартные разделения на самом деле не требуют обучения для создания новых шаблонов запросов.

При анализе наборов данных Text2SQL они обнаружили, что некоторые часто используемые имеют ограниченное количество шаблонов и что большие наборы данных не обязательно имеют пропорционально больше шаблонов запросов. Чтобы дополнительно изучить эффект, который это имеет, авторы пробуют простой подход на основе шаблонов, который автоматически идентифицирует шаблоны из обучающих данных, а во время теста назначает пример одного из этих шаблонов и заполняет его слоты. Эта базовая линия на основе шаблона достигает конкурентоспособной производительности с моделями seq2seq для нескольких наборов данных. Это вызывает беспокойство, потому что базовый план на основе шаблона не может обобщаться на новые шаблоны запросов по своей конструкции. Тем не менее, авторы обнаруживают, что seq2seq действительно демонстрирует некоторую способность обобщать за пределы шаблонов, наблюдаемых во время обучения.

Чтобы дополнительно изучить эффект, который это имеет, авторы пробуют простой подход на основе шаблонов, который автоматически идентифицирует шаблоны из обучающих данных, а во время теста назначает пример одного из этих шаблонов и заполняет его слоты. Эта базовая линия на основе шаблона достигает конкурентоспособной производительности с моделями seq2seq для нескольких наборов данных. Это вызывает беспокойство, потому что базовый план на основе шаблона не может обобщаться на новые шаблоны запросов по своей конструкции. Тем не менее, авторы обнаруживают, что seq2seq действительно демонстрирует некоторую способность обобщать за пределы шаблонов, наблюдаемых во время обучения.

Авторы также экспериментируют с другим разделением поезд/тест. Там, где обычно данные разбиваются таким образом, чтобы в тесте не встречалась пара (вопрос, запрос), которая происходила при обучении, авторы предлагают разделение на основе чисто шаблона запроса . Чтобы создать это разделение, они сначала анонимизируют сущности в запросах SQL и позволяют примерам с одним и тем же анонимным запросом быть только в обучении или тестировании. Это разделение оказалось гораздо более сложным для нескольких часто используемых наборов данных Text2SQL, что часто приводило к резкому снижению производительности. Это еще раз указывает на зависимость существующих моделей от запоминания шаблонов запросов.

Это разделение оказалось гораздо более сложным для нескольких часто используемых наборов данных Text2SQL, что часто приводило к резкому снижению производительности. Это еще раз указывает на зависимость существующих моделей от запоминания шаблонов запросов.

Таким образом, эта работа показывает, что обычно используемая методология оценки для семантического разбора может игнорировать композиционную способность моделей к обобщению, которая в значительной степени может быть сведена к модели заполнения слотов.

(Keysers et al., ICLR 2020)

Статья: https://openreview.net/pdf?id=SygcCnNKwr

Состав атомарных и составных фраз. Источник. В то время как работа над SCAN предоставила первоначальные доказательства неспособности стандартных моделей seq2seq обобщать невидимые композиции, установка в SCAN была чрезвычайно простой, а в данных использовалась лишь наноскопическая часть языка. В этой работе авторы нацелены на более интересную универсальную настройку семантического анализа для ответов на вопросы по графам знаний. И пока СКАН тестировал «повернуть налево» и «прыгнуть» , эта работа следует более систематическому подходу, который генерирует расщепления на основе максимального расхождения соединений при минимизации расхождения атомов.

И пока СКАН тестировал «повернуть налево» и «прыгнуть» , эта работа следует более систематическому подходу, который генерирует расщепления на основе максимального расхождения соединений при минимизации расхождения атомов.

Оценка композиционности на основе распределения

Основная идея этой работы состоит в том, чтобы создать набор данных/контрольный показатель с разделением обучения/теста, который сводит к минимуму перекрытие между соединениями, наблюдаемыми во время обучения, и теми, которые наблюдаются во время тестирования, и в то же время гарантирует, что все компоненты (атомы) для построения этих составных фраз во время теста наблюдались во время обучения.

Атомарные фразы можно рассматривать как те фразы, значение которых нельзя далее разделить на состав некоторых составных элементов. Например, слово «лошадь» напрямую относится к животному 🐴 и не подлежит дальнейшему разложению. Другие фразы, такие как «возраст» (относится к предикату age(X, Y) ) и шаблоны вопросов (например, «Что такое <предикат> <сущности>» ) также считаются атомами. . Напротив, соединения — это фразы, из которых состоят эти атомы. Например, «Сколько лет лошади» составляет все три вышеуказанных атома.

. Напротив, соединения — это фразы, из которых состоят эти атомы. Например, «Сколько лет лошади» составляет все три вышеуказанных атома.

Чтобы проверить композиционное обобщение моделей seq2seq, расщепления тестовой последовательности определяются таким образом, чтобы расхождение между распределениями атомов было минимальным, а расхождение между распределениями композиционных фраз (составное расхождение) должно быть максимальным. Когда все атомы были обнаружены во время обучения, система не страдает от проблем со словарным запасом, которые привели бы к очевидным потерям производительности. Однако минимизация количества общих соединений между тестом и обучением проверяет модель на ее способность составлять уже наблюдаемые атомы новыми, ненаблюдаемыми способами.

Набор данных

Авторы создают большой набор данных для семантического анализа на основе Freebase и предоставляют три различных разделения обучающих тестов, которые максимизируют составное расхождение при минимизации атомарного расхождения. Набор данных формируется автоматически, но, судя по примерам, вопросы выглядят вполне естественно.

Набор данных формируется автоматически, но, судя по примерам, вопросы выглядят вполне естественно.

По стандартам семантического разбора набор данных очень велик: 239 357 вопросов, 228 149 запросов и 34 921 шаблон запросов. И ввод, и вывод предоставляются в разных форматах, где объекты упоминаются по их имени, идентификатору или просто заполнителю. Это означает, что вам не нужно беспокоиться о запуске сущностей, связывающих ¯\_(ツ)_/¯.

Вопросы на английском языке:

- «Агустин Альмодовар был исполнительным продюсером Deadfall?» M1»

И запросы приведены в SPARQL:

- «SELECT count(*) WHERE {ns:m.04lhs01 ns:film.producer.films_executive_produced ns: m.0gx0plf}»

- 027

- «SELECT count(*) WHERE {M0 ns:film.producer. Films_executive_produced M1}”

- «Кошка улыбнулась» → кот(х) ∧ улыбка.агент(у, х)

Также приведены версии запросов SPARQL-заполнителей:

При проведении экспериментов авторы используют версии, в которых сущности заменены заполнителями.

Набор данных создается автоматически с использованием набора правил. Во-первых, генерируется вопрос на естественном языке и соответствующая ему логическая форма. Затем логическая форма сопоставляется с запросом SPARQL. Логическая форма использует вариант логики описания ℰℒ (ℰℒ DL допускает только пересечения и кванторы существования). Приложения правил образуют DAG, а подграфы этого DAG, соответствующие соединениям, используются для измерения составного расхождения.

Эксперименты

Авторы проводят эксперименты по CFQ, а также по SCAN с тремя моделями: LSTM+Attention, Transformer и Universal Transformer. При использовании случайного разбиения, что обычно и делается, все три модели достигают очень высокой производительности (выше 95%). Однако, когда модели обучаются с использованием расщеплений MCD, результаты резко падают ниже 20%!!! 😮

Результаты теста с бумаги.Авторы приходят к выводу, что нормальные модели, которые обычно повсеместно используются для семантического разбора, на самом деле совсем плохи, когда видят новые комбинации уже виденных вещей.

Точность CFQ для разных базовых уровней при изменении степени расхождения соединений.

Можно утверждать, что эти результаты являются ожидаемыми, поскольку распределения обучающих и тестовых данных резко различаются, и что модель даже не должна обрабатывать такое несоответствие.

С другой стороны, это не должно иметь значения, поскольку нам нужны семантические парсеры, способные создавать новые комбинации элементов.

(Shaw et al., 2020)

Документ: https://arxiv.org/pdf/2010.12725.pdf

В то время как критерий MCD CFQ обеспечивает хорошо обоснованное разделение, метод разделения CFQ полагается на входные и выходные данные, генерируемые набором правил. Это ограничивает применимость их критерия MCD только к синтетическим данным. В этой работе Shaw и соавт. предложить простую адаптацию MCD, которая вычисляет составную дивергенцию, используя только целевые представления (логические формы). Это позволяет находить расщепления TMCD также для уже существующих, созданных вручную примеров без каких-либо дополнительных аннотаций.

Этот показатель можно использовать для разделения существующих наборов данных (здесь используются GeoQuery и Spider). Авторы создают разделения, которые максимизируют TMCD, обеспечивая при этом, чтобы все атомы наблюдались хотя бы один раз во время обучения.

Для набора данных GeoQuery авторы используют версию FunQL и принимают все символы предикатов и сущностей как атомы. Составные — это комбинации родительских и дочерних символов в дереве FunQL. Обратите внимание, что соединения не обязательно должны быть полными (под)деревьями. Для SQL авторы берут отдельные токены как атомы и определяют составные части на основе разбора запросов CFG.

Дополнительный момент, на который обращают внимание авторы, заключается в том, что многие работы, посвященные композиционному обобщению, были оценены только с помощью SCAN и что их производительность на существующих стандартных наборах данных семантического анализа (таких как GeoQuery) может быть ниже номинала из-за компромиссов, сделанных для улучшения композиционное обобщение.

Наконец, авторы предлагают подход к семантическому анализу, в котором используется предварительно обученный преобразователь T5 seq2seq, а также автоматически индуцированный семантический анализатор на основе грамматики, о котором мы расскажем в следующей статье.

(Ким и Линзен, EMNLP 2020)

Документ: https://arxiv.org/pdf/2010.05465.pdf

Здесь авторы создают набор данных семантического анализа, который позволяет явно измерить пять лингвистически мотивированных типов обобщения. Это отличается от CFQ, который просто максимизирует сложное расхождение. Хотя COGS охватывает некоторые случаи (обобщение примитивов), использованные в предыдущих работах, диапазон категорий более широк.

Набор данных содержит предложения, соединенные с лямбда-выражениями. Предложения генерируются автоматически с использованием PCFG.

В наборе данных содержатся следующие категории обобщения:

1. Обобщение примитивов и других грамматических ролей:

Здесь есть два типа примеров:

a).

обучение только примитивам (атомам) и тестирование предложений, содержащих эти примитивы. Нарицательные существительные сопоставляются с унарными предикатами (например, «лошадь» → λx.horse(x) ), имена собственные сопоставляются с константами (например, «Rocinante» → ROCINANTE ), а глаголы сопоставляются с n-арными предикатами (пример из статьи: «like» → λx.λy.λe.like.agent(e,y) ∧ like.theme (е, х) ).

обучение только примитивам (атомам) и тестирование предложений, содержащих эти примитивы. Нарицательные существительные сопоставляются с унарными предикатами (например, «лошадь» → λx.horse(x) ), имена собственные сопоставляются с константами (например, «Rocinante» → ROCINANTE ), а глаголы сопоставляются с n-арными предикатами (пример из статьи: «like» → λx.λy.λe.like.agent(e,y) ∧ like.theme (е, х) ).Такие изолированные сопоставления наблюдаются только во время обучения. Во время тестирования эти примитивы используются в полном предложении вместе с другими константами и предикатами.

Обратите внимание, что это очень похоже на третий эксперимент SCAN, где проверяется обобщение примитивов, видимых только изолированно.

б). замена слова с объекта на субъект. Например, если во время обучения наблюдается «лошадь съела морковь» (здесь речь идет об испытуемом «лошадь» ), то в тестовой выборке не будет примеров, где «лошадь» используется в качестве подлежащее, но будет пример, где «лошадь» используется как прямое дополнение (например, «Дон Кихот ехал на лошади» ).

2. Модифицированные фразы в другой синтаксической роли

Когда, например, именная группа (NP) изменяется с предложной группой (PP), мы получаем новую NP, которая может использоваться в тех же синтаксических ролях, что и исходная NP. Например, [конь] (NP) и [[лошадь] [на поле]] (NP, состоящий из NP и PP) могут использоваться в предложении как объект или субъект.

Во время обучения COGS использует предложения с PP-модифицированными NP в качестве объекта, а во время тестирования PP-модифицированные NP используются в качестве субъекта.

3. Более глубокая рекурсия

Человеческий язык позволяет вкладывать фразы в другие фразы, что позволяет строить бесконечное количество выражений. Например, предложение может иметь один уровень вложенности: «Дон Кихот знал, что Росинант ел траву» , но это может быть и более глубокая: «Дон Кихот знал, что Санчо Панса знал, что Росинант ел траву» .

В COGS при обучении используется только до двух уровней вложенности, а в тестовых примерах этой категории используется строго три и более уровней.

Это позволяет измерить способность моделей экстраполировать на более длинные предложения с определенными типами рекурсии. Обратите внимание, что это чем-то похоже на второй эксперимент SCAN, где в обучении использовались более короткие последовательности, а затем модель тестировалась на более длинных.

Это позволяет измерить способность моделей экстраполировать на более длинные предложения с определенными типами рекурсии. Обратите внимание, что это чем-то похоже на второй эксперимент SCAN, где в обучении использовались более короткие последовательности, а затем модель тестировалась на более длинных.4. Глагольное чередование

Некоторые глаголы, которые могут использоваться в переходной форме ( «Дон Кихот накормил лошадь» ), могут также использоваться в пассивной форме ( «Лошадь накормили» ). Этот и другие шаблоны включены в набор данных COGS: конкретный глагол используется только одним способом (например, активным) в обучающем наборе, в то время как используется только другим способом (например, пассивным) в тестовом наборе.

5. Класс глаголов

Прежде чем обсуждать этот последний, давайте возьмем …

Небольшой экскурс в глаголы и семантику:

Некоторые более лингвистически подкованные читатели, вероятно, уже знают это и могут уверенно пропустить это.

Для остальных вот небольшой обзор терминологии, чтобы помочь понять, что представляет собой эта пятая категория.

Для остальных вот небольшой обзор терминологии, чтобы помочь понять, что представляет собой эта пятая категория. Глаголы могут быть переходными , что означает, что у глагола есть подлежащее и дополнение (например, «Росинант [subj]🐴 съел траву [obj]🌿» ). Но глаголы также могут быть непереходными , что означает, что у них нет объекта (например, «Росинант [subj] съел» ).

Теперь давайте повторим семантические роли. Субъект и объект — это грамматические роли, и хотя они обычно коррелируют с нашим пониманием того, кто что с кем делает, они не всегда правильны. Чтобы правильно описать, что кто-то кому делает, что было бы буквальным «значением» описываемого действия, мы можем лучше использовать семантические роли. Кроме того, семантические роли также предоставляют более точную информацию о последствиях действия.

The main semantic roles (a.

k.a. thematic relations) we are most interested in here are (1) Agent , (2) Theme and (3 ) Пациент , хотя есть несколько других, которые покрывают свой собственный кусок семантического пирога. Агент — это сущность в предложении, которая выполняет действие (например, «Росинант [Агент] ел траву». ). Роли «Тема» и «Пациент» являются получателями выполняемого действия, с той разницей, что состояние «Пациент» изменяется (например, «Росинант съел траву [Пациент]» ), а Тема — нет (например, «Росинант любит траву [Тема]»). ).

k.a. thematic relations) we are most interested in here are (1) Agent , (2) Theme and (3 ) Пациент , хотя есть несколько других, которые покрывают свой собственный кусок семантического пирога. Агент — это сущность в предложении, которая выполняет действие (например, «Росинант [Агент] ел траву». ). Роли «Тема» и «Пациент» являются получателями выполняемого действия, с той разницей, что состояние «Пациент» изменяется (например, «Росинант съел траву [Пациент]» ), а Тема — нет (например, «Росинант любит траву [Тема]»). ). Вернемся к глаголам. Среди непереходных глаголов есть неэргативные глаголы и неаккузативные глаголы. Неэргативный Глаголы – это глаголы, грамматический субъект которых также является их семантическим агентом (например, «Росинант съел» ) и невинительные глаголы — это глаголы, субъект которых является пациентом или темой, поэтому субъект сам страдает от действия (например, «Росинант исчез».

).

). Для последней категории «Класс глаголов» авторы отмечают, что грамматических ролей недостаточно для предсказания правильной структуры аргумента. Например, хотя как неэргативный, так и неаккузативный глагол кажутся синтаксически непереходными, подлежащее глагола в первом случае является Агентом, а во втором случае Темой или Пациентом, что также будет отражено в построенной логической форме.

Для проверки способности моделей семантического разбора к обобщению авторы включают случаи, когда определенный NP встречается только в одной роли при обучении и в другой при тестировании. Например, определенный NP наблюдается как субъект-агент (например, «Росинант» в «Росинант ел траву». ), но в наборе обобщения встречается как тематический субъект (например, «Росинант исчез 👻 .” )

Набор данных

Набор данных автоматически генерируется с использованием PCFG, и каждое предложение на естественном языке проходит этап автоматической обработки для создания логических форм.

Пример пары вопрос-логическая форма:

Наборы для обучения, разработки и тестирования содержат 24155, 3000 и 3000 экземпляров соответственно. Последние 155 примеров в обучающем наборе являются примитивами. Набор обобщений, который является тестовым набором, используемым для измерения композиционного обобщения, был создан с использованием другой PCFG и содержит 21000 примеров.

Результаты

Модели seq2seq на основе Transformer и LSTM были протестированы в экспериментах.

Как и ожидалось, результаты случайного тестирования (с использованием тестового набора из 3000 примеров) были близки к идеальным.

Однако производительность на наборе обобщений (набор тестов из 21 тыс. примеров, содержащих сложные случаи) была в среднем довольно низкой, с разными числами для разных случаев обобщения и высокой дисперсией между запусками. В целом, стандартные модели seq2seq сильно потерпели неудачу:

Авторы также провели анализ ошибок, сравнив лексический и структурный обобщение.

обучение только примитивам (атомам) и тестирование предложений, содержащих эти примитивы. Нарицательные существительные сопоставляются с унарными предикатами (например, «лошадь» → λx.horse(x) ), имена собственные сопоставляются с константами (например, «Rocinante» → ROCINANTE ), а глаголы сопоставляются с n-арными предикатами (пример из статьи: «like» → λx.λy.λe.like.agent(e,y) ∧ like.theme (е, х) ).

обучение только примитивам (атомам) и тестирование предложений, содержащих эти примитивы. Нарицательные существительные сопоставляются с унарными предикатами (например, «лошадь» → λx.horse(x) ), имена собственные сопоставляются с константами (например, «Rocinante» → ROCINANTE ), а глаголы сопоставляются с n-арными предикатами (пример из статьи: «like» → λx.λy.λe.like.agent(e,y) ∧ like.theme (е, х) ).

Это позволяет измерить способность моделей экстраполировать на более длинные предложения с определенными типами рекурсии. Обратите внимание, что это чем-то похоже на второй эксперимент SCAN, где в обучении использовались более короткие последовательности, а затем модель тестировалась на более длинных.

Это позволяет измерить способность моделей экстраполировать на более длинные предложения с определенными типами рекурсии. Обратите внимание, что это чем-то похоже на второй эксперимент SCAN, где в обучении использовались более короткие последовательности, а затем модель тестировалась на более длинных. Для остальных вот небольшой обзор терминологии, чтобы помочь понять, что представляет собой эта пятая категория.

Для остальных вот небольшой обзор терминологии, чтобы помочь понять, что представляет собой эта пятая категория.  k.a. thematic relations) we are most interested in here are (1) Agent , (2) Theme and (3 ) Пациент , хотя есть несколько других, которые покрывают свой собственный кусок семантического пирога. Агент — это сущность в предложении, которая выполняет действие (например, «Росинант [Агент] ел траву». ). Роли «Тема» и «Пациент» являются получателями выполняемого действия, с той разницей, что состояние «Пациент» изменяется (например, «Росинант съел траву [Пациент]» ), а Тема — нет (например, «Росинант любит траву [Тема]»). ).

k.a. thematic relations) we are most interested in here are (1) Agent , (2) Theme and (3 ) Пациент , хотя есть несколько других, которые покрывают свой собственный кусок семантического пирога. Агент — это сущность в предложении, которая выполняет действие (например, «Росинант [Агент] ел траву». ). Роли «Тема» и «Пациент» являются получателями выполняемого действия, с той разницей, что состояние «Пациент» изменяется (например, «Росинант съел траву [Пациент]» ), а Тема — нет (например, «Росинант любит траву [Тема]»). ).  ).

).