Словообразовательный разбор / Разборы. Проверка умений / Русский на 5

Тест №1

-

Какая производящая основа в паре слов:

быстренько — быстренький?- быстренько

- быстренький

-

Какая производная основа в паре слов:

угоднически — угодник?- угоднический

- угодник

-

Каков способ словообразования слова

щебет?- сокращение основы

- аббревиация

-

Каков способ образования слова

свежемолотый?- сложение основ

- сращение основ

-

Каков способ образования слова

недосып?- приставочный

- сокращение основы

Правильные ответы:

- быстренький

- угоднический

- сокращение основы

- сращение основ

- сокращение основы

Тест №2

-

Каков способ образования слова

осенью?- суффиксальный

- переход в другую часть речи

-

Каково средство образования слова

по-рыбацки?- приставка по-

- суффикс -и-

- приставка по- и суффикс -и-

-

Каково средство образования слова

преждевременный?- приставка прежде-

- суффикс -н-

- приставка прежде- и суффикс -н-

-

Каково средство образования слова

передвижник?- суффикс -ик-

- суффикс -ник-

- приставка пере- и суффикс -ик-

- приставка пере- и суффикс -ник-

-

Каково средство образования слова

снова?- приставка с-

- суффикс -а-

- приставка с- и суффикс -а-?

Правильные ответы:

- переход в другую часть речи

- приставка по- и суффикс -и-

- приставка прежде-

- суффикс -ик-

- приставка с- и суффикс -а-?

Тест №3

-

От каких слов образовано слово

РФ?- Россия

- Российская Федерация

-

Каким способом образовано слово

РФ?- сложение основ

- аббревиация

- переход в другую часть речи

- сокращение основы

-

Каким способом образовано

операционная?- приставочный

- суффиксальный

- приставочно-суффиксальный

- переход в другую часть речи

-

Какая основа является производящей для слова

сетчатка?- сетчатость

- сетчатый

- сетка

- сеточка

-

Какая основа является производящей для слова

лжец?- лживый

- лгун

- лгать

Правильные ответы:

- Российская Федерация

- аббревиация

- переход в другую часть речи

- сетчатый

- лживый

Тест №4

-

Какая основа является производящей для слова

зелень?- зеленеть

- зеленый

- зелёненький

- зелено

-

Какая основа является производящей для слова

никак?- никакой

- как

- какой

-

Какими процессами сопровождается образование слова

дороженька от производящей основы дорога?- чередование согласных г//ж

- появление соединительной гласной

- усечение основы

-

Какими процессами сопровождается образование слова

нефтепровод?- чередование согласных

- появление соединительной гласной

-

От каких основ образовано слово

нефтепровод?- нефть

- провод

- нефть, провод

- нефть, проводка

Правильные ответы:

- зеленый

- как

- чередование согласных г//ж

- появление соединительной гласной

- нефть, провод

Смотрите также

- Глава 5.

Словообразование

Словообразование - Особенности словообразовательного разбора

- Советы. Как приступить к делу

- Примеры и комментарии

- Типичные ошибки

- Первые шаги — подготовительные задания

- Тренинг «Словообразовательный разбор»

- Итоговые тесты «Словообразовательный анализ в формате ЕГЭ»

- В1 — В7. Работа с текстом. Владение языковедческими понятиями

— Понравилась статья?:)

Контрольный диктант в 9 классе № 11 | Сборник диктантов по Русскому языку в 9 классе с русским языком обучения

Цель: проверить соответствие знаний, умений и навыков учащихся требованиям учебной программы на конец 2-й четверти по теме «СПП с придаточными определительными и изъяснительными» и 1-го полугодия

Содержание контрольной работы направлено на выявление уровня развития умений, выбора условий для написания:

— проверяемые безударные гласные в корне слова;

-непроверяемые безударные гласные;

-правописание окончаний существительных;

-написание слов с пол-;

— написание приставок пре-, при-;

— н-нн в прилагательных;

-написание сложных наречий.

Постановка знаков препинания:

— запятая в ССП;

-запятая в СПП;

-запятая при однородных членах предложения;

-Запятая при обособленных членах предложения.

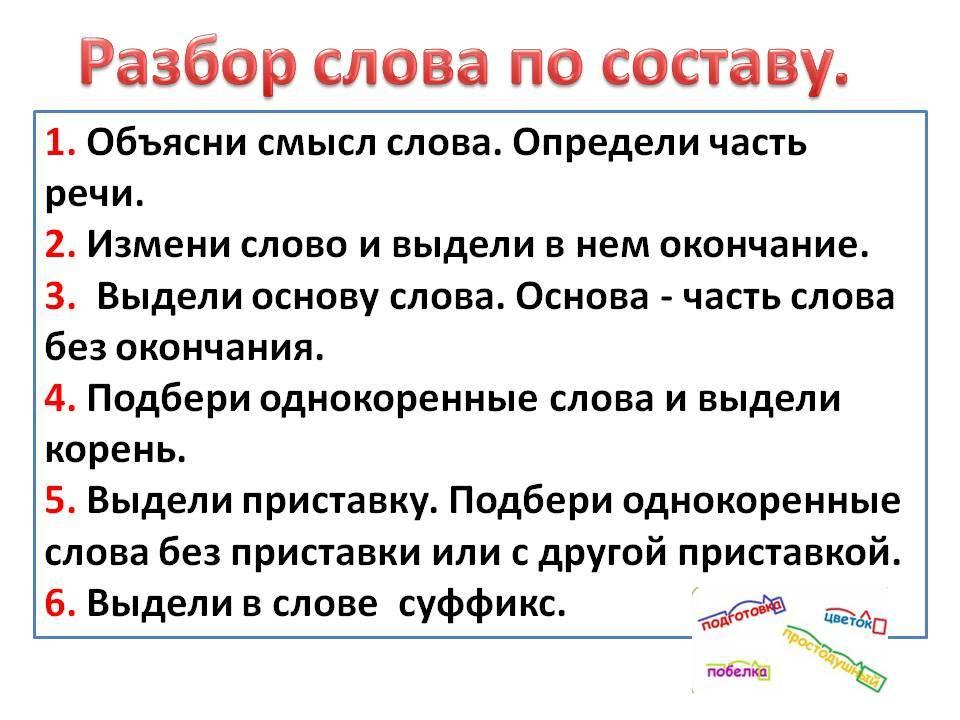

Грамматические задания направлены на выявление уровня сформированности практических умений и навыков:

— синтаксического разбора предложения;

-умение разбирать слова морфологически

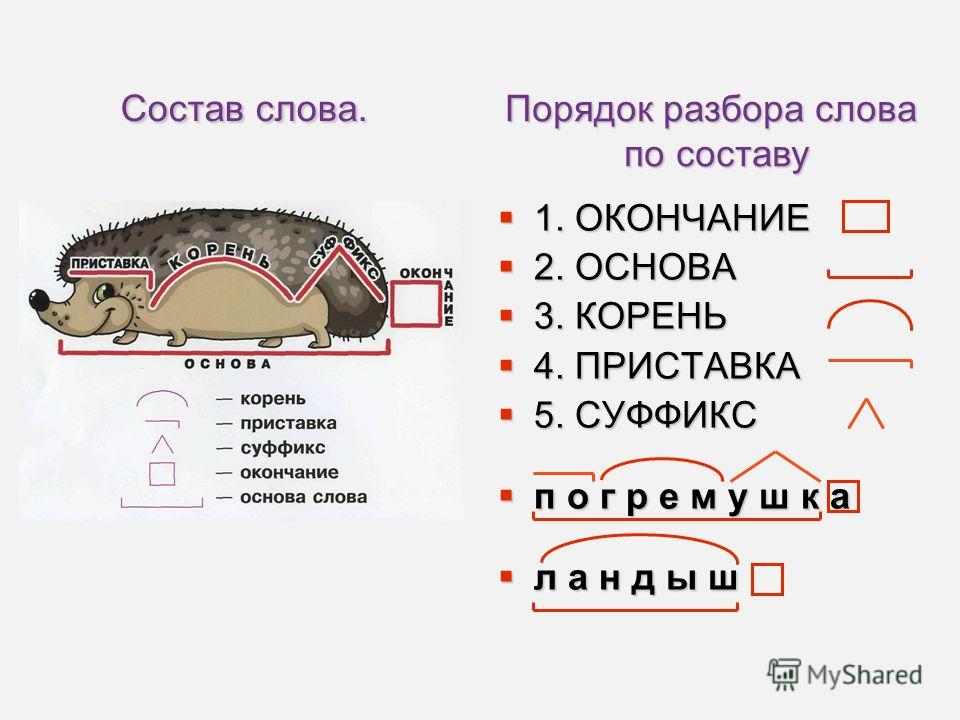

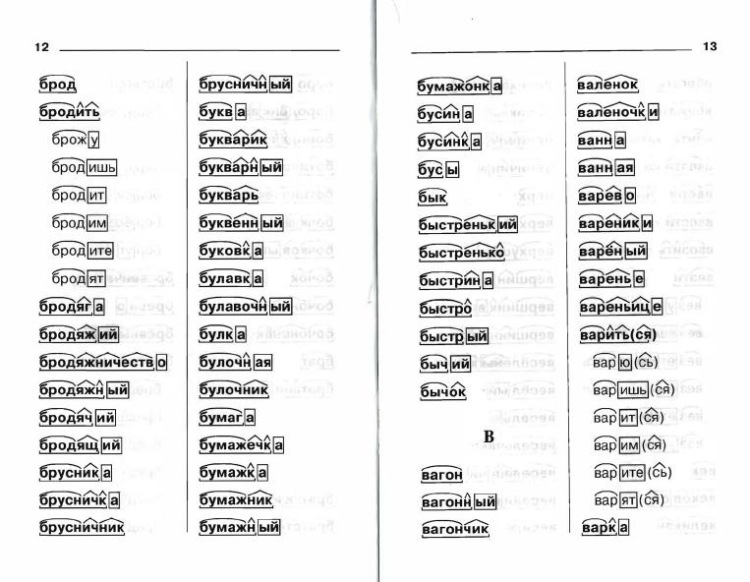

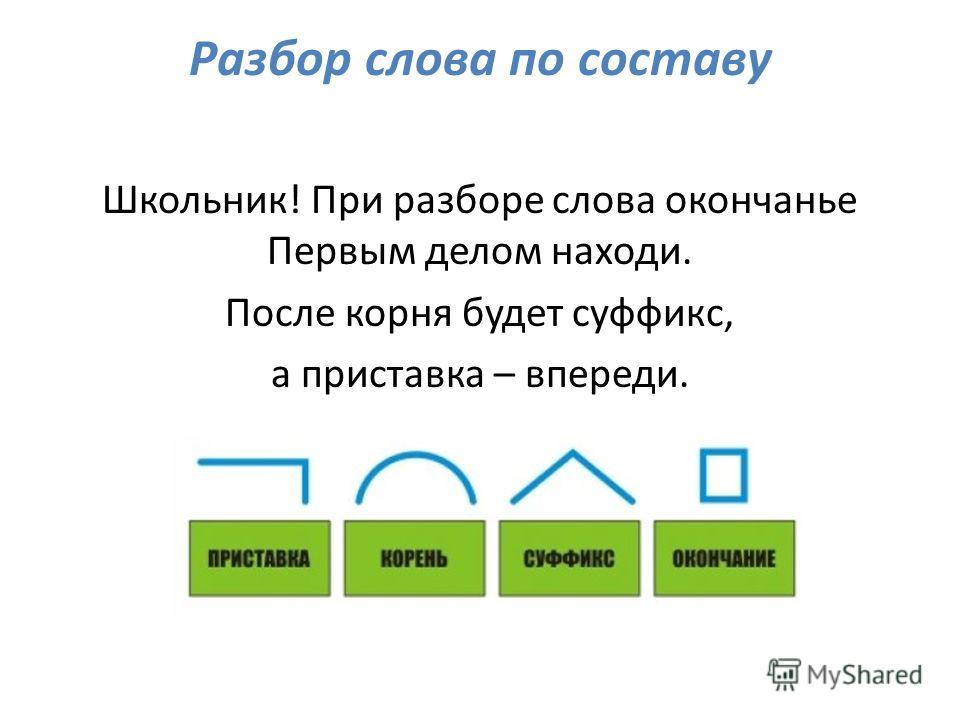

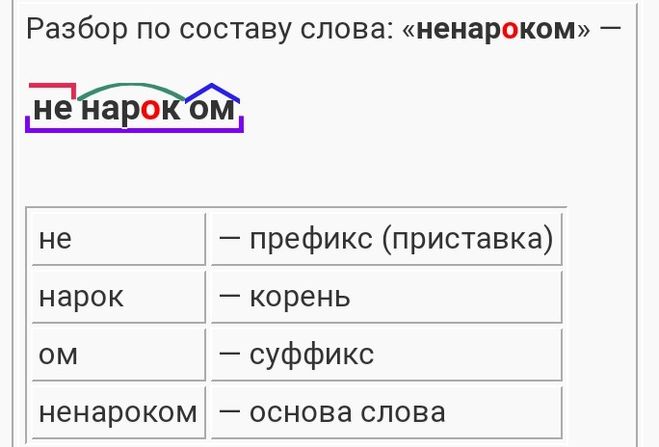

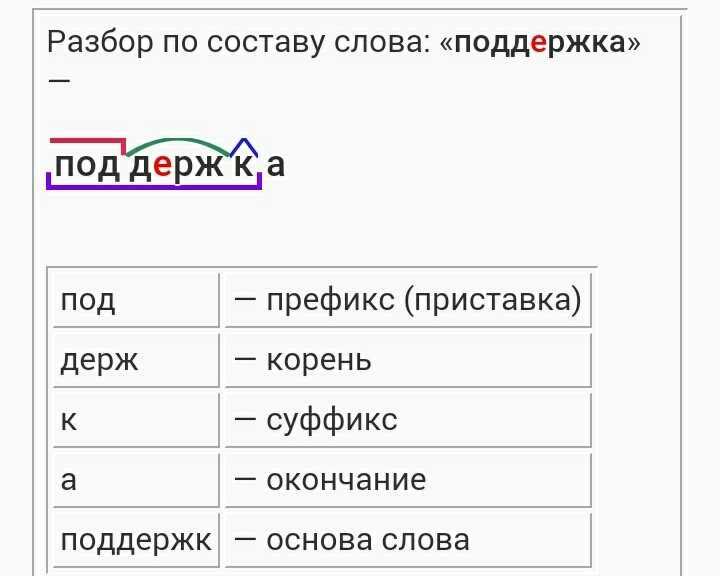

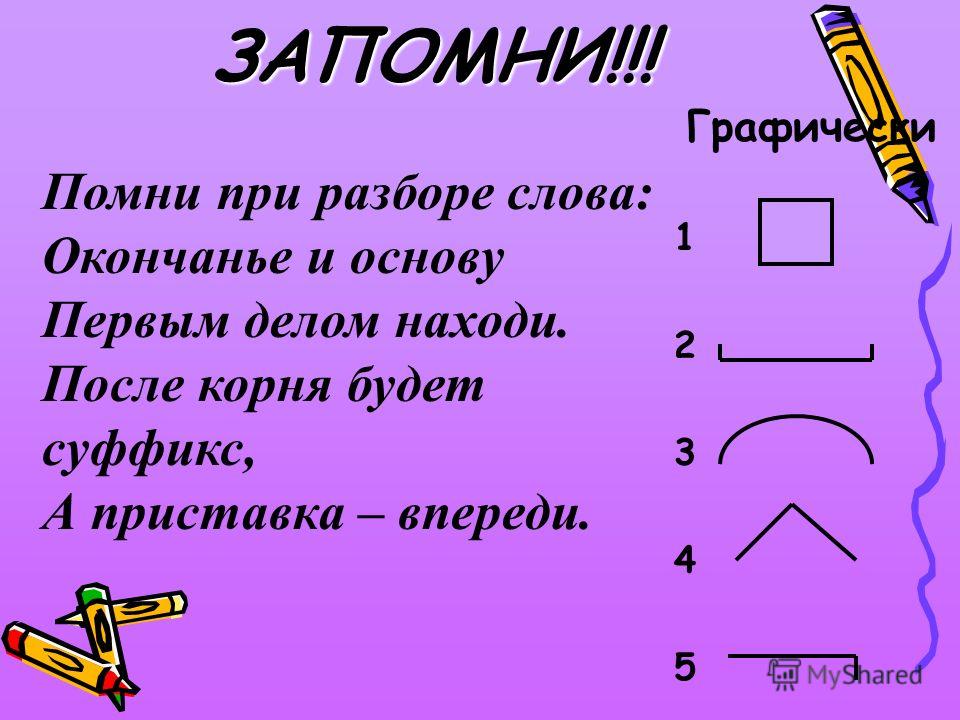

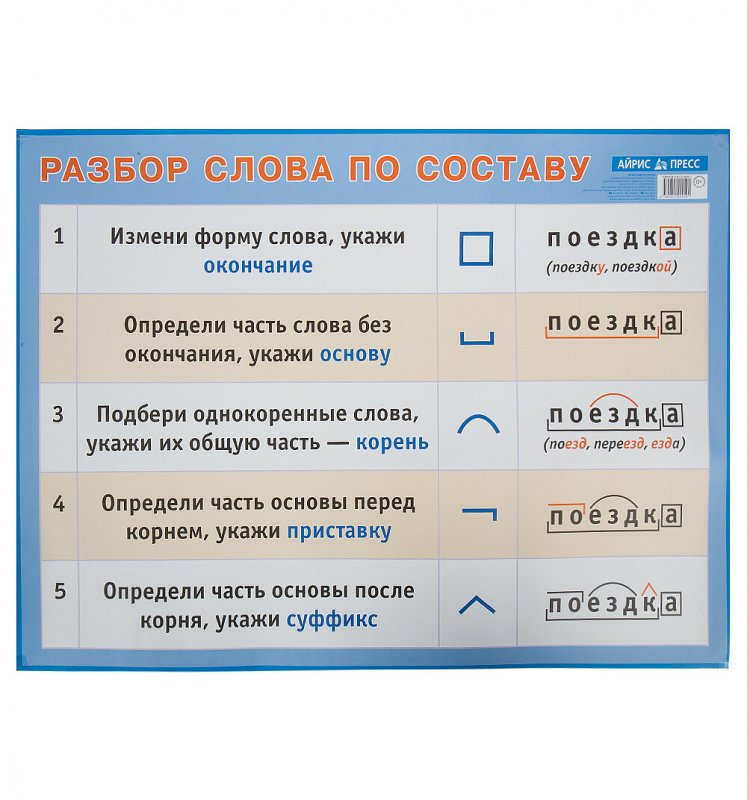

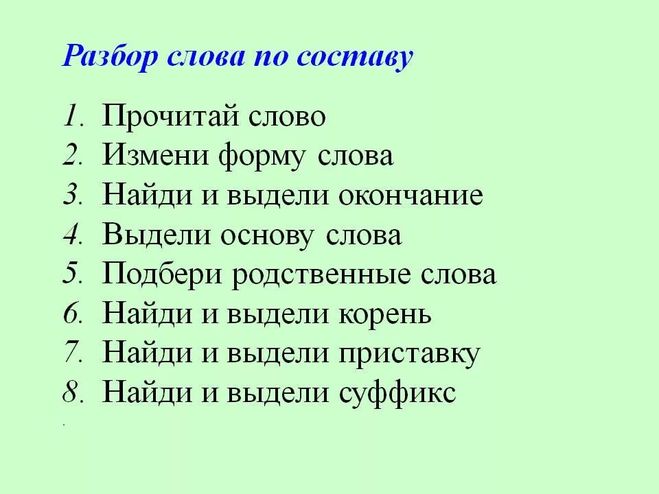

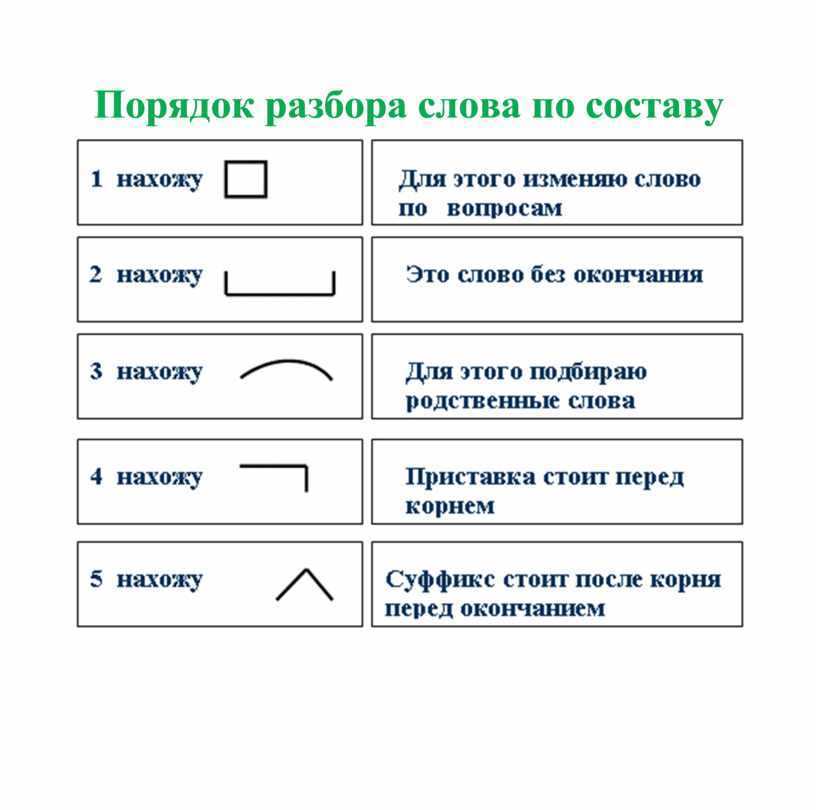

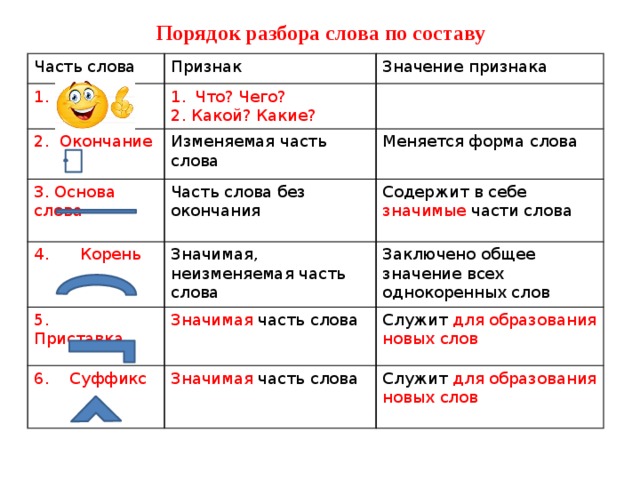

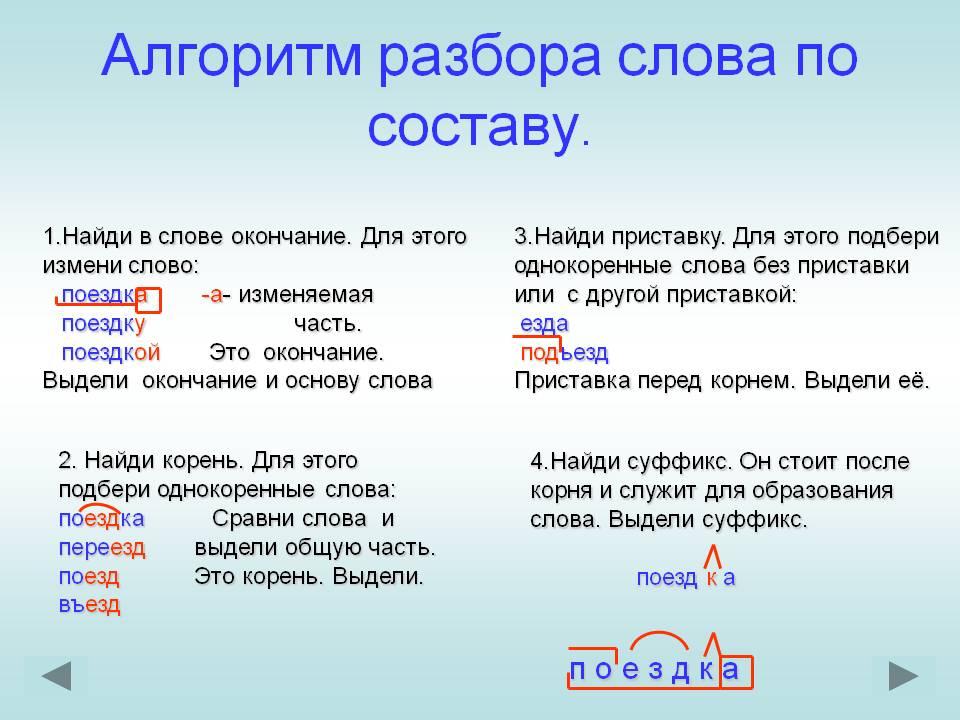

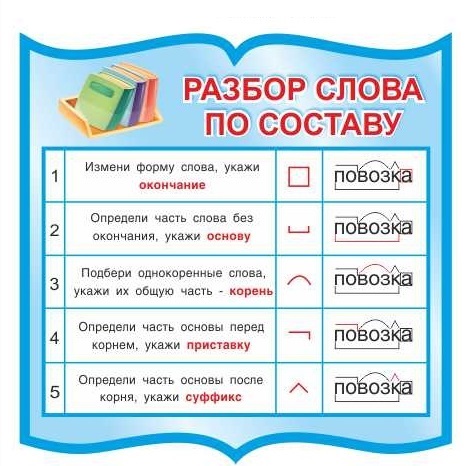

— разбора слова по составу;

— работы со словосочетаниями.

Диктант

Затопив в

землянке печурку, Поля

сварила чай и, как

только стемнело, легла

спать. Первые полчаса

было как-то тревожно

и неуютно. Всё

казалось, что кто-то

крадётся к землянке.

Вот-вот откроется дверь

— и войдут

чужие люди. Потом

поднимала голову, прислушивалась. Оказывается,

это похрустывало сено

под её телом.

В конце концов Поля убедила

себя, что тайга

пустынна в зимнее

время и ничто

ей не грозит.

С рассветом Поля, встав на лыжи, пошла дальше. Шла, как вчера, легко, излишне не торопилась, но и не мешкала зря на остановках. Посидит где-нибудь на валежнике, похрустит сухарями — и снова в путь.

Тайга лежала, закутанная в снега, притихшая, задумчивая. День выдался светлее вчерашнего. Несколько раз выглядывало солнышко, и тогда макушки деревьев со своими белыми пушистыми шапками становились золотыми и светились, как горящие свечи. Виднее становились и затёсы на стволах, за которыми Поля следила в оба глаза, чтобы не сбиться с пути.

(167 слов) (По Г. Маркову)

Грамматические задания

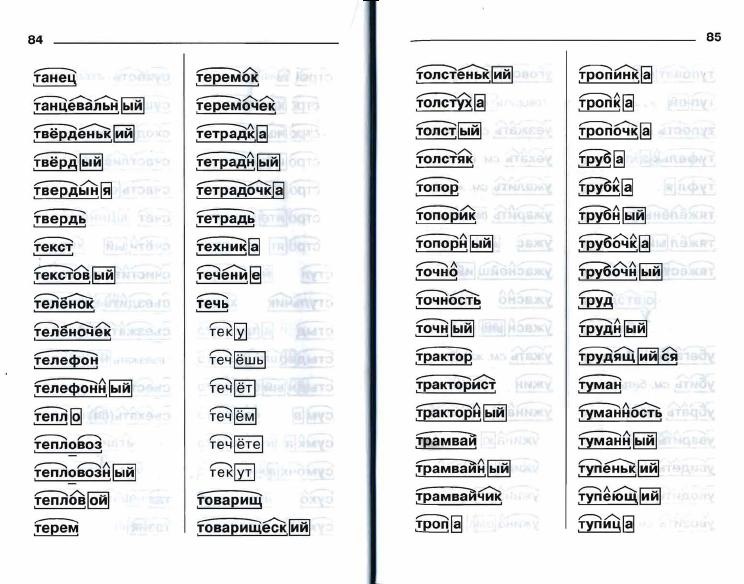

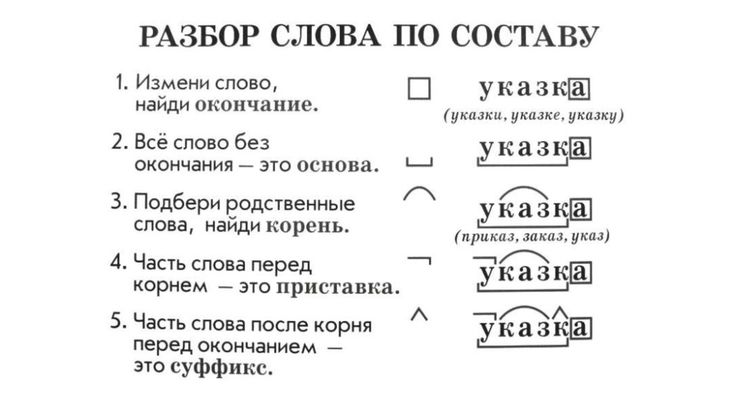

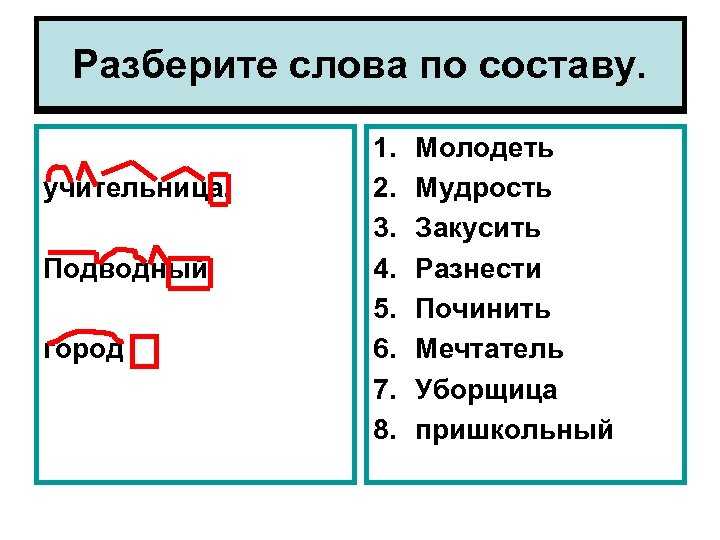

1. Разобрать слова по составу:

Похрустывало, закутанная, затопив — 1-й вариант;

притихшая, проспав, прислушивалась — 2-й вариант

2. Выполнить

морфологический разбор слова:

Выполнить

морфологический разбор слова:

Закутанная — 1-й вариант притихшая — 2-й вариант

3. Сделать синтаксический разбор предложения:

Всё казалось, что кто-то крадётся к землянке. — 1-й вариант

Виднее становились и затёсы на стволах, за которыми Поля следила в оба глаза. — 2-й вариант.

4. Выписать по одному словосочетанию на все виды подчинительной связи:

Из первого абзаца — 1-й вариант из остального текста — 2-й вариант

CSE 230, зима 2012 г. — монадический анализ

CSE 230, зима 2012 г. — монадический анализГлавная оценка Лекции Задания Ссылки Пьяцца

> импорт Data.Char

> импорт Data.Functor

> импорт Control.Monad

Прежде чем мы продолжим, слово от наших спонсоров:

**Не бойтесь монад**

Это просто (чрезвычайно универсальная) абстракция, например map или fold .

Синтаксический анализатор — это часть программного обеспечения, которая принимает необработанные Строка (или последовательность байтов) и возвращает некоторый структурированный объект, например, список опций, XML-дерево или объект JSON, Абстрактное синтаксическое дерево программы и так далее. Синтаксический анализ является одной из самых основных вычислительных задач. Каждая серьезная программная система имеет парсер, спрятанный где-то внутри, например

- Сценарии оболочки (параметры командной строки)

- Веб-браузеры (да!)

- Игры (дескрипторы уровней)

- Маршрутизаторы (пакеты)

- и т. д.

(Действительно, я бросаю вам вызов, чтобы найти какую-либо серьезную систему, которая не где-то занимается синтаксическим анализом!)

Самый простой и точный способ представить синтаксический анализатор как функцию

тип Parser = String -> StructuredObject

Составление парсеров

Обычный способ создания синтаксического анализатора заключается в указании грамматики и использовании генератора синтаксического анализа (например, yacc, bison, antlr) для создания фактической функции синтаксического анализа.

Thingy и Whatsit . Thingy : правило { действие }

; Whatsit: правило {действие}

;

Если вам нужен синтаксический анализатор для последовательностей Thingy и Whatsit , мы должны тщательно продублировать правила как

Thingies : Thingy Thingies { ... }

EmptyThingy { ... }

; Whatsits: Whatsit Whatsits {...}

EmptyWhatsit {...}

;

Это затрудняет повторное использование подпарсеров. Далее мы увидим, как составить мини-парсера для подзначений, чтобы получить большие парсеры для сложных значений.

Для этого мы немного обобщим приведенный выше тип синтаксического анализатора, отметив, что (суб-)парсеру не нужно (действительно, не будет) потреблять все его входных данных, и поэтому мы можем просто иметь синтаксический анализатор вернуть неиспользованный ввод

тип Parser = String -> (StructuredObject, String)

Конечно, было бы глупо иметь разные типы парсеров для разных типов объектов, поэтому мы можем сделать его параметризованным типом

Последнее обобщение: синтаксический анализатор может возвращать несколько результатов, например, мы можем захотеть проанализировать строку

.

"2 - 3 - 4"

либо как

Минус (Минус 2 3) 4

или как

Минус 2 (Минус 3 4)

> Парсер нового типа a = P (String -> [(a, String)])

Это просто парсер ( кашель действие) фактический разбор выполняется

> doParse (P p) s = p s

Давайте создадим несколько парсеров!

Вот очень простой анализатор символов, который возвращает первый Char из списка, если он существует

> oneChar :: Parser Char

> oneChar = P (\cs -> case cs of

> c:cs' -> [(c, cs')]

> _ -> [])

> twoChar0 = P (\cs -> случай cs из

> c1:c2:cs' -> [((c1,c2), cs')]

> _ -> [])

> twoChar9 = oneChar `pairP` oneChar

Запускаем анализатор

ghci> doParse oneChar "эй!"

[('ч',"эй!")]ghci> doParse oneChar ""

[]

Парсер Состав

Мы можем написать комбинатор, который принимает два парсера и возвращает новый парсер, который возвращает пару значений

парыP :: Анализатор a -> Анализатор b -> Анализатор (a,b)

пара P p1 p2 = P (\cs ->

[((x,y), cs'') | (x, cs' ) <- doParse p1 cs,

(y, cs'') <- doParse p2 cs ']

)

Теперь мы можем написать еще один анализатор, который получает пару значений Char

twoChar :: Parser (Char, Char)

twoChar = P (\cs -> case cs of

c1:c2:cs' -> [((c1, c2), cs')]

_ -> [])

или более элегантно, как

> twoChar = параP oneChar oneChar

, который будет работать так

ghci> doParse twoChar "эй!"

[(('h','e'), "y!")]ghci> doParse twoChar ""

[]

Теперь мы могли бы продолжать это делать, но часто, чтобы двигаться вперед, полезно сделать шаг назад и взглянуть на более широкую картину.

Вот тип парсера

Парсер нового типа a = P (String -> [(a, String)])

это должно напоминать тебе о чем-то другом, помнишь это?

тип ST a = состояние -> (a, состояние)

Действительно, синтаксический анализатор, как и преобразователь состояний, является монадой! если правильно прищуриться. Нам нужно определить функции return и >>= .

Первый очень простой, мы можем позволить типам вести нас

:тип returnP

returnP :: a -> Parser a

, что означает, что мы должны игнорировать входную строку и просто вернуть элемент ввода

.> returnP x = P (\cs -> [(x, cs)])

Привязка немного сложнее, но опять же, давайте опираться на типы

:type bindP

bindP :: Анализатор a -> (a -> Анализатор b) -> Анализатор b

, поэтому нам нужно высосать значения и из первого синтаксического анализатора и вызвать второй синтаксический анализатор с ними для оставшейся части строки.

> p1 `bindP` fp2 = P (\cs ->

> [(y, cs'') | (x, cs') <- doParse p1 cs

> , (y, cs'') <- doParse ( fp2 x) cs'])

Вооружившись ими, мы можем официально называть парсеры монадами

> экземпляр Monad Parser, где

> (>>=) = bindP

> return = returnP

Поскольку синтаксические анализаторы являются монадами, мы можем написать кучу высокоуровневых комбинаторов для объединения меньших синтаксических анализаторов в более крупные.

Например, мы можем использовать нашу любимую нотацию do , чтобы переписать пару P как

> параP px py = do x <- px

> y <- py

> возврат (x, y)

selectP p1 p2 = P ( -> doParse p1 cs ++ doParse p2 cs)

поразительно, точно так же, как пар функции отсюда.

Теперь давайте разомнем наши монадические мускулы и напишем несколько новых парсеров. Будет полезно иметь синтаксический анализатор сбоя , который всегда сгорает (возвращает [] )

> сбойP = P $ const []

Кажется немного глупым писать вышеизложенное, но полезно создать более богатые синтаксические анализаторы, подобные следующему, который анализирует Char , если удовлетворяет предикату р

> satP :: (Char -> Bool) -> Parser Char

> satP p = do

> c <- oneChar

> если pc, то вернуть c, иначе failP

мы можем написать несколько простых парсеров для определенных символов

> нижний регистрP = satP isAsciiLower

ghci> doParse (satP ('h' ==)) "mugatu"

[]

ghci> doParse (satP ('h' ==)) "hello"

[('h',"ello")] Следующий алфавит и числовые символы разбора соответственно

> alphaChar = satP isAlpha

> digitChar = satP isDigit

и этот малыш возвращает первую цифру строки как Int

> digitInt = do

> c <- digitChar

> return ((read [c]) :: Int)

который работает так

ghci> doParse digitInt "92"

[(9,"2")]ghci> doParse digitInt "cat"

[]

Наконец, этот синтаксический анализатор будет анализировать только определенный Char передано как ввод

> char c = satP (== c)

Комбинатор недетерминированного выбора

Теперь давайте напишем комбинатор, который принимает два подпарсера и недетерминированно выбирает между ними.

> selectP :: Парсер a -> Парсер a -> Парсер a

Как бы мы закодировали выбор в наших парсерах? Итак, мы хотим вернуть успешный синтаксический анализ, если или синтаксический анализатор успешен. Поскольку наши синтаксические анализаторы возвращают несколько значений,

> p1 `выбрать P` p2 = P (\cs -> doParse p1 cs ++ doParse p2 cs)

Мы можем использовать приведенный выше комбинатор для создания синтаксического анализатора, который возвращает либо алфавит, либо числовой символ

> alphaNumChar = alphaChar `выберитеP` digitChar

Когда мы запускаем это выше, мы получаем довольно интересные результаты

ghci> doParse alphaNumChar "cat"

[('c',"at")]

ghci> doParse alphaNumChar "2cat"

[('2',"cat")]

ghci> doParse alphaNumChar "2at"

[('2',"в")]

Что еще лучше, так это то, что если оба синтаксических анализатора завершатся успешно, вы получите все результаты. Например, вот синтаксический анализатор, который берет

Например, вот синтаксический анализатор, который берет n символов из ввода

> захватить :: Int -> Строка синтаксического анализатора

> захватить n | n <= 0 = возврат ""

> | иначе = do c <- oneChar

> cs <-grabbn (n-1)

> return (c:cs)

grabn n = последовательность (возьмите n $ цикла oneChar) grabn n = последовательность (повторите n oneChar)

ДЕЛАТЬ В КЛАССЕ Как бы вы уничтожили неприятную рекурсию из приведенного выше?

Теперь мы можем использовать наш комбинатор выбора

> захват2или4 = захват 2 `выбратьP` захват 4

и сейчас, мы вернем оба результата если возможно

ghci> doParse grab2or4 "mickeymouse"

[("mi","ckeymouse"),("mick","eymouse")]

и только один результат, если это возможно

ghci> doParse grab2or4 "микрофон"

[("mi","c")]ghci> doParse grab2or4 "m"

[]

Даже имея в своем распоряжении рудиментарные синтаксические анализаторы, мы можем начать делать некоторые довольно интересные вещи. Например, вот небольшой калькулятор. Сначала разбираем операцию

Например, вот небольшой калькулятор. Сначала разбираем операцию

> intOp = плюс `chooseP` минус `chooseP` умножить на `chooseP` разделить

> где плюс = char '+' >> возврат (+)

> минус = char '-' >> возврат (-)

> раз = char '*' >> вернуть (*)

> разделить = char '/' >> вернуть div

DO IN CLASS Можете ли вы угадать тип вышеприведенного синтаксического анализатора?

Далее мы можем разобрать выражение

> calc = do x <- digitInt

> op <- intOp

> y <- digitInt

> return $ x `op` y

stringP str = последовательность (map char str)

строкаP = последовательность. карта символ

, который при запуске будет анализировать и вычислять

ghci> doParse вычислить "8/2"

[(4,"")]ghci> doParse calc "8+2cat"

[(10,"cat")]ghci> doParse calc "8/2cat"

[(4,"cat")]ghci> doParse calc "8- 2cat"

[(6,"cat")]ghci> doParse calc "8*2cat"

[(16,"cat")]

Рекурсивный анализ

Чтобы начать парсить интересные вещи, нам нужно добавить рекурсию в наши комбинаторы. Например, очень хорошо анализировать отдельные символы (как в

Например, очень хорошо анализировать отдельные символы (как в char выше), но было бы намного больше, если бы мы могли получить конкретные 9 символов.0013 Строка токенов.

Попробуем написать!

> строка :: строка -> строка анализатора

string "" = return ""

string (c:cs) = do char c

string cs

return $ c:cs

Фу-у-у! Это явная рекурсия?! Давайте попробуем еще раз (можете найти закономерность)

> строка = mapM char

Гораздо лучше!

ghci> doParse (строка "микрофон") "mickeyMouse"

[("микрофон","keyMouse")]ghci> doParse (строка "микрофон") "дональд дак"

[]

Хорошо, я думаю, тогда это было не совсем рекурсивно! Давай еще раз попробуем. Давайте напишем комбинатор, который принимает синтаксический анализатор p , который возвращает и , и возвращает синтаксический анализатор, который возвращает много значений и . То есть он продолжает захватывать как можно больше значений

То есть он продолжает захватывать как можно больше значений a и возвращает их как [a] .

> manyP :: Parser a -> Parser [a]

> manyP p = many1 `chooseP` many0

> где many0 = return []

> many1 = do x <- p

> xs <- manyP p

> return (x:xs)

Но будьте осторожны! Вышеприведенное может дать много результатов

ghci> doParse (manyP digitInt) "123a"

[([], "123a"), ([1], "23a"), ([1, 2], "3a"), ([1, 2, 3], "а")]

, который просто представляет собой все возможные способы извлечения последовательностей целых чисел из входной строки.

Детерминированный максимальный анализ

Часто нам нужен один результат, а не набор результатов. Например, более интуитивное поведение много будет возвращать максимальную последовательность элементов, а не все префиксы.

Для этого нам понадобится детерминированный комбинатор выбора

> (<|>) :: Парсер a -> Парсер a -> Парсер a

> p1 <|> p2 = P $ \cs -> case doParse (p1 `chooseP` p2) cs of

> [] -> []

> х:_ -> [х]

>

Приведенный выше синтаксический анализатор запускает выбор, но возвращает только первый результат. Теперь мы можем вернуться к

Теперь мы можем вернуться к комбинатор manyP и убедитесь, что он возвращает одну максимальную последовательность

> mmanyP :: Parser a -> Parser [a]

> mmanyP p = mmany1 <|> mmany0

> где mmany0 = return []

> mmany1 = do x <- p

> xs <- mmanyP p

> return (х:хс)

ДЕЛАТЬ В КЛАССЕ Минуточку! В чем именно разница между вышеперечисленным и оригинальным manyP ? Как вы это объясните:

ghci> doParse (manyP digitInt) "123a"

[([1,2,3],"a"),([1,2],"3a"),([1],"23a"),( [],"123a")]ghci> doParse (mmanyP digitInt) "123a"

[([1,2,3],"a")]

Давайте воспользуемся этим, чтобы написать синтаксический анализатор, который будет возвращать целое число (а не только одну цифру).

oneInt :: Parser Integer

oneInt = do xs <- mmanyP digitChar

return $ ((read xs) :: Integer)

Помимо , можете ли вы найти шаблон выше? Взяли парсер mmanyP digitChar и просто преобразовал его вывод, используя функцию чтения . Это повторяющаяся тема, и тип того, что мы сделали, дает нам подсказку

Это повторяющаяся тема, и тип того, что мы сделали, дает нам подсказку

(a -> b) -> Парсер a -> Парсер b

Ага! очень похоже на карту . Действительно, существует обобщенная версия map , которую мы видели ранее ( lift1 ), и мы ограничиваем шаблон, объявляя Parser экземпляром Functor класса типов 9.0003

> экземпляр Functor Parser, где

> fmap f p = do x <- p

> return (f x)

после чего мы можем переписать

> oneInt :: Parser Int

> oneInt = прочитать `fmap` mmanyP digitChar

Давай попробуем

ghci> doParse oneInt "123a"

[(123, "a")]

Давайте воспользуемся вышеизложенным для создания небольшого калькулятора, который анализирует и вычисляет арифметические выражения. По сути, выражение представляет собой либо двоичный операнд, применяемый к двум подвыражениям, либо целое число. Мы можем сформулировать это как

> calc0 :: Parser Int

> calc0 = binExp <|> oneInt

> где binExp = do x <- oneInt

> o <- intOp

> y <- calc0

> return $ x `o` y

Это работает очень хорошо!

ghci> doParse calc0 "1+2+33"

[(36,"")]ghci> doParse calc0 "11+22-33"

[(0,"")]

, но с минусом

все становится немного странно.

ghci> doParse calc0 "11+22-33+45"

[(-45,"")]

А? Что ж, если вы снова посмотрите на код, вы поймете, что приведенное выше было проанализировано как

.11 + ( 22 - (33 + 45))

, потому что в каждом binExp мы требуем, чтобы левый операнд был целым числом. Другими словами, мы предполагаем, что каждый оператор является правой ассоциативностью , отсюда и полученный выше результат.

Интересно, можем ли мы попытаться это исправить, просто перевернув заказ

> calc1 :: Parser Int

> calc1 = binExp <|> oneInt

> где binExp = do x <- calc1

> o <- intOp

> y <- oneInt

> return $ x `o` y

ДЕЛАТЬ В КЛАССЕ Но здесь есть ошибка… Вы можете это понять? (Подсказка: что вернет следующее?)

ghci> doParse calc1 "2+2"

Хуже того, у нас нет приоритета, и поэтому

ghci> doParse calc0 "10*2+100"

[(1020,"")]

, так как строка анализируется как

10*(2+100)

$> calc2 = oneInt >>= захватить $> где захватить x = кг x <|> вернуть x $> кг x = сделать o <- intOp $> y <- oneInt $> захватить $ x o y

Приоритет

Мы можем добавить и ассоциативность, и приоритет обычным способом, расслоив парсер на разные уровни. Здесь давайте разделим наши операции на приоритет сложения и умножения.

Здесь давайте разделим наши операции на приоритет сложения и умножения.

> addOp = плюс `chooseP` минус

> где плюс = char '+' >> return (+)

> минус = char '-' >> возврат (-)

>

> mulOp = умножить `chooseP` разделить

> где раз = char '*' >> вернуть (*)

> разделить = char '/' >> возврат div

Теперь мы можем разделить наш язык на (взаимно рекурсивные) подъязыки, где каждое выражение верхнего уровня анализируется как сумма произведений

> pP `цепочка` opP

> = recP <|> pP

> где recP = do x <- pP

> o <- opP

> y <- (pP `цепочка` opP)

> return $ x `o` y

> sumE = addE <|> prodE

> где addE = do x <- prodE

> o <- addOp

> y <- sumE

> return $ x `o` y

>

> prodE = mulE <|> factorE

> где mulE = do x <- factorE

> o <- mulOp

> y <- prodE

> return $ x `o` y

>

> factorE = parenE <|> oneInt

> где parenE = do char '('

> n <- sumE

> char ')'

> вернуть номер

Мы можем запустить это

ghci> doParse sumE "10*2+100"

[(120,"")]ghci> doParse sumE "10*(2+100)"

[(1020,"")]

Вы понимаете, почему первый синтаксический анализ вернул 120 ? Что произойдет, если мы поменяем местами порядок prodE и sumE в теле addE (или factorE и prodE в теле prodE )? Почему?

Шаблон синтаксического анализа: Цепочка

Нет особого смысла злорадствовать по поводу комбинаторов, если мы собираемся писать код, подобный приведенному выше — корпуса sumE и prodE практически идентичны!

Давайте посмотрим на них поближе. По сути

По сути sumE имеет форму

prodE + < prodE + < prodE + ... < prodE >>>

, то есть мы продолжаем связывать значений prodE и добавлять их столько, сколько сможем. Точно так же prodE имеет вид

фактор E * < фактор E * < фактор E * ... < фактор E >>>

, где мы продолжаем связывать значений factorE и умножать их столько, сколько сможем. В этом есть что-то неприятное: операторы сложения правоассоциативны

ghci> doParse sumE "10-1-1"

[(10,"")]

Ух! Надеюсь, вы понимаете, почему: это потому, что приведенное выше было проанализировано как 10 - (1 - 1) (правоассоциативное), а не (10 - 1) - 1 (левоассоциативное). У вас может возникнуть соблазн исправить это, просто поменяв местами prodE и sumE

sumE = addE <|> prodE

где addE = do x <- sumE

o <- addOp

y <- prodE

return $ x `o` y

, но это было бы катастрофой. Вы видите, почему? Парсер для

Вы видите, почему? Парсер для sumE напрямую (рекурсивно) вызывает себя без каких-либо входных данных! Таким образом, он уходит в глубокий конец и никогда не возвращается. Вместо этого мы хотим убедиться, что мы продолжаем потреблять значений prodE и суммировать их (скорее, как складывать), и поэтому мы можем сделать

> sumE1 = prodE1 >>= addE1

> где addE1 x = захватить x <|> return x

> захватить x = сделать о <- addOp

> y <- prodE1

> addE1 $ x `o` y

>

> prodE1 = factorE1 >>= mulE1

> где mulE1 x = захватить x <|> return x

> захватить x = do o <- mulOp

> y <- factorE1

> mulE1 $ x `o` y

>

> factorE1 = parenE <|> oneInt

> где parenE = do char '('

> n <- sumE1

> char ')'

> вернуть номер

Легко проверить, что приведенное выше действительно ассоциативно слева.

ghci> doParse sumE1 "10-1-1"

[(8,"")]

, а также очень легко определить и скрыть шаблон вычисления цепочки: единственными отличиями являются парсер base ( prodE1 vs factorE1 ) и бинарная операция ( addOp vs mulOp ). Мы просто делаем эти параметры для нашего chain-left комбинатор

Мы просто делаем эти параметры для нашего chain-left комбинатор

> p `chainl` pop = p >>= rest

> где rest x = схватить x <|> return x

> схватить x = do o <- pop

> y <- p

> rest $ x `o` г

Точно так же нам часто нужно анализировать выражения в квадратных скобках, поэтому мы можем написать комбинатор

> parenP l p r = do char l

> x <- p

> char r

> return x

после чего мы можем переписать грамматику в три строки

> sumE2 = prodE2 `chainl` addOp

> prodE2 = factorE2 `chainl` mulOp

> factorE2 = parenP '('sumE2 ')' <|> oneInt

ghci> doParse sumE2 "10-1-1"

[(8,"")]ghci> doParse sumE2 "10*2+1"

[(21,"")]ghci> doParse sumE2 "10 +2*1"

[(12,"")]

На этом мы завершаем наше (в классе) изучение монадического синтаксического анализа. Это всего лишь верхушка айсберга. Хотя синтаксический анализ — очень старая проблема, и ее изучали на заре вычислительной техники, мы увидели, как монады привносят свежий взгляд, который недавно был перенесен из Haskell во многие другие языки. Недавно было опубликовано несколько захватывающих статей на эту тему, которые вы можете изучить самостоятельно. Наконец, Haskell поставляется с несколькими библиотеками комбинаторов синтаксических анализаторов, включая Parsec, с которым вы поэкспериментируете в HW3.

Недавно было опубликовано несколько захватывающих статей на эту тему, которые вы можете изучить самостоятельно. Наконец, Haskell поставляется с несколькими библиотеками комбинаторов синтаксических анализаторов, включая Parsec, с которым вы поэкспериментируете в HW3.

Введение в регулярные выражения Tableau (REGEX)

Введение

Есть Вы когда-нибудь задумывались, что представляют собой все эти функции Tableau, начинающиеся с REGEXP? о? Всегда хотел сделать что-то, что мог бы можно обрабатывать с помощью функции SPLIT(), но это не совсем так, как вы ожидал? Или, возможно, поверьте, что эти функции REGEXP немного пугают. (иногда они выглядят как египетские иероглифы!!)?

Да,

Я был там во всех этих случаях. Итак, я с вами. Как немного

предыстория, я не программист, никогда не писал ни строчки кода (кроме

Расчет таблицы или два), я знаю и понимаю синтаксис SQL и

систем уровня предприятия достаточно, чтобы быть опасными.

Да, Я в основном непрофессионал с базовым пониманием структуры данных, данных анализ и сопутствующие инструменты для очистки и изменения формы данных… так что эта серия предназначена для все мы, кто хотел бы понять немного больше, что это за функции о. И когда/как их использовать!

Я думаю, одна из причин, по которой я склонился к изучению выражений REGEX, заключается в том, что они следовать шаблонам. Собственно, именно этим они и занимаются — помогают тянуть извлекать (извлекать) или сопоставлять шаблоны в строках данных. В начале моего квест, чтобы изучить REGEX, все это выглядело как куча тарабарщины. Полностью непонятно. Теперь я могу читать и строить эти иероглифы с большим уверенность и понимание, и я собираюсь использовать эту серию блогов, чтобы помочь вам понять и написать их, а также.

Воля

эта серия решает все ваши вопросы по обработке данных REGEX? Возможно нет.

Но это будет хорошей отправной точкой на вашем пути, чтобы начать использовать их в Tableau. Мы предоставим некоторые связанные ссылки и онлайн-инструменты по пути, а также некоторые

соответствующие ссылки на разделы справки Tableau. Самое главное, что многие из

примеры — от основного до

от среднего до более продвинутого — будут использовать фактические решения, найденные в

Сообщество Табло

Форумы.

Мы предоставим некоторые связанные ссылки и онлайн-инструменты по пути, а также некоторые

соответствующие ссылки на разделы справки Tableau. Самое главное, что многие из

примеры — от основного до

от среднего до более продвинутого — будут использовать фактические решения, найденные в

Сообщество Табло

Форумы.

История Регулярные выражения

Регулярные Выражения , часто сокращенно обозначаемые как REGEX или REGEXP , существуют с тех пор, как 1980-е годы. Они были продуктом регулярного языка, разработанного в 1950-х годах. который использовался в основном в системах на основе UNIX для обработки текста. Синтаксис немного отличается от системы к системе, поэтому я поделюсь здесь сосредоточился на Tableau.

основной вариант использования регулярных выражений — извлечение определенных данных

элемент из строки данных. Регулярные выражения обычно используются веб-сайтом

и разработчики приложений, чтобы проверить, соответствует ли пользовательский ввод

требуемая структура элемента данных. Пример, с которым мы сталкиваемся почти

ежедневно — это адрес электронной почты. Адреса электронной почты, например, требуют, чтобы пользователь

имя, за которым следует знак @, за которым следует домен (имя-пользователя@имя-домена.com).

Мы могли бы использовать REGEXP_MATCH для проверки правильности ввода данных пользователем.

элемент/поле были введены правильно и отображали сообщение об ошибке, если это не так.

правильно соответствовать требуемому формату.

Пример, с которым мы сталкиваемся почти

ежедневно — это адрес электронной почты. Адреса электронной почты, например, требуют, чтобы пользователь

имя, за которым следует знак @, за которым следует домен (имя-пользователя@имя-домена.com).

Мы могли бы использовать REGEXP_MATCH для проверки правильности ввода данных пользователем.

элемент/поле были введены правильно и отображали сообщение об ошибке, если это не так.

правильно соответствовать требуемому формату.

Как сделать Обычный Выражения работают?

Хорошо,

Итак, мы знаем, что такое регулярные выражения, но как они работают? Ну как любой

«язык» или формат, существуют компоненты, помогающие построить синтаксис или

составление выражения, очень похожее на построение вычисления в Tableau с использованием

Синтаксис типа ЕСЛИ-ЭТО-ТО-ТО. При правильном построении базовый алгоритм

в Tableau переведет шаблон и предоставит совпадение или извлечет данные.

Всякий раз, когда нет совпадения с входным шаблоном, Tableau возвращает Нуль .

Тот означает, что нам нужно понять, что строит/поддерживает синтаксис. Другими словами, что означают эти иероглифы?

Коротко о предупреждение: этот раздел может показаться немного запутанным, так как большая часть терминологии и определения будут вам чужды. Но это нормально, пожалуйста, не слишком много беспокойтесь об этом. Мне просто нужно покрыть некоторые из этих основных зданий блоков, прежде чем показать вам, как регулярные выражения работают на практике.

А регулярное выражение может содержать 3 отдельные части. Примечание. Не для всех выражений требуются все три, это зависит от требование.

1) Метасимволы регулярных выражений Классы – А Метасимвол — это символ, который имеет особое значение для компьютерной программы. например, интерпретатор оболочки или, в нашем случае, регулярное выражение (REGEX) двигатель.

2) Операторы/квантификаторы регулярных выражений – используются для

уточнить узор. Например, как

много раз должно повторяться совпадение с образцом.

Например, как

много раз должно повторяться совпадение с образцом.

3) Набор выражений (классы символов) — используются для помогите определить конкретные символы, которые мы хотим сопоставить.

Регулярное выражение Метасимволы Классы

В обычном выражения, используя обратную косую черту с определенными буквами заставляет определенных персонажей что-то делать. Заглавная буква будет другое значение и действие, чем у нижнего регистра:

Символ | Описание |

\б | Матч

если текущая позиция является границей слова. Границы возникают на

переходы между словесными (\w) и несловесными (\W) символами с комбинированием

отметки игнорируются. |

\В | Матч если текущая позиция не является границей слова. |

\д | Матч любой символ с общей категорией Unicode Nd (число, десятичный цифра) |

\Д | Матч любой символ, не являющийся десятичной цифрой. |

\ш | Матч символ слова. |

\Вт | 9$ | \ .|

\ | Цитаты следующий персонаж. Символы, которые должны быть заключены в кавычки, чтобы рассматриваться как литералы: [ ] \ Символы, которые могут потребоваться в кавычках, в зависимости от контекст - & |

Обычный Операторы выражения/квантификаторы

Функция

операторов/квантификаторов отличается от их

буквальные значения. За

Например, знак + обычно означал бы добавление к нам, но в регулярных выражениях он

может означать сделать что-нибудь —в

В этом случае выполните одно или несколько повторений матча. Ниже приведен неполный список:

За

Например, знак + обычно означал бы добавление к нам, но в регулярных выражениях он

может означать сделать что-нибудь —в

В этом случае выполните одно или несколько повторений матча. Ниже приведен неполный список:

Оператор | Описание | |

| | Чередование. A|B соответствует либо A, либо B. | |

* | Совпадение 0 или более раз. Совпадение как можно больше раз. | |

+ | Совпадение 1 или более раз. Совпадение как можно больше раз. | |

? | Совпадение ноль или один раз. | |

{н} | Совпадение ровно n раз | |

{н,} | Совпадение не менее n раз. Совпадение как можно больше раз. | |

{н,м} | Совпадение от n до m раз. Совпадение как можно больше раз, но не более м. | |

*? | Совпадение 0 или более раз. Совпадение как можно меньше раз. | |

+? | Совпадение 1 или более раз. Совпадение как можно меньше раз. | |

?? | Совпадение ноль или один раз. | |

{н}? | Совпадение ровно n раз. | |

{н,}? | Совпадение не менее n раз, но не более, чем требуется для общего результата соответствие шаблону. | |

{н,м}? | Совпадение от n до m раз. Совпадение как можно меньше раз, но не менее н. 9азбука] | Отрицание - соответствует любому символу, кроме a, b или c. |

[А-М] | Диапазон - соответствует любому символу от A до M. |

Как Например, на приведенном ниже рисунке показан синтаксис/схема всех трех частей. который можно использовать для проверки или сопоставления номера социального страхования:

ОК,

это немного, чтобы принять и понять, на данный момент. Но прежде чем перейти к

следующий раздел, пожалуйста, найдите минутку, чтобы действительно посмотреть на эти символы и на то, что

они могли бы сделать с набором данных. Помните, что регулярные выражения

вполне буквальным/явным, пока мы не добавим определенные операторы, метасимволы или

набор выражений.

Но прежде чем перейти к

следующий раздел, пожалуйста, найдите минутку, чтобы действительно посмотреть на эти символы и на то, что

они могли бы сделать с набором данных. Помните, что регулярные выражения

вполне буквальным/явным, пока мы не добавим определенные операторы, метасимволы или

набор выражений.

Примечание. Если вы хотел бы увидеть все три таблицы, они основаны на International Компоненты для Unicode (ICU) Обычный Библиотеки выражений.

Обычный Выражения в таблице

Сейчас что вы понимаете историю регулярных выражений и их основные строительные блоки, давайте поговорим о том, как их создать в Tableau. Таблица имеет четыре различные функции REGEXP, которые либо сопоставляются, либо извлекаются, либо заменяются строки внутри большей строки данных. Если это не имеет смысла, наберитесь терпения так как я скоро поделюсь некоторыми примерами.

REGEXP_EXTRACT

(нитка, узор) – Ищет определенный шаблон в строке или подстроке и извлекает этот элемент данных.

REGEXP_EXTRACT_NTH (строка, шаблон, индекс) — ищет определенный шаблон в строке или подстроке, начиная с n-й позиции в строке, и извлекает этот элемент данных.

REGEXP_MATCH (нитка, узор) – Ищет определенный шаблон в строке или подстроке и возвращает TRUE если есть точное совпадение с .

REGEXP_REPLACE (строка, шаблон, замена) — ищет определенный шаблон внутри строки или подстроки и заменяет этот элемент данных с другим элементом данных.

Таблица регулярные выражения также могут быть «вложенными», то есть вы можете использовать Функция REGEXP_REPLACE() внутри другой функции REGEXP_REPLACE(), очень похоже на вы можете сделать это с помощью обычной функции REPLACE(). Вложенность позволяет сделать несколько проходов по данным, чтобы вам не нужно было зубрить все ваши логика в одно выражение. Но не будем забегать вперед… или слишком перегруженный!

Примеры таблиц

Давайте

теперь посмотрите на некоторые примеры регулярных выражений. Мы собираемся начать с

несколько относительно простых примеров, чтобы облегчить его.

Мы собираемся начать с

несколько относительно простых примеров, чтобы облегчить его.

Мы начнем с нескольких простых примеров, которые затем будут становиться все более сложно, когда мы движемся вперед. Я использую термин «простой», но для новичков для регулярных выражений они могут показаться совсем не простыми. Пожалуйста, не получайте ошеломлены, когда вы работаете с ними — они могут быть сложными для понимания вокруг, но со временем, практикой и временем вы станете постоянным мастер выражений!

Запомнить примеры таблиц метасимволов, операторов и наборов? Мы будем работать с этими различными символами из этих таблиц для поддержки наших усилий по сопоставлению и извлечению шаблонов. К сохраняйте базовые вещи, как сопоставление с образцом номера социального страхования, мы будем использовать упрощенный метод, который опирается на все три таблицы для нашего первого пример.

Для В этом примере давайте воспользуемся следующим простым набором данных о курсах студентов:

Текст |

Смит, Пол изучает английский язык, студенческий билет: ABC123 . |

Джонс, Мэри изучает математику, студенческий билет: DEF345 . |

Ли, Салли учится на факультете экономики, номер студента: GHI678 . |

Браун, Сэм учится на музыкальном факультете, ID студента: ABC345 |

Черный, Келли изучает бизнес, студенческий билет: ABC123 . |

Просто скопируйте эти строки в Excel или Google Sheets, затем используйте Tableau Desktop или Tableau Prep для подключения к электронной таблице.

Мы установит всего 2 цели для сопоставления по этим данным:

1) Получить фамилию человека.

2) Узнайте имя человека.

Мы будет использовать REGEXP_EXTRACT для извлечения каждого из этих различных компонентов, используя следующий синтаксис:

REGEXP_EXTRACT ([текст], '( )')

После

первую запятую мы ставим открывающую скобку и закрывающую скобку

внутри кавычек. Почему? Ну, кавычки обязательный синтаксис, но скобки

это совсем другое. Мне потребовалось некоторое время, чтобы понять, что в

почти в каждом случае, набор закрывающих скобок необходим для создания

то, что известно как «группа захвата». Другими словами, какие конкретные ценности мы

хотите выйти из шаблона? Tableau очень, очень любит группы захвата.

Итак, я всегда начинаю с этого начального синтаксиса, а затем строю свой шаблон — те

иероглифы — внутри и/или вокруг

этот набор скобок.

Почему? Ну, кавычки обязательный синтаксис, но скобки

это совсем другое. Мне потребовалось некоторое время, чтобы понять, что в

почти в каждом случае, набор закрывающих скобок необходим для создания

то, что известно как «группа захвата». Другими словами, какие конкретные ценности мы

хотите выйти из шаблона? Tableau очень, очень любит группы захвата.

Итак, я всегда начинаю с этого начального синтаксиса, а затем строю свой шаблон — те

иероглифы — внутри и/или вокруг

этот набор скобок.

Последний Имя

Давайте поработайте над первой постановкой задачи получения фамилии человека. В нашем данные, фамилия всегда является первым «словом» в тексте, поэтому простейшее Синтаксис для захвата группы и ее извлечения будет следующим:

REGEXP_EXTRACT ([Text], '(\w+)')

,

9 что здесь происходит на самом деле? Мы знаем что скобки — это наша «группа захвата», данные, которые мы пытаемся извлечь или сопоставить. Эта начальная обратная косая черта

считается нашей вводной или отправной точкой того, что мы пытаемся захватить. Обратная косая черта сама по себе означает начало здесь

или, скорее, начните с этого следующего символа. Маленькая буква «w» = совпадение со словом

символ. Это также будет соответствовать буквенно-цифровым значениям . Комбинированное использование обратной косой черты в REGEXP

с маленькой буквой «w» заставляет эту маленькую букву w больше не быть буквальной буквой «w», а

стать действием по совершению чего-либо. Когда следует

знак + вызывает совпадение всех последующих символов, но только один раз. Смысл,

он остановит процесс сопоставления, когда встретит следующий символ, который не

словесный (буквенно-цифровой) символ. В Tableau этот синтаксис вернет

следующие:

Эта начальная обратная косая черта

считается нашей вводной или отправной точкой того, что мы пытаемся захватить. Обратная косая черта сама по себе означает начало здесь

или, скорее, начните с этого следующего символа. Маленькая буква «w» = совпадение со словом

символ. Это также будет соответствовать буквенно-цифровым значениям . Комбинированное использование обратной косой черты в REGEXP

с маленькой буквой «w» заставляет эту маленькую букву w больше не быть буквальной буквой «w», а

стать действием по совершению чего-либо. Когда следует

знак + вызывает совпадение всех последующих символов, но только один раз. Смысл,

он остановит процесс сопоставления, когда встретит следующий символ, который не

словесный (буквенно-цифровой) символ. В Tableau этот синтаксис вернет

следующие:

Это

именно то, что мы хотим от этого набора данных. Обратите внимание, что он останавливается на запятой

поскольку в этом случае выражение REGEXP ищет целое «слово», а не

поиск любых дополнительных символов или пробелов. Если бы вы убрали +

знак, используя только \w, вы получите следующее совпадение, которое является правильным

потому что это совпадение «символа слова» в единственном числе:

Если бы вы убрали +

знак, используя только \w, вы получите следующее совпадение, которое является правильным

потому что это совпадение «символа слова» в единственном числе:

См., это было легко!

Первый Имя

Что о следующей постановке проблемы/цели? Чтобы получить их имя? Он расположен после пробела и запятой. Это будут наши «якоря», с которых мы будем работать. We’ll use the following syntax:

REGEXP_EXTRACT ([Text], ',\s+(\w+)')

For В этой ситуации мы выходим за пределы нашей «группы захвата». Почему? Потому что мы нужно указать регулярному выражению начинаться с определенной точки текста — в нашем случае мы нужно смотреть вперед от запятой и пробела. Давайте разберем этот синтаксис на его составные части.

, – Это просто буквальная строка.

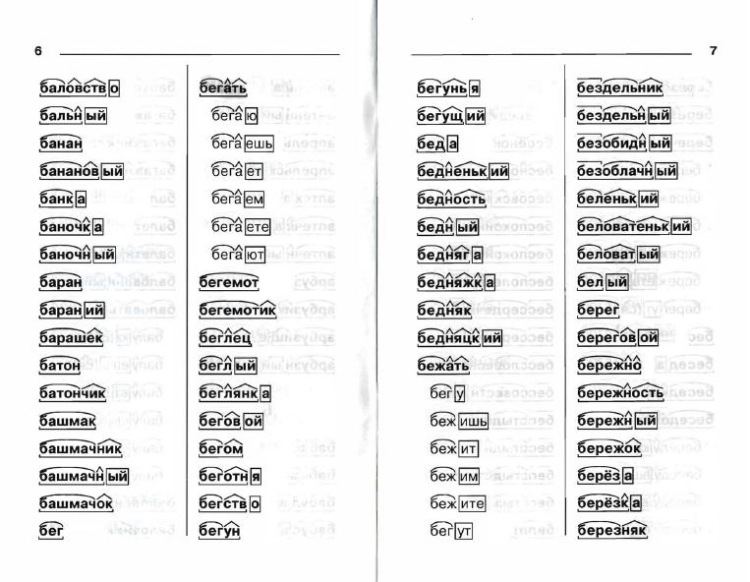

Словообразование

Словообразование

Предпочитаю один.

Предпочитаю один. Лучше ноль.

Лучше ноль.