Как разобрать по составу слова «прилавок» и «лавочка»?

Какой морфемный разбор слов «прилавок» и «лавочка»?

2

Дублон

Ответы (7):

Share

1

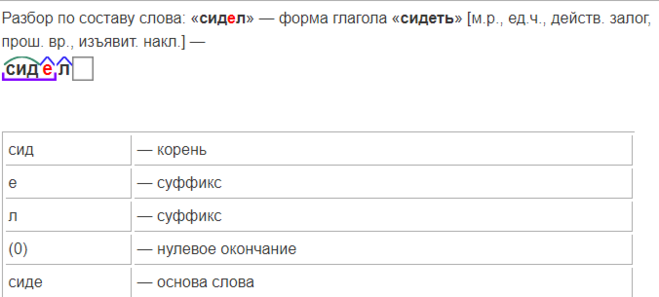

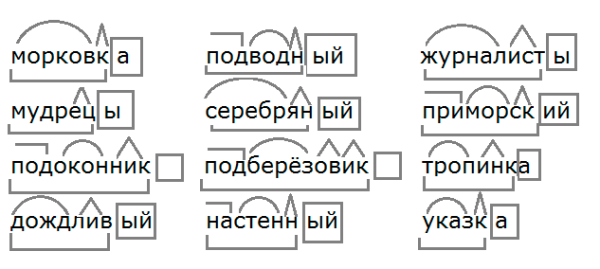

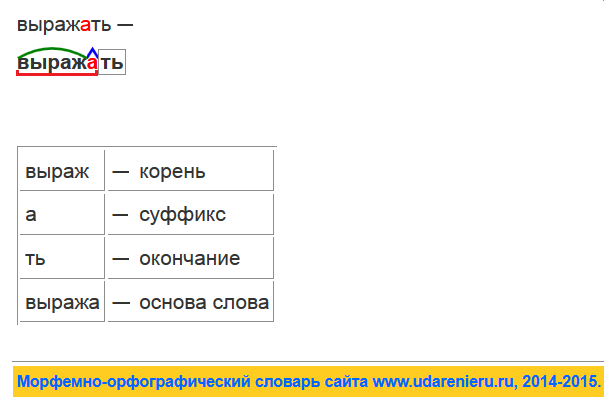

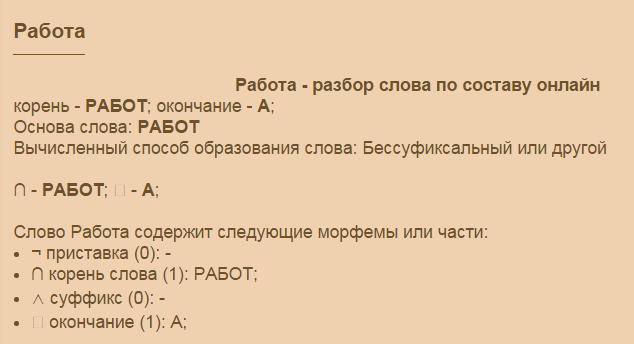

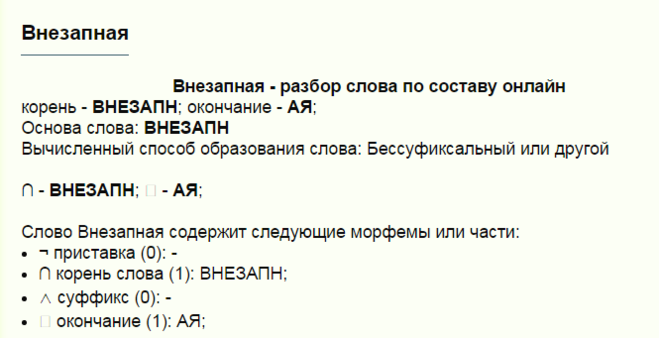

Слово «прилавок» — содержит следующие морфемы (или по другому их можно назвать части слова):

приставка — при, корень — лавок

Основа слова — прилавок.

Приставочный или префиксальный способ образования слова.

Значение слова «Прилавок»

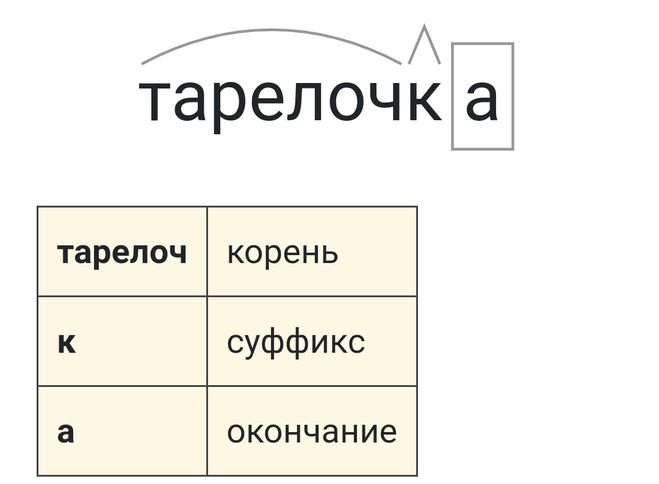

Слово «лавочка» — содержит следующие морфемы (или по другому их можно назвать части слова):

корень — лавоч, суффикс — к, окончание — а.

Основа слова — лавочк.

Суффиксальный способ образования слова.

Значение слова «Лавочка»

Share

2

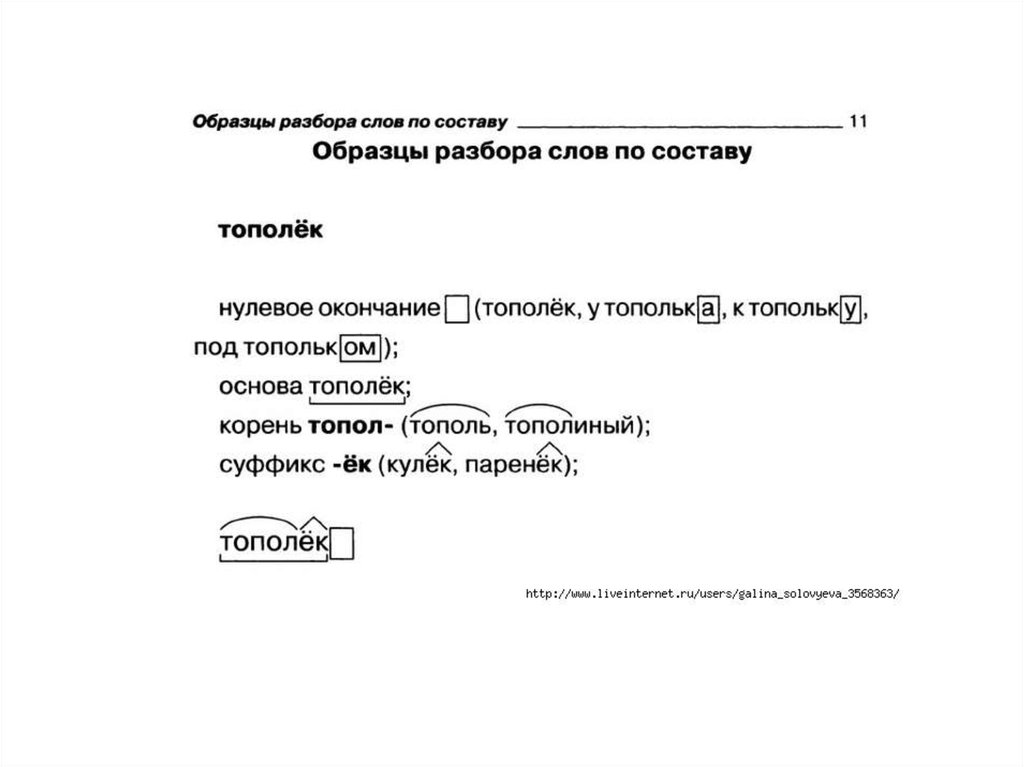

Морфемный разбор существительного женского рода «лавочка»:

- окончание «-а», слово изменяется по падежам и числам, поэтому окончание легко выделяется,

- основа «лавочк-«, часть слова без окончания,

- суффикс «-к-«, от «лавка,

- корень «лавоч-«, чередование нуль звука//о (лавк-//лавОч-) и чередование к//ч (лавК-//лавоЧ-).

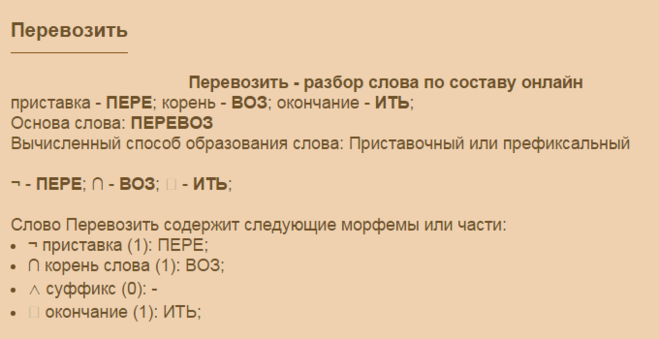

Морфемный разбор существительного «прилавок»:

- окончание нулевое, проявляется в других формах (например, Р.п. прилавкА),

- основа «прилавок-«, часть слова без окончания,

- приставка «при-«, есть слово без этой приставки,

- корень «-лавок-«, есть чередование нуль звука//о (прилавОк//прилавка).

Share

1

Слово Прилавок отвечает на вопрос Что? и оказывается существительным мужского рода, которое обладает нулевым окончанием: Прилавок-Прилавка-Пр

Однокоренными словами оказываются: Прилавок-Лавочка-Лав

Следовательно корнем слова будет морфема -лавок.

Далее выделим в составе слова приставку при-.

Получаем: при-лавок_ (приставка-корень-ну

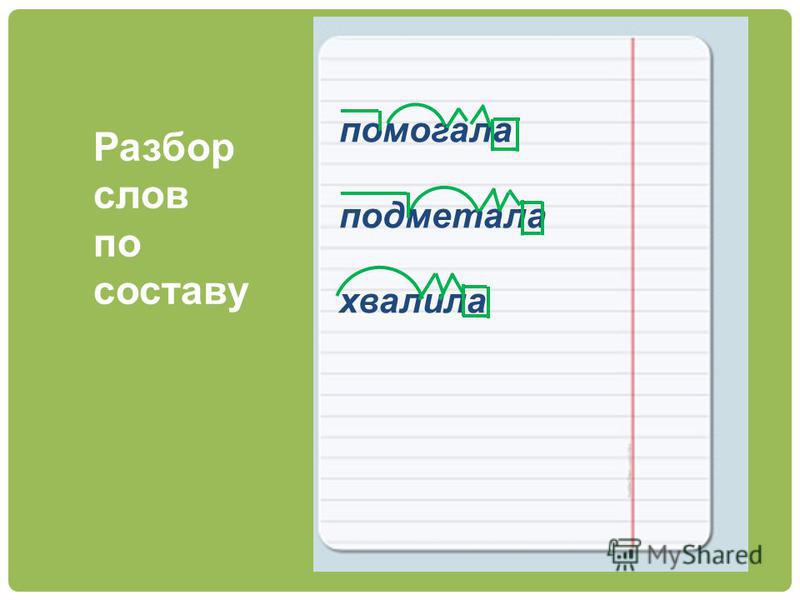

Слово Лавочка отвечает на вопрос Что? и оказывается существительным женского рода, которое обладает окончанием: -а: Лавочка-Лавочки-Лаво

Выделим здесь тот же корень лавоч-.

Далее выделим в составе слова суффикс существительного -к-.

Получаем: лавоч-к-а (корень-суффикс-окон

1

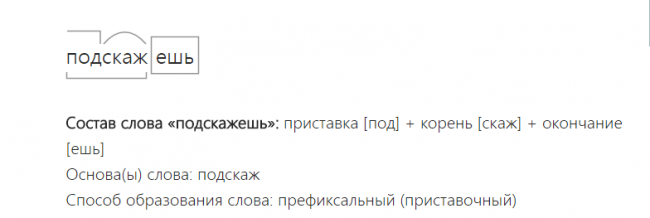

Слово «прилавок» это имя существительное отвечает на вопрос «Что?», неодушевлённое, мужского рода единственного числа, винительный падеж.

Разбор по составу слова «прилавок» имеет вид:

при — приставка;

лавок — это корень;

окончание нулевое.

Основа слова является — прилавок .

Способ образования слова: префиксальный (приставочный).

Слово «лавочка» это имя существительное отвечает на вопрос «Что?», неодушевлённое, женского рода единственного числа, именительный падеж.

Разбор по составу слова «лавочка» имеет вид:

лавоч — это корень;

к — суффикс;

а]окончание.

Основа слова является — лавочк .

Способ образования слова: суффиксальный.

Share

1

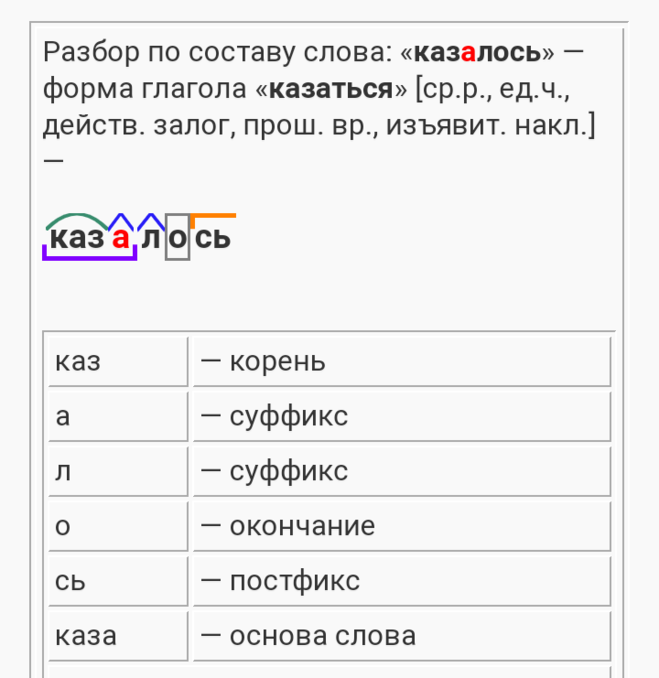

В данном вопросе нам требуется сделать морфемный разбор слов прилавок и лавочка.

Вот как это сделаем с каждым словом по очереди

Разбор по составу слова прилавок. Основа данного слова прилавок. Слово прилавок является существительным. Оно состоит из приставки при и корня лавок. В итоге получается схема приставка — корень, а именно при — лавок.

Способ образования слова приставочный.

Разбор по составу слова лавочка. Основа данного слова лавочк. Слово лавочка является существительным. Оно состоит из корня лавоч, суффикса К и окончания а. Видим схему корень — суффикс — окончание, а именно лавоч — к — а.

Share

В любом случае слова «прилавок» и лавочка» являются однокоренными словами и происходят от слова «лавка», где корень «лавк», а -о- беглое гласное.В первом слове лавок — корень, -при- приставки.

Лавочка — лавоч -корень,к- суффикс. а — окончание.

Share

Слово прилавок разбирается по составу таким образом:

при — это приставка

лавок — это корень

окончание нулевое, основа прилавок

Слово лавочка:

корень — лавоч

суффикс — к

окончание а

Основа слова это лавочк.

«Айнтрахт» – команда-трансформер с левым защитником в ключевой роли (Костич – топ). В контратаках в ЛЕ им не было равных

Содержание:

- 1 Победа над «Барсой» – главный спектакль «Айнтрахта». Это не совпадение – с такими соперниками им удобнее

- 2 «Франкфурт» не любит владеть мячом, но обожает открытые матчи. Схема помогает устраивать им перестрелки

- 3 Филип Костич – левый латераль и мозг команды

- 4 В позиционных атаках тоже помогает схема-трансформер.

Постепенно команда становится вариативнее

Постепенно команда становится вариативнее - 5 ***

Разбор Вадима Лукомского.

«Айнтрахт» обыграл «Рейнджерс» по пенальти в финале Лиги Европы (1:1 до серии). Финал получился драматичным и местами приятным для просмотра, но обошелся без тактического триллера. В этот раз интереснее разобрать не конкретную игру, а путь команды Оливера Гласнера к триумфу.

Начнем с очевидного вопроса: как 11-е место в Бундеслиге сочетается со вполне заслуженной победой в еврокубке?

Победа над «Барсой» – главный спектакль «Айнтрахта». Это не совпадение – с такими соперниками им удобнее

На самом деле ситуация даже радикальнее, чем кажется на первый взгляд. По ожидаемым очкам «Айнтрахт» даже не 11-й, а 14-й в Бундеслиге. То есть не получится сказать, что сильная команда из-за невезения провалила сезон в чемпионате, но круто собиралась на топовые матчи в Европе.

В Бундеслиге «Франкфурт» – действительно непримечательная и посредственная команда. Именно в рамках рисунка игры, который им предлагается в большинстве встреч Бундеслиги. Да, парадокс «Айнтрахта» строится именно на контрасте между удобным и неудобным рисунком игры. Конечно, такое понятие применимо почти к любой команде, но ни у кого оно не достигает таких крайностей.

Да, парадокс «Айнтрахта» строится именно на контрасте между удобным и неудобным рисунком игры. Конечно, такое понятие применимо почти к любой команде, но ни у кого оно не достигает таких крайностей.

В Лиге Европы «Айнтрахт» выбился в финал с самой трудной сеткой плей-офф с 2008-го. С этого сезона аналитическая компания 21st Club ведет свой клубный рейтинг. По средней трудности соперника «Франкфурту» нет равных:

Модель тут помогает поместить сетку плей-офф в контекст и сравнить с прошлыми сезонами, но мощь соперников можно ощутить и через простое перечисление – «Бетис» (5-е место в Ла Лиге), «Барселона» (2-е место в Ла Лиге) и «Вест Хэм» (7-е место в АПЛ). Все противники из двух сильнейших чемпионатов Европы – все проводят достойный сезон.

«Айнтрахт» уничтожил их на контратаках. Лишь с «Вест Хэмом» рисунок был иным – там немцы так и не показали свою мощь, продрались за счет деталей – в первом матче повезло с плохой реализаций «Вест Хэма»; а во втором – с ранним удалением.

С «Бетисом» и «Барселоной» команда Гласнера кайфовала, получив комфортные условия. В обоих случаях залогом успеха стали выездные матчи с 65%+ владения у соперника. В обоих случаях они создавали огромную долю моментов в быстрых атаках. В обоих случаях «Франкфурт» мог побеждать крупнее.

Завязанный на этой особенности контраст чуть менее прослеживается и во внутреннем чемпионате. В Бундеслиге «Айнтрахт» на 6-м месте в таблице гостевых матчей, но 16-й – по домашним. Проще говоря, чем смелее играет соперник, тем удобнее «Франкфурту». По количеству быстрых атак, которые завершаются ударом или касанием внутри чужой штрафной, команда Гласнера на 3-м месте в «Бундеслиге».

«В определенных условиях мы можем обыграть любого. В этом сезоне мы побеждали в Мюнхене и Барселоне. Наша система хорошо работает против трудных соперников», – рассказывал вингер Йенс Петтер Хауге.

А вот более подробный анализ от спортивного директора клуба Маркуса Креше: «Как правило, в Бундеслиге – особенно в домашних матчах – мы встречаемся с оппонентами, который обороняются глубоко, вынуждая нас искать решения на чужой трети поля. Пространства перекрыты, играть становится непросто, а в роли контратакующей команды выступает сам соперник.

Пространства перекрыты, играть становится непросто, а в роли контратакующей команды выступает сам соперник.

Все иначе, когда у нас есть открытое пространство. Если соперник играет в более атакующей манере, мы можем играть через переходные эпизоды – нам проще в таком футболе, чем при взламывании соперника на его трети».

«Франкфурт» не любит владеть мячом, но обожает открытые матчи. Схема помогает устраивать им перестрелки

Интересная особенность контратакующих побед «Франкфурта» в том, что команда играет вторым номером, но не ставит автобус. Наоборот, устраивает перестрелки, в которых оказывается острее. То есть сценарии с владением у соперника нужен им, чтобы получить пространство для контратак, а не чтобы вымучивать результат, стоя у своих ворот.

Если соперник забирает мяч (следовательно, пространство для отрывов есть), команда Гласнера не выжидает у своих ворот, а, наоборот, делает все, чтобы в матче было максимальное количество переходов мяча и ошибок. Соперник тоже получает шансы ловить «Франкфурт» на моментах дезорганизованности, но ставка делается на то, что «Франкфурт» лучше накажет в таких условиях.

Олицетворением этого замысла служит схема «Айнтрахта». Команда встречает позиционные атаки соперника в 5-4-1, но не садится слишком глубоко:

Скриншоты сделаны в InStatScout

В этой схеме «Айнтрахт» не выжидает, а проявляет агрессию каждый раз, когда мяч на флангах.

В такие моменты очень резко выдвигается крайний защитник, а оставшиеся перестраиваются на четверку:

Вот аналогичная трансформация, но на другом фланге по ходу этой же атаки. В этот раз завершится отбором и классической для «Франкфурта» контратакой:

Дополнительный бонус такого подхода: часто игроком, который начинает контратаку, становится латераль – Костич или Кнауфф. Во-первых, оба здорово тащят мяч на пространстве. Во-вторых, это означает, что тройки атакующих игроков (как минимум) создает им варианты. В случае, если бы мяч отбирал/перехватывал игрок без дриблинга терялся бы ритм. В случае, если бы отбирал кто-то из атакующих игроков, на одного футболиста меньше поддерживало бы атаку.

Схожая трансформация происходит и при высоком прессинге – тогда схема переходит в 4-2-4, где одним из игроков в последней линии становится крайний защитник (в этом примере Кнауфф):

Такой подход рождает моменты в обе стороны – если пройти первую линию давления, получится опасная атака соперника. Очень многое в игре «Франкфурта» завязано на четкости маневров при трансформации схемы и на выборе момента для начала активной фазы давления. В данном случае все закончилось высоким отбором и опаснейшим моментом в штрафной «Бетиса»:

Филип Костич – левый латераль и мозг команды

В составе «Айнтрахта» есть звезда, о которой стоит поговорить отдельно – Филип Костич. Он бросается в глаза еще до стартового свистка матчей – при взгляде на составы. Левый защитник под 10-м номером.

Кажется, эта нестандартная деталь на интуитивном уровне побуждает за ним следить – и серб не разочаровывает:

Вот список параметров, в которых Костич лидирует – переводы, разрезающие пасы, навесы, предударные действия, пасы в штрафную, точные навесы. Все так или иначе завязаны на игре в пас, но обратите внимание, насколько разные по типажу передачи ему подвластны. Здесь и работа плеймейкера, и прямая угроза разных типов. Особенно впечатляет лидерство по пасам в штрафную:

Все так или иначе завязаны на игре в пас, но обратите внимание, насколько разные по типажу передачи ему подвластны. Здесь и работа плеймейкера, и прямая угроза разных типов. Особенно впечатляет лидерство по пасам в штрафную:

Космический отрыв от второго места подчеркивает, насколько сильно игра команды заточена на Филипа. Также очевиден его любимый прием – в каждый из последних 4 сезонов Бундеслиги (включая нынешний) Костич входил в топ-2 по количеству точных подач с игры. Уровень его подач – топовый.

Еще одно качество, которое не так просто измерить цифрами, подмечал Гласнер: «Филип обладает выдающимся даром замечать и находить пасом свободного игрока в центре. Он делает это, даже если находится под серьезнейшим давлением. И не только замечает, но и достаточно одарен технически, чтобы исполнить нужный пас».

С точки зрения статистики передачи, которые возвращают мяч с фланга в центр на свободного партнера, не фиксируются отдельно, но с точки зрения развития атак они категорически важны.

Для «Айнтрахта» Костич – ключевой элемент любимого сценария (связывает контратаки и нестандартными решениями находит партнеров) и единственное светлое пятно при неудобном сценарии (дают ему мяч, он вешает – какие-то моменты возникают).

Еще одно важное качество – поставленный удар. 7 сезонов подряд Костич не опускается ниже планки в 4 гола (мощно для его позиции). В этом сезоне, кроме этих голов, было 8 ударов, которые создавали ситуацию под добивание.

В общем, для «Айнтрахта» – огромная удача, что такой топ до сих пор в команде (уже четвертый сезон). Ближе всего к уходу он был этим летом. В конце лета Костич очень хотел в «Лацио» – даже бойкотировал тренировки и отказывался играть в одном матче.

«Лацио» хотел завершить сделку, «Айнтрахт» на фоне желания игрока был готов к переговорам, но история сенсационно заглохла с формулировкой «не получили официального предложения». Сначала «Лацио» обвинил немецкий клуб во лжи, но позже выяснилось, что «Лацио» просто отправил официальное предложение не на ту почту – вместо окончания «eintrachtfrankfurt. de» использовали «eintrachtfranfurt.de».

de» использовали «eintrachtfranfurt.de».

Из-за опечатки Костич остался в «Айнтрахте». Из-за Костича «Айнтрахт» выиграл Лигу Европы.

В позиционных атаках тоже помогает схема-трансформер. Постепенно команда становится вариативнее

Важно отметить, что описанные механизмы – и топовый Костич – были построены при прошлом тренере Ади Хюттере. Нельзя недооценивать его вклад в успех. Гласнер вернулся к его схеме и футболу после неудачных экспериментов на старте кампании. Его заслуга – в мотивации и микроменеджменте в конкретных матчах.

Но один важный апгрейд «Франкфурт» получил буквально зимой. В команду ворвался арендованный у «Дортмунда» Ансгар Кнауфф. Теперь оба фланга несут более прямую угрозу. Кнауфф не так вариативен, как Костич, но у него очень мощные проходы с мячом. Это дает возможность трансформировать схему на любом из флангов.

Трансформация происходит через крайних центральных защитников, которые подключаются по флангу и по эпизоду становятся крайними защитниками:

Так выглядит тепловая карта левого ЦЗ Эвана Ндика – по действиям с мячом он больше похож на левого защитника:

Справа – на фланге Кнауффа – играет Альмами Туре. Трансформация в правого защитника его более явная:

Трансформация в правого защитника его более явная:

Этот прием не стоит переоценивать. Позиционная атака в команде точно не выдающаяся, но в ключевой отрезок вчерашнего матча в середине второго тайма «Айнтрахт» владел мячом за 60%, атаковал именно таким образом и все-таки организовал моменты.

***

Подытожим. «Айнтрахт» – это:

• категорическая зависимость от игры вторым номером – возможно, самая явная в Европе;

• но не автобус – им неинтересно выжидать ошибку, им интересно вскрывать пространство;

• возможно, самая зависимая от своего левого защитника команда мира – частично из-за мощи Костича, который давно перерос клуб;

• команда-трансформер – переходы с пятерки на четверку и обратно отлажены почти идеально со времен Хюттера. Это не просто интересная для изучения тактическая фишка, а правда важнейший инструмент команды во всех стадиях.

Разобрать по составу слова: гладиатор, раритетная, раколовка? Разобрать

образование

Разобрать по составу слова: гладиатор, раритетная, раколовка?

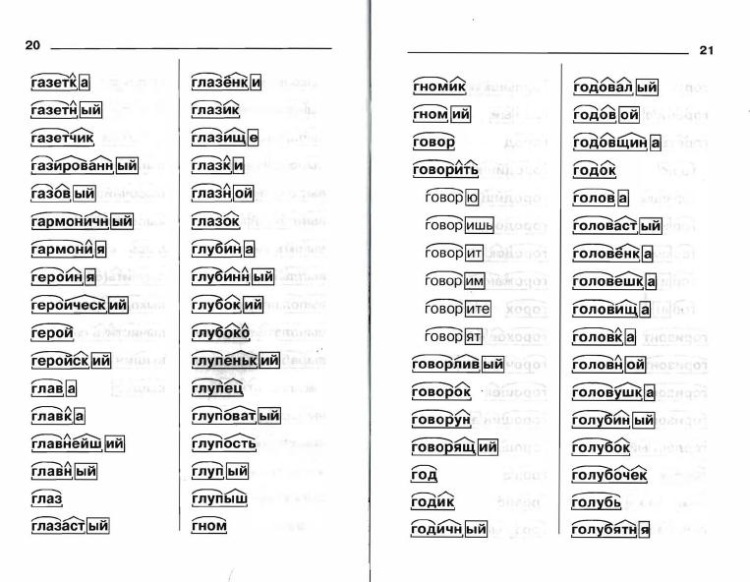

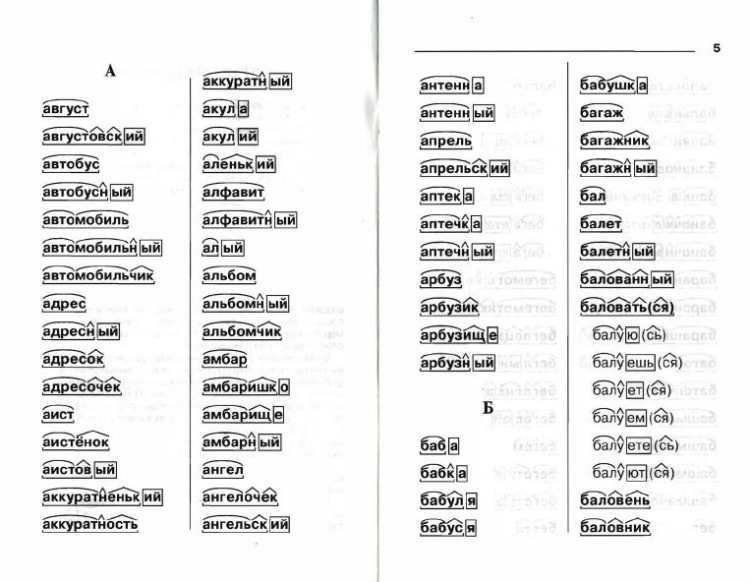

Слово «гладиатор» — это имя существительное, отвечает на вопрос «Кто?», одушевлённое, мужского рода единственного числа, именительный падеж. Разбор по составу слова «гладиатор» имеет вид:

гладиатор — это корень;

нулевое окончание.

Основа слова является — гладиатор .

Разбор по составу слова «раритетная» имеет вид:

раритет — это корень ;

н — суффикс ;

ая — окончание .

Основа слова является — раритетн .

Способ образования слова — суффиксальный.

Разбор по составу слова «раколовка» имеет вид:

рак — это корень ;

ол — суффикс ;

ов — суффикс;

к — суффикс;

а — окончание .

Основа слова является — раколовк .

Способ образования слова — суффиксальный.

Разбор по составу слова «гладиатор» имеет вид:

гладиатор — это корень;

нулевое окончание.

Основа слова является — гладиатор .

Разбор по составу слова «раритетная» имеет вид:

раритет — это корень ;

н — суффикс ;

ая — окончание .

Основа слова является — раритетн .

Способ образования слова — суффиксальный.

Разбор по составу слова «раколовка» имеет вид:

рак — это корень ;

ол — суффикс ;

ов — суффикс;

к — суффикс;

а — окончание .

Основа слова является — раколовк .

Способ образования слова — суффиксальный.

Существительное мужского рода Гладиатор имеет нулевое окончание: Гладиатор-Гладиатора-Гладиатору-Гладиатором. Однокоренные слова Гладиатор-Гладиаторский. Корень слова Гладиатор.

Получаем: ГЛАДИАТОР_ (корень-нулевое окончание), основа слова ГЛАДИАТОР.

Прилагательное Раритетная имеет окончание женского рода -АЯ: Раритетная-Раритетный-Раритетное. Однокоренными словами будут Раритетный-Раритет. Корнем слова оказывается РАРИТЕТ-. Также выделим в слове суффикс прилагательного -Н-. Получаем: РАРИТЕТ-Н-АЯ (корень-суффикс-окончание), основа слова РАРИТЕТН-.

Странное существительное Раколовка имеет окончание -А: Раколовка-Раколовку-Раколовке-Раколовкой. Слово это сложное и выделим в нем два корня. Первый корень будет РАК- и однокоренные слова Рак-Раковый-Ракоед. Второй корень -ЛОВ- и однокоренные слова Ловля-Ловить-Ловец. Между корнями выделим соединительную гласную -О-, а после второго корня суффикс -К-.

Получаем: РАК-О-ЛОВ-К-А (корень-соединительная гласная-корень-суффикс-окончание), основа слова РАКОЛОВК-.

Получаем: РАРИТЕТ-Н-АЯ (корень-суффикс-окончание), основа слова РАРИТЕТН-.

Странное существительное Раколовка имеет окончание -А: Раколовка-Раколовку-Раколовке-Раколовкой. Слово это сложное и выделим в нем два корня. Первый корень будет РАК- и однокоренные слова Рак-Раковый-Ракоед. Второй корень -ЛОВ- и однокоренные слова Ловля-Ловить-Ловец. Между корнями выделим соединительную гласную -О-, а после второго корня суффикс -К-.

Получаем: РАК-О-ЛОВ-К-А (корень-соединительная гласная-корень-суффикс-окончание), основа слова РАКОЛОВК-.

Морфемный анализ Слово «гладиатор» имеет: корень «-гладиатор-«, однокоренное слово — гладиаторский (бой) нулевое окончание основа слова — все слово «гладиатор-» Слово «раритетная» имеет: корень «-раритет-» суффикс «-н-» окончание «-ая» (раритетную, раритетной) основа слова «раритетн-» Слово «раколовка» имеет: два корня: «-рак-» (раковый, раки) и «-лов-» (ловить, ловля, улов) «-о-» — соединительная гласная «-к-» — суффикс «-а» окончание (раколовку, раколовке) основа слова «раколовк-«

Если человек закончил только бакалавриат, то поступать в магистратуру точно стоит. Я, несмотря на то, что имею диплом специалиста, отучилась еще и в магистратуре и получила ученую степень магистра. Магистратура помогла мне поднять свой профессиональный уровень. На зарплате мое обучение никак не отразилось, но училась я для себя, еще и бесплатно. Если бы еще можно было бесплатно в магистратуре поучиться, то еще бы поучилась, только уже по другому направлению. А то практических знаний уже много, а теория уже забывается, да и новые направления в развитии науки дают в магистратуре.

Еще плюсом магистратуры служит то, что можно и в аспирантуру поступить. Можно даже работу продолжать по своей магистерской диссертации.

Я, несмотря на то, что имею диплом специалиста, отучилась еще и в магистратуре и получила ученую степень магистра. Магистратура помогла мне поднять свой профессиональный уровень. На зарплате мое обучение никак не отразилось, но училась я для себя, еще и бесплатно. Если бы еще можно было бесплатно в магистратуре поучиться, то еще бы поучилась, только уже по другому направлению. А то практических знаний уже много, а теория уже забывается, да и новые направления в развитии науки дают в магистратуре.

Еще плюсом магистратуры служит то, что можно и в аспирантуру поступить. Можно даже работу продолжать по своей магистерской диссертации.Больше ответов

Популярные вопросы из категории: образование

образование

Как бы Вы поступили, если, вернувшись из 1 класса, ребёнок продекламировал?…

образование

В чем смысл выражения «небо с овчинку покажется»?…

образование

Почему «лучшее — враг хорошего»?…

образование

Журналистика это что?. 2t…

2t…

Математика, 21.03.2019 00:10

Две стрелки насажены на одну ось и в некоторый момент времени совмещены. одна из стрелок описывает круг за 12 часов, а другая за 16 часов. за какое время стрелки совместяться опять…

Геометрия, 21.03.2019 00:10

Найти площадь паролелограмма если его стороны ровны 9 и 16 см2 а угол между ними 30%…

Русский язык, 21.03.2019 00:10

Уверенность каждого за свой завтрашний день. какая тут ошибка, граматическая или лексическая и почему…

Геометрия, 21.03.2019 00:10

Сторона треугольника равна 12см а высота проведённая к ней в три раза меньше стороны, найдите площадь треугольника….

Физика, 21.03.2019 00:10

Медный шар имеет объем 240 см2 и массу 1,78 кг. определить объем полости внутри этого шара….

Обществознание, 21.03.2019 00:10

Укажи какие ресурсы необходимы для удовлетворения следующих потребностей: в пище, в чистоте и уюте, в тепле, в общении, в безопасности жилища…

Алгебра, 21. 2 + 3x / x+4…

2 + 3x / x+4…

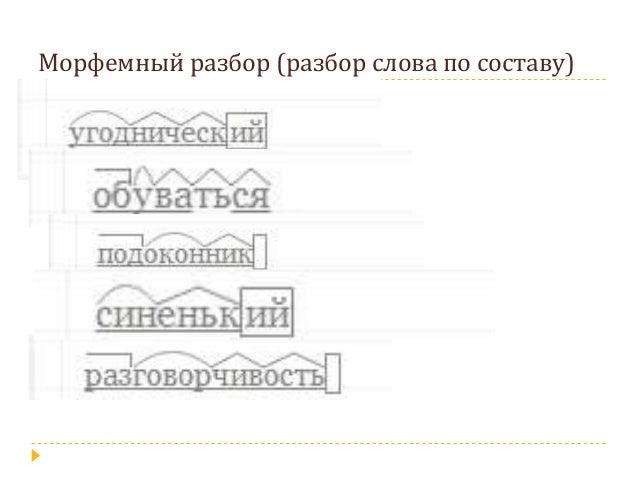

Грамматически укореняем себя с помощью деревьев синтаксического анализа | Вайдехи Джоши | basecs

Грамматически укореняем себя с помощью деревьев синтаксического анализа!Размышление обо всех абстракциях, окружающих нас в мире технологий, иногда может быть ошеломляющим. Это особенно верно, когда вы пытаетесь осмыслить новую парадигму или раскрыть слои одной или нескольких концепций, которые вы пытаетесь понять.

В контексте изучения компьютерных наук существует слишком много абстракций, чтобы знать, видеть или распознавать их все, не говоря уже о способности понять их все!

Абстракции — это мощные вещи, когда вы можете заглянуть за их пределы и понять, как что-то абстрагируется и почему, может сделать вас лучшим программистом. Однако, по той же причине, каждая абстракция была создана с какой-то целью: чтобы никто из нас не беспокоился о них изо дня в день! Мы не должны постоянно думать об абстракциях, и по большей части очень немногие из нас на самом деле так думают. Но вот в чем дело — некоторые абстракции более равны, чем другие. Те, которые, вероятно, волнуют большинство инженеров, связаны с тем, как они взаимодействуют со своим компьютером, и с тем, как их компьютер на самом деле понимает их. Даже если никому из нас никогда не придется писать алгоритм пузырьковой сортировки, если мы напишем код, то нам придется взаимодействовать с нашими машинами.

Но вот в чем дело — некоторые абстракции более равны, чем другие. Те, которые, вероятно, волнуют большинство инженеров, связаны с тем, как они взаимодействуют со своим компьютером, и с тем, как их компьютер на самом деле понимает их. Даже если никому из нас никогда не придется писать алгоритм пузырьковой сортировки, если мы напишем код, то нам придется взаимодействовать с нашими машинами.

Наконец-то пришло время нам разобраться в этих тайнах и понять абстракции, лежащие в основе наших рабочих процессов как программистов.

Древовидная структура данных снова и снова всплывает в наших компьютерных приключениях. Мы видели, как они использовались для хранения данных всех типов, мы видели самобалансирующиеся, в то время как другие были оптимизированы для хранения и хранения данных. Мы даже рассмотрели, как манипулировать деревьями, поворачивая и перекрашивая их, чтобы убедиться, что они соответствуют набору правил.

Но, несмотря на все эти различные формы флоры структур данных, существует одна конкретная итерация древовидной структуры данных, которую нам еще предстоит открыть. Даже если бы мы ничего не знали о компьютерных науках, о том, как сбалансировать дерево или о том, как работает древовидная структура данных, все программисты ежедневно взаимодействуют с одним типом древовидной структуры в силу того простого факта, что каждый разработчик, пишущий код, должны убедиться, что их код понятен их машинам.

Даже если бы мы ничего не знали о компьютерных науках, о том, как сбалансировать дерево или о том, как работает древовидная структура данных, все программисты ежедневно взаимодействуют с одним типом древовидной структуры в силу того простого факта, что каждый разработчик, пишущий код, должны убедиться, что их код понятен их машинам.

Эта структура данных называется деревом синтаксического анализа, и это (одна из) лежащих в основе абстракций, позволяющих сделать код, который мы пишем как программисты, «читаемым» для наших компьютеров.

Дерево синтаксического анализа: определение. По своей сути дерево синтаксического анализа представляет собой иллюстрированную графическую версию грамматической структуры предложения. Деревья синтаксического анализа на самом деле уходят корнями в область лингвистики, но они также используются в педагогике, изучающей преподавание. Деревья синтаксического анализа часто используются для обучения студентов тому, как идентифицировать части предложения, и являются распространенным способом введения грамматических понятий. Вполне вероятно, что каждый из нас взаимодействовал с ними с точки зрения построения диаграмм предложений, которым некоторые из нас могли научиться в начальной школе.

Вполне вероятно, что каждый из нас взаимодействовал с ними с точки зрения построения диаграмм предложений, которым некоторые из нас могли научиться в начальной школе.

Дерево синтаксического анализа — это на самом деле просто «диаграммная» форма предложения; это предложение может быть написано на любом языке, а это значит, что оно может соответствовать любому набору грамматических правил.

Составление диаграмм предложений включает в себя разбиение одного предложения на мельчайшие и наиболее отчетливые части. Если мы подумаем о деревьях синтаксического анализа с точки зрения построения диаграмм предложений, мы быстро начнем понимать, что в зависимости от грамматики и языка предложения дерево синтаксического анализа действительно может быть построено множеством различных способов!

Но что такое компьютерная версия «предложения»? И как мы собираемся изобразить это на диаграмме?

Что ж, полезно начать с примера того, с чем мы уже знакомы, так что давайте освежим нашу память, нарисовав диаграмму обычного английского предложения.

На иллюстрации, показанной здесь, у нас есть простое предложение: "Вайдехи съел пирог" . Поскольку мы знаем, что дерево синтаксического анализа — это всего лишь схематичное предложение, мы можем построить дерево синтаксического анализа из этого примерного предложения. Помните, что на самом деле все, что мы пытаемся сделать, — это определить различные части этого предложения и разбить его на самые маленькие, наиболее отчетливые части.

Мы можем начать с разделения предложения на две части: существительное , «вайдехи» и глагольная фраза , «съел пирог» . Так как существительное не может быть далее разбито, мы оставим слово "Вайдехи" как есть. Другой способ думать об этом — тот факт, что, поскольку мы не можем дальше разбивать существительное, от этого слова не будет дочерних узлов.

А как насчет глагольной фразы, "съел пирог" ? Ну, эта фраза еще не разбита на простейшую форму, не так ли? Мы можем разобрать его еще дальше. Во-первых, слово

Во-первых, слово «съел» — это глагол, а «пирог» — это скорее существительное — на самом деле, если быть точным, это именное словосочетание . Если мы разделим «съел пирог» , мы можем разделить его на глагол и именную группу. Поскольку глагол не может быть изображен с какими-либо дополнительными деталями, слово «съел» станет конечным узлом в нашем дереве синтаксического анализа.

Итак, теперь осталось только словосочетание "пирог" . Мы можем разделить эту фразу на две отдельные части: существительное «пирог» и его определитель , известный как любое модифицирующее слово существительного. В данном случае определителем является слово "the" .

Как только мы разделим нашу группу существительных, мы закончим разделять наше предложение! Другими словами, мы закончили построение диаграммы нашего дерева синтаксического анализа. Когда мы посмотрим на наше дерево синтаксического анализа, мы заметим, что наше предложение по-прежнему читается так же, и мы на самом деле вообще не изменили его. Мы просто взяли предложение, которое нам дали, и, используя правила английской грамматики, разделили его на мельчайшие, наиболее отчетливые части.

Когда мы посмотрим на наше дерево синтаксического анализа, мы заметим, что наше предложение по-прежнему читается так же, и мы на самом деле вообще не изменили его. Мы просто взяли предложение, которое нам дали, и, используя правила английской грамматики, разделили его на мельчайшие, наиболее отчетливые части.

Что на самом деле означает парсить что-то?В английском языке наименьшая «часть» каждого предложения — это слово; слова могут быть объединены в фразы, такие как именные или глагольные фразы, которые, в свою очередь, могут быть объединены с другими фразами для создания выражения предложения.

Однако это всего лишь один пример того, как одно конкретное предложение на одном конкретном языке с собственным набором грамматических правил может быть представлено в виде дерева синтаксического анализа. Это же предложение выглядело бы совсем по-другому на другом языке, особенно если бы оно должно было следовать собственному набору грамматических правил.

В конечном счете, грамматика и синтаксис языка — включая способ построения предложений этого языка — становятся правилами, определяющими, как определяется этот язык, как мы пишем на нем и как те из нас, кто говорить на языке в конечном итоге будет понимать и интерпретировать его.

Интересно, что мы знали, как нарисовать простое предложение «Вайдехи съел пирог». , потому что мы уже были знакомы с грамматикой английского языка. Представьте, если бы в нашем предложении вообще отсутствовало существительное или глагол? Что случилось бы? Что ж, мы, вероятно, прочтем предложение в первый раз и быстро поймем, что это вообще не предложение! Скорее, мы бы прочитали его и почти сразу увидели, что имеем дело с фрагмент предложения или неполный фрагмент предложения.

Однако единственная причина, по которой мы смогли бы распознать фрагмент предложения, заключается в том, что мы знали правила английского языка, а именно, что (почти) каждое предложение нуждается в существительном и глаголе, чтобы считаться действительным. Грамматика языка — это то, как мы можем проверить, допустимо ли предложение в языке; этот процесс «проверки» на достоверность называется разбором предложения.

Грамматика языка — это то, как мы можем проверить, допустимо ли предложение в языке; этот процесс «проверки» на достоверность называется разбором предложения.

Процесс разбора предложения, чтобы понять его, когда мы читаем его в первый раз, включает в себя те же мыслительные шаги, что и построение предложения в виде диаграммы, а построение диаграммы предложения включает в себя те же шаги, что и построение дерева разбора. Когда мы читаем предложение в первый раз, мы делаем работу по его мысленной деконструкции и анализу.

Как оказалось, компьютеры делают то же самое с кодом, который мы пишем!

Итак, теперь мы знаем, как составить схему и разобрать предложение на английском языке. Но как это применимо к коду? А что такое «предложение» в нашем коде?

Итак, мы можем думать о дереве синтаксического анализа как о иллюстрированной «картинке» того, как выглядит наш код. Если мы представим наш код, нашу программу или хотя бы простейший сценарий в виде предложения, мы, вероятно, довольно быстро поймем, что весь код, который мы пишем, можно просто упростить до наборов выражений.

Это становится более понятным на примере, поэтому давайте рассмотрим очень простую программу-калькулятор. Используя одно выражение, мы можем использовать грамматические «правила» математики для создания дерева синтаксического анализа из этого выражения. Нам нужно найти самые простые, наиболее четкие единицы нашего выражения, а это значит, что нам нужно разбить наше выражение на более мелкие сегменты, как показано ниже.

Нахождение грамматики в математических выражениях.Мы заметим, что отдельное математическое выражение имеет свои собственные грамматические правила; даже простое выражение (например, два числа, умноженные вместе, а затем добавленные к другому числу) можно было бы разделить на еще более простые выражения внутри самих себя.

Представление математических выражений в виде дерева разбора. Но давайте для начала проведем простой расчет. Как мы могли бы создать дерево синтаксического анализа, используя математическую грамматику для такого выражения, как 2 х 8 ?

Если мы подумаем о том, как на самом деле выглядит это выражение, мы увидим, что здесь есть три отдельные части: выражение слева, выражение справа и операция, которая умножает их две вместе.

Изображение, показанное здесь, изображает выражение 2 x 8 в виде дерева синтаксического анализа. Мы увидим, что оператор x — это часть выражения, которую нельзя упростить дальше, поэтому у него нет дочерних узлов.

Выражение слева и справа может быть упрощено до его конкретных терминов, а именно 2 и 8 . Как и в примере с английским предложением, который мы рассматривали ранее, одно математическое выражение может содержать внутренних выражений внутри него, а также отдельных терминов , например фраза 2 x 8 , или множителей , например число . 2 как индивидуальное выражение.

Но что произойдет после того, как мы создадим это дерево разбора? Мы заметим, что иерархия дочерних узлов здесь немного менее очевидна, чем в нашем предыдущем примере с предложением. оба 2 и 8 находятся на одном уровне, так как мы можем это интерпретировать?

Ну, мы уже знаем, что есть разные способы обхода дерева в глубину. В зависимости от того, как мы перемещаемся по этому дереву, это единственное математическое выражение 2 x 8 может быть интерпретировано и прочитано по-разному. Например, если бы мы прошли через это дерево, используя обходов в порядке , мы прочитали бы левое дерево, корневой уровень, а затем правое дерево, в результате чего 2 -> х -> 8 .

Но если бы мы решили пройтись по этому дереву, используя обход предварительного порядка , мы бы сначала прочитали значение на корневом уровне, затем в левом поддереве, а затем в правом поддереве, что дало бы нам x -> 2 - > 8 . И если бы мы использовали обход в обратном порядке , мы бы прочитали левое поддерево, правое поддерево, а затем, наконец, прочитали бы корневой уровень, что привело бы к 2 -> 8 -> x .

Деревья синтаксического анализа показывают нам, что представляют собой наши выражения выглядят как , раскрывая конкретный синтаксис наших выражений, что часто означает, что одно дерево синтаксического анализа может выражать «предложение» различными способами. По этой причине деревья синтаксического анализа также часто называют конкретными синтаксическими деревьями или CST для краткости. Когда эти деревья интерпретируются или «читаются» нашими машинами, должны существовать строгие правила в отношении того, как эти деревья анализируются, чтобы в итоге мы получили правильное выражение со всеми терминами в правильном порядке и в правильном порядке. место!

По этой причине деревья синтаксического анализа также часто называют конкретными синтаксическими деревьями или CST для краткости. Когда эти деревья интерпретируются или «читаются» нашими машинами, должны существовать строгие правила в отношении того, как эти деревья анализируются, чтобы в итоге мы получили правильное выражение со всеми терминами в правильном порядке и в правильном порядке. место!

Но большинство выражений, с которыми мы имеем дело, более сложны, чем просто 2 x 8 . Даже для программы-калькулятора нам, вероятно, придется выполнять более сложные вычисления. Например, что произойдет, если мы захотим найти такое выражение, как 5 + 1 x 12 ? Как будет выглядеть наше дерево синтаксического анализа?

Как оказалось, проблема с деревьями синтаксического анализа заключается в том, что иногда вы можете получить более одного дерева.

Неоднозначная грамматика в действии (разборе)! Более конкретно, может быть более одного результата для одного анализируемого выражения. Если мы предположим, что деревья синтаксического анализа сначала считываются с самого нижнего уровня, мы можем начать видеть, как иерархия конечных узлов может привести к тому, что одно и то же выражение будет интерпретировано двумя совершенно разными способами, в результате чего будут получены два совершенно разных значения.

Если мы предположим, что деревья синтаксического анализа сначала считываются с самого нижнего уровня, мы можем начать видеть, как иерархия конечных узлов может привести к тому, что одно и то же выражение будет интерпретировано двумя совершенно разными способами, в результате чего будут получены два совершенно разных значения.

Например, на иллюстрации выше есть два возможных дерева синтаксического анализа для выражения 5 + 1 x 12 . Как мы видим в левом дереве разбора, иерархия узлов такова, что сначала будет оцениваться выражение 1 x 12 , а затем продолжится сложение: 5 + (1 x 12) . С другой стороны, правильное дерево синтаксического анализа сильно отличается; иерархия узлов заставляет сначала выполнить сложение ( 5 + 1 ), а затем перемещается вверх по дереву, чтобы продолжить умножение: (5 + 1) х 12 .

Неоднозначная грамматика в языке — это именно то, что вызывает такую ситуацию: когда неясно, как должно быть построено синтаксическое дерево, оно может быть построено (по крайней мере) более чем одним способом.

Борьба с неоднозначной грамматикой в качестве компилятораНо вот загвоздка: неоднозначная грамматика создает проблемы для компилятора!

Основываясь на правилах математики, которые большинство из нас учили в школе, мы по своей сути знаем, что умножение всегда должно выполняться перед сложением. Другими словами, только левое дерево синтаксического анализа в приведенном выше примере действительно правильно на основе грамматики математики. Помните: грамматика определяет синтаксис и правила любого языка, будь то английское предложение или математическое выражение.

Но откуда компилятору знать эти правила? Ну просто не может быть! Компилятор не будет знать, как читать код, который мы пишем, если мы не зададим ему грамматические правила, которым нужно следовать. Если компилятор увидит, что мы написали математическое выражение, например, которое может привести к двум разным деревьям синтаксического анализа, он не будет знать, какое из двух деревьев синтаксического анализа выбрать, и, таким образом, он не будет знать, как даже читать или интерпретировать наш код.

Именно по этой причине в большинстве языков программирования обычно избегают неоднозначной грамматики. На самом деле, большинство синтаксических анализаторов и языков программирования намеренно решают проблемы неоднозначности с самого начала. Язык программирования обычно имеет грамматику, обеспечивающую приоритет , что заставит некоторые операции или символы иметь более высокий вес/значение, чем другие. Примером этого является гарантия того, что всякий раз при построении дерева синтаксического анализа умножение имеет более высокий приоритет, чем сложение, так что когда-либо может быть построено только одно дерево синтаксического анализа.

Еще один способ борьбы с двусмысленностью — применение способа интерпретации грамматики. Например, в математике, если у нас есть такое выражение, как 1 + 2 + 3 + 4 , мы изначально знаем, что должны начинать сложение слева и продвигаться вправо. Если бы мы хотели, чтобы наш компилятор понял, как это сделать с нашим собственным кодом, нам нужно было бы применить оставил ассоциативность , что сузило бы наш компилятор так, что при разборе нашего кода он создал бы дерево разбора, которое помещает коэффициент 4 ниже в иерархии дерева разбора, чем фактор 1 .

Эти два примера часто называют правилами устранения неоднозначности в дизайне компилятора, поскольку они создают определенные синтаксические правила, гарантирующие, что мы никогда не столкнемся с неоднозначной грамматикой, которая может сильно запутать наш компилятор.

Если двусмысленность является корнем всех зол дерева синтаксического анализа, то ясность является предпочтительным режимом работы. Конечно, мы можем добавить правила устранения неоднозначности, чтобы избежать двусмысленных ситуаций, которые заставят наш бедный маленький компьютер зайти в тупик при чтении нашего кода, но на самом деле мы делаем гораздо больше. Или, скорее, именно языки программирования, которые мы используем, делают настоящую тяжелую работу!

Поясню. Мы можем думать об этом так: одним из способов добавить ясности математическому выражению являются круглые скобки. Фактически, это то, что большинство из нас, вероятно, сделало бы для выражения, с которым мы имели дело ранее: 5 + 1 х 12 . Вероятно, мы прочитали бы это выражение и, вспомнив порядок действий, который мы изучили в школе, переписали бы его в уме так:

Вероятно, мы прочитали бы это выражение и, вспомнив порядок действий, который мы изучили в школе, переписали бы его в уме так: 5 + (1 x 12) . Скобка () помогла нам прояснить само выражение и два выражения, которые по своей сути находятся внутри него. Эти два символа узнаваемы для нас, и если бы мы поместили их в наше дерево синтаксического анализа, у них не было бы дочерних узлов, потому что они не могут быть разбиты дальше.

Это то, что мы называем терминалами , которые также широко известны как токены . Они имеют решающее значение для всех языков программирования, потому что помогают нам понять, как части выражения соотносятся друг с другом, и синтаксические отношения между отдельными элементами. Некоторые общие токены в программировании включают знаки операций ( + , -, x , /), круглые скобки ( () ) и зарезервированные условные слова (9). 0035, если ,

0035, если , , затем , , иначе , и ). Некоторые токены используются для уточнения выражений, поскольку они могут указывать, как разные элементы связаны друг с другом.

Итак, каковы все остальные элементы в нашем дереве синтаксического анализа? У нас явно больше, чем просто , если и + знаков в нашем коде! Ну, нам также обычно приходится иметь дело с наборами нетерминалов , которые являются выражениями, терминами и факторами, которые потенциально могут быть разбиты дальше. Это фразы/идеи, которые содержат в себе другие выражения, такие как выражение (8 + 1) / 3 .

Как терминалы, так и нетерминалы имеют определенное отношение к месту их появления в дереве синтаксического анализа. Как следует из их названия, символ терминала всегда будет заканчиваться листьями дерева синтаксического анализа; это означает, что не только операторы, круглые скобки и зарезервированные условные операторы являются «терминалами», но и все значения факторов, которые представляют строку, число или понятие, которое находится в каждом конечном узле. Все, что разбито на мельчайшие части, фактически всегда будет «терминалом».

Все, что разбито на мельчайшие части, фактически всегда будет «терминалом».

С другой стороны, внутренние узлы дерева синтаксического анализа — неконечные узлы, которые являются родительскими узлами — это нетерминальных символов, и именно они представляют применение правил грамматики языка программирования.

Дерево синтаксического анализа становится намного легче понять, визуализировать и идентифицировать, как только мы поймем, что это не что иное, как представление нашей программы и всех символов, понятий и выражений в ней.

Понимание роли синтаксического анализатораНо какова ценность дерева синтаксического анализа? Мы не думаем об этом как программисты, но ведь это должно существовать по какой-то причине, верно?

Ну, как оказалось, дерево синтаксического анализа больше всего заботит синтаксический анализатор , который является частью компилятора, который обрабатывает процесс синтаксического анализа всех кода, который мы пишем.

Процесс синтаксического анализа на самом деле просто берет некоторые входные данные и строит из них дерево синтаксического анализа. Этими входными данными могут быть самые разные вещи, такие как строка, предложение, выражение или даже целая программа.

Независимо от того, какие входные данные мы передаем, наш синтаксический анализатор будет разбирать эти входные данные на грамматические фразы и строить из них дерево разбора. На самом деле синтаксический анализатор играет две основные роли в контексте нашего компьютера и процесса компиляции:

- При задании допустимой последовательности токенов он должен быть в состоянии сгенерировать соответствующее дерево разбора, следуя синтаксису языка.

- При задании недопустимой последовательности токенов он должен обнаруживать синтаксическую ошибку и сообщать программисту, написавшему код, о проблеме в его коде.

И это действительно так! Это может показаться очень простым, но если мы начнем рассматривать, насколько массивными и сложными могут быть некоторые программы, мы быстро начнем понимать, насколько четко должны быть вещи, чтобы синтаксический анализатор действительно выполнял эти две, казалось бы, простые роли.

Например, даже простому синтаксическому анализатору нужно много сделать, чтобы обработать синтаксис такого выражения, как 1 + 2 + 3 x 4 .

- Во-первых, из этого выражения нужно построить дерево разбора. Входная строка, которую получает синтаксический анализатор, может не отображать никакой связи между операциями, но синтаксическому анализатору необходимо создать дерево синтаксического анализа, которое это делает.

- Однако для этого необходимо знать синтаксис языка и правила грамматики, которым необходимо следовать.

- После того, как он действительно сможет создать одно дерево синтаксического анализа (без двусмысленности), он должен иметь возможность извлекать токены и нетерминальные символы и располагать их так, чтобы иерархия дерева синтаксического анализа была правильной.

- Наконец, синтаксический анализатор должен гарантировать, что при оценке этого дерева оно будет оцениваться слева направо с операторами одинакового приоритета.

- Но подождите! Он также должен убедиться, что при обходе этого дерева с использованием метода неупорядоченного обхода снизу никогда не возникает ни одной синтаксической ошибки!

- Конечно, если ломает , синтаксический анализатор должен посмотреть на ввод, выяснить, где он сломается, а затем сообщить об этом программисту.

Если вам кажется, что это очень много работы, то это потому, что так оно и есть. Но не беспокойтесь слишком сильно о том, чтобы сделать все это, потому что это работа синтаксического анализатора, и большая часть ее абстрагируется. К счастью, анализатору помогают другие части компилятора. Подробнее об этом на следующей неделе!

К счастью для нас, разработка компилятора — это то, чему хорошо учат почти в каждой учебной программе по информатике, и существует достаточное количество надежных ресурсов, которые помогут нам понять различные части компилятора, включая синтаксический анализатор и синтаксический анализ. дерево. Однако, как и в случае с большинством контента CS, многие из них могут быть трудными для восприятия, особенно если вы не знакомы с концепциями или используемым жаргоном. Ниже приведены еще несколько ресурсов, удобных для начинающих, которые по-прежнему хорошо объясняют деревья синтаксического анализа, если вы захотите узнать еще больше.

Ниже приведены еще несколько ресурсов, удобных для начинающих, которые по-прежнему хорошо объясняют деревья синтаксического анализа, если вы захотите узнать еще больше.

- Дерево синтаксического анализа, интерактивный Python

- Грамматика, синтаксический анализ, обход дерева, профессора Дэвид Грайс и Дуг Джеймс

- Давайте создадим простой интерпретатор, часть 7, Руслан Спивак

- Руководство по синтаксическому анализу: алгоритмы и терминология, Габриэле Томассетти2 9032 Томассетти2

- Лекция 2: Абстрактный и конкретный синтаксис, Аарне Ранта

- Компиляторы и интерпретаторы, профессор Чжун Шао

- Основы компиляции — Парсер, Джеймс Алан Фаррелл

Модель синтаксического анализа и рациональная теория памяти

1. Введение

В рациональной теории познания утверждается, что когнитивные функции во многом формируются нашей адаптацией к окружающей среде. С этой точки зрения предполагается, что различные аспекты нашего поведения можно объяснить как результат оптимизации структуры окружающей среды. Рациональная теория познания оказалась плодотворной в объяснении закономерностей в категоризации, обучении, общении и рассуждении, среди прочего (Anderson, 1990, 1991; Oaksford and Chater, 19).94, 2007; Тененбаум и др., 2011; Франке и Ягер, 2016 г.; Пиантадоси и др., 2016).

Рациональная теория познания оказалась плодотворной в объяснении закономерностей в категоризации, обучении, общении и рассуждении, среди прочего (Anderson, 1990, 1991; Oaksford and Chater, 19).94, 2007; Тененбаум и др., 2011; Франке и Ягер, 2016 г.; Пиантадоси и др., 2016).

Одним из особенно успешных случаев рациональной теории было ее применение к изучению человеческой памяти, как обобщается в Anderson (1991). Предполагая, что человеческая память должна стремиться предоставить информацию, необходимую в конкретной ситуации, и что извлечение элементов из памяти требует больших затрат и времени, можно было бы ожидать, что извлечение элемента связано с вероятностью того, что он необходим. То есть элементы, которые, скорее всего, будут необходимы в конкретной ситуации, будут иметь приоритет при поиске. Поскольку поиск упорядочен по вероятности потребности, ожидается, что для вызова менее необходимых элементов потребуется больше времени. Кроме того, если поиск прекращается, когда стоимость поиска превышает некоторый порог, мы ожидаем, что чем меньше потребность в предмете, тем больше вероятность того, что его отзыв не удастся. Эти предсказания в значительной степени подтвердились, см. Anderson (1991).

Эти предсказания в значительной степени подтвердились, см. Anderson (1991).

Рациональная теория памяти сыграла важную роль в развитии когнитивной архитектуры Adaptive Control of Thought-Rational, ACT-R (Anderson and Lebiere, 1998; Anderson et al., 2004), которая, в свою очередь, сыграла важную роль. в психолингвистических моделях анализа (Lewis and Vasishth, 2005; Lewis et al., 2006; Reitter et al., 2011; Engelmann et al., 2013; Vogelzang et al., 2017; Brasoveanu and Dotlačil, 2020). Льюис и Васишт (2005) и последующие работы показали, в частности, что рациональная теория памяти, реализованная в ACT-R, проницательна при анализе паттерна припоминания при формировании зависимостей при разборе, например, зависимости подлежащее-глагол, как в (1 -а) и антецедентно-рефлексивной зависимости, как в (1-б) (см. также Lewis et al., 2006; Van Dyke, 2007; Wagers et al., 2009).; Диллон и др., 2013 г.; Куш и др., 2015; Лаго и др., 2015; Ягер и др., 2017; Ягер и др., 2020 г.; Нисенбойм и др., 2018; Виллата и др. , 2018 г.; Энгельманн и др., 2019; Васишт и др., 2019; Smith and Vasishth, 2020 и др.).

, 2018 г.; Энгельманн и др., 2019; Васишт и др., 2019; Smith and Vasishth, 2020 и др.).

Это подводит нас к теме исследования данной статьи, а именно к изучению того, могут ли другие аспекты, в которых синтаксический анализ должен полагаться на память, также рассматриваться как соответствующие исследовательской программе рациональной теории познания. В частности, во время понимания и производства носители языка должны постоянно полагаться на свои прошлые знания правил синтаксического анализа. Например, в (1) читатели не смогут правильно понять предложения, если не вспомнят, что в английском языке подлежащее обычно предшествует глаголу, за глаголом следует дополнение, в английском языке есть предлоги (а не послелоги) и т. д. С точки зрения рациональной теории памяти ожидается, что поиск правил синтаксического анализа, таких как эти, должен следовать общим соображениям, изложенным выше, т. е. правила синтаксического анализа должны извлекаться в порядке вероятности их необходимости, и порядок должен монотонно коррелировать с задержками и точность. Мы покажем, что синтаксический анализ действительно можно построить на основе рациональной теории памяти. Полученная модель может, кроме того, правильно предсказывать качественные данные в психолингвистике (феномен садовой дорожки), а ее предсказания соответствуют поведенческим показателям в психолингвистическом корпусе (Natural Stories Corpus, Futrell et al., 2018).

Мы покажем, что синтаксический анализ действительно можно построить на основе рациональной теории памяти. Полученная модель может, кроме того, правильно предсказывать качественные данные в психолингвистике (феномен садовой дорожки), а ее предсказания соответствуют поведенческим показателям в психолингвистическом корпусе (Natural Stories Corpus, Futrell et al., 2018).

Структура статьи следующая: в следующем разделе мы кратко представляем рациональную теорию памяти как часть когнитивной архитектуры ACT-R. Далее мы представляем синтаксические анализаторы на основе переходов, разработанные в компьютерной лингвистике, и показываем, как можно комбинировать синтаксический анализ на основе переходов и когнитивные архитектуры. Затем когнитивно информированный синтаксический анализатор оценивается на примерах садовых дорожек и данных из Natural Stories Corpus. Наконец, наше исследование кратко сравнивается с родственными работами по вычислительной психолингвистике.

2. Моделирование извлечения памяти в рациональной теории

Адаптивное управление мыслью-Рациональное предполагает, в соответствии со своим названием, что различные когнитивные функции следует моделировать как случай рациональной теории познания. Здесь мы сосредоточимся на том, как память и извлечение памяти формализованы в ACT-R.

Здесь мы сосредоточимся на том, как память и извлечение памяти формализованы в ACT-R.

ACT-R предполагает два типа памяти: процедурную память и декларативную память. Мы сосредоточимся здесь на последней, декларативной памяти, которая используется для хранения фактических знаний. 1

Целью системы декларативной памяти должно быть воспроизведение части информации i , необходимой для достижения текущей цели. Как это принято в ACT-R, мы формализуем фрагменты информации в виде фрагментов. Это матрицы значений атрибутов или, в терминологии ACT-R, матрицы значений слотов. Пример фрагмента, представляющего упрощенную часть информации, полученной в зависимости в (1-a), показан в (2). В этом обозначении имена слотов отображаются слева, а их значения — справа. Кусок представляет собой знание того, что подлежащее во множественном числе в форме студента было встречено и сохранено в памяти.

Предполагая, что извлечение фрагмента является дорогостоящим и требует времени, извлечение из памяти должно быть ограничено. Оптимальная система поиска будет отдавать приоритет тем частям, которые, скорее всего, необходимы для текущей цели. В общем, следует считать, что отзыв части информации, чанк i , скорректированный на значение текущей цели G , не должен превышать стоимость извлечения C .

Оптимальная система поиска будет отдавать приоритет тем частям, которые, скорее всего, необходимы для текущей цели. В общем, следует считать, что отзыв части информации, чанк i , скорректированный на значение текущей цели G , не должен превышать стоимость извлечения C .

Задача рациональной теории памяти состоит в том, чтобы найти разумную оценку P ( i ). В ACT-R предполагается, что P ( i ), вероятность того, что i необходимы, обусловлена двумя источниками информации: (i) историей H i , что то есть прошлое использование i и (ii) текущий контекст Q . Таким образом, нам нужно оценить P ( и | H i , Q ), что легко сделать с помощью правила Байеса. Однако вместо прямого выражения условной вероятности в ACT-R стандартно используется оценка логарифмических шансов. Оценка выражается в (4) ( i c является дополнением к i , т. е. ; Q , текущий контекст, состоит из индексов j , которые мы называем репликами).

е. ; Q , текущий контекст, состоит из индексов j , которые мы называем репликами).

Вывод в (4) делает общее предположение, что хотя вероятность того, что i необходимы, зависит от H i и Q , вероятности сигналов 94 j текущий контекст Q взаимно независимы и не зависят от истории H i , обусловленных i (см. Anderson, 1991). Лог-шансы в (4) имеют особый статус в ACT-R. Они называются активацией i , записывается как A i . Активация состоит из двух частей: компонента истории [первое дополнение в (4)] и компонента контекста [второе дополнение в (4)]. В ACT-R компонент истории называется активацией базового уровня, сокращенно B i , а компонент контекста называется активацией распространения, сокращенно S i . Мы можем переписать формулу следующим образом 2 :

Давайте посмотрим, как ACT-R оценивает компоненты истории и контекста. Прежде чем сделать это, мы хотим подчеркнуть две вещи. Во-первых, теория, которую мы собираемся обсудить, в целом и широко принята исследовательским сообществом ACT-R. Во-вторых, важно понимать, что оценки как компонента истории, так и компонента контекста — это не просто произвольные уравнения, которые соответствуют данным памяти. Они должны отражать оценки, которые ум делает из структуры окружающей среды, чтобы прийти к наилучшей оценке P ( i ), используемое в (3), как и следовало бы ожидать от рациональной теории познания. Однако мы не будем приводить доказательства того, что следующие оценки являются обобщением структуры окружающей среды, так как это было сделано в другом месте (см. Anderson, 1991).

Прежде чем сделать это, мы хотим подчеркнуть две вещи. Во-первых, теория, которую мы собираемся обсудить, в целом и широко принята исследовательским сообществом ACT-R. Во-вторых, важно понимать, что оценки как компонента истории, так и компонента контекста — это не просто произвольные уравнения, которые соответствуют данным памяти. Они должны отражать оценки, которые ум делает из структуры окружающей среды, чтобы прийти к наилучшей оценке P ( i ), используемое в (3), как и следовало бы ожидать от рациональной теории познания. Однако мы не будем приводить доказательства того, что следующие оценки являются обобщением структуры окружающей среды, так как это было сделано в другом месте (см. Anderson, 1991).

Активация базового уровня B i фрагмента дана в (6) и отражает тот факт, что вероятность того, что фрагмент будет использован в следующий раз, уменьшается как степенная функция времени, прошедшего с момента последней операции. использования, но на него также влияет количество раз, когда фрагмент был использован. Активация базового уровня выражается как логарифм суммы tk-d, где t k — время, прошедшее между моментом предъявления k и временем извлечения. d — отрицательная экспонента (затухание), свободный параметр ACT-R, для которого часто устанавливается значение по умолчанию 0,5. «Презентация» в ACT-R означает две вещи. Либо это относится к моменту, когда блок был создан в первый раз (т. е. кто-то узнал конкретный факт), либо к моменту, когда блок был успешно вызван из декларативной памяти для использования в каком-либо контексте, после чего он сохраняется в снова декларативная память.

Активация базового уровня выражается как логарифм суммы tk-d, где t k — время, прошедшее между моментом предъявления k и временем извлечения. d — отрицательная экспонента (затухание), свободный параметр ACT-R, для которого часто устанавливается значение по умолчанию 0,5. «Презентация» в ACT-R означает две вещи. Либо это относится к моменту, когда блок был создан в первый раз (т. е. кто-то узнал конкретный факт), либо к моменту, когда блок был успешно вызван из декларативной памяти для использования в каком-либо контексте, после чего он сохраняется в снова декларативная память.

Второй элемент в расчете активации приведен в (7). Чтобы расчеты были управляемыми, вводятся некоторые упрощающие допущения (см. Anderson, 1991; Anderson and Lebiere, 1998). Во-первых, предполагается, что реплики и в текущем контексте независимы друг от друга (и от истории H i ), обусловлены i . Во-вторых, знаменатель, который должен быть P ( j | i c ), упрощается до P ( j ), поскольку обусловливает j нерелевантной частью информации i c и не может существенно влиять на вероятности. Полученный логарифм отношений вероятностей logP(j|i)P(j) называется ассоциативной силой и обычно обозначается аббревиатурой S ji . Уравнение также включает вес W , который является свободным параметром, взвешивающим компонент контекста активации.

Полученный логарифм отношений вероятностей logP(j|i)P(j) называется ассоциативной силой и обычно обозначается аббревиатурой S ji . Уравнение также включает вес W , который является свободным параметром, взвешивающим компонент контекста активации.

Наконец, уравнение в (8) показывает, как ACT-R оценивает ассоциативную силу S ji . Это уравнение используется только в том случае, если сигнал j предсказывает фрагмент i . Если это не так, S ji устанавливается равным 0. Несколько упрощая, ACT-R предполагает, что сигнал предсказывает фрагмент, если сигнал появляется как значение в фрагменте.

S — это логарифм размера декларативной памяти, но обычно он выбирается вручную как достаточно большое значение, чтобы S ji всегда было положительным (см. Bothell, 2017). ). fan j — это количество чанков в памяти, значением которых является cue j . Обсуждение того, почему (8) аппроксимирует logP(j|i)P(j), см. в Brasoveanu and Dotlačil (2020). Также полезно заметить, что формула S ji также выражает следующую интуицию: ассоциативная сила (и, следовательно, активация) будет большой, когда j появляется только в нескольких фрагментах, так как в этом случае j является высокопредсказательным для каждого из этих кусочки; ассоциативная сила будет уменьшаться, если в декларативной памяти будет больше фрагментов, содержащих 90 393 j 90 394 в качестве своего значения (эмпирические данные см. Anderson, 1974; Anderson and Lebiere, 1998; Anderson and Reder, 1999).

Обсуждение того, почему (8) аппроксимирует logP(j|i)P(j), см. в Brasoveanu and Dotlačil (2020). Также полезно заметить, что формула S ji также выражает следующую интуицию: ассоциативная сила (и, следовательно, активация) будет большой, когда j появляется только в нескольких фрагментах, так как в этом случае j является высокопредсказательным для каждого из этих кусочки; ассоциативная сила будет уменьшаться, если в декларативной памяти будет больше фрагментов, содержащих 90 393 j 90 394 в качестве своего значения (эмпирические данные см. Anderson, 1974; Anderson and Lebiere, 1998; Anderson and Reder, 1999).

Наконец, формула в (9) показывает, как A i связано со временем извлечения блока из декларативной памяти, T i . Отношение между A i и T i модулируется двумя свободными параметрами, F , коэффициентом задержки, и f , показателем задержки.

Когда оба параметра установлены на 1 (их значение по умолчанию), время выборки чанка i — это просто экспонента его отрицательной активации, которая представляет собой обратную вероятность того, что фрагмент i необходим в текущем контексте [см. (4)]:

Из (10) следует, что чем больше a чанк необходим для достижения текущей цели, тем быстрее он будет извлечен.

Проиллюстрируем, как складываются все уравнения, на примере из введения, зависимости подлежащее-глагол.

Предположим, что мы понимаем или произносим глагол в (11-a) и хотим извлечь фрагмент студентов , чтобы решить зависимость субъект-глагол. Для целей этой иллюстрации мы предполагаем, что фрагмент представлен в памяти, как показано в (11-b), повторяющемся из (2). Зависимость должна быть разрешена для целей интерпретации, поскольку слушатели должны знать, кто агент знает . Это также необходимо для производственных целей, поскольку говорящим нужно знать, какую флективную форму должен иметь глагол.

Активация предмета студента , его логарифмическая вероятность того, что блок необходим, состоит из активации базового уровня и активации распространения. Предположим, что с момента сохранения фрагмента в памяти прошло 1 с, и фрагмент не использовался повторно. Тогда активация базового уровня, рассчитанная с использованием уравнения (6), равна:

Активация распространения, рассчитанная с использованием уравнений (7) и (8), приведена в (13). Обратите внимание, что сигналы [подлежащее], [множественное число] являются сигналами в текущем контексте, т. Е. Мы предполагаем для этого примера, что эти два сигнала присутствуют в когнитивном контексте при разрешении зависимости субъект-глагол.

Предположим, что свободный параметр S установлен равным 1, а также вес W . Поскольку обе реплики появляются в блоке студентов , мы должны вычислить оба слагаемых как:

Единственная часть, которую необходимо решить, — это значение веера для двух реплик. Предположим, что в памяти нет другого подлежащего и еще одного элемента множественного числа. Затем вычисления выполняются следующим образом:

Предположим, что в памяти нет другого подлежащего и еще одного элемента множественного числа. Затем вычисления выполняются следующим образом:

Наконец, мы можем рассчитать время поиска следующим образом:

Основываясь на обсуждении этого примера, можно отметить, что модель декларативной памяти ACT-R делает несколько прогнозов относительно времени извлечения. Некоторые из них приведены в пунктах ниже:

• Чем больше времени прошло с момента последнего использования блока, тем ниже активация блока на базовом уровне. Следовательно, фрагменты, которые использовались давно, будут извлекаться медленнее, чем недавно использовавшиеся фрагменты.

• Чем реже использовался чанк, тем ниже базовый уровень активации чанка. Следовательно, фрагменты, которые редко используются, будут извлекаться медленнее, чем часто используемые фрагменты.

• Чем больше фрагмент соответствует сигналам текущего контекста, тем выше усиление от активации распространения. Следовательно, фрагменты с более высокими совпадениями с репликами должны извлекаться быстрее.

Следовательно, фрагменты с более высокими совпадениями с репликами должны извлекаться быстрее.

• Увеличение веера сигнала увеличивает время извлечения элемента. Например, представьте, что в декларативной памяти хранится больше фрагментов со значением во множественном числе . Тогда ассоциативная сила любого фрагмента с во множественном числе будет ниже, и, следовательно, для извлечения таких фрагментов потребуется больше времени.

В той мере, в какой эти качественные предсказания подтверждаются, у нас есть подтверждающие доказательства рациональной теории памяти, реализованной в ACT-R. В той мере, в какой количественные прогнозы модели могут быть хорошо приспособлены к поисковым данным, у нас также есть доказательства того, что оценки истории и контекстного компонента (4) в ACT-R находятся на правильном пути.

Были собраны различные доказательства, показывающие, что качественные, а также количественные прогнозы модели поиска в ACT-R оправданы. Андерсон (1991) и Андерсон и Лебьер (1998) представляют подтверждающие данные из общих когнитивных задач (независимо от языка). В психолингвистике Льюис и соавт. (2006), Jäger et al. (2017 г.); Ягер и др. (2020), среди прочего, обобщают доказательства того, что по крайней мере некоторые случаи поиска зависимостей можно смоделировать как случай поиска ACT-R.

В психолингвистике Льюис и соавт. (2006), Jäger et al. (2017 г.); Ягер и др. (2020), среди прочего, обобщают доказательства того, что по крайней мере некоторые случаи поиска зависимостей можно смоделировать как случай поиска ACT-R.

Целью этой статьи является применение модели поиска и памяти ACT-R к новой области. Мы исследуем, как рациональная теория памяти может моделировать синтаксический анализ знаний и как модель синтаксического анализа может быть встроена в ACT-R. Мы покажем, что если рассматривать шаги синтаксического анализа как фрагменты декларативной памяти, извлечение которых управляется теми же правилами, что и другие элементы памяти, модель памяти ACT-R становится непосредственно применимой к синтаксическому анализу. Активация, связанная с извлеченными этапами синтаксического анализа, может затем использоваться для моделирования влияния контекста на процессинг, например, исследования, которые в основном являются областью психолингвистических теорий синтаксического анализа, таких как теория неожиданностей (Hale, 2001). В той мере, в какой результирующая модель синтаксического анализа делает правильные количественные и качественные прогнозы, мы строим доказательства того, что к трудностям обработки, наблюдаемым во время синтаксического анализа, можно подойти с точки зрения рациональной теории памяти. Гипотеза, изучаемая в этой статье, дополнительно исследуется в Dotlačil (принято) 3 , в котором также изучается, как отдельные компоненты системы поиска ACT-R влияют на поиск шагов синтаксического анализа и как поиск знаний синтаксического анализа взаимодействует с поиском зависимостей в обработке.

В той мере, в какой результирующая модель синтаксического анализа делает правильные количественные и качественные прогнозы, мы строим доказательства того, что к трудностям обработки, наблюдаемым во время синтаксического анализа, можно подойти с точки зрения рациональной теории памяти. Гипотеза, изучаемая в этой статье, дополнительно исследуется в Dotlačil (принято) 3 , в котором также изучается, как отдельные компоненты системы поиска ACT-R влияют на поиск шагов синтаксического анализа и как поиск знаний синтаксического анализа взаимодействует с поиском зависимостей в обработке.

В разделе 3 мы вводим синтаксический анализ на основе переходов и показываем, как такие синтаксические анализаторы могут быть созданы на примере декларативной памяти в ACT-R. В разделе 4 мы показываем, как модель может быть связана с данными о времени реакции, и оцениваем ее качественные и количественные прогнозы.

3. Синтаксический анализ на основе переходов

Мы вводим синтаксические анализаторы на основе переходов и показываем, что они могут быть в значительной степени встроены в ACT-R и объединены со структурами памяти, обсуждаемыми в разделе 2. Такая комбинация напрямую обеспечивает поведенческие анализы. предсказания, которые будут проверены в следующих разделах.

Такая комбинация напрямую обеспечивает поведенческие анализы. предсказания, которые будут проверены в следующих разделах.

Синтаксические анализаторы на основе переходов — это системы синтаксического анализа, которые предсказывают переходы из одного состояния в другое в соответствии с решениями, принятыми классификатором. Поскольку классификатор играет решающую роль в парсерах этого типа, эти парсеры также называются парсерами на основе классификаторов.

Синтаксические анализаторы на основе переходов чаще всего реализуются для грамматик зависимостей и, возможно, они наиболее успешны и широко распространены при построении графов зависимостей (Nivre et al., 2007). Однако они также применялись для синтаксического анализа фраз (Kalt, 2004; Sagae, Lavie, 2005; Liu, Zhang, 2017; Китаев, Клейн, 2018, и др.). В этой статье также разрабатывается синтаксический анализатор, основанный на переходе структуры фразы. Мы представляем вариант алгоритма синтаксического анализа на основе перехода, основанный на сдвиге, который, возможно, является наиболее распространенным типом синтаксического анализатора на основе перехода для структур фраз, и показываем, как его можно понять с точки зрения систем памяти, обсуждавшихся в предыдущем разделе.

3.1. Алгоритм синтаксического анализа фразовой структуры на основе переходов

Алгоритм синтаксического анализа работает с двумя базами данных, стеком построенных деревьев S и стеком предстоящих слов с их POS (тегами части речи) W. Когда начинается синтаксический анализ, S пусто, а W переносит следующие слова по мере их появления в предложении, так что первое слово появляется в начале стека, за ним следует второе слово и т. д.

Разбор продолжается путем выбора действий на основе содержимого S и W Каждый шаг разбора P является функцией от S,W до действий A, то есть P:S×W↝A. В рассматриваемом нами варианте парсера есть три действия, которые может выбрать парсер:

• сдвиг

• уменьшение

• постулат пробел

Первое действие, сдвиг , извлекает верхний элемент из стека W и помещает его как тривиальное дерево в стек S. Элементом в W является пара 〈 слово, POS〉, дерево, перемещенное в стек, представляет собой просто тег POS с терминалом, являющимся фактическим словом.

Второе действие, reduce

, извлекает верхний элемент (если редукция унарная) или два верхних элемента (если редукция бинарная) из стека построенных деревьев S и создает новое дерево. Если редукция является унарной, новое дерево имеет только одну дочернюю структуру под корнем, дерево, которое только что было извлечено из стека. Если редукция бинарная, то у вновь созданного дерева есть две дочери, два дерева, которые только что были извлечены из стека. В любом случае вновь построенное дерево помещается на вершину стека S. Предполагается, что все деревья не более чем двоичные, поэтому никаких дальнейших сокращений, кроме двоичных, не требуется. Наконец, третье действие, постулирует пробел , постулирует пробел и разрешает его в его антецедент. Не каждый синтаксический анализатор в компьютерной лингвистике предполагает это действие, т. е. реализованные синтаксические анализаторы могут работать только путем сдвига и сокращения (но см. Crabbé, 2015; Coavoux and Crabbé, 2017a,b в качестве примеров синтаксических анализаторов на основе переходов, которые учитывают разрешение пробелов).

Есть несколько ограничений на три действия. Во-первых, сдвиг не может быть применен, когда W пусто. Когда S пуст, никакое сокращение не может быть применено, а когда оно имеет только одно дерево, двоичное сокращение не может быть применено. Наконец, между двумя сменами может быть применено не более двух действий по пропуску постулатов. Это последнее ограничение гарантирует, что система не впадет в бесконечный регресс постулирования разрыва.

Проиллюстрируем шаги парсера shift-reduce на простом примере: парсинг мальчик танцует . Структура фразы показана на рис. 1, а шаги синтаксического анализа:

Рисунок 1 . Фраза мальчик танцует .

В этом иллюстративном примере мы предполагаем, что синтаксический анализатор знает, какова правильная структура фразы, и проводит синтаксический анализ в направлении этой структуры. Конечно, ключевой вопрос заключается в том, что происходит, когда структура фразы неизвестна и синтаксический анализатор должен предсказать, какое действие следует предпринять. Это обсуждается в следующем разделе.

Конечно, ключевой вопрос заключается в том, что происходит, когда структура фразы неизвестна и синтаксический анализатор должен предсказать, какое действие следует предпринять. Это обсуждается в следующем разделе.

3.2. Шаги синтаксического анализа как извлечения памяти

На этапе синтаксического анализа необходимо решить, какое действие (среди сдвиг, уменьшение и пробел постулата ) должно быть выполнено, и, если выбрано сокращение , как должно быть выполнено сокращение: следует оно должно быть унарным или бинарным, и какой должна быть корневая метка вновь построенного дерева?

Мы исследуем гипотезу о том, что этап синтаксического анализа можно рассматривать как случай извлечения из памяти. Прошлые шаги синтаксического анализа формируют декларативную память синтаксического анализатора. Синтаксический анализатор извлекает из памяти шаг (или шаги) синтаксического анализа, который имеет наибольшую вероятность того, что он потребуется для текущей цели. Текущая цель, в свою очередь, состоит в разборе предложения. С этой точки зрения синтаксический анализ — это всего лишь конкретная реализация рациональной теории памяти, которая может быть встроена в ACT-R. Активация шага синтаксического анализа, т. е. логарифмическая вероятность того, что шаг необходим, вычисляется из компонента истории и компонента контекста. Первый выводится из времени, прошедшего с момента использования и повторного использования шага, последний рассчитывается на основе сигналов в текущем контексте и распространения активации от этих сигналов на фрагменты в декларативной памяти.

Текущая цель, в свою очередь, состоит в разборе предложения. С этой точки зрения синтаксический анализ — это всего лишь конкретная реализация рациональной теории памяти, которая может быть встроена в ACT-R. Активация шага синтаксического анализа, т. е. логарифмическая вероятность того, что шаг необходим, вычисляется из компонента истории и компонента контекста. Первый выводится из времени, прошедшего с момента использования и повторного использования шага, последний рассчитывается на основе сигналов в текущем контексте и распространения активации от этих сигналов на фрагменты в декларативной памяти.

Хотя контекст можно рассматривать как полные деревья в S и всю информацию в W, мы значительно ограничим объем информации в двух базах данных. Будем предполагать, что S и W несут только некоторые признаки деревьев и предстоящих слов, перечисленных в (17). Таким образом, сам синтаксический анализатор никогда не имеет полного снимка структуры фразы, которую он выводит. Он несет только минимальную локальную информацию. Структуру фразы всегда можно реконструировать с помощью шагов синтаксического анализа, предпринятых агентом ACT-R (и, возможно, людьми), но не существует единого снимка, в котором вся информация доступна агенту. Эта позиция распространена при анализе ACT-R, см., например, Lewis and Vasishth (2005).

Структуру фразы всегда можно реконструировать с помощью шагов синтаксического анализа, предпринятых агентом ACT-R (и, возможно, людьми), но не существует единого снимка, в котором вся информация доступна агенту. Эта позиция распространена при анализе ACT-R, см., например, Lewis and Vasishth (2005).

Признаки должны быть знакомы, возможно, за исключением лексического заголовка. Голова — это терминал, который проецирует свою фразу (глагол — это голова глагольной фразы, существительное — голова именной фразы и т. д.; см. Collins, 1997 о проекции головы в вычислительных синтаксических анализаторах, которым следует эта работа).