Морфемный разбор слова | 5 класс | Русский язык

Содержание

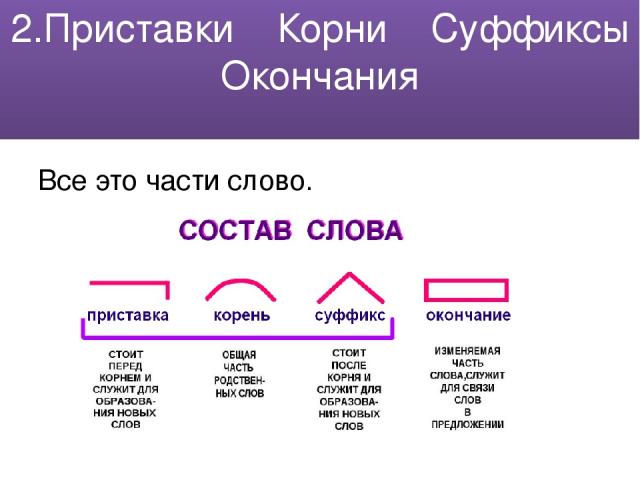

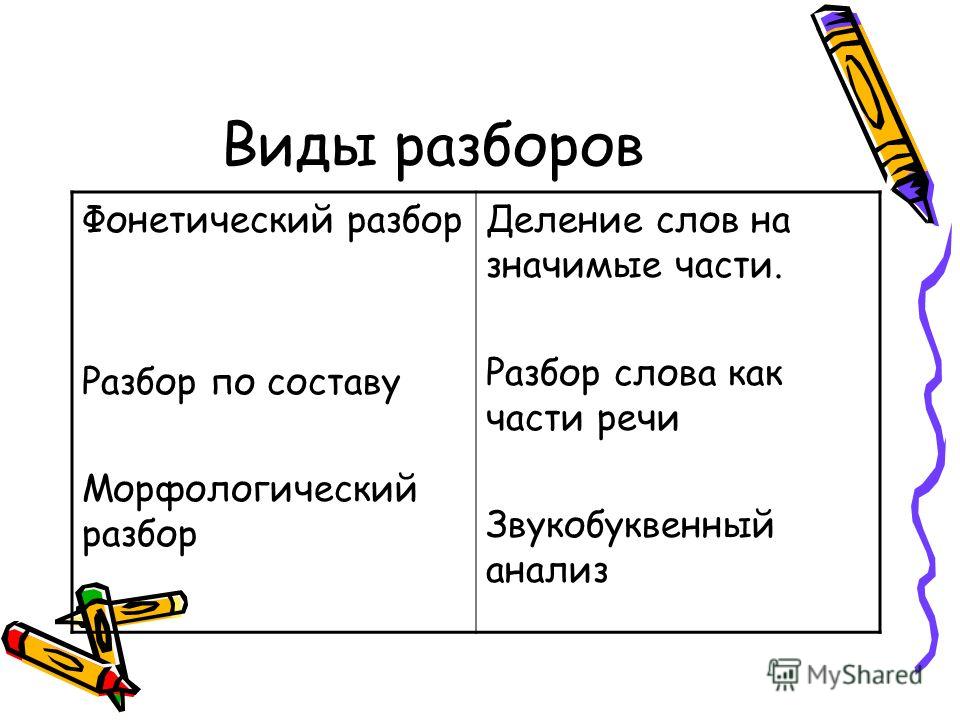

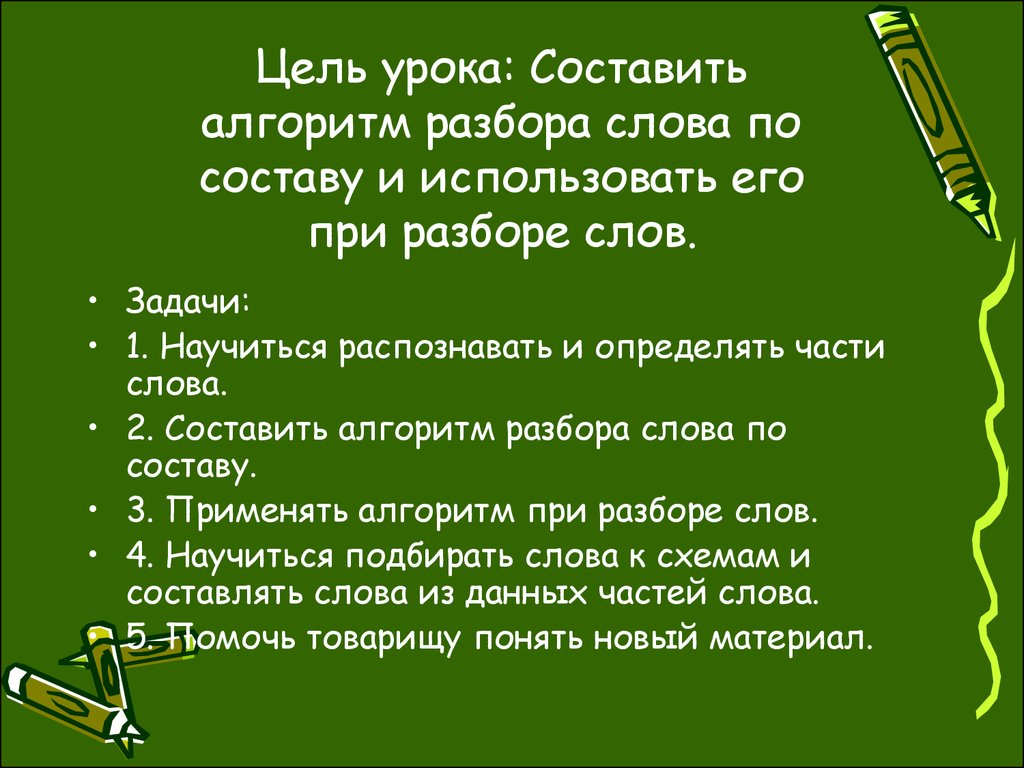

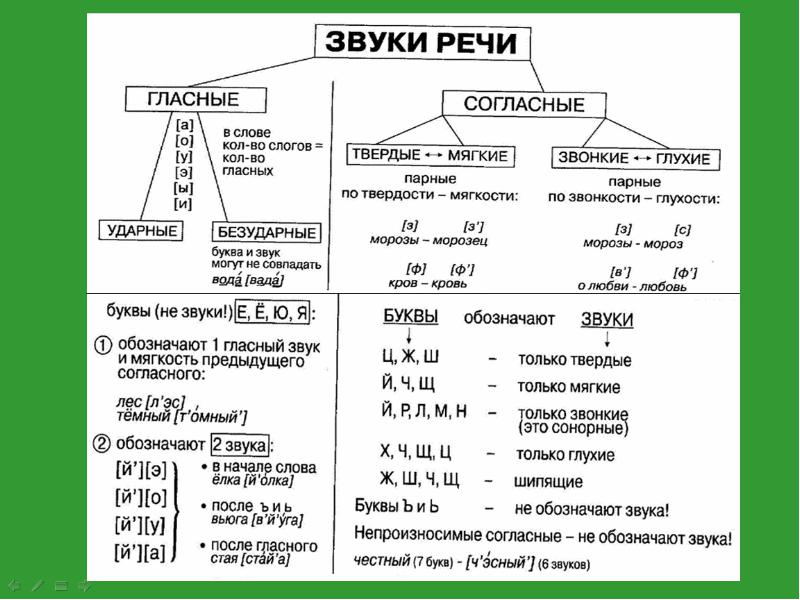

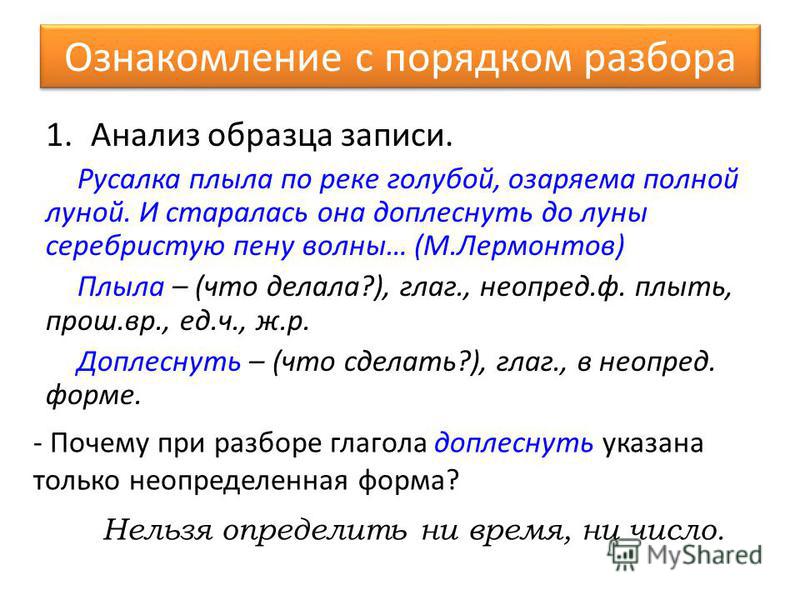

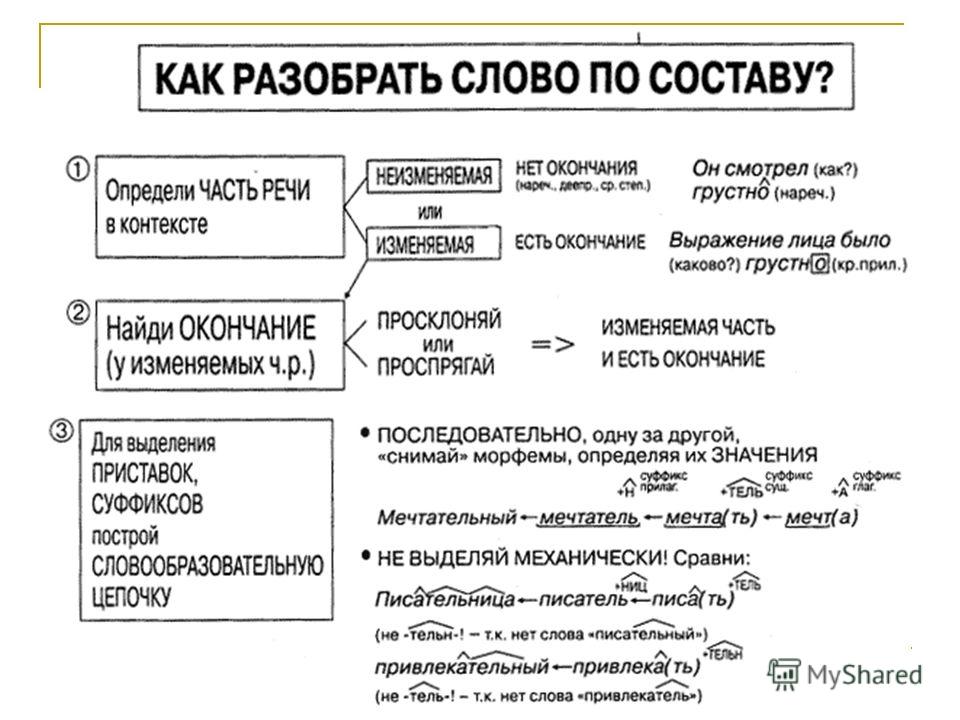

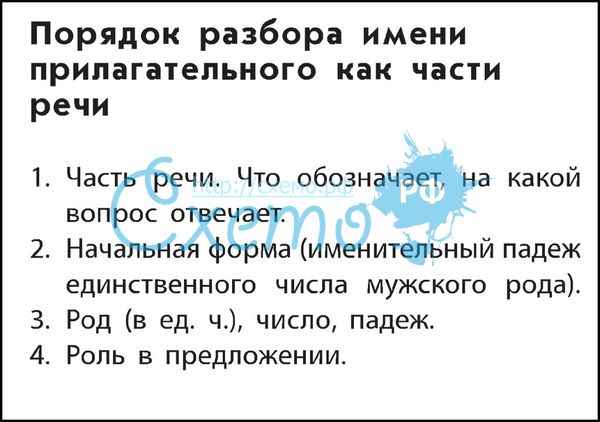

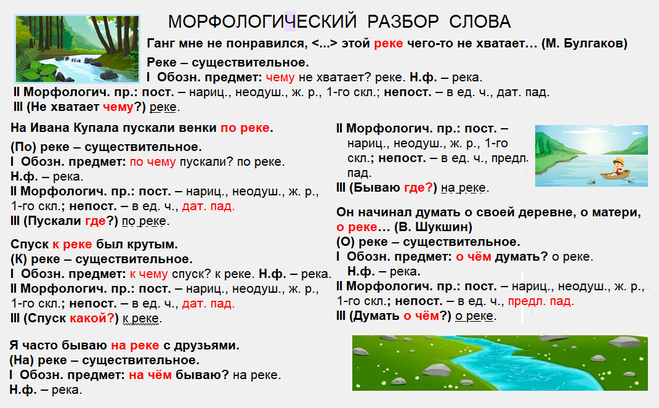

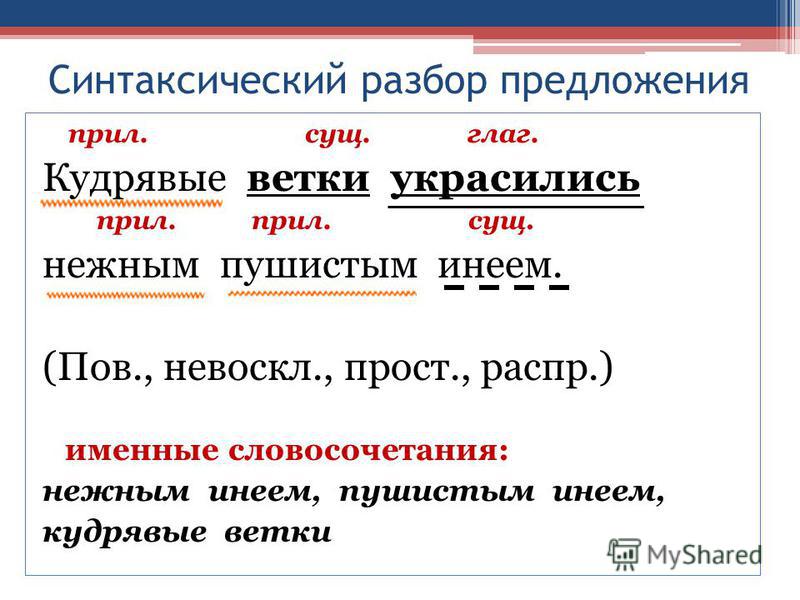

Наш язык состоит из уровней: фонетического, морфемного, морфологического, лексического и синтаксического. И для каждого из этих уровней предусмотрен определенный вид анализа структурных элементов этого уровня. Так, вы уже знакомы с фонетическим разбором. С его помощью мы анализируем состав звуков и букв слов. Но сейчас вы уже хорошо знаете и более крупные единицы – морфемы. Поэтому пришло время провести морфемный разбор слова.

Что мы уже знаем о морфемах?Для начала давайте кратко вспомним всё, что мы изучали на последних уроках.

Но сперва еще раз отметим, что морфемы – это минимальные значимые части слова. А это значит, что все они несут в себе определенное значение, смысл.

Это значение может быть грамматическим, то есть морфема нужна для того, чтобы передать принадлежность слова к какой-либо грамматической категории.

Например, суффикс -лив- используется, чтобы передать принадлежность слова к категории прилагательных.

А еще значение может быть смысловым, то есть морфема используется для передачи или уточнения какого-либо смысла.

Например, приставка в- (входить) используется, чтобы показать движение внутрь, а приставка вы- (выходить) – чтобы показать действие наружу.

Функции морфемы{"questions":[{"content":"Соедините слово и значение морфемы в этом слове.[[matcher-1]]","widgets":{"matcher-1":{"type":"matcher","labels":["Окончание показывает множественное число","Окончание – показатель среднего рода","Приставка со значением близкого расположения к чему-либо","Суффикс указывает на свойство или качество предмета"],"items":["плод-ы","зерн-о","при-брежный","свеж-есть"]}},"step":1,"hints":["Показателем множественного числа может быть окончание -ы.","Показатели среднего рода – окончания -о, -е. ","Приставка при- может обозначать близкое расположение чего-то к чему-либо.","Суффиксы, обозначающие свойства или качества: -есть-, -от-, -изн-."]}]}

","Приставка при- может обозначать близкое расположение чего-то к чему-либо.","Суффиксы, обозначающие свойства или качества: -есть-, -от-, -изн-."]}]}Итак, приступим к обобщению изученного.

Приставка, корень, суффикс

И начнем с приставки.

Приставка

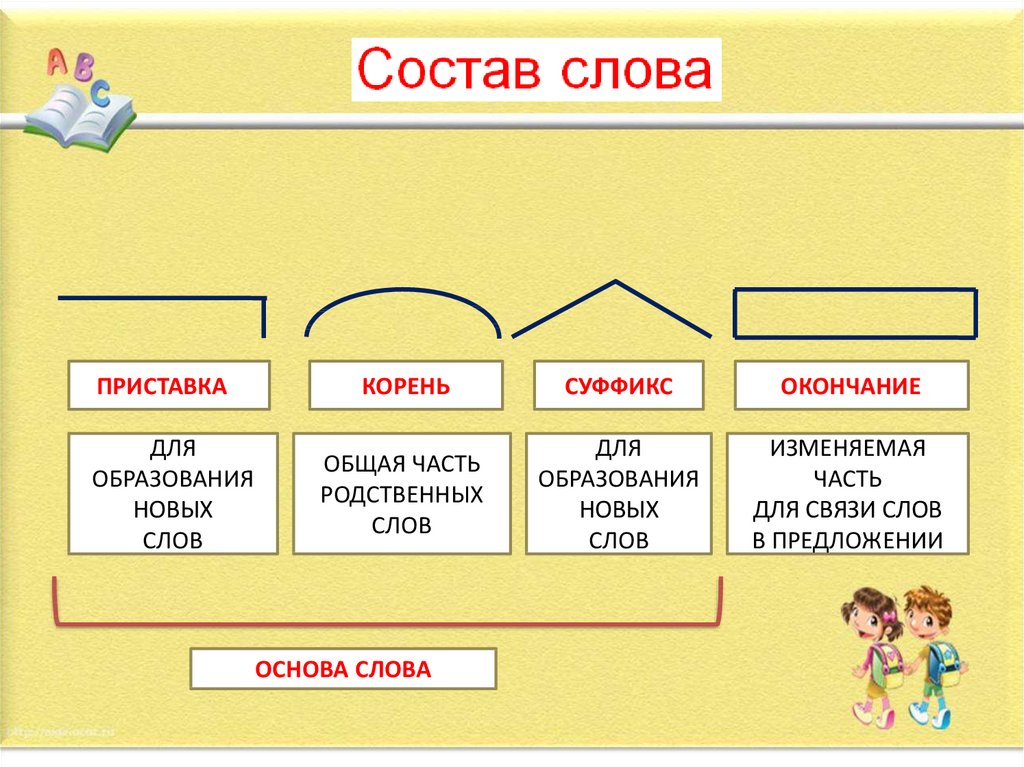

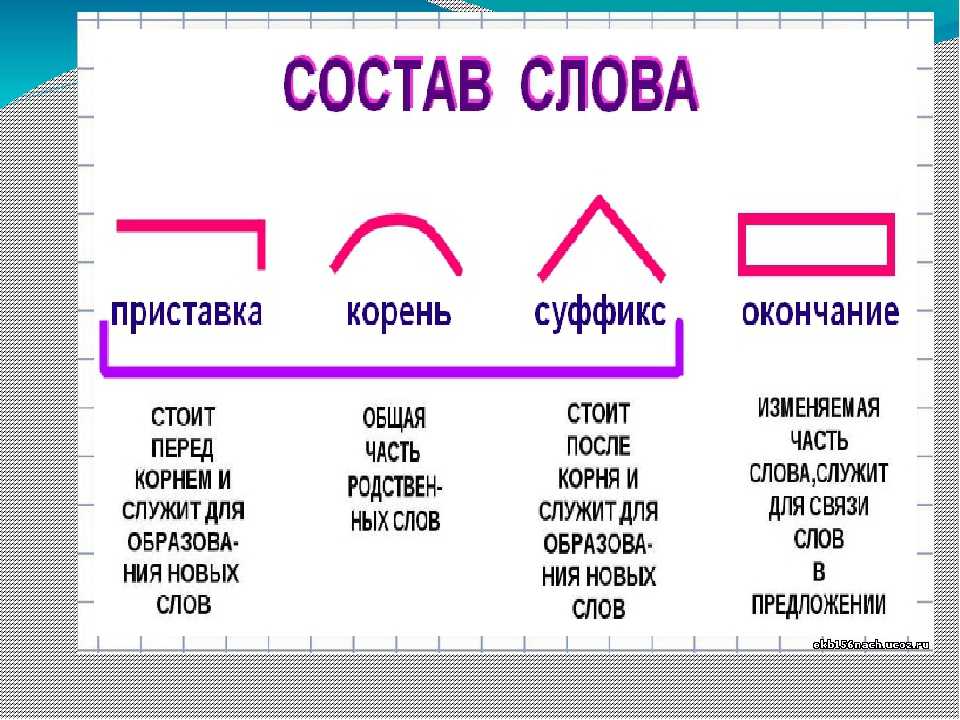

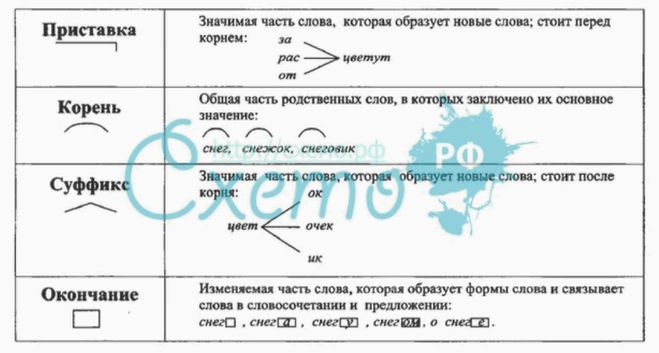

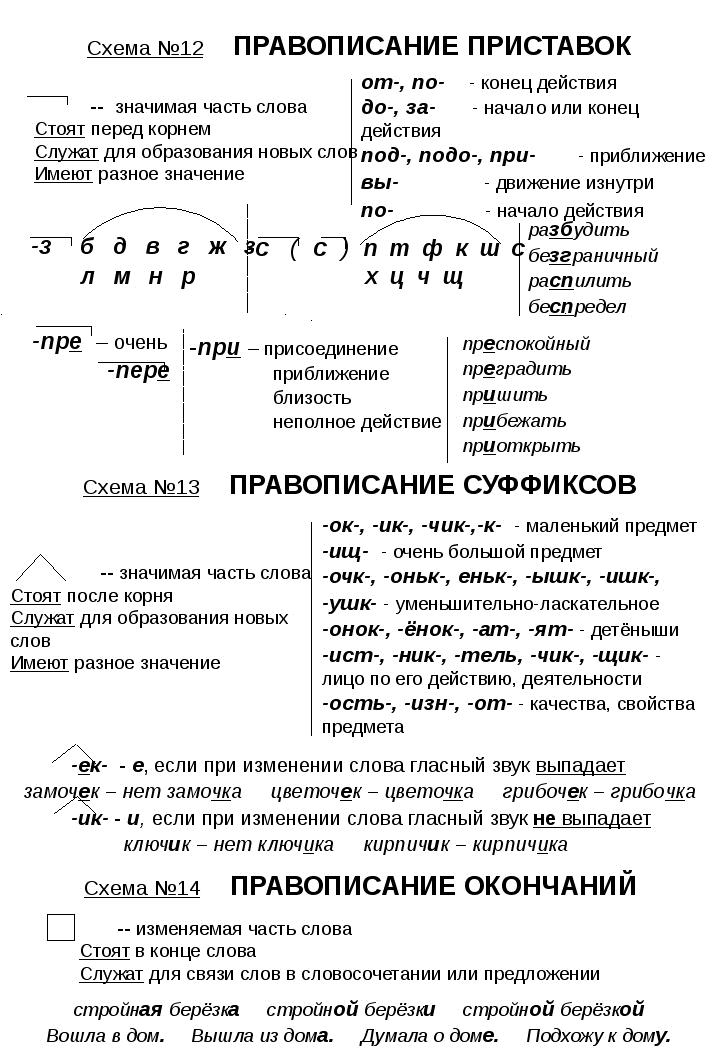

Как вы помните, приставка – это значимая часть слова, которая стоит перед корнем и служит для образования новых слов той же части речи.

Одна из главных особенностей приставки заключается в том, что она присоединяется ко всему слову в целом и придает ему новый оттенок смысла. Поэтому приставки несут только смысловые значения. То есть они уточняют значение корня. Грамматические же значения приставками не выражаются.

Свойства приставки{"questions":[{"content":"Выберите верные утверждения.[[choice-1]]","widgets":{"choice-1":{"type":"choice","options":["Приставка служит для образования однокоренного слова другой части речи. ","Приставка служит для уточнения смысла слова.","Приставка служит для образования однокоренного слова той же части речи.","Приставка выражает грамматические значения."],"explanations":["Приставка помогает образовать слова той же части речи, что и исходное слово.","Верно!","Верно!","Приставка уточняет смысл слова."],"answer":[1,2]}},"step":1,"hints":["Приставка служит для уточнения смысла слова.","Приставка служит для образования однокоренного слова той же части речи."]}]}

","Приставка служит для уточнения смысла слова.","Приставка служит для образования однокоренного слова той же части речи.","Приставка выражает грамматические значения."],"explanations":["Приставка помогает образовать слова той же части речи, что и исходное слово.","Верно!","Верно!","Приставка уточняет смысл слова."],"answer":[1,2]}},"step":1,"hints":["Приставка служит для уточнения смысла слова.","Приставка служит для образования однокоренного слова той же части речи."]}]}Корень

Самой главной морфемой слова является корень. Именно в нем заключается вся суть слова, его лексическое значение.

Мы с вами уже отмечали, что у однокоренных слов всегда есть общий элемент смысла. Так, например, все слова из ряда «снег – снежок – снежный – подснежник» связаны со снегом. Кроме того, корень самостоятелен. В отличие от других морфем он ни к чему не присоединяется и может существовать сам по себе.

Свойства корня{"questions":[{"content":"Сопоставьте корень и слово с этим корнем. [[grouper-1]]","widgets":{"grouper-1":{"type":"grouper","labels":["Берег","Дом","Боль"],"items":[["прибрежный","береговой","бережок","побережье"],["домашний","домище","одомашнить"],["больной","заболеть","больничный"]]}},"hints":["Обратите внимание на то, что звуки в корнях могут чередоваться."]}]}

[[grouper-1]]","widgets":{"grouper-1":{"type":"grouper","labels":["Берег","Дом","Боль"],"items":[["прибрежный","береговой","бережок","побережье"],["домашний","домище","одомашнить"],["больной","заболеть","больничный"]]}},"hints":["Обратите внимание на то, что звуки в корнях могут чередоваться."]}]}Суффикс

Следом за корнем может идти суффикс.

Суффикс – это значимая часть слова, которая стоит после корня и служит для образования новых слов другой части речи или для выражения определенного грамматического значения.

Давайте рассмотрим, как суффикс выражает грамматические значения.

Для этого возьмем, например, следующий ряд слов:

рука – ручка – ручной

Суффикс -к- в слове «ручка» образует уменьшительно-ласкательную форму слова «рука». При этом часть речи слова не изменяется. А вот в слове «ручной» суффикс -н- служит для образования новой части речи – прилагательного от существительного.

Более того, есть специальные суффиксы, служащие для образования конкретных частей речи. Например, суффиксы -ец-, -чик-, -щик- закреплены за существительными. Суффикс -лив- образует прилагательные.

Но суффиксы могут выражать не только грамматические, но и смысловые значения.

Так, суффикс -л- в глаголах выражает грамматическое значение прошедшего времени. А, например, суффикс -щик- может обозначать человека какой-либо профессии (пильщик, сварщик).

Также отметим, что суффикс присоединяется только к корню, а не к готовому слову.

Свойства суффикса{"questions":[{"content":"Сопоставьте свойство и морфему.[[grouper-1]]","widgets":{"grouper-1":{"type":"grouper","labels":["Приставка","Суффикс"],"items":[["стоит перед корнем","выражает только смысловое значение","присоединяется ко всему слову"],["стоит после корня","выражает грамматическое и смысловое значения","присоединяется к корню","может образовывать слова другой части речи"]]}},"step":1,"hints":["Приставка:

- стоит перед корнем;

- выражает только смысловое значение;

- присоединяется ко всему слову. ","Суффикс:

","Суффикс:

- стоит после корня;

- выражает грамматическое и смысловое значения;

- присоединяется к корню;

- может образовывать слова другой части речи."]}]}Основа и окончание

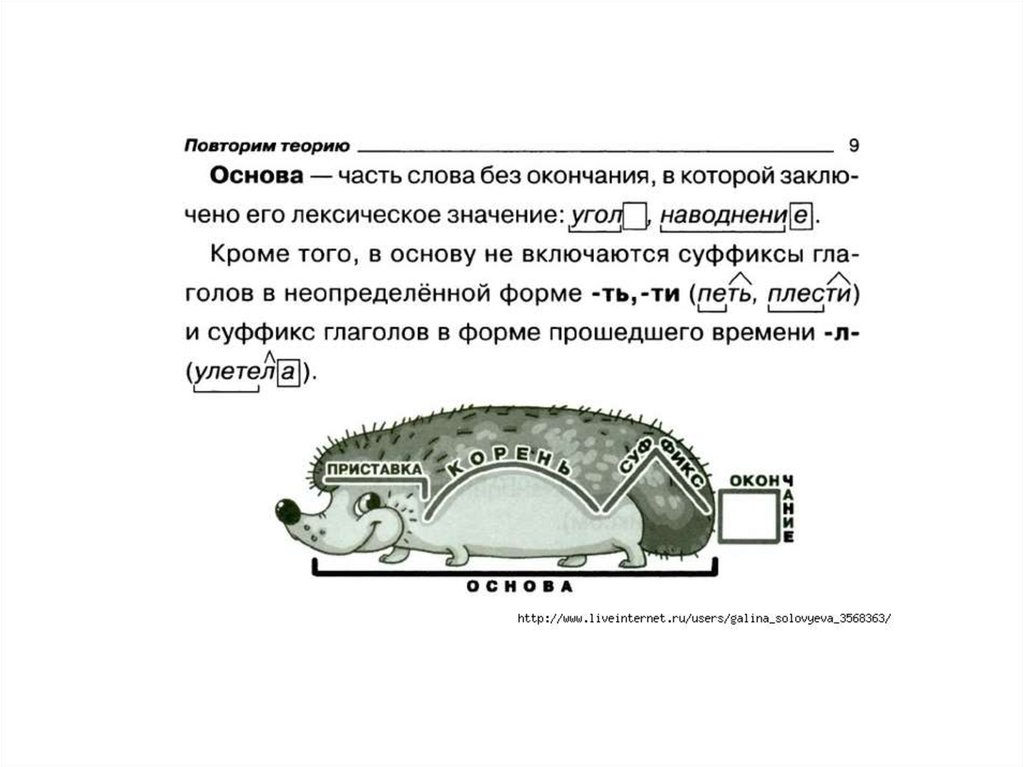

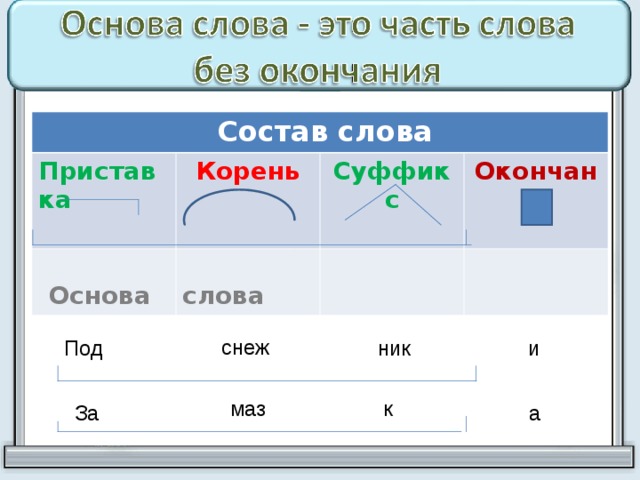

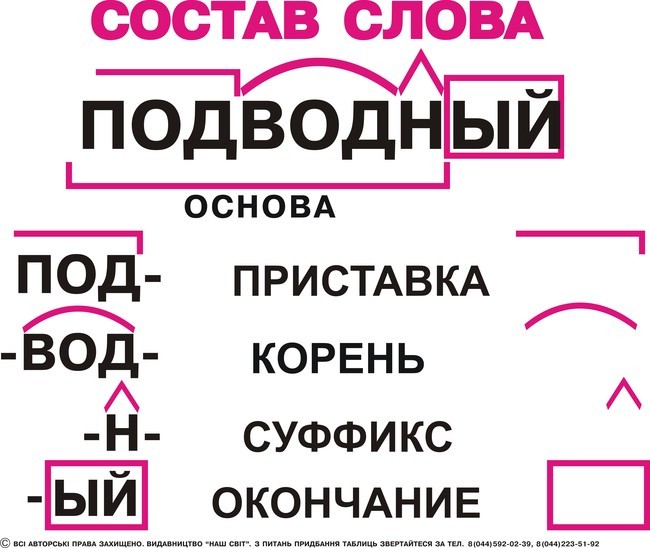

Основа словаВсе вышеуказанные морфемы – приставка, корень, суффикс – образуют основу слова. То есть его неизменяемую часть.

И, наконец, у нас осталась еще одна важная морфема, свойственная изменяемым словам, – окончание.

Окончание – это морфема, служащая для образования форм слова и выражения грамматических значений.

Давайте запомним, что окончания есть только у изменяемых слов. Так, у неизменяемых наречий окончания нет. Например, в наречии «тепло» конечное -о- является суффиксом, но не окончанием!

Но у окончаний есть особенность: они могут быть нулевыми. То есть при изменении слова окончание появляется, но в какой-то конкретной форме слова его нет. Это слова мужского рода второго склонения и женского рода третьего склонения (стол, ночь).

Это слова мужского рода второго склонения и женского рода третьего склонения (стол, ночь).

Окончания присоединяются к основе слова, не входя в нее, и служат для выражения грамматических значений.

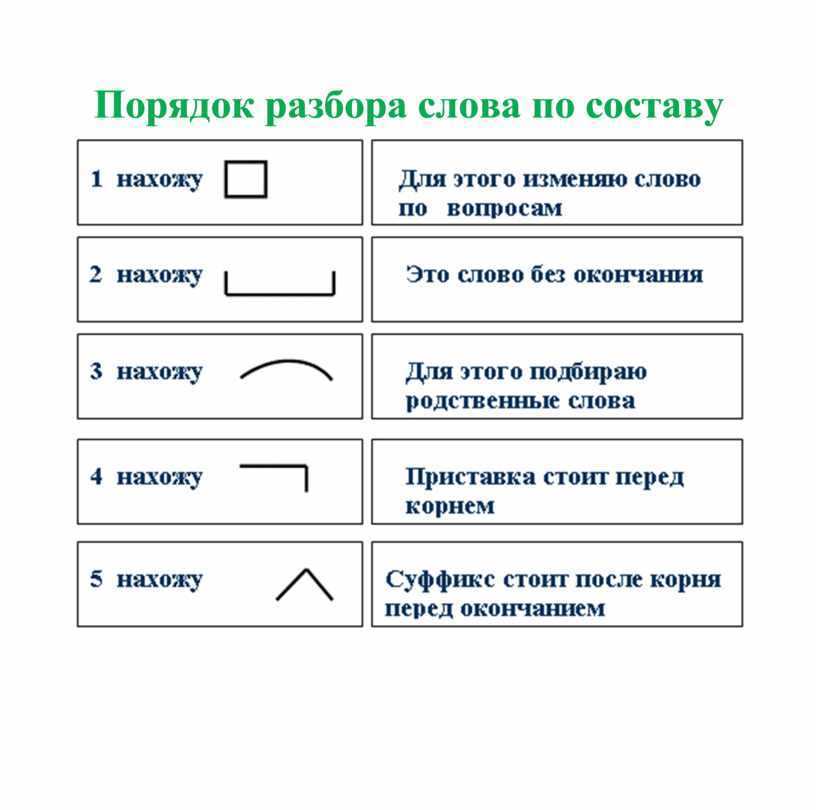

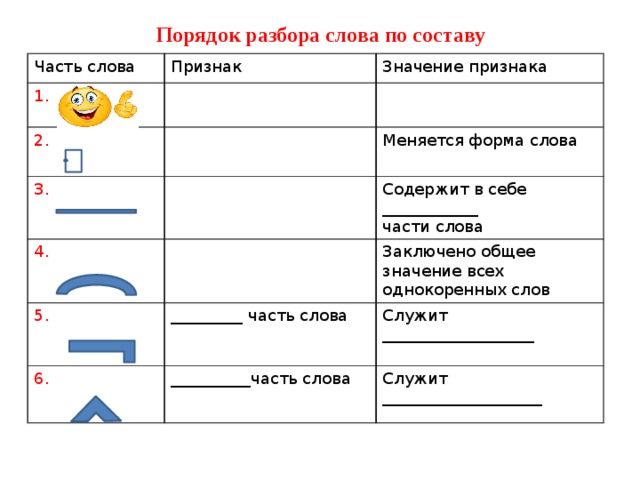

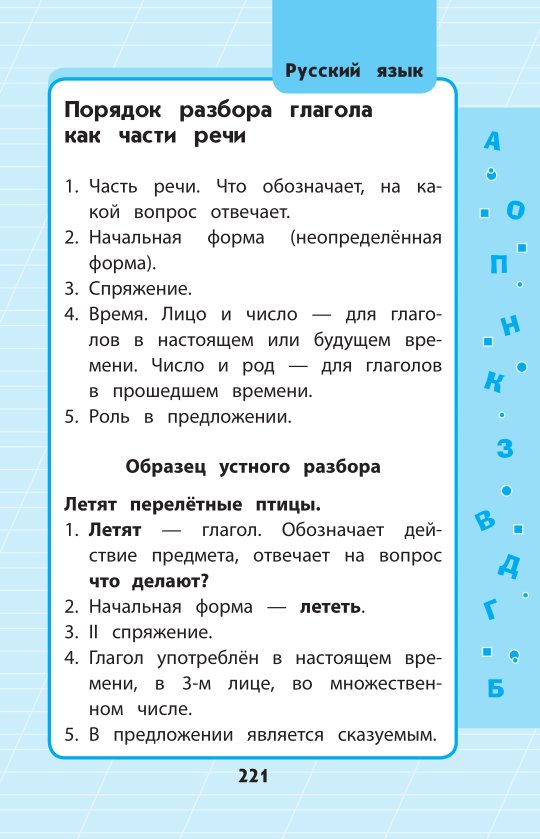

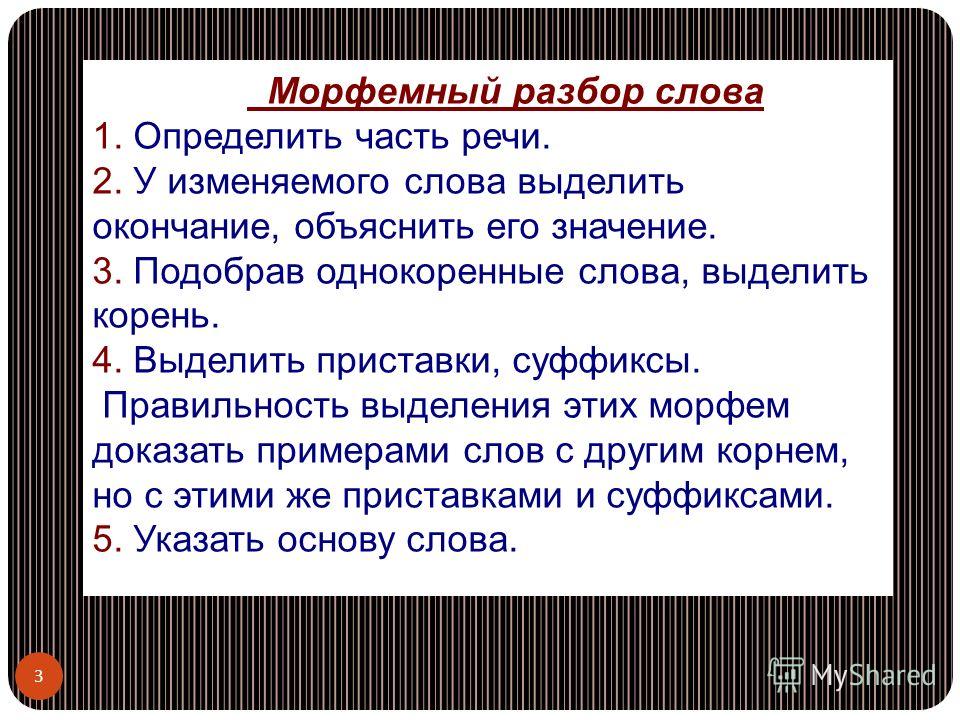

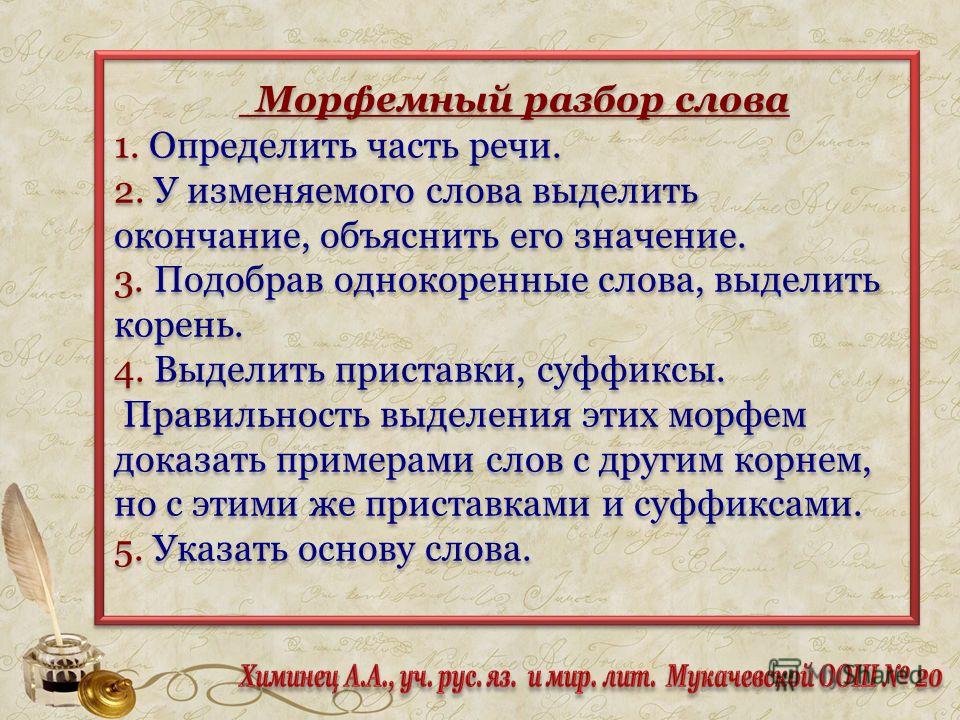

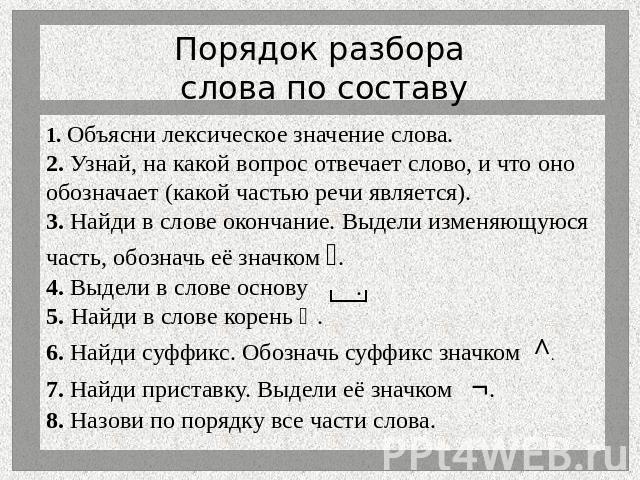

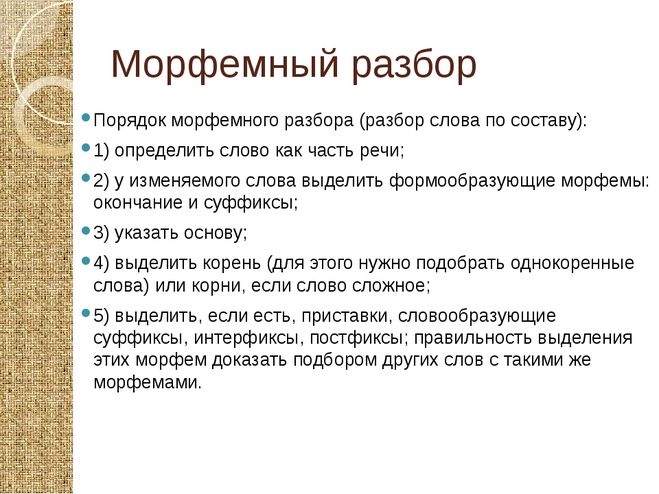

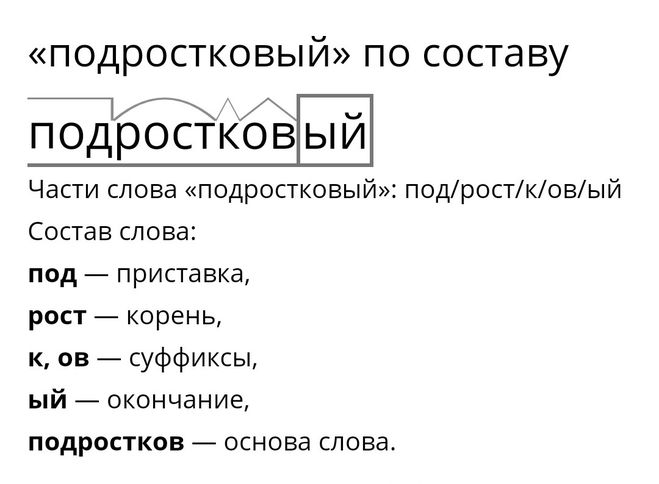

Свойства окончания{"questions":[{"content":"Распределите слова по группам.[[grouper-1]]","widgets":{"grouper-1":{"type":"grouper","labels":["Слова с выраженным окончанием","Слова с нулевым окончанием","Слова без окончания"],"items":[["столы","тетради"],["сон","ночь"],["светло","холодно"]]}},"step":1,"hints":["Слова с выраженным окончанием: столы, тетради.","Слова с нулевым окончанием: сон, ночь.","Слова без окончания: светло, холодно."]}]}Порядок морфемного разбора словаИтак, мы с вами вспомнили весь необходимый материал. И теперь пора приступить к морфемному разбору слова.

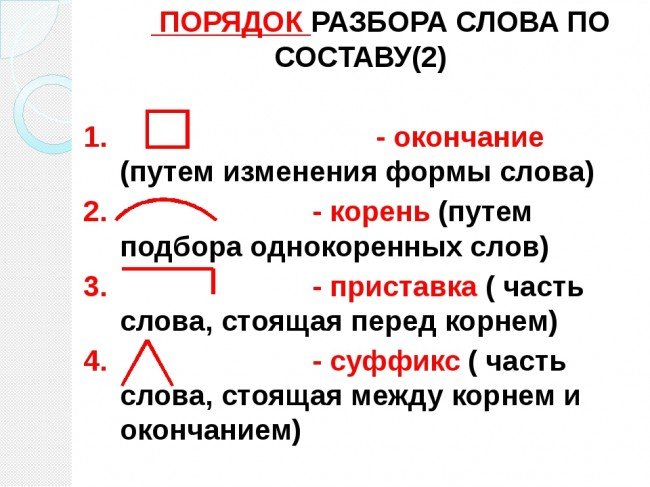

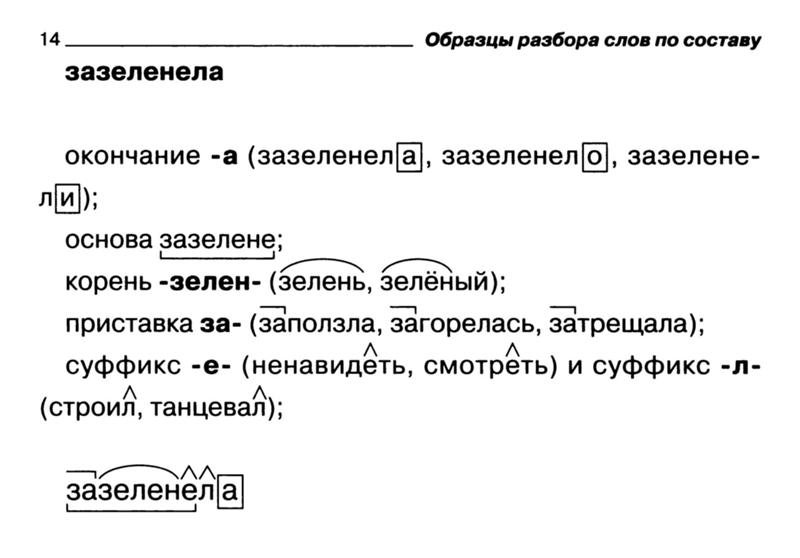

Традиционно в учебниках этот вид разбора обозначается цифрой 2 над словом, которое требуется проанализировать. Это выглядит вот так:

Мы почувствовали дуновение легкого морского ветерка2 с запада.

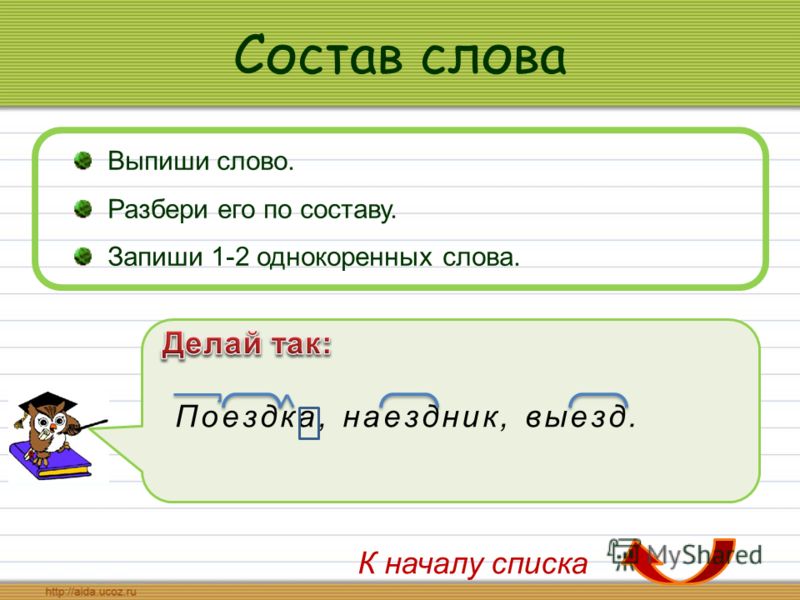

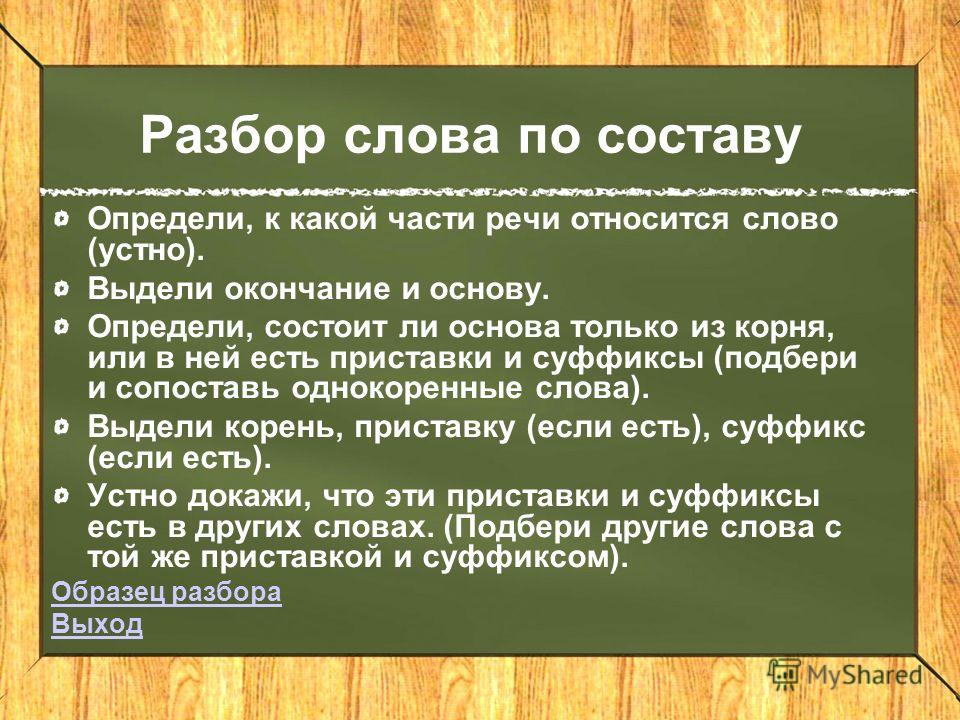

Итак, первое, что нам нужно запомнить: морфемный разбор проводится именно над той формой слова, в которой оно употребляется в тексте. Так, в нашем примере необходимо разобрать именно слово «ветерка», а не «ветерок» (в им.п.).

Поэтому первое, что мы делаем, — выписываем слово в той форме, в которой оно употреблено в предложении.

Ветерка

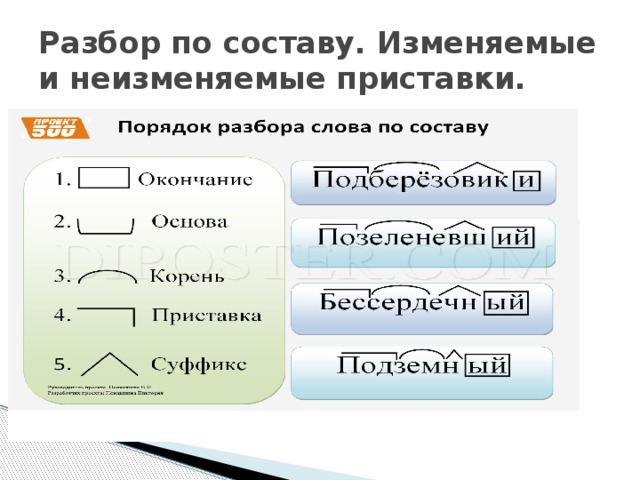

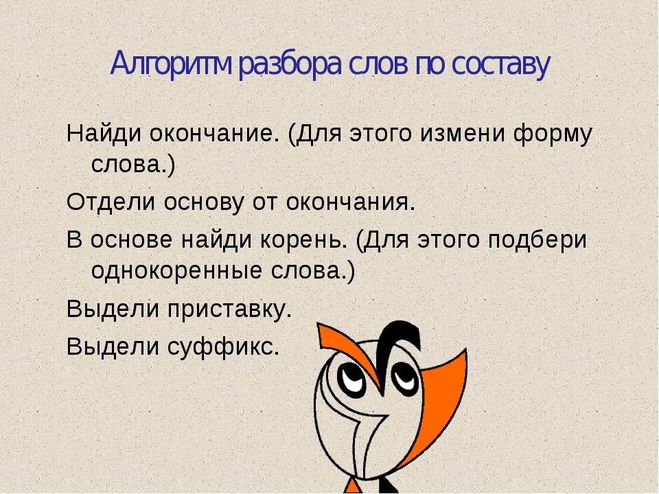

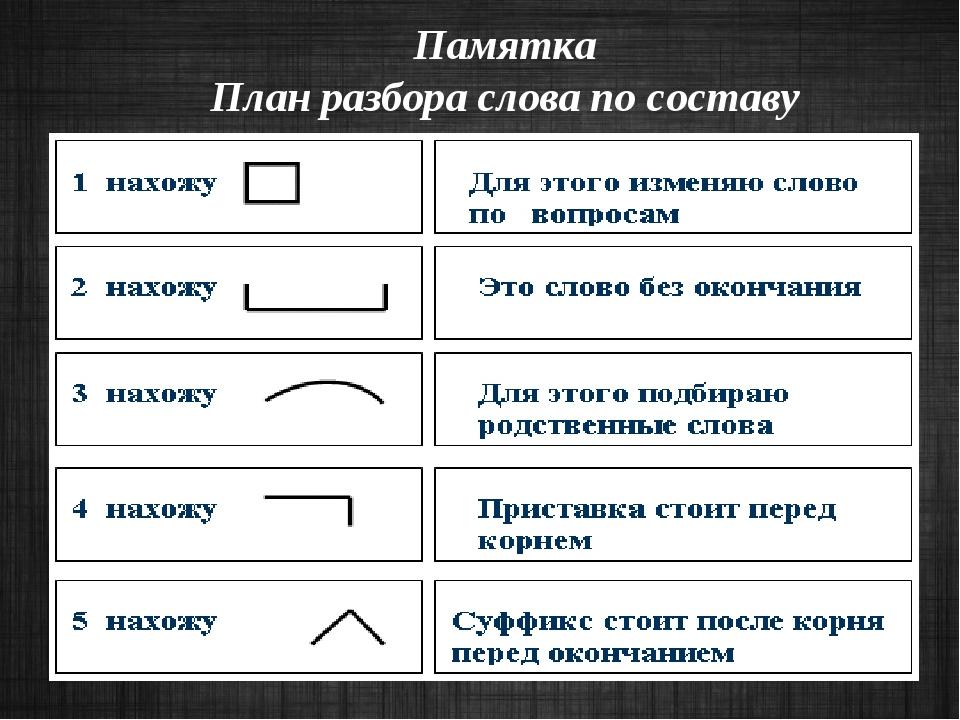

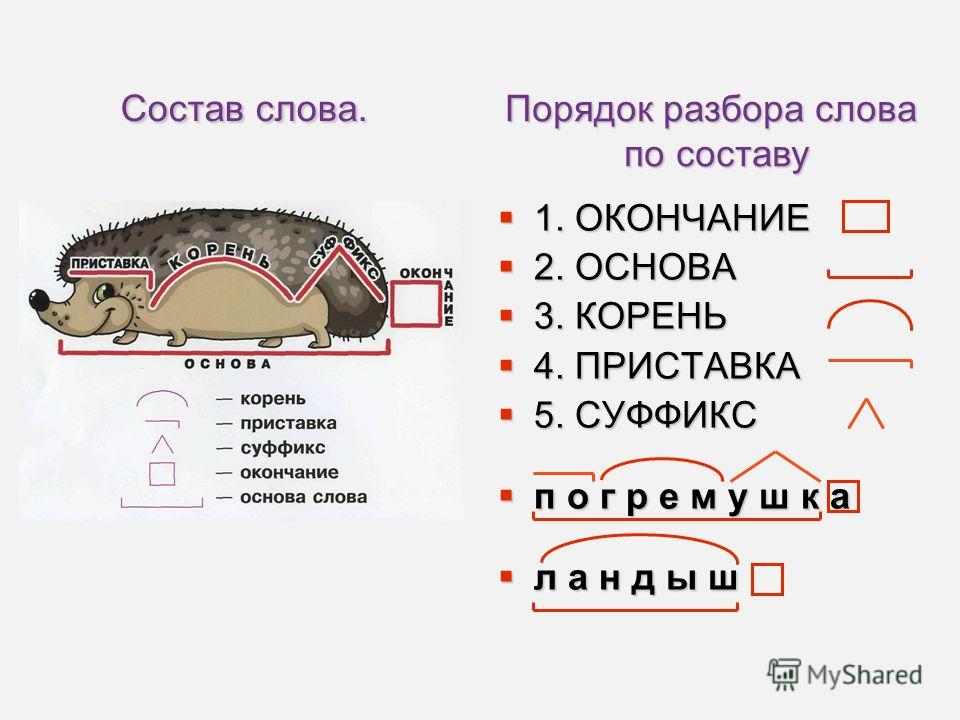

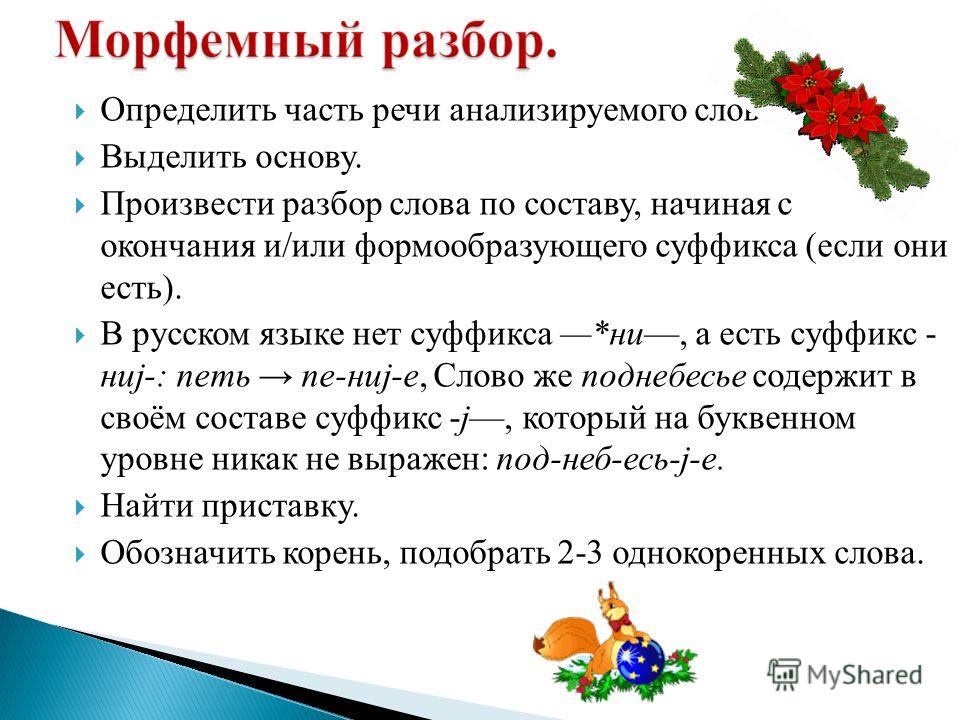

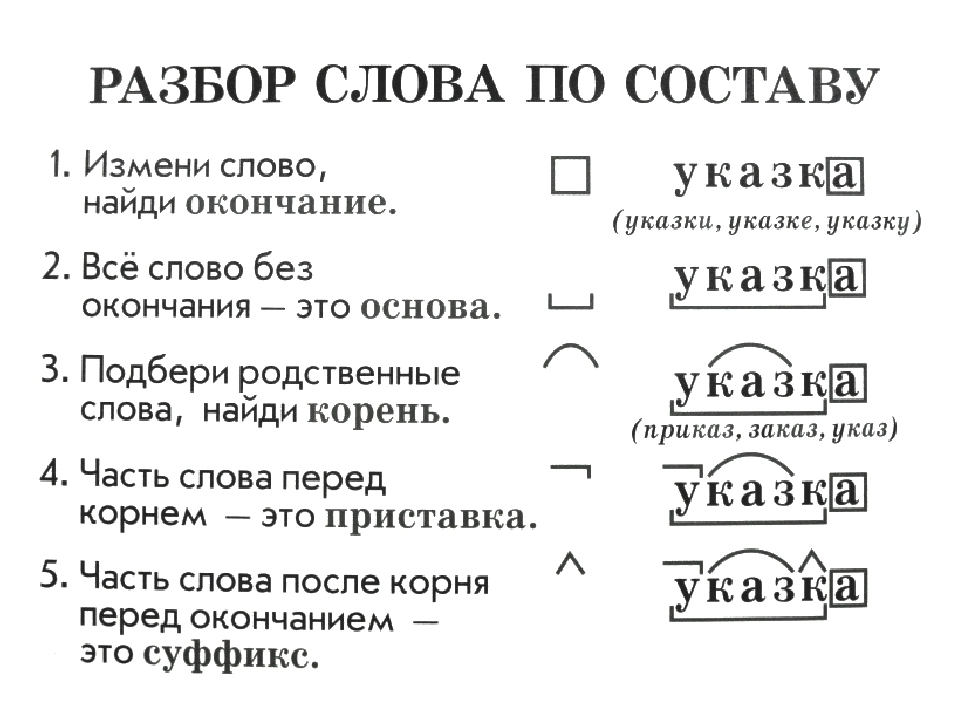

После того, как слово выписано, нам нужно выполнить следующие действия:

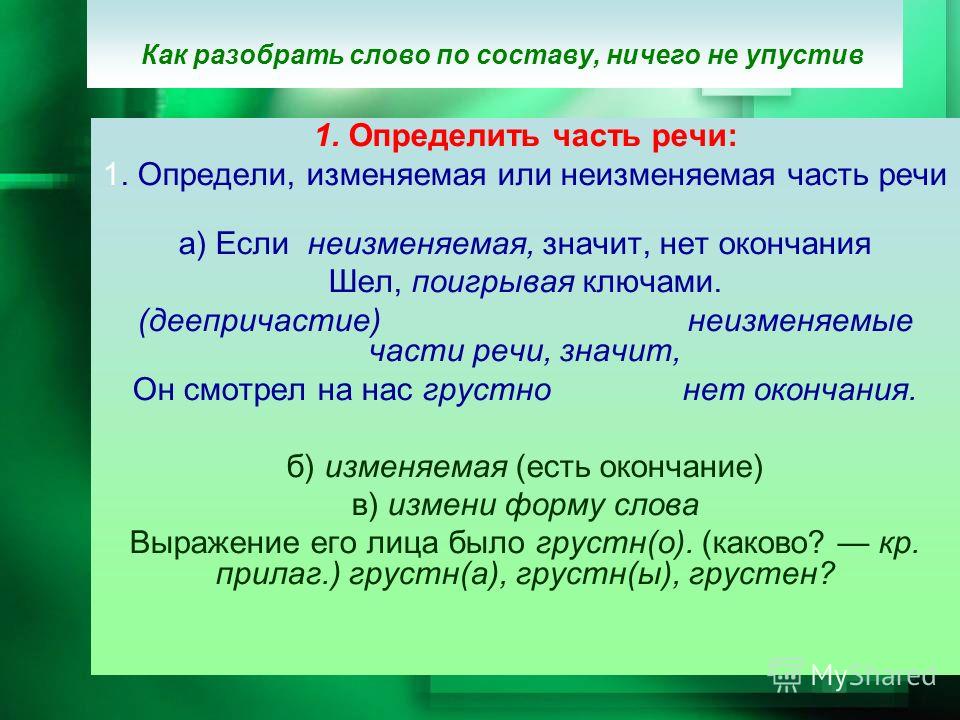

- Определить, изменяется ли слово. И если ответ положительный, то выделить окончание. Но помните, что оно может быть нулевым!

И затем мы устно проговариваем, что обозначает окончание. - Когда окончание отброшено, выделяем оставшуюся часть слова как основу.

- Устно подобрать однокоренные слова и определить их одинаковую часть – корень слова. Выделить его. Помните, что в корне слова могут встречаться чередования звуков! Если есть такие чередования, устно называем их.

- Между корнем и окончанием могут стоять суффиксы. Если они есть, выделяем их. Устно проговариваем их функцию (грамматическое или смысловое значение).

- Перед корнем может стоять приставка. Если она есть, выделяем ее. И также устно проговариваем ее функцию (смысловое значение).

А теперь давайте проведем морфемный разбор вместе. Выполняйте пункты плана сначала самостоятельно, а затем открывайте ответ.

Представим, что в учебнике вам попалось такое предложение:

Кора лесных великанов часто обрастает2 мхом и даже травою.

Мы видим, что в этом предложении над словом «обрастает» стоит цифра 2. Это сигнал, который говорит нам провести морфемный разбор этого слова.

Давайте выпишем его.

Показать ответ

Скрыть ответ

Выписываем в той же форме, как и в предложении:

обрастает

Выделяем окончание и основу

Теперь первое, что нам необходимо сделать, — выделить окончание. Чтобы правильно найти его, попробуем изменить слово, например, по числам.

Чтобы правильно найти его, попробуем изменить слово, например, по числам.

Показать ответ

Скрыть ответ

Обрастает – обрастают.

Видим, что -ет меняется на -ют. Значит, -ет – это окончание.

Выделяем окончание и вспоминаем, что оно должно нести какое-то грамматическое значение. Поэтому устно проговариваем это значение.

Показать ответ

Скрыть ответ

Окончание -ет показывает нам, что глагол стоит в форме 3-го лица единственного числа.

Итак, окончание и его значение мы нашли. Значит, все остальное – это основа слова. Выделим ее, и на этом этапе у нас получится вот такой результат:

Морфемный разбор слова «обрастает»Выделяем корень, суффикс и приставку

Теперь нам нужно выделить корень. Для этого найдем однокоренные слова.

Показать ответ

Скрыть ответ

Например: обрастает – растёт, растущий, растение и др.

Видим, что у всех слов повторяется часть -раст-, значит, это и есть наш корень. Выделим его.

Теперь между корнем и окончанием мы видим еще одну морфему – суффикс -а-. Выделим его и вспомним, что он тоже несет в себе определенное значение. И оно может быть как грамматическим, так и смысловым. Какое же значение помогает выразить суффикс -а-?

Показать ответ

Скрыть ответ

Здесь суффикс -а- помогает образовать глагол настоящего времени несовершенного вида. Это грамматическое значение.

И на этом этапе у нас осталась одна невыделенная морфема, которая стоит перед корнем. Это приставка об-! Выделим ее и подумаем, какой же оттенок смысла вносит в слово эта приставка?

Показать ответ

Скрыть ответ

Приставка об- в этом слове показывает, что действие совершается вокруг предмета. Сравните с подобными словами: облететь, обрисовать.

Вот и все! На этом наш морфемный разбор завершается. И письменно он выглядит так:

Морфемный разбор слова «обрастает»А теперь закрепите две наши последние темы, посмотрев видеоурок.

Очень простая инструкция для разбора слова по составу — Морфемный разбор в помощь второклашке | Блог КУМОНомамы

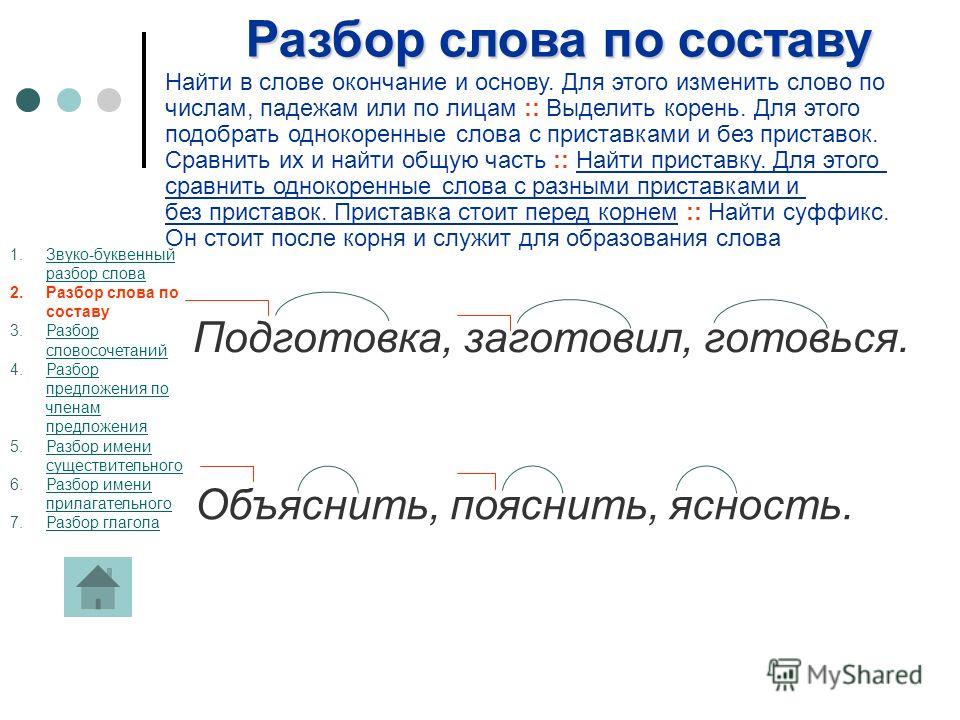

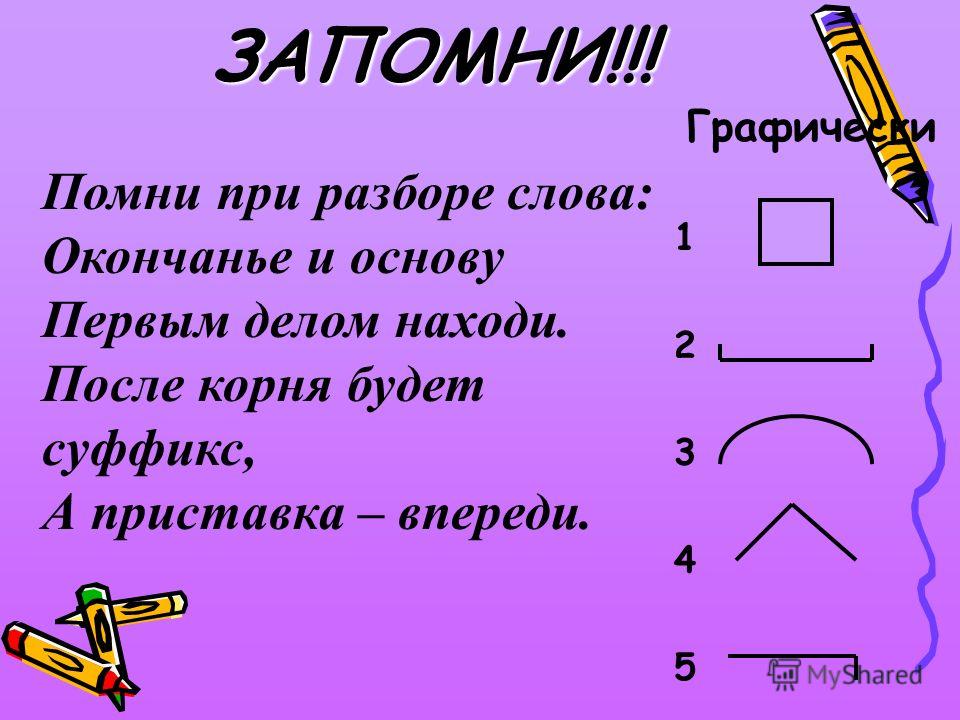

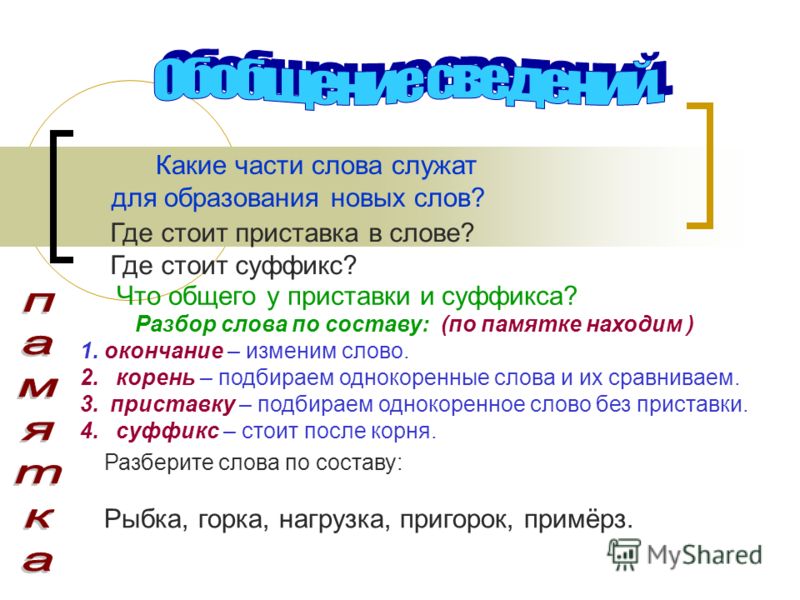

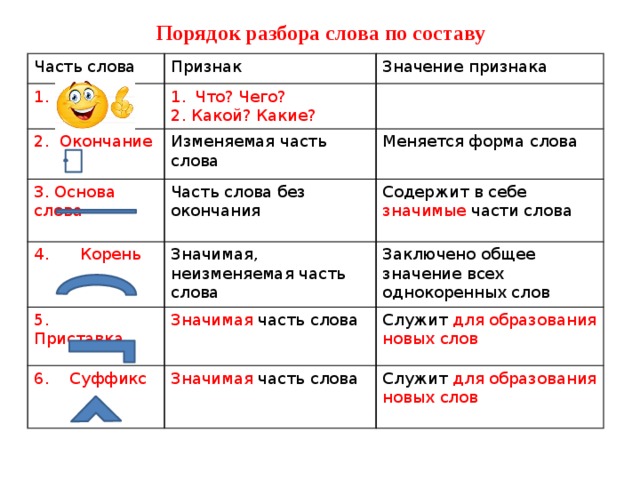

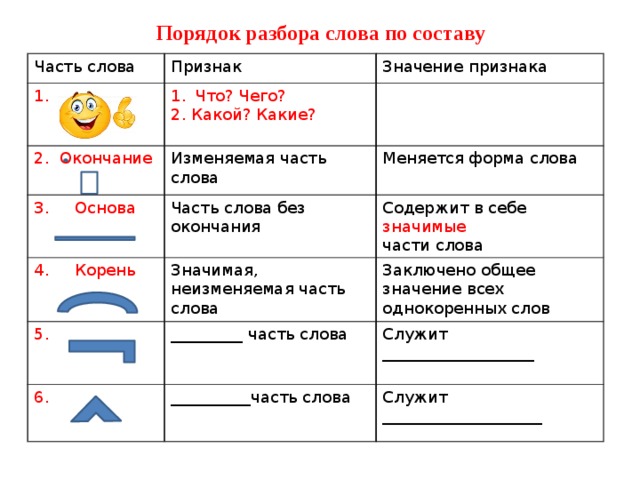

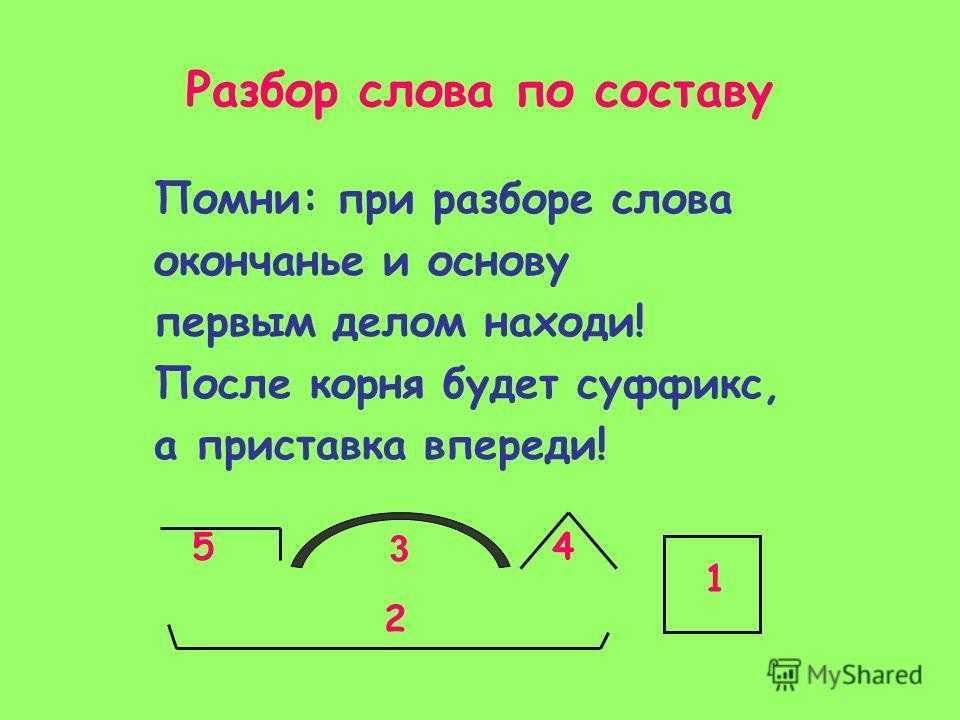

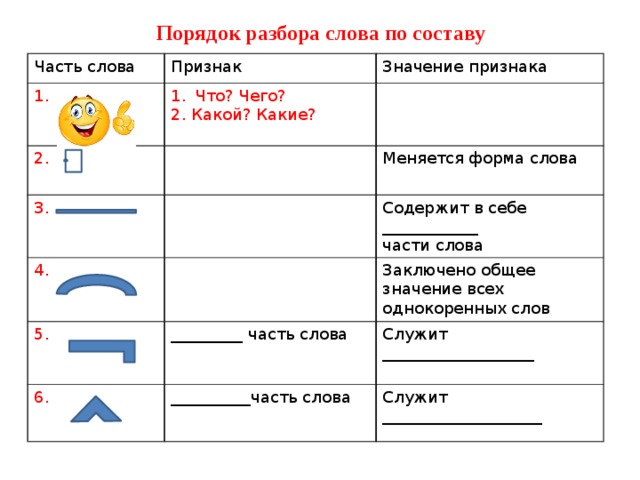

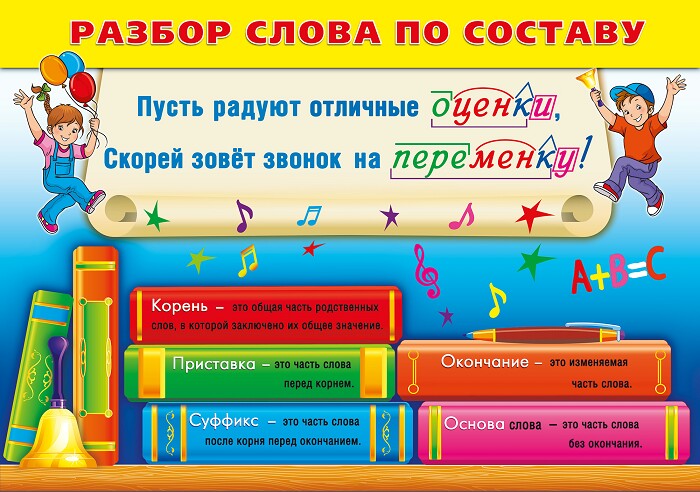

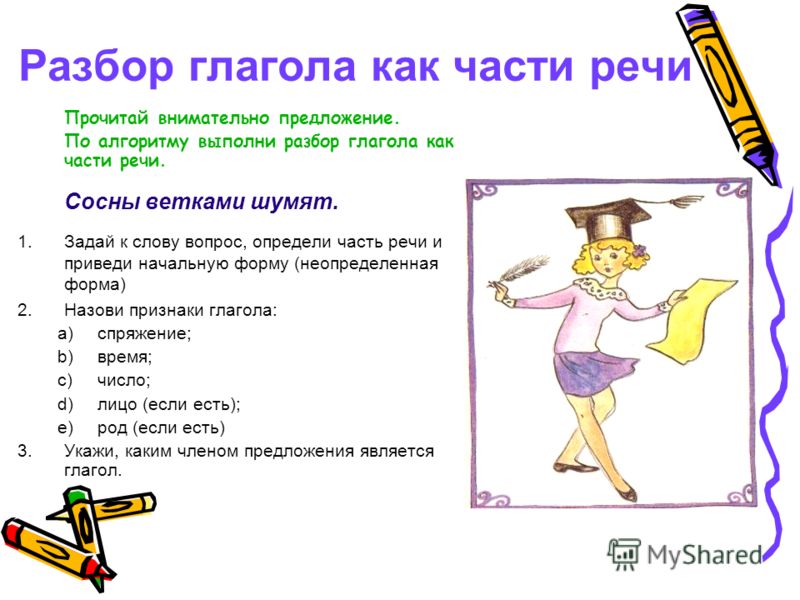

Разбор слова по составу — это очень просто, элементарщина. Частей слова ведь всего 5 (даже почти 4): приставка, корень, суффикс, окончание. А всё вместе, кроме окончания — это основа.

Чего тут сложного, казалось бы.

Проблема в том, что в школе все эти части слова учат и отрабатывают по-отдельности. То суффиксы отдельно ищем, то окончания… И у ребенка не складывается общая картинка — что из себя представляет состав слова. Ему начинает казаться, что это — эдакая игра в угадайку: угадай суффикс, угадай приставку, угадай часть речи.

Интересно, что даже если ребенок хорошо разбирается в частях речи, задания типа «найди суффикс» могут поставить его в тупик, потому что, в отличие от корня, суффикс — это «бессмысленный набор буковок».Пойди угадай, какие именно буковки относятся к этому «треугольничку».

В этой статье предложу схему разбора по составу, применяя которую ребенок всегда — независимо от типа задания — сможет легко разбирать по составу все части речи.

Что нужно знать о частях слова, прежде чем делать разборСамое главное — нужно запомнить, что части слова не существуют в изоляции: они все связаны друг с другом. Ну конечно — слово-то одно. Поэтому…

Когда-нибудь ваш второклашка наберется солидного опыта в выявлении любых суффиксов с первого взгляда.

А пока — даже если в задании написано «найди суффикс», для корректного определения этого суффикса нужно сделать разбор полностью. Сначала найди все части слова, а потом среди них вычислить — и уже отметить в тетради только суффикс.

В ближайшие дни я выпущу отдельную статью именно про суффиксы.

Здесь же замечу, что, конечно, не нужно полностью разбирать слово по составу, если ваш второклашка безошибочно узнал суффикс «-еньк-«, например, и ни с чем его никогда не перепутает.

Просто знания о конкретных суффиксах у второклашек редко возникают сами по себе — в связи с этим и возникла рекомендация про полный разбор.

Итак, договорились: для того, чтобы корректно выделить какую-то часть речи, нужно разобрать по составу всё слово.

Теперь двигаемся по схеме.

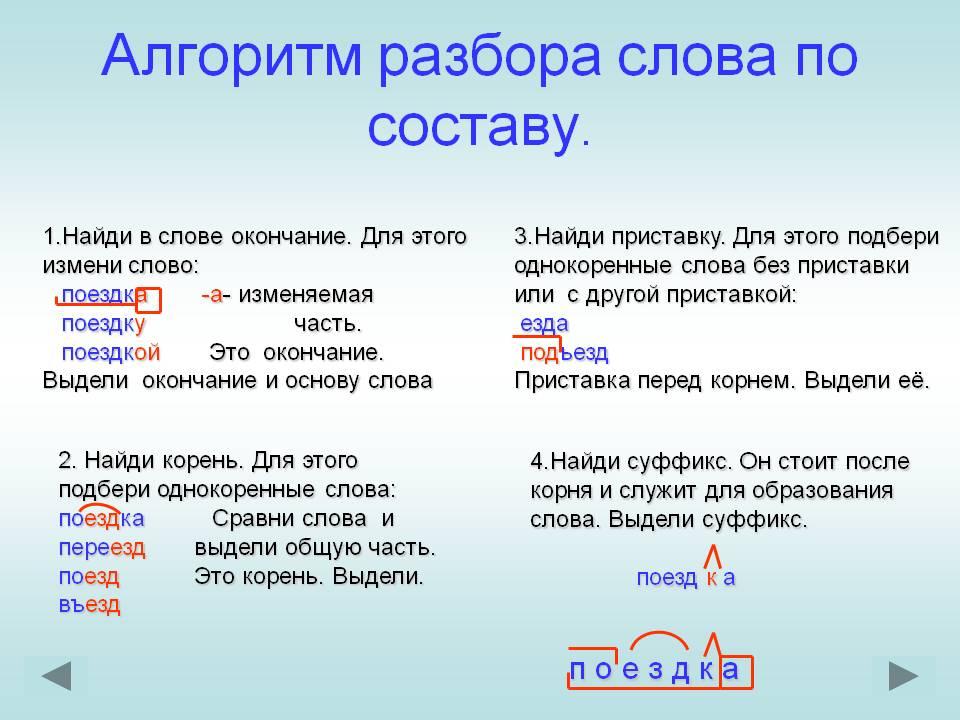

1. Находим кореньСначала найдем самое главное — и самое простое.

Чтобы найди корень, нужно придумать похожие слова.

Почитайте эту мою статью про однокоренные слова и формы слова — и обратите внимание: для поиска корня нам нужны НЕ ФОРМЫ одного слова, а именно ОДНОКОРЕННЫЕ слова.

Напр., разбирая слово «подарок» — для поиска корня нам нужно НЕ «подарку, подарком», а «дар, дарить, задарить, подарить«.

«Ударить». Лол 🙂 Поменяли приставку — и вуа-ля 🙂

Реальная история про то, как НЕ НАДО искать однокоренные — расскажу в отдельной статье про приставки.

Итак, подбираем много похожих (однокоренных) слов и внимательно слушаем, что у этих слов изменяется, а что — остается неизменным.

Важно, что это «неизменное» должно иметь смысл — то есть быть не набором абстрактных буковок, а что-то значить.

Напр., в нашем примере с «подарком» у всех подобранных нами слов остается неизменной часть «дар». А мы, слыша эту часть, как-то понимаем, что это не абракадабра, а что-то, связанное с бесплатным получением чего-то.

То, что не поменялось у нескольких однокоренных — это корень. Отмечаем.

Да, конечно, всегда будет 100500 исключений, чередований в корне и т.д. Но русскоговорящий человек (даже ребенок), как правило, эти чередования «считывает» на слух и понимает, что это чередования.

2. Находим окончаниеПомним, что окончание так называется — потому что стоит в конце слова. Поэтому его очень просто искать: нужно обвести в квадратик сколько-то буковок в конце слова.

Поэтому его очень просто искать: нужно обвести в квадратик сколько-то буковок в конце слова.

Осталось только выяснить, сколько буковок с конца — это окончание, а не что-то другое.

Напомню, мы уже определили корень.

Возможно, после определения корня ни одной лишней буковки в конце слова не оказалось.

У окончания есть такое явление, как нулевое окончание: это когда окончания нет — но оно как бы есть. Тогда мы ставим в конце слова пустой квадратик — обвели воздух в виде окончания.

Всё слово — один сплошной корень. Окончание нулевоеВсё слово — один сплошной корень. Окончание нулевое

А еще бывает, что окончания нет в принципе — и обводить воздух в виде нулевого окончания не нужно.

До 4 класса ребенок почти наверняка с этим явлением не столкнется. Но если вдруг…

Как определить — есть ли у слова нулевое окончание или окончания нет вовсе?

Окончаний нет у слов, которые не умеют изменяться по падежам, лицам, числам, временам. .. чему угодно:

.. чему угодно:

- Союзов, предлогов, междометий — разных коротких служебных словечек, которые сами по себе никакого смысла не несут, а лишь «помогают» связываться словам друг с другом (ах/ох, перед/над…).

- Существительных и прилагательных, которые нельзя изменить (пальто (цвета) индиго — и существительное и прилагательное здесь будут без окончания… ). Здесь же — аббревиатуры и сокращения вроде «минфин».

- У всех слов, которые могут ответить на вопрос КАК.

По последнему пункту интересно. «Официально» окончание не существует у деепричастий (что делая? — играя), а также прилагательных (какой? — красивее) и наречий (как? — ярче) в простой сравнительной форме.

А теперь попробуйте к тем же словам, которые я написала, задать тот же вопрос КАК:

- Играя, он вошел в комнату. — КАК он вошел в комнату?

- Он пишет красивее, чем Вася.

— КАК он пишет?

— КАК он пишет? - Сегодня солнце светит ярче. — КАК светит солнце?

Видите, несмотря на то, что речь идет про разные части речи, вопрос КАК все равно поможет определить, есть ли у слова окончание.

Хорошо, с нулевым или отсутствующим окончанием разобрались.

А, допустим, нам не повезло, и следом за корнем остались какие-то буковки. Наша задача — найти среди этих буковок окончание.

Для удобства запомним себе подсказки:

** Если разбираем существительное, прилагательное или причастие — будем говорить наше слово в компании со следующими тремя:

- НЕТ (чего?) нашего слова. Напр. «подарка«

- ДОВОЛЕН (чем?) нашим словом. Напр., «подарком«

- ДУМАЮ О (чем?) нашем слове. Напр., «подарке«

** Если разбираем глагол — скажем его в настоящем и прошедшем времени:

- что Я ДЕЛАЮ — ОНА ДЕЛАЕТ — МЫ ДЕЛАЕМ сейчас ? — Напр.

, «думаю — думает — думаем«

, «думаю — думает — думаем« - ЧТО Я ДЕЛАЛ — ОНА ДЕЛАЛА — МЫ ДЕЛАЛИ вчера? — Напр. «думал — думала — думали«

То есть существительные и прилагательные мы изменяем по падежам, а глаголы — по лицам и числам в настоящем и прошедшем времени.

Их гораздо больше, чем я показала здесь.

Но нам для разбора по составу больше не нужно — возьмите только самые «показательные» в смысле изменений.

Проговариваем слова и наблюдаем, что изменилось в конце слова.

То, что изменилось после наших изменений — и будет окончанием. Отмечаем.

Здесь, к счастью, исключений будет минимум. Главное — быть очень внимательным. Иногда имеет смысл записать все получившиеся формы на черновичок в столбик — и глазами посмотреть, что изменяется.

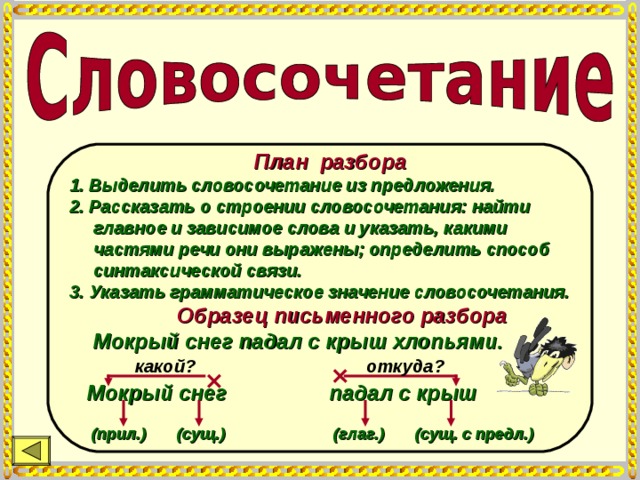

3. Находим приставку

Находим приставкуПриставка — это то, что стоит перед корнем.

Возможно, вам повезло, и перед корнем у вас ничего не стоит. УРА! Значит, приставки нет — двигаемся дальше.

Если же перед корнем что-то написано — это 100% приставка. А может — несколько приставок.

Четыре приставки в словеЧетыре приставки в слове

Как определить: одна приставка, или две, или вообще несколько?

В начальной школе ребенок с 99% вероятностью ни разу не столкнется с двумя и более приставками — так что смело отмечайте всё, что оказалось перед корнем, одной квадратной загогулинкой.

Но если вдруг… тогда читайте дальше:

Приставки похожи на предлоги. Если то, что написано перед корнем, выглядит очень-очень длинно — попробуйте выделить оттуда кусочки, похожие на предлоги.

В нашем примере ребенок легко найдет слово «под» целых два раза. Скажем вместе с существительным: «под столом» — работает! Попробуем выделить его в отдельную приставку.

Скажем вместе с существительным: «под столом» — работает! Попробуем выделить его в отдельную приставку.

ПОД- в начале слова — это скорее всего приставка

Осталось всего два кусочка: «пере-» и «-вы-«. Проверим, могут ли они быть отдельными приставками.

Осталось проверить, могут ли считаться приставками другие кусочкиОсталось проверить, могут ли считаться приставками другие кусочки

Для проверки приставок удобно использовать базовое слово «ХОД» — оно подходит к очень многим приставкам, к большинству из них. Добавляйте к этому слову все кусочки, которые вы считаете отдельными приставками. Если новое слово, которое получилось из слова «ход» и вашей предполагаемой приставки звучит адекватно — значит, вы правильно выделили отдельную приставку.

Добавим к слову «ход» эти приставки. Получилось «переход» и «выход» — вполне себе адекватные слова. Значит, обе приставки тоже имеют право на существование.

Конечно, слово «ход» подойдет далеко не ко всем приставкам.

Мы это обсудим в отдельной статье на тему приставок.

Там же поговорим о том, как отличить приставку, скажем, «по-» или «под-» от одноименного кусочка корняю

Итак, запоминаем:

- Всё, что перед корнем — это приставка.

- Если перед корнем ничего не написано — значит, приставки нет.

- Если оно слишком длинное — может, приставок несколько.

- Если нам нужно проверить, одна или несколько приставок — пробуем каждую «предположительно отдельную» приставку в качестве предлога или в качестве одной отдельной приставки к другому слову.

Суффикс — это то, что находится между корнем и окончанием.

Возможно, вам повезло, и между корнем и окончанием никаких букв не написано — УРА! Значит суффикса нет.

Если между корнем и окончанием вы видите только одну букву — смело отмечайте ее как суффикс.

Если же между корнем и окончанием оказалось больше одной буквы — тут начинаются нюансы: суффиксов может быть несколько.

Пример слов с двумя суффиксамиПример слов с двумя суффиксами

…Вообще, суффиксы — это самая мерзостная тема русского языка, потому что суффиксов немерено, и логика в их выделении присутствует далеко не всегда.

Поэтому в суффиксах нужно искать логику и заучивать их наизусть.

У меня выйдет цикл статей о суффиксах: как выстроить логическую систему суффиксов русского языка, запомнить их и не ошибаться при морфемном разборе.

Запомните: если в суффиксе несколько букв — а в начале или в конце «потенциального суффикса» стоит Л, К или Н — всегда подозревайте, что эта буква — это ОТДЕЛЬНЫЙ СУФФИКС (а всего в слове — два или больше суффиксов).

Дело в том, что буквы Л, К и Н чаще других букв выступают в роли отдельных суффиксов.

Здесь буква Н — в начале «потенциально суффикса», а значит, её можно подозревать в том, что она — отдельный суффиксЗдесь буква Н — в начале «потенциально суффикса», а значит, её можно подозревать в том, что она — отдельный суффикс

Что интересно, букв в суффиксе может быть совсем мало, и все равно буква Л, Н или К может оказаться отдельным суффиксом.

Буква К в конце «потенциального суффикса» с очень высокой вероятностью будет отдельным суффиксом — несмотря на то, что тут между корнем и окончанием всего 3 буквыБуква К в конце «потенциального суффикса» с очень высокой вероятностью будет отдельным суффиксом — несмотря на то, что тут между корнем и окончанием всего 3 буквы

Как, например, в глаголах прошедшего времени — Л всегда будет отдельным суффиксом:

В общем, с буквами Н, К и Л в начале и конце потенциального суффикса будьте внимательны — с высокой степенью вероятности они будут выделяться в отдельный суффикс, а всего в слове будет больше одного слова, как в наших примерах:

Примеры с двумя суффиксами, с буквами Н, К и ЛПримеры с двумя суффиксами, с буквами Н, К и Л

Итак, запоминаем:

- То, что стоит между корнем и окончанием — это один или несколько суффиксов.

- Если между корнем и окончанием нет ни одной буквы — значит, суффикса нет.

- Если в начале или конце потенциального суффикса есть буква Н, Л или К — высока вероятность того, что эта буква — отдельный суффикс, а в слове больше, чем один суффикс.

- Чтобы безошибочно определять суффиксы — придется учить их наизусть, и вообще этот навык нарабатывается, увы, с опытом.

И снова — самое простое. Всё, что не окончание — это основа.

Выделим квадратной закорючкой всё, кроме квадратика окончания — и разбор закончен!

***

Не забывайте, что морфемный анализ — это навык, который нарабатывается большим количеством повторений.

Поэтому, чтобы хорошо научиться разбирать слово по составу, нужно повторять это много — много — много — очень много раз, причем с разными частями речи.

Успехов у учебе вашим детям!

______________________

Мой блог про японскую методику обучения детей KUMON ищите по адресу https://kumon-deti.com

Познакомиться со мной в Инстаграм https://instagram.com/kumon.deti

Основа слова / Морфемный разбор / Справочник по русскому языку для начальной школы

- Главная

- Справочники

- Справочник по русскому языку для начальной школы

- Морфемный разбор

- Основа слова

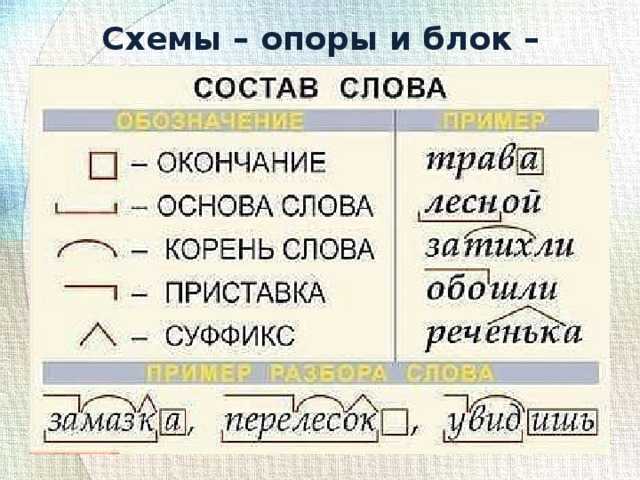

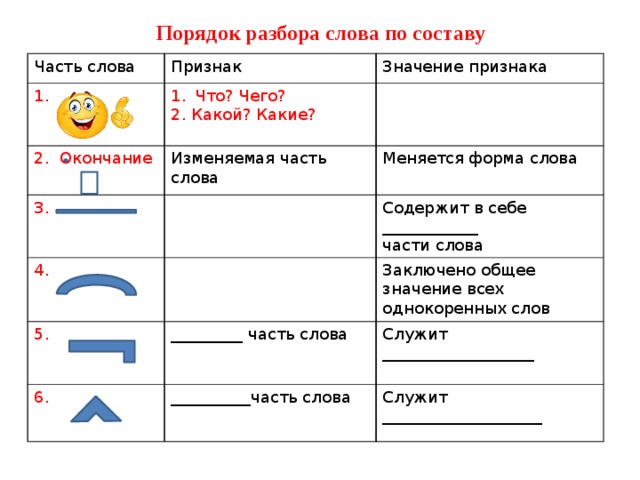

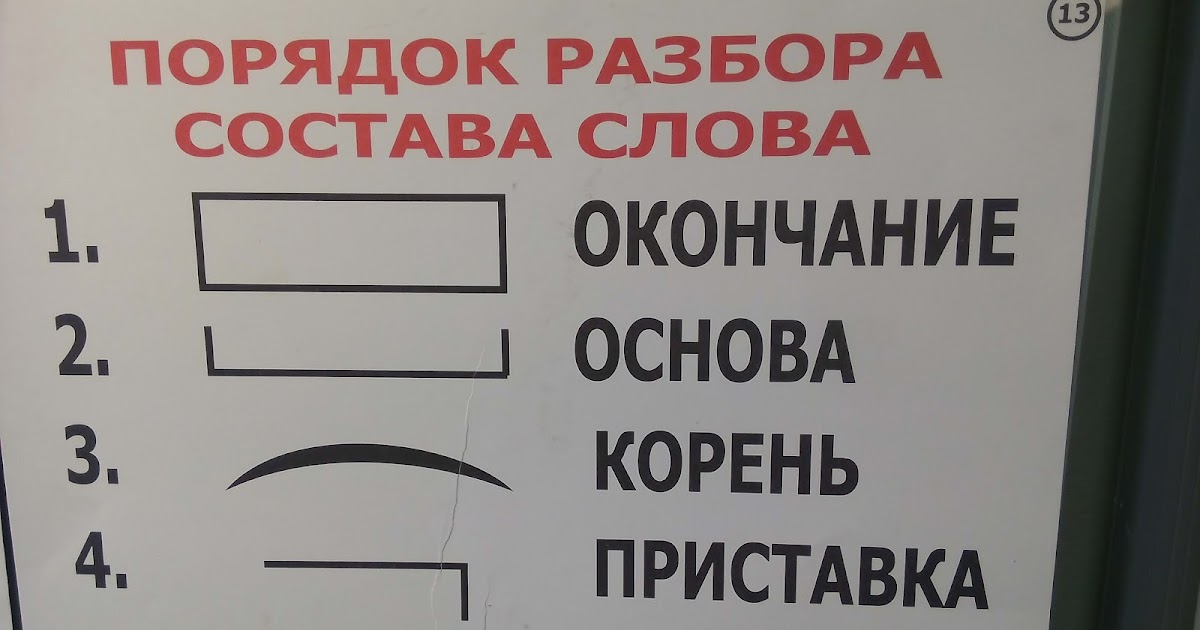

При разборе слова по составу иногда указывают основу слова, в которой заключено значение конкретного слова. Основу могут составлять приставка, корень и суффикс, т.е. все морфемы, кроме окончания. Основа графически отображается как ̢_______̡

Чтобы найти основу слова, его нужно изменить.

Например:

По числам: книга – книги, написал – написали

По падежам: раскрыл книгу – выписал из книги

По родам: сказочная история – сказочный мир

По лицам: я говорю – он говорит

Если слово изменяется (как в приведенных выше примерах), то часть слова без окончания и составляет его основу.

яблочко — яблочками

Если слово не изменяется, то основу составляет все слово целиком:

далеко, тихо, вправо

Обратите внимание, что у глаголов в прошедшем времени суффикс -л- в основу не входит:

позвала, увидел , сходило

Также у глаголов в неопределённой форме не входит в основу суффикс -ть:

позвать, желтеть

Поделись с друзьями в социальных сетях:

Советуем посмотреть:

Окончание

Корень и однокоренные (родственные) слова

Приставки и их значения

Суффикс

Морфемный разбор

Правило встречается в следующих упражнениях:

3 класс

Упражнение 156, Климанова, Бабушкина, Рабочая тетрадь, часть 1

Упражнение 135, Полякова, Учебник, часть 1

Упражнение 138, Полякова, Учебник, часть 1

Упражнение 141, Полякова, Учебник, часть 1

Упражнение 144, Полякова, Учебник, часть 1

Упражнение 160, Полякова, Учебник, часть 1

Упражнение 251, Полякова, Учебник, часть 1

Упражнение 1, Бунеев, Бунеева, Пронина, Учебник, часть 2

Упражнение 5, Исаева, Бунеев, Рабочая тетрадь

Упражнение 6, Исаева, Бунеев, Рабочая тетрадь

4 класс

Упражнение 141, Полякова, Учебник, часть 1

Упражнение 134, Полякова, Учебник, часть 2

Упражнение 145, Полякова, Учебник, часть 2

Упражнение 298, Бунеев, Бунеева, Пронина, Учебник, часть 2

Упражнение 301, Бунеев, Бунеева, Пронина, Учебник, часть 2

Упражнение 302, Бунеев, Бунеева, Пронина, Учебник, часть 2

Упражнение 303, Бунеев, Бунеева, Пронина, Учебник, часть 2

Упражнение 5, Бунеев, Бунеева, Пронина, Учебник, часть 2

Упражнение 386, Ладыженская, Баранов, Тростенцова, Григорян, Кулибаба, Учебник, часть 2

Упражнение 710, Ладыженская, Баранов, Тростенцова, Григорян, Кулибаба, Учебник, часть 2

5 класс

Упражнение 82, Александрова, Рыбченкова, Глазков, Лисицин, Учебник, часть 1

Упражнение 83, Александрова, Рыбченкова, Глазков, Лисицин, Учебник, часть 1

Упражнение 92, Александрова, Рыбченкова, Глазков, Лисицин, Учебник, часть 1

6 класс

Упражнение 25, Ладыженская, Баранов, Тростенцова, Григорян, Кулибаба, Учебник, часть 1

Упражнение 134, Ладыженская, Баранов, Тростенцова, Григорян, Кулибаба, Учебник, часть 1

Упражнение 156, Ладыженская, Баранов, Тростенцова, Григорян, Кулибаба, Учебник, часть 1

Упражнение 29, Александрова, Рыбченкова, Загоровская, Нарушевич, Учебник, часть 1

Как разобрать слово по составу — РОСТОВСКИЙ ЦЕНТР ПОМОЩИ ДЕТЯМ № 7

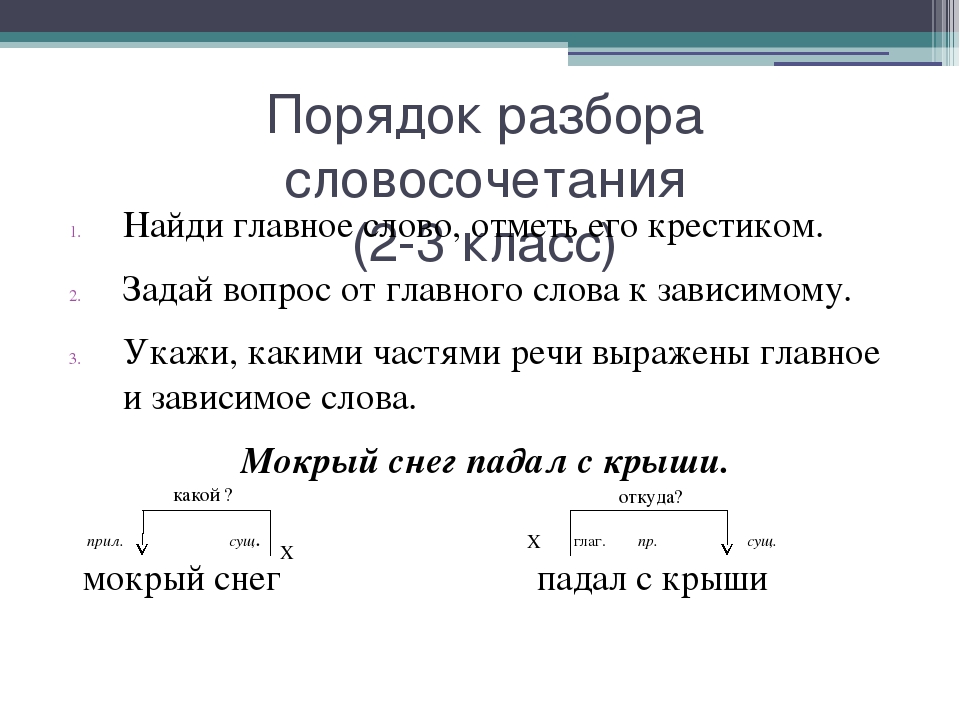

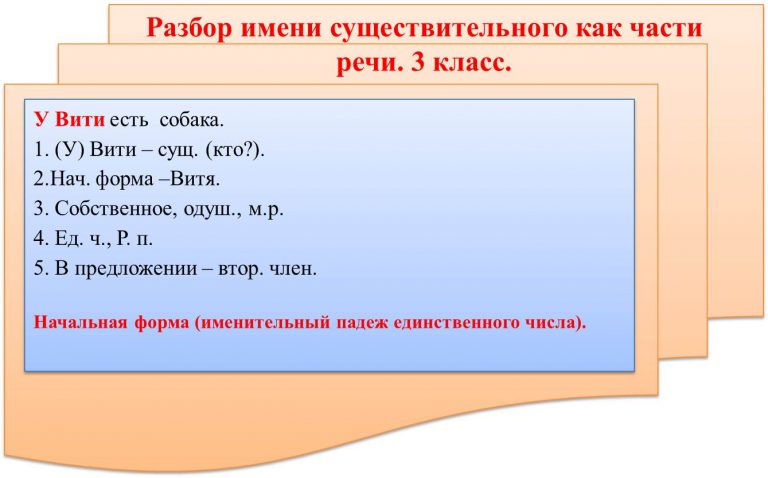

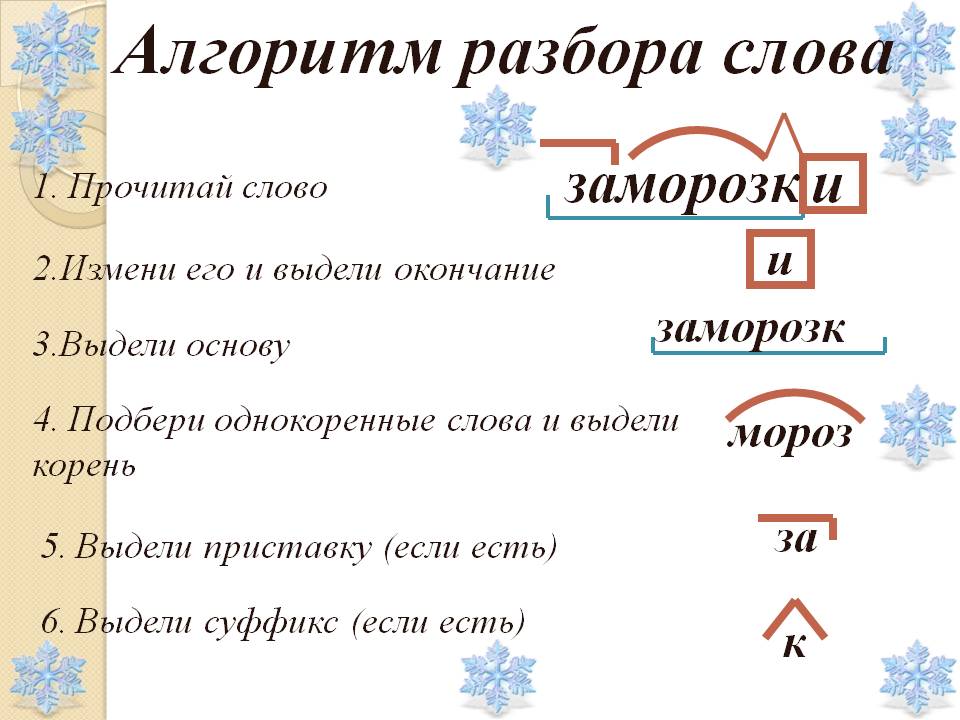

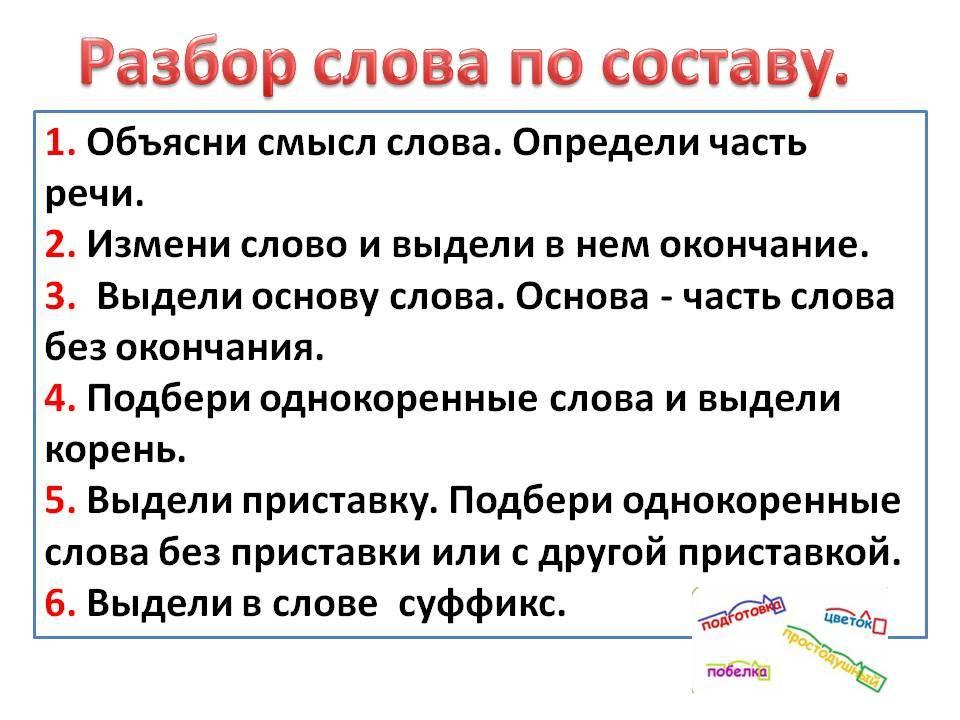

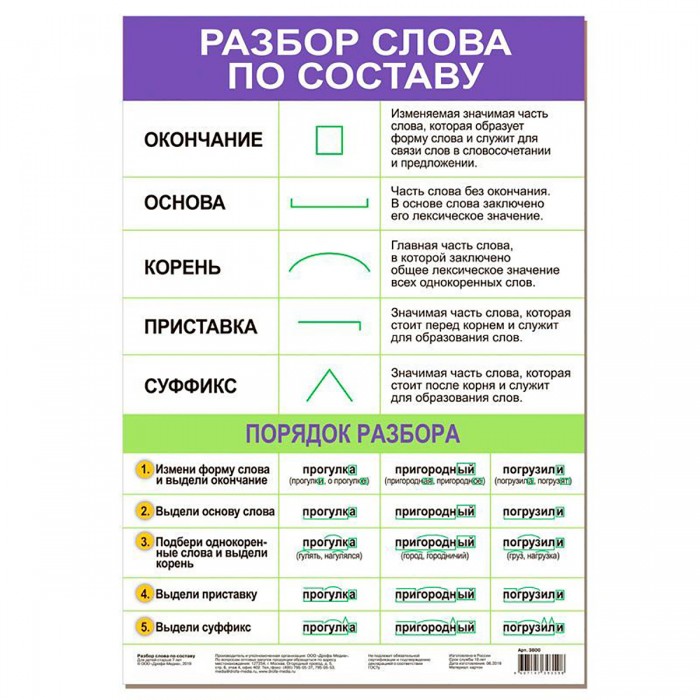

1. Измени слово по числам или по команде одного-двух вопросов, выдели изменяемую часть – окончание. Отметь основу слова (это часть слова без окончания).

Измени слово по числам или по команде одного-двух вопросов, выдели изменяемую часть – окончание. Отметь основу слова (это часть слова без окончания).

2. Объясни значение слова с помощью слова-родственника, подбери ещё одно-два однокоренных, выдели их общую часть – корень.

3. Определи и укажи часть слова перед корнем – приставку, постарайся объяснить её работу.

4. Определи и укажи часть слова после корня перед окончанием – суффикс, подумай о его работе.

1. Изменю слово по числам: подставки – подставка (изменилось -а, это окончание). Основа подставк-

2. Объясню значение слова: подставка – подставляют, ставят под что-то; подставить. Корень –став.

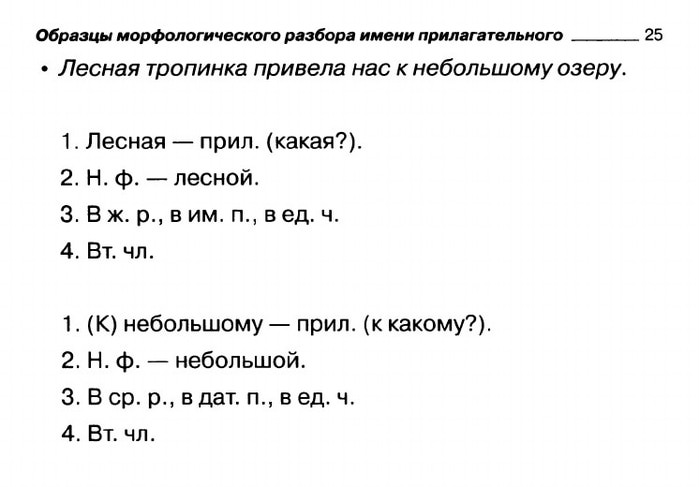

Чтобы не делать ошибок в разборе слова по составу, нужно учитывать значение слова и значение части слова.

В существительном мячик выделяем суффикс -ик-, который придаёт слову значение «маленький» (мячик – это маленький мяч).

А существительное лётчик не имеет значения «маленький». В этом слове другой суффикс -чик-. Существительное обозначает профессию человека. Такое значение придаёт суффикс -чик-

В существительном дружок выделяем суффикс -ок-, который имеет уменьшительно-ласкательное значение (друг – дружок).

А существительное урок не имеет такого значения, потому что в нём нет такого суффикса. Корень -урок- (родственное слово урочный)

В существительном победа нет такой приставки, корень -побед- (однокоренные слова: победить, победитель)

Смешу – вызываю смех, корень -смеш-, -смех-, в корне есть чередование согласных х//ш.

В этом существительном нет суффикса -ик-, корень -ластик- (однокоренное слово ластиковый).

В глаголе ухожу выделяем приставку у-, которая имеет значение «удаляться». Корень -хож- (родственные слова: ход, ходьба, чередование д//ж в корне).

В существительном ухо нет приставки у-. Однокоренные слова: ушастый, ушки, корень -ух-, -уш-, чередование х//ш.

Однокоренные слова: ушастый, ушки, корень -ух-, -уш-, чередование х//ш.

Попробуйте самостоятельно разобрать слова по составу: касса, рассада, рассольник, рассказ.

В словах рассказ, рассада и рассольник последняя буква приставки и первая буква корня одинаковые.

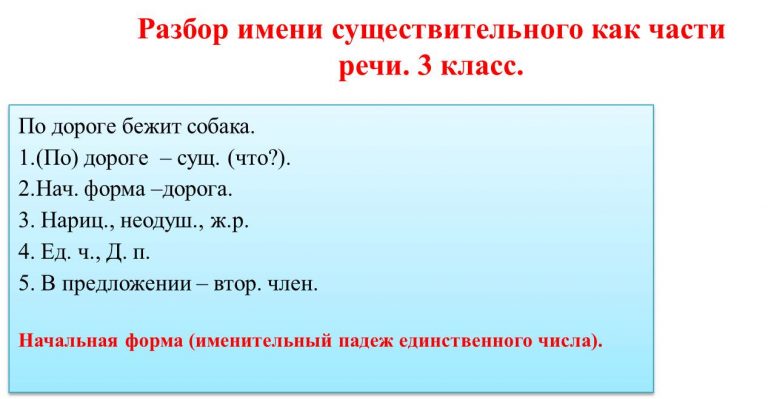

Для того, чтобы выбрать ответ, надо только определить часть речи и лексическое значение. Ведь одно и то же слово может быть сразу несколькими частями речи в зависимости от контекста.

Существительное:

Я сижу в онлайне.

Я сижу в кафе.

Наречие:

Я смотрю фильм онлайн.

Я сижу давно.

Есть шпаргалка по разбору слова по составуСоставСлова

Урезанная копия morphemeonline, где не объясняется лексическое значение слова «онлайн». Кроме того, есть реклама. Как я уже сказала, ни единой причины использовать этот сайт по сравнению с предыдущим нет.

Результат работы сервиса СоставСловаЛексическое значение слов «онлайн» не объяснено, хотя оно не очевидно. Ведь есть существительное «онлайн», в котором можно сидеть. Есть наречие «онлайн»: например, смотреть «онлайн». И есть наречие «онлайн» в противоположность «офлайн», будет приставка. Во всех трех случаях разбор по составу разный.

Ведь есть существительное «онлайн», в котором можно сидеть. Есть наречие «онлайн»: например, смотреть «онлайн». И есть наречие «онлайн» в противоположность «офлайн», будет приставка. Во всех трех случаях разбор по составу разный.

Но не пугайтесь, если не понимаете разницу, в школьных домашних заданиях слова для разбора обычно попроще. Этот пример приведен для того, чтоб вы поняли преимущества первого сайта.

Как видите, скриншот даже не вмещает все три разбора из-за наличия рекламы.

ВикиСлово

Тоже урезанная копия morphemeonline, где не объясняется лексическое значение. Кроме того, урезано описание морфем – только картинка.

Есть дополнительный сервисы: фонетический, морфологический разбор.

ВикиСлово

Но в этом сервисе, как и во всех, кроме самого первого, больше минусов, чем плюсов. Один из них реклама.

Есть навязчивая реклама

УдарениеРу

Словарь не полностью представлен, найдено только одно значение слова «онлайн». Разбор слова по составу представлен некрасиво, описание с сокращениями, нет картинок.

Как видите, найдено только одно основное значение слова:

Результат работы сервиса УдарениеСловОнлайн

Очень ограниченный словарь, слово «онлайн» не найдено вообще. Разбор по составу представлен некрасиво. Есть реклама, интерфейс устаревший неудобный.

Ужасный интерфейс СловОнлайнТрудно пользоваться, при поиске надо не забыть выбрать «Разбор по составу (Морфемный)» и потом щелкнуть найденное слово. Тут много словарей, но устаревших, так как наше слово в них все равно не найдено.

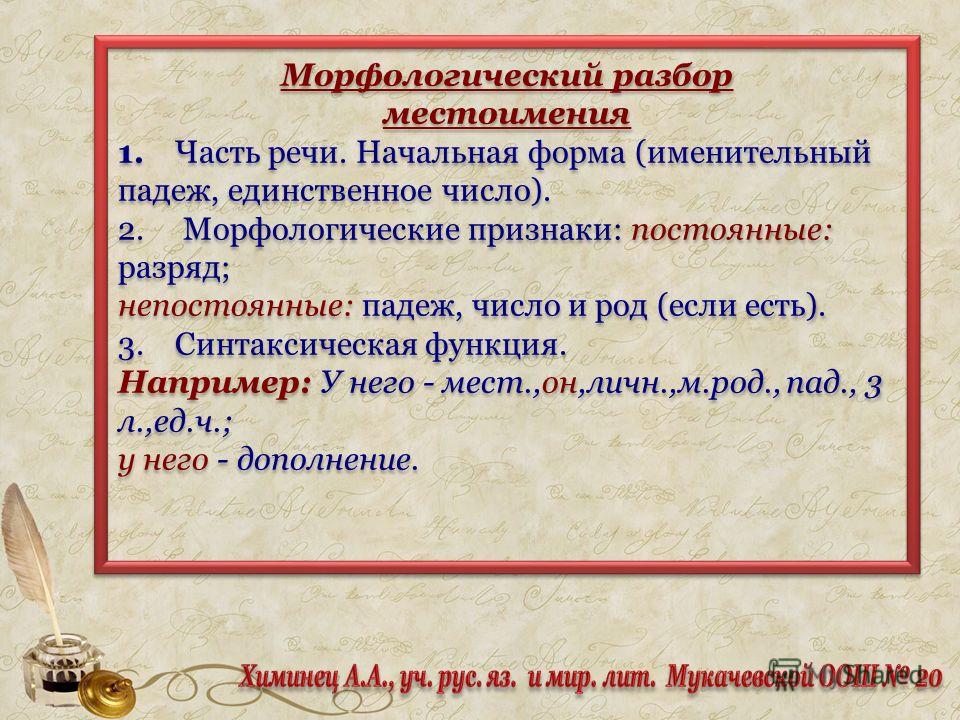

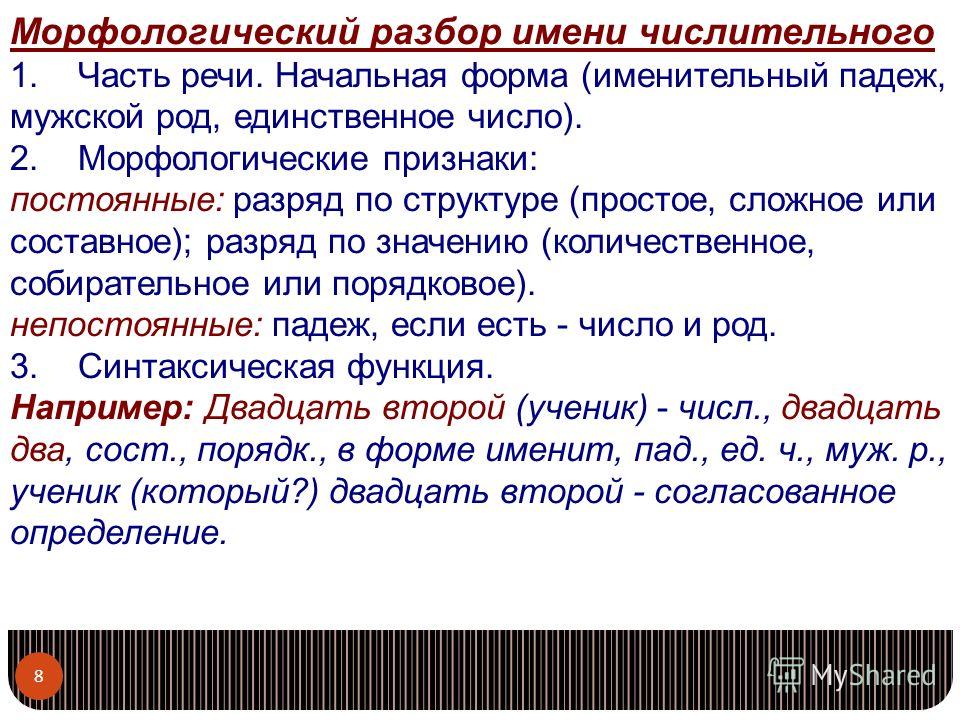

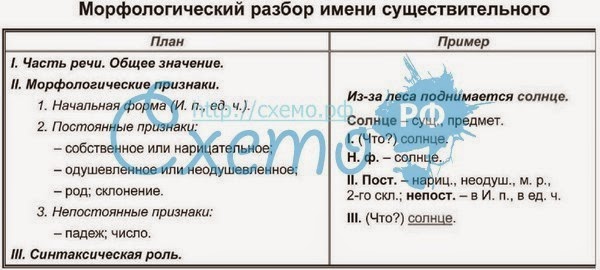

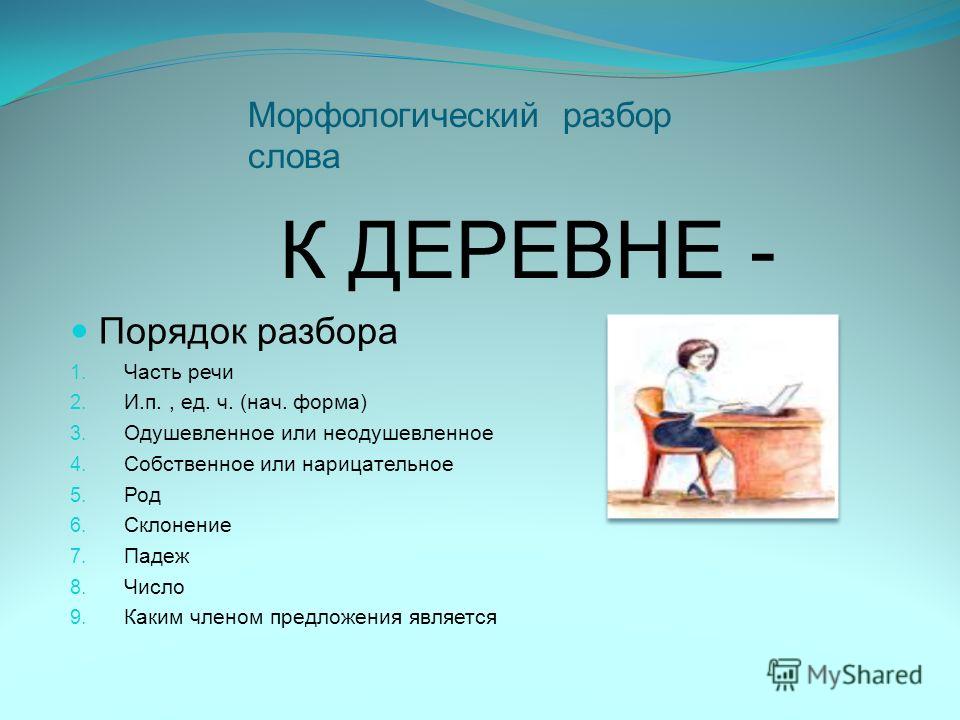

Разница между морфемный и морфологическим разбором

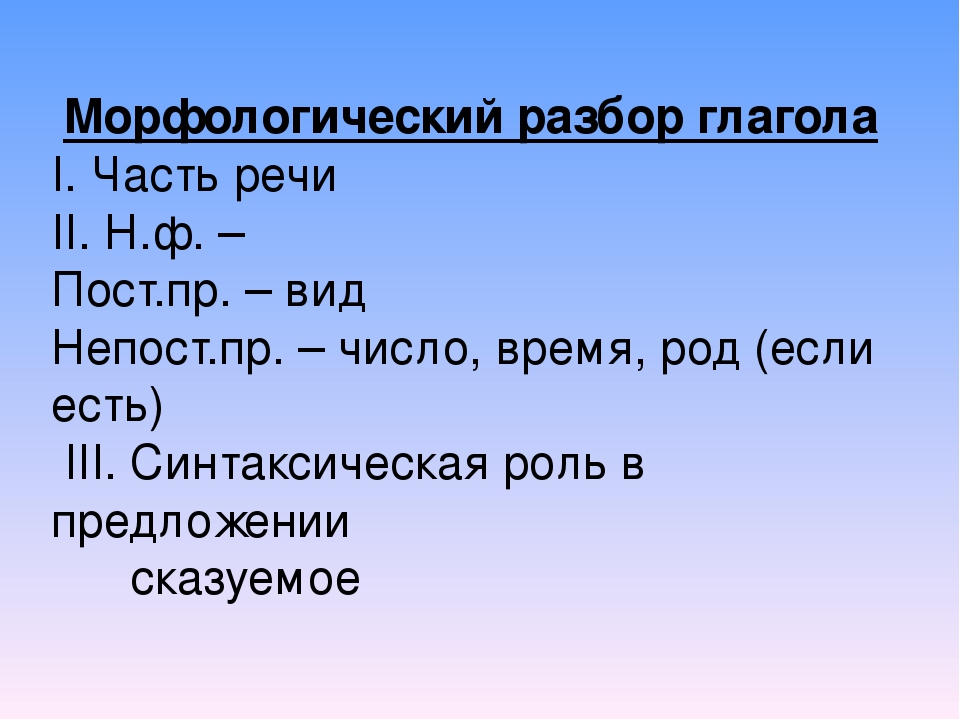

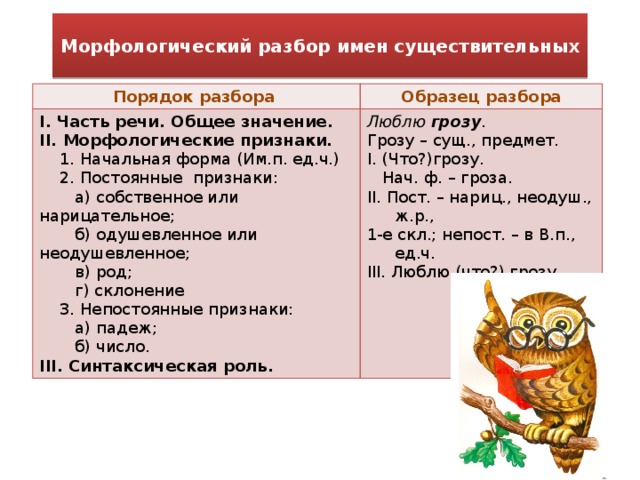

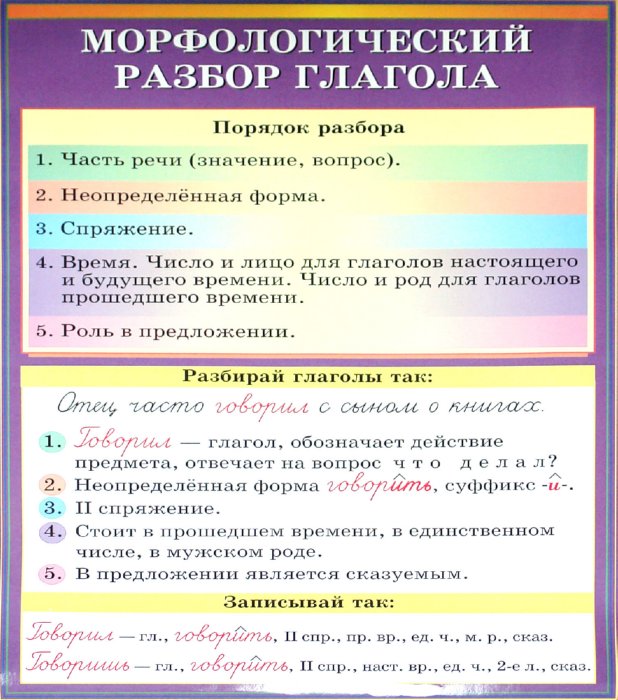

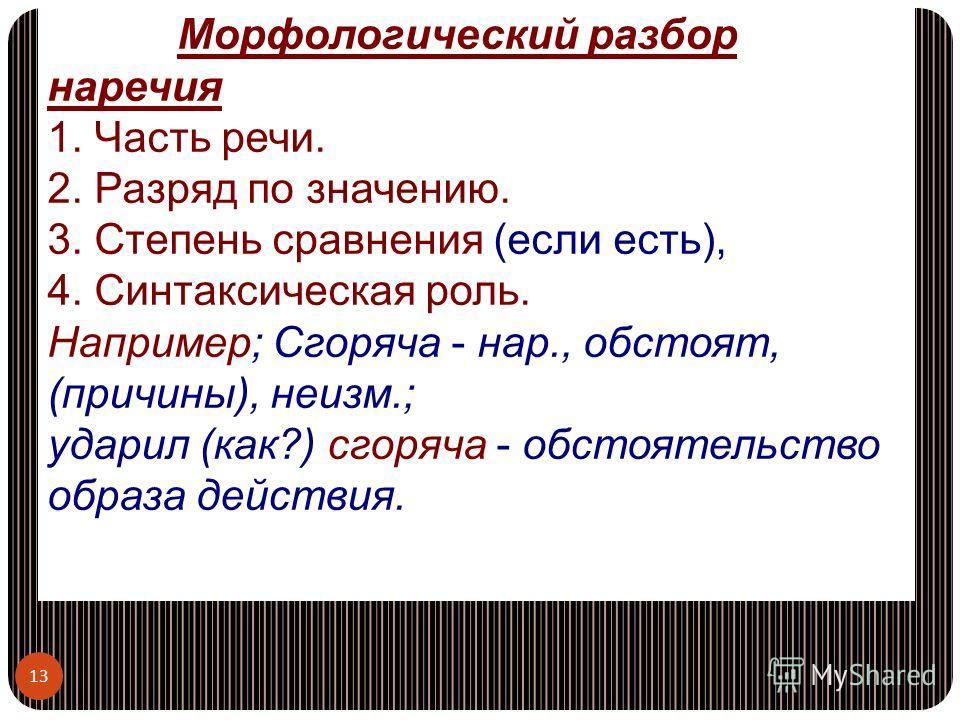

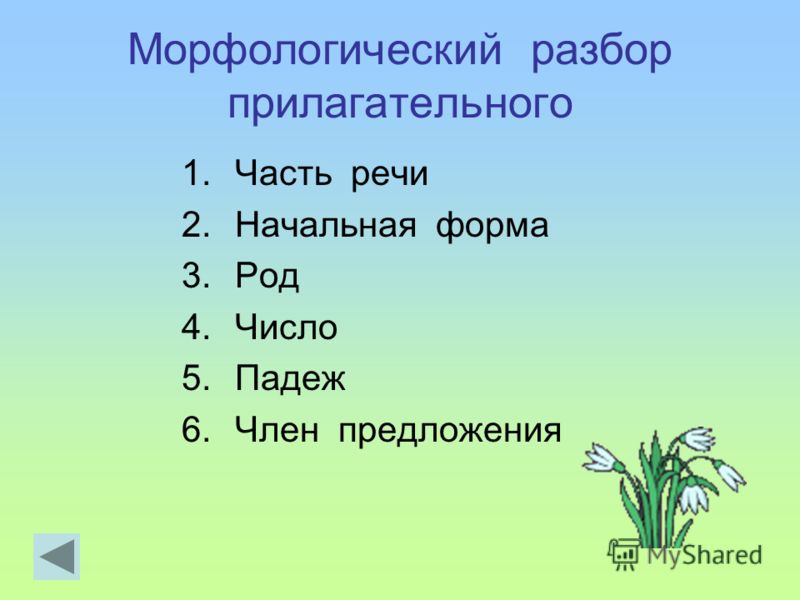

И напоследок разъясню разницу между морфемным и морфологическим разбором слова.

Морфемный разбор – это разбор по составу, тут ручкой отмечают корень, суффикс, окончание.

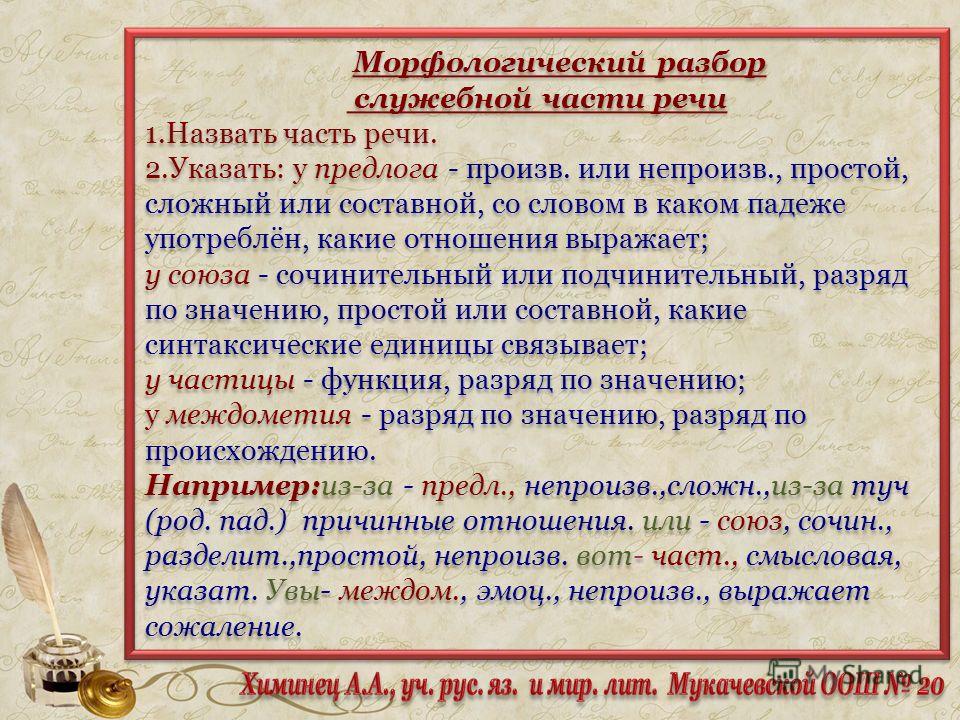

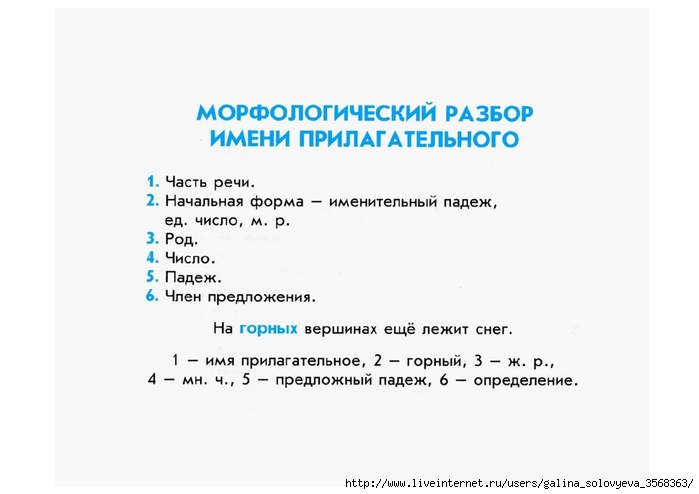

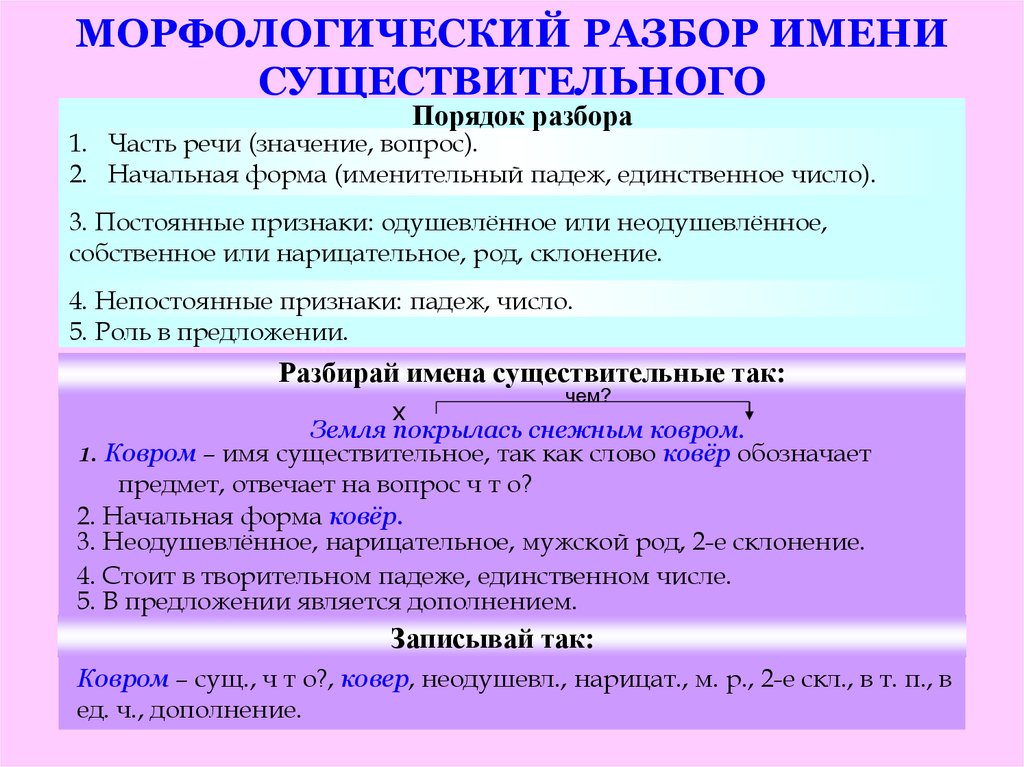

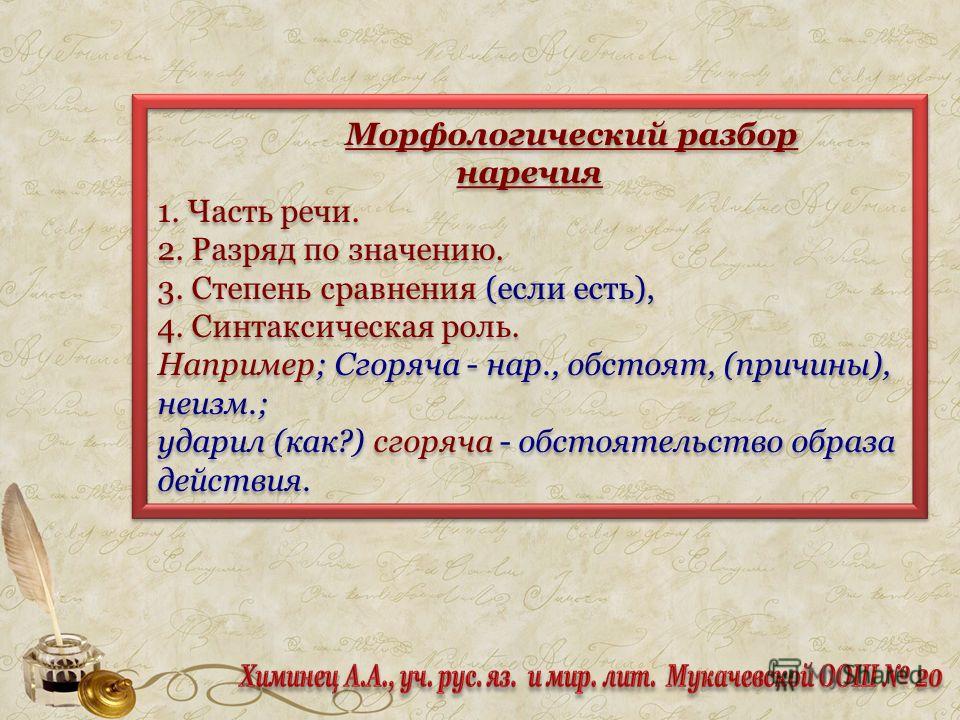

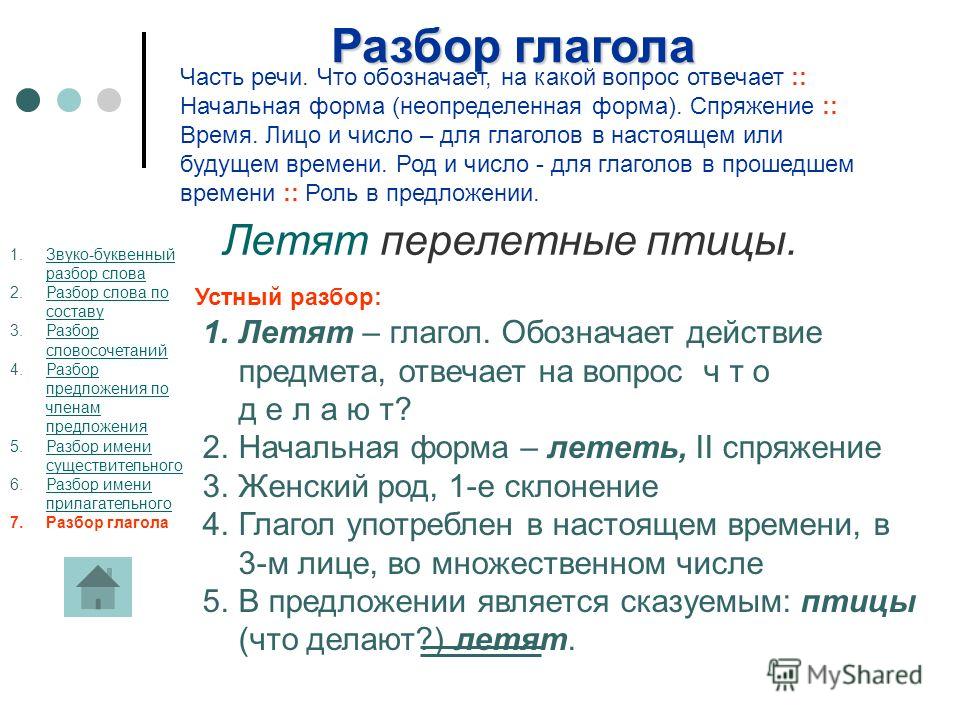

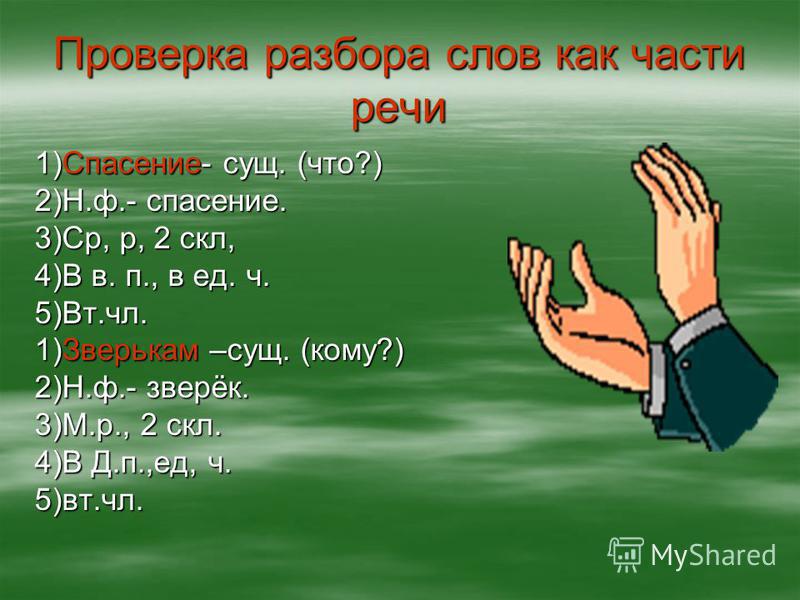

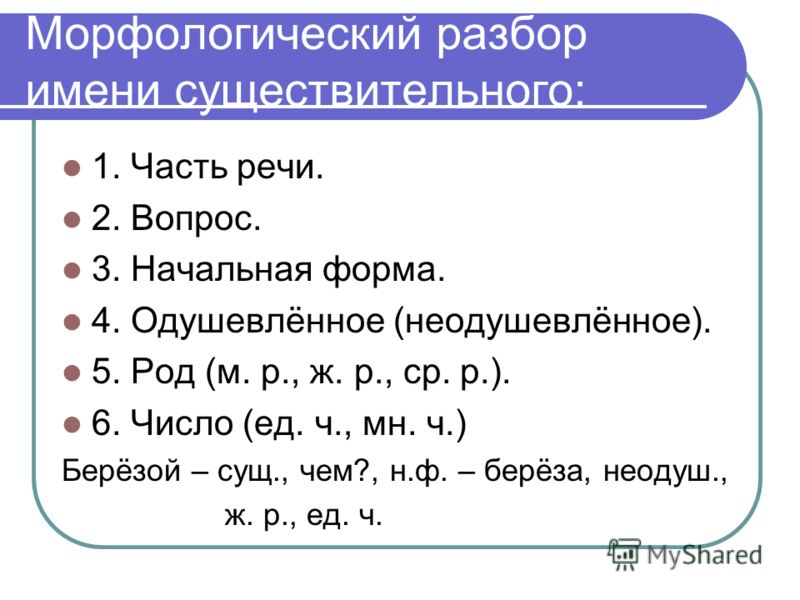

Что такое морфемный разбор словаА при морфологическом разборе ручкой ничего не отмечают, это просто определение склонения, рода и других (зависит от слова) характеристик части речи.

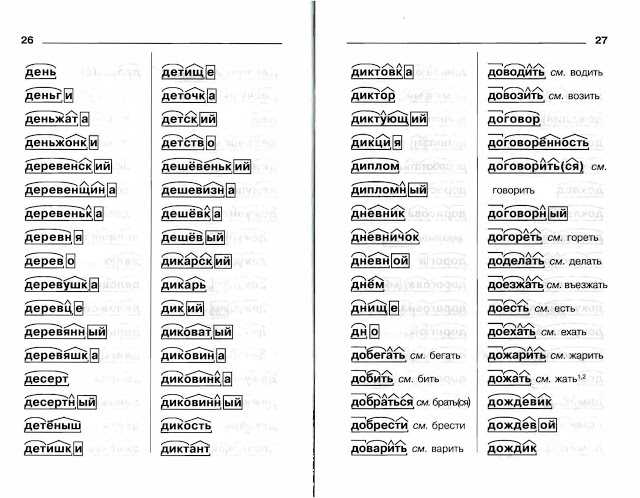

Разбор слова по составу — Штрих-код: 9785944550866

Результаты поиска Штрих-код: 9785944550866

Наши пользователи определили следующие наименования для данного штрих-кода:

| № | Штрих-код | Наименование | Единица измерения | Рейтинг* |

|---|---|---|---|---|

| 1 | 9785944550866 | РАЗБОР СЛОВА ПО СОСТАВУ | ШТ. | 3 |

| 2 | 9785944550866 | СЛОВАРЬ РАЗБОР СЛОВА ПО СОСТАВУ.СЛОВАРИК ШКОЛЬН. | ШТ. | 1 |

| 3 | 9785944550866 | РАЗБОР СЛОВА ПО СОСТАВУ СЛОВАРИК ШКОЛЬНИКА / 978-5-94455-086-6, ШТ (1 ШТ)) | ШТ. | 1 |

| 4 | 9785944550866 | РАЗБОР СЛОВА ПО СОСТАВУ СЛОВАРИК ШКОЛЬНИКА / 978-5-94455-086-6 | ШТ. | 1 |

| 5 | 9785944550866 | СЛОВАРИК ШКОЛЬНИКА»РАЗБОР СЛОВА ПО СОСТАВУ» | ШТ. |

1 |

* Рейтинг — количество пользователей, которые выбрали это наименование, как наиболее подходящее для данного штрих-кода

Поиск: Разбор слова составу

морфемного разбора слова, разбора по составу (корневой суффикс, префикс, окончание). Разбор состава (морфемы) слова «sloppy» Морфемный разбор слова sloppy

Разбор слова по составу один из видов лингвистических исследований, цель которого — определить структуру или состав слова, классифицировать морфемы по месту в слове и установить значение каждой из них. В школьной программе это также называется синтаксический анализ морфемы … Сайт с практическими рекомендациями поможет правильно разобрать любую часть речи онлайн: существительное, прилагательное, глагол, местоимение, причастие, причастие, наречие, числительное.

План: Как разобрать слово?

При синтаксическом разборе морфем соблюдайте определенную последовательность выделения значимых частей.

- Запишите слово так же, как и в домашнем задании. Прежде чем приступить к разборке сочинения, выясните его лексическое значение (значение).

- Определите из контекста, к какой части речи он относится. Вспомните особенности слов, относящихся к этой части речи:

- изменчивый (имеет окончание) или неизменный (не имеет окончания)

- есть ли у него формирующий суффикс?

- Найдите концовку. Для этого склоняйтесь по регистру, меняйте число, пол или человека, спрягайте — переменная часть будет окончанием.Помните об изменяемых словах с нулевым окончанием, обязательно укажите, если оно есть: sleep (), friend (), audibility (), gratitude (), ate ().

- Выделите основу слова как часть без окончания (и формирующего суффикса).

- Обозначьте префикс в базе (если есть). Для этого сравните одинаковые корневые слова с префиксами и без них.

- Определите суффикс (если есть). Для проверки сопоставьте слова с разными корнями и с одним и тем же суффиксом, чтобы они выражали одно и то же значение.

- Найдите корень в основании. Для этого сравните несколько связанных слов. Их общая часть — это корень. Запомните одни и те же корневые слова с чередующимися корнями.

- Если в слове два (или более) корня, обозначьте соединяющую гласную (если есть): листопад, звездолет, садовник, пешеход.

- Отметьте формирующие суффиксы и постфиксы (если есть)

- Еще раз проверьте синтаксический анализ и выберите все значимые части с помощью значков

В начальной школе разобрать слово — означает выделить окончание и основу, затем обозначить префикс суффиксом, подобрать одинаковые корневые слова и затем найти их общую часть: корень, и все.

* Примечание: Минобрнауки России рекомендует для общеобразовательных школ три учебных комплекса по русскому языку в 5-9 классах. У разных авторов морфемный анализ по составу отличается подходом. Чтобы избежать проблем с домашним заданием, сравните приведенный ниже порядок анализа с вашим учебником.

У разных авторов морфемный анализ по составу отличается подходом. Чтобы избежать проблем с домашним заданием, сравните приведенный ниже порядок анализа с вашим учебником.

Порядок полного синтаксического анализа морфем по составу

Во избежание ошибок предпочтительно связывать синтаксический анализ морфем с деривационным синтаксическим анализом.Такой анализ называется формально-семантическим.

- Определите часть речи и проведите графический морфемный анализ слова, то есть обозначьте все доступные морфемы.

- Выпишите окончание, определите его грамматическое значение. Укажите суффиксы словоформы (если есть)

- Запишите основу слова (без формирующих морфем: окончаний и формирующих суффиксов)

- Найдите морфемы. Выпишите суффиксы и префиксы, обоснуйте их выбор, объясните их значение

- Корень: свободный или связанный.Для слов со свободными корнями составьте цепочку словообразования: «напиши-то → напиши-напиши → напиши-ое», «dry (oh) → dry-ar () → dry-ar-nits» — (а) «.

Для слов со связанными корнями выберите слова с единой структурой: «платье-раздевание-переодевание».

Для слов со связанными корнями выберите слова с единой структурой: «платье-раздевание-переодевание». - Запишите корень, подберите одинаковые корневые слова, укажите возможные варианты, чередование гласных или согласных в корнях.

Как найти морфему в слове?

Пример полного морфемного синтаксического анализа глагола «спал»:

- окончание «а» указывает на женскую форму глагола, единственного числа, прошедшего времени, сравните: проспал;

- основание гандикапа «проспал»;

- два суффикса: «a» — суффикс основы глагола, «l» — этот суффикс, образует глаголы прошедшего времени,

- приставку «pro» — действие со значением потери, неудобства, ср.: просчитаться, проиграть, упустить;

- словообразовательная цепочка: сон — проспал — проспал;

- корень «cn» — в родственных словах возможны чередования cn // cn // sleep // syp. Однокорневые слова: сон, засыпание, сонливость, недосыпание, бессонница.

Неаккуратная схема парсинга:

Неряшливая

Разбор словесной композиции.

Состав слова «sloppy»:

Соединительная гласная: отсутствует

Постфикс: отсутствует

Морфемы — части слова sloppy

carelessДетальный разбор слова в a неосторожный способ.Слово cope, префикс, суффикс и окончание слова. Мофема разбор слова неаккуратна, его схема и часть слова (морфология).

- Схема морфем: sloppy / n / a

- Структура слова по морфемам: корень / суффикс / окончание

- Схема (построение) слова sloppy по составу: корень sloppy + суффикс n + окончание th

- Список морфем в слове коряво:

- небрежно — корень

- n — суффикс

- th — конец

- Типы морфов и их количество в слове неаккуратное:

- доставка: отсутствует — 0

- королева: небрежно — 1

- соединение лед: отсутствует — 0

- cyffix: n — 1

- постфикс: отсутствует — 0

- конец: th — 1

Все морфемы в слове: 3.

Производный синтаксический анализ слова sloppy

- Основа слова: небрежно ;

- Словообразовательные аффиксы: префикс отсутствует , суффикс

n , постфикс отсутствует ; - Словообразование: ○ суффикс ;

- Способ обучения: производная, так как образуется в 1 (один) способ .

См. Также другие словари:

Однокорневые слова … это слова с корнем … принадлежащие к разным частям речи, и в то же время близкие по значению… Слова с тем же корнем, что и у слова sloppy

Как будет слово sloppy в единственном и множественном числе. Словенский дословно

Полный морфологический анализ слова «небрежный»: часть речи, начальная форма, морфологические особенности и формы слова. Направление науки о языке, где это слово изучается … Морфологический разбор sloppy

Ударение в слове небрежно: какой слог ударен и как … Слово «небрежный» правильно пишется как… Ударение в слове sloppy

Синонимов к слову sloppy. Онлайн-словарь синонимов: найдите синонимы к слову «небрежный». Синонимические слова, похожие слова и похожие выражения в … Синонимы к небрежному

Онлайн-словарь синонимов: найдите синонимы к слову «небрежный». Синонимические слова, похожие слова и похожие выражения в … Синонимы к небрежному

Антонимы … имеют противоположное значение, различаются по звучанию, но относятся к одной и той же части речи … Антонимы к небрежному

Анаграммы (составьте анаграмма) к слову sloppy, смешивая буквы … Анаграммы для слова sloppy

Морфемический разбор слова sloppy

Морфемный разбор слова обычно называют разбором слова по составу — это поиск и анализ морфемы (части слова), входящие в данное слово.

Морфемный синтаксический анализ слова sloppy очень прост. Для этого достаточно соблюдать все правила и порядок разбора.

Давайте проведем морфемный синтаксический анализ правильно, для этого нам достаточно пройти 5 шагов:

- определение части речи слова — первый шаг;

- второй — выбираем окончание: для изменчивых слов сопрягаем или раздуваем, для неизменяемых (герундий, наречия, некоторые существительные и прилагательные, официальные части речи) — окончаний нет;

- дальше ищем основу.

Это самая легкая часть, потому что для определения основы вам просто нужно отрезать конец. Это будет основой слова;

Это самая легкая часть, потому что для определения основы вам просто нужно отрезать конец. Это будет основой слова; - Следующий шаг — поиск корня слова. Подбираем родственные слова для неосторожных (их еще называют однокорневыми), тогда корень слова будет очевиден;

- Остальные морфемы мы находим, выбирая другие слова, образованные таким же образом.

Как видите, синтаксический анализ морфемы выполняется просто. Теперь давайте определим основные морфемы слова и проанализируем их.

* Морфемный синтаксический анализ слова (синтаксический анализ слов) — поиск корня, префиксов, суффиксов, окончаний и основных слов Парсинг слова по составу на сайте производится по словарю морфемного разбораНеаккуратная схема парсинга:

небрежная

Разбор словесной композиции.

Состав слова «небрежно»:

Соединительная гласная: отсутствует

Постфикс: отсутствует

Морфемы — части слова случайно

случайно Подробная разбивка слова небрежно составленный. Слово cope, префикс, суффикс и окончание слова. Мофема небрежное расположение слова, его схема и части слова (морфология).

Слово cope, префикс, суффикс и окончание слова. Мофема небрежное расположение слова, его схема и части слова (морфология).

- Схема морфем: небрежный / н / о

- Структура слова по морфемам: корень / суффикс / суффикс

- Схема (построение) слова небрежно в составе: корень небрежный + суффикс n + суффикс o

- Список морфем словом случайно:

- небрежный — корень

- n — суффикс

- o — суффикс

- Типы морфов и их количество в слове неаккуратно:

- доставка: отсутствует — 0

- королева: небрежно — 1

- соединение ледяное: отсутствует — 0

- cyffix: но — 2

- постфикс: отсутствует — 0

- конец: нулевое окончание.–0

Все морфемы в слове: 3.

Производный синтаксический анализ слова неаккуратно

- Основа слова: случайно ;

- Словообразовательные аффиксы: префикс отсутствует , суффикс но , постфикс отсутствует ;

- Словообразование: ○ суффикс ;

- Способ обучения: производная, так как образуется в 1 (один) способ .

См. Также другие словари:

Однокорневые слова… это слова с корнем … принадлежащие к разным частям речи, и в то же время близкие по значению … Однокорневые слова к слову случайно

Какое слово в слово случайно в единственном и множественном числе . Склонение слова «небрежно» в падежах

Полный морфологический анализ слова «небрежно»: часть речи, начальная форма, морфологические особенности и формы слова. Направление науки о языке, где изучается слово … Неосторожный морфологический разбор

Ударение в слове невнимательное: на какой слог ударение и как… Слово «небрежно» написано правильно как … Ударение в слове неосторожно

Синонимы к слову «небрежно». Онлайн-словарь синонимов: найдите синонимы к слову «небрежно». Синонимы, похожие слова и похожие выражения в … Синонимы к неосторожному

Антонимы … имеют противоположное значение, различаются по звучанию, но относятся к одной и той же части речи … Антонимы к случайному

Анаграммы анаграмма) к слову случайно, путём смешивания букв . .. Анаграммы для слова случайно

.. Анаграммы для слова случайно

Неосторожный разбор морфемного слова

Морфемный разбор слова обычно называют разбором слова по составу — это поиск и анализ морфем ( части слова), входящие в данное слово.

Морфемный разбор слова обычно выполняется очень просто. Для этого достаточно соблюдать все правила и порядок разбора.

Давайте проведем морфемный синтаксический анализ правильно, для этого нам достаточно пройти 5 шагов:

- определение части речи слова — первый шаг;

- второй — выбираем окончание: для изменчивых слов сопрягаем или раздуваем, для неизменяемых (герундий, наречия, некоторые существительные и прилагательные, официальные части речи) — окончаний нет;

- дальше ищем основу.Это самая легкая часть, потому что для определения основы вам просто нужно отрезать конец. Это будет основой слова;

- Следующий шаг — поиск корня слова. Родственные слова подбираем по неаккуратности (их еще называют однокорневыми), тогда корень слова будет очевиден;

- Остальные морфемы мы находим, выбирая другие слова, образованные таким же образом.

Как видите, синтаксический анализ морфемы выполняется просто. Теперь давайте определим основные морфемы слова и проанализируем их.

* Морфемный синтаксический анализ слова (синтаксический анализ слов) — поиск корня, префиксов, суффиксов, окончаний и основных слов Парсинг слова по составу на сайте производится по словарю морфемного разбора(PDF) Разбор GLR с несколькими грамматиками для запросов естественного языка

Разбор GLR с несколькими грамматиками для запросов естественного языка • 143

Транзакции ACM по обработке информации на азиатских языках, Vol. 1, No. 2, June 2002.

работает с соответствующим субпарсером.Мы объединяем выходы субпарсеров

вместе, чтобы сформировать общий синтаксический анализ входной строки. Наши экспериментальные результаты показывают, что

разбиение грамматики может уменьшить общий размер таблицы синтаксического анализа на порядок,

по сравнению с использованием одной контекстно-свободной грамматики, полученной из обучающих наборов ATIS

. Полный анализ синтаксического анализа одного синтаксического анализатора GLR такой же, как подходы для синтаксического анализа

Полный анализ синтаксического анализа одного синтаксического анализатора GLR такой же, как подходы для синтаксического анализа

. Однако композиция синтаксического анализатора может производить частичный синтаксический анализ, и

, таким образом, достигает более высокой точности понимания.Мы также сравнили две стратегии составления синтаксического анализатора

: каскадирование и прогнозирующее сокращение. Каскадирование применяет субпарсеры в каждой позиции

во входной строке (или решетке) в порядке, указанном вызывающим графом коллекции субграмматик

. Мы использовали алгоритм кратчайшего пути, чтобы найти лучший путь

через несколько выходов подпарсера, чтобы охватить всю входную строку. Predictive

pruning следует ограничениям предсказания левого угла при вызове различных подпараметров

и, следовательно, более эффективен с точки зрения вычислений, чем каскадирование.Дополнительные вычисления

в каскаде (по сравнению с прогнозирующим сокращением) расходуются на производство

дополнительных частичных синтаксических анализов, поскольку каскадирование позволяет синтаксическим деревьям начинаться и заканчиваться во всех местах

входного предложения. Текущая работа включает в себя разработку подхода к композиции гибридного анализатора

Текущая работа включает в себя разработку подхода к композиции гибридного анализатора

, встроенного в архитектуру мультипарсера, которая может составлять

различных синтаксических анализаторов (синтаксический анализатор GLR, синтаксический анализатор Эрли и т. Д.). Мы также экспериментируем с

с автоматическими методами разбиения грамматик. для замены ручного процесса, а также

, поскольку включает вероятности ранжирования альтернативных деревьев синтаксического анализа в выходных данных данных WSJ

в Penn Treebank.

БЛАГОДАРНОСТЬ

Мы хотели бы поблагодарить нескольких анонимных рецензентов за их комментарии и предложения.

СПИСОК ЛИТЕРАТУРЫ

ЭБНИ, С. 1991. Разбор по частям. В «Принципиальный синтаксический анализ: вычисления и психолингвистика», R. C.

Berwick et al., Eds. Kluwer Academic Publishers, 1991.

AHO, A., SETHI, I, R. и ULLMAN, J. 1986. Компиляторы: принципы, методы и инструменты. Addison-Wesley,

Reading, MA: 1986.

AMTRUP, J.1995. Параллельный анализ: разные схемы распределения диаграмм. В материалах 4-го международного семинара

по технологиям синтаксического анализа (ACL / SIGPARSE, сентябрь 1995 г.), 12-13.

EARLEY, J. 1968. Эффективный контекстно-свободный алгоритм синтаксического анализа. Кандидат наук. диссертация, Университет Карнеги-Меллона,

Питтсбург, Пенсильвания, 1968.

ХИЛЛИЕР Ф. С. и ЛИБЕРМАН Г. Дж. 1995. Введение в исследования операций. 6-е изд. McGraw-Hill, 1995.

ДЖОНСОН, С.С. 1975. YACC: еще один компилятор компилятора.Tech. Rep. CSTR 32, Bell Laboratories,

Murray Hill, NJ., 1975.

KITA, K., MORIMOTO, T. и SAGAYAMA, S. 1993. Анализ LR с тестом достижимости категорий, примененный к распознаванию речи

. IEICE Trans. Инф. Syst. Е 76-Д, 1 (1993), 23-28.

KITA, K., TAKEZAWA, T., HOSAKA, J., EHARA, T. и MORIMOTO, T. 1990. Распознавание непрерывной речи

с использованием двухуровневого анализа LR. В материалах Международной конференции по разговорному языку

Processing, 21. 3.1, 905-908.

3.1, 905-908.

КИТА, К., ТАКЕЗАВА, Т. и МОРИМОТО, Т. 1991. Распознавание непрерывной речи с использованием двухуровневого анализа LR.

IEICE Пер. Е 74, 7 (1991), 1806-1810.

КОРЕНЯК А. 1969. Практический метод построения LR (k). Commun. ACM 12, 11 (ноябрь 1969).

LUK, P. C., MENG, H., and WENG, F. 2000. Грамматическое разбиение и состав синтаксического анализатора для понимания естественного языка.

. В материалах Международной конференции по обработке разговорной речи (Пекин,

2000).

Добросовестная морфема. Разбор состава (морфемы) слова «прилежный». Как найти морфему в слове

Разбор словесной композиции.

Состав слова «усердный»:

Морфемный разбор слова усердный

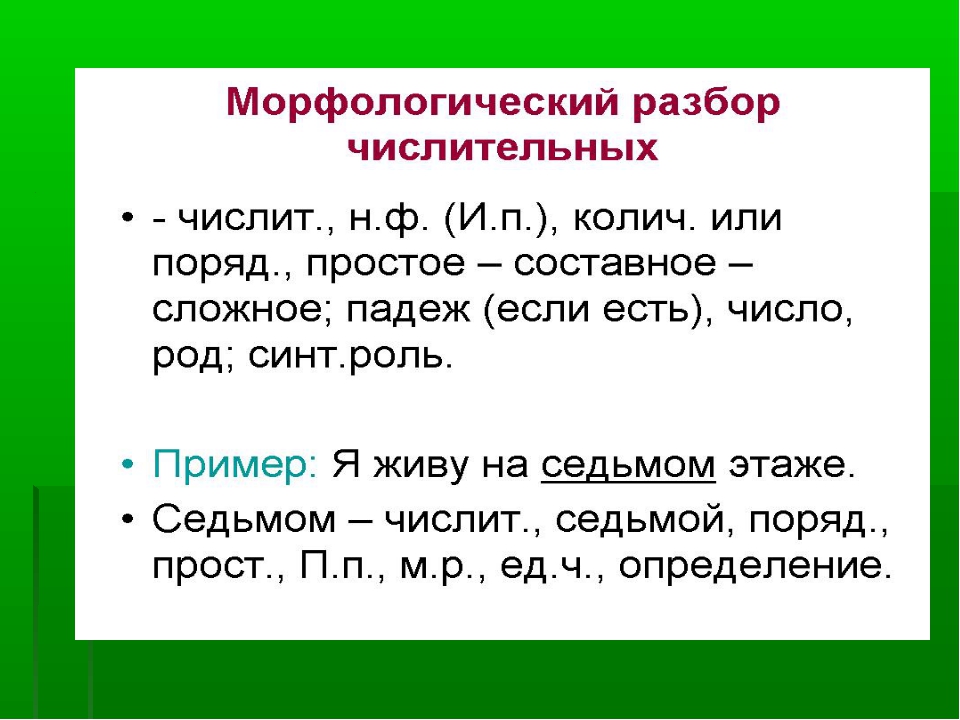

Морфемный разбор слова обычно называют разбором слова по составу — это поиск и анализ морфемы данного слова (части слова ).

Морфемный разбор слова прилежный очень прост.Для этого достаточно соблюдать все правила и порядок разбора.

Давайте сделаем синтаксический анализ морфемы правильным, но для этого достаточно пройти 5 шагов:

- определение части речи слова прилежный — первый шаг;

- второй — выбираем окончание: для изменчивых слов сопрягаем или раздуваем, для неизменяемых (герундий, наречия, некоторые существительные и прилагательные, официальные части речи) — окончаний нет;

- дальше ищем основу.

Это самая легкая часть, потому что для определения основы вам просто нужно отрезать конец. Это будет основой слова;

Это самая легкая часть, потому что для определения основы вам просто нужно отрезать конец. Это будет основой слова; - Следующий шаг — поиск корня слова. Подбираем родственные слова для усердных (их еще называют однокорневыми), тогда корень слова будет очевиден;

- Остальные морфемы для усердного мы находим, выбирая другие слова, образованные таким же образом, как и усердный.

Как видите, синтаксический анализ морфемы усердно проделан просто.Теперь давайте определимся с основными морфемами слова прилежный и проясним.

См. Также другие словари:

Какое слово означает прилежный в единственном и множественном числе …. Прилежный

Полный морфологический анализ слова «прилежный»: часть речи, начальная форма, морфологические признаки и словоформы. Направление науки о языке, где изучается слово … Морфологический разбор прилежный

Ударение в слове прилежное: на какой слог ударение и как… Слово «прилежный» правильно пишется как… Ударение в слове прилежный

Синонимы слова «прилежный». Онлайн-словарь синонимов: найдите синонимы к слову «прилежный». Слова-синонимы, похожие слова и похожие выражения в … Синонимы к слову прилежный

Онлайн-словарь синонимов: найдите синонимы к слову «прилежный». Слова-синонимы, похожие слова и похожие выражения в … Синонимы к слову прилежный

Разбор словесной композиции.

Состав слова «усердно»:

Морфемный разбор слова усердно

Морфемный разбор слова обычно называется разбором слова по составу — это поиск и анализ морфем (частей слова), входящих в данное слово.

Морфемный разбор слова выполняется старательно очень просто. Для этого достаточно соблюдать все правила и порядок разбора.

Давайте сделаем морфемный синтаксический анализ правильно, и для этого нам достаточно пройти 5 шагов:

- Прилежное определение части речи слова — первый шаг;

- второй — выбираем окончание: для изменчивых слов сопрягаем или раздуваем, для неизменяемых (герундий, наречия, некоторые существительные и прилагательные, официальные части речи) — окончаний нет;

- дальше ищем основу.Это самая легкая часть, потому что для определения основы вам просто нужно отрезать конец.

Это будет основой слова;

Это будет основой слова; - Следующий шаг — поиск корня слова. Мы старательно подбираем родственные слова для (их еще называют однокорневыми), тогда корень слова будет очевиден;

- Мы находим остальные морфемы для усердно, выбирая другие слова, которые сформированы таким же образом, как усердно.

Как видите, парсинг морфемы старательно делается просто.Теперь давайте тщательно определим основные морфемы слова и проанализируем их.

См. Также другие словари:

Что означает слово «усердно» в единственном и множественном числе. Склонение слова усердно

Полный морфологический анализ слова «усердно»: часть речи, начальная форма, морфологические признаки и формы слова. Направление науки о языке, где изучается слово … Морфологический разбор усердно

Ударение в слове старательное: на какой слог падает ударение и как… Слово «прилежно» правильно написано как … Ударение в слове прилежное

Разбор слова по составу один из видов лингвистических исследований, цель которого — определить структуру или состав слова, классифицировать морфемы по месту в слове и установить значение каждой из них. В школьной программе это также называется разбор морфем … Сайт с практическими рекомендациями поможет вам правильно разобрать любую часть речи онлайн: существительное, прилагательное, глагол, местоимение, причастие, причастие, наречие, числительное.

В школьной программе это также называется разбор морфем … Сайт с практическими рекомендациями поможет вам правильно разобрать любую часть речи онлайн: существительное, прилагательное, глагол, местоимение, причастие, причастие, наречие, числительное.

План: Как разобрать слово?

При синтаксическом разборе морфем соблюдайте определенную последовательность выделения значимых частей … Начните с того, чтобы «убрать» морфемы с конца, методом «раздевания корня». Подходите к анализу осмысленно, избегайте бездумных разделений. Определите значения морфем и выберите одинаковые корневые слова, чтобы подтвердить правильный анализ.

- Запишите слово так же, как и в домашнем задании. Прежде чем приступить к разборке композиции, выясните ее лексическое значение (значение).

- Определите из контекста, к какой части речи он относится. Вспомните особенности слов, относящихся к этой части речи:

- изменчивый (имеет окончание) или неизменный (не имеет окончания)

- есть ли у него формирующий суффикс?

- Найдите концовку.

Для этого в склонении по падежу измените число, пол или лицо, спрягите — переменная часть будет окончанием. Помните о изменяемых словах с нулевым окончанием, обязательно обозначьте, если оно есть: sleep (), friend (), audibility (), gratitude (), ate ().

Для этого в склонении по падежу измените число, пол или лицо, спрягите — переменная часть будет окончанием. Помните о изменяемых словах с нулевым окончанием, обязательно обозначьте, если оно есть: sleep (), friend (), audibility (), gratitude (), ate (). - Выделите основу слова как часть без окончания (и формирующего суффикса).

- Обозначьте префикс в базе (если есть). Для этого сравните одинаковые корневые слова с префиксами и без них.

- Определите суффикс (если есть). Для проверки сопоставьте слова с разными корнями и с одним и тем же суффиксом, чтобы они выражали одно и то же значение.

- Найдите корень в основании. Для этого сравните несколько связанных слов. Их общая часть — это корень. Запомните одни и те же корневые слова с чередующимися корнями.

- Если в слове два (или более) корня, обозначьте соединяющую гласную (если есть): листопад, звездолет, садовник, пешеход.

- Отметьте формирующие суффиксы и постфиксы (если есть)

- Еще раз проверьте синтаксический анализ и выберите все значимые части с помощью значков

В первичных классах разобрать слово — означает выделить окончание и основу, затем обозначить префикс суффиксом, выбрать одинаковые корневые слова и затем найти их общую часть: корень, и все.

* Примечание: Минобрнауки России рекомендует для общеобразовательных школ три учебных комплекса по русскому языку в 5-9 классах. У разных авторов морфемный анализ по составу отличается подходом. Чтобы избежать проблем с выполнением домашнего задания, сравните приведенный ниже порядок синтаксического анализа с вашим учебником.

Порядок полного синтаксического анализа морфем по составу

Во избежание ошибок предпочтительно связывать синтаксический анализ морфем с деривационным синтаксическим анализом.Такой анализ называется формально-семантическим.

- Определите часть речи и проведите графический морфемический анализ слова, то есть обозначьте все доступные морфемы.

- Запишите окончание, определите его грамматическое значение. Укажите суффиксы словоформы (если есть)

- Запишите основу слова (без формирующих морфем: окончаний и формирующих суффиксов)

- Найдите морфемы. Выпишите суффиксы и префиксы, обоснуйте их выбор, объясните их значение

- Корень: свободный или связанный.

Для слов со свободными корнями составьте цепочку словообразования: «напиши-то → напиши-напиши → напиши-ое», «dry (oh) → dry-ar () → dry-ar-nits» — (а) «. Для слов со связанными корнями выберите слова с единой структурой: «платье-раздевание-переодевание».

Для слов со свободными корнями составьте цепочку словообразования: «напиши-то → напиши-напиши → напиши-ое», «dry (oh) → dry-ar () → dry-ar-nits» — (а) «. Для слов со связанными корнями выберите слова с единой структурой: «платье-раздевание-переодевание». - Запишите корень, подберите одинаковые корневые слова, укажите возможные варианты, чередование гласных или согласных в корнях.

Как найти морфему в слове?

Пример полного морфемного синтаксического анализа глагола «спал»:

- окончание «а» указывает на форму глагола женского рода, единственного числа, прошедшего времени, сравните: проспал;

- основание гандикапа «проспал»;

- два суффикса: «a» — суффикс основы глагола, «l» — этот суффикс, образует глаголы прошедшего времени,

- приставку «pro» — действие со значением потери, неудобства, ср.: просчитаться, проиграть, упустить;

- словообразовательная цепочка: сон — проспал — проспал;

- корень «cn» — в родственных словах возможно чередование cn // sn // sleep // syp.

Однокорневые слова: сон, засыпание, сонливость, недосыпание, бессонница.

Однокорневые слова: сон, засыпание, сонливость, недосыпание, бессонница.

синонимов, антонимов и парсинговых слов. Как пишется слово «дольше»?

К какой части речи относится слово «длиннее»? Ответ на этот вопрос вы узнаете из материалов этой статьи.Кроме того, мы расскажем, как разобрать такую лексическую единицу по ее составу, какой синоним можно заменить и так далее.

Общая информация

Как правильно написать слово «длиннее» знает почти каждый. Но не все знают, к какой части речи идет речь. В связи с этим предлагаем начать нашу статью с разъяснения именно этого вопроса.

Определить часть речи

Чтобы определить, какая часть речи принадлежит слову «длиннее», его следует указать в его исходной форме — «длинный».Далее требуется задать подходящий вопрос: «что?» — длинный. Следовательно, это имя — прилагательное. Но здесь возникает новый вопрос: почему слово «более длинный» оканчивается не на -е или -е, а на -е? Для этого необходимо вспомнить особенности названий прилагательных.

Степени сравнения прилагательных

Все качественные прилагательные имеют такой вариативный морфологический признак, как степень сравнения. Из школьной программы мы знаем, что в русском языке есть две степени:

Рассмотрим их подробнее.

Превосходная степень

Такой знак указывает на наименьшую или наибольшую степень проявления признака (например, самая высокая гора) или на очень маленькую или большую степень проявления признака (например, на самого доброго человека).

Следует особо отметить, что отличная степень прилагательных образуется путем добавления к основным словам суффиксов -yush- или -aish-, приставок большинства, а также дополнительных лексических единиц «самый», «самый», «наименее», «все» или «все».

Как мы выяснили выше, слово «длиннее» — это прилагательное имени. Однако он не стоит в высшей степени, поскольку не показывает суффиксы -yesh- или -aish-, префиксы большинства, а также дополнительные лексические единицы «большинство», «большинство», «меньше всего», «все» или «всего».

сравнительный

Такой знак названий прилагательных указывает (например, Маша выше Саши, это озеро глубже того) или на этот предмет, но в другом случае (Маша выше, чем была в прошлом году, здесь озеро глубже, чем в том).

Следует отметить, что сравнительная степень формируется на основе названий прилагательных с помощью суффиксов типа -sh / -e-ee (-e) и -e (например, выше, быстрее, раньше, глубже), префиксов (например, новее), а также из других основ (например, хорошо — лучше, хуже — хуже) или дополнительных лексических единиц (более или менее).

Из всего вышесказанного мы можем с уверенностью сказать, что слово «дольше» является прилагательным в сравнительной степени. Он будет состоять из основания слова long и суффикса her.

Как пишется слово «дольше»?

О том, как написано это слово, знает практически каждый. Хотя некоторые люди на момент написания все же могут ошибаться. Например, довольно часто в письме встречается выражение: «Посмотрим, у кого нос длиннее». Это ошибочное написание слова. В конце концов, его следует использовать только с двумя буквами «n». Чтобы доказать это утверждение, приведем соответствующее правило русского языка.

Это ошибочное написание слова. В конце концов, его следует использовать только с двумя буквами «n». Чтобы доказать это утверждение, приведем соответствующее правило русского языка.

Слово «более длинный» образовано от начальной формы прилагательного «длинный».Как видите, в нем две буквы «n». Ведь, в свою очередь, такая лексическая единица произошла от существительного «длина» с добавлением суффикса -n-. Следовательно, и «длинный», и «длинный» пишутся только с двойным «n». Приведем наглядный пример:

- Ее платье длиннее моего.

- Она намного длиннее своей подруги.

- Дольше трассы я не видел в жизни.

- Он был настолько длинным, что с трудом поместился в машине.

Кстати, в этой лексической единице некоторые сомневаются в правильности написания буквы «и».Например, часто в тексте можно встретить слово «еще». Как в этом случае это проверить? Для этого следует применить правило, которое применяется к безударным гласным в корне слова. То есть к представленной лексической единице требуется выбрать такое проверочное слово, в котором сомнительная буква будет находиться в ударной позиции. Например, «длина». Как видите, буква «и» в этом слове подчеркнута. Поэтому правильнее будет быть «длиннее».

Например, «длина». Как видите, буква «и» в этом слове подчеркнута. Поэтому правильнее будет быть «длиннее».

Морфемный анализ слова

Нередко учителя просят своих учеников произвести разбор слова по композиции.«Лонгер» — лексическая единица, которую довольно проблематично подвергнуть морфемическому анализу. Однако мы рассмотрели выше, как образовано это слово. Поэтому разобрать его по составу несложно.

Итак, проведем морфемный анализ названия прилагательного «длиннее», которое стоит в сравнительной степени:

- Определим окончание. В данном случае это ноль.

- Определяем приставку. В нашем случае префикс отсутствует.

- Определите суффикс.Сравнительный суффикс в этом слове — -e-. Также есть суффикс -n-, относящийся к основанию.

- Определить корень. Корень этого слова — «длина».

- Определяем основу. Основа имени прилагательного — «длиннее» — «долго».

Подбираем синоним

Синонимами в русском языке называют слова одной части речи, разные по написанию и звучанию, но имеющие схожее лексическое значение. Приведем наглядный пример:

Приведем наглядный пример:

- small — малый;

- large — большой;

- beautiful — красиво;

- некрасиво — ужасно;

- хочу — желание;

- talk — разговор;

- большой — большой;

- create — создать;

- вещь объект;

- die — погибнуть;

- to keep — защелкнуть;

- холодный — не теплый;

- медленно — медленно и так далее.

Таким образом, синоним слова «длиннее» должен быть названием прилагательного и по возможности стоять в сравнительной степени. Например:

- длиннее — удлиненная;

- длиннее — длиннее;

- длиннее — растянуто;

- длиннее — более продолжительное;

- длиннее — выше;

- длиннее — длиннее и тд.

Однако следует отметить, что синонимы к этому слову следует подбирать так, чтобы в контексте они выглядели естественно.Было бы ошибкой сказать: «Он длиннее его», так как нужно сказать: «Он выше ее».

Подбираем антонимы

Антонимами в русском языке называют слова одной и той же части речи, которые отличаются по написанию и звучанию, но имеют прямо противоположные лексические значения.

- true False;

- красиво — некрасиво;

- говори — молчи;

- холодный — горячий;

- длинный короткий;

- морозно-горячий;

- большой маленький;

- fast — медленный;

- бегать — стоять;

- добрый злой;

- высокий Низкий;

- плохо хорошо и тд.

Итак, попробуем найти антоним слову «длиннее»:

- long — короче;

- длиннее — меньше.

Аналогичным образом можно выбрать синонимы и антонимы для начальной формы прилагательного «длинный». Например: высокий, длинный, удлиненный и короткий, лаконичный, короткий и так далее.

Земной суффикс. «Земля» — морфемный анализ слова, анализ композиции (корень soffix, приставка, окончание)

Схема анализа состава Земля:

земля

Продам слова в композиции.

Состав слова «земля»:

Соединительные гласные: отсутствует

POCTFICC: отсутствует

Морфемы — части слова Земля

земля Подробная PAZBOP Calway Earth Po Cost. Коппи, префикс, суффикс и конечные слова. MOPFEM PAZBOP CERVA EARTH, EGO CXEMA и МИНУСЫ (MOPFEM).

Коппи, префикс, суффикс и конечные слова. MOPFEM PAZBOP CERVA EARTH, EGO CXEMA и МИНУСЫ (MOPFEM).

- Схема морфем: Земля / I

- Структура слова Морфема: Корень / Окончание

- Схема (дизайн) Слова Земля в составе: земля корень + конец

- Список морфем в слове Земля:

- Bid MopFEM и их число в слове Земля:

- собственно

- : отсутствует — 0

- copa: земля — 1

- cOEDINITE HLACHNA: отсутствует — 0

- cyFFICC: отсутствует -0

- pOCTFICC: отсутствует — 0

- выезд: и — 1

BCEGO MORFEM в CLA: 2.

Словообразующее слово Слово

См. Также в других словарях:

Отдельные слова … Это слова, имеющие корень … принадлежащие к разным частям речи, и в то же время близкие по значению … Отдельные слова к слову Земля

Заглушите слово Земля для падежей в единственном и кратном числе …. Склонение слова Земля для Пада

Полный морфологический анализ слова «Земля»: часть речи, исходная форма, морфологические признаки и форма слова. Направление языкознания, где изучается слово… Морфологический анализ земля

Направление языкознания, где изучается слово… Морфологический анализ земля

Ударение в слове Земля: на какой слог падает ударение и как … слово «земля» правильно пишется как … Курс земли

Синонимы «Земля». Словарь синонимов онлайн: Подберите синонимы к слову «земля». Пел синонимы, похожие слова и близкие по смыслу выражения в … Кононимы к слову Земля

Антонимы … имеют противоположное значение, разные по звучанию, но относятся к одной и той же части речи … Антонимы для слово Земля

Анаграммы (составьте анаграмму) к слову Земля с помощью движущихся букв…. Анаграмма к слову Земля

Слово из букв составляют анаграмму. Вы ввели буквы «Земля», можете составить следующие слова из … Составьте слова из заданных букв земля

К чему снится земля толкование снов, узнайте бесплатно в нашем соннике, что означает мечта о земле. … увиденная во сне земля означает, что … Сонник: К чему снится земля

Разбор слова Морфем

Анализ слова Морфем принято называть анализом слов по составу — это поиск и анализ Морфам входит в указанное слово (части слова).

Морфемный анализ слов Земля очень прост. Для этого соблюдайте все правила и порядок проведения анализа.

Сделайте это анализ морфемы Это верно, и для этого мы просто пройдем через 5 шагов:

- определение слова «речь» — это первый шаг;

- второй — выделяем окончание: для изменяющихся слов мы прячем или склоняем, для неизменяемого (глагольные духи, наречия, некоторые имена существительных и имена прилагательных, официальные части речи) — окончания не являются ;

- дальше ищем основу.Это самая легкая часть, ведь для определения основы нужно просто отрезать конец. Это будет основой слова;

- На следующем шаге нужно найти корень слова. Подбираем родственные слова для Земли (их еще называют одноручными), тогда корень слова будет очевиден;

- Мы находим оставшиеся морфемы, выбирая другие слова, образованные таким же образом.

Как видите, анализ морфем Делается просто.Теперь определимся с основными морфемами слова и проведем его разбор.

земля

Состав слова «земля» :

корень — [Земля], окончание — [I]

Предлагает со словом «Земля»

И он пришел внезапно: за его спиной ничего нет , край, земля рушится, и только тьма у стены, звезды, вечный холод.

Но вторая рука Рубахина, швартовная машина на земле, взобралась на него и с изрезанным ртом с красивыми губами и легким дрожащим вздохом.

Так, наверное, старый дуб нащупывает свою кукурузу, шаркая корнями из земли.

Планер получает достаточно энергии, чтобы оторваться от земли и взлететь с холма.

Дед снимает ощущение сырости кожи, вытряхивает из них мелкие камешки, землю, потом выдавливает оттуда пучки бархатистой специальной альпийской травы, которую для мягкости закладывают в сенсоры.

Кроме того, эта же техника позволит быстро и засыпать землю под кустарники и клумбы.

Однако сделать это им не удалось: над тоннелем Stater слой льда и суши.

Вот кубанцев, скажем так, можно сортировать, потому что земля у них голая, как пальма …

Текст этой лекции стал популярным, но министерство образования одной из земель ФРГ запретило ее вузам.

Слово разбирать по составу, что это значит?

Свернуть слова в композиции Один из видов лингвистических исследований, цель которого — определить структуру или состав слова, классифицировать морфемы по месту в слове и установить значение каждой из них.В школьной программе также называется морфемный анализ . Сайт HOW-TO-ALL поможет вам правильно разобрать в составе онлайн любую часть речи: существительное, прилагательное, глагол, местоимение, причастие, глагол, наречие, числительное.

План: как слово разобрать?

При проведении морфемного анализа соблюдайте определенную последовательность выделения значимых частей. Начнем с того, чтобы «отстрелять» морфемы с конца, метод «сдирания корня». Подходите к анализу осмысленно, избегайте необдуманных разделений.Определите значения морфемы и выберите односторонние слова, чтобы подтвердить правильность анализа.

Подходите к анализу осмысленно, избегайте необдуманных разделений.Определите значения морфемы и выберите односторонние слова, чтобы подтвердить правильность анализа.

- Напишите слово в той же форме, что и в домашнем задании. Прежде чем приступить к разборке сочинения, выясните его лексическое значение (значение).

- Определите из контекста, к какой части речи он применяется. Вспомните особенности слов, относящихся к этой части речи:

- изменчивый (есть) или неизменный (нет конца)

- есть ли у него формирующий суффикс?

- Найди конец.Для этого подкрадитесь к корпусу, измените номер, род или грань, спрайты — вариативная часть будет завершением. Помните об изменении слов с нулевым окончанием, обязательно укажите, если это возможно: sleep (), friend (), слышание (), спасибо (), при попытке ().

- Выбрать основу слова — часть без конца (и образующий суффикс).

- Обозначить префикс (если он есть). Для этого сравните одноручные слова с консолями и без.

- Определите суффикс (если есть).Чтобы проверить, выберите слова с другими корнями и с тем же суффиксом, чтобы они выражали то же значение.

- Находим рут. Для этого сравните несколько связанных слов. Их общая часть — это корень. Помните о однокоренных словах с чередующимися корнями.

- Если в слове два (и более) корня, обозначьте соединительные гласные (если есть): листопад, звездчатый, садовник, пешеход.

- Отметить формообразующие суффиксы и постфиксы (если есть)

- Повторный анализ и значки выделяют все значимые части

В первичных классах разобрать слово — Означает выделить окончание и основание, после обозначения префикса суффиксом подобрать отдельные слова, а затем найти их общую часть: корень — и все.

* Примечание: Минобразования РФ рекомендует три учебных комплекса на русском языке в 5-9 классах общеобразовательных школ. З. разных авторов morphem Диффузный подход. Чтобы избежать проблем при выполнении домашнего задания, сравните описанную ниже процедуру с вашим учебным пособием.

Порядок полного морфемного анализа композиции

Во избежание ошибок морфемный анализ предпочтительнее ассоциировать с словообразованием. Этот анализ называется формально семантическим.

- Задать часть речи и выполнить графический морфемный анализ слов, то есть обозначить все доступные морфемы.

- Запишите окончание, определите его грамматические значения. Укажите суффиксы, образующие формулы (если есть)

- Запишите основу слова (без образования морфем: окончания и формирующие суффиксы)

- Найдите морфемы. Запишите суффиксы и консоли, обоснуйте их назначение, объясните их значения

- Root: Free or connected.Для слов со свободными корнями составьте словообразовательную цепочку: «Ине-ах → Писать», «сухой (ой) → dry-art () → dry-ar-nice — (но)». Для слов со связным корнем выберите слова с одной структурой: «Оденься и раздай маскировку».

- Напишите корень, выберите отдельные слова, укажите возможные варианты, чередование гласных или согласных звуков в корнях.

Как найти морфинг в слове?

Пример полной морфемы pavement глагола «спал»:

- конец «А» указывает на форму глагола женский, единицы, прошедшее время, ср .: Pospel-and;

- основа формы — «проспек»;

- два суффикса: «А» — суффикс глагольной основы, «л» — этот суффикс, образует глаголы прошедшего времени,

- приставка «Про» — действие со смыслом потери, нечувствительный, ср: По заплатить, проиграть, проникнуть;

- лечебная цепочка: Сон — Сон — Сон;

- корень «ИП» — по родственным словам есть чередования СП // СН // Сон // Сыр.Отдельные слова: сон, сон, сонливость, недосыпание, бессонница.

Как разобрать слово «земля»?

- Именительный падеж (какой?) — Земля;

- Родительский корпус (нет Что?) — Земля;

- Токопроводящий падеж (до чего дошел?) — На землю

- Винительный падеж (я вижу что?) — Земля;

- Сертификатный футляр (чем устраивает?) — Земля;

- Предлагаемый футляр (о чем говорили?) — Про Землю.

Анализ состава (или морфемный анализ) слова земля

Наша земля — одна из планет солнечной системы.

Земля — существительное женского рода с окончанием I:

земля, земля, земля, земля, земля, земля.

Основа слова земля.

Теперь найдите в слове основную его часть — корень.

Вспомните одноручные слова: землянка, земляне, земля, экскаватор, земля.

Итак, корень будет частью слова Земля // Земля.

Существительное земля различается по падежам и числам: