Слова «призывы» морфологический и фонетический разбор

Фонетический морфологический и лексический анализ слова «призывы». Объяснение правил грамматики.

Онлайн словарь Soosle.ru поможет: фонетический и морфологический разобрать слово «призывы» по составу, правильно делить на слоги по провилам русского языка, выделить части слова, поставить ударение, укажет значение, синонимы, антонимы и сочетаемость к слову «призывы».

Содержимое:

- 1 Слоги в слове «призывы» деление на слоги

- 2 Как перенести слово «призывы»

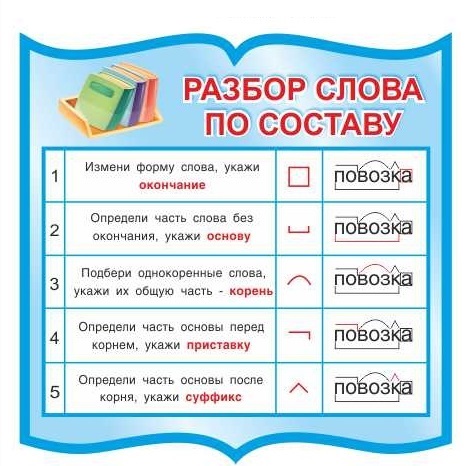

- 3 Морфологический разбор слова «призывы»

- 4 Разбор слова «призывы» по составу

- 5 Сходные по морфемному строению слова «призывы»

- 6 Синонимы слова «призывы»

- 7 Ударение в слове «призывы»

- 8 Фонетическая транскрипция слова «призывы»

- 9 Фонетический разбор слова «призывы» на буквы и звуки (Звуко-буквенный)

- 10 Предложения со словом «призывы»

- 11 Сочетаемость слова «призывы»

- 12 Значение слова «призывы»

- 13 Как правильно пишется слово «призывы»

- 14 Ассоциации к слову «призывы»

Слоги в слове «призывы» деление на слоги

Количество слогов: 3

По слогам: при-зы-вы

Как перенести слово «призывы»

при—зывы

призы—вы

Морфологический разбор слова «призывы»

Часть речи:

Имя существительное

Грамматика:

часть речи: имя существительное;

одушевлённость: неодушевлённое;

род: мужской;

число: множественное;

падеж: именительный, винительный;

отвечает на вопрос: (есть) Что?, (вижу/виню) Что?

Начальная форма:

призыв

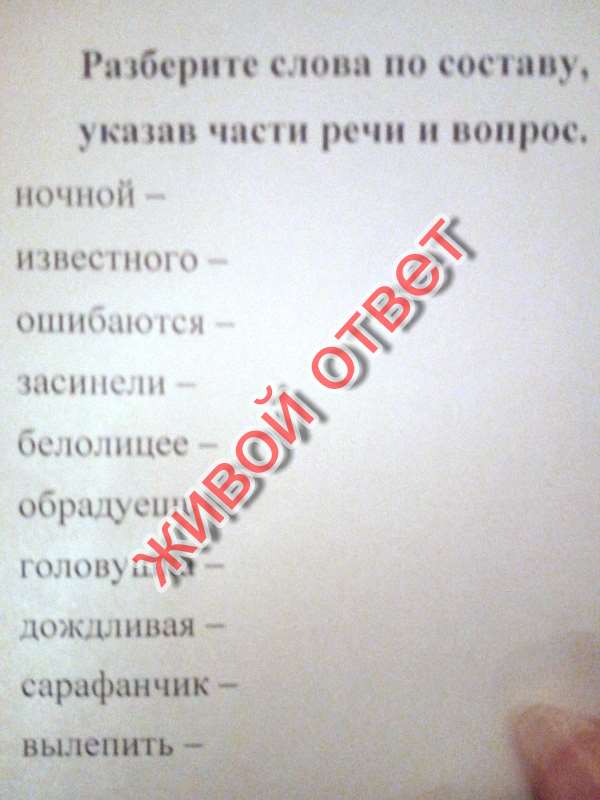

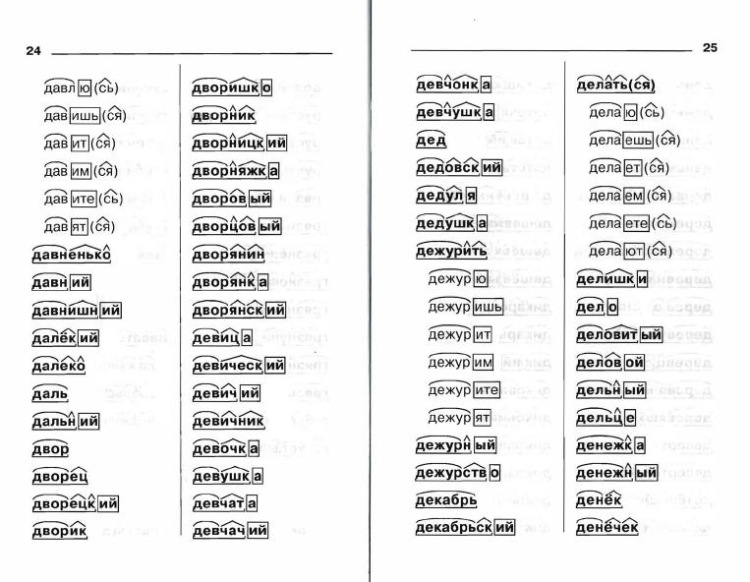

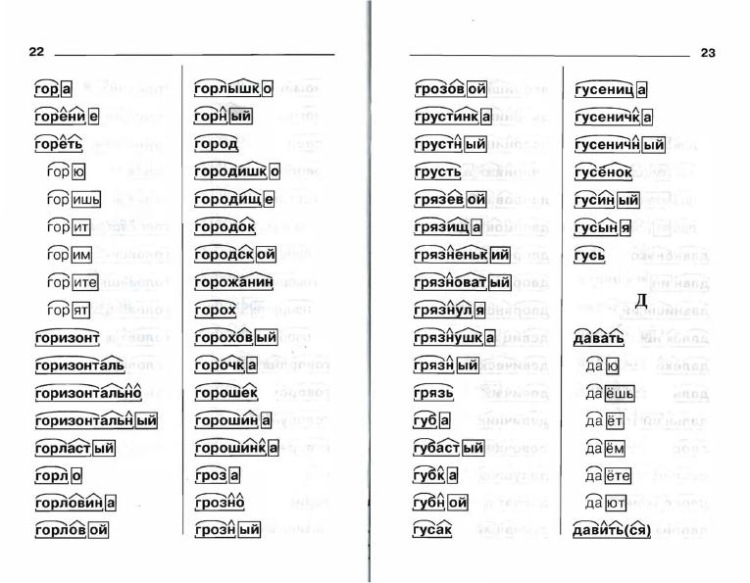

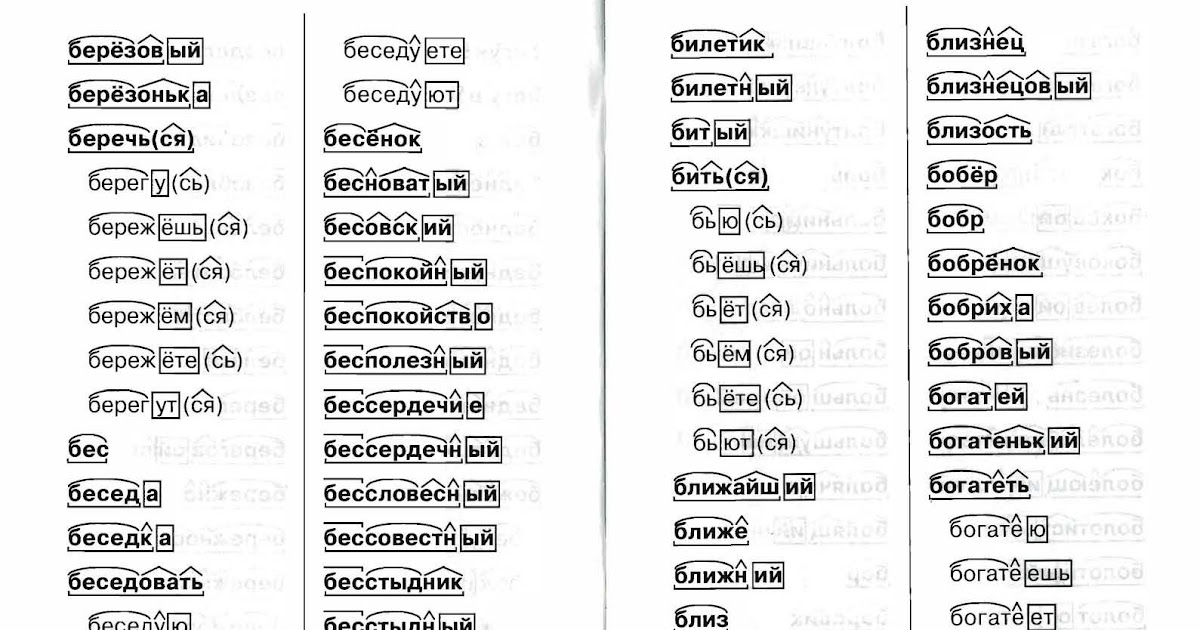

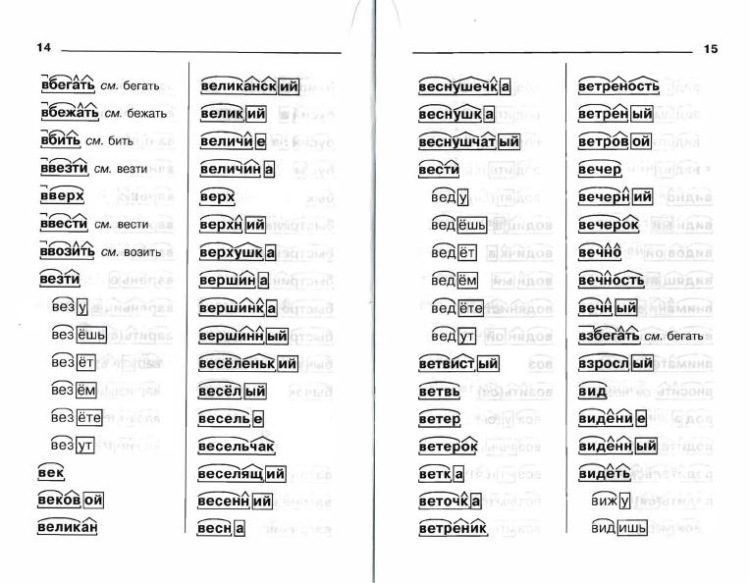

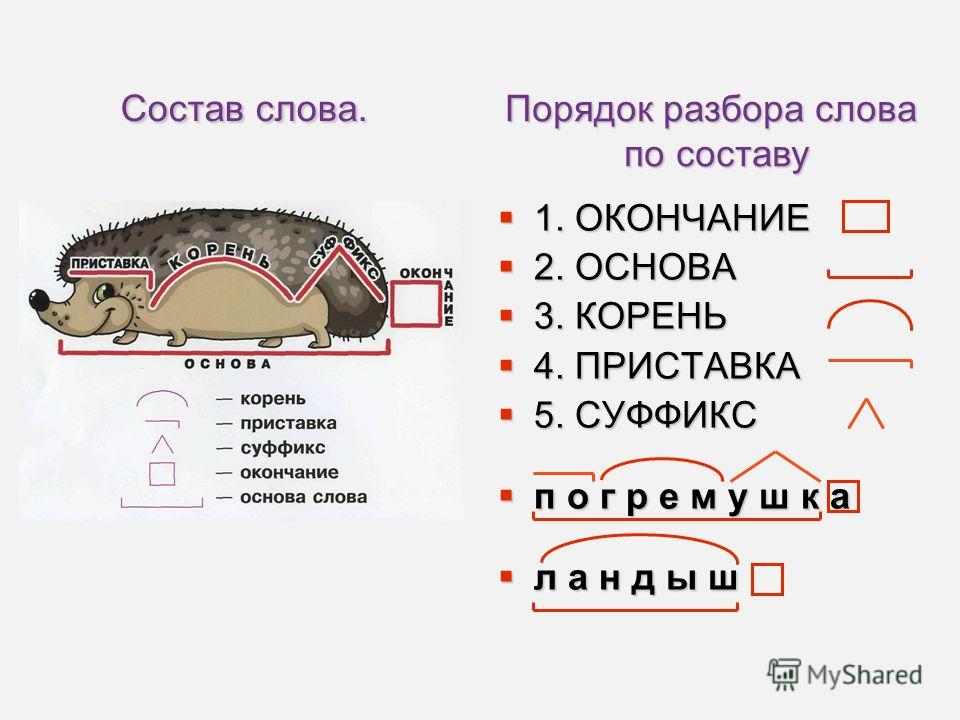

Разбор слова «призывы» по составу

| при | приставка |

| зыв | корень |

| ø | нулевое окончание |

призыв

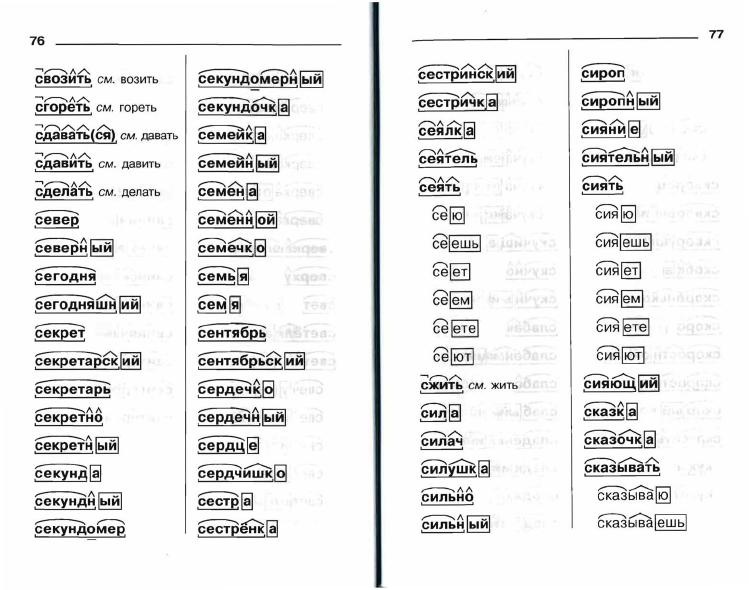

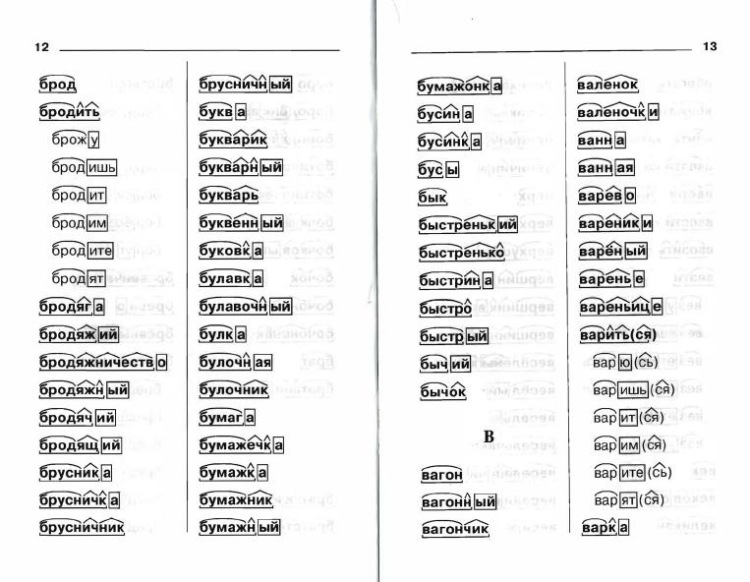

Сходные по морфемному строению слова «призывы»

Сходные по морфемному строению слова

Синонимы слова «призывы»

1. зов

зов

2. лозунг

3. клич

4. требование

5. воззвание

6. мобилизация

7. обращение

8. вызывание

9. кликание

10. призывание

11. просьба

12. мольба

13. стоп

14. тсс

15. азан

16. слоган

17. бяш-бяш

18. вабление

19. вабка

20. закличка

21. заклик

Ударение в слове «призывы»

призы́вы — ударение падает на 2-й слог

Фонетическая транскрипция слова «призывы»

[пр’из`ывы]

Фонетический разбор слова «призывы» на буквы и звуки (Звуко-буквенный)

| Буква | Звук | Характеристики звука | Цвет |

|---|---|---|---|

| п | [п] | согласный, глухой парный, твёрдый, шумный | п |

| р | [р’] | согласный, звонкий непарный (сонорный), мягкий | р |

| и | [и] | гласный, безударный | и |

| з | [з] | согласный, звонкий парный, твёрдый, шумный | з |

| ы | [`ы] | гласный, ударный | ы |

| в | [в] | согласный, звонкий парный, твёрдый, шумный | в |

| ы | [ы] | гласный, безударный | ы |

Число букв и звуков:

На основе сделанного разбора делаем вывод, что в слове 7 букв и 7 звуков.

Буквы: 3 гласных буквы, 4 согласных букв.

Звуки: 3 гласных звука, 4 согласных звука.

Предложения со словом «призывы»

В замке никто не мог услышать призывов незадачливого жениха о помощи – все были на празднике.

Элеонора Шах, Киан и Ланика.

Снова прозвучал призыв к более строгому отбору и сценариев, и режиссёров.

Мария Белодубровская, Не по плану. Кинематография при Сталине.

Удержать казаков под ружьём оказывалось практически невозможно – они стремились по домам, обещая по первому призыву вернуться в строй и, наверное, сами в эти минуты веря своим обещаниям.

Андрей Сергеевич Кручинин, Белое движение. Том 1, 2017.

Сочетаемость слова «призывы»

1. подобные призывы

2. новый призыв

3. последний призыв

4. призыв демона

5. призыв духа

призыв духа

6. призыв муэдзина

7. в ответ на призыв

8. заклинание призыва

9. ритуал призыва

10. призыв прозвучал

11. откликнуться на призыв

12. услышать призыв

13. ответить на призыв

14. (полная таблица сочетаемости)

Значение слова «призывы»

ПРИЗЫ́В , -а, м. 1. Действие по знач. глаг. призвать—призывать. Призыв на действительную военную службу. Призыв к порядку. (Малый академический словарь, МАС)

Как правильно пишется слово «призывы»

Правописание слова «призывы»

Орфография слова «призывы»

Правильно слово пишется:

Нумерация букв в слове

Номера букв в слове «призывы» в прямом и обратном порядке:

Ассоциации к слову «призывы»

Листовка

Свержение

Отклик

Лозунг

Мобилизация

Отсрочка

Подлежащее

Новобранец

Забастовка

Ополчение

Плакат

Повинность

Покаяние

Агитация

Митинг

Манифест

Доброволец

Неповиновение

Повестка

Резолюция

Комсомол

Рекрут

Пропаганда

Клич

Благоразумие

Мольба

Солидарность

Патриотизм

Проповедь

Единение

Льгота

Декларация

Увольнение

Восстание

Бунт

Громкоговоритель

Отмена

Мятеж

Молитва

Комиссариат

Молодёжь

Обращение

Осуждение

Фашизм

Пролетариат

Сура

Погром

Зов

Военнослужащий

Страстный

Пламенный

Патриотический

Настойчивый

Мысленный

Отчаянный

Безмолвный

Ленинский

Насильственный

Воинский

Жалобный

Телепатический

Крестовый

Тщетный

Комсомольский

Немедленный

Истошный

Воинственный

Большевистский

Исламский

Революционный

Вопиющий

Манящий

Альтернативный

Антисоветский

Конституционный

Протяжный

Властный

Трудящийся

Откликаться

Внять

Откликнуться

Возыметь

Подлежать

Разослать

Проигнорировать

Уклоняться

Раздаваться

Содержаться

Мобилизовать

Отзываться

Выкрикивать

Расценить

Призывать

Голосовать

Слать

Внимать

Игнорировать

Взывать

Отслужить

Заслышать

Морфологический разбор слова «казнить»

Часть речи: Инфинитив

КАЗНИТЬ — слово может быть как одушевленное так и неодушевленное, смотрите по предложению в котором оно используется.

Начальная форма слова: «КАЗНИТЬ»

| Слово | Морфологические признаки |

|---|---|

| КАЗНИТЬ |

|

Все формы слова КАЗНИТЬ

КАЗНИТЬ, КАЗНЮ, КАЗНИМ, КАЗНИШЬ, КАЗНИТЕ, КАЗНИТ, КАЗНЯТ, КАЗНИЛ, КАЗНИЛА, КАЗНИЛО, КАЗНИЛИ, КАЗНЯ, КАЗНИВ, КАЗНИВШИ, КАЗНИМТЕ, КАЗНИ, КАЗНЯЩИЙ, КАЗНЯЩЕГО, КАЗНЯЩЕМУ, КАЗНЯЩИМ, КАЗНЯЩЕМ, КАЗНЯЩАЯ, КАЗНЯЩЕЙ, КАЗНЯЩУЮ, КАЗНЯЩЕЮ, КАЗНЯЩЕЕ, КАЗНЯЩИЕ, КАЗНЯЩИХ, КАЗНЯЩИМИ, КАЗНИВШИЙ, КАЗНИВШЕГО, КАЗНИВШЕМУ, КАЗНИВШИМ, КАЗНИВШЕМ, КАЗНИВШАЯ, КАЗНИВШЕЙ, КАЗНИВШУЮ, КАЗНИВШЕЮ, КАЗНИВШЕЕ, КАЗНИВШИЕ, КАЗНИВШИХ, КАЗНИВШИМИ, КАЗНИМЫЙ, КАЗНИМОГО, КАЗНИМОМУ, КАЗНИМЫМ, КАЗНИМОМ, КАЗНИМАЯ, КАЗНИМОЙ, КАЗНИМУЮ, КАЗНИМОЮ, КАЗНИМА, КАЗНИМОЕ, КАЗНИМО, КАЗНИМЫЕ, КАЗНИМЫХ, КАЗНИМЫМИ, КАЗНИМЫ, КАЗНЕННЫЙ, КАЗНЕННОГО, КАЗНЕННОМУ, КАЗНЕННЫМ, КАЗНЕННОМ, КАЗНЕН, КАЗНЕННАЯ, КАЗНЕННОЙ, КАЗНЕННУЮ, КАЗНЕННОЮ, КАЗНЕНА, КАЗНЕННОЕ, КАЗНЕНО, КАЗНЕННЫЕ, КАЗНЕННЫХ, КАЗНЕННЫМИ, КАЗНЕНЫ

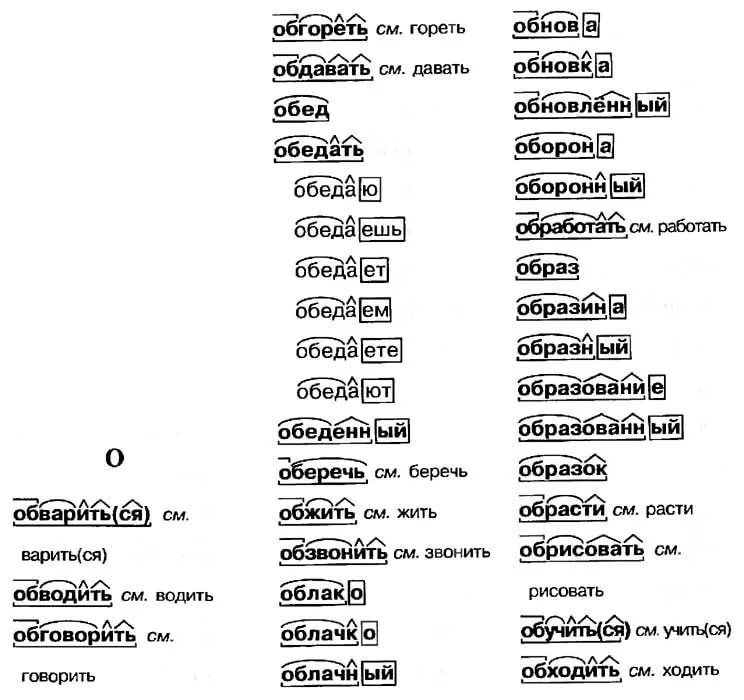

Разбор слова по составу казнить

казни

ть

| Основа слова | казни |

|---|---|

| Корень | казн |

| Суффикс | и |

| Глагольное окончание | ть |

Разобрать другие слова

Разбор слова в тексте или предложении

Если вы хотите разобрать слово «КАЗНИТЬ» в конкретном предложении или тексте, то лучше использовать

морфологический разбор текста.

Примеры предложений со словом «казнить»

1

Мы должны думать, казнить или не казнить, а не казнить или награждать.

Хирург, Юлий Крелин, 1970-1973г.

2

Толпа тут же остервенело подхватила этот призыв и начала скандировать: «Казнить, казнить, казнить».

Неупиваемая чаша, Александр Такмаков

3

А уж если казнить кого, так вели меня казнить, не давай я, дурак, напиваться сыну допьяна!

Князь Серебряный, Алексей Толстой, 1863г.

4

Казнить так казнить, миловать так миловать.

Юность длиною в сто лет. Читаем про себя. Молодежь в литературе XVIII – середины XIX века. 52 произведения про нас (с рисунками автора), Валерий Бондаренко, 2019г.

5

Скажет же когда-нибудь: «Прииди, Рита, сучка немецкая, вот Я буду казнить тебя, даже не судить, но сразу – казнить.

Все проплывающие, Юрий Буйда, 2011г.

Найти еще примеры предложений со словом КАЗНИТЬ

18.4 Разбор и грамматика | Advanced R

Мы много говорили о выражениях и AST, но не о том, как выражения создаются из кода, который вы вводите (например, "x + y" ). Процесс, посредством которого компьютерный язык берет строку и создает выражение, называется разбором и управляется набором правил, известным как грамматика . В этом разделе мы будем использовать

В этом разделе мы будем использовать lobstr::ast() для изучения некоторых деталей грамматики R, а затем покажем, как можно выполнять преобразования между выражениями и строками.

18.4.1 Приоритет оператора

Инфиксные функции вводят два источника неоднозначности 65 . Первый источник неоднозначности возникает из-за инфиксных функций: что дает 1 + 2 * 3 ? Получится ли 9 (т.е. (1 + 2) * 3 ) или 7 (т.е. 1 + (2 * 3) )? Другими словами, какое из двух приведенных ниже возможных деревьев синтаксического анализа использует R?

Языки программирования используют соглашения, называемые приоритетом оператора , чтобы разрешить эту неоднозначность. Мы можем использовать ast() чтобы увидеть, что делает R:

lobstr::ast(1 + 2 * 3) #> █─`+` #> ├─1 #> └─█─`*` #> ├─2 #> └─3

Предсказать приоритет арифметических операций обычно несложно, потому что это вбито в вас в школе и единообразно для подавляющего большинства языков программирования.

Предсказать приоритет других операторов сложнее. В R есть один особенно удивительный случай: ! имеет гораздо более низкий приоритет (т. е. связывает менее тесно), чем можно было бы ожидать. Это позволяет вам писать полезные операции, такие как:

лобстр::аст(!х %в%у) #> █─`!` #> └─█─`%in%` #> ├─x #> └─y

R содержит более 30 инфиксных операторов, разделенных на 18 групп приоритета. Хотя детали описаны в ?Синтаксис , очень немногие люди запомнили полный порядок. Если есть путаница, используйте скобки!

лобстр::аст((1 + 2) * 3) #> █─`*` #> ├─█─`(` #> │ └─█─`+` #> │ ├─1 #> │ └─2 #> └─3

Обратите внимание на появление скобок в AST как вызов (функция .

18.4.2 Ассоциативность

Второй источник неоднозначности появляется при многократном использовании одной и той же инфиксной функции. Например, 1 + 2 + 3 эквивалентно (1 + 2) + 3 или к 1 + (2 + 3) ? Обычно это не имеет значения, потому что x + (y + z) == (x + y) + z , т. е. сложение ассоциативно, но необходимо, потому что некоторый S3 классы определяют

е. сложение ассоциативно, но необходимо, потому что некоторый S3 классы определяют + неассоциативным образом, например, ggplot2 перегружает + для построения сложного сюжета из простых кусочков; это неассоциативно, потому что более ранние слои отображаются под более поздними слоями (например, geom_point() + geom_smooth() не дает того же графика, что и geom_smooth() + geom_point() ).

В R большинство операторов являются левоассоциативными , т. е. операции слева оцениваются первыми:

lobstr::ast(1 + 2 + 3) #> █─`+` #> ├─█─`+` #> │ ├─1 #> │ └─2 #> └─3 9` #> ├─2 #> └─3 lobstr::ast(x <- y <- z) #> █─`<-` #> ├─x #> └─█─`<-` #> ├─y #> └─z

18.4.3 Разбор и разбор

Большую часть времени вы вводите код в консоль, и R позаботится о преобразовании введенных вами символов в AST. Но иногда у вас есть код, хранящийся в строке, и вы хотите проанализировать его самостоятельно. Вы можете сделать это, используя

Вы можете сделать это, используя rlang::parse_expr() :

x1 <- "y <- x + 10" х1 #> [1] "у <- х + 10" есть.вызов(x1) #> [1] ЛОЖЬ x2 <- rlang::parse_expr(x1) х2 #> у <- х + 10 есть.вызов(x2) #> [1] ИСТИНА

parse_expr() всегда возвращает одно выражение. Если у вас есть несколько выражений, разделенных ; или \n , вам нужно будет использовать rlang::parse_exprs() . Он возвращает список выражений:

x3 <- "a <- 1; a + 1" rlang::parse_exprs(x3) #> [[1]] #> а <- 1 #> #> [[2]] #> a + 1

Если вы очень часто работаете со строками, содержащими код, вам следует пересмотреть свой процесс. Прочитать главу 19и подумайте, можно ли генерировать выражения с помощью квазицитирования более безопасно.

Базовый эквивалент parse_exprs() равен parse() . Его немного сложнее использовать, потому что он специализируется на анализе кода R, хранящегося в файлах. Вам нужно предоставить свою строку аргументу text , и он вернет вектор выражения (раздел 18. 6.3). Я рекомендую превратить вывод в список:

6.3). Я рекомендую превратить вывод в список:

as.list(parse(text = x1)) #> [[1]] #> у <- х + 10

Инверсия синтаксического анализа: deparsing : при заданном выражении вам нужна строка, которая его сгенерирует. Это происходит автоматически, когда вы печатаете выражение, и вы можете получить строку с помощью rlang::expr_text() :

z <- expr(y <- x + 10) expr_text(z) #> [1] "y <- x + 10"

Разбор и разбор не полностью симметричны, потому что разбор генерирует абстрактное синтаксическое дерево. Это означает, что мы теряем обратные кавычки вокруг обычных имен, комментариев и пробелов:

кошка (выражение_текст (выражение ({

# Это комментарий

х <- `х` + 1

})))

#> {

#> х <- х + 1

#> } Будьте осторожны при использовании базового эквивалента R, deparse() : он возвращает вектор символов с одним элементом для каждой строки. Всякий раз, когда вы используете его, помните, что длина вывода может быть больше единицы, и планируйте соответственно.

18.4.4 Упражнения

R использует скобки двумя немного разными способами, как показано на эти два вызова: 9у %+% z . Чему ты научился о приоритете пользовательских инфиксных функций?

Что произойдет, если вы вызовете

parse_expr()со строкой, которая генерирует несколько выражений? напримерparse_expr("х + 1; у + 1")Что произойдет, если вы попытаетесь проанализировать недопустимое выражение? например

"а +"или"f())".deparse()создает векторы, когда ввод длинный. Например, следующий вызов создает вектор длины два:expr <- expr(g(a + b + c + d + e + f + g + h + i + j + k + l + m + n + o + p + q + r + s + t + u + v + w + x + y + z)) депарс (выражение)

Что вместо этого делает

expr_text()?pairwise.t.test()предполагает, чтоdeparse()всегда возвращает длину один вектор символов. Можете ли вы построить ввод, который нарушает это ожидание?

Что происходит?

Можете ли вы построить ввод, который нарушает это ожидание?

Что происходит?

Эта двусмысленность отсутствует в языках с только префиксными или постфиксными вызовами. Интересно сравнить простую арифметическую операцию в Лиспе (префикс) и Форте (постфикс). В Лиспе вы бы написали

(* (+ 1 2) 3)); это позволяет избежать двусмысленности, требуя скобок везде. В Форте вы бы написали1 2 + 3 *; это не требует никаких круглых скобок, но требует большего внимания при чтении. ↩︎

TLB хит 💥 Parsers Podcast Notes

TLB хит 💥 Parsers Podcast NotesПодкаст о системах и компиляторах

🐦 @TLBhit

🎙 RSS

🍎 Подкаст Apple

- 0,5⨉

- 1⨉

- 1,25⨉

- 1,5⨉

- 1,75⨉

- 2⨉

[00:00] Ужасные зимние каникулы / Холодное вступление ко Дню святого Валентина

- Теплый и пушистый.

.. и parse-y ... время года

.. и parse-y ... время года - Сегодня мы поговорим о парсерах, а не о фаззерах, но JF любит петрушки и другую кроличью еду в ассортименте

[00:13] Отказ от ответственности

[00:35] Об парсерах

- В основном о нашем практическом опыте работы с парсерами

- Работа с полем синтаксического анализа в целом затруднена, потому что оно содержит множество нюансов и имеет большой размер (сравните с целым классом теории вычислений в школе)

- Одно из критических замечаний, которое вы часто слышите об оригинальном издании Книги Дракона, заключается в том, что оно было загружено большим количеством теоретического содержания синтаксического анализатора, которое сбивало с толку многих людей в классе «Введение в компиляторы»

- Большая часть этой книги была посвящена синтаксически управляемой генерации кода в качестве внутреннего потока [в котором вы анализируете AST, а затем в основном просто проходите этот AST, чтобы сгенерировать код, непосредственно соответствующий структуре AST, когда вы ее проходите, т.

е. затем-эмит-пасс-стиль]

е. затем-эмит-пасс-стиль]- Понятно, что много сделал на разборе

- Но также не всегда то, что люди хотели понять в классе компиляторов... [против, возможно: как выглядят внутренности оптимизирующего компилятора, как обычно работают преобразования программ, что я могу ожидать от компилятора/не делать и т. д.]

[01:20] Использование синтаксических анализаторов рекурсивного спуска

- Немного ересь, но часть того, что мы собираемся заявить сегодня, заключается в том, что синтаксические анализаторы в практическом смысле можно рассматривать как стилизованный образец кодирования

- С парсерами рекурсивного спуска в качестве решения вы можете легко создавать свои собственные сценарии и решения синтаксического анализа и повторно использовать это понимание [например. даже на разных языках, в разных средах]

[1:40] Парсеры появляются повсюду!

- Парсеры, когда вы заходите в них, появляются повсюду

- Люди скажут: «Вы не можете просто указать на что-то и назвать это синтаксическим анализатором», но когда вы начинаете любить синтаксические анализаторы, вам это нравится!

- Примером являются внешние процессоры, те, которые декодируют инструкции

- Действительно очень компактные парсеры/генераторы "на лету" для микрокода

- Если вы посмотрите на ARM64: это 4-байтовые слова, которые вы анализируете по одному, ЦП анализирует их, как это сделал бы любой дизассемблер, иногда делает это более чем по одному слову за раз, но в основном причудливый анализатор

- [И синтаксические анализаторы, которые могут векторизовать символы ввода/вывода, представляют собой совершенно другую область интереса; например в этом примере можете ли вы, в среднем, потреблять два 4-миллиардных слова и производить >= 2 микрооперации за заданный такт?]

- x86 немного сложнее в качестве внешнего интерфейса, потому что размер инструкции [входные символы] имеют переменную длину, кодирование переменной ширины, но все же своего рода синтаксический анализатор .

- Это тип синтаксического анализатора, который должен иметь контекст для правильного декодирования инструкций, например. начиная с правильного места [и в правильном режиме] для декодирования правильных инструкций

- На самом деле, если вы неправильно выровнены, вы можете декодировать совершенно другие инструкции

- По-прежнему эффективный парсер!

- В сфере безопасности это одна из забавных вещей, которые шелл-код [полезная нагрузка буфера кода, контролируемого злоумышленником] попытается сделать, чтобы воспользоваться этим: поместить кучу констант в код и перейти к странному смещение, поэтому инструкции перемещения константы в регистр будут декодироваться по-разному с помощью непосредственных элементов, которые не находятся в предполагаемом «начале» инструкции .

[2:50] Некоторые наивные предыстории процесса синтаксического анализа

[4:25] Unicode-qua Parser

- Пример "указать на вещь и вызвать ее синтаксический анализатор"

- Сам Unicode, нужна форма парсера для

- Самозапускающийся синтаксический анализатор: не такой контекстный

- Способ кодирования юникода [переменной длины] при каждом запуске UTF, например, в UTF-8, сообщает вам, где начинается кодовая точка .

- Таким образом, если вы пропустите одну кодовую точку, следующую вы уже не сможете пропустить, потому что способ закодирован

- Очень простой синтаксический анализатор, но все же то, что вы могли бы «разобрать» из потока байтов

- Парсеры повсюду!

[5:05] Сомневаетесь в общепринятой мудрости? Компромиссы в Parser-Generation

- Общепринято всегда писать синтаксический анализатор вручную, но всегда использовать генератор синтаксических анализаторов

- JF и Крис обычно считают, что общепринятое мнение здесь неверно

- Мы бы предпочли [для проектов в режиме миссии] написать синтаксический анализатор вручную: начните с синтаксического анализатора рекурсивного спуска, и если эта форма вызывает проблемы, используйте больше формы в стиле конечного автомата, которая при необходимости отслеживает контекст/состояние

- [Или иногда ошибки чрезмерной рекурсии, возникающие из-за глубокой рекурсивной структуры, могут быть преобразованы в более итеративную формулировку, например, восхождение по приоритету]

- Рекурсивную форму легко написать, и преобразование в форму, более похожую на «машину состояний», не так уж и плохо

- JF начал свои первые синтаксические анализаторы давным-давно, руководствуясь общепринятым мнением: перепробовал кучу вещей

- Пробовал ANTLR, пробовал lex/yacc и flex/bison

- Остановился на Boost Spirit — оглядываясь назад, я понял, что это была плохая идея: сложно писать, сложно отлаживать, не очень гибко, выдавало ужасные сообщения об ошибках, , но в качестве компромисса также дал ужасное время компиляции!

- Положительный момент работы в Boost Spirit все это время назад заключается в том, что JF высмеивает Брайса Лельбаха — друга шоу и ведущего подкаста ADSP, работал над Spirit, и JF всегда делает из него за это, положительную сторону в обучении игнорировать общепринятое мнение

- Boost Spirit — это своего рода предметно-ориентированный язык (DSL) EBNF, написанный на шаблонном метапрограммировании C++ (TMP)

- Если вы посмотрите на EBNF, в нем есть специальные операторы; некоторые из них существуют в наборе перегружаемых операторов C++

- Кто-то пошел и сделал умный оптимизатор C++ в метапрограммировании шаблонов для языка DSL, используя шаблоны и перегрузку операторов, чтобы сделать что-то вроде синтаксического анализатора EBNF; очень мило, но глупая идея, если честно, я бы предпочел написать все это от руки

- Думаю, у нас, в промышленности, было грубое пробуждение [с Yacc], чтобы увидеть

.файлов, пытающихся чередовать различные вещи в процессе синтаксического анализа; неясное время жизни в файлах y

y .y, ошибки памяти, которые могут возникнуть в результате — часть того, что заставило JF полюбить парсинг с рекурсивным спуском, в отличие от такого рода вещей- Когда я высмеиваю Boost Spirit, я бы не сказал, что файлы .y лучше, чем то, что вы там получите; действительно думаю, что парсеры с рекурсивным спуском — правильный путь: они более гибкие, приятнее в написании, проще в отладке и т. д.

- Для людей, которые раньше не использовали Yacc, файлы

.yпредставляют собой стилизованные шаблоны C, к которым может обращаться парсер Yacc, когда происходят события при формировании дерева разбора. , но там, где происходят вещи, управляемые синтаксическим анализатором Yacc [в качестве основного цикла] - JF лично является большим поклонником генерации кода: пользовательский DSL, который вы (самостоятельно) анализируете и генерируете код C/C++ для выполнения задач, которые использует ваша кодовая база; просто кажется, что файлы Yacc - не лучший композиционный способ генерации кода

- Все больше людей пытаются создавать и использовать простые версии, которые работают примерно так же; в Yacc внутренний цикл управляется теоретической композицией грамматики LALR — т.

е. есть что-то, чего вы не понимаете, из чего вы получите свой сдвиг, уменьшающий конфликты, из вашего внутреннего цикла, но это запускает события в этом другом файле

е. есть что-то, чего вы не понимаете, из чего вы получите свой сдвиг, уменьшающий конфликты, из вашего внутреннего цикла, но это запускает события в этом другом файле - Такие вещи, как грамматики PEG, которые люди пытаются использовать чаще, могут в конечном итоге выдать C-файл, который является парсером с рекурсивным спуском, но мы также поговорим о некоторых компромиссах

- Несмотря на то, что такие вещи, как грамматики PEG, являются более современной техникой, которая выплевывает реализации парсера рекурсивного спуска , здесь мы в основном будем говорить о созданных вручную парсерах рекурсивного спуска

- Компромисс для скрученных вручную состоит в том, что они хорошо работают и понятны, когда вы сами структурируете их как код, и на самом деле все сводится к стилизованному способу структурирования вашего кода для создания полезной и легко узнаваемой структуры данных, который представляет собой дерево синтаксического анализа, которое выходит, или красивое сообщение об ошибке, которое может использовать контекст, из которого возникло сообщение об ошибке

- Очень хорошая статья, опровергающая наше мнение о том, что это наш предпочтительный способ: Почему нам нужно знать LR и методы анализа рекурсивного спуска

- [Ключевое наблюдение из этой статьи состоит в том, что мы все должны усвоить: синтаксические анализаторы, являющиеся «просто стилизованным кодом», являются одновременно и благословением, и проклятием: вы можете написать двусмысленность в своей грамматике, например, «если это вторник, проанализируйте это таким образом», и не пропустите ни секунды.

Ключевым моментом является понимание того, как сделать языки регулярными по форме, даже если они реализованы как рекурсивный спуск вручную. В синтаксическом анализаторе с рекурсивным спуском, свернутым вручную, стремление написать LL(1), например, когда вы можете устранить неоднозначность, в каком направлении движется грамматика, с помощью единственного маркера просмотра вперед, является хорошей идеей.]

Ключевым моментом является понимание того, как сделать языки регулярными по форме, даже если они реализованы как рекурсивный спуск вручную. В синтаксическом анализаторе с рекурсивным спуском, свернутым вручную, стремление написать LL(1), например, когда вы можете устранить неоднозначность, в каком направлении движется грамматика, с помощью единственного маркера просмотра вперед, является хорошей идеей.]

- [Ключевое наблюдение из этой статьи состоит в том, что мы все должны усвоить: синтаксические анализаторы, являющиеся «просто стилизованным кодом», являются одновременно и благословением, и проклятием: вы можете написать двусмысленность в своей грамматике, например, «если это вторник, проанализируйте это таким образом», и не пропустите ни секунды.

- Синтаксический анализ исторически был одним из таких великих пересечений между фундаментальными CS и практическими приложениями

- Вы узнаете об этом на уроке теории вычислений:

- Регулярное выражение имеет определенный уровень мощности

- Автоматы с нажатием вниз — это следующий уровень мощности, который позволяет вам делать такие вещи, как сопоставление скобок; например когда у вас открыты закрывающие скобки

- Вы не можете написать парсер HTML, например, используя только регулярные выражения!

- Таким образом, синтаксические анализаторы намного мощнее, чем то, что вы можете сделать с помощью регулярных выражений!

- Люди, благодаря важной теоретической базе, могут почувствовать, что лежащая в основе теория важна, что имеет смысл — в той мере, в какой вы можете узнать о теориях Хомпского и диагностических доказательствах Кантора и тому подобных вещах — которые все важно и здорово, знать основы CS - это здорово!

- Точно так же, с точки зрения практика, есть аспект, который говорит: если вы просто пишете код в определенном стилизованном виде, вы можете выполнить свою конкретную задачу, вы можете выполнить работу, которую хотите выполнить; и, если вы находите теорию сложной, вы можете пропустить некоторые из этих основ и просто научиться писать эту стилизованную форму кода

- JF работал с кем-то 10 лет назад или около того, кто защитил докторскую диссертацию по синтаксическому анализу — возможно, сегодня мы думаем, что синтаксический анализ — хорошо известная область — работая над докторской диссертацией, он значительно продвинул уровень техники в CS в 70-х — действительно говорит вам, что информатика сама по себе является довольно новой областью, многие вещи были поняты относительно недавно

- Интересно, что мы находимся в этой области, где вещи настолько новы, что можно знать людей, которые изобрели ключевые вещи

[11:40] Резюме основного процесса синтаксического анализа

"Токенизировать" символы: линейный поток символов трансформируется в линейный поток жетонов

Сделать дерево из этих жетонов

Сканирование и токенизация являются синонимами

Но даже этот факт интересен: вызывает вопросы вроде:

- "контекстно-зависима ли токенизация?" и

- "насколько это распараллеливается по отношению к потоку символов?"

Иногда требуется разделить синтаксический анализ и сканирование [например, для хорошего разделения проблем], иногда хочется присоединиться к ним

Сканирование, как правило, имеет очень мало контекста -- обычно понимает только основные разделители в самом тексте

В то время как синтаксический анализ направлен на понимание контекста и структуры грамматики, с которой вы имеете дело

Сам синтаксический анализатор имеет состояние, чтобы понять, где вы находитесь, т.

е. в конечном автомате, чтобы декодировать грамматику, которую вы анализируете

е. в конечном автомате, чтобы декодировать грамматику, которую вы анализируетеСинтаксический анализатор генерирует вывод: в зависимости от того, что вы делаете, это может быть абстрактное синтаксическое дерево, которое вы создаете из своего анализатора

, т.е. может генерировать код напрямую, если вы небольшой/эффективный [т.е. "один проход"] компилятор

В синтаксическом анализаторе с рекурсивным спуском это состояние частично кодируется в самом потоке управления: вызовы функций, содержимое стека и т. д. кодируют часть состояния

Когда мы обсуждали преобразование синтаксического анализатора рекурсивного спуска в нечто вроде конечного автомата, в конечном итоге вы просматриваете это состояние, которое у вас было с помощью рекурсии, и имеете собственный стек для кодирования этого состояния в качестве побочной структуры данных

И это вообще интересная вещь в том, как мы пишем последовательные программы: счетчик программ фактически является состоянием, которое движется вперед и совершает скачки и тому подобное

- Рекурсивные функции — это один из способов структурирования вашего состояния с данными в стеке и продвижением счетчика программ различными способами

[13:30] Как мы уже говорили, токены формируются из потока символов

Упреждающий просмотр того, какой токен, который вы видите, является частью того, что определяет порождение грамматики (правило грамматики) для применения

Если я смотрю на поток символов и держу что-то в руке, и смотрю вперед и вижу знак плюс, я

Предварительный просмотр того, какой токен вы видите, является частью того, что в конечном итоге может определить применимое правило грамматики: если я смотрю вперед и вижу знак плюс, я знаю, что это, вероятно, двоичный оператор плюс (во многих распространенных языках) который хочет взять вещь, которую я только что видел с левой стороны, и добавить ее к вещи (мне еще нужно определиться) с правой стороны

Итак, что происходит с этими правилами, они вложены друг в друга: я возьму оператор плюс и скажу: «Хорошо, я должен сейчас делать слабое арифметическое выражение» — потому что время связывает сильнее, чем плюс, плюс «слабее»

Тогда я бы посмотрел на правую сторону и спросил: «Могу ли я разобрать то, что я вижу после

+, как сильную арифметическую операцию? Может быть, как*? плюс меня сейчас рассматривают как оператора?"- Этот уровень привязки или приоритета определяет, будете ли вы вкладывать следующее выражение на том же уровне или на более высоком уровне, например, при более жесткой привязке; т.

е.

е. *будет более жесткой привязкой, чем оператор+ - Таким образом, вы устанавливаете правила грамматики так, чтобы элементы, которые вложены более плотно , становились более внутренними узлами внутри дерева

- Вы делаете это, используя автономные правила; например

WEAK_ARITH_EXPRвыше, что имеетSTRONG_ARITH_EXPRслева и справа - Вы стилизуете свои рекурсивные функции грамматики / грамматику БНФ, чтобы сделать эту ассоциацию понятной

- Этот уровень привязки или приоритета определяет, будете ли вы вкладывать следующее выражение на том же уровне или на более высоком уровне, например, при более жесткой привязке; т.

[15:10] Причудливость JavaScript: описание функций

- В стране JavaScript, помимо этих основных принципов работы грамматики, есть несколько интересных и причудливых вещей

- Представьте, что в файле сотни функций, посмотрите, где начало/конец функций, чтобы я мог лениво загрузить дерево, описывающее синтаксис (т. е. лениво проанализировать его)

- Представьте, что я никогда не вызываю конкретную функцию, действительно ли я хочу тратить циклы на ее синтаксический анализ и анализ, если я никогда ее не вызываю?

- Но могут быть и интересные задачи: например, токенизация! Если вы работаете с регулярным выражением, вы можете переключить сканер из режима регулярного выражения в обычный режим кода JavaScript .

- Или, если вы окажетесь посреди многострочного комментария, там могут быть произвольные вещи, которые вообще ничего не делают!

- Проблемы при расширенном/быстром/параллельном сканировании или токенизации

- Когда вы пытаетесь распараллелить что-то, вам нужно иметь достаточно работы в каждом параллельном рабочем потоке, чтобы сделать что-то полезное: классический компромисс между параллелизмом и параллелизмом — вы уходите и оптимизируете все функции на этом этапе?

- У вас есть быстрый параллельный синтаксический анализатор, который вычисляет, где находятся начало/конец -- вы разделяете работу на N потоков, чтобы быстро оптимизировать их все, или, возможно, выполняете дополнительный объем синтаксического анализа, или вы просто сохраняете эту информацию вокруг и делать это лениво с интерпретатором, когда вы в конечном итоге выполняете это? А потом скомпилировать Just-in-Time? И затем вы выполняете функцию «точно вовремя» с потоком переднего плана или потоком фона, часть компромисса

- Распараллеливание — хороший способ использовать несколько ядер, но для более низкой задержки загрузки страницы, возможно, вы захотите заблокировать и скомпилировать прямо здесь/затем в потоке переднего плана и выполнить работу так, как она есть в .

- Всегда интересный компромисс, чтобы увидеть, связываете ли вы синтаксический анализ с оптимизацией или другими видами генерации контекста

[17:15] Возвращение

- Чтобы немного отступить от продвинутых методов, о которых мы говорим, и вернуться к основам синтаксического анализа

- Одним из очень важных аспектов синтаксического анализа является концепция поиска с возвратом.

- Точно так же, как вы предположительно могли бы распараллелить анализ JavaScript на странице или что-то в этом роде

- В самом процессе синтаксического анализа, когда нужно сделать что-то неоднозначное: вы видите оператор

<— вы не уверены, запускает ли он создание экземпляра шаблона в C++ или выполняет операцию меньше — когда вы видите, что<в C++ это может означать одно из двух, поэтому у вас есть этот неоднозначный выбор - Возврат в основном означает захват вашей текущей точки в процессе синтаксического анализа и возможность вернуться к этому выбору и сделать другой выбор

- Таким образом, вы можете предположить, что этот оператор

<будет фактическим оператором «меньше чем», и вы можете попытаться выполнить синтаксический анализ, как будто это так, и если вы обнаружите, что это ошибка, вы можете вернуться, восстановить исходный контекст и пойти по противоположному пути [экземпляра шаблона] - Некоторые языки могут быть более регулярными и требовать меньшего количества возвратов или отсутствия возвратов, и есть полное описание того, какие языки могут обладать этим свойством в теории — это важное понятие, которое вводится, когда ваша грамматика не полностью определяется упреждающие токены, так что это свойство, которым обладают многие языки реального мира, которые мы используем в компьютерах

- [18:55] В Rust есть оператор «турбо-рыба», который помогает устранить двусмысленность, упомянутую в C++, — вместо того, чтобы видеть

<символ и мысль "может быть, это создание экземпляра шаблона" есть явный оператор::<, который говорит синтаксическому анализатору "вещь в левой части этого оператора - это имя типа, экземпляр которого создается, я говорю вам, что это!» Интересное решение для того, чтобы сделать вещи менее двусмысленными, поскольку стоимость вещи имеет больше знаков препинания в строках . - В связи с этим Haskell позволяет пользователям создавать совершенно новые инфиксные операторы, поэтому вы можете расширить грамматику, например. с оператором Кирби

<(o.o)>(или, может быть, не так далеко) -- но почти произвольная пунктуация может стать новыми инфиксными операторами - Такие вещи, как CamlP4 [ред: плохо, я неправильно запомнил и сказал Caml4P] были в истории/вдохновении создания макроса Rust, где вещи расширяемы в пользовательском пространстве, поэтому синтаксис может быть расширен, чтобы вы могли создавать новые деревья синтаксического анализа и конструкции

- [20:00] Для возврата в целом, но также и при синтаксическом анализе, у вас есть эти точки принятия решений, когда вы должны отбросить работу, выполненную в каком-то поддереве, а затем продолжить делать другой выбор, пока не выясните, что было на самом деле поддерево

- Аналогично всем транзакционным вещам: сделайте точку продолжения, которую вы можете пересмотреть, пока не решите, что «хорошо, я действительно закончил, и мне больше не нужно возвращаться», а затем вы фактически фиксируете это и проходите свою «точку невозврата»

- [20:28] Возврат также напоминает нам: разработка синтаксического анализатора — это то, что вы хотите делать в идеале, пока разрабатываете грамматику, которую хотите анализировать

- Многие грамматики разработаны таким образом, чтобы их было легко анализировать, некоторые из них думают так: не только программисту легко написать синтаксический анализатор, но и человеку легко понять написанное

- В C++ мы говорили об операторе

<; те, кто знаком с C++ в контексте шаблона, в конечном итоге должны указать имя типа и шаблон -

typenameиtemplateключевые слова имеют несколько разных значений - в контексте шаблона они устраняют неоднозначность определенных вещей; когда был разработан C++, его грамматика оказалась довольно сложной, и эти ключевые слова помогают устранить неоднозначность некоторых вещей не только для синтаксических анализаторов, но и для людей - Когда они создавали Go, этому уделялось большое внимание — они хотели иметь грамматику, которая была бы не только для людей, но и легко поддавалась разбору, и поэтому в итоге у них появились такие вещи, как типы, следующие за идентификаторами

[21:30] Как растет дерево?

- [21:30] Основная вещь, которую мы утаиваем, говоря о парсерах с рекурсивным спуском, в первую очередь заключается в том, должны ли деревья синтаксического анализа расти от листьев к корню или наоборот

- Если смотреть на график: снизу графика или корень вверху?

- Шутка здесь: настоящих деревьев, вероятно, имеют сильное предпочтение, в каком направлении они растут! Но в CS деревья вы можете выбирать, как растут деревья

- В LL и рекурсивном спуске, обычно нисходящем, начните с корня; LALR/разбор снизу вверх начинается с листьев/терминалов грамматики

- Компромиссы при выборе каждого из них в зависимости от того, что вы анализируете: какой язык/грамматику вы ищете

- Иногда рекурсия «слева»/«справа» может иметь больше возвратов и, следовательно, быть менее эффективной

- Опять же, разработка грамматики с помощью синтаксического анализатора требует компромиссов в плане эффективности и реализации синтаксического анализа

- В конечном итоге все сводится к тому, как разрешаются неоднозначности и когда они обнаруживаются в процессе синтаксического анализа

- Конфликты Shift-Reduce печально известны здесь и возникают из-за неоднозначности процесса восходящего слияния

- Что хорошо в парсерах рекурсивного спуска, так это то, что вы на самом деле просто пишете код, разрешая конфликты с кодом, который вы пишете — одна из вещей, которая может быть приятной, если вы не будете осторожны, вы даже не заметите, что вы делать это -- что плохо, то и хорошо, вы просто пишете код, иногда это приятно, иногда это отличный способ навести беспорядок

- Очень мощный инструмент, с большой силой приходит и большая ответственность

- Можно легко сказать "грамматика анализирует таким образом, когда это среда после 16:00", но это было бы ужасно писать синтаксический анализатор, даже если это возможно в синтаксическом анализаторе рекурсивного спуска

- Структура этих декларативных вещей вынуждает вас сказать: «Он следует этой регулярной структуре, и у него есть способы разрешения двусмысленностей, которые я разместил в своей спецификации впереди»

[23:53] Свернуть вручную или сгенерировать:

что это вопрос!- [23:53] Вернемся к тому, о чем мы говорили в начале о компромиссе между генераторами синтаксических анализаторов и рекурсивными синтаксическими анализаторами, свернутыми вручную: невозможно избежать языка компромиссов

- Некоторые вещи, которые следует учитывать: производительность; когда ваш парсер-генератор дает вам что-то, что дает определенную производительность при разборе, каковы ваши инструменты/методы для повышения производительности системы, например.

анализировать больше мегабайт текста в секунду в вашей структуре данных

анализировать больше мегабайт текста в секунду в вашей структуре данных - Имея в руках код в синтаксическом анализаторе с рекурсивным спуском, мы можем использовать множество наших традиционных методов оптимизации, в то время как с помощью генератора синтаксического анализатора можно реструктурировать грамматику или, возможно, дать подсказки генератору синтаксического анализатора. сгенерированный сценарий

- Когда вы пишете код, у вас больше контроля над использованием памяти и тем, как все структурируется; например если есть пиковые пределы памяти, в которых вы хотите оставаться, или если у вас есть своего рода разделяй и властвуй, ты можешь сделать

- Когда у вас в руках код, у вас есть весь контроль и власть, но за счет дополнительного написания кода и дополнительной работы для вас

- Сообщения об ошибках — довольно важный момент, о котором мы должны поговорить подробнее:

- Такие вещи, как встроенная диагностика : скажем, вы прошли часть пути через синтаксический анализ вашей программы, но затем обнаруживаете, что есть какая-то проблема, диагностика частично завершенного процесса синтаксического анализа очень важна, чтобы иметь возможность обратной связи с пользователем

- "Я дошел до этого момента, но потом увидел, что

$THIS_THING, в частности, пошло не так"

- "Я дошел до этого момента, но потом увидел, что

- Отслеживание состояния для диагностики, подобной этой, в «боксе» для диагностических целей при разборе — действительно мощный инструмент в анализаторах рекурсивного спуска

- Если вы посмотрите на Clang — внешний интерфейс C++ — он всегда отслеживает потенциальные ошибки/диагностику в побочном состоянии во время синтаксического анализа — он всегда отслеживает множество вещей

- Если он сталкивается с проблемой, он распечатайте его из диагностики, если он включен, иначе он просто "продолжит работать"

- Это также упрощает распечатку диагностического контекста, поскольку он отслеживает контекст во время синтаксического анализа

- Диагностическая информация сама по себе может также привести к лучшему исправлению ошибки — чтобы продолжать двигаться вперед, вы можете продолжать синтаксический анализ, а не просто отказываться от первой обнаруженной ошибки .

- Некоторые языки хотят выдавать больше полезных ошибок, а не только первую при вызове компилятора

- Особенно если время компиляции медленное! Хотите иметь несколько ошибок, которые вы можете исправить, а не только первую, до перекомпиляции

- Похоже на "расслабленный режим" при синтаксическом анализе "причуд" HTML

- Если вы знакомы с историей HTML, то знаете, что в XHTML и HTML5, а также в предыдущих версиях происходили эти колебания.

- Были люди, которые были очень религиозны в отношении того, что "HTML должен анализироваться абсолютно правильно, и любая небольшая ошибка не должна отображать веб-страницу" против "HTML должен анализироваться... типа... что угодно!" [ср. Закон Постеля]

- Если вы посмотрите на синтаксические анализаторы HTML в современных браузерах, они делают очень интересные вещи, чтобы иметь возможность формировать слегка искаженный HTML, который «случайно работает»

- Способность очень хорошо обрабатывать сообщения об ошибках и случаи ошибок с использованием частично сконструированной информации в конечном итоге немного вредит возможности модуляции [процесса синтаксического анализа] — в конечном итоге вы хотите добраться до «окружающих», «то, что не закончилось».

Можете ли вы построить ввод, который нарушает это ожидание?

Что происходит?

Можете ли вы построить ввод, который нарушает это ожидание?

Что происходит? .. и parse-y ... время года

.. и parse-y ... время года е. затем-эмит-пасс-стиль]

е. затем-эмит-пасс-стиль] y

y  е. есть что-то, чего вы не понимаете, из чего вы получите свой сдвиг, уменьшающий конфликты, из вашего внутреннего цикла, но это запускает события в этом другом файле

е. есть что-то, чего вы не понимаете, из чего вы получите свой сдвиг, уменьшающий конфликты, из вашего внутреннего цикла, но это запускает события в этом другом файле Ключевым моментом является понимание того, как сделать языки регулярными по форме, даже если они реализованы как рекурсивный спуск вручную. В синтаксическом анализаторе с рекурсивным спуском, свернутым вручную, стремление написать LL(1), например, когда вы можете устранить неоднозначность, в каком направлении движется грамматика, с помощью единственного маркера просмотра вперед, является хорошей идеей.]

Ключевым моментом является понимание того, как сделать языки регулярными по форме, даже если они реализованы как рекурсивный спуск вручную. В синтаксическом анализаторе с рекурсивным спуском, свернутым вручную, стремление написать LL(1), например, когда вы можете устранить неоднозначность, в каком направлении движется грамматика, с помощью единственного маркера просмотра вперед, является хорошей идеей.] е. в конечном автомате, чтобы декодировать грамматику, которую вы анализируете

е. в конечном автомате, чтобы декодировать грамматику, которую вы анализируете е.

е.

анализировать больше мегабайт текста в секунду в вашей структуре данных

анализировать больше мегабайт текста в секунду в вашей структуре данных