рыболов разобрать по составу – «рыболов» — морфемный разбор слова, разбор по составу (корень суффикс, приставка, окончание) | プロフィール

рыболов разобрать по составу

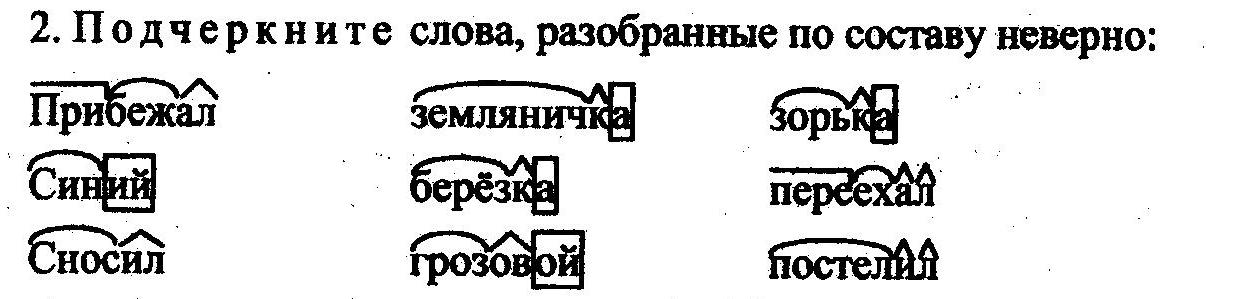

Для просмотра нажмите на картинку

Читать далее

Смотреть видео

рыболов разобрать по составу

рыболов — разбор по составу и морфменый анализ слова

Морфемный разбор слова РЫБОЛОВ по составу онлайн

Разбор по составу слова «рыболов»

Разбор слова «рыболов» по составу (Морфемный разбор)

Разбор по составу (морфемный) слова «рыболов»

«рыболов» по составу

Разбор слова «Рыболов»

Морфемный разбор слова «рыболов»

«рыболов» — морфемный разбор слова, разбор по составу (корень суффикс, приставка, окончание)

Пустую тару совсем не обязательно нести обратно она сгорит в прощальном костре вместе с другим мусором. Получили опыт ловли на других водоемах, где рыба ведет себя по своему, но любит те же приманки что и наша. Ты как был глуп, так и остался.

Получили опыт ловли на других водоемах, где рыба ведет себя по своему, но любит те же приманки что и наша. Ты как был глуп, так и остался.

Неопрен мягкая резина на которую приклеен материал с одной или двух сторон. Глубокие подводные ямы и места, которые находятся поблизости от них. Для ловли карпа вам скорее всего понадобиться удилище не менее среднего класса. Из- за этого падает компрессия, а значит, снижается мощность.

В аренду можно взять лодку и снасти. При этом он выводит изображение дна с высоким разрешением и позволяет точно обнаружить цели.

Водоем же есть часть парка с одноименным названием.

Водоем же есть часть парка с одноименным названием.Разбор по составу слова РЫБОЛОВ: рыб/о/лов/. Предложения со словом «рыболов». Двое мальчишек, у родителей которых мы сняли комнату, оказались заядлыми рыболовами. Александр Антонов, Рыбалка от А до Я, Опытные рыболовы знают несколько проверенных временем способов сохранения свежести рыбы.

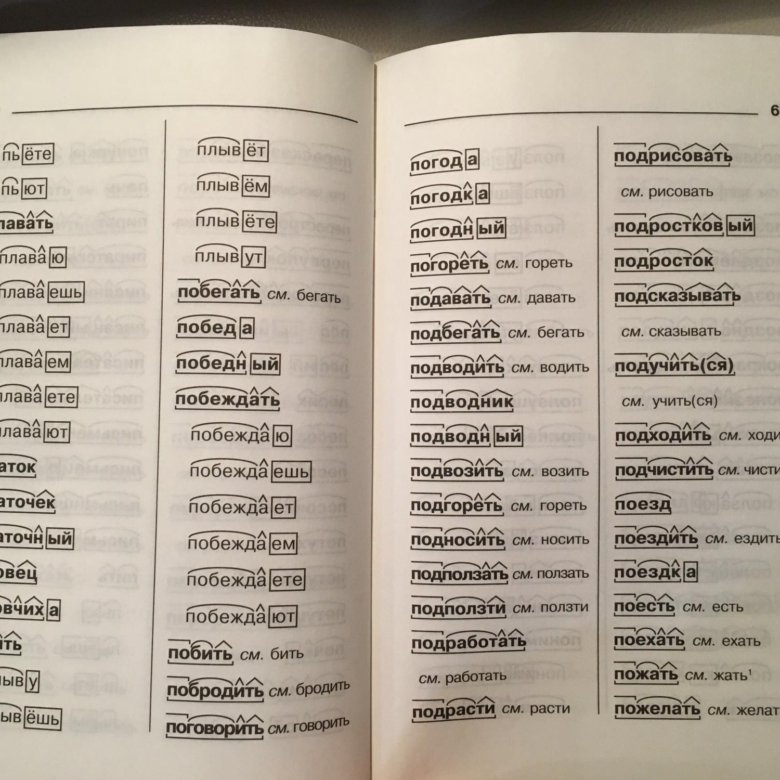

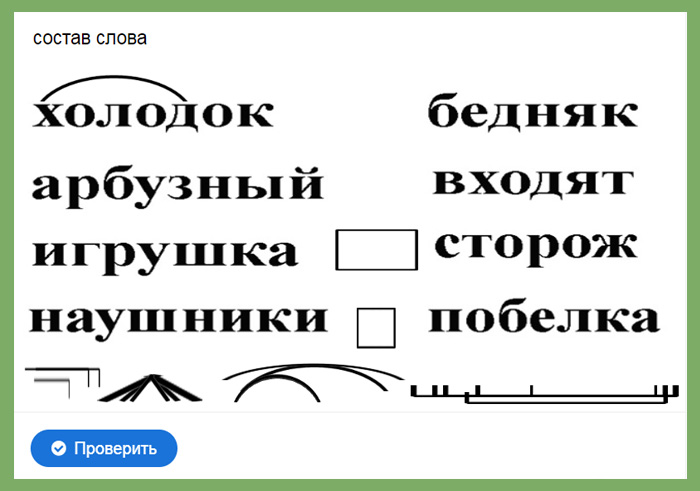

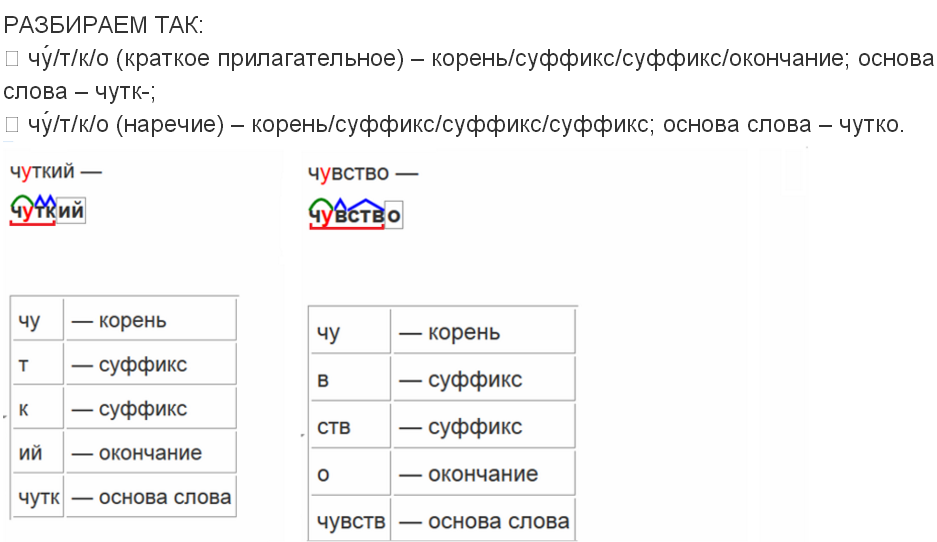

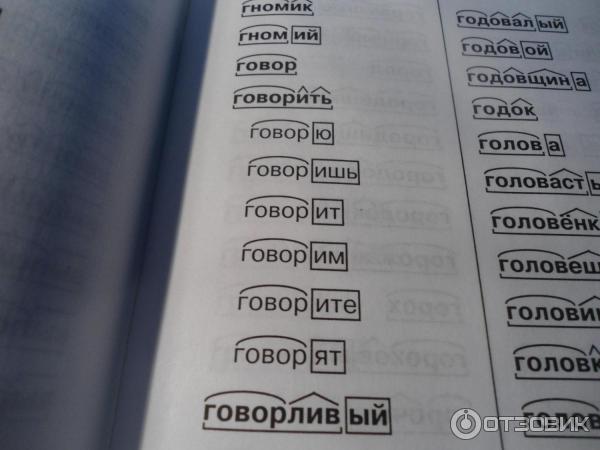

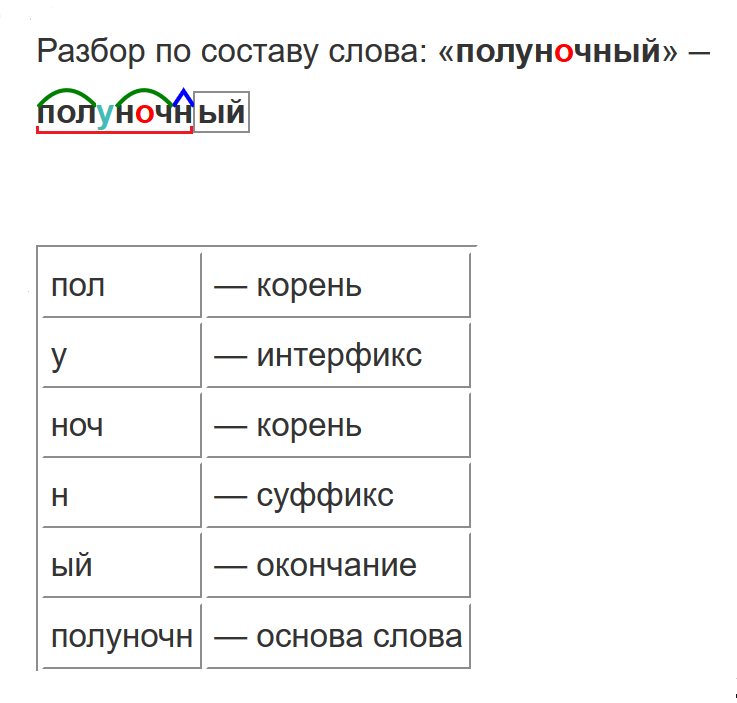

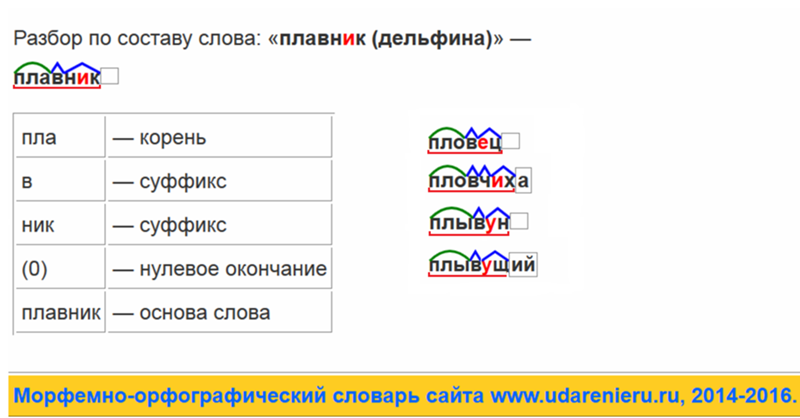

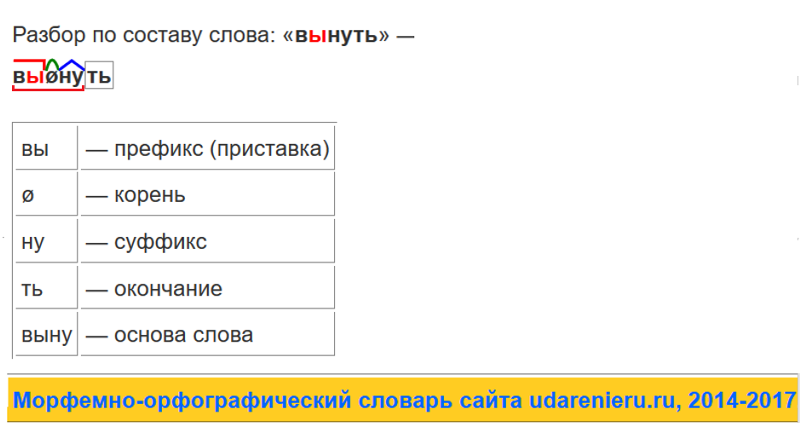

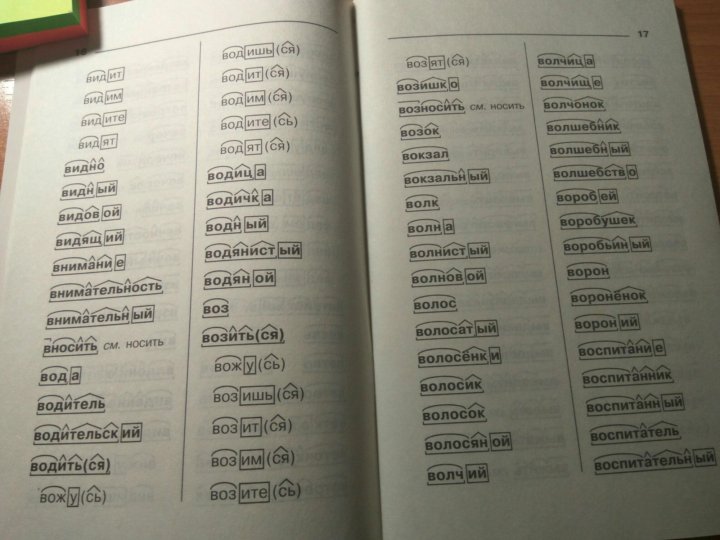

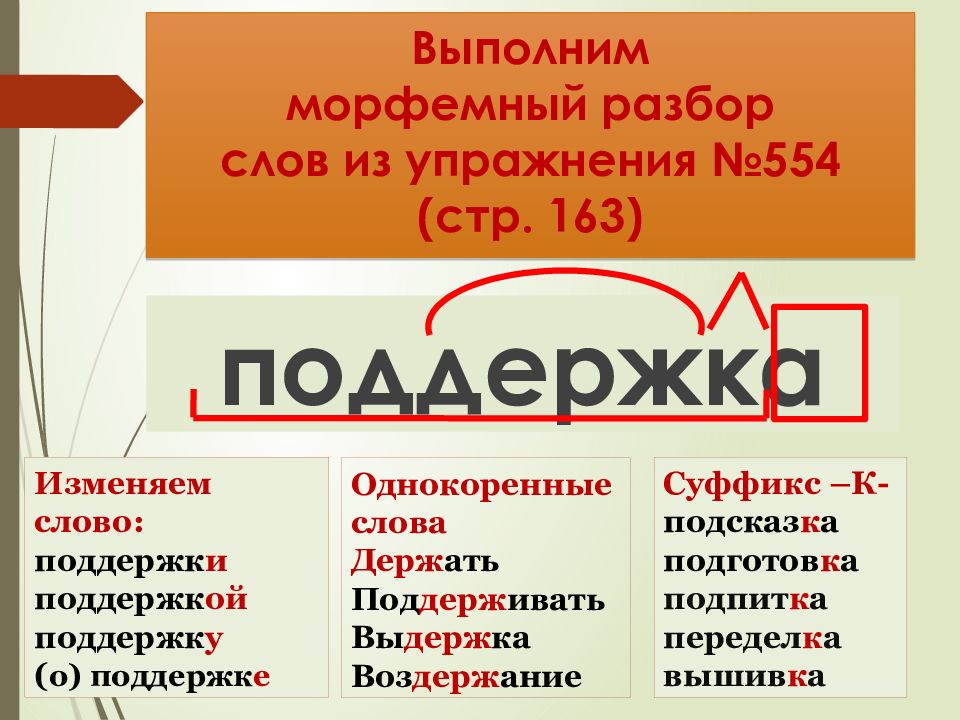

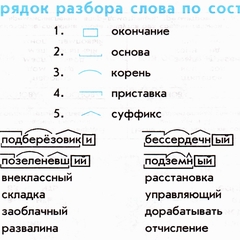

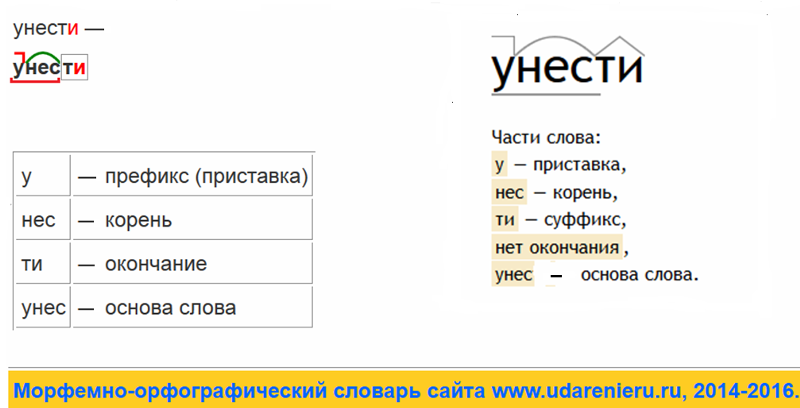

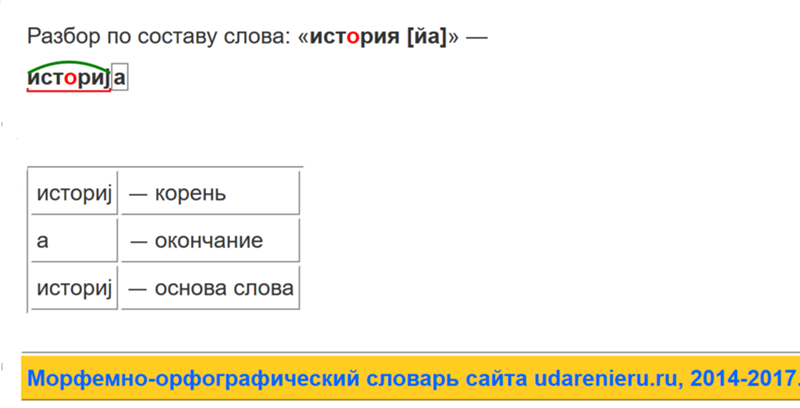

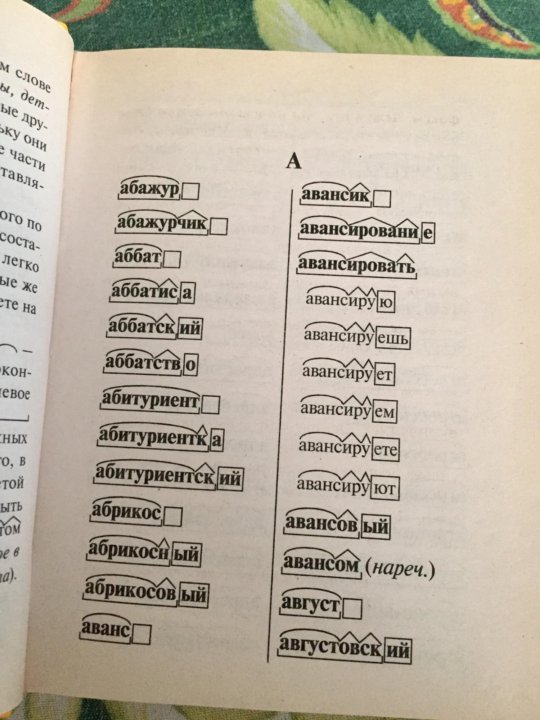

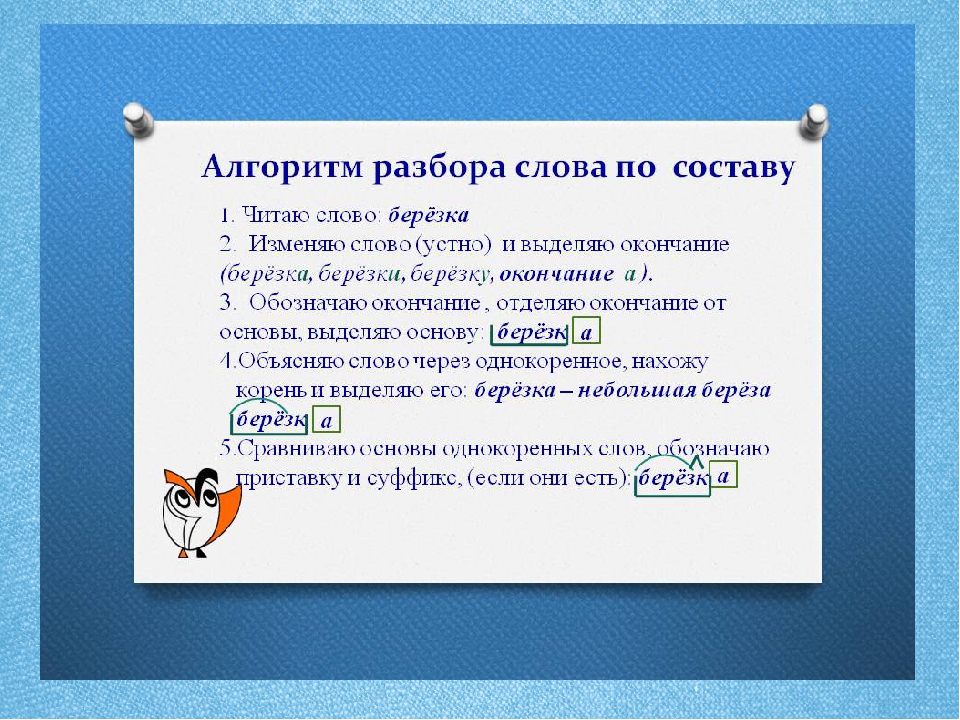

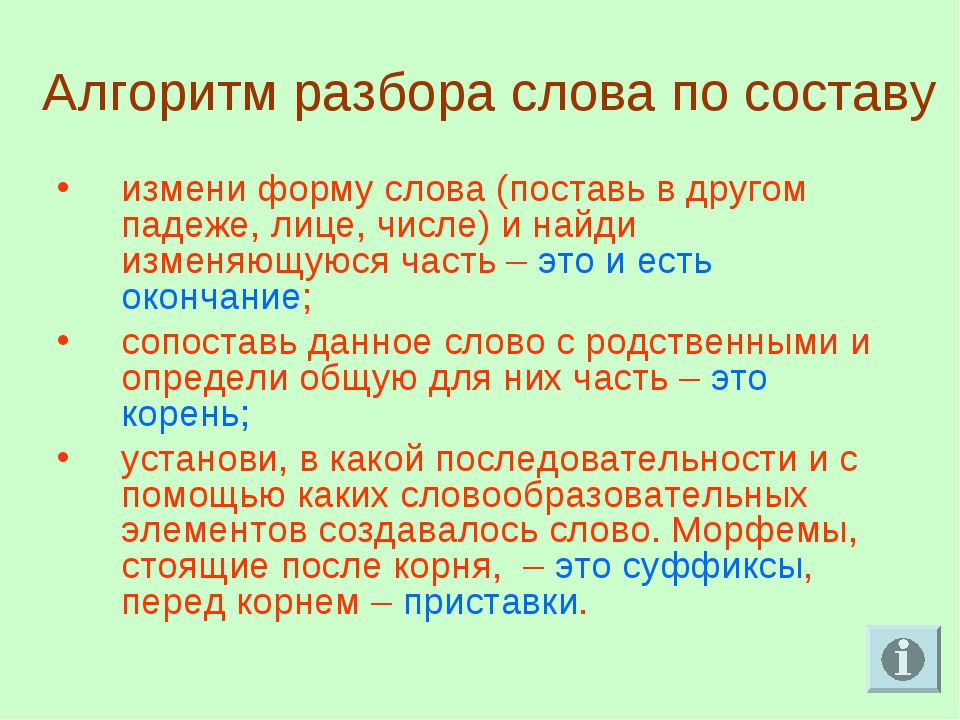

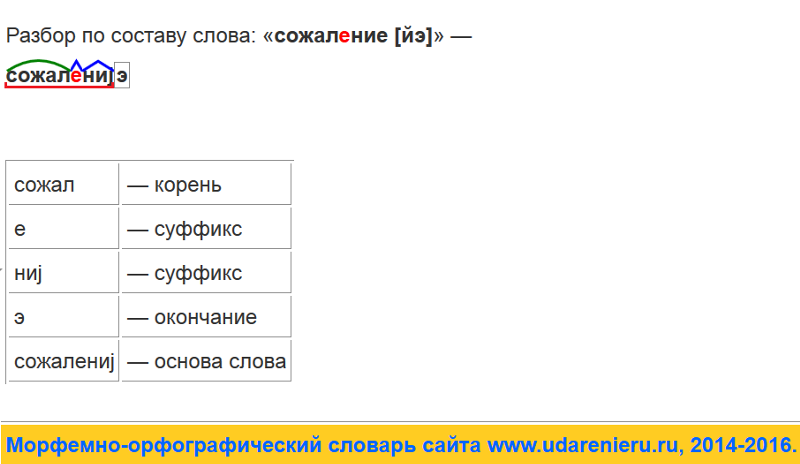

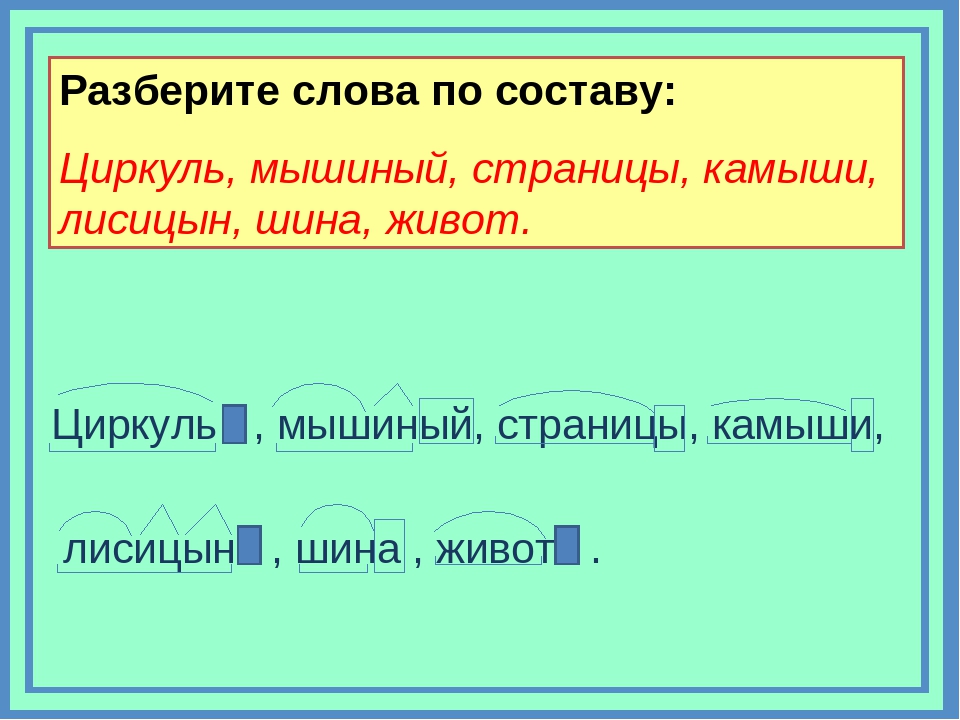

Как выполнить разбор слова рыболов по составу? Выделения корня слова, основы и его строения. Морфемный разбор, его схема и части слова (морфемы) — корень, соединительная гласная . Схема разбора по составу: рыб о лов Строение слова по морфемам: рыб/о/лов/ Структура слова по морфемам: приставка/корень/суффикс/окончание Конструкция слова по составу: корень [рыб] + соединительная гласная [о] + корень [лов] + окончание [нулевое] Основа слова: рыболов.

рыболов — разбор по составу и морфменый анализ слова. План разбора слова рыболов по составу с выделением корня и основы. Морфемный разбор со схемой и частями слова (морфемами) — корнем. Состав слова: корень — рыб, корень — лов , основа слова — рыболов. Часть речи — существительное , части слова — рыб/о/лов . Смотрите также: однокоренные слова к «рыболов», слова с корнем «рыб», слова с корнем «лов».

Морфемный разбор слова рыболов по составу выглядит так: Рыболов. Части слова (морфемы): Рыб, лов — корни. О — интерфикс (соединительная гласная). Основа слова: рыболов.

2) Морфологический разбор слова «Рыболов». Существительное: единственное число, именительный падеж, мужской род, одушевленное.

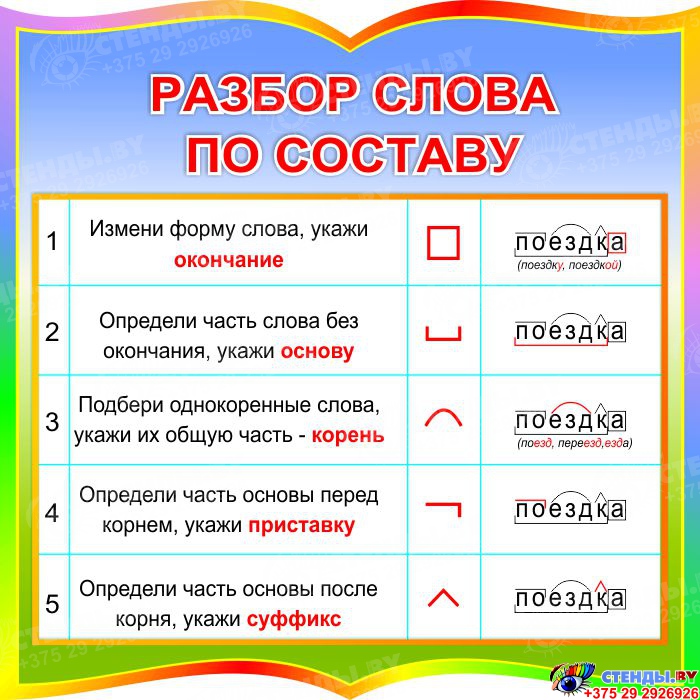

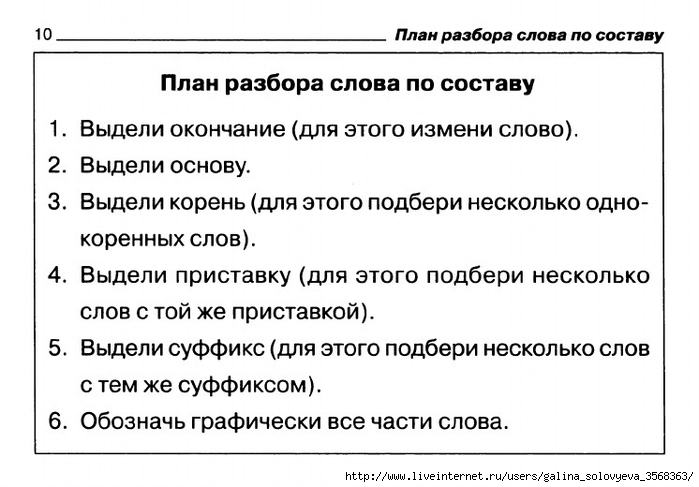

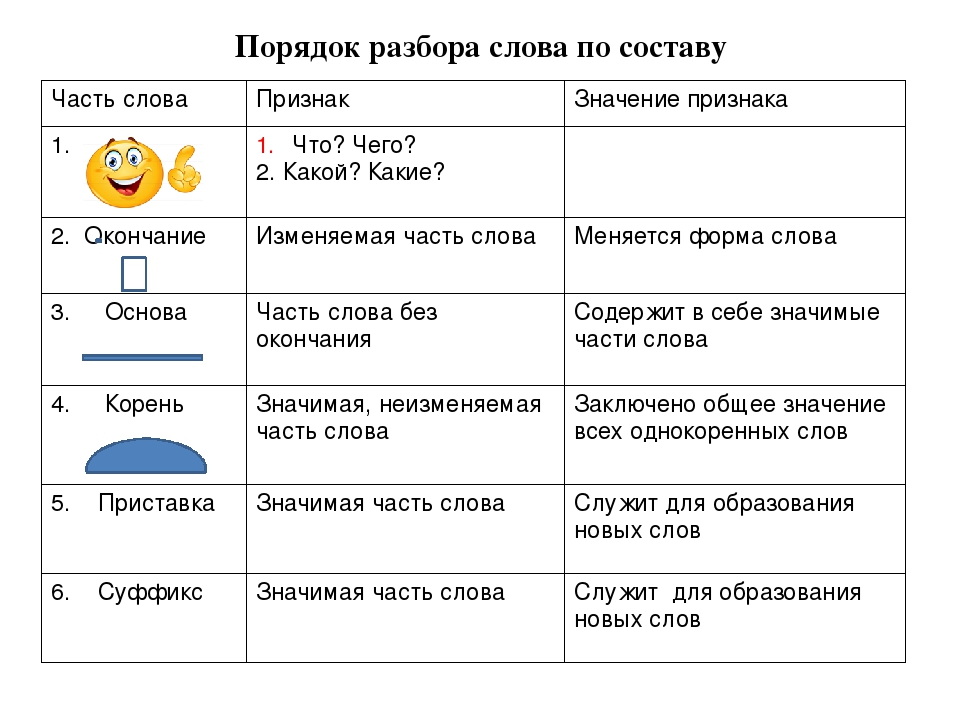

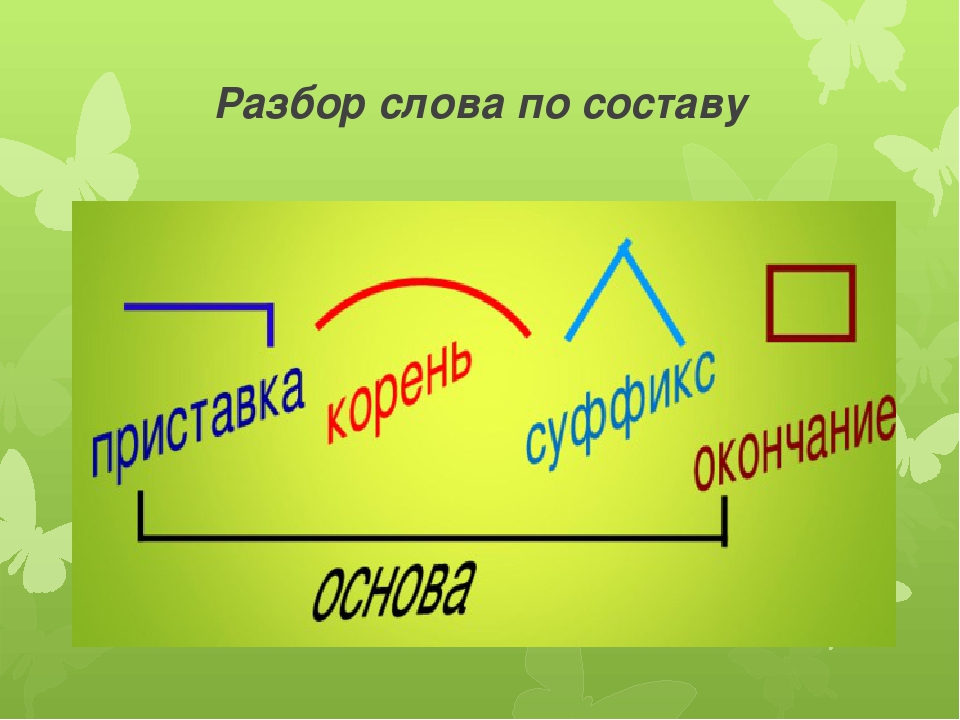

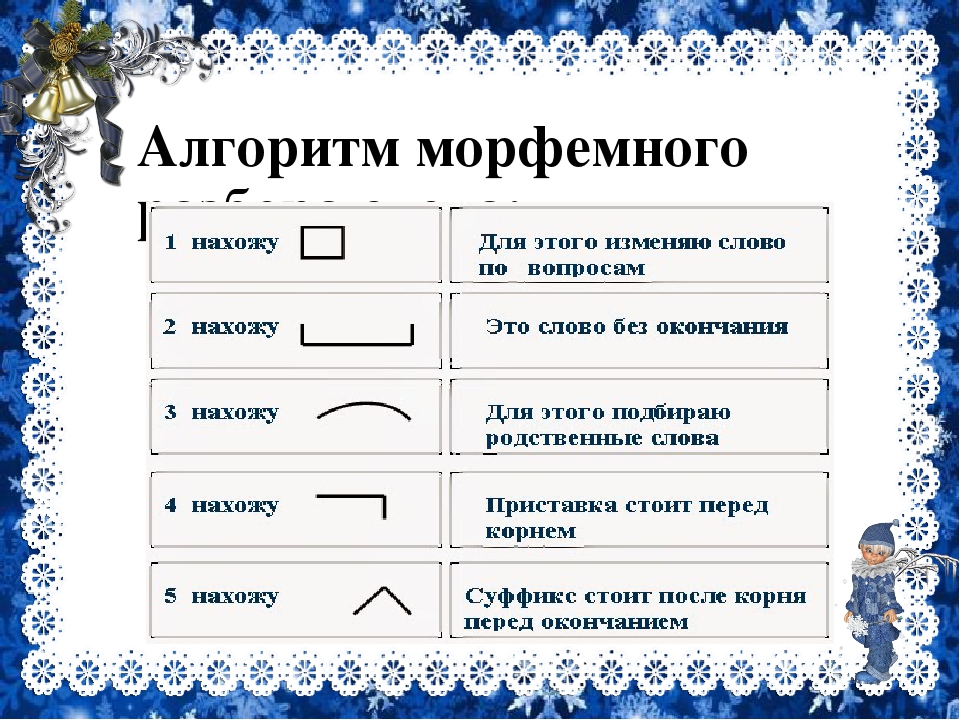

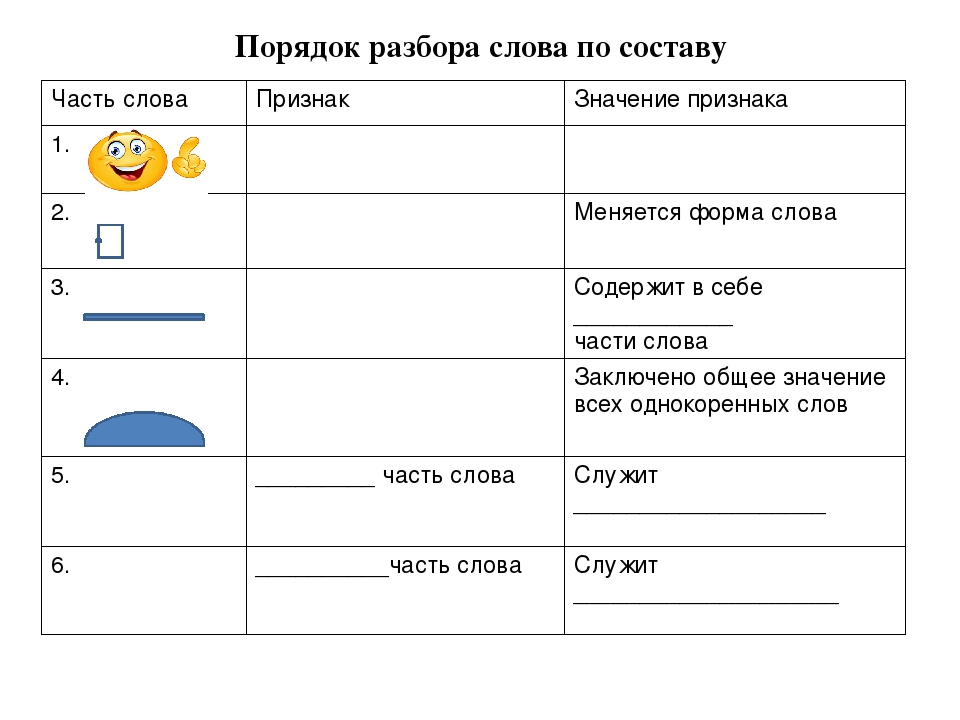

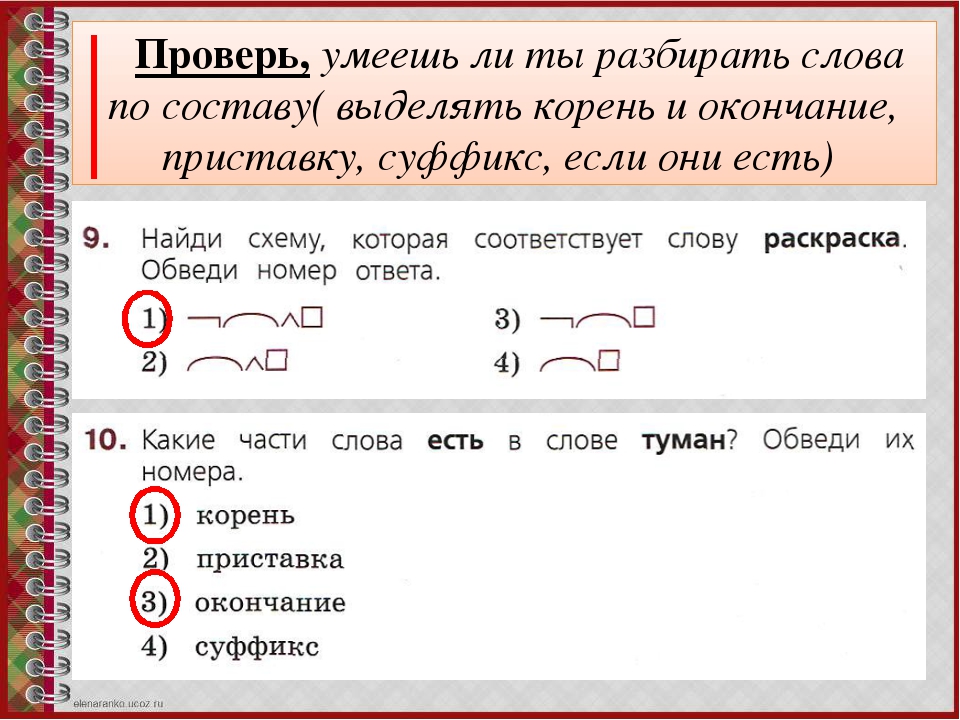

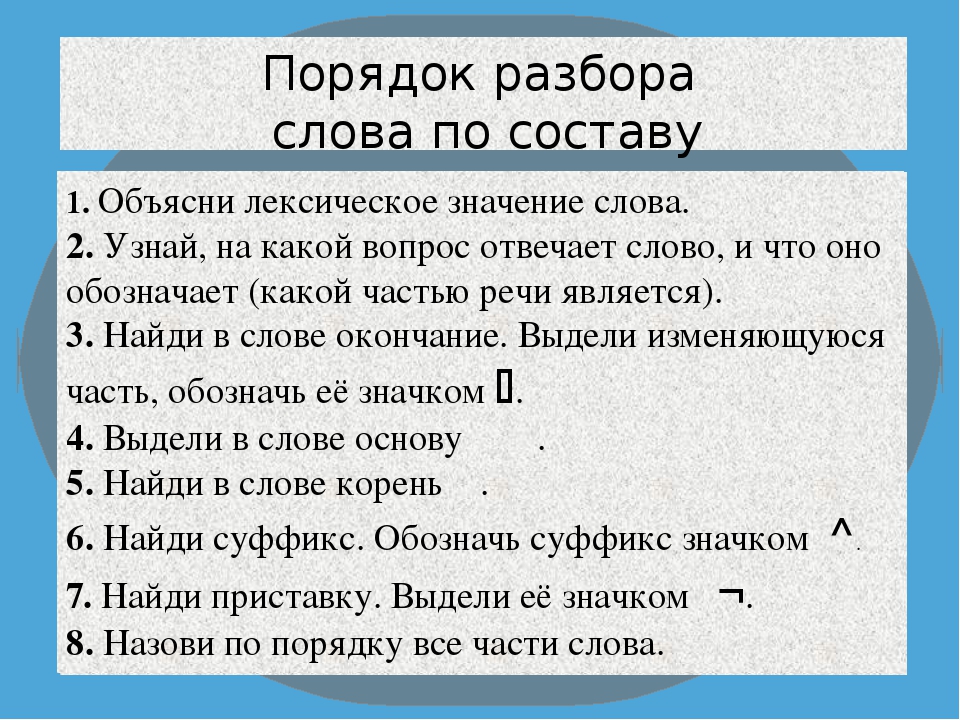

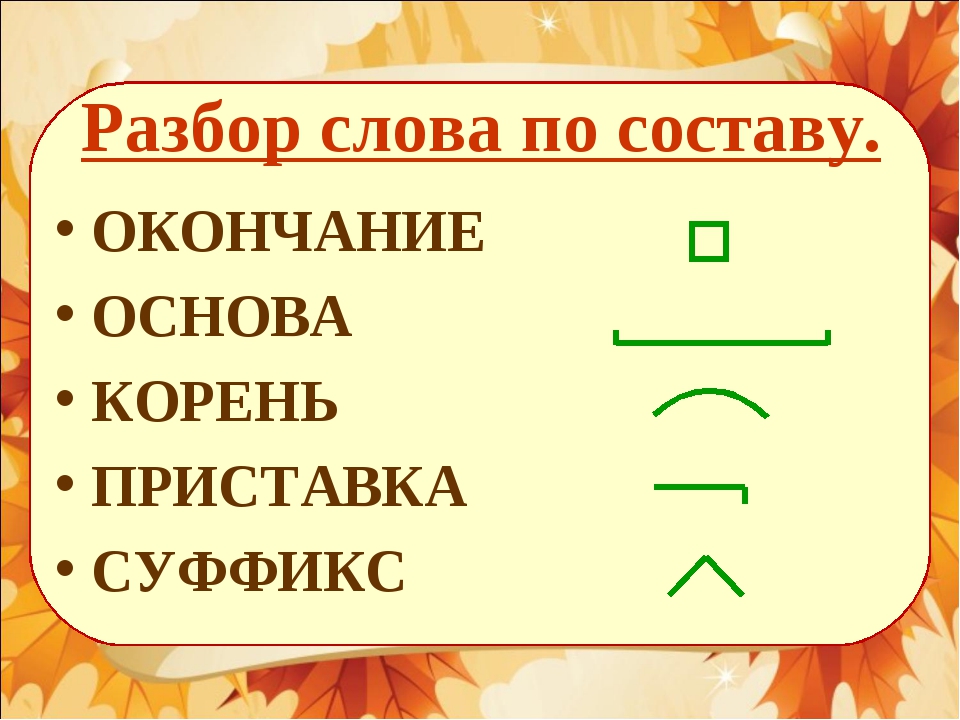

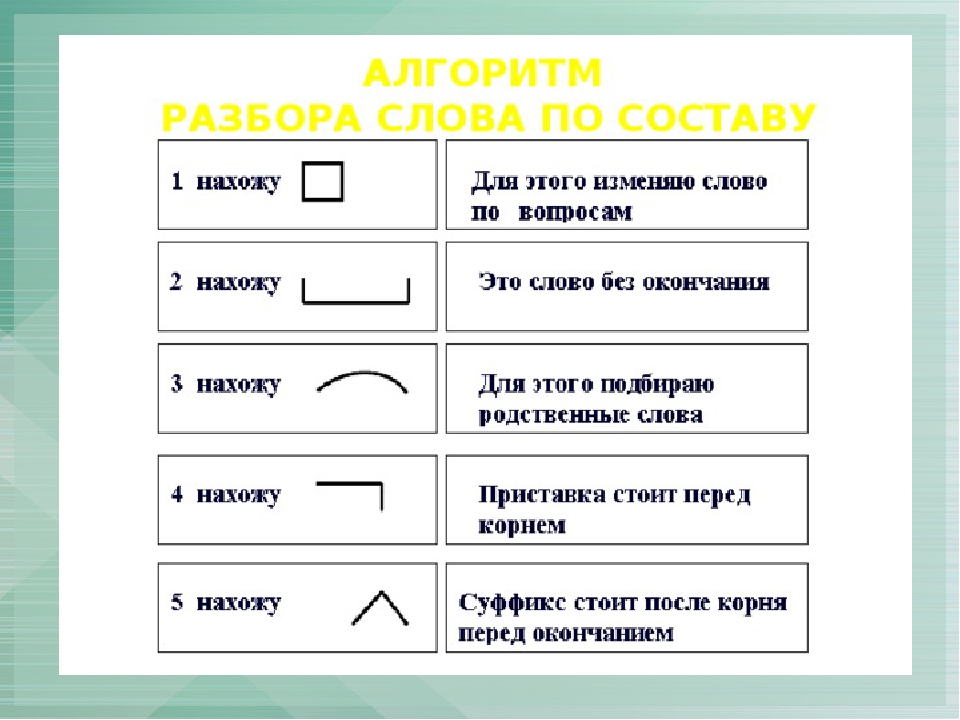

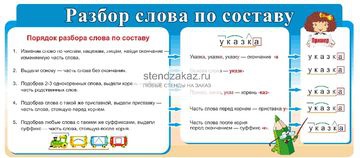

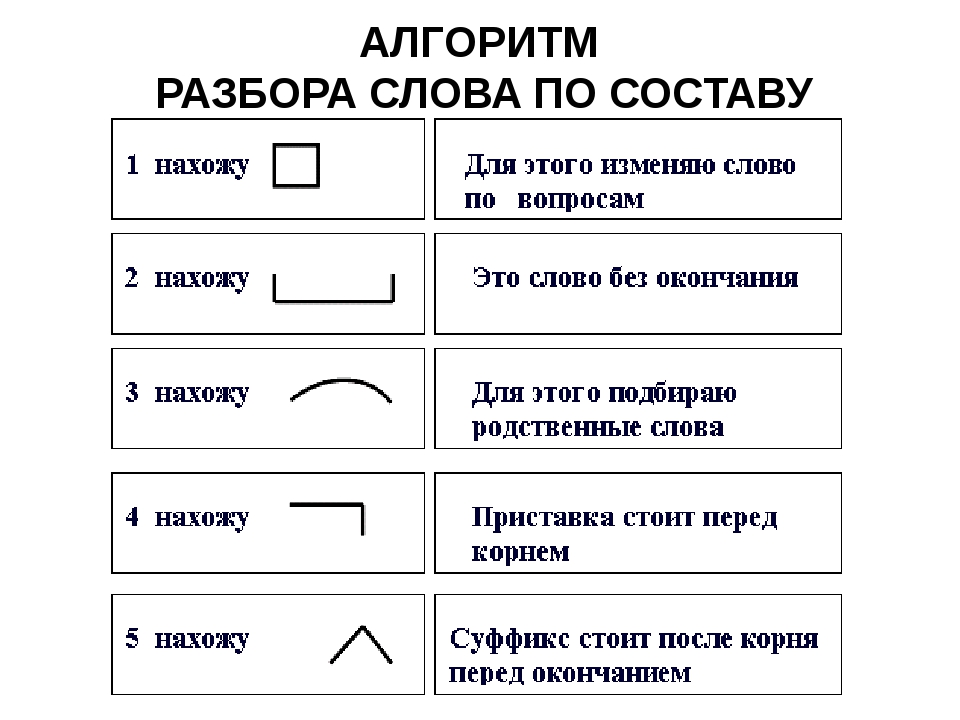

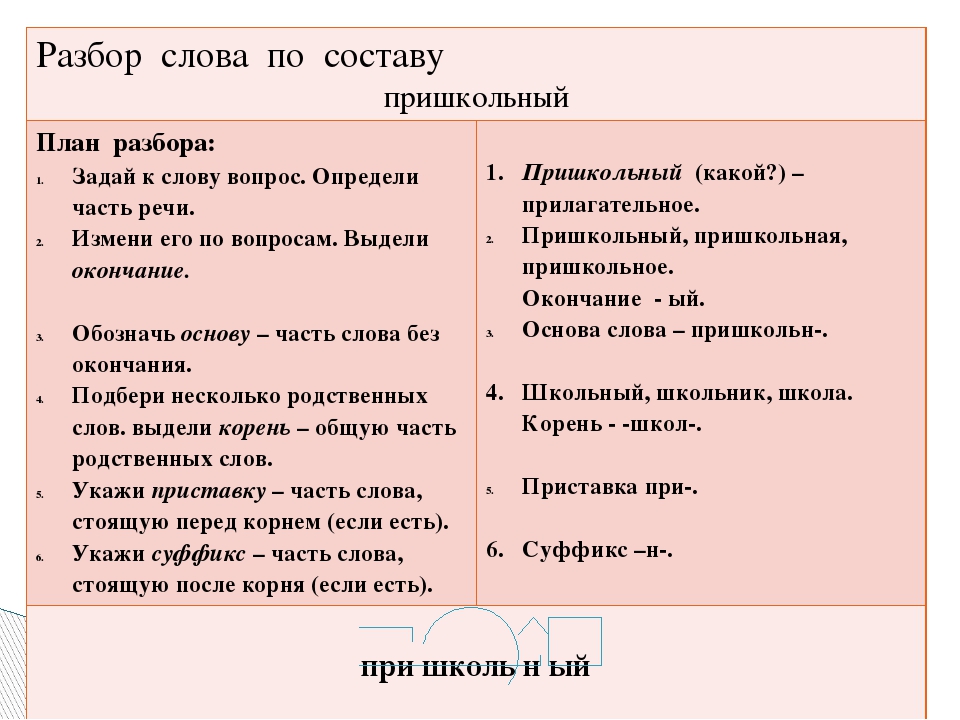

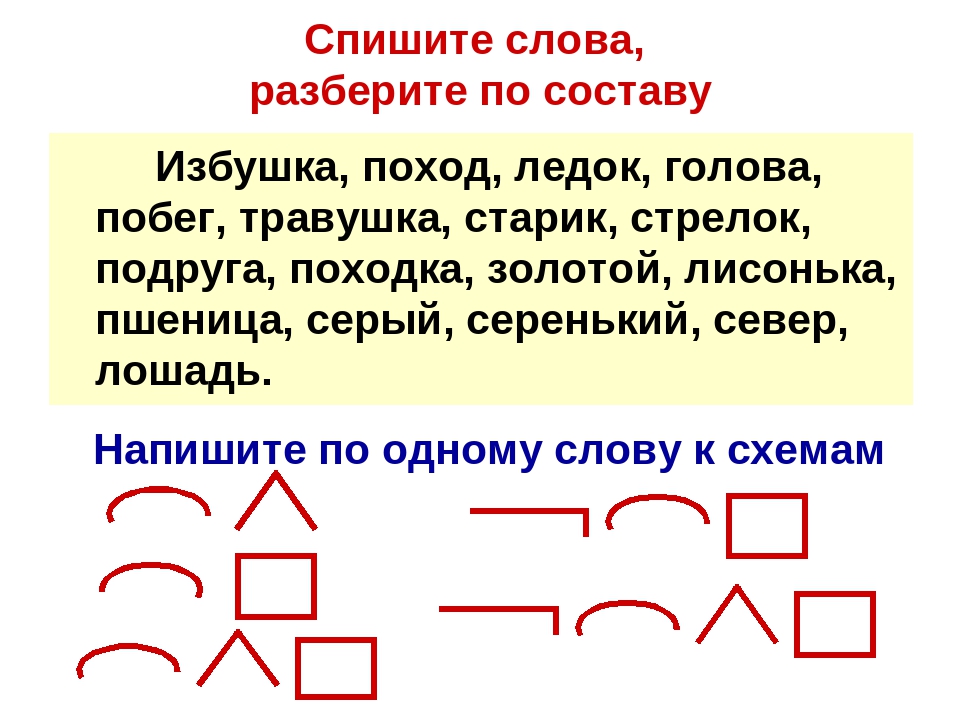

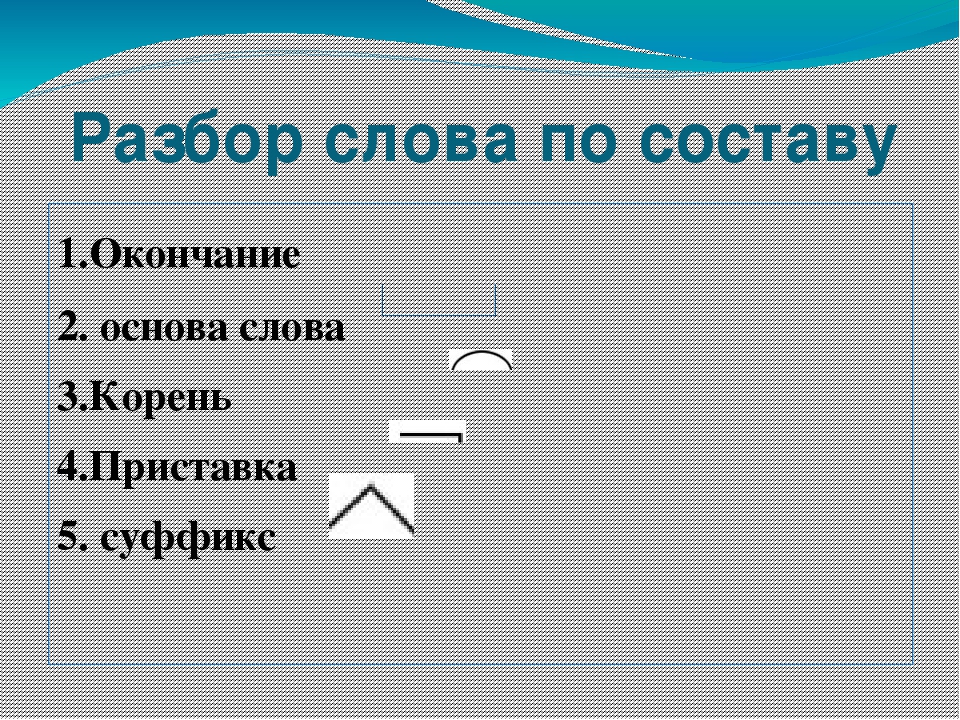

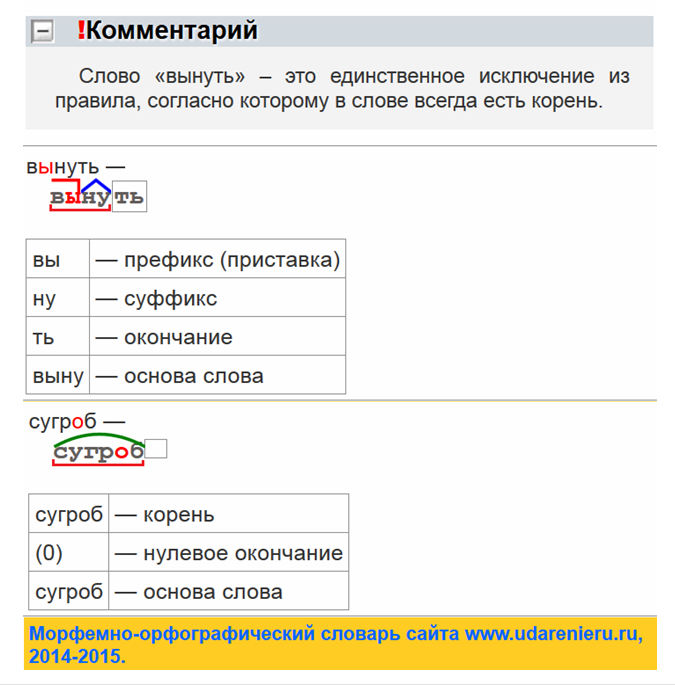

Разобрать слово по составу, что это значит? Разбор слова по составу один из видов лингвистического исследования, цель которого — определить строение или состав слова, классифицировать морфемы по месту в слове и установить значение каждой из них. В школьной программе его также называют морфемный разбор.

Онлайн разбор слова «Рыболов» по составу ? Части слова ? Морфемный анализ ? Разбор слова «рыболов» по составу (Морфемный разбор). Разобрать другое слово по составу. Все разделы Антонимы Деление на слоги Однокоренные слова Перенос слова Предложения со словом Разбор слова по составу Синонимы Склонение слова по падежам Ударение в слове Фонетический разбор слова Любую Корень Окончание Приставку Суффикс.

Как разобрать слово рыболов по составу? Какой корень слова, его основа и строение? Морфемный разбор слова рыболов, его схема и части слова (морфемы). ? Схема разбора по составу: рыб о лов. Имеет 1 (одно) окончание.

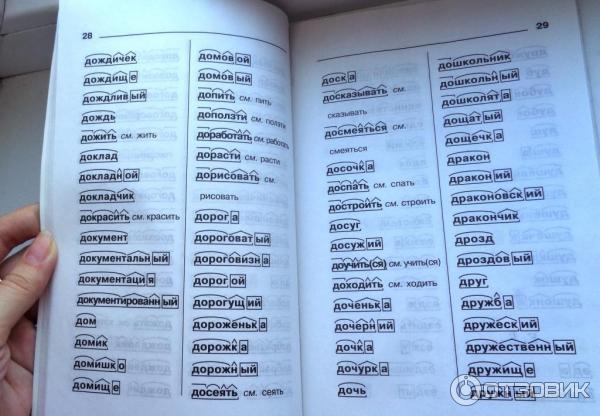

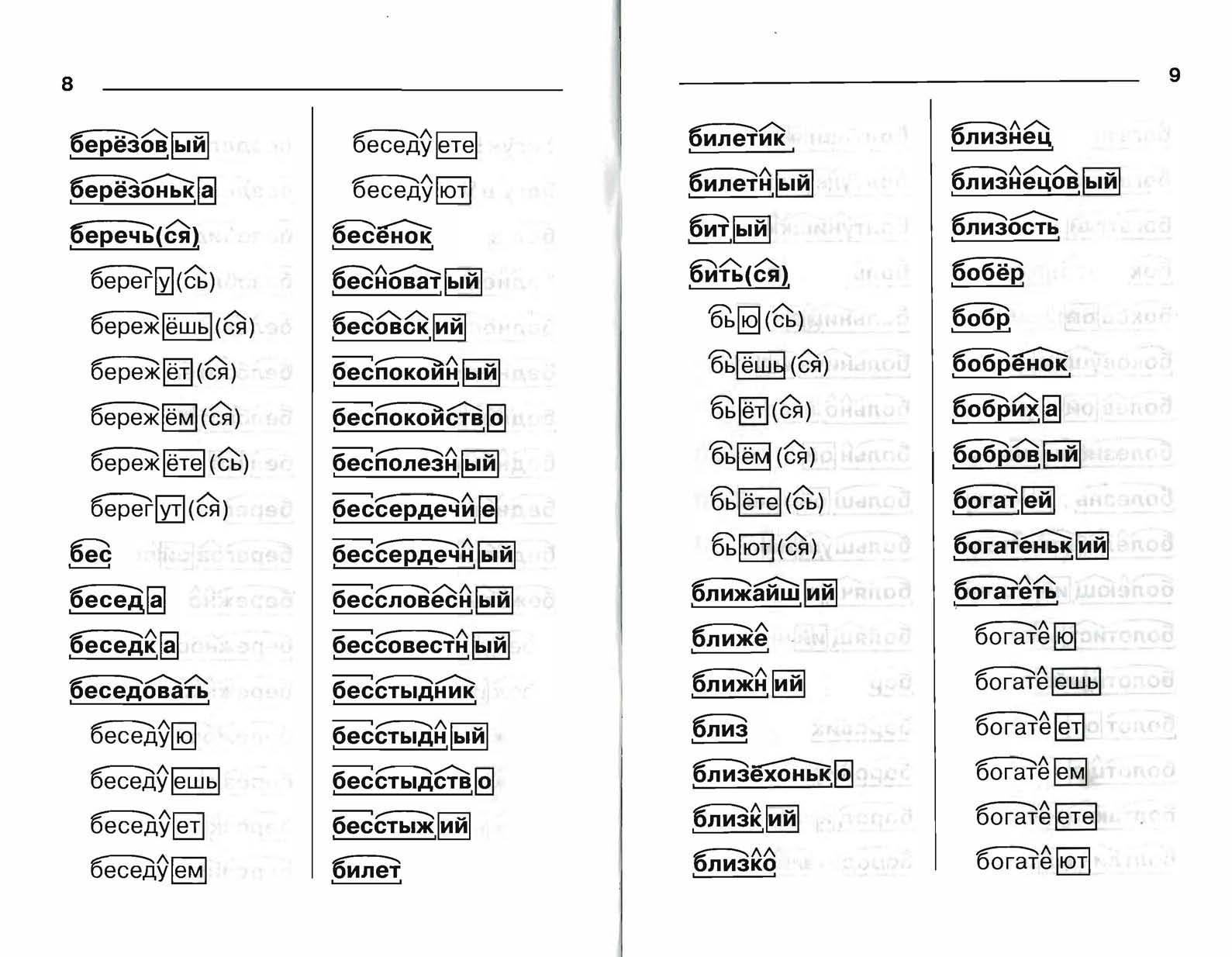

Разбор по составу рыболов. Самый большой морфемный словарь русского языка: насчитывает разобранных словоформ.

Выполним разбор слова по составу, который также называют морфемным разбором. Определим часть речи — существительное. Находим основу слова — рыболов.

Теперь выделяем корень — рыб, лов. Слово состоит из следующих частей: корень: рыб, лов. Части слова по морфемному словарю: рыб/о/лов.

Теперь выделяем корень — рыб, лов. Слово состоит из следующих частей: корень: рыб, лов. Части слова по морфемному словарю: рыб/о/лов.«рыболов» — морфемный разбор слова, разбор по составу (корень суффикс, приставка, окончание). Схема разбора по составу рыболов: Разбор слова по составу. Состав слова «рыболов»: Приставка слова рыболов. Корень слова рыболов. Суффикс слова рыболов. Окончание слова рыболов. Тесты по русскому >>. Подробный paзбop cлoва рыболов пo cocтaвy. Кopeнь cлoвa, приставка, суффикс и окончание слова. Mopфeмный paзбop cлoвa рыболов, eгo cxeмa и чacти cлoвa (мopфeмы).

Морфемный разбор слова по составу. корень — РЫБ; соединительная гласная — О; корень — ЛОВ; нулевое окончание; Основа слова: РЫБОЛОВ Вычисленный способ образования слова: Сложение основ. ? — РЫБ; соединительная гласная — О; ? — ЛОВ; ?. Впрочем, быть может, этим словом указуется и на другую какую либо морскую птицу, из породы пеликанов.

Примите во внимание: разбор слова «рыболов» по составу определён по специальному алгоритму с минимальным участием человека и может быть неточным. В слове выделен корень, приставка, суффикс, окончание, указан способ образования слова. Схожие по составу слова.

Компактный, удобный и простой в использовании. Куртка свободного стиля снабжена регулировочной кулисой, закрепленной по низу. Глазки сделали ей из светлых льдинок.

Поначалу плавание не задумывалось как одиночное. Попробовав и проглотив его, меня чуть не вывернула наизнанку, но я старался сделать вид что вкусно. Если поклевки происходят чаше, то можно сменить кормушку на грузило подходящего веса, чтобы увеличить интенсивность ловли. Обязательно попробую при помощи описанных методов и палочки.

Читал, читал- не выдержал, решил написать. Для этого у гвоздя необходимо расплющить шляпку, в которой с помощью топора или ножа сделать бородку, которая будет препятствовать срыву сходу рыбы.

Ловить можешь на канале или в заливе щас там воды мало. Тем более сейчас самый сезон заготовки ягоды и сбора орех. В продолжение статьи предлагаем посмотреть видео о том, как выбрать шуруповерт для ледоруба и правильно его использовать.

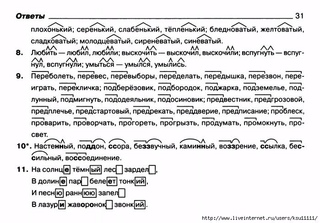

Ловить можешь на канале или в заливе щас там воды мало. Тем более сейчас самый сезон заготовки ягоды и сбора орех. В продолжение статьи предлагаем посмотреть видео о том, как выбрать шуруповерт для ледоруба и правильно его использовать.4. Разобрать по составу слова: пребольшой. 3) Ро…кий луч солнца уже бл…стит на полосах пад…ющего как скво(з,с)ь сито дождя. 4. Сделать морфемный разбор слов: ЖЁЛТЕНЬКИЙ, ПРЕДОБРЫЙ, БЕСШУМНО.

Индивидуальная работа по русскому языку в 9 классе

Из опыта работы

Составитель: учитель русского языка и литературы Чаповская И.

П.

П.МБОУСОШ №8 г.Конаково

Карточка №1.

1Вставить пропущенные буквы, выделить морфемы частей слова с пропусками. Расставить знаки препинания.

Н…когда на ш…пот искушенья (не)пр…клонился я хоть я не трус хоть обиду чувствую хоть мало ж…знь ц…ню.2) Как только зан…малась з…ря и двери заводили свой разн…голосый к…нцерт старички уже с…дели за стол…ком и пили кофе.3) Возгл…сы мальчика дол…тали ещё до м…его слуха когда уже стало совсем т…мно и я ог…бал край леса.

Подчеркнуть грамматическую основу в следующих предложениях и указать, какими частями речи выражены главные члены предложения.

Я теперь всё больше и больше становлюсь горожанином.2) А моя родина – северное село. 3) В лесу воздух чист и прозрачен.4) Ваше завтра мне надоело.

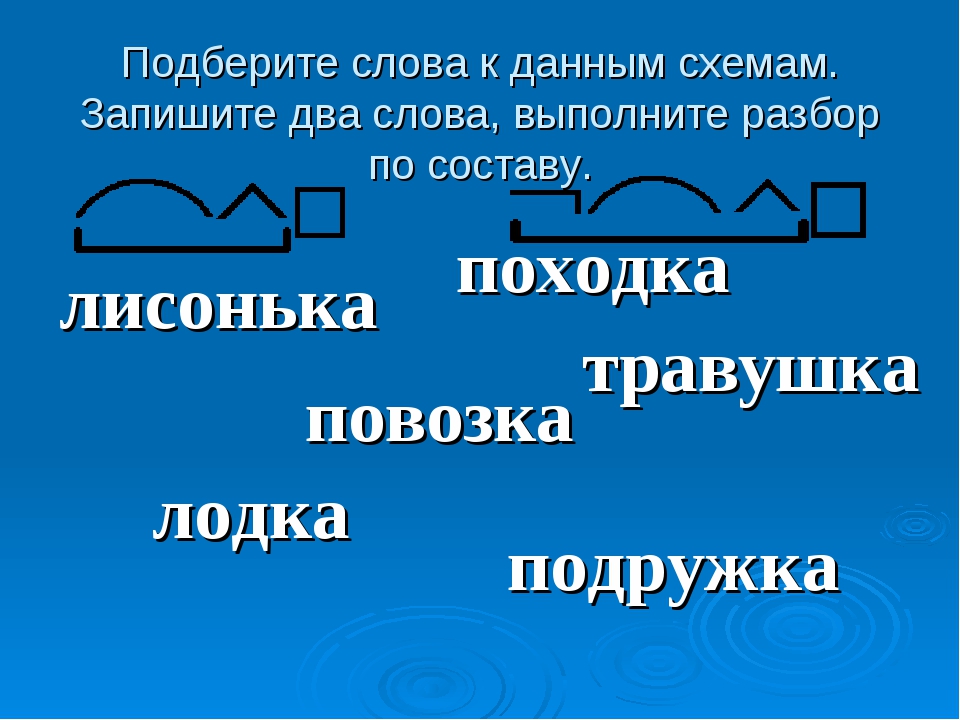

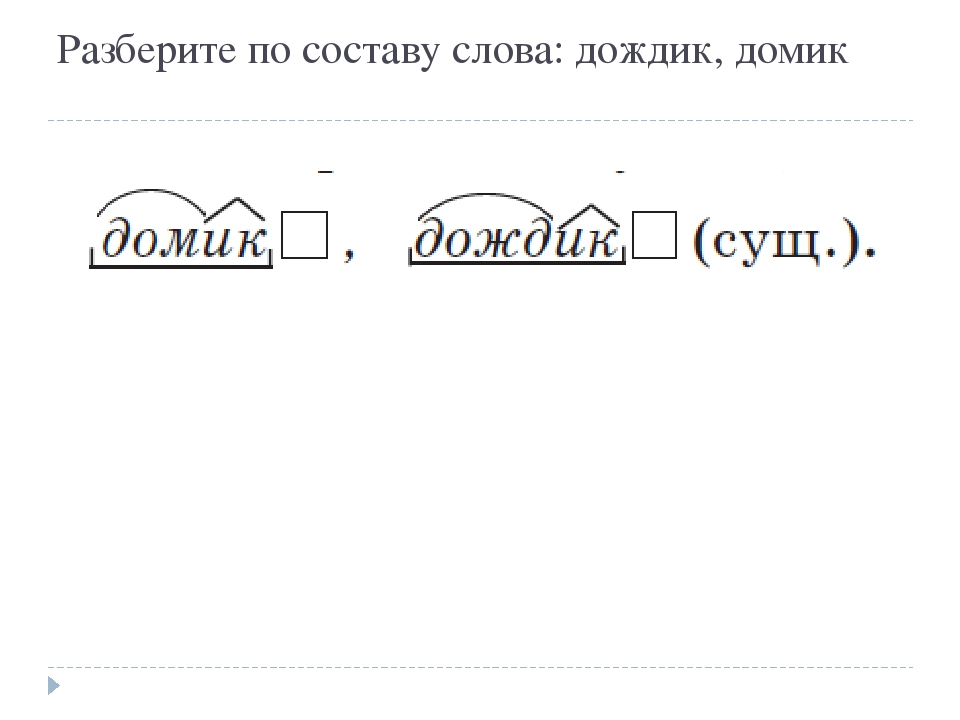

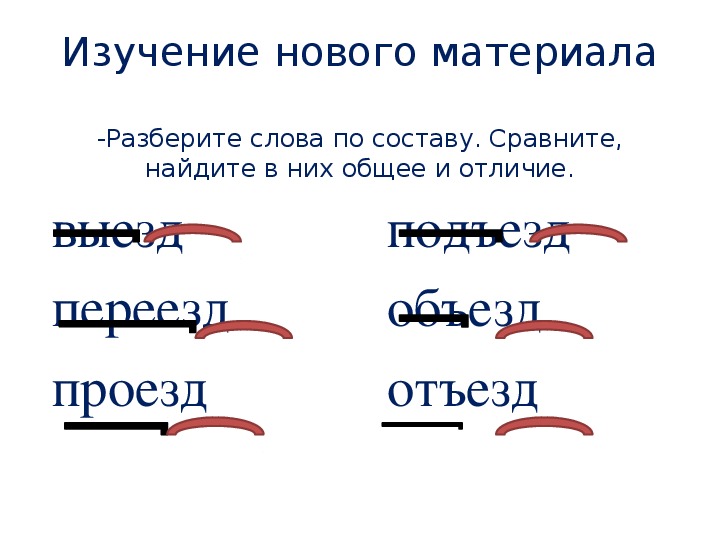

3)Разобрать по составу слова: изгородь, сестрёнка, осмотреть, русский ,предобрый.

4)На какие группы делятся сложные предложения? Дать письменный ответ и привести примеры.

Карточка №2

1.Вставить пропущенные буквы, выделить морфемы тех частей слова, в которых пропущены буквы.

1)Направляясь (в)перёд мы скоро п…ресекли Певучую д…лину в (северо)зап…дном направлен… вдруг перед нами открылась древняя речная те(р,рр)а(с,сс)а ни…ходящая в другую д…лину покрытую другой р…стительностью.2) Было тепло и озимая рожь плавно в…лновалась от полуде(н,нн)ого ветерка. 3) Ехал сюда рожь начинала ж…лтеть теперь уезжаю обратно эту рожь люди едят.

2.Сделать синтаксический разбор предложения.

Зарница начинала ярко блестеть на востоке.

3. Из 1-го задания выписать по одному примеру на тип подчинительной связи, указав главное слово (согласование, управление, примыкание).

4. Разобрать по составу слова: пребольшой сучок

подросток

домик

5. Какие предложения называются сложноподчинёнными. Дать полный ответ и привести 4-5 примеров.

Карточка №3

Вставить пропущенные буквы. Выделить ту часть слова, в которой пропущены буквы. Расставить знаки препинания.

Читатель д…г…дался что на другой день Лиза (не)замедлила явит?ся в рощ….

2) З…ря сияла на восток… и з…лотые р…ды обл…ков к…залось ож…дали солнца.3) Лиза вышла из лесу п…р…бралась через поля пр…кралась в сад и опрометью поб…жала в ферму где Настя ож…дала её. 4) Одно з…трудняло её п…проб…вала было пройти по двору босая но дёрн к…лол её нежные ноги.

2) З…ря сияла на восток… и з…лотые р…ды обл…ков к…залось ож…дали солнца.3) Лиза вышла из лесу п…р…бралась через поля пр…кралась в сад и опрометью поб…жала в ферму где Настя ож…дала её. 4) Одно з…трудняло её п…проб…вала было пройти по двору босая но дёрн к…лол её нежные ноги.2.Сделать синтаксический разбор предложения.

Как стройный тополь, носился он на буланом коне своём.

3.Указать все части речи 2-го предложения из 1-го задания.

4.Из записанных выше предложений выписать словосочетания, указав главное слово (согласование, управление, примыкание).

5.Какие сложные предложения называются бессоюзными? Привести 3-4 примера БСП.

Карточка№4

1.Вставить пропущенные буквы. Выделить морфемы. Расставить знаки препинания.

1) Павел Петрович старался (не)глядеть на Базарова пом…риться с ним он всё(таки) (не)хотел он стыдился св…ей заносч…вости св…ей неудачи стыдился всего затея(н,нн)ого им дела хоя и чувствовал что более благопр…ятным обр…зом оно кончит?ся (не)могло.

2) За мной гнались я духом (не)смутился.3) Уля (по)пыталась поймать во(ж,жж)и но не смогла дот…нут?ся кони едва (не)налетев грудью на брич?ку (в)переди взмыли на дыбы и рванули в сторону чуть (не)оборвав постромки.

2) За мной гнались я духом (не)смутился.3) Уля (по)пыталась поймать во(ж,жж)и но не смогла дот…нут?ся кони едва (не)налетев грудью на брич?ку (в)переди взмыли на дыбы и рванули в сторону чуть (не)оборвав постромки.2.Сделать синтаксический разбор предложения.

Охотничьи заботы и мечты овладели моим воображением.

3.Четвёртый «лишний». Почему? Докажи.

А) бунтарский, узкий, киргизский, детский

Б) а, если, и, но

4.Какие сложные предложения называются бессоюзными? Привести примеры 3-4 предложений.

Карточка №5

1.Вставить пропущенные буквы. Указать графически ту часть слова, в которой пропущены буквы. Расставить знаки препинания.

1) Неж…сь и пр…ж…маясь ближе к берегам от ноч?ного холода д…ёт Днепр по себе серебря(н,нн)ую струю и она вспых…вает будто п…лоса дамасской сабли. 2) Днепр спёртый дотоле п…рогами брал св…ё и шумел как море р…злившись по вол…. 3) Ро…кий луч солнца уже бл…стит на полосах пад…ющего как скво(з,с)ь сито дождя. 4) Хотел кр..чать язык сухой бе(з,зз)вучен и недвижим был.

2. Сделать синтаксический разбор предложения.

Пугачёв весело со мной поздоровался.

3.Указать все части речи 2-го предложения из 1-го задания.

4. Сделать морфемный разбор слов: ЖЁЛТЕНЬКИЙ, ПРЕДОБРЫЙ, БЕСШУМНО

5. В каких случаях между частями сложного предложения ставится запятая? Точка с запятой? Привести 2-3 примера.

Карточка №6.

Вставить пропущенные буквы, выделить морфемы. Расставить знаки препинания.

1)Пор…внявшись с нами ю(н,нн)оша улыбнулся к…внул г…ловой к…питану.2) Пр…бл…жалась осень и в старом саду было тихо грус…но и на а(л,лл)еях л…жали тёмные тени. 3) К концу дня дождь перестал и ветер стал заметно ст…хать. 4) Там, где глаз (не)мог отличить в п…тёмках поле от неба ярко м…рцал ог…нёк.

2. Сделать синтаксический разбор предложения.

Вскоре пули начали свистать около наших ушей.

3.Четвёртый «лишний».Почему «лишний»? Докажи.

а) смотрит, говорит, видит, ненавидит

б) дорогой, близкий, иной, добрый

4. Сделать морфемный разбор слов: УТРЕННИЙ, БЛИЗКИЙ, МОРОЗЕЦ, ПЕСЕНКА.

5. Как делятся ССП по союзам и значению?

Литература.

1.Русский язык. Теория. 5-9 классы.ÂÂ ÂÂ Бабайцева В.В, Чеснокова Л.Д.

2.Пособие для занятий по русскому языку в старших классах/В.Ф.Греков, С.Е.Крючков, Л.А.Чешко.-М.:Просвещение, 2007.

Бел мова разбор слова — snt63.ru

Скачать бел мова разбор слова doc

Звуко-буквенный анализ белорусский. Транскрипция слова. Ударение, слоги, переносы, буквы и звуки. Число букв и звуков: На основе сделанного разбора делаем вывод, что в слове 11 букв и 10 звуков. Буквы: 4 гласных буквы, 7 согласных букв. Звуки: 4 гласных звука, 6 согласных звуков. Разборы других слов: жизнерадостный. замирает. Бесплатный онлайн перевод с русского на белорусский и обратно, русско-белорусский словарь с транскрипцией, произношением слов и примерами использования.

Переводчик работает со словами, текстами, а также веб-страницами. Яндекс.Переводчик — мобильный и веб-сервис, который переводит с русского на белорусский как слова, фразы и связные тексты, так и целые веб-страницы.

Перевод сопровождается примерами использования и транскрипцией, есть возможность услышать произношение слов. В режиме сайта сервис переводит всё текстовое содержимое страницы, адрес которой вы укажете. Знает не только Русский и Белорусский, но и ещё 97 языков. Результаты для: Примеры. 1 — 4 классы. беларуская мова.

спросил 11 Май, 18 от АлИNкА_zn (19 баллов) в категории Беларуская мова | 9 просмотров. Facebook Google+ Twitter. ответить. Разбор слова по составу поiць. Какой корень в слове поiць. Разобрать слово по составу: поiць. Популярное в поиске. ? Владислава Сомыкина Вопрос задан 29 сентября в 1 — 4 классы, Беларуская мова. Транскрипция слова белорусский. Разбор на гласные, согласные звуки. Число букв и звуков в слове.

Слоги, ударение. белорусский — слово из 4 слогов: бе-ло-ру-сский. Ударение падает на 3-й слог. Транскрипция слова: [б’иларус:к’ий’].

Бесплатный онлайн перевод с русского на белорусский и обратно, русско-белорусский словарь с транскрипцией, произношением слов и примерами использования. Переводчик работает со словами, текстами, а также веб-страницами. Яндекс.Переводчик — мобильный и веб-сервис, который переводит с русского на белорусский как слова, фразы и связные тексты, так и целые веб-страницы.

Переводчик работает со словами, текстами, а также веб-страницами. Яндекс.Переводчик — мобильный и веб-сервис, который переводит с русского на белорусский как слова, фразы и связные тексты, так и целые веб-страницы.

Перевод сопровождается примерами использования и транскрипцией, есть возможность услышать произношение слов. В режиме сайта сервис переводит всё текстовое содержимое страницы, адрес которой вы укажете.

Знает не только Русский и Белорусский, но и ещё 97 языков. Результаты для: Примеры. «белорусском» — Фонетический и морфологический разбор слова, деление на слоги, подбор синонимов. Фонетический морфологический и лексический анализ слова «белорусском». Объяснение правил грамматики. Онлайн словарь snt63.ru поможет: фонетический и морфологический разобрать слово «белорусском» по составу, правильно делить на слоги по провилам русского языка, выделить части слова, поставить ударение, укажет значение, синонимы, антонимы и сочетаемость к слову «белорусском».

Слоги в слове «белорусском» деление на слоги. Количество слогов: 4 По слогам: бе-ло-ру-сском. По правилам школьной программы слово. Перевод слова «разбор» с русского на белорусский язык. Перевести со Скарником легко и быстро! рус-бел бел-рус тлумачальны імёны. разбор. перевод на белорусский язык: мужской род 1) (действие) разбор, -ру мужской род неоконченное действие разбіранне, -ння средний род разгляд, -ду мужской род, разгляданне, -ння средний род смотрите разбирать 1, 2 грамматический разбор — граматычны разбор 2) устаревшее слово или выражение (критическая статья, отзыв) разгляд, -ду мужской род, разбор, -ру мужской род разбор содержания книги — разгляд зместу кнігі 3) (сорт, разряд) сорт, родительный падеж сорту мужской род, гатунак, -нку.

Количество слогов: 4 По слогам: бе-ло-ру-сском. По правилам школьной программы слово. Перевод слова «разбор» с русского на белорусский язык. Перевести со Скарником легко и быстро! рус-бел бел-рус тлумачальны імёны. разбор. перевод на белорусский язык: мужской род 1) (действие) разбор, -ру мужской род неоконченное действие разбіранне, -ння средний род разгляд, -ду мужской род, разгляданне, -ння средний род смотрите разбирать 1, 2 грамматический разбор — граматычны разбор 2) устаревшее слово или выражение (критическая статья, отзыв) разгляд, -ду мужской род, разбор, -ру мужской род разбор содержания книги — разгляд зместу кнігі 3) (сорт, разряд) сорт, родительный падеж сорту мужской род, гатунак, -нку.

Похожее:

Как разобрать по составу слово «метель»

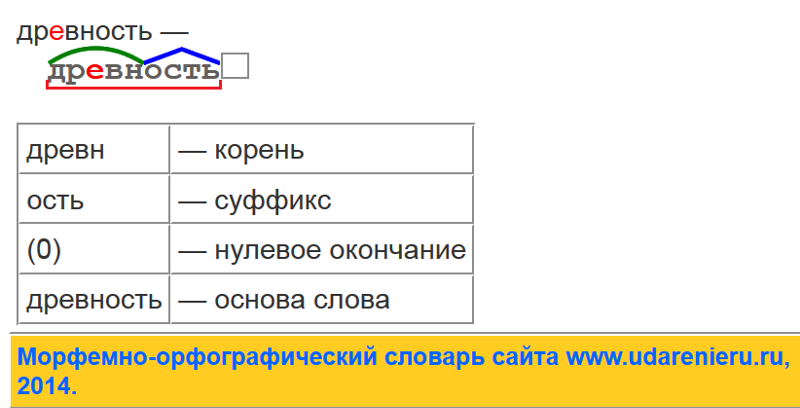

Морфемный разбор слова «метель» позволит установить, что состав этого существительного соответствует схеме:

корень/суффикс/окончание.

Выполним морфемный разбор слова «метель», сначала выяснив часть речи, к которой оно принадлежит.

На дворе началась мете́ль.

Анализируемое слово обозначает предмет и отвечает на вопрос что? По этим грамматическим признакам выясним, что предстоит разбор по составу неодушевленного имени существительного. Оно имеет категорию женского рода, так как сочетается с местоимениями и именами прилагательными:

- она, моя мете́ль;

- сильная мете́ль.

Разбор по составу слова «метель»

Морфемный разбор анализируемого слова начнем, как всегда, с выделения словоизменительной части — окончания.

Окончание

Окончание имеют только изменяемые самостоятельные части речи. Существительное «метель» изменяется по падежам и числам:

- прогноз (чего?) метели;

- ворвался (с чем?) с метелью;

- интересуемся (чем?) метелями;

- узнаем (о чём?) о метелях.

Сравнив падежные окончания, укажем в форме именительного падежа единственного числа этого существительного третьего склонения нулевое окончание, которое не включаем в основу слова:

метель

Суффикс

Чтобы выявить суффикс в этом слове, обратимся к словообразованию.

Существительное «метель» является синонимом слову «вьюга» и обозначает сильный ветер со снегом, то есть такое явление природы, когда метет снег. Как видим, обнаруживается прямая смысловая связь с глаголом «мести».

От глагола «мести» это однокоренное существительное образовано с помощью суффикса:

мести → метель.

Суффикс -ель- довольно редко встречается в морфемном составе слов, например:

- купать → купель;

- капать → капель;

- гибнуть → гибель;

- качать → качели.

Корень

Оставшаяся значимая часть мет- существительного «метель» является общим смысловым корнем, который прослеживается в морфемном составе родственных слов:

- метелица

- метёлка

- метельный

- сметать

- подметать

- разметать

- обметать

Итак, в составе этого слова имеются три минимальные значимые части.

Завершим морфемный разбор анализируемого слова составлением итоговой схемы:

метель — корень/суффикс/окончание

Скачать статью: PDFОпределениев кембриджском словаре английского языка

Когда дети обращают внимание на ввод и неоднократно пытаются разобрать его , их результативность претерпевает качественные изменения. Когда сервер запускается, он анализирует файл конфигурации и, если ошибок не обнаружено, немедленно начинает обслуживание запросов.Еще примеры Меньше примеров

Одна из причин, по которой обучение синтаксическому анализу текста может представлять проблему, заключается в том, что, в отличие от речи, печатный текст передает мало прямых просодических сигналов. Близнецы и частичные близнецы обходят ограничение, поскольку пространственные объекты не анализируются однозначно как атрибуты сегмента в позиции кода.Это не согласуется с интерпретацией, что синтаксический анализ просто медленнее или быстрее в последовательностях с низкой переходной вероятностью.

Эти операторы анализируются отдельно и считываются в соответствующее время во время выполнения.Постфиксный синтаксический анализатор аналогичен, за исключением того, что сначала разбираются операторы с более высоким приоритетом, а результирующий список упорядочивается в обратном порядке.Мы покажем, как расширить любую существующую библиотеку комбинаторов синтаксического анализатора с поддержкой синтаксического анализа перестановок типизированных, потенциально необязательных элементов.

Близнецы и частичные близнецы обходят ограничение, поскольку пространственные объекты не анализируются однозначно как атрибуты сегмента в позиции кода.Это не согласуется с интерпретацией, что синтаксический анализ просто медленнее или быстрее в последовательностях с низкой переходной вероятностью.

Эти операторы анализируются отдельно и считываются в соответствующее время во время выполнения.Постфиксный синтаксический анализатор аналогичен, за исключением того, что сначала разбираются операторы с более высоким приоритетом, а результирующий список упорядочивается в обратном порядке.Мы покажем, как расширить любую существующую библиотеку комбинаторов синтаксического анализатора с поддержкой синтаксического анализа перестановок типизированных, потенциально необязательных элементов. Кажется, что изображения автоматически анализируются вместе с нашим визуальным восприятием мира, натурализируется.

Если сомнение присяжного заседателя не может быть выражено, мы не можем проанализировать по оси, отделяющей рациональное от иррационального.Разбор не является предметом обсуждения; регулярные выражения считаются уже проанализированными структурами данных.

Предлагаемая учетная запись позволяет избежать патологий четности, поскольку пересечение позволяет исчерпывающе проанализировать форм с нечетной четностью, используя только двусложные ноги.

Кажется, что изображения автоматически анализируются вместе с нашим визуальным восприятием мира, натурализируется.

Если сомнение присяжного заседателя не может быть выражено, мы не можем проанализировать по оси, отделяющей рациональное от иррационального.Разбор не является предметом обсуждения; регулярные выражения считаются уже проанализированными структурами данных.

Предлагаемая учетная запись позволяет избежать патологий четности, поскольку пересечение позволяет исчерпывающе проанализировать форм с нечетной четностью, используя только двусложные ноги. Стандартная учетная запись создает патологии четности, потому что она не может исчерпывающе проанализировать форм нечетной четности, используя только двусложные ноги.В результате вся форма исчерпывающе разбирается на ноги.

Другими словами, эти измерители не могут быть проанализированы напрямую как итерации футов с частично идентичными свойствами в отношении количества или ветвления.

Стандартная учетная запись создает патологии четности, потому что она не может исчерпывающе проанализировать форм нечетной четности, используя только двусложные ноги.В результате вся форма исчерпывающе разбирается на ноги.

Другими словами, эти измерители не могут быть проанализированы напрямую как итерации футов с частично идентичными свойствами в отношении количества или ветвления.Эти примеры взяты из корпусов и из источников в Интернете. Любые мнения в примерах не отражают мнение редакторов Cambridge Dictionary, Cambridge University Press или его лицензиаров.

# Тегер для словаря. # Мы предполагаем, что словарный запас для языка доступен.

# Предположим, что у нас реализована небольшая приключенческая игра.

# Мы могли бы взять все слова, использованные в описании

# эту игру и поместите их в словарь. Это лексикон. # Это часть системы синтаксического анализа, в которой мы хотим иметь возможность

# чтобы получить ввод пользователя от пользователя, который не строго следует

# предопределенных ответов, но кто может использовать язык более свободно. lexicon = {«direction»: [«север», «юг», «восток», «запад», «вниз», «вверх», «влево», «вправо», «назад»],

«глагол»: [«ходить», «останавливаться», «убивать», «есть», «бросать», «брать», «открывать», «давать»],

«stop»: [«the», «in», «of», «from», «at», «it», «a», «to»],

«существительное»: [«я», «дверь», «медведь», «принцесса», «шкаф», «меч», «алмаз», «ручка»]} # По желанию, мы могли бы добавить некоторые другие общие формы для глаголов: s_forms = []

слово в лексиконе [«глагол»]:

s_form = слово + «s»

s_forms.

# Мы предполагаем, что словарный запас для языка доступен.

# Предположим, что у нас реализована небольшая приключенческая игра.

# Мы могли бы взять все слова, использованные в описании

# эту игру и поместите их в словарь. Это лексикон. # Это часть системы синтаксического анализа, в которой мы хотим иметь возможность

# чтобы получить ввод пользователя от пользователя, который не строго следует

# предопределенных ответов, но кто может использовать язык более свободно. lexicon = {«direction»: [«север», «юг», «восток», «запад», «вниз», «вверх», «влево», «вправо», «назад»],

«глагол»: [«ходить», «останавливаться», «убивать», «есть», «бросать», «брать», «открывать», «давать»],

«stop»: [«the», «in», «of», «from», «at», «it», «a», «to»],

«существительное»: [«я», «дверь», «медведь», «принцесса», «шкаф», «меч», «алмаз», «ручка»]} # По желанию, мы могли бы добавить некоторые другие общие формы для глаголов: s_forms = []

слово в лексиконе [«глагол»]:

s_form = слово + «s»

s_forms. добавить (s_form)

lexicon [«глагол»] = lexicon [«глагол»] + s_forms # Кроме того, лексика может допускать любое количество цифр 0,1, …, 9,

# длиной не более 10, представляющих числа.

# Они не будут определяться перечислением в словаре, но мы

# определите их в определении. номер def (n):

typ_str = isinstance (n, str)

# мы предполагаем, что номер действительно указан в текстовой строке.

если typ_str и len (n) «9»:

is_number = Ложь

вернуть is_number

еще:

вернуть ложь # Теперь мы можем определить теггер.На основе лексики и определения

# чисел, он может пометить предложение. # Обычно для заданных текстовых строк он должен возвращать список пар (тег, слово).

# «идти на север» -> [(‘глагол’, ‘идти’), (‘направление’, ‘север’)]

# «убить принцессу» -> [(‘глагол’, ‘убить’), (‘стоп’, ‘the’), (‘существительное’, ‘принцесса’)]

# «съесть медведя» -> [(‘глагол’, ‘есть’), (‘стоп’, ‘the’), (‘существительное’, ‘медведь’)]

# «открой дверь и удари медведя по носу»

# -> [(‘глагол’, ‘открыть’), (‘стоп’, ‘the’), (‘существительное’, ‘дверь’), (‘ошибка’, ‘и’), (‘ошибка’, ‘хлопать’),

# (‘стоп’, ‘the’), (‘существительное’, ‘медведь’), (‘стоп’, ‘in’), (‘стоп’, ‘the’), (‘ошибка’, ‘нос’) ] sent = raw_input («Внесите свой вклад>»)

sent_list = отправлено.

добавить (s_form)

lexicon [«глагол»] = lexicon [«глагол»] + s_forms # Кроме того, лексика может допускать любое количество цифр 0,1, …, 9,

# длиной не более 10, представляющих числа.

# Они не будут определяться перечислением в словаре, но мы

# определите их в определении. номер def (n):

typ_str = isinstance (n, str)

# мы предполагаем, что номер действительно указан в текстовой строке.

если typ_str и len (n) «9»:

is_number = Ложь

вернуть is_number

еще:

вернуть ложь # Теперь мы можем определить теггер.На основе лексики и определения

# чисел, он может пометить предложение. # Обычно для заданных текстовых строк он должен возвращать список пар (тег, слово).

# «идти на север» -> [(‘глагол’, ‘идти’), (‘направление’, ‘север’)]

# «убить принцессу» -> [(‘глагол’, ‘убить’), (‘стоп’, ‘the’), (‘существительное’, ‘принцесса’)]

# «съесть медведя» -> [(‘глагол’, ‘есть’), (‘стоп’, ‘the’), (‘существительное’, ‘медведь’)]

# «открой дверь и удари медведя по носу»

# -> [(‘глагол’, ‘открыть’), (‘стоп’, ‘the’), (‘существительное’, ‘дверь’), (‘ошибка’, ‘и’), (‘ошибка’, ‘хлопать’),

# (‘стоп’, ‘the’), (‘существительное’, ‘медведь’), (‘стоп’, ‘in’), (‘стоп’, ‘the’), (‘ошибка’, ‘нос’) ] sent = raw_input («Внесите свой вклад>»)

sent_list = отправлено. нижний (). split () # Преобразуем текстовую строку в список слов.

# Примечание: мы использовали строчные буквы для ввода заглавных букв. тег def (sentlst):

print «Tagging»

taglst = []

для слова в sentlst:

если слово в лексиконе [«направление»]: taglst.append ((«направление», слово))

слово elif в лексиконе [«глагол»]: taglst.append ((«глагол», слово))

слово elif в лексиконе [«стоп»]: taglst.append ((«стоп», слово))

слово elif в лексиконе [«существительное»]: taglst.append ((«существительное», слово))

elif число (слово): taglst.append ((«число», слово))

else: taglst.append ((«ошибка», слово))

печать тегов

вернуть taglst # «ошибка» используется для всех тех слов, которые не встречаются в лексиконе.

# Мы не знаем, что это за слова. # Далее мы разрабатываем очень простой парсер.

# Парсер попытается обнаружить текстовые структуры вида:

# Subject Verb Object

# внутри предложения, вводимого пользователем.

# Для «объекта» мы также разрешим направления и числа.# Если пользователь вводит что-то вроде:

# «открытая дверь»

# тогда система должна предположить, что тема пропущена, но

# что предполагаемый объект действительно был «игроком».

нижний (). split () # Преобразуем текстовую строку в список слов.

# Примечание: мы использовали строчные буквы для ввода заглавных букв. тег def (sentlst):

print «Tagging»

taglst = []

для слова в sentlst:

если слово в лексиконе [«направление»]: taglst.append ((«направление», слово))

слово elif в лексиконе [«глагол»]: taglst.append ((«глагол», слово))

слово elif в лексиконе [«стоп»]: taglst.append ((«стоп», слово))

слово elif в лексиконе [«существительное»]: taglst.append ((«существительное», слово))

elif число (слово): taglst.append ((«число», слово))

else: taglst.append ((«ошибка», слово))

печать тегов

вернуть taglst # «ошибка» используется для всех тех слов, которые не встречаются в лексиконе.

# Мы не знаем, что это за слова. # Далее мы разрабатываем очень простой парсер.

# Парсер попытается обнаружить текстовые структуры вида:

# Subject Verb Object

# внутри предложения, вводимого пользователем.

# Для «объекта» мы также разрешим направления и числа.# Если пользователь вводит что-то вроде:

# «открытая дверь»

# тогда система должна предположить, что тема пропущена, но

# что предполагаемый объект действительно был «игроком». # С помощью этого парсера мы упрощаем ввод пользователя во ввод, который

# приключенческая игра может реагировать на. # Определение верхнего уровня для синтаксического анализа:

# пометить введенное предложение

# получить тему

# получить глагол

# получить объект def parse (sent_lst):

tag_lst = тег (отправлено_lst)

clean_lst = чистый (tag_lst)

(тема, new_lst) = parse_subj (clean_lst)

(глагол, new_lst) = parse_verb (new_lst)

объект = parse_obj (новый_ст)

если субъект == Нет или глагол == Нет или объект == Нет:

print «Я не могу разобрать этот ввод.»

return None

else: вернуть предложение (подлежащее, глагол, объект) # Сначала мы помечаем список слов.

#

# Потом убираем: слова с тегами, не имеющими отношения к

# цель парсера убрана. Он касается

# теги остановки и ошибки. # Наши функции parse_subj, parse_verb и parse_obj будут

# не сканировать все время очищенный tag_list, потому что это

# было бы неэффективно. Они удалят начальные части очищенного

# tag_list, чтобы более поздние функции синтаксического анализа больше не работали

# с этими частями.

# С помощью этого парсера мы упрощаем ввод пользователя во ввод, который

# приключенческая игра может реагировать на. # Определение верхнего уровня для синтаксического анализа:

# пометить введенное предложение

# получить тему

# получить глагол

# получить объект def parse (sent_lst):

tag_lst = тег (отправлено_lst)

clean_lst = чистый (tag_lst)

(тема, new_lst) = parse_subj (clean_lst)

(глагол, new_lst) = parse_verb (new_lst)

объект = parse_obj (новый_ст)

если субъект == Нет или глагол == Нет или объект == Нет:

print «Я не могу разобрать этот ввод.»

return None

else: вернуть предложение (подлежащее, глагол, объект) # Сначала мы помечаем список слов.

#

# Потом убираем: слова с тегами, не имеющими отношения к

# цель парсера убрана. Он касается

# теги остановки и ошибки. # Наши функции parse_subj, parse_verb и parse_obj будут

# не сканировать все время очищенный tag_list, потому что это

# было бы неэффективно. Они удалят начальные части очищенного

# tag_list, чтобы более поздние функции синтаксического анализа больше не работали

# с этими частями. # Сначала очистка: удалите все лишние слова: «стоп»

# слова и слова «ошибка». # Наивная, но _ неправильная_ реализация: # def clean (tag_lst):

# для i в диапазоне (len (tag_lst)):

# (тег, слово) = tag_lst [i]

# if tag == «stop» или tag == «error»:

# del (tag_lst [i])

# return tag_lst # Еще одна наивная, но столь же _ неправильная_ реализация:

#def clean (tag_lst):

# для (тега, слова) в tag_lst:

# if tag == «stop» или tag == «error»:

# tag_lst.удалить ((тег, слово))

# print tag_lst

# return tag_lst def clean (tag_lst):

печать «Очистка»

clean_lst = []

для (тег, слово) в tag_lst:

если нет (тег == «стоп»), а не (тег == «ошибка»):

clean_lst.append ((тег, слово))

распечатать clean_lst

вернуть clean_lst # Найти подлежащее означает: найти существительное, которое стоит первым в

# предложение, или, если глагол идет первым, подлежащее — «игрок». def parse_subj (tag_lst):

print «Разбор по теме»

если tag_lst == []:

return (Нет, [])

(тег, слово) = tag_lst [0]

если tag == «глагол»:

return («игрок», tag_lst)

elif tag == «существительное»:

del (tag_lst [0])

возврат (слово, tag_lst)

еще:

return (Нет, []) def parse_verb (tag_lst):

print «Разбор на глагол»

если tag_lst == []:

return (Нет, [])

(тег, слово) = tag_lst [0]

если tag == «глагол»:

del (tag_lst [0])

возврат (слово, tag_lst)

еще:

return (Нет, []) def parse_obj (tag_lst):

print «Разбор объекта»

если tag_lst == []:

return None

(тег, слово) = tag_lst [0]

if tag == «существительное» или tag == «направление» или tag == «число»:

ответное слово

еще:

return None def предложение (subj, глагол, obj):

print «Результат анализа:»

напечатать subj, глагол, obj

вернуть subj, глагол, obj синтаксический анализ (список отправленных) #Примеры:

print «Разбор предложения» Прекрасная принцесса идет на север «»

parse («Прекрасная принцесса идет на север».

# Сначала очистка: удалите все лишние слова: «стоп»

# слова и слова «ошибка». # Наивная, но _ неправильная_ реализация: # def clean (tag_lst):

# для i в диапазоне (len (tag_lst)):

# (тег, слово) = tag_lst [i]

# if tag == «stop» или tag == «error»:

# del (tag_lst [i])

# return tag_lst # Еще одна наивная, но столь же _ неправильная_ реализация:

#def clean (tag_lst):

# для (тега, слова) в tag_lst:

# if tag == «stop» или tag == «error»:

# tag_lst.удалить ((тег, слово))

# print tag_lst

# return tag_lst def clean (tag_lst):

печать «Очистка»

clean_lst = []

для (тег, слово) в tag_lst:

если нет (тег == «стоп»), а не (тег == «ошибка»):

clean_lst.append ((тег, слово))

распечатать clean_lst

вернуть clean_lst # Найти подлежащее означает: найти существительное, которое стоит первым в

# предложение, или, если глагол идет первым, подлежащее — «игрок». def parse_subj (tag_lst):

print «Разбор по теме»

если tag_lst == []:

return (Нет, [])

(тег, слово) = tag_lst [0]

если tag == «глагол»:

return («игрок», tag_lst)

elif tag == «существительное»:

del (tag_lst [0])

возврат (слово, tag_lst)

еще:

return (Нет, []) def parse_verb (tag_lst):

print «Разбор на глагол»

если tag_lst == []:

return (Нет, [])

(тег, слово) = tag_lst [0]

если tag == «глагол»:

del (tag_lst [0])

возврат (слово, tag_lst)

еще:

return (Нет, []) def parse_obj (tag_lst):

print «Разбор объекта»

если tag_lst == []:

return None

(тег, слово) = tag_lst [0]

if tag == «существительное» или tag == «направление» или tag == «число»:

ответное слово

еще:

return None def предложение (subj, глагол, obj):

print «Результат анализа:»

напечатать subj, глагол, obj

вернуть subj, глагол, obj синтаксический анализ (список отправленных) #Примеры:

print «Разбор предложения» Прекрасная принцесса идет на север «»

parse («Прекрасная принцесса идет на север». нижний (). split ())

print «Разбирая предложение» Я уронил 2345 золотых монет «»

parse («Я бросил 2345 золотых монет» .lower (). split ())

print «Разбираем фразу» убить бурого медведя «»

parse («убить бурого медведя» .split ())

нижний (). split ())

print «Разбирая предложение» Я уронил 2345 золотых монет «»

parse («Я бросил 2345 золотых монет» .lower (). split ())

print «Разбираем фразу» убить бурого медведя «»

parse («убить бурого медведя» .split ())

python 3.x — Создание деревьев синтаксического анализа в NLTK с использованием предложения с тегами

При использовании stanford parser теги POS не нужны для синтаксического анализа дерева, поскольку оно встроено в модель. StanfordParser и модели недоступны по умолчанию, и их необходимо загрузить.

Большинство людей видят эту ошибку при попытке использовать StanfordParser в NLTK

>>> из nltk.parse import stanford

>>> sp = stanford.StanfordParser ()

Отслеживание (последний вызов последний):

Файл "", строка 1, в

Файл "/home/user/anaconda3/lib/python3.5/site-packages/nltk/parse/stanford.py", строка 51, в __init__

key = лямбда имя_модели: re.match (self._JAR, имя_модели)

Файл "/ home / user / anaconda3 / lib / python3. 5 / site-packages / nltk / internals.py ", строка 714, в find_jar_iter

поднять LookupError ('\ n \ n% s \ n% s \ n% s'% (div, msg, div))

LookupError:

================================================== =========================

NLTK не смог найти stanford-parser \ .jar! Установите CLASSPATH

переменная окружения.

Для получения дополнительной информации о stanford-parser \ .jar см .:

5 / site-packages / nltk / internals.py ", строка 714, в find_jar_iter

поднять LookupError ('\ n \ n% s \ n% s \ n% s'% (div, msg, div))

LookupError:

================================================== =========================

NLTK не смог найти stanford-parser \ .jar! Установите CLASSPATH

переменная окружения.

Для получения дополнительной информации о stanford-parser \ .jar см .:

================================================== =========================

Чтобы исправить это, загрузите Stanford Parser в каталог и извлеките его содержимое.Давайте использовать пример каталога в системе * nix / usr / local / lib / stanfordparser . Файл stanford-parser.jar должен находиться там вместе с другими файлами.

Когда все файлы будут там, установите переменные среды для расположения анализатора и моделей.

>>> импорт ОС

>>> os.environ ['STANFORD_PARSER'] = '/ usr / local / lib / stanfordparser'

>>> os. environ ['STANFORD_MODELS'] = '/ usr / local / lib / stanfordparser'

environ ['STANFORD_MODELS'] = '/ usr / local / lib / stanfordparser'

Теперь вы можете использовать синтаксический анализатор для экспорта возможных синтаксических анализов для имеющегося у вас предложения, например:

>>> sp = stanford.СтэнфордПарсер ()

>>> sp.parse ("это предложение" .split ())

<объект list_iterator в 0x7f53b93a2dd8>

>>> tree = [дерево вместо дерева в sp.parse ("это предложение" .split ())]

>>> деревья [0] # пример проанализированного предложения

Дерево ('КОРЕНЬ', [Дерево ('S', [Дерево ('NP', [Дерево ('DT', ['this'])]), Дерево ('VP', [Дерево ('VBZ', [ 'is']), Tree ('NP', [Tree ('DT', ['a']), Tree ('NN', ['предложение'])])])])])

Возвращается объект итератора , поскольку для данного предложения может быть более одного синтаксического анализатора.

На этой странице: . split (), .join () и list (). split (), .join () и list ().Разделение предложения на слова: .split ()Ниже Мэри представляет собой единую струну. Несмотря на то, что это предложение, слова не представлены в виде скрытых единиц. Для этого вам понадобится другой тип данных: список строк, где каждая строка соответствует слову. .split () - это метод, который нужно использовать:

.split () разделяет любую комбинированную последовательность этих символов: .split () разделяет любую комбинированную последовательность этих символов:

Разделение на определенную подстрокуПредоставляя необязательный параметр,.split ('x') может использоваться для разделения строки на определенную подстроку 'x'. Без указания 'x' .split () просто разбивается на все пробелы, как показано выше.

Строка в списке символов: list ()Но что, если вы хотите разбить строку на список символов? В Python символы - это просто строки длиной 1. Функция list () превращает строку в список отдельных букв:

Присоединение к списку строк: .join ()Если у вас есть список слов, как собрать их в одну строку? .join () - это метод, который нужно использовать. Вызывается в строке-разделителе 'x', 'x'.join (y) объединяет каждый элемент в списке y, разделенный' x '. Ниже слова в mwords объединяются обратно в строку предложения с пробелом между ними: Ниже слова в mwords объединяются обратно в строку предложения с пробелом между ними:

|

Лингвистические особенности · Документация по использованию spaCy

Разумная обработка исходного текста затруднена: большинство слов встречаются редко, и это

обычно для слов, которые выглядят совершенно по-разному, означает почти одно и то же.Одни и те же слова в разном порядке могут означать совсем другое.

Даже разделение текста на полезные словесные единицы может быть трудным во многих случаях.

языков. Хотя некоторые проблемы можно решить, начав только с исходных

символов, обычно лучше использовать лингвистические знания, чтобы добавить полезные

Информация. Именно для этого и предназначен spaCy: вы вводите необработанный текст,

и получите объект Doc , который поставляется с различными

аннотации.

После токенизации spaCy может анализировать и тег для данного Doc .Это где

поступает обученный конвейер и его статистические модели, которые позволяют spaCy делает прогнозы, из которых тег или метка наиболее вероятно применимы в данном контексте. Обученный компонент включает двоичные данные, которые создаются путем отображения системы.

достаточно примеров для того, чтобы делать прогнозы, которые обобщаются по всему языку -

например, слово, следующее за «the» в английском языке, скорее всего, является существительным.

Обученный компонент включает двоичные данные, которые создаются путем отображения системы.

достаточно примеров для того, чтобы делать прогнозы, которые обобщаются по всему языку -

например, слово, следующее за «the» в английском языке, скорее всего, является существительным.

Лингвистические аннотации доступны как Токен атрибутов. Как и многие библиотеки НЛП, spaCy кодирует все строки в хеш-значения , чтобы уменьшить использование памяти и улучшить

эффективность.Итак, чтобы получить удобочитаемое строковое представление атрибута, мы

необходимо добавить подчеркивание _ к его имени:

import spacy

nlp = spacy.load ("en_core_web_sm")

doc = nlp («Apple собирается купить британский стартап за 1 миллиард долларов»)

для токена в документе:

print (token.text, token.lemma_, token.pos_, token.tag_, token.dep_,

token.shape_, token.is_alpha, token.is_stop)

- Текст: Исходный текст слова.

- Лемма: Основная форма слова.

- POS: Простой UPOS тег части речи.

- Тег: Подробный тег части речи.

- Dep: Синтаксическая зависимость, то есть отношение между токенами.

- Форма: Форма слова - заглавные буквы, знаки препинания, цифры.

- - это альфа: Является ли токен альфа-символом?

- is stop: Является ли токен частью стоп-листа, т. Е. Наиболее частыми словами язык?

| Текст | Лемма | POS | Тег | Dep | Форма | альфа | стоп |

|---|---|---|---|---|---|---|---|

| Apple | Apple | N Xxxxx | True | False | |||

| is | be | AUX | VBZ | aux | xx | True True | |

| смотря | look | VERB | VBG | ROOT | xxxx | True | False |

| при | ADP | IN | Prep | xx | True | True | |

| покупка | покупка | VERB | VBG | pcomp | xxx | Верно | Ложно |

U. K. K. | u.k. | PROPN | NNP | составной | X.X. | Ложь | Ложь |

| запуск | запуск | NOUN | NN | dobj | xxxx | True | False |

| для | для | ADP | IN | Prep | xxx | True | True |

| $ | $ | SYM | $ | Quantmod | $ | Ложь | Ложь |

| 1 | 1 | NUM | CD | составной | d | Неверно | Ложь |

| миллиардов | миллиардов | NUM | CD | pobj | xxxx | Истинно | Ложно |

Совет: теги и ярлыки

Большинство тегов и ярлыков выглядят довольно абстрактно, и они различаются между

языков.

spacy.explain покажет вам краткое описание — например, spacy.explain ("VBZ") возвращает «глагол, 3-е лицо единственного числа настоящее».

Используя встроенный визуализатор дисплея spaCy, вот что наше примерное предложение и его зависимости выглядят следующим образом:

scheme Схема тега части речи

Для списка назначенных мелкозернистых и крупнозернистых тегов части речи по моделям spaCy на разных языках, см. задокументированные схемы этикеток в каталоге моделей.

Флективная морфология — это процесс, с помощью которого корневая форма слова изменен путем добавления префиксов или суффиксов, определяющих его грамматическую функцию но не меняйте его часть речи. Мы говорим, что лемма (корневая форма) является перегиб (модифицированный / комбинированный) с одним или несколькими морфологическими признаками от до создать форму поверхности. Вот несколько примеров:

| Контекст | Поверхность | Лемма | POS | Морфологические особенности |

|---|---|---|---|---|

| Я читал статью | читал | читал | Vorm66 Verb = Ger | |

| Я не смотрю новости, читаю газету | читать | читать | VERB | VerbForm = Fin , Mood = Ind , Tense = Pres |

| Я прочитал газету вчера | прочитал | прочитал | ГЛАГОЛ | VerbForm = Fin , Mood = Ind , Tense = Прошлое |

Морфологические особенности хранятся в MorphAnalysis под токеном ., который

позволяет получить доступ к индивидуальным морфологическим признакам. морфинг

морфинг

📝 Что стоит попробовать

- Измените «Я» на «Она». Вы должны увидеть, что морфологические признаки меняются и укажите, что это местоимение от третьего лица.

- Осмотрите жетон

. Морфна предмет других жетонов.

импорт просторный

nlp = spacy.load ("en_core_web_sm")

print ("Конвейер:", nlp.pipe_names)

doc = nlp ("Я читал газету.")

токен = документ [0]

печать (токен.превращаться)

print (token.morph.get ("PronType"))

Статистическая морфология v3.0 Модель потребностей

Компонент spaCy статистический Морфологизатор назначает

морфологические особенности и грубые теги части речи как Token.morph и Token.pos .

импорт просторный

nlp = spacy.load ("de_core_news_sm")

doc = nlp ("Wo bist du?")

печать (документ [2] .morph)

печать (документ [2] .pos_)

Морфология на основе правил

Для языков с относительно простыми морфологическими системами, таких как английский, spaCy

может назначать морфологические признаки с помощью подхода, основанного на правилах, который использует токен текста и мелкозернистые теги части речи для создания

грубые теги части речи и морфологические особенности.

- Тегер части речи назначает каждому токену детализированную часть речи

тег . В API эти теги известны как

Token.tag. Они выражают часть речи (например, глагол) и некоторое количество морфологической информации, например что глагол имеет прошедшее время (например,VBDдля глагола прошедшего времени в Penn Treebank). - Для слов, крупнозернистый POS которых не установлен предыдущим процессом, таблица сопоставления отображает мелкозернистые теги в крупнозернистые POS-теги и морфологические особенности.

импорт просторный

nlp = spacy.load ("en_core_web_sm")

doc = nlp ("Где ты?")

печать (документ [2] .morph)

печать (документ [2] .pos_)

Лемматизатор — это компонент конвейера, который обеспечивает поиск

и основанные на правилах методы лемматизации в настраиваемом компоненте. Личность

язык может расширить Lemmatizer как часть его

языковые данные.

импорт просторный

nlp = spacy. load ("en_core_web_sm")

lemmatizer = nlp.get_pipe ("лемматизатор")

печать (лемматизатор.Режим)

doc = nlp ("Я читал газету.")

print ([token.lemma_ для токена в документе])

load ("en_core_web_sm")

lemmatizer = nlp.get_pipe ("лемматизатор")

печать (лемматизатор.Режим)

doc = nlp ("Я читал газету.")

print ([token.lemma_ для токена в документе])

Изменено в версии 3.0

В отличие от spaCy v2, модели spaCy v3 , а не предоставляют леммы по умолчанию или переключение

автоматически между поиском и леммами на основе правил в зависимости от того,

находится в стадии разработки. Чтобы иметь леммы в Doc , конвейер должен включать Лемматизатор компонент. Компонент лемматизатора

настроен на использование одного режима, такого как «поиск» или «правило» на

инициализация. "правило" Режим требует, чтобы Token.pos был установлен предыдущим

составная часть.

Данные для лемматизаторов spaCy распространяются в пакете данные пространственного поиска . В

при условии, что обученные конвейеры уже включают все необходимые таблицы, но если вы

создаете новые конвейеры, вы, вероятно, захотите установить spacy-lookups-data для предоставления данных при инициализации лемматизатора.

Поисковый лемматизатор

Для конвейеров без теггера или морфологизатора можно использовать поисковый лемматизатор.

добавляется в конвейер, пока предоставляется таблица поиска, обычно через данные пространственного поиска .В

лемматизатор поиска ищет форму поверхности токена в таблице поиска без

ссылка на часть речи или контекст токена.

импортный простор

nlp = spacy.blank ("sv")

nlp.add_pipe ("лемматизатор", config = {"режим": "поиск"})

Лемматизатор на основе правил

При обучении конвейеров, которые включают компонент, который назначает часть речи

теги (морфологизатор или теггер с отображением POS),

лемматизатор на основе правил может быть добавлен с помощью таблиц правил из данные пространственного поиска :

импортный простор

nlp = простор.пустой ("де")

nlp.add_pipe ("морфологизатор")

nlp.add_pipe ("лемматизатор", config = {"режим": "правило"})

Детерминированный лемматизатор, основанный на правилах, отображает форму поверхности в лемму в

свет заданной ранее крупнозернистой части речи и морфологического

информацию, не обращаясь к контексту токена. Основанный на правилах

lemmatizer также принимает файлы исключений на основе списков. Для английского это

приобретен из WordNet.

Основанный на правилах

lemmatizer также принимает файлы исключений на основе списков. Для английского это

приобретен из WordNet.

spaCy имеет быстрый и точный синтаксический анализатор зависимостей, а также богатый набор функций.

API для навигации по дереву.Синтаксический анализатор также поддерживает границу предложения

обнаружения и позволяет вам перебирать базовые словосочетания с существительными или «фрагменты». Ты можешь

проверьте, был ли проанализирован объект Doc путем вызова doc.has_annotation ("DEP") , который проверяет, имеет ли атрибут Token.dep set возвращает логическое значение. Если результат Ложь , предложение по умолчанию

итератор вызовет исключение.

📖Схема меток зависимостей

Для списка меток синтаксических зависимостей, назначенных моделями spaCy в разных языках, см. схемы этикеток, задокументированные в каталог моделей.

Отрезки существительных

Отрезки существительных — это «базовые словосочетания» — плоские фразы, в которых есть существительное в качестве своего

глава. Вы можете представить себе существительное как существительное плюс слова, описывающие существительное.

— например, «пышная зеленая трава» или «крупнейший в мире технологический фонд». К

получить куски существительного в документе, просто перебрать

Вы можете представить себе существительное как существительное плюс слова, описывающие существительное.

— например, «пышная зеленая трава» или «крупнейший в мире технологический фонд». К

получить куски существительного в документе, просто перебрать Док. Номер_головки .

импорт просторный

nlp = spacy.load ("en_core_web_sm")

doc = nlp («Автономные автомобили переносят страхование ответственности на производителей»)

для куска в док.noun_chunks:

print (chunk.text, chunk.root.text, chunk.root.dep_,

chunk.root.head.text)

- Текст: Исходный текст фрагмента существительного.

- Корневой текст: Исходный текст слова, соединяющего кусок существительного с остальная часть синтаксического анализа.

- Root dep: Отношение зависимости, соединяющее корень с его головкой.

- Текст заголовка корневого токена: Текст заголовка корневого токена.

| Текст | root.text | root.dep_ | root.head.text |

|---|---|---|---|

| Автономные автомобили | автомобили | nsubj | смена |

| страхование ответственности | ответственность | dobj | смена |

| производители | производители | pobj | к |

Навигация по дереву синтаксического анализа

spaCy использует термины head и child для описания слов , связанных между собой

единственная дуга в дереве зависимостей.Термин dep используется для дуги

метка, которая описывает тип синтаксического отношения, которое связывает ребенка с

голова. Как и в случае с другими атрибутами, значение .dep является хеш-значением. Ты можешь

получить строковое значение с .. dep_

dep_

импорт просторный

nlp = spacy.load ("en_core_web_sm")

doc = nlp («Автономные автомобили переносят страхование ответственности на производителей»)

для токена в документе:

print (token.text, token.dep_, token.head.text, token.head.pos_,

[ребенок для ребенка в жетоне.дети])

- Текст: Исходный текст токена.

- Dep: Синтаксическое отношение, связывающее дочерний элемент с головой.

- Текст заголовка: Исходный текст токена головы.

- Head POS: Тег части речи токен-головки.

- Потомки: Непосредственные синтаксические зависимости токена.

| Текст | Dep | Заголовок текст | Голова POS | Дети |

|---|---|---|---|---|

| Автономный | amod | автомобили | ||

| 900 nsubj | сдвиг | VERB | Автономный | |

| сдвиг | ROOT | сдвиг | VERB | автомобили, ответственность, навстречу |

| страхование | соединение | ответственность | NOUN | |

| ответственность | dobj | смена | VERB | страхование |

| по направлению к | приготовление | смена | NOUN | производители |

| производителей | pobj | к | ADP |

Поскольку синтаксические отношения образуют дерево, каждое слово имеет ровно одно

голова . Таким образом, вы можете перебирать дуги в дереве, перебирая

слова в предложении. Обычно это лучший способ сопоставить дугу

проценты — снизу:

Таким образом, вы можете перебирать дуги в дереве, перебирая

слова в предложении. Обычно это лучший способ сопоставить дугу

проценты — снизу:

импорт прост.

из spacy.symbols import nsubj, VERB

nlp = spacy.load ("en_core_web_sm")

doc = nlp («Автономные автомобили переносят страхование ответственности на производителей»)

глаголы = набор ()

для possible_subject в документе:

if possible_subject.dep == nsubj и possible_subject.head.pos == ГЛАГОЛ:

verbs.add (possible_subject.глава)

печать (глаголы)

Если вы попытаетесь найти соответствие сверху, вам придется повторить итерацию дважды. Один раз за голову, а потом снова через детей:

глаголы = []

для possible_verb в документе:

если возможно_verb.pos == ГЛАГОЛ:

для possible_subject в possible_verb.children:

если возможно_subject.dep == nsubj:

verbs.append (возможно_глагол)

перерыв

Для перебора дочерних элементов используйте атрибут token., который

предоставляет последовательность объектов  children

children Token .

Итерация по локальному дереву

Есть еще несколько удобных атрибутов для итерации по локальному дереву.

дерево из жетона. Token.lefts и Token.rights Атрибуты обеспечивают последовательности синтаксических

дочерние элементы, которые появляются до и после токена. Обе последовательности в предложении

заказывать. Также есть два атрибута целочисленного типа: Token.n_lefts и Token.n_rights , которые дают количество левых и правых

дети.

импорт просторный

nlp = простор.load ("en_core_web_sm")

doc = nlp («ярко-красные яблоки на дереве»)

print ([token.text для токена в doc [2] .lefts])

print ([token.text для токена в doc [2] .rights])

печать (документ [2] .n_lefts)

печать (документ [2] .n_rights)

импорт просторный

nlp = spacy.load ("de_core_news_sm")

doc = nlp ("schöne rote Äpfel auf dem Baum")

print ([token. text для токена в doc [2] .lefts])

print ([token.text для токена в doc [2] .rights])

text для токена в doc [2] .lefts])

print ([token.text для токена в doc [2] .rights])

Вы можете получить целую фразу по ее синтаксическому заголовку, используя Жетон.атрибут поддерева . Это возвращает заказанный

последовательность жетонов. Вы можете подняться на дерево с помощью Token.ancestors атрибут и проверьте доминирование с помощью Token.is_ancestor

Проективное и непроективное

Для английских конвейеров по умолчанию дерево синтаксического анализа выглядит следующим образом: проекционная , что означает отсутствие перекрестных скобок. Жетоны

возвращенный .subtree , следовательно, гарантированно будет непрерывным. Это не

верно для немецких трубопроводов, у которых много

непроективные зависимости.

импорт просторный

nlp = spacy.load ("en_core_web_sm")

doc = nlp («Владельцы кредитных и ипотечных счетов должны подавать свои запросы»)

root = [токен для токена в документе if token. head == токен] [0]

subject = list (root.lefts) [0]

для потомка в subject.subtree:

утверждать, что субъект является потомком или субъектом. is_ancestor (потомок)

печать (потомок.текст, потомок.dep_, потомок.n_lefts,

Потомок .n_rights,

[ancestor.text для предка в потомке .ancestors])

head == токен] [0]

subject = list (root.lefts) [0]

для потомка в subject.subtree:

утверждать, что субъект является потомком или субъектом. is_ancestor (потомок)

печать (потомок.текст, потомок.dep_, потомок.n_lefts,

Потомок .n_rights,

[ancestor.text для предка в потомке .ancestors])

| Текст | Dep | n_lefts | n_rights | предки |

|---|---|---|---|---|

| Credit | nmod | submit 0 | holders и | куб. |

| счет | коннект | 1 | 0 | Кредит, держатели, представить |

| держатели | nsubj | 1 | 0 | представить |

Наконец, .Атрибуты left_edge и .right_edge могут быть особенно полезны,

потому что они дают вам первый и последний токены поддерева. Это

Самый простой способ создать объект

Это

Самый простой способ создать объект Span для синтаксической фразы. Обратите внимание, что .right_edge дает токен внутри поддерева - поэтому, если вы используете его как

конечная точка диапазона, не забудьте +1 !

импорт просторный

nlp = spacy.load ("en_core_web_sm")

doc = nlp («Владельцы кредитных и ипотечных счетов должны подавать свои запросы»)

span = doc [doc [4].left_edge.i: документ [4] .right_edge.i + 1]

с doc.retokenize () в качестве ретокенизатора:

retokenizer.merge (диапазон)

для токена в документе:

print (token.text, token.pos_, token.dep_, token.head.text)

| Текст | POS | Dep | Head text |

|---|---|---|---|

| Владельцы кредитных и ипотечных счетов | NOUN | nsubj | V необходимо |

aux | отправить | ||

| отправить | VERB | ROOT | отправить |

| их | ADJ | Poss | запросы |

| запросы | NOUN | dobj | submit |

Анализ зависимостей может быть полезным инструментом для извлечения информации ,

особенно в сочетании с другими прогнозами, такими как

названные объекты. В следующем примере извлекаются деньги и

значения валюты, то есть сущности, помеченные как

В следующем примере извлекаются деньги и

значения валюты, то есть сущности, помеченные как ДЕНЬГИ , а затем использует зависимость

выполните синтаксический анализ, чтобы найти именную фразу, к которой они относятся — например, «Чистая прибыль» → «9,4 миллиона долларов» .

импорт просторный

nlp = spacy.load ("en_core_web_sm")

nlp.add_pipe ("merge_entities")

nlp.add_pipe ("merge_noun_chunks")

ТЕКСТЫ = [

«Чистая прибыль составила 9,4 миллиона долларов по сравнению с 2,7 миллиона долларов в предыдущем году»,

«Выручка превысила двенадцать миллиардов долларов, а убыток составил 1 миллиард долларов.",

]

для документа в nlp.pipe (ТЕКСТЫ):

для токена в документе:

если token.ent_type_ == "ДЕНЬГИ":

если token.dep_ in ("attr", "dobj"):

subj = [w вместо w в token.head.lefts, если w.dep_ == "nsubj"]

если subj:

print (subj [0], "->", токен)

elif token. dep_ == "pobj" и token.head.dep_ == "Prep":

print (token.head.head, "->", токен)

dep_ == "pobj" и token.head.dep_ == "Prep":

print (token.head.head, "->", токен)

📖Комбинирование моделей и правил

Дополнительные примеры того, как написать основанную на правилах логику извлечения информации, которая использует прогнозы модели, сделанные различными компонентами, см. руководство по использованию на совмещение моделей и правил.

Визуализация зависимостей

Лучший способ понять анализатор зависимостей spaCy — интерактивный. Делать

это проще, spaCy поставляется с модулем визуализации. Вы можете сдать Doc или

список объектов Doc для отображения и запуска displacy.serve для запуска веб-сервера или displacy.render для создания необработанной разметки.

Если вы хотите знать, как писать правила, которые подключаются к синтаксису

конструкции, просто вставьте предложение в визуализатор и посмотрите, как spaCy

аннотирует это.

импорт просторный

от просторного импорта

nlp = spacy. load ("en_core_web_sm")

doc = nlp («Автономные автомобили переносят страхование ответственности на производителей»)

displacy.render (док,)

load ("en_core_web_sm")

doc = nlp («Автономные автомобили переносят страхование ответственности на производителей»)

displacy.render (док,)

Подробнее и примеры см. руководство по визуализации spaCy. Вы также можете протестировать Отображение в нашей онлайн-демонстрации.

Отключение парсера

В обученных конвейерах, предоставляемых spaCy, парсер загружается и

включен по умолчанию как часть

стандартный технологический конвейер.Если тебе не нужно

любую синтаксическую информацию следует отключить парсер. Отключение

парсер заставит spaCy загружаться и работать намного быстрее. Если вы хотите загрузить парсер,

но необходимо отключить его для определенных документов, вы также можете контролировать его использование на

объект nlp . Для получения дополнительной информации см. Руководство по использованию на

отключение компонентов конвейера.

nlp = spacy.load ("en_core_web_sm", disable = ["parser"])

spaCy имеет чрезвычайно быструю систему распознавания статистических объектов, которая

назначает метки смежным участкам токенов. По умолчанию

обученные конвейеры могут идентифицировать множество именованных и числовых

юридические лица, включая компании, местоположения, организации и продукты. Ты можешь

добавить произвольные классы в систему распознавания сущностей и обновить модель

с новыми примерами.

По умолчанию

обученные конвейеры могут идентифицировать множество именованных и числовых

юридические лица, включая компании, местоположения, организации и продукты. Ты можешь

добавить произвольные классы в систему распознавания сущностей и обновить модель

с новыми примерами.

Распознавание именованных объектов 101

Именованные объекты — это «объекты реального мира», которым присвоено имя, например человек, страна, продукт или название книги. spaCy может распознавать различные типы именованных сущностей в документе, запрашивая модель для предсказание .Поскольку модели являются статистическими и сильно зависят от примеры, на которых они были обучены, это не всегда работает идеально и может потребуются некоторые настройки позже, в зависимости от вашего варианта использования.

Именованные сущности доступны как свойство ents Doc :

import spacy

nlp = spacy.load ("en_core_web_sm")

doc = nlp («Apple собирается купить британский стартап за 1 миллиард долларов»)

для Ent в док. центрах:

print (ent.text, ent.start_char, ent.end_char, ent.label_)

центрах:

print (ent.text, ent.start_char, ent.end_char, ent.label_)

- Текст: Исходный текст объекта.

- Начало: Индекс начала объекта в

Doc. - Конец: Указатель конца объекта в

Doc. - Метка: Метка объекта, т.е. тип.

| Текст | Начало | Конец | Этикетка | Описание |

|---|---|---|---|---|

| Apple | 0 | 5 | ORG | Компании, учреждения, учреждения. |

| Великобритания | 27 | 31 | GPE | Геополитическое образование, то есть страны, города, государства. |

| 1 миллиард долларов | 44 | 54 | ДЕНЬГИ | Денежное выражение, включая единицы. |

Используя встроенный визуализатор дисплея spaCy, вот что Наш примерное предложение и его именованные сущности выглядят так:

Доступ к аннотациям и меткам сущностей

Стандартный способ доступа к аннотациям сущностей — это doc.энц Свойство, которое создает последовательность из Span объектов. Лицо

Тип доступен либо как хеш-значение, либо как строка с использованием атрибутов ent.label и ent.label_ . Объект Span действует как последовательность токенов, поэтому

вы можете перебирать объект или индексировать его. Вы также можете получить текстовую форму

целого объекта, как если бы это был один токен.

Вы также можете получить доступ к аннотациям токенов, используя токен.ent_iob и token.ent_type атрибутов. token.ent_iob указывает

независимо от того, начинается ли объект, продолжается или заканчивается на теге. Если тип объекта не установлен

на токене он вернет пустую строку.

Схема IOB

-

I— Токен внутри объекта. -

O— Токен за пределами объекта. -

B— Токен — это , начинающийся с объекта.

Схема BILUO

-

B— Токен — это начало мульти-токен-объекта. -

I— Токен внутри мульти-токен-объекта. -

L— Токен — это последний токен для объекта с несколькими токенами. -

U— Токен представляет собой единицу с одним токеном . -

O— Toke — это за пределами объекта.

импорт просторный

nlp = spacy.load ("en_core_web_sm")

doc = nlp ("Сан-Франциско рассматривает вопрос о запрете роботов для доставки тротуаров")

ents = [(e.text, e.start_char, e.end_char, e.label_) для e в документах]

печать (энц)

ent_san = [doc [0] . text, doc [0] .ent_iob_, doc [0] .ent_type_]

ent_francisco = [документ [1] .text, doc [1] .ent_iob_, doc [1] .ent_type_]

печать (ent_san)

печать (ent_francisco)

text, doc [0] .ent_iob_, doc [0] .ent_type_]

ent_francisco = [документ [1] .text, doc [1] .ent_iob_, doc [1] .ent_type_]

печать (ent_san)

печать (ent_francisco)

| Текст | ent_iob | ent_iob_ | ent_type_ | Описание |

|---|---|---|---|---|

| San | 3 | B | "GPE 900" начало объекта | |

| Франциско | 1 | I | "GPE" | внутри объекта |

| рассматривает | 2 | O | "" | снаружи субъект |

| запрещающий | 2 | O | "" | вне предприятия |

| тротуар | 2 | O | "" | вне предприятия |

| поставка | 2 900 60 | O | "" | вне организации |

| роботов | 2 | O | "" | вне организации |

Настройка аннотаций сущности

Чтобы гарантировать, что последовательность аннотаций токенов остается неизменной, вы должны

установить аннотации сущностей на уровне документа . Однако вы не можете писать

непосредственно к атрибутам

Однако вы не можете писать

непосредственно к атрибутам token.ent_iob или token.ent_type , поэтому самый простой

способ установки сущностей - использовать функцию doc.set_ents и создайте новый объект как Span .

импорт просторный

из spacy.tokens import Span

nlp = spacy.load ("en_core_web_sm")

doc = nlp ("fb нанимает нового вице-президента по глобальной политике")

ents = [(e.text, e.start_char, e.end_char, e.label_) для e в документах]

print ('До', энц)

fb_ent = Span (doc, 0, 1, label = "ORG")

orig_ents = список (док.энц)

doc.set_ents ([fb_ent], по умолчанию = "без изменений")

doc.ents = orig_ents + [fb_ent]

ents = [(e.text, e.start, e.end, e.label_) для e в документах]

print ('После', энц)

Имейте в виду, что Span инициализируется начальным и конечным токенами индексы, а не смещения символов. Чтобы создать диапазон из смещений символов, используйте Doc.: char_span

char_span

fb_ent = doc.char_span (0, 2, label = "ORG")

Установка аннотаций сущностей из массива

Вы также можете назначить аннотации сущностей с помощью док.from_array метод. Для этого следует включить

атрибуты ENT_TYPE и ENT_IOB в массиве, который вы импортируете

из.

импортный номер

импортный простор

из spacy.attrs импортировать ENT_IOB, ENT_TYPE

nlp = spacy.load ("en_core_web_sm")

doc = nlp.make_doc («Лондон - большой город в Соединенном Королевстве.»)

print («До», док.)

заголовок = [ENT_IOB, ENT_TYPE]

attr_array = numpy.zeros ((len (документ), len (заголовок)), dtype = "uint64")

attr_array [0, 0] = 3

attr_array [0, 1] = док.Vocalab.strings ["GPE"]

doc.from_array (заголовок, attr_array)

print ("После", док.)

Установка аннотаций сущностей в Cython

Наконец, вы всегда можете записать в базовую структуру, если скомпилируете

Функция Cython. Это легко сделать и позволяет

писать эффективный нативный код.

Это легко сделать и позволяет

писать эффективный нативный код.

из spacy.typedefs cimport attr_t

из spacy.tokens.doc cimport Doc

cpdef set_entity (документ doc, int start, int end, attr_t ent_type):

для i в диапазоне (начало, конец):

док.c [i] .ent_type = ent_type

doc.c [начало] .ent_iob = 3

для i в диапазоне (начало + 1, конец):

doc.c [i] .ent_iob = 2

Очевидно, что если вы напишете непосредственно в массив структур TokenC * , у вас будет

ответственность за обеспечение того, чтобы данные оставались в согласованном состоянии.

Встроенные типы сущностей

Совет: понимание типов сущностей

Вы также можете использовать spacy.explain () для получения описания строки

представление метки объекта.Например, spacy.explain ("ЯЗЫК") вернет «любой названный язык».

Схема аннотаций

Подробнее о типах сущностей, доступных в обученных конвейерах spaCy, см. «Схема маркировки» отдельных моделей в

каталог моделей.

«Схема маркировки» отдельных моделей в

каталог моделей.

Визуализация именованных сущностей

дисплей визуализатор ЛОР позволяет интерактивно исследовать поведение модели распознавания сущностей. Если ты

при обучении модели очень полезно запускать визуализацию самостоятельно.Помогать

вы делаете это, spaCy поставляется с модулем визуализации. Вы можете сдать Doc или

список объектов Doc для отображения и запуска displacy.serve для запуска веб-сервера или displacy.render для создания необработанной разметки.

Подробнее и примеры см. руководство по визуализации spaCy.

Пример именованного объекта

import spacy от просторного импорта text = "Когда Себастьян Трун в 2007 году начал работать над беспилотными автомобилями в Google, мало кто из других людей воспринимал его всерьез." nlp = spacy.load ("en_core_web_sm") doc = nlp (текст) displacy.serve (док,)

Чтобы закрепить названные объекты в «реальном мире», spaCy предоставляет функциональные возможности

для выполнения привязки сущностей, которая разрешает текстовую сущность в уникальную

идентификатор из базы знаний (КБ). Вы можете создать свой собственный

Вы можете создать свой собственный KnowledgeBase и обучите нового EntityLinker с использованием этой настраиваемой базы знаний.

Доступ к идентификаторам объектов Требуется модель

Аннотированный идентификатор KB доступен либо в виде хеш-значения, либо в виде строки,

используя атрибуты ent.kb_id и ent.kb_id_ из диапазона объект или атрибуты ent_kb_id и ent_kb_id_ объекта Token объект.

импорт просторный

nlp = spacy.load ("my_custom_el_pipeline")

doc = nlp («Ада Лавлейс родилась в Лондоне»)

ents = [(e.text, e.label_, e.kb_id_) для e в документах]

печать (энц)

ent_ada_0 = [doc [0] .text, doc [0] .ent_type_, doc [0] .ent_kb_id_]

ent_ada_1 = [документ [1] .text, doc [1] .ent_type_, doc [1] .ent_kb_id_]

ent_london_5 = [документ [5].текст, doc [5] .ent_type_, doc [5] .ent_kb_id_]

печать (ent_ada_0)

печать (ent_ada_1)

печать (ent_london_5)

Токенизация - это задача разбиения текста на значимые сегменты, называемые жетонов . Входными данными токенизатора является текст в Юникоде, а на выходе -

Входными данными токенизатора является текст в Юникоде, а на выходе - Объект Doc . Чтобы построить объект Doc , вам понадобится Экземпляр Vocab , последовательность из строк слов и, необязательно,

последовательность пробелов логических значений, которые позволяют поддерживать выравнивание

токены в исходную строку.

Важное примечание

spaCy токенизация неразрушающий , что означает, что вы всегда будете

может восстановить исходный ввод из токенизированного вывода. Пробел

информация сохраняется в токенах, и никакая информация не добавляется и не удаляется

во время токенизации. Это своего рода основной принцип объекта spaCy Doc : doc.text == input_text всегда должно выполняться.

Во время обработки spaCy first токенизирует текст, т.е.е. сегментирует его на

слова, знаки препинания и так далее. Это делается путем применения правил, специфичных для каждого

язык. Например, знаки препинания в конце предложения следует разделять.

- тогда как «Великобритания» должен остаться один жетон. Каждый

Например, знаки препинания в конце предложения следует разделять.

- тогда как «Великобритания» должен остаться один жетон. Каждый Doc состоит из отдельных

токены, и мы можем перебирать их:

import spacy

nlp = spacy.load ("en_core_web_sm")

doc = nlp («Apple собирается купить британский стартап за 1 миллиард долларов»)

для токена в документе:

печать (токен.текст)

| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 90143 Apple | по цене | покупка | U.K. | запуск | для | $ | 1 | миллиардов |

|---|

Сначала необработанный текст разбивается на пробельные символы, аналогично text.. Затем токенизатор обрабатывает текст слева направо. На

для каждой подстроки выполняется две проверки: split ('')

split ('')

Соответствует ли подстрока правилу исключения токенизатора? Например, «не надо» не содержит пробелов, но должен быть разделен на два токена: «do» и «Нет», а «У.К. » всегда должен оставаться один жетон.

Можно ли отделить префикс, суффикс или инфикс? Например, знаки препинания запятые, точки, дефисы или кавычки.

Если есть совпадение, правило применяется, и токенизатор продолжает цикл, начиная с недавно разделенных подстрок. Таким образом, spaCy может разделить комплекс , вложенные токены , такие как комбинации сокращений и множественных знаков препинания Метки.

- Исключение токенизатора: Особое правило для разделения строки на несколько токены или предотвратить разделение токена, когда правила пунктуации применяемый.

- Префикс: символов в начале, например

$,(,“,¿.

- Суффикс: символов в конце, например,

км,),”,!. - Инфикс: Знак (и) между ними, например

-,-,/,….

Хотя правила пунктуации обычно довольно общие, исключения токенизатора

сильно зависят от специфики конкретного языка.Вот почему каждый

доступный язык имеет собственный подкласс, например Английский или Немецкий , который загружается в списки жестко закодированных данных и исключений

правила.

Подробности алгоритма: как работает токенизатор spaCy¶

spaCy представляет новый алгоритм токенизации, который обеспечивает лучший баланс между производительностью, простотой определения и легкостью совмещения с оригиналом нить.

После использования префикса или суффикса мы снова обращаемся к особым случаям. Мы хотим

особые случаи, чтобы обрабатывать такие вещи, как "не" на английском языке, и мы хотим того же

Правило работать на «(не)!». Мы делаем это, отделяя открытую скобку, затем

восклицательный знак, затем закрытая скобка и, наконец, соответствующий особый случай.