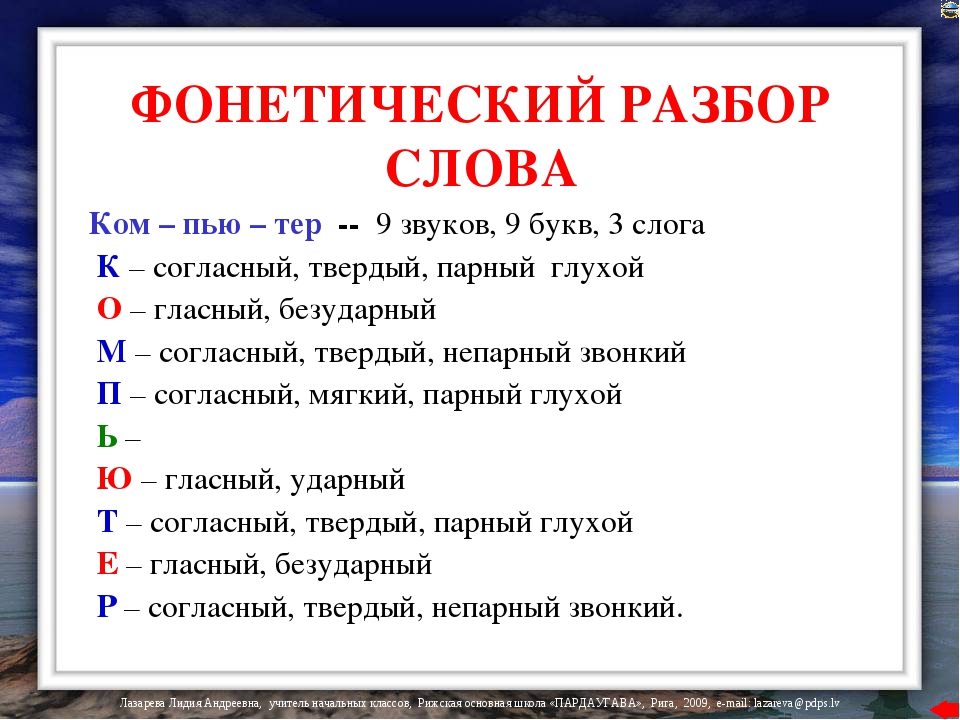

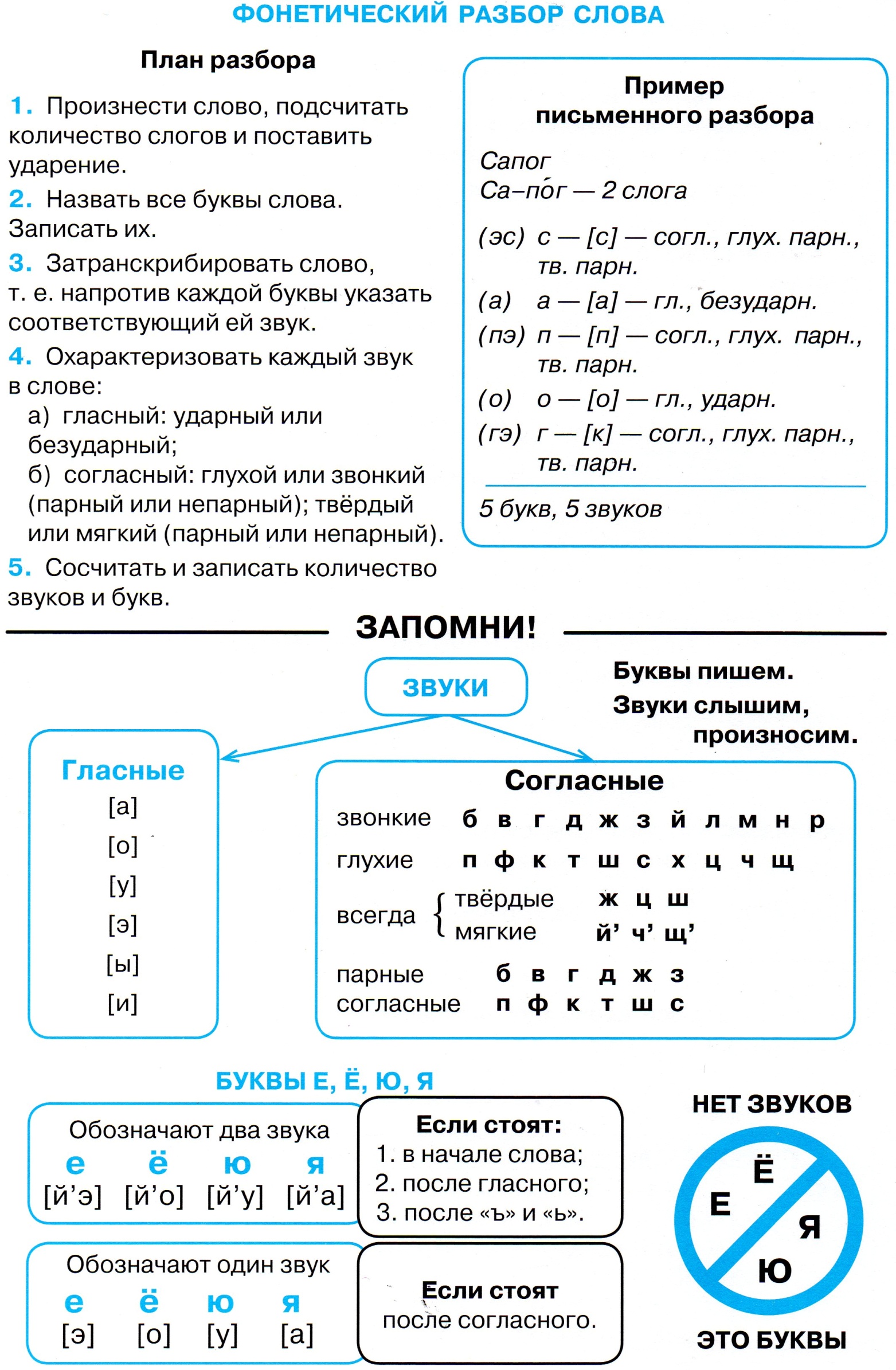

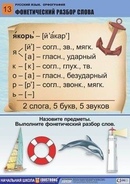

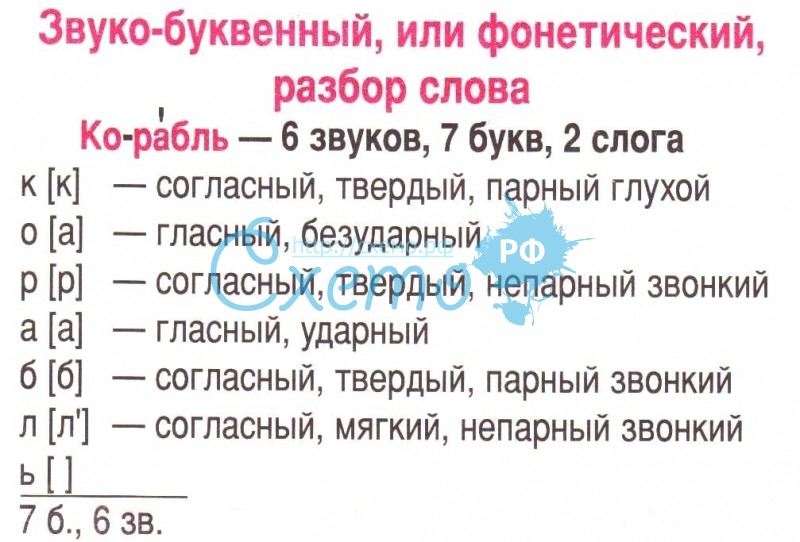

1) фонетический разбор слова НЕ МОГУ 2)морфемный разбор слова ПОБЕГУ 3) пунктационый разбор предлож Где ты, радуга-дуга.

Расставим знаки препинания:

1. Взволнованный и нетерпеливый, Абай даже не заметил, как они доехали до Верблюжьих горбов. В песнях его, нежных и волнующих душу, была и радость, наполнявшая его грудь, и тихая грусть. 3.

Изысканно одетая, гибкая, как молодое весеннее деревце, ясноглазая и

приветливая, она каким-то особенным сиянием одобрила юрту. 4. Часто, вконец уставший, измученный, он засыпал прямо в степи. 5. И время, прожитое с

бабушкой, овеянное её лаской, осталось в памяти Касыма как не ясное

воспоминание, как сладкий сон. 6. Сумрачный и озлобленный, он даже не

пытался скрыть своего подавленного настроения. 7. Во время весеннего

половодья мчится широкий поток бурный и стремительный, мощный и

волнующий. 8. Абай не уставал слушать бабушку, весь поглощённый её

рассказом, сосредоточенный и внимательный. 9. Голос её, удивительно

приятный и в разговоре, в песне, был совершенно пленительным. 10. Решение,

твердое и непоколебимое, внезапно возникло в нём. 11. Зачарованный

луной, Абай не открывал глаз от сияющего диска. 12. Стоит снять с беркута

колпачок — плененная птица тотчас кинет быстрый, мечущий искры, гордый, непокорённый взгляд, ещё более отважный и выразительный, чем когда она

находится на воле.

-Подожди меня.Я скоро вернусь.

-И как долго тебя ждать?Тише.Это пройдёт очень

быстро

-Хорошо.Буду ждать в правом крыле здания

Прости больше нечего придумать

..

..Спросить, потребовать ответ, узнать, зать вопрос, полюбопытствовать, поинтересоваться.

Морфологический разбор слова «мог»

Часть речи: Глагол в личной форме

МОГ — слово может быть как одушевленное так и неодушевленное, смотрите по предложению в котором оно используется.

Начальная форма слова: «МОЧЬ»

| Слово | Морфологические признаки |

|---|---|

| МОГ |

|

Все формы слова МОГ

МОЧЬ, МОГУ, МОЖЕМ, МОЖЕШЬ, МОЖЕТЕ, МОЖЕТ, МОГУТ, МОГ, МОГЛА, МОГЛО, МОГЛИ, МОГШИ, МОГИ, МОГИТЕ, МОГУЩИЙ, МОГУЩЕГО, МОГУЩЕМУ, МОГУЩИМ, МОГУЩЕМ, МОГУЩАЯ, МОГУЩЕЙ, МОГУЩУЮ, МОГУЩЕЮ, МОГУЩЕЕ, МОГУЩИЕ, МОГУЩИХ, МОГУЩИМИ, МОГШИЙ, МОГШЕГО, МОГШЕМУ, МОГШИМ, МОГШЕМ, МОГШАЯ, МОГШЕЙ, МОГШУЮ, МОГШЕЮ, МОГШЕЕ, МОГШИЕ, МОГШИХ, МОГШИМИ

Разбор слова в тексте или предложении

Если вы хотите разобрать слово «МОГ» в конкретном предложении или тексте, то лучше использовать морфологический разбор текста.

Найти синонимы к слову «мог»Примеры предложений со словом «мог»

1

не мог не смотреть на них, не мог стереть их, не мог не вызывать их.

2

Он не мог разлепить опухших век, не мог встать, не мог лежать, не мог вообще жить.

Суррогатный мир, Константин Уткин3

Ну пошутил, ну не мог ты заболеть им, не мог, не мог, не мог…

ЛЕДЯНАЯ КУПЕЛЬ. ПРОЗА XXI ВЕКА, Владимир Хованский4

Конечно, с Розановым

5

Положим, вы могли взять с него векселя, но ведь он мог их оспорить, мог доказывать, что они безденежные: взяты с него обманом, или насилием…

На ножах, Николай Лесков, 1870г.Найти еще примеры предложений со словом МОГ

Официальный сайт школы №2

Поздравляем победителей городских конкурсов24 января 2014

1. Бондаревича Егора ученика 3 Б класса (кл.руководитель Коваленко Л.В.) за лучшую декламацию в городском конкурсе литературно-музыкальных композиций «Чувства добрые я лирой пробуждал…» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии»

Бондаревича Егора ученика 3 Б класса (кл.руководитель Коваленко Л.В.) за лучшую декламацию в городском конкурсе литературно-музыкальных композиций «Чувства добрые я лирой пробуждал…» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии»

2. Устиновича Андрея — ученика 3 Г класса (кл.руководитель Куламова А.Н.), занявшего 1 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Традиционная кукла»

3. Кондратьеву Екатерину — ученицу 1 А класса (кл.руководитель Овчинникова Ю.А.),занявшую 1 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Рождественский ангел»

4. Болдыреву Дарью — ученицу 1 А класса (кл.руководитель Овчинникова Ю.А.),занявшую 1 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Настроение»

5. Цепелеву Василису — ученицу 4 В класс (кл.руководитель Данилова Т.А.) ,занявшую 1 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Традиционная кукла»

6. Быкова Романа — ученика 3 А класса (кл.руководитель Перепёлкина Н.В.), занявшего 2 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Бал в стиле Ретро»

7. Цергер Татьяну — ученицу 2 Г класса (кл.руководитель Роговая Л.А.), занявшую 2 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Традиционная кукла»

8. Волошину Дарью — ученицу 1 Б класса (кл.руководитель Низамутдинова Г.Ж.), занявшую 3 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Бал в стиле Ретро»

Волошину Дарью — ученицу 1 Б класса (кл.руководитель Низамутдинова Г.Ж.), занявшую 3 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Бал в стиле Ретро»

9. Бескову Анастасию — ученицу 4 Б класса (кл.руководитель Ермоленко О.И.), занявшую 3 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Настроение»

10. Якубова Ульяна — ученицу 1 А класса (кл.руководитель Овчинникова Ю.А.),занявшую 3 место в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии» В НОМИНАЦИИ «Рождественский ангел»

За оригинальность исполнения в городском конкурсе «Традиционная кукла» в рамках областного фестиваля детского и юношеского художественного и технического творчества «Юные таланты Московии»: Карпова Елизавета — ученица 3 Д класса , Полухин Михаил — ученик 3 А класса, Лучицкая Диана -ученица 1 Б класса, Старостин Андрей -ученик 4 А класса

ГДЗ по русскому языку 5 класс Рыбченкова, Алесандрова Решебник

В пятом классе изучение русского языка переходит на новый уровень. Дети уже считаются более взрослыми, а, соответственно, способными понять более сложные концепции, выполнять более интеллектуально насыщенные учебные действия. Рыбченкова Л.М., Алесандрова О.М., Глазков А.В. создали учебник и решебник для таких школьников. Его изданием, начиная с 2012 года, занимается издательство «Просвещение». Наиболее актуальной версией на данный момент считается издание 2019 года. На нашем сайте именно оно и представлено онлайн, а потому вы можете никогда не волноваться за качество и новизну представленной информации.

Чем конкретно ГДЗ Рыбченковой и Александровой поможет школьнику в 5 классе?

Чтобы приносить домой хорошие оценки и не чувствовать себя неуверенно на уроках, нужно прилагать некоторые усилия для учебы. Обязательно необходимо слушать пояснения учителя, однако по мере усложнения программы этого уже не достаточно. Следует также активно участвовать в обсуждениях, выходить к доске, следить за ходом дискуссии, особенно важно не отвлекаться на посторонние раздражители. Вне школы необходимо тщательно выполнять задания учителя на дом, своевременно устранять все недоработки, которые могли иметь место на уроках родной речи.

Обязательно необходимо слушать пояснения учителя, однако по мере усложнения программы этого уже не достаточно. Следует также активно участвовать в обсуждениях, выходить к доске, следить за ходом дискуссии, особенно важно не отвлекаться на посторонние раздражители. Вне школы необходимо тщательно выполнять задания учителя на дом, своевременно устранять все недоработки, которые могли иметь место на уроках родной речи.

Онлайн-решебник может помочь во время самостоятельных занятий предметом. Он содержит большое количество полезных комментариев, а также вспомогательных материалов. Часто бывает такие ситуации, что тема вроде бы усвоена, но чего-то не хватает, чтобы начать эффективно применять полученные знания на практике. В таких случаях нужно посмотреть на пример верного выполнения и распространить его на другие упражнения. Наши сборники обладают следующими положительными чертами:

- номера отсортированы с помощью табличного указателя;

- предложена только самая актуальная версия пособия;

- комментарии даны даже к самым простым вопросам;

- страница с верными ответами работает 24 часа в сутки и 7 дней в неделю. Заниматься можно когда угодно.

Материалы помогут повысить успеваемость, подготовиться к контрольным и проверочным работам. Ученик почувствует себя более уверенно, возможно, даже заинтересуется предметом.

Какие темы проходят по русскому языку с решебником Рыбченковой?

Рабочая программа этого года обучения весьма насыщена. Не стоит расслабляться и откладывать учебу на потом. Следует с первого дня серьезно засесть за уроки и выполнять все упражнения, ведь вот какие сложные и пространные разделы ждут пятиклассников:

- определение частей речи по вопросам, на которые отвечают слова;

- самостоятельные и служебные единицы. Имена существительные прилагательные, числительные, наречия, глаголы. Междометия, частицы, союзы, предлоги;

- морфологические разборы слов;

- развитие связной речи.

Сочинения и творческие изложения.

Сочинения и творческие изложения.

Сборник заданий по русскому языку (авторы: Рыбченкова, Алесандрова, Глазков) предназначен для пятиклассников. Он соответствует всем федеральным образовательным стандартам (ФГОС), поэтому используется в школах практически повсеместно.

Создание когнитивной формы фонологических единиц: Проблема соответствия звуков речи в младенчестве может быть решена с помощью зеркального речевого взаимодействия, а не имитации

Основные моменты

- •

Механизм, с помощью которого дети учатся произносить L1, все еще не был учредил.

- •

Ребенок может использовать переформулировку своей продукции во время имитационных взаимодействий как доказательство эквивалентности.

- •

Зеркальное отображение лица, осуществляющего уход, решает проблему соответствия между звуками действия и речи.

- •

Прямая ассоциация голосового действия и звука создает перцептуомоторное представление речи.

Abstract

Теории о когнитивной природе фонологических единиц были ограничены предположением, что маленькие дети решают проблему соответствия звуков речи путем имитации, будь то слуховое или жестовое сопоставление с целевым процессом. Подражание со стороны ребенка подразумевает, что он проводит сравнение в одной из этих областей, которая, как предполагается, является модальностью основного представления звуков речи.Однако нет никаких свидетельств того, что проблема соответствия решается таким образом. Вместо этого мы утверждаем, что ребенок может решить эту проблему, отражая поведение своих опекунов в рамках имитационных взаимодействий, и что этот механизм более согласуется с данными о развитии. Базовое представление, сформированное зеркальным отображением, по своей сути является моторно-перцептивным. Он создается путем объединения речевого действия, выполняемого ребенком, и его переформулирования в речевой токен L1, который он слышит в ответ. Наше описание того, как развиваются производство и восприятие с использованием этого механизма, объясняет некоторые давние проблемы речи и согласовывает данные из психологии и нейробиологии.

Наше описание того, как развиваются производство и восприятие с использованием этого механизма, объясняет некоторые давние проблемы речи и согласовывает данные из психологии и нейробиологии.

Ключевые слова

Фонологические единицы

Базовое представление речи

Приобретение речи

Задача соответствия

Развитие произношения

Имитация

Зеркальное отображение

Рекомендуемые статьи Цитирующие статьи (0)

Авторы.Опубликовано Elsevier Ltd.

Рекомендуемые статьи

Цитирующие статьи

Генетическая фонетика может быть уловкой для определения значения ДНК — ScienceDaily

Большинство современных попыток расшифровать, как части генетического кода преобразуются в физические характеристики, сродни первоклассник пытается произнести слово буква за буквой — или, в данном случае, пару оснований.

Но исследователи из Университета Флориды разработали вычислительный метод, который больше похож на чтение целых слов за раз.

В мире, где способность науки транскрибировать генетический код организма растет с каждым днем все быстрее, этот метод может предложить столь необходимую эффективность в преобразовании кажущейся бесконечной строки символов в информацию, которая может излечить болезнь или создать новые урожаи.

Исследователи из Института продовольственных и сельскохозяйственных наук UF и Института генетики UF опубликовали результаты своей проверки метода в PLoS One, онлайн-журнале, выпускаемом Публичной научной библиотекой.

«Мы очень много работали, чтобы найти способы сбора генетической информации», — сказал Ронглинг Ву, ведущий исследователь проекта и профессор UF Research Foundation. «Теперь мы должны упорно трудиться, чтобы найти способы, чтобы использовать его.»

Во многих отношениях исследователи думают о геноме организма как о списках из четырех букв, представляющих четыре аминокислотных основания, повторяющихся в разном порядке. Цель состоит в том, чтобы найти смысл в последовательностях, выяснить, как вариации в образе влияют на физиологию организма.

Цель состоит в том, чтобы найти смысл в последовательностях, выяснить, как вариации в образе влияют на физиологию организма.

Человеческий код, например, состоит из 3 миллиардов букв. Между любыми двумя из нас 99,9% этих букв совпадают. Но именно последние 0,1 процента разницы, пронизанные всей нашей ДНК в виде однобуквенных изменений, и объясняют нашу уникальную идентичность — от цвета глаз до восприимчивости к болезням.

Эти различия называются однонуклеотидными полиморфизмами или SNP (произносится как «обрезки»).

Самый простой способ узнать, как SNP влияет на организм, — это собрать группу организмов, которые имеют разные вариации этой буквы в своем генетическом коде.

Но на физические черты обычно влияют несколько SNP, которые взаимодействуют иногда непредсказуемым образом — так же, как буква «е» в конце слова может изменить его произношение.

К счастью, правила генетики гласят, что SNP, влияющие на один и тот же признак, обычно каким-то образом связаны друг с другом, например, находятся рядом друг с другом.

МодельВу использует эти правила в сочетании со статистическим анализом реальных данных о генетически картированных организмах.В результате модель может находить целые группы SNP, связанных с физическим признаком.

Точно так же, как понимание общих фонетических принципов позволяет читателю озвучить целое слово, это дополнительное знание генетики позволяет модели Ву находить полные картины геномных / физических корреляций.

«Настоящее обещание работы Ву состоит в том, что она может дать исследователю возможность не тратить действительно удручающее количество времени на анализ отдельных нуклеотидов, а перейти непосредственно к выполнению генетической работы, которая будет иметь большее значение. — сказал Рори Тодхантер, исследователь, занимающийся генетикой собак в Корнельском университете.

В этой статье исследователи проверили свою модель, используя генетическую и физическую информацию от мышей, которая была впервые собрана в лаборатории Джеймса Чеверуда Вашингтонского университета в середине 1990-х годов. Затем они сравнили свои результаты с результатами генетического анализа за несколько лет.

Затем они сравнили свои результаты с результатами генетического анализа за несколько лет.

Это подтверждение было важным, сказал Вэй Хоу, первый автор статьи и доцент кафедры эпидемиологии и исследований политики здравоохранения UF. Но анализ современных данных станет настоящим ключом к пониманию важности этого метода.Например, генетическая информация мышей, использованная в этой статье, содержала всего несколько тысяч SNP. В выпуске журнала Nature от 29 июля было указано более 8 миллионов SNP для генома мыши.

«Это показывает, как нам нужно выйти за рамки рассмотрения SNP геномов по SNP», — сказал Чеверуд. «Представьте себе работу, которая впереди нас, если мы этого не сделаем».

Как морфологическая структура влияет на фонетическую реализацию в составных существительных английского языка

Data

Мы исследовали продолжительность согласных на границах составных внутренних, например:

- (4)

Согласный звук является частью первого существительного («N1»), как в (4), второго существительного («N2»), как в (6), или обоих, как в (5).Это позволило нам проверить, какие факторы влияют на какую часть границы. Другими словами, если происходит редукция, происходит ли это перед границей, после границы или по обе стороны границы?

Мы особенно хотели включить такие соединения, как crea m m ini , с двойной согласной на границе, чтобы максимизировать наши шансы на обнаружение парадигматического эффекта улучшения. Единственное предыдущее сообщение о таком эффекте для соединений — это Kuperman et al.(2007), которые обнаружили парадигматический эффект увеличения продолжительности интерфиксов в голландских соединениях. Хотя в английском языке нет интерфиксов, мы рассудили, что мы могли бы увидеть похожий эффект на сегменты на сложных внутренних границах, возможно, особенно на морфологических близнецов, поскольку в таких случаях один артикуляционный жест пересекает границу. Следовательно, близнецы могут подвергаться влиянию лексических свойств обеих составляющих, как и интерфиксы. В настоящем исследовании мы сосредотачиваемся на согласных / m /, / n / и / s /, поскольку было показано (e.грамм. by Ben Hedia 2019), что эти звуки могут демонстрировать явные фонетические эффекты морфологической геминации в английском языке.

Следовательно, близнецы могут подвергаться влиянию лексических свойств обеих составляющих, как и интерфиксы. В настоящем исследовании мы сосредотачиваемся на согласных / m /, / n / и / s /, поскольку было показано (e.грамм. by Ben Hedia 2019), что эти звуки могут демонстрировать явные фонетические эффекты морфологической геминации в английском языке.

Английские соединения показывают значительные различия в орфографическом представлении между написанием с интервалом, дефисом и без пробела. Однако написание без пробелов и дефисов, как правило, коррелирует с высокой частотой и лексикализацией (см. Обсуждение в Bell and Plag 2012). Поэтому, чтобы найти образец подтвержденных соединений с широким диапазоном частот и в то же время избежать усложняющего фактора, связанного с разнообразием написания, мы решили сосредоточиться исключительно на соединениях, расположенных через интервалы.

Соединения, используемые в настоящем исследовании, были выбраны из устной части Британского национального корпуса. Использование речевой части корпуса гарантирует, что полученные соединения были спонтанно произведены говорящим по крайней мере один раз. Интерфейс BNCweb (Hoffmann et al. 2008) использовался для поиска строк из двух существительных, за исключением строк, которые пересекали границу предложения или включали паузу или любую другую форму прерывания, например, кашель, между двумя существительными. В запросах корпуса также указывалось, что слово после второго существительного не должно быть другим существительным, прилагательным или притяжательным.Это ограничило поиск строками из двух существительных и исключило комбинации, которые были частью более крупной составной конструкции. Впоследствии строки были проверены в контексте, чтобы убедиться, что они представляют конструкции, в которых первое существительное изменяет второе. Мы придерживаемся точки зрения, следуя, например, Бауэр (1998), Белл (2011), Плаг и др. (2008), что все подобные конструкции можно отнести к составным. На этом этапе из данных также были исключены типы, в которых два существительных были идентичны или одно существительное было расставлено через дефис, а также имена собственные, аппозитивные конструкции и звательные падежи.

На этом этапе из данных также были исключены типы, в которых два существительных были идентичны или одно существительное было расставлено через дефис, а также имена собственные, аппозитивные конструкции и звательные падежи.

Фонологические транскрипции существительных, составляющих соединения, были извлечены из лексической базы данных CELEX (Baayen et al. 1995, далее CELEX), а в тех случаях, когда компонент не появлялся в CELEX, они были дополнены ручной транскрипцией. Эти транскрипции затем использовались для определения типов, в которых первое слово заканчивалось одной из согласных / s /, / m / или / n /, а второе слово начиналось той же фонемой. Из этого набора мы выбрали только те комбинации, в которых ни согласная в конце слова, ни согласная в начале слова не входили в состав кластера.Мы также использовали транскрипцию для выбора соединений, в которых либо первое слово заканчивалось на / s /, / m / или / n /, а второе слово начиналось с гласной, либо второе слово начиналось с одного из этих согласных и первого слова заканчивался гласной. Опять же, мы исключили типы с кластерами в начале или в конце слова. Далее мы ограничились типами, в которых, согласно CELEX или нашей ручной транскрипции, лексическое ударение второго существительного приходилось на первый слог этого существительного. Footnote 2 Таким образом, все соединения в наборе данных удовлетворяют следующим критериям: есть одинарный или двойной / s /, / m / или / n / на внутренней границе соединения, и соответствующие согласные оба следуют за гласная и предшествует ударной гласной.Некоторые примеры показаны в таблице 1.

Таблица 1 Примеры экспериментальных элементовИз набора соединений, описанных в предыдущем абзаце, мы выбрали подмножество для использования в нашем исследовании. При выборе подмножества мы стремились достичь как можно более широкого и сбалансированного диапазона по следующим критериям:

Количество слогов в N1

Количество слогов в N2

Вес последнего слога N1, сильный или слабый

Ожидаемое положение сложного напряжения на N1 или N2

Гласная фонема, предшествующая согласной (-ым)

Гласная фонема, следующая за согласной (-ми)

Другими словами, элементы были выбраны для увеличения разнообразия данных по этим критериям и во избежание предвзятости в отношении какой-либо конкретной структуры слогов, ударения или гласных. С другой стороны, элементы исключались, если они были уникальными с точки зрения любой из этих переменных, так как это привело бы к путанице между составом и условием. В случаях, когда всем этим ограничениям удовлетворяло более одного соединения, окончательный выбор производился случайным образом. Эти процедуры привели к списку соединений с 19 типами соединений с / m / на границе, 19 типами для / n / и 24 типами для / s /.

С другой стороны, элементы исключались, если они были уникальными с точки зрения любой из этих переменных, так как это привело бы к путанице между составом и условием. В случаях, когда всем этим ограничениям удовлетворяло более одного соединения, окончательный выбор производился случайным образом. Эти процедуры привели к списку соединений с 19 типами соединений с / m / на границе, 19 типами для / n / и 24 типами для / s /.

Экспериментальная установка

Разговорные токены всех соединений в нашем окончательном наборе данных были получены от 30 носителей британского английского языка, которые читали соединения, представленные в предложениях-носителях, на экране компьютера.Каждое соединение было встроено в два разных предложения-носителя:

- (5)

Снова заговорили о [ соединение ] .

- (6)

Она рассказала мне о [ соединение ].

Эти два предложения различаются в зависимости от того, встречается ли составное слово в конечной позиции: это позволило включить в анализ любые эффекты удлинения или сокращения фразовой позиции.Каждый участник прочитал каждое соединение только один раз, либо в предложении (7), либо в предложении (8). Однако в целом каждый участник видел равное количество обоих типов предложений, и каждое соединение было включено в равное количество токенов каждого типа предложения. Предложения были смешаны с таким же количеством несвязанных предложений-заполнителей, которые были экспериментальными элементами для другого исследования. Поскольку предложения-наполнители имели множество различных структур, они служили для устранения повторяемости наших предложений-носителей и снижения риска развития интонации, подобной списку. Каждый участник видел предметы, включая наполнители, в разном случайном порядке.

Каждый участник видел предметы, включая наполнители, в разном случайном порядке.

Каждое предложение было представлено на двух последовательных слайдах. На первом слайде каждой пары участникам предлагалось прочитать предложение молча, а на втором слайде им предлагалось прочитать предложение вслух. Фаза беззвучного чтения была предназначена как для поощрения семантической обработки предложения, так и для снижения риска ошибок выполнения при последующем чтении вслух. Это был начальный этап обучения, и участники могли продвигаться по презентации в своем собственном темпе.

Записи производились в звукоизолированной кабине, оцифровывались с частотой 44,1 кГц с использованием цифрового записывающего устройства Tascam HD-P2 и кардиоидного микрофона Sennheiser ME 64, участники сидели на расстоянии 15 см от микрофона, а уровни записи устанавливались для каждого участника.

Акустические измерения

После записи предложений мы вручную сегментировали данные и фонетически расшифровали их с помощью программного обеспечения Praat (Boersma and Weenink 2014). Мы аннотировали рассматриваемые сегменты, а также предыдущие и последующие сегменты.Аннотация для паровой машины , например, включала сегментацию и / e /. Сегментация проводилась в соответствии с критериями, основанными на визуальном осмотре форм сигналов и спектрограмм элементов. Эти критерии были основаны на критериях сегментации, примененных в Ben Hedia (2019), которые, в свою очередь, основывались на особенностях конкретных звуков, как описано в фонетической литературе (например, Ladefoged 2003).

Поскольку все согласные встречаются в интервокальной позиции, мы сосредоточились на различиях между соответствующими согласными и гласными.Как и гласные, носовые имеют правильную форму волны, но их форманты довольно слабые по сравнению с таковыми у гласных. Это можно увидеть на фиг. 1, где показан пример сегментации слова паровой двигатель . В отличие от гласных, фрикативные звуки имеют апериодическую форму волны, и поэтому их довольно легко идентифицировать в интервокальной позиции. Все границы были установлены на ближайшем нулевом пересечении осциллограммы. Двойные согласные (например, / mm / in cream mini ) обрабатывались как один сегмент в аннотации, когда не было различимости границы между двумя идентичными согласными.Если между двумя согласными существовала видимая граница, оба согласных были сегментированы. Это был тот случай, когда говорящий создавал паузу между первой и второй составляющими. Впоследствии такие токены были исключены из анализа.

Все границы были установлены на ближайшем нулевом пересечении осциллограммы. Двойные согласные (например, / mm / in cream mini ) обрабатывались как один сегмент в аннотации, когда не было различимости границы между двумя идентичными согласными.Если между двумя согласными существовала видимая граница, оба согласных были сегментированы. Это был тот случай, когда говорящий создавал паузу между первой и второй составляющими. Впоследствии такие токены были исключены из анализа.

Аннотация к составу паровой двигатель

Надежность критериев сегментации проверялась серией пробных сегментов. В этих испытаниях три аннотатора использовали критерии для сегментации одних и тех же 20 элементов.Если было какое-либо расхождение более чем на 10 миллисекунд в размещении границ, аннотаторы обсуждали расхождение и уточняли критерии, чтобы уменьшить количество вариаций между аннотаторами. Эти пробные сегменты повторяли до тех пор, пока все границы не были надежно размещены с небольшими отклонениями (т.е. не более 10 миллисекунд). Для окончательного измерения каждый аннотатор работал с разрозненным набором элементов. Для обеспечения согласованности между аннотаторами проводились регулярные встречи между аннотирующей группой и первыми двумя авторами этой статьи, на которых мы обсуждали любые вопросы, по которым у аннотатора был запрос.Для этих проблемных элементов соответствующие границы были установлены на основе консенсуса, а рекомендации по аннотациям были обновлены с учетом любых ранее непредвиденных проблем. В качестве дополнительной меры предосторожности против систематической изменчивости между экспертами мы включили аннотатор как случайный эффект в наши модели, хотя это оказалось несущественным.

токенов были исключены из дальнейшего анализа, если предполагалось, что говорящий совершил ошибку производительности, или если было невозможно определить соответствующие границы сегмента в речевом потоке. В результате осталось 1546 сегментированных составных токенов. Для этого набора токенов скрипт Python использовался для измерения и извлечения длительности соединения, продолжительности составляющих, продолжительности рассматриваемых согласных, а также продолжительности их предшествующих и последующих сегментов в миллисекундах.

В результате осталось 1546 сегментированных составных токенов. Для этого набора токенов скрипт Python использовался для измерения и извлечения длительности соединения, продолжительности составляющих, продолжительности рассматриваемых согласных, а также продолжительности их предшествующих и последующих сегментов в миллисекундах.

Переменные-предикторы

Обзор

Для проверки трех рассматриваемых гипотез мы извлекли ряд частотных показателей из ukWaC (https://www.webarchive.org.uk/ukwa/), корпус из более чем 2 миллиарда слов из.uk интернет-домен. В том числе:

Частота соединения: общая частота соединения, включая все варианты написания (с пробелами, дефисами и конкатенациями; британский и американский), а также формы единственного и множественного числа N2. Мы лемматизировали N2, чтобы формы единственного и множественного числа одного и того же соединения считались вместе, например бутерброд с тунцом и бутерброд с тунцом . Однако мы не включили форму множественного числа N1, потому что посчитали, что модификаторы множественного числа, вероятно, представляют разные леммы e.грамм. кресло против гонка вооружений .

Коэффициент правописания: отношение количества жетонов составного слова, написанного без пробелов, т. Е. С дефисом или конкатенированием, к количеству жетонов, написанных с пробелом, рассчитывается как:

$$ \ mathit {Правописание} \ mathit {Ratio} = (f (\ mathit {concatenated}) + f (\ mathit {hyphenated})) / f (\ mathit {spaced}) $$

Частота N1 и частота N2: общая частота леммы каждой составляющей, включая все варианты написания (британский и американский).

Размер семейства N1 и размер семейства N2: размер позиционного семейства каждого компонента, то есть количество составных типов с данным компонентом в одной позиции.

{n} _ {i = 1} f (\ textit {N1-component} _ {i}) $$

{n} _ {i = 1} f (\ textit {N1-component} _ {i}) $$Парадигматическая вероятность согласного с данным N1: парадигматическая вероятность соответствующего согласного, следующего за N1 в составе, на основе токена.{n} _ {i = 1} f (\ textit {N1-component} _ {i}) \ end {align} $$

Мы также вычислили версию этой переменной на основе типа: количество соединений N1 в который N2 начинался с рассматриваемого согласного, разделенного на размер семейства N1.

Энтропия N1 и энтропия N2: энтропии составляющих семейств. Энтропия составляющего семейства — это мера относительной ожидаемости различных соединений в семействе и общий уровень неопределенности в семействе.{n} _ {i = 1} f (\ textit {Nx-соединение} _ {i} \!) $$

Показатели частоты, орфографии, размера семьи и вероятности были преобразованы в логарифм перед вводом их в статистический анализ. Давайте теперь посмотрим, как эти меры соотносятся с тремя гипотезами.

Сегментируемость

Мы использовали коэффициент правописания и размер семейства N1 для оценки сегментируемости соединений в нашем наборе данных. Эти переменные связаны с гипотезой сегментируемости следующим образом:

- Коэффициент правописания

: Куперман и Бертрам (2013) показали, что английские составные части с большей вероятностью будут написаны с интервалом, если их составные части встречаются чаще или орфографически длиннее.Они интерпретируют эти результаты как свидетельство опосредующего эффекта того, что они называют «морфемической заметностью»: соединения, составные части которых более заметны (в силу частоты или длины), с большей вероятностью будут написаны с интервалом. Мы понимаем, что это понятие значимости составляющих связано с возможностью сегментирования, так что более сегментируемые соединения имеют более заметные составляющие.

Мы предполагаем, что пространство в разнесенном соединении указывает на сегментацию писателя, и что писатели с большей вероятностью включают пространство, чем более сегментированным они считают составное соединение.С другой стороны, представления без интервалов связаны с лексикализацией и предполагают, что автор воспринимает составное слово как единую концептуальную единицу (см. Bell and Plag 2012). Следовательно, соединение с большей долей разнесенных токенов может рассматриваться как более сегментируемое, чем соединение с меньшим количеством разнесенных токенов, а коэффициент написания может отрицательно коррелировать с сегментируемостью. Если гипотеза сегментируемости верна, продолжительность согласных будет больше на внутренних границах более сегментированных соединений.Предполагая, что письмо и чтение вслух отражают одну и ту же конструкцию сегментирования, гипотеза, следовательно, предсказывает, что коэффициент правописания будет отрицательно коррелирован с продолжительностью согласных в наших данных.

Мы предполагаем, что пространство в разнесенном соединении указывает на сегментацию писателя, и что писатели с большей вероятностью включают пространство, чем более сегментированным они считают составное соединение.С другой стороны, представления без интервалов связаны с лексикализацией и предполагают, что автор воспринимает составное слово как единую концептуальную единицу (см. Bell and Plag 2012). Следовательно, соединение с большей долей разнесенных токенов может рассматриваться как более сегментируемое, чем соединение с меньшим количеством разнесенных токенов, а коэффициент написания может отрицательно коррелировать с сегментируемостью. Если гипотеза сегментируемости верна, продолжительность согласных будет больше на внутренних границах более сегментированных соединений.Предполагая, что письмо и чтение вслух отражают одну и ту же конструкцию сегментирования, гипотеза, следовательно, предсказывает, что коэффициент правописания будет отрицательно коррелирован с продолжительностью согласных в наших данных. Размер семейства N1: здесь мы предполагаем, что чем больше семейство N1, тем продуктивнее N1 как составной модификатор. Было показано, что большая продуктивность связана с большей сегментируемостью сложных слов (см.Hay and Baayen 2003), следовательно, соединения с более крупными семействами N1 должны быть более сегментированными, чем соединения с меньшими семействами N1. Гипотеза сегментируемости, таким образом, предсказывает, что размер семейства N1 будет положительно коррелировать с продолжительностью согласных на границе соединения и внутренней части.

Таблица 2 суммирует прогнозы, сделанные с помощью гипотезы сегментируемости. Как описано в разд. 2.1 сообщалось об эффектах сегментирования лингвистических элементов, возникающих как до, так и после морфологических границ.Если гипотеза сегментируемости верна, мы ожидаем найти соответствующие эффекты для всех согласных с внутренней границей в наших данных: N1-конечный, двойной и N2-начальный.

Информативность

Информативность связана с концепциями вероятности и ожидаемости. Лингвистический элемент, который менее вероятен в любом данном контексте, менее ожидаем в этом контексте и, в свою очередь, более информативен.Вероятный лингвистический элемент является более ожидаемым и, следовательно, менее информативным. Таким образом, гипотеза информативности предсказывает, что чем менее вероятно наличие согласного в данном контексте, тем дольше будет его реализация.

Мы проверили шесть различных типов вероятностей: составную частоту, составляющие частоты, условную вероятность N2 с учетом N1, размер семейства N1, энтропию N1 и условную вероятность рассматриваемого согласного с учетом N1. Первые пять из этих переменных относятся к ожидаемому на уровне слов.Мы предполагаем, что, если гипотеза верна, сложные внутренние согласные наследуют связанные с информативностью эффекты длины от составляющих и от составных, в которых они встречаются. Другими словами, чем менее вероятно соединение или компонент, тем дольше будет его реализация и, следовательно, тем дольше будет реализован каждый из его сегментов. Напротив, последняя переменная (условная вероятность согласного с данным N1) непосредственно измеряет ожидаемое значение согласного. Кроме того, некоторые из этих переменных измеряют вероятность N1 и / или N1-конечных согласных, в то время как другие измеряют вероятность N2 и / или N2-начальных согласных.Предполагается, что двойные согласные принадлежат частично к N1 и частично к N2 и, следовательно, отражают вероятность как N1, так и N2. Относительно этих различных показателей гипотеза информативности делает прогнозы, обобщенные в таблице 3 и описанные в следующих параграфах.

Частота соединения: чем чаще встречается соединение, тем более ожидаемым оно является в языке в целом, следовательно, тем короче его реализация и реализация любого согласного в нем.

Таким образом, все три типа согласных, N1-конечный, двойной и N2-начальный, должны иметь отрицательную корреляцию между их длительностью и составной частотой. Мы можем также ожидать, что наклон корреляции для двойных звуков будет круче, чем для одинарных согласных, поскольку будут затронуты как компоненты N1, так и N2.

Таким образом, все три типа согласных, N1-конечный, двойной и N2-начальный, должны иметь отрицательную корреляцию между их длительностью и составной частотой. Мы можем также ожидать, что наклон корреляции для двойных звуков будет круче, чем для одинарных согласных, поскольку будут затронуты как компоненты N1, так и N2.Частота N1 и частота N2: чем чаще составляющая, тем более ожидаемая она в языке в целом, следовательно, тем короче ее реализация и реализация любого согласного в нем.Таким образом, N1-конечные и двойные согласные должны показывать отрицательную корреляцию между их длительностью и частотой N1, в то время как двойные и N2-начальные согласные должны показывать отрицательную корреляцию между их длительностью и частотой N2.

Условные вероятности N2 при N1: Чем выше условная вероятность N2, синтагматически или парадигматически, тем менее информативно N2 при N1, следовательно, тем короче его реализация и реализация его сегментов.Таким образом, продолжительность N2-начальных и двойных согласных должна быть отрицательно коррелирована как с синтагматической вероятностью N2 для N1, так и с парадигматической вероятностью N2 для N1.

Размер семейства N1 и энтропия N1: чем больше семейство N1 и больше его энтропия, тем менее предсказуемо N2 при N1, поэтому более высокие значения этих переменных указывают на то, что N2 более информативно. Следовательно, продолжительность N2-начальных согласных должна быть положительно коррелирована как с размером семейства N1, так и с энтропией N1.И наоборот, чем меньше семейство N1 и чем ниже его энтропия, тем более информативным является N1 в отношении возможных значений N2. Следовательно, продолжительность согласных в конце N1 должна иметь отрицательную корреляцию с размером семейства N1 и энтропией N1.

Ожидается, что продолжительность двойных согласных не будет показывать общий эффект этих переменных или не будет вообще, положительная корреляция с длительностью элемента N2 уравновешивается отрицательной корреляцией с длительностью элемента N1.

Ожидается, что продолжительность двойных согласных не будет показывать общий эффект этих переменных или не будет вообще, положительная корреляция с длительностью элемента N2 уравновешивается отрицательной корреляцией с длительностью элемента N1.Парадигматическая вероятность согласного с данным N1 (на основе типа или на основе лексемы): поскольку это вероятность того, что согласный звук следует за N1 в пределах составляющего семейства, т.е.е. в начале N2, что касается гипотезы информативности, это относится только к двойным и начальным N2 согласным. Чем больше вероятность на основе лексемы или типа того, что N2 начинается с рассматриваемого согласного, тем короче должны быть эти согласные.

Парадигматическая поддержка

За исключением Lõo et al. (2018), которые измеряли длительность всего слова, большинство исследований, в которых сообщалось об эффектах парадигматического улучшения, обнаруживали их в суффиксах или сложных интерфиксах.Рассматриваемые аффиксы в основном состоят из одиночных фонем, и поэтому неясно, действуют ли такие эффекты на уровне морфемы или фонемы. По этой причине мы включили оба этих уровня в наш анализ продолжительности согласного, то есть парадигматическую вероятность самого согласного и составного компонента, содержащего его. Соответствующая парадигма для слов с изменением и производных слов состоит из всех слов, имеющих одну основу или аффикс. Что касается соединений, единственным исследованием, в котором сообщалось об усилении парадигматизма, является Kuperman et al.(2007), которые обнаружили, что релевантной парадигмой является семейство позиционных составляющих N1, то есть все соединения, которые имеют один и тот же первый элемент. Поэтому для проверки гипотезы поддержки парадигм мы использовали размер семейства N1 и парадигматическую вероятность согласного с данным N1 следующим образом:

Размер семейства N1: Чем больше размер семейства N1, тем больше возможных значений для N2, следовательно, тем ниже парадигматическая поддержка для каждого соединения в семье.

Таким образом, парадигматическая гипотеза поддержки предсказывает, что увеличение размера семейства N1 будет связано с более короткой продолжительностью согласных на границе соединения и внутренней гармонии.

Таким образом, парадигматическая гипотеза поддержки предсказывает, что увеличение размера семейства N1 будет связано с более короткой продолжительностью согласных на границе соединения и внутренней гармонии.Парадигматическая вероятность согласного с данным N1 (на основе типа или на основе лексемы): более высокие значения этих переменных означают, что, когда N1 встречается как первый элемент соединения, за ним с большей вероятностью последует рассматриваемый согласный.Другими словами, более высокие значения указывают на то, что соединения, в которых N2 начинается с соответствующей согласной, сравнительно многочисленны и / или часто встречаются в семействе составляющих N1. Таким образом, парадигматическая гипотеза поддержки предсказывает, что увеличение парадигматической вероятности согласного с данным N1 будет связано с большей длительностью согласного на границе составного и внутреннего.

Поскольку ранее сообщалось об улучшении парадигматизма в основном для суффиксов и интерфиксов, т.е.е. для лингвистических элементов, которые следуют за морфологической границей, неясно, следует ли ожидать эффекта для всех наших согласных с внутренней границей или только для двойных и N2-начальных падежей. Прогнозы гипотезы поддержки парадигм суммированы в Таблице 4.

Таблица 4 Сводка прогнозов, сделанных гипотезой поддержки парадигмОбратите внимание, что разные гипотезы делают противоречивые прогнозы о влиянии определенных переменных, особенно размера семьи N1 и парадигматического вероятность согласного данного N1.Таким образом, эти предикторы можно использовать для проверки гипотез друг против друга.

Контрольные переменные

Помимо интересующих нас предикторов, мы также включили в наши модели ряд контрольных переменных. Это были:

Граничный тип (C # C, C # V или V # C): мы включили эту переменную по двум причинам.

Во-первых, фонетические исследования показали, что на продолжительность согласных может влиять фонетический контекст, в котором они встречаются (например,грамм. Умеда 1977). Во-вторых, наши гипотезы делают разные прогнозы для согласных в разных позициях, поэтому мы ожидали найти взаимодействия между типом границы и другими предикторами.

Во-первых, фонетические исследования показали, что на продолжительность согласных может влиять фонетический контекст, в котором они встречаются (например,грамм. Умеда 1977). Во-вторых, наши гипотезы делают разные прогнозы для согласных в разных позициях, поэтому мы ожидали найти взаимодействия между типом границы и другими предикторами.Согласный (/ m /, / n / или / s /): эта переменная контролирует внутреннюю разницу в продолжительности между тремя согласными.

Скорость речи: это локальная скорость речи, измеряемая как количество сегментов в секунду.Он был вычислен для каждого составного токена путем деления количества сегментов в соединении на общую продолжительность соединения в секундах. Очевидно, что более высокая скорость речи приводит к меньшей продолжительности отдельных сегментов.

Количество слогов в N1 и количество слогов в N2: было показано (например, Lindblom 1963; Nooteboom 1972), что сегменты могут быть короче, если слова, в которых они встречаются, имеют больше слогов.Этот эффект можно концептуализировать как своего рода эффект сжатия, когда слова с большим количеством слогов подвергаются сокращению. Поэтому мы включили количество слогов двух составляющих в наш набор ковариат.

Орфография: это двоичная переменная, кодирующая, встречается ли один и тот же орфографический согласный по обе стороны от составляющей границы. Он принимает значение «истина», если одна и та же буква встречается с обеих сторон границы, e.грамм. сигнал шины . Для всех остальных соединений он имеет значение «ложь», например мирное поселение , СМИ , лебединый трактир . Мы включили эту переменную, потому что существует хорошо известное влияние орфографии на произношение у грамотных носителей (см.

Damian and Bowers 2003 и ссылки в нем), поэтому вполне возможно, что согласные, представленные орфографически по обе стороны от составляющей границы, могут иметь разные акустические характеристики. реализация, чем другие альтернативы.

Damian and Bowers 2003 и ссылки в нем), поэтому вполне возможно, что согласные, представленные орфографически по обе стороны от составляющей границы, могут иметь разные акустические характеристики. реализация, чем другие альтернативы.Порядок представления элементов: Эта переменная была включена для контроля эффектов изменчивости внимания или утомляемости на протяжении всего эксперимента.

Статистический анализ

Мы провели регрессионный анализ смешанных эффектов с использованием пакета lme4 в R (Bates et al. 2015). Зависимой переменной была продолжительность согласного, продолжительность согласного на границе сложного и внутреннего звука в миллисекундах.Перед анализом мы обрезали данные, чтобы удалить выбросы с очень большой или короткой продолжительностью, а также удалили выбросы в отношении скорости речи. Этот процесс привел к потере 25 точек данных, около 1,6% данных. Количество типов и токенов в наборе данных, используемом для моделирования, показано в таблице 5.

Таблица 5 Распределение типов и токеновМногие из наших интересующих переменных сильно коррелированы друг с другом, что означает, что они, вероятно, учитывают для той же части дисперсии в зависимой переменной.Включение коллинеарных предикторов может привести к нестабильным статистическим моделям, в которых трудно идентифицировать эффекты отдельных переменных. Поскольку нас в первую очередь интересовали эффекты конкретных предикторов как способ проверки наших гипотез, поэтому нам нужно было уменьшить количество коллинеарности в наших моделях. Для этого мы применили процедуру моделирования, описанную в следующих параграфах.

На первом этапе мы построили модели со случайными эффектами только для участника, элемента, аннотатора и составной позиции (финальное предложение или нет).При наличии случайных эффектов для участника и предмета влияние аннотатора было незначительным, и поэтому эта переменная была исключена из дальнейшего анализа. Во-вторых, мы добавили управляющие переменные, включая трехстороннее взаимодействие между типом границы, согласным звуком и скоростью речи. На этом этапе ни порядок представления пунктов, ни количество слогов в любой из составляющих не оказались значимыми, поэтому эти переменные также были исключены. В-третьих, мы смоделировали влияние каждого интересующего предиктора на продолжительность согласных в отдельных отдельных моделях.Каждая из этих моделей также включала значительные случайные эффекты и управляющие переменные, а также трехстороннее взаимодействие между типом границы, согласным и предиктором, а также между типом границы, согласным и скоростью речи. Мы включили эти условия взаимодействия, потому что, как описано в разд. 3.4.5, наши гипотезы делают разные прогнозы для согласных на разных типах границ, и мы также ожидали, что присущие различия продолжительности между / m /, / n / и / s / могут привести к различиям в их наклонах по сравнению с другими предикторами. .

Во-вторых, мы добавили управляющие переменные, включая трехстороннее взаимодействие между типом границы, согласным звуком и скоростью речи. На этом этапе ни порядок представления пунктов, ни количество слогов в любой из составляющих не оказались значимыми, поэтому эти переменные также были исключены. В-третьих, мы смоделировали влияние каждого интересующего предиктора на продолжительность согласных в отдельных отдельных моделях.Каждая из этих моделей также включала значительные случайные эффекты и управляющие переменные, а также трехстороннее взаимодействие между типом границы, согласным и предиктором, а также между типом границы, согласным и скоростью речи. Мы включили эти условия взаимодействия, потому что, как описано в разд. 3.4.5, наши гипотезы делают разные прогнозы для согласных на разных типах границ, и мы также ожидали, что присущие различия продолжительности между / m /, / n / и / s / могут привести к различиям в их наклонах по сравнению с другими предикторами. .

Среди переменных, перечисленных в таблицах 2–4, коллинеарность была особенно высокой между составной частотой и условной вероятностью N2, между версиями вероятности согласных на основе типа и на основе лексемы, а также между частотой N1, размером семейства N1 и N1. энтропия. Поэтому в нашу полную модель мы включили только переменную из каждой из этих групп, которая оказала наибольшее влияние на продолжительность согласных в ее индивидуальной модели. Остальные переменные из каждой группы были исключены из анализа.После этого процесса интересующие нас переменные, оставшиеся в нашей полной модели, включали составную частоту, размер семейства N1, коэффициент написания, частоту N2 и парадигматическую вероятность согласного, заданного N1, на основе токенов. Этот набор переменных был проверен на любую оставшуюся коллинеарность с помощью функции collin.fnc пакета LanguageR (Baayen and Shafaei-Bajestan 2019), которая дала приемлемое число условий около 27,15 (согласно Baayen 2008, числа условий 30 и больше может указывать на потенциально опасную коллинеарность).

Начиная с полной модели, описанной выше, и включая значимые взаимодействия отдельных моделей, мы использовали ступенчатую функцию пакета lmerTest (Кузнецова и др., 2017), чтобы исключить незначительные фиксированные эффекты и выбрать оптимальные случайные эффекты. состав. Проверка полученной модели показала, что остатки имели неудовлетворительное, то есть ненормальное, распределение. Чтобы решить эту проблему, снова глядя на полную модель, мы использовали преобразование Бокса-Кокса (Box and Cox 1964, Venables and Ripley 2002), чтобы определить подходящий параметр преобразования ( λ ) для степенного преобразования зависимой переменной.Оптимальное значение λ оказалось равным λ = 0,5454545. Это преобразование было применено, и незначительные эффекты были снова удалены с помощью пошаговой функции. Наконец, мы удалили точки данных, стандартизированные остатки которых имели абсолютное значение более 2,5 стандартных отклонений, что привело к потере 1,9% наблюдений. Полученная окончательная модель имела нормально распределенные остатки (критерий нормальности Шапиро-Уилка, W = 0,99818, p = 0.1038).

эпитран · PyPI

Библиотека и инструмент для транслитерации орфографического текста в IPA (международный фонетический алфавит).

Использование

Модули Python epitran и epitran.vector можно использовать для простого написания более сложных программ Python для развертывания таблиц сопоставления Epitran , препроцессоров и постпроцессоров. Это описано ниже.

Использование эпитрана

МодульКласс Эпитран

Наиболее общие функции модуля epitran заключены в очень простой класс Epitran :

Эпитран (код, preproc = True, postproc = True, ligatures = False, cedict_file = None).

Его конструктор принимает один аргумент, код , , код ISO 639-3 языка, который нужно транслитерировать, плюс дефис плюс четырехбуквенный код сценария (например, «Latn» для латинского алфавита, «Cyrl» для кириллицы, и «арабский» для персидско-арабского письма). Он также принимает необязательные аргументы ключевого слова:

Он также принимает необязательные аргументы ключевого слова:

-

preprocиpostprocвключают пре- и постпроцессоры. По умолчанию они включены. -

лигатурпозволяет использовать нестандартные лигатуры IPA, такие как «ʤ» и «ʨ». -

cedict_fileуказывает путь к файлу словаря CC-CEDict (актуально только при работе с мандаринским китайским языком и который из-за лицензионных ограничений не может распространяться с Epitran).

>>> импортный эпитран

>>> epi = epitran.Epitran ('uig-Arab') # уйгурский язык персидско-арабским шрифтом.

Теперь можно использовать класс Epitran для английского и китайского (упрощенного и традиционного) G2P, а также для других языков, использующих «классическую» модель Epitran.Для китайского языка необходимо указать в конструкторе копию словаря CC-CEDict:

>>> импортный эпитран

>>> epi = epitran.Epitran ('cmn-Hans', cedict_file = 'cedict_1_0_ts_utf-8_mdbg.txt')

Наиболее полезным общедоступным методом класса Epitran является транслитерация :

Эпитран. транслитерировать (текст, normpunc = False, лигатуры = False). Преобразование текста (в кодировке Unicode языка, указанного в конструкторе) в IPA, который возвращается. normpunc включает нормализацию пунктуации, а лигатур разрешает нестандартные лигатуры IPA, такие как «ʤ» и «ʨ». Использование показано ниже (Python 2):

>>> epi.transliterate (u'Düğün ') u'dy \ u0270yn ' >>> print (epi.transliterate (u'Düğün ')) Dyɰyn

Эпитран. word_to_tuples (слово, normpunc = False):

Принимает слово (строка Unicode) в поддерживаемой орфографии в качестве входных данных и возвращает список кортежей, каждый из которых соответствует сегменту IPA слова.Кортежи имеют следующую структуру:

(

character_category :: String,

is_upper :: Integer,

orthographic_form :: Unicode String,

phonetic_form :: Unicode String,

сегменты :: List

)

Обратите внимание, что word_to_tuples реализовано не для всех пар язык-скрипт.

Коды для character_category — это начальные символы двух последовательностей символов, перечисленных в кодах «Общая категория», приведенных в главе 4 стандарта Unicode.Например, «L» соответствует буквам, а «P» — производственным маркам. Приведенная выше структура данных может измениться в последующих версиях библиотеки. Структура сегментов выглядит следующим образом:

(

сегмент :: Unicode String,

vector :: List

)

Вот пример взаимодействия с word_to_tuples (Python 2):

>>> импортный эпитран

>>> epi = epitran.Epitran ('тур-латн')

>>> эпи.word_to_tuples (u'Düğün ')

[(u'L ', 1, u'D', u'd ', [(u'd', [-1, -1, 1, -1, -1, -1, -1, -1, 1, -1, -1, 1, 1, -1, -1, -1, -1, -1, -1, 0, -1])]), (u'L ', 0, u'u \ u0308 ', u'y', [(u'y ', [1, 1, -1, 1, -1, -1, -1, 0, 1, -1, -1, -1, -1 , -1, 1, 1, -1, -1, 1, 1, -1])]), (u'L ', 0, u'g \ u0306', u '\ u0270', [(u ' \ u0270 ', [-1, 1, -1, 1, 0, -1, -1, 0, 1, -1, -1, 0, -1, 0, -1, 1, -1, 0, -1, 1, -1])]), (u'L ', 0, u'u \ u0308', u'y ', [(u'y', [1, 1, -1, 1, - 1, -1, -1, 0, 1, -1, -1, -1, -1, -1, 1, 1, -1, -1, 1, 1, -1])]), (u 'L', 0, u'n ', u'n', [(u'n ', [-1, 1, 1, -1, -1, -1, 1, -1, 1, -1, -1, 1, 1, -1, -1, -1, -1, -1, -1, 0, -1])])]

Класс отсрочки

Иногда при синтаксическом анализе текста более чем в одном скрипте полезно использовать изящную отсрочку.Если один языковой режим не работает, может быть полезно вернуться к другому и так далее. Эта функциональность обеспечивается классом Backoff:

.Отсрочка (lang_script_codes, cedict_file = None)

Обратите внимание, что класс Backoff в настоящее время не поддерживает параметризованное приложение препроцессора и постпроцессора и не поддерживает нестандартные лигатуры. Он также не поддерживает нормализацию знаков препинания. lang_script_codes — это список кодов, например eng-Latn или hin-Deva . Например, если кто-то транскрибирует текст на хинди с большим количеством английских заимствований и некоторыми случайными символами упрощенного китайского языка, можно использовать следующий код (Python 3):

Например, если кто-то транскрибирует текст на хинди с большим количеством английских заимствований и некоторыми случайными символами упрощенного китайского языка, можно использовать следующий код (Python 3):

из epitran.backoff import Backoff

>>> backoff = Backoff (['hin-Deva', 'eng-Latn', 'cmn-Hans'], cedict_file = ‘cedict_1_0_ts_utf-8_mdbg.txt ')

>>> backoff.transliterate ('हिन्दी')

'ɦindiː'

>>> backoff.transliterate ('английский')

'ɪŋɡlɪʃ'

>>> backoff.transliterate ('中文')

'oŋwən'

Backoff работает по принципу «токен за токеном»: токены, содержащие смешанные скрипты, будут возвращены как пустая строка, поскольку они не могут быть полностью преобразованы ни в одном из режимов.

Класс Backoff имеет следующие общедоступные методы:

- транслитерация : возвращает строку Unicode фонем IPA

- trans_list : возвращает список строк Unicode IPA, каждая из которых является фонема

- xsampa_list : возвращает список строк X-SAMPA (ASCII), каждая из которых фонема

Рассмотрим следующий пример (Python 3):

>>> backoff.transliterate ('हिन्दी')

'ɦindiː'

>>> Откат.trans_list ('हिन्दी')

['ɦ', 'i', 'n', 'd', 'iː']

>>> backoff.xsampa_list ('हिन्दी')

['h \\', 'i', 'n', 'd', 'i:']

DictFirst

Класс DictFirst представляет собой простую альтернативу классу Backoff . Это

требуется словарь слов, принадлежащих к языку A, по одному слову в строке в

Текстовый файл в кодировке UTF-8. Он принимает три аргумента: код языка-скрипта.

для языка A, для языка B и путь к файлу словаря. У него есть один общедоступный метод, транслитерация , который работает как Epitran.транслитерировать , за исключением того, что он возвращает транслитерацию для языка A, если входной токен находится в словаре; в противном случае возвращается транслитерация токена на языке B:

>>> import dictfirst >>> df = dictfirst.DictFirst ('tpi-Latn', 'eng-Latn', '../sample-dict.txt') >>> df.transliterate ('пела') "пела" >>> df.transliterate ('пело') 'пахать'

Препроцессоры, постпроцессоры и их подводные камни

Для создания поддерживаемого средства отображения орфографии в фонемы иногда необходимо использовать препроцессоры, которые выполняют контекстную замену символов перед передачей текста в систему отображения орфографии в IPA, которая сохраняет отношения между входными и выходными символами.Это особенно верно в отношении языков с плохим соответствием звуков и символов (например, французского и английского). Такие языки, как французский, являются особенно хорошими целями для этого подхода, потому что произношение данной строки букв очень предсказуемо, даже несмотря на то, что отдельные символы часто не отображаются четко в звуки. (Соответствие звука и символа в английском языке настолько плохо, что эффективные английские системы G2P сильно зависят от произношения словарей.)

Предварительная обработка входных слов для обеспечения прямого сопоставления графемы с фонемами (как это сделано в текущей версии epitran для некоторых языков) имеет преимущество, потому что ограниченный язык регулярных выражений, используемый для написания правил предварительной обработки, более мощный, чем язык правил отображения и позволяет записать эквивалент многих правил отображения с помощью одного правила.Без них поддержка epitran для таких языков, как французский и немецкий, была бы непрактичной. Однако они создают некоторые проблемы. В частности, при использовании языка с препроцессором, должен знать, что входное слово не всегда будет идентично конкатенации орфографических строк ( orthographic_form ), выводимых Epitran.word_to_tuples . Вместо этого вывод word_to_tuple будет отражать вывод препроцессора, который может удалять, вставлять и изменять буквы, чтобы на следующем этапе было возможно прямое отображение орфографии на фонемы. То же самое верно и для других методов, которые полагаются на

То же самое верно и для других методов, которые полагаются на Epitran.word_to_tuple , например VectorsWithIPASpace.word_to_segs из модуля epitran.vector .

Информацию о написании новых пре- и постпроцессоров см. В разделе «Расширение Epitran с помощью файлов карты, препроцессоров и постпроцессоров» ниже.

Использование

epitran.vector Модуль Модуль epitran.vector тоже очень прост. Он содержит один класс, VectorsWithIPASpace , включая один интересующий метод, word_to_segs :

Конструктор для VectorsWithIPASpace принимает два аргумента:

-

код: код языкового сценария для обрабатываемого языка. -

пробелов: коды для пробелов пунктуации / символов / IPA, в которых, как ожидается, будут находиться символы / сегменты из данных. Доступные места перечислены ниже.

Его основной метод — word_to_segs :

ВекторWithIPASpace. word_to_segs (слово, normpunc = False). слово — строка Unicode. Если аргумент ключевого слова normpunc установлен на True, пунктуация, обнаруженная в слове , нормализуется до эквивалентов ASCII.

Типичное взаимодействие с объектом VectorsWithIPASpace через метод word_to_segs показано здесь (Python 2):

>>> import epitran.vector

>>> vwis = epitran.vector.VectorsWithIPASpace ('uzb-Latn', ['uzb-Latn'])

>>> vwis.word_to_segs (u'darë ')

[(u'L ', 0, u'd', u'd \ u032a ', u'40', [-1, -1, 1, -1, -1, -1, -1, -1, 1, -1, -1, 1, 1, 1, -1, -1, -1, -1, -1, 0, -1]), (u'L ', 0, u'a', u 'a', u'37 ', [1, 1, -1, 1, -1, -1, -1, 0, 1, -1, -1, -1, -1, -1, -1, -1, 1, 1, -1, 1, -1]), (u'L ', 0, u'r', u'r ', u'54', [-1, 1, 1, 1, 0, -1, -1, -1, 1, -1, -1, 1, 1, -1, -1, 0, 0, 0, -1, 0, -1]), (u'L ' , 0, u'e \ u0308 ', u'ja', u'46 ', [-1, 1, -1, 1, -1, -1, -1, 0, 1, -1, -1, -1, -1, 0, -1, 1, -1, -1, -1, 0, -1]), (u'L ', 0, u'e \ u0308', u'ja ', u '37', [1, 1, -1, 1, -1, -1, -1, 0, 1, -1, -1, -1, -1, -1, -1, -1, 1, 1, -1, 1, -1])]

(Важно отметить, что, хотя слово, которое служит входом — дарэ — имеет четыре буквы, результат содержит четыре кортежа, потому что последняя буква в дарэ фактически соответствует двум сегментам IPA, / j / и / а /. ) Возвращенная структура данных представляет собой список кортежей, каждый из которых имеет следующую структуру:

) Возвращенная структура данных представляет собой список кортежей, каждый из которых имеет следующую структуру:

(

character_category :: String,

is_upper :: Integer,

orthographic_form :: Unicode String,

phonetic_form :: Unicode String,

in_ipa_punc_space :: Целое число,

phonological_feature_vector :: List <Целое число>

)

Несколько примечаний относительно этой структуры данных:

-

категория_символовопределена как часть стандарта Unicode (глава 4).Он состоит из одной заглавной буквы из набора {‘L’, ‘M’, ‘N’, ‘P’, ‘S’, ‘Z’, ‘C’}. Наиболее частыми из них являются ‘L ‘(буква),’ N ‘(число),’ P ‘(пунктуация) и’ Z ‘(разделитель [включая разделительный пробел]). -

is_upperсостоит только из целых чисел из набора {0, 1}, где 0 указывает нижний регистр, а 1 означает верхний регистр. - Целое число в

in_ipa_punc_spaceявляется индексом для списка известных символов / сегментов, так что, за исключением вырожденных случаев, каждому символу или сегменту присваивается уникальный и глобально согласованный номер.В случаях, когда встречается символ, который не находится в известном пространстве, это поле имеет значение -1. - Длина списка

phonological_feature_vectorдолжна быть постоянной для любого экземпляра класса (она основана на количестве функций, определенных в panphon), но — в принципе — переменной. Целые числа в этом списке взяты из набора {-1, 0, 1}, где -1 соответствует ‘-‘, 0 соответствует ‘0’, а 1 соответствует ‘+’. Для символов без эквивалента IPA все значения в списке равны 0.

Языковая поддержка

Пары языка транслитерации и скрипта

| Код | Язык (сценарий) |

|---|---|

| аар-Латн | Афар |

| amh-Ethi | Амхарский |

| арабский | Литературный арабский |

| азе-Cyrl | Азербайджанский (кириллица) |

| азе-Латн | Азербайджанский (латиница) |

| Бен-Бенг | Бенгальский |

| Бен-Бенг-красный | Бенгальский (сокращенный) |

| кот-Латн | Каталонский |

| ceb-Latn | Себуано |

| cmn-Hans | Мандарин (упрощенный) * |

| cmn-Hant | Мандарин (традиционный) * |

| ckb-арабский | Сорани |

| деу-Латн | Немецкий |

| деу-Латн-НП | немецкий † |

| deu-Latn-nar | Немецкий (более фонетический) |

англ. Лат. Лат. | Английский ‡ |

| фас-араб | Фарси (персидско-арабский) |

| фра-Латн | Французский |

| фра-Латн-НП | французский † |

| hau-Latn | Хауса |

| Хин-Дева | Хинди |

| хун-латн | Венгерский |

| ilo-Latn | Илокано |

| Инд-Латн | Индонезийский |

| ita-Latn | Итальянский |

| jav-Latn | Яванский |

| каз-Сирл | казахский (кириллица) |

| каз-Латн | казахский (латиница) |

| кин-Латн | киньяруанда |

| Кир-Араб | Кыргызский (персидско-арабский) |

| Кир-Кирл | Кыргызский (кириллица) |

| Кир-Латн | Кыргызский (латиница) |

| кмр-Латн | Курманджи |

| Лао-Лаоо | Лаос |

| Мар-Дева | маратхи |

| млт-латн | Мальтийский |

| mya-Mymr | Бирманский |

| мса-Латн | Малайский |

| nld-Latn | Голландский |

| ня-Латн | Chichewa |

| orm-Latn | Оромо |

| пан-Гуру | Пенджаби (восточный) |

| Поль-Латн | Польский |

| Пор-Латн | Португальский |

| Рон-Латн | Румынский |

| рус-Cyrl | Русский |

| sna-Latn | Шона |

| сом-латн | Сомали |

| СПА-Латн | Испанский |

| swa-Latn | Суахили |

| swe-Latn | шведский |

| там-Тамл | Тамил |

| тел-Телу | телугу |

| tgk-Cyrl | Таджикский |

| tgl-Latn | Тагальский |

| тайский | Тайский |

| tir-Ethi | Тигриня |

| tpi-Latn | Ток писин |

| тук-Сирл | Туркменский (кириллица) |

| тук-латн | туркменский (латиница) |

| тур-Латн | Турецкий (латиница) |

| укр-Сирл | украинцы |

| уг-араб | Уйгурский (персидско-арабский) |

| uzb-Cyrl | Узбекский (кириллица) |

| узб-латн | Узбекский (латиница) |

| vie-Latn | Вьетнамский |

| xho-Latn | Xhosa |

| йор-латн | Йоруба |

| зул-Латн | Зулу |

* Для китайского G2P требуется свободно доступный словарь CC-CEDict.

† Эти языковые препроцессоры и карты наивно предполагают фонематическую орфографию.

‡ Английский язык G2P требует установки свободно доступной системы синтеза речи CMU Flite.

Языки с ограниченной поддержкой из-за очень неоднозначной орфографии

К некоторым перечисленным выше языкам следует подходить с осторожностью. Невозможно обеспечить высокоточную поддержку этих пар язык-сценарий из-за высокой степени неоднозначности, присущей орфографии.В конце концов, мы планируем поддерживать эти языки с помощью другой серверной части, основанной на WFST или нейронных методах.

| Код | Язык (сценарий) |

|---|---|

| арабско-арабский | Арабский |

| кот-Латн | Каталонский |

| ckb-арабский | Сорани |

| фас-араб | Фарси (персидско-арабский) |

| фра-Латн | Французский |

| фра-Латн-НП | французский † |

| mya-Mymr | Бирманский |

| Пор-Латн | Португальский |

«Пространства» языка

| Код | Язык | Примечание |

|---|---|---|

| amh-Ethi | Амхарский | |

| деу-Латн | Немецкий | |

| англ. Лат. | Английский | |

| nld-Latn | Голландский | |

| СПА-Латн | Испанский | |

| тур-Латн | Турецкий | На основе данных с добавленными суффиксами |

| тур-Латн-носуф | Турецкий | На основе данных с удаленными суффиксами |

| узб-латн-суф | Узбекский | На основе данных с добавленными суффиксами |

Обратите внимание, что основные языки, включая французский , отсутствуют в этой таблице из-за отсутствия соответствующих текстовых данных.

Установка Flite (для англ. G2P)

Для использования с большинством языков Epitran не требует специальных действий по установке. Его можно установить как обычный пакет python, либо с pip , либо путем запуска python setup.py install в корне исходного каталога. Однако английский G2P в Epitran полагается на CMU Flite, пакет синтеза речи, разработанный Аланом Блэком и другими исследователями речи из Университета Карнеги-Меллона. Для текущей версии Epitran вы должны следовать инструкциям по установке для lex_lookup , который используется в качестве интерфейса G2P по умолчанию для Epitran.

t2p Не рекомендуется

Модуль epitran.flite дополняет систему синтеза речи flite для выполнения английского языка G2P. Для работы этого модуля необходимо установить Flite. Бинарный файл t2p из flite не установлен по умолчанию и должен быть вручную скопирован в путь. Ниже приводится иллюстрация того, как это можно сделать в Unix-подобной системе. Обратите внимание, что требуется GNU gmake и что, если у вас установлен еще один make , вам, возможно, придется явно вызвать gmake :

$ tar xjf flite-2.0.0-release.tar.bz2 $ cd flite-2.0.0-релиз / $ ./configure && make $ sudo make install $ sudo cp bin / t2p / usr / местный / bin

Вам следует адаптировать эти инструкции к местным условиям. Установка в Windows проще всего при использовании Cygwin. Вам придется по своему усмотрению решить, где разместить t2p.exe в Windows, поскольку это может зависеть от ваших настроек python. Другие платформы, вероятно, работают, но не тестировались.

lex_lookup Рекомендуемая

t2p не работает должным образом с последовательностями букв, которые в английском языке встречаются очень редко. В таких случаях

В таких случаях t2p дает произношение английских букв имени, а не попытку произношения имени. В самые последние (предварительные) версии Flite включен другой двоичный файл, который в этом отношении ведет себя лучше, но требует дополнительных усилий для установки. Для установки вам необходимо получить Flite как минимум версии 2.0.5. Мы рекомендуем вам получить исходный код на GitHub (https://github.com/festvox/flite). Разверните и скомпилируйте исходный код, выполнив следующие шаги, при необходимости изменив настройки для вашей системы:

$ tar xjf flite-2.0.5-current.tar.bz2 $ cd flite-2.0.5-ток

или

$ git clone [email protected]: festvox / flite.git $ cd flite /

, затем

$ ./конфигурировать && сделать $ sudo make install $ cd testsuite $ make lex_lookup $ sudo cp lex_lookup / usr / местный / bin

При установке в MacOS и других системах, использующих версию BSD cp , необходимо внести некоторые изменения в Makefile, чтобы установить flite-2.0.5 (между шагами 3 и 4). Отредактируйте main / Makefile и измените оба экземпляра cp -pd на cp -pR .Затем вернитесь к шагу 4, описанному выше.

Использование

Чтобы использовать lex_lookup , просто создайте экземпляр Epitran как обычно, но с кодом , установленным на ‘eng-Latn’:

>>> импортный эпитран

>>> epi = epitran.Epitran ('англ-латн')

>>> выведите epi.transliterate (u'Berkeley ')

Bkli

Расширение Epitran с помощью файлов карт, препроцессоров и постпроцессоров

Языковая поддержка в Epitran обеспечивается через файлы карт, которые определяют сопоставления между орфографическими и фонетическими единицами, препроцессоры, которые запускаются до применения карты, и постпроцессоры, которые запускаются после применения карты.Карты определяются в файлах значений с разделителями-запятыми (CSV) в кодировке UTF8. Каждый файл имеет имена , где  csv

csv — это (трехбуквенный, все строчные буквы) код ISO 639-3 для языка, а — (четырехбуквенный , заглавные буквы) Код ISO 15924 для скрипта. Эти файлы находятся в каталоге data установки Epitran в подкаталогах map , pre и post соответственно.Файлы пре- и постпроцессора представляют собой текстовые файлы, формат которых описан ниже. Они следуют тем же соглашениям об именах, за исключением того, что у них есть расширения файлов .txt .

Файлы карт (таблицы сопоставления)

Файлы карты представляют собой простые файлы с двумя столбцами, в которых первый столбец содержит ортографические символы / последовательности, а второй столбец содержит фонетические символы / последовательности. Два столбца разделены запятой; каждая строка заканчивается новой строкой. Для многих языков (большинства языков с однозначной, фонематически адекватной орфографией) этого простого в создании файла сопоставления достаточно для создания работоспособной системы G2P.

Первая строка является заголовком и отбрасывается. Для единообразия он должен содержать поля «Орт» и «Фон». Следующие строки состоят из полей любой длины, разделенных запятыми. Одна и та же фонетическая форма (второе поле) может встречаться любое количество раз, но орфографическая форма может встречаться только один раз. Если одна орфографическая форма является префиксом другой формы, более длинная форма имеет приоритет при отображении. Другими словами, соответствие между орфографическими единицами и орфографическими строками является жадным.Отображение работает путем нахождения самого длинного префикса орфографической формы и добавления соответствующей фонетической строки в конец фонетической формы, затем удаления префикса из орфографической формы и продолжения таким же образом до тех пор, пока орфографическая форма не будет использована. Если в таблице сопоставления нет непустого префикса орфографической формы, первый символ орфографической формы удаляется и добавляется к фонетической форме. Затем возобновляется нормальная последовательность действий. Это означает, что нефонетические символы могут оказаться в «фонетической» форме, что, по нашему мнению, лучше, чем потеря информации из-за неадекватной таблицы сопоставления.

Затем возобновляется нормальная последовательность действий. Это означает, что нефонетические символы могут оказаться в «фонетической» форме, что, по нашему мнению, лучше, чем потеря информации из-за неадекватной таблицы сопоставления.

Препроцессоры и постпроцессоры

Для пар язык-сценарий с более сложной орфографией иногда необходимо изменить орфографическую форму до сопоставления или изменить фонетическую форму после сопоставления. В Epitran это делается с помощью грамматик контекстно-зависимых правил перезаписи строк. По правде говоря, этих правил было бы более чем достаточно для решения проблемы сопоставления, но с практической точки зрения обычно легче позволить простым для понимания и легким в обслуживании файлам сопоставления нести большую часть веса преобразования и резервирования. более мощный контекстно-зависимый грамматический формализм для предварительной и последующей обработки.

Файлы препроцессора и постпроцессора имеют одинаковый формат. Они состоят из последовательности строк, каждая из четырех типов:

- Определения символов

- Контекстно-зависимые правила перезаписи

- Комментарии

- Пустые строки

Определения символов

Строки, похожие на следующие

:: гласные :: = a | e | i | o | u

определяют символы, которые можно повторно использовать при написании правил. Символы должны состоять из префикса из двух двоеточий, последовательности из одной или нескольких строчных букв и знаков подчеркивания и суффикса из двух двоеточий.Они отделены от своих определений знаком равенства (при желании можно выделить пробелом). Определение состоит из подстроки регулярного выражения.

Символы должны быть определены до того, как на них будут ссылаться.

Правила перезаписи

Контекстно-зависимые правила перезаписи в Epitran записываются в формате, знакомом фонологам, но прозрачном для компьютерных ученых. Их можно схематически обозначить как

.

a -> b / X _ Y

, который можно переписать как

XaY → XbY

Стрелка -> может читаться как «перезаписывается как», а косая черта / может читаться как «в контексте».Нижнее подчеркивание указывает позицию перезаписываемого символа (ов). Другой специальный символ — octothorp # , который указывает начало или конец строки (длиной слова) (граница слова). Учтите следующее правило:

e -> ə / _ #

Это правило можно прочитать как «/ e / переписывается как / ə / в контексте в конце слова». Последний специальный символ — ноль 0 , который представляет собой пустую строку. Он используется в правилах, которые вставляют или удаляют сегменты.Рассмотрим следующее правило, которое удаляет / ə / между / k / и / l /:

ə -> 0 / k _ l

Все правила должны включать оператор стрелки, оператор косой черты и знак подчеркивания. Правило, которое применяется вне контекста, может быть записано следующим образом:

ch -> x / _