Слова «мавзолей» морфологический и фонетический разбор

Объяснение правил деление (разбивки) слова «мавзолей» на слоги для переноса.

Онлайн словарь Soosle.ru поможет: фонетический и морфологический разобрать слово «мавзолей» по составу, правильно делить на слоги по провилам русского языка, выделить части слова, поставить ударение, укажет значение, синонимы, антонимы и сочетаемость к слову «мавзолей».

Содержимое:

- 1 Слоги в слове «мавзолей» деление на слоги

- 2 Как перенести слово «мавзолей»

- 3 Морфологический разбор слова «мавзолей»

- 4 Разбор слова «мавзолей» по составу

- 5 Сходные по морфемному строению слова «мавзолей»

- 6 Синонимы слова «мавзолей»

- 7 Ударение в слове «мавзолей»

- 8 Фонетическая транскрипция слова «мавзолей»

- 9 Фонетический разбор слова «мавзолей» на буквы и звуки (Звуко-буквенный)

- 10 Предложения со словом «мавзолей»

- 11 Сочетаемость слова «мавзолей»

- 12 Значение слова «мавзолей»

- 13 Склонение слова «мавзолей» по подежам

- 14 Как правильно пишется слово «мавзолей»

- 15 Ассоциации к слову «мавзолей»

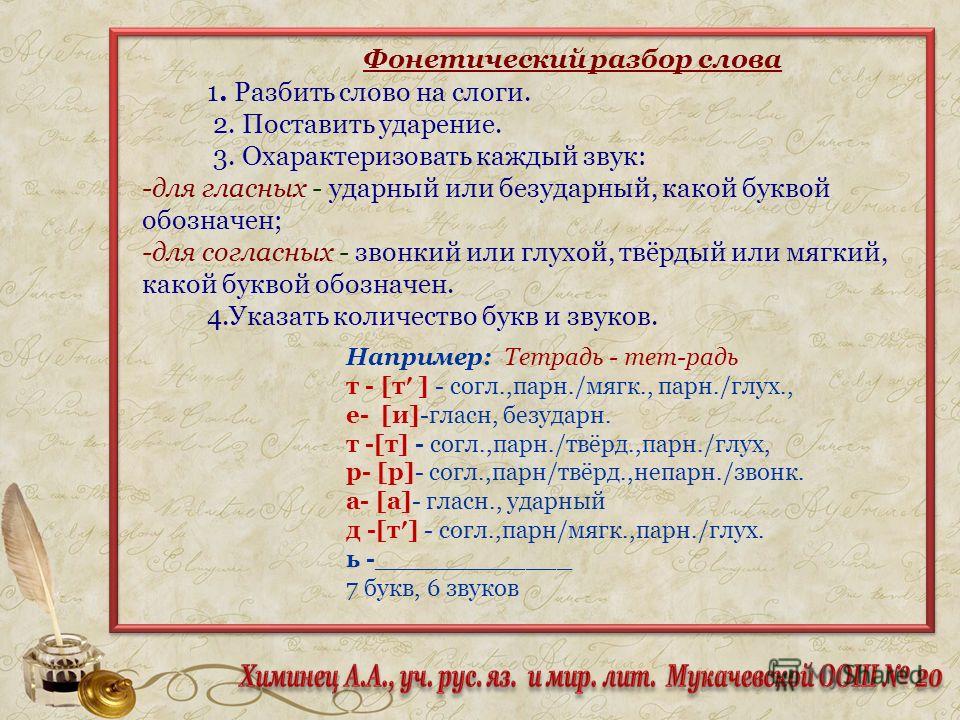

Слоги в слове «мавзолей» деление на слоги

Количество слогов: 3

По слогам: ма-взо-лей

По правилам школьной программы слово «мавзолей» можно поделить на слоги разными способами. Допускается вариативность, то есть все варианты правильные. Например, такой:

Допускается вариативность, то есть все варианты правильные. Например, такой:

мав-зо-лей

По программе института слоги выделяются на основе восходящей звучности:

ма-взо-лей

Ниже перечислены виды слогов и объяснено деление с учётом программы института и школ с углублённым изучением русского языка.

в примыкает к этому слогу, а не к предыдущему, так как не является сонорной (непарной звонкой согласной)

Как перенести слово «мавзолей»

ма—взолей

мав—золей

мавзо—лей

Морфологический разбор слова «мавзолей»

Часть речи:

Имя существительное

Грамматика:

часть речи: имя существительное;

одушевлённость: неодушевлённое;

род: мужской;

число: единственное;

падеж: именительный, винительный;

отвечает на вопрос: (есть) Что?, (вижу/виню) Что?

Начальная форма:

мавзолей

Разбор слова «мавзолей» по составу

| мавзолей | корень |

| ø | нулевое окончание |

мавзолей

Сходные по морфемному строению слова «мавзолей»

Сходные по морфемному строению слова

Синонимы слова «мавзолей»

1. дагоба

дагоба

2. тадж-махал

3. мазар

Ударение в слове «мавзолей»

мавзоле́й — ударение падает на 3-й слог

Фонетическая транскрипция слова «мавзолей»

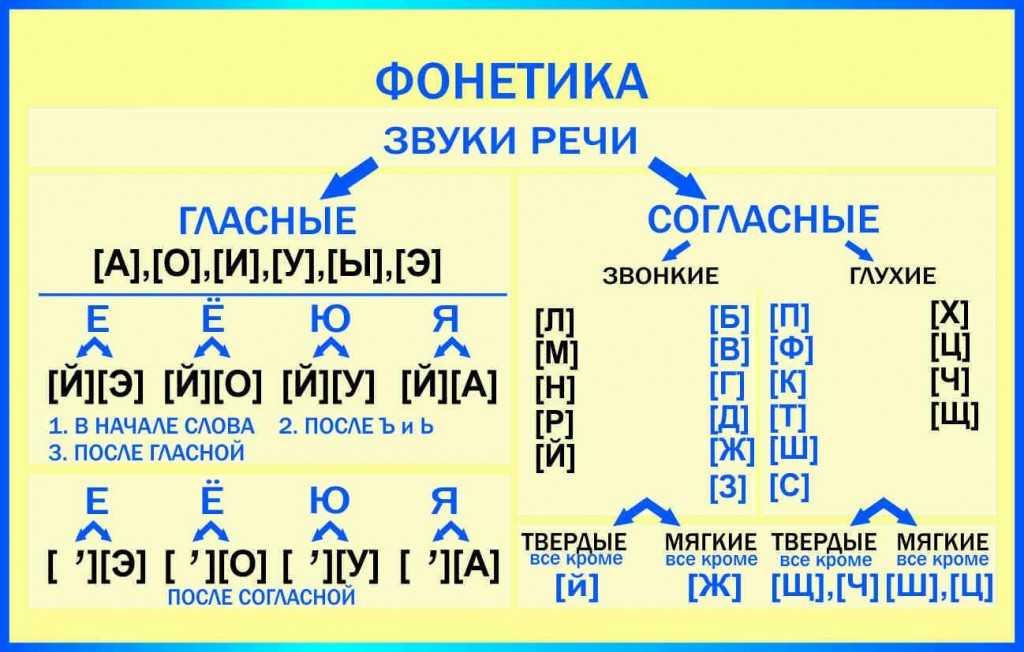

[мавзал’`эй’]

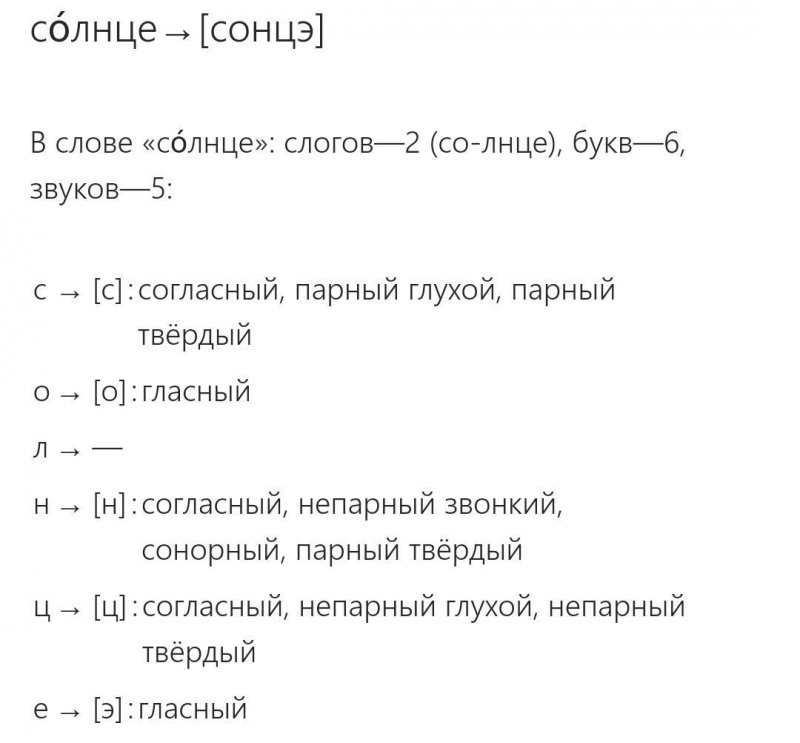

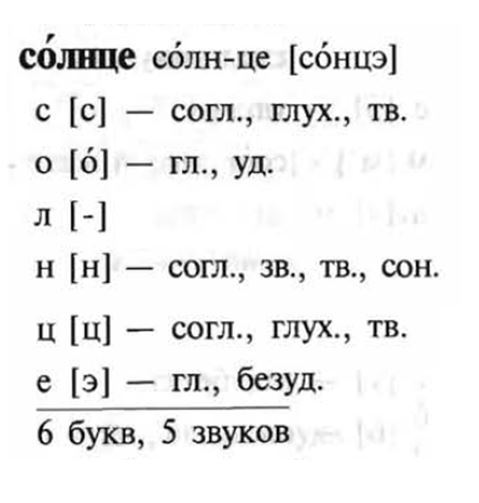

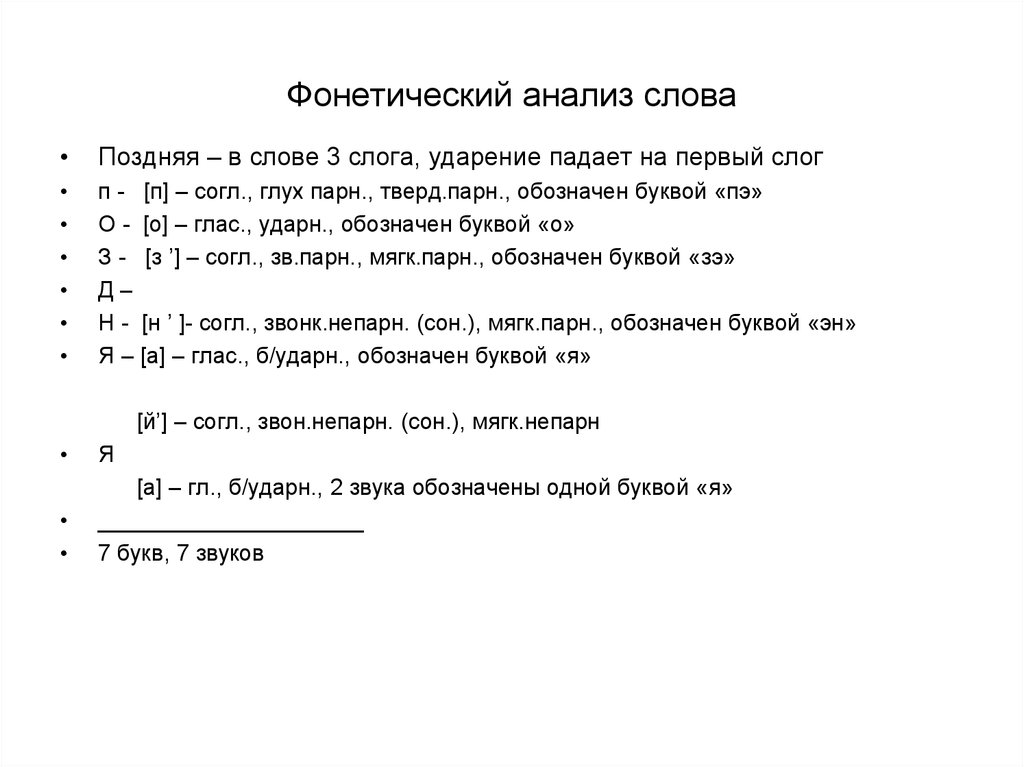

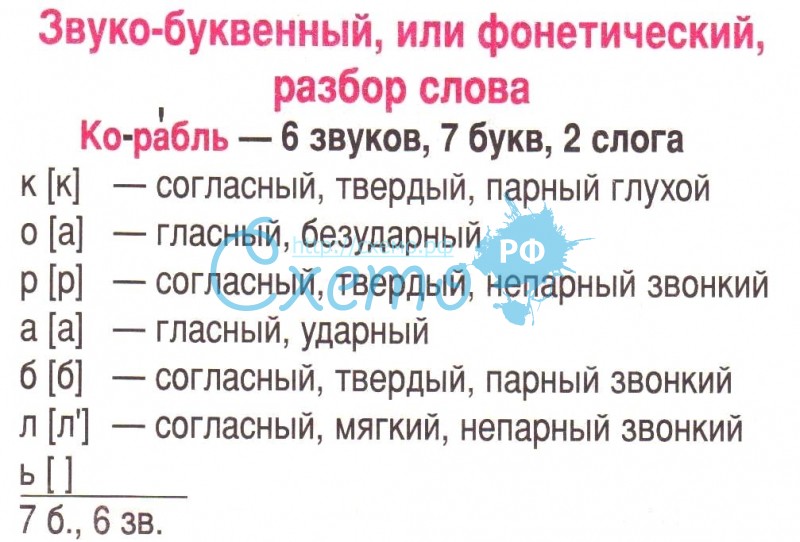

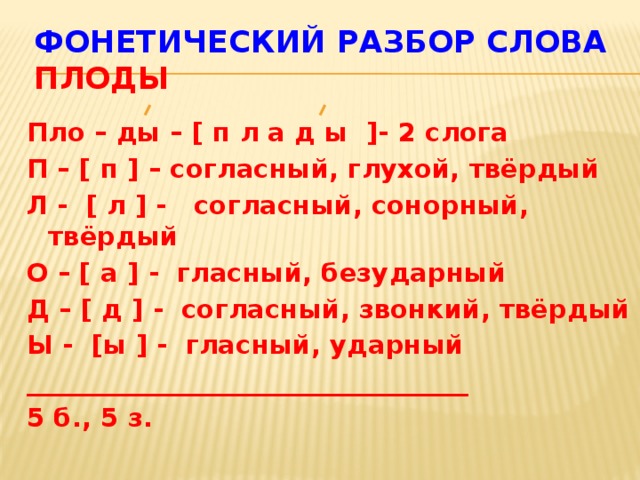

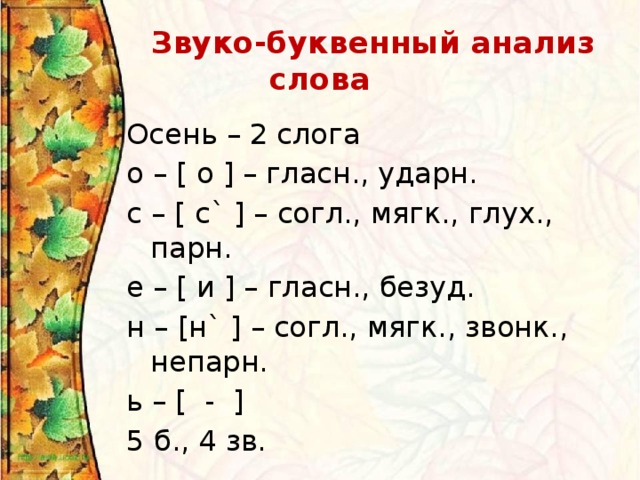

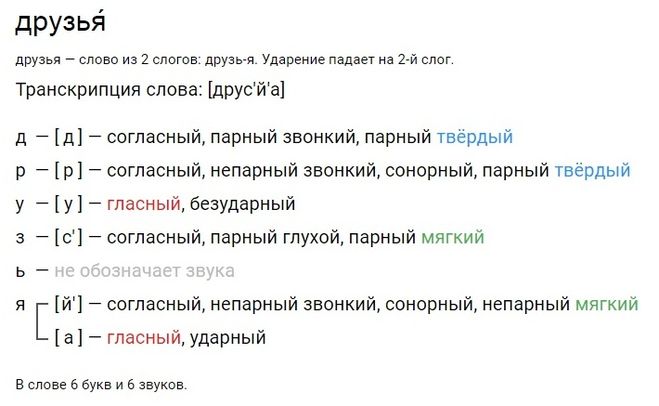

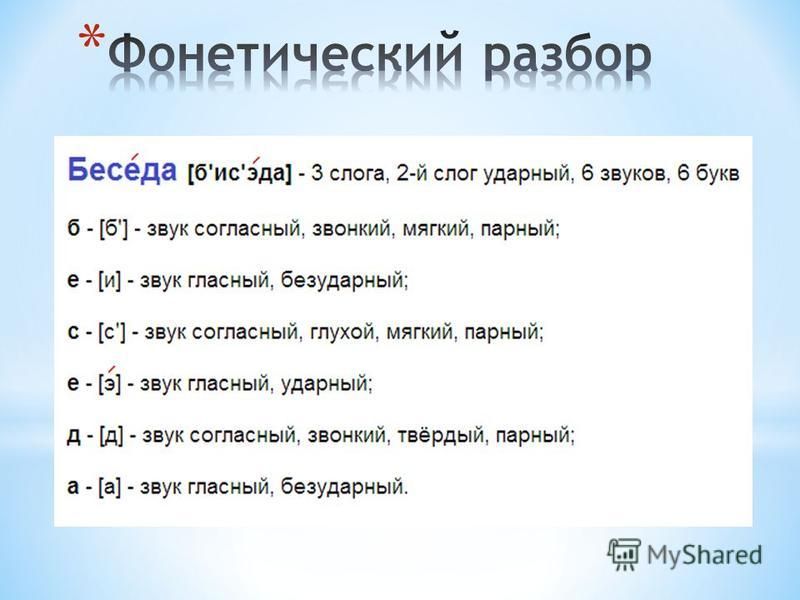

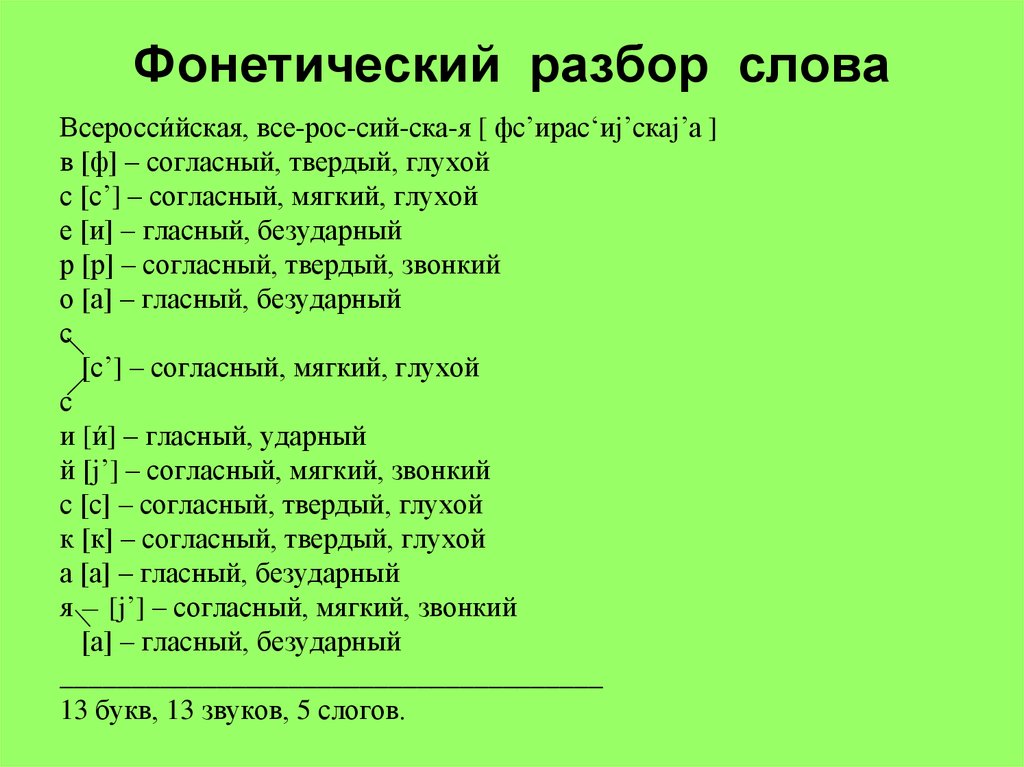

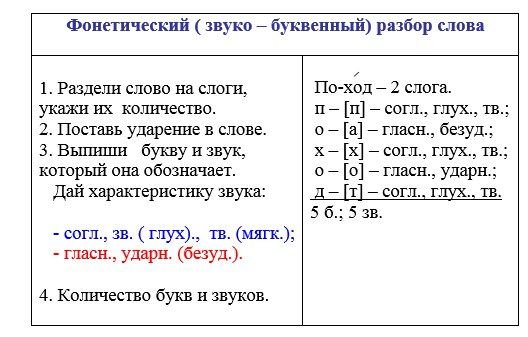

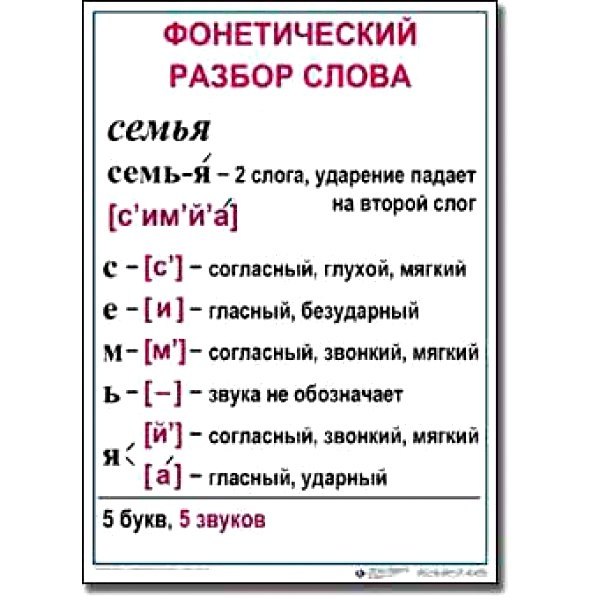

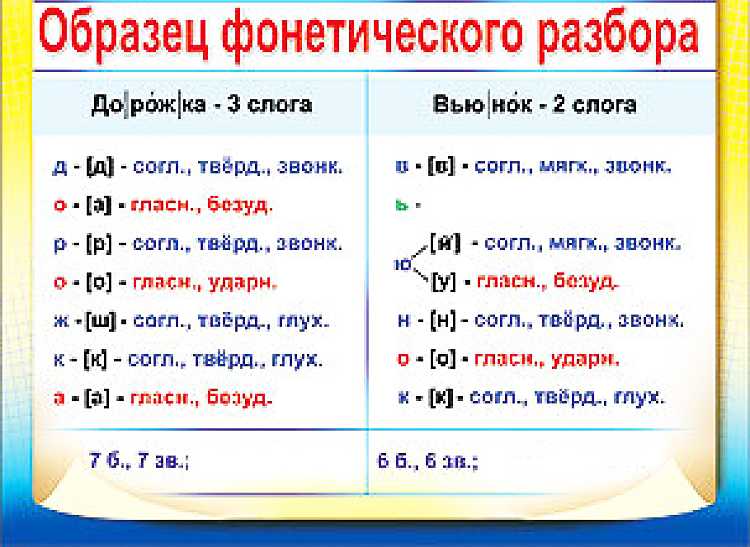

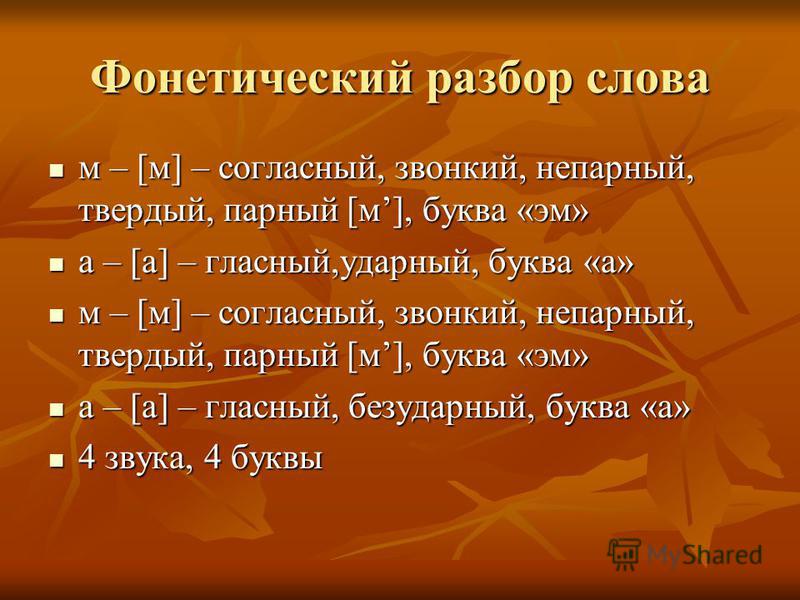

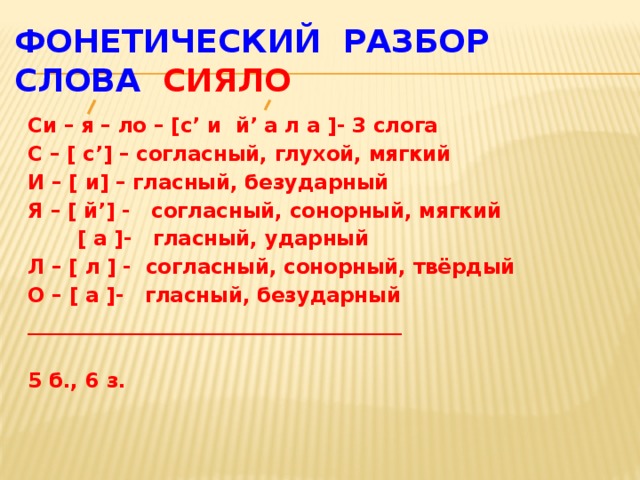

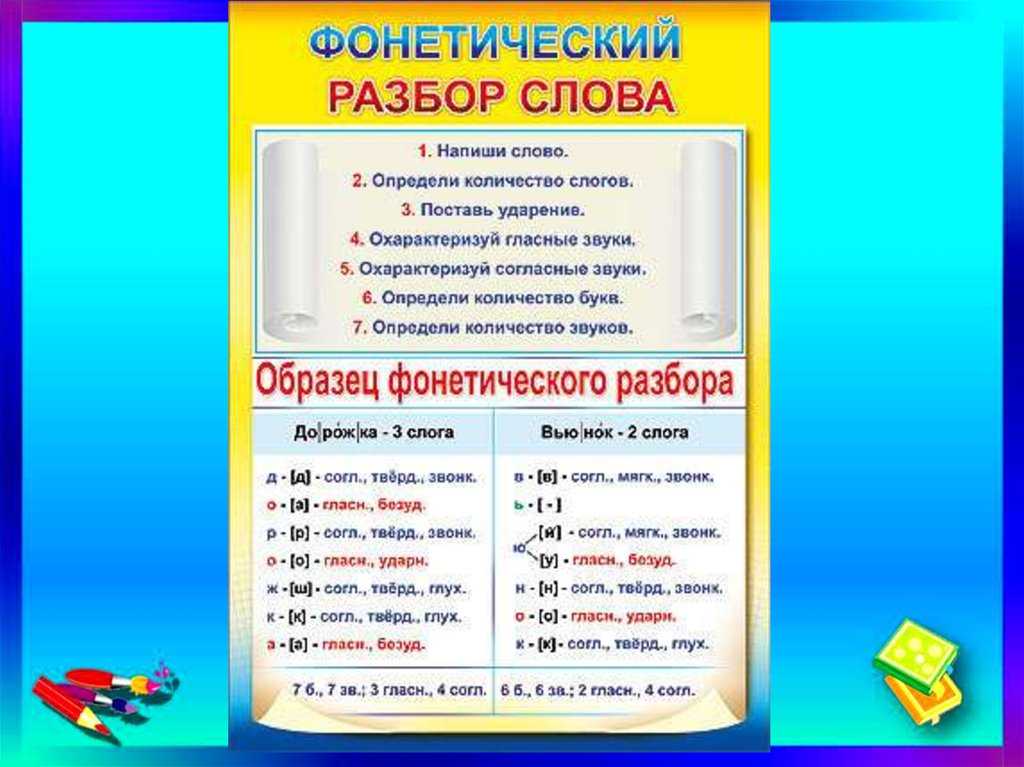

Фонетический разбор слова «мавзолей» на буквы и звуки (Звуко-буквенный)

| Буква | Звук | Характеристики звука | Цвет |

|---|---|---|---|

| М | [м] | согласный, звонкий непарный (сонорный), твёрдый | М |

| а | [а] | гласный, безударный | а |

| в | [в] | согласный, звонкий парный, твёрдый, шумный | в |

| з | [з] | согласный, звонкий парный, твёрдый, шумный | з |

| о | [а] | гласный, безударный | о |

| л | [л’] | согласный, звонкий непарный (сонорный), мягкий | л |

| е | [`э] | гласный, ударный | е |

| й | [й’] | согласный, звонкий непарный (сонорный), мягкий | й |

Число букв и звуков:

На основе сделанного разбора делаем вывод, что в слове 8 букв и 8 звуков.

Буквы: 3 гласных буквы, 5 согласных букв.

Звуки: 3 гласных звука, 5 согласных звуков.

Предложения со словом «мавзолей»

Впрочем, ленинский мавзолей в XX веке — не единственное сооружение явно мистического толка.

Источник: И. С. Прокопенко, Тайны древних цивилизаций, 2015.

Гулькин, который связывал с конём большие надежды, был в расстройстве и построил мавзолей на холме, возвышавшемся аккурат за его курятником.

Источник: Кир Булычев, Жизнь за трицератопса, 2001.

Пропускаю его, сижу на лавочке, прижавшись к мраморной стене мавзолея метро.

Источник: Улья Нова, Птицы города.

Сочетаемость слова «мавзолей»

1. огромный мавзолей

2. величественный мавзолей

величественный мавзолей

3. небольшой мавзолей

4. в мавзолее августа

5. на трибуне мавзолея

6. к подножию мавзолея

7. в сторону мавзолея

8. лежать в мавзолее

9. стоять на мавзолее

10. подойти к мавзолею

11. (полная таблица сочетаемости)

Значение слова «мавзолей»

МАВЗОЛЕ́Й , -я, м. Большое надгробное архитектурное сооружение. (Малый академический словарь, МАС)

Склонение слова «мавзолей» по подежам

| Падеж | Вопрос | Единственное числоЕд.ч. | Множественное числоМн.ч. |

|---|---|---|---|

| ИменительныйИм. | мавзолей | мавзолеи | |

| РодительныйРод. | чего? | мавзолея | мавзолеев |

| ДательныйДат. | чему? | мавзолею | мавзолеям |

| ВинительныйВин. | что? | мавзолей | мавзолеи |

ТворительныйТв. | чем? | мавзолеем | мавзолеями |

| ПредложныйПред. | о чём? | мавзолее | мавзолеях |

Как правильно пишется слово «мавзолей»

Правописание слова «мавзолей»

Орфография слова «мавзолей»

Правильно слово пишется: мавзоле́й

Нумерация букв в слове

Номера букв в слове «мавзолей» в прямом и обратном порядке:

- 8

м

1 - 7

а

2 - 6

в

3 - 5

з

4 - 4

о

5 - 3

л

6 - 2

е

7 - 1

й

8

Ассоциации к слову «мавзолей»

Усыпальница

Мечеть

Трибун

Саркофаг

Имам

Гробница

Парад

Надгробие

Склеп

Мао

Сталина

Захоронение

Мумия

Трибуна

Шейх

Кремль

Ахмед

Галл

Адриана

Урна

Мухаммад

Погребение

Брежнев

Хрущев

Портик

Паломничество

Караул

Махмуд

Мемориал

Штандарт

Мрамор

Памятник

Тимур

Монумент

Останки

Гранит

Гранита

Политбюро

Кладбище

Прах

Могила

Ташкент

Архитектура

Султана

Клеопатра

Виссарион

Сооружение

Возведение

Купол

Акбар

Барельеф

Шах

Красная

Сталин

Ансамбль

Святыня

Храмов

Мозаика

Мухаммед

Годовщина

Площадь

Городище

Пирамида

Гроб

Эмир

Нерон

Демонстрация

Берия

Абу

- Ленин

Надгробный

Архитектурный

Монументальный

Ленинский

Мемориальный

Гранитный

Мраморный

Фамильный

Могильный

Казахский

Скульптурный

Траурный

Мусульманский

Культовый

Погребальный

Величественный

Усопший

Исламский

Трудящийся

Воздвигнуть

Погрести

Похоронить

Покоиться

Возвести

Соорудить

Спроектировать

Построить

Выстроить

Перестроить

Замуровать

леев Определение и значение | Dictionary.

com

com- Основные определения

- Викторина

- Связанный контент

- Примеры

- Британский

Показывает уровень оценки в зависимости от сложности слова.

1

[ лей, лей-ее ]

/ leɪ, ˈleɪ i /

Сохранить это слово!

См. синонимы слова lei на сайте Thesaurus.com

Показывает уровень обучения в зависимости от сложности слова.

существительное во множественном числе leis.

(на Гавайских островах) венок из цветов, листьев и т. д. на шею или голову.

ТЕСТ

МОЖЕТЕ ЛИ ВЫ ОТВЕЧАТЬ НА ЭТИ ОБЫЧНЫЕ ГРАММАТИЧЕСКИЕ СПОРЫ?

Есть грамматические дебаты, которые никогда не умирают; и те, которые выделены в вопросах этой викторины, наверняка снова всех разозлят. Знаете ли вы, как отвечать на вопросы, которые вызывают самые ожесточенные споры по грамматике?

Знаете ли вы, как отвечать на вопросы, которые вызывают самые ожесточенные споры по грамматике?

Вопрос 1 из 7

Какое предложение верно?

Происхождение LEI

1

Заимствовано на английском языке у Hawaiian около 1835–45

Слова поблизости Lei

Lehman, Lehmann, Lehmbruck, Lehr, Lehua, Leibnis, Leibnis, Leibnis, Leibnis, Leibnis, Leibnis, Leibnis, lehman’s, lehman’s, lehman’s, lehmann, lehman Горы Лейбница

Другие определения для lei (2 из 2)

lei 2

[ ley ]

/ leɪ /

существительное

.

Dictionary.com Полный текст На основе Random House Unabridged Dictionary, © Random House, Inc., 2023 г.

Слова, связанные со словом lei

гирлянда, горшок, ваза, венок, букет, бутоньерка, бутоньерка, корсаж, гирлянда, букет цветов, букет, спрей, лента, залив, венка, венец, корона, корона, корона, лавр

Как использовать лей в предложении

Лэй Хуачжэнь — красивая женщина и необычно высокая для жительницы Сычуани.

Устная история о величайшем преступлении Мао|Чжоу Сюнь|24 ноября 2013 г.|DAILY BEAST

«Заинтересованные СМИ знают в глубине души, что они сделали неправильно», – объяснил позже официальный представитель министерства иностранных дел Китая Хун Лэй.

Твои рождественские подарки сделаны в китайском ГУЛАГе?|Дэн Левин|27 декабря 2012|DAILY BEAST

Если бы не политические аспекты, разоблачение Лэя вряд ли можно было бы назвать самым заметным из китайских сексуальных скандалов.

Секс-видео Лэй Чжэнфу: Китай загипнотизирован некогда табуированными темами политики и порно|Мелинда Лю|28 ноября 2012 г.|DAILY BEAST любовница и его брат.

Секс-видео Лэй Чжэнфу: Китай загипнотизирован некогда табуированными темами политики и порно|Мелинда Лю|28 ноября 2012 г.|DAILY BEAST

рациональным и законным путем».

Китай тоже протестует|Мелинда Лю|17 сентября 2012 г.|DAILY BEAST

Sumar lei af, ok frtti rhallr ekki til sauamanns, ok engi kunni skyn honum.

Беовульф|Р. В. Чемберс

Heyru menn til sauamanns ndveran daginn, en mir er lei daginn.

Беовульф|Р. W. Чемберс

Tk at fjka, ok geri hr um kveldit; kmu menn til ta, ok lei sv fram at dagsetri; eigi kom Glmr heim.

Беовульф|Р. В. Чемберс

Но ее фотография не стоила и пяти леев, как вы сами видите.

Новые границы свободы от Альп до Геана|Эдвард Александр Пауэлл

«A Lei non posso dar un rifiuto», сказал он, встретившись с ее сияющими глазами; и он серьезно собрал деньги и бросил свой поднос.

Atlantic Monthly, Volume 14, No. 84, October, 1864|Various

British Dictionary definitions for lei (1 of 2)

lei 1

/ (leɪ) /

noun

(на Гавайях) гирлянда цветов, которую носят на шее

сущ.

множественное число от leu

Collins English Dictionary — Complete & Unabridged 2012 Digital Edition

© William Collins Sons & Co. Ltd., 1979, 1986 © HarperCollins

Publishers 1998, 2000, 2003, 2005, 2006, 2007, 2009, 2012

Ltd., 1979, 1986 © HarperCollins

Publishers 1998, 2000, 2003, 2005, 2006, 2007, 2009, 2012

Эволюция токенизации в НЛП — Парное кодирование байтов в НЛП | by Harshit Tyagi

Image by AuthorНЛП, возможно, немного опоздал к прозрению ИИ, но он творит чудеса с такими организациями, как Google, OpenAI, выпускающими современные языковые модели (SOTA), такие как BERT и GPT-2/ 3 соответственно.

GitHub Copilot и OpenAI codex — одни из немногих очень популярных приложений, о которых говорят в новостях. Как человек, который очень мало знаком с НЛП, я решил заняться НЛП в качестве области исследований, и в следующих нескольких блогах/видео я буду делиться тем, что узнаю после анализа некоторых важных компонентов НЛП.

Системы НЛП состоят из трех основных компонентов, которые помогают машинам понимать естественный язык:

- Токенизация

- Встраивание

- Архитектуры моделей

Лучшие модели глубокого обучения, такие как BERT, GPT-2 или GPT-3, используют одни и те же компоненты, но имеют разные архитектуры, которые отличают одну модель от другой.

В этом информационном бюллетене (и записной книжке) мы сосредоточимся на основах первого компонента конвейера NLP, который представляет собой токенизацию . Концепция, которую часто упускают из виду, но сама по себе является областью исследований. Мы далеко опередили традиционный процесс токенизации NLTK.

Хотя у нас есть алгоритмы SOTA для токенизации, всегда полезно понять путь эволюции и узнать, как мы достигли этого.

Итак, вот что мы рассмотрим:

- Что такое токенизация?

- Зачем нам токенизатор?

- Типы токенизации — Слово, Символ и Подслово.

- Алгоритм кодирования пары байтов — версия, которая в наши дни используется в большинстве моделей НЛП.

Следующая часть этого руководства посвящена более продвинутым (или расширенной версии BPE) алгоритмам:

- Алгоритм Unigram

- WordPiece — преобразователь BERT

- SentencePiece — Сквозная система токенизатора

Токенизация — это процесс представления необработанного текста в более мелких единицах, называемых токенами. Затем эти токены можно сопоставить с числами для дальнейшего использования в модели НЛП.

Затем эти токены можно сопоставить с числами для дальнейшего использования в модели НЛП.

Вот чрезмерно упрощенный пример того, что делает токенизатор:

Изображение автораЗдесь мы просто сопоставили каждое слово в тексте с числовым индексом. Очевидно, что это очень простой пример, и мы не рассматривали грамматику, пунктуацию, сложные слова (такие как test, test-ify, test-ing и т. д.).

Таким образом, нам нужно более техническое и точное определение токенизации. Чтобы учесть каждую пунктуацию и связанное с ней слово, нам нужно начать работать на уровне символов.

Существует несколько приложений токенизации. Один из вариантов использования исходит из конструкции компилятора, где нам нужно анализировать компьютерные программы для преобразования необработанных символов в ключевые слова языка программирования.

В глубоком обучении токенизация — это процесс преобразования последовательности символов в последовательность токенов, которые затем необходимо преобразовать в последовательность числовых векторов, которые могут быть обработаны нейронной сетью.

Необходимость в токенизаторе возникла из вопроса «Как заставить машины читать?»

Image by AuthorОдним из распространенных способов обработки текстовых данных является определение набора правил в словаре и последующий поиск этого фиксированного словаря правил. Но этот метод может зайти так далеко, и мы хотим, чтобы машины учились этим правилам из текста, который она читает.

Машины не знают ни языка, ни звуков, ни фонетики. Их нужно учить с нуля и таким образом, чтобы они могли читать на любом возможном языке.

Неплохая задача, правда?

Люди изучают язык, связывая звук со значением, а затем мы учимся читать и писать на этом языке. Машины не могут этого сделать, поэтому им нужно предоставить самые основные единицы текста, чтобы начать его обрабатывать.

Вот где токенизация вступает в игру. Разбейте текст на более мелкие единицы, называемые «токенами».

Существуют разные способы токенизации текста, о чем мы сейчас и узнаем.

Чтобы заставить модель глубокого обучения учиться на основе текста, нам нужен двухэтапный процесс:

Image by Author- Tokenize — определите алгоритм, который будет использоваться для генерации токенов.

- Кодировать токены в векторы

Как следует из первого шага, нам нужно решить, как преобразовать текст в маленькие токены. Простой и прямой метод, который предложило бы большинство из нас, — это токены на основе слов, разбивающие текст по пробелам.

- риск пропуска слов в обучающих данных: с токенами слов ваша модель не будет распознавать варианты слов, которые не были частью данных, на которых обучалась модель. Итак, если ваша модель видела

footandballin the training data but the final text hasfootball, the model won’t be able to recognize the word and it will be treated withпустьилипустьпотребуют отдельных токенов, и это неэффективное решение. Это потребует огромного словарного запаса , чтобы убедиться, что у вас есть все варианты слова. Даже если вы добавите лемматизатор , чтобы решить эту проблему, вы добавляете дополнительный шаг в конвейер обработки.

- Работа со сленгом и аббревиатурами. Другой проблемой является использование сленга и аббревиатур в текстах в наши дни, таких как «FOMO», «LOL», «tl;dr» и т. д. Что мы делаем с этими словами?

- Что делать, если язык не использует пробел для сегментации: для такого языка, как китайский, который не использует пробелы для разделения слов, этот токенизатор полностью выйдет из строя.

Столкнувшись с этими проблемами, исследователи изучили другой подход, заключающийся в токенизации всех символов.

Для решения проблем, связанных с токенизацией на основе слов, был опробован альтернативный подход посимвольной токенизации.

Это действительно решило проблему пропущенных слов, поскольку теперь мы имеем дело с символами, которые можно закодировать с помощью ASCII или Unicode, и теперь он может генерировать встраивание для любого слова.

Каждому символу, будь то пробел, апостроф или двоеточие, теперь можно назначить символ для создания последовательности векторов.

Но у этого подхода были свои минусы.

- Требование дополнительных вычислений: модели на основе символов будут обрабатывать каждый символ как токены, а большее количество токенов означает больше входных вычислений для обработки каждого токена, что, в свою очередь, требует больше вычислительных ресурсов. Для длинного предложения из 5 слов вам может потребоваться обработать 30 токенов вместо 5 токенов на основе слов.

- Сокращает количество задач и приложений НЛП: с длинными последовательностями символов можно использовать только определенный тип архитектуры нейронной сети. Это накладывает ограничения на типы задач НЛП, которые мы можем выполнять. Для таких приложений, как распознавание сущностей или классификация текста, кодирование на основе символов может оказаться неэффективным подходом.

- Риск обучения неправильной семантике: работа с символами может привести к неправильному написанию слов.

Кроме того, без внутреннего смысла обучение с помощью символов похоже на обучение без осмысленной семантики.

Кроме того, без внутреннего смысла обучение с помощью символов похоже на обучение без осмысленной семантики.

Удивительно, что для такой, казалось бы, простой задачи написано несколько алгоритмов для поиска оптимальной политики токенизации.

После понимания плюсов и минусов этих методов токенизации имеет смысл искать подход, который предлагает средний путь, то есть сохранить семантику с ограниченным словарным запасом, который может генерировать все слова в тексте при слиянии.

С символьными моделями мы рискуем потерять семантические свойства слова, а с токенизацией на основе слов нам нужен очень большой словарь, чтобы охватить все возможные варианты каждого слова.

Итак, цель состояла в том, чтобы разработать алгоритм, который мог бы:

- Сохранять семантические характеристики токена, т.е. информацию для каждого токена.

- токенизировать, не требуя очень большого словаря с конечным набором слов.

Чтобы решить эту проблему, мы могли бы разбить слова на набор префиксов и суффиксов. Например, мы можем написать систему, основанную на правилах, для определения таких подслов, как 9.0272 «##s» , "##ing" , "##ify" , "un##" и т. д., где позиция двойного хэша обозначает префикс и суффикс.

Таким образом, такое слово, как «несчастливо» , токенизировано с помощью подслов, таких как «un##» , «счастливый» и «##ily» .

Модель запоминает только несколько подслов, а затем объединяет их для создания других слов. Это решает проблему потребности в памяти и усилий для создания большого словарного запаса.

- Некоторые подслова, созданные в соответствии с определенными правилами, могут никогда не появиться в вашем тексте для токенизации и в конечном итоге могут занять дополнительную память.

- Кроме того, для каждого языка нам потребуется определить свой набор правил для создания подслов.

Чтобы облегчить эту проблему, на практике большинство современных токенизаторов имеют этап обучения, который идентифицирует повторяющийся текст во входном корпусе и создает новые токены подслов. Для редких паттернов мы придерживаемся токенов на основе слов.

Другим важным фактором, играющим жизненно важную роль в этом процессе, является размер словаря, установленного пользователем. Large vocabulary size allows for more common words to be tokenized whereas smaller vocabulary requires more subwords to be created to create every word in the text without using the token.

Ключевым моментом здесь является достижение баланса для вашего приложения.

Первоначально BPE был алгоритмом сжатия данных, который использовался для поиска наилучшего способа представления данных путем определения общих пар байтов. Теперь он используется в НЛП для поиска наилучшего представления текста с использованием наименьшего количества токенов.

Вот как это работает:

- Добавьте идентификатор (

- Разбить слово на символы и затем вычислить частоту символов.

- Из токенов символов для предопределенного количества итераций подсчитайте частоту последовательных пар байтов и объедините наиболее часто встречающиеся пары байтов.

- Продолжайте итерацию, пока не достигнете предела итераций (установленного вами) или если вы не достигли предела токенов.

Давайте рассмотрим каждый шаг (в коде) для образца текста. Для написания этого кода я воспользовался очень минималистичным блогом Лей Мао о BPE. Я призываю вас проверить это!

Вот наш образец текста:

Изображение автора Изображение автораНа этом этапе лучше превратить структуру нашего кода в функции. Это потребует от нас выполнения следующих шагов:

- Найдите наиболее часто встречающиеся пары байтов в каждой итерации.

- Объединить эти токены.

- Пересчитайте частоту жетонов символов с добавлением новой парной кодировки.

- Продолжайте делать это до тех пор, пока не останется пара или вы не дойдете до конца цикла for.

Подробный код можно посмотреть в моем блокноте Colab .

Вот урезанный результат этих 4 шагов:

Изображение автораИтак, когда мы повторяем каждую лучшую пару, мы объединяем (объединяем) пару, и вы можете видеть, как мы пересчитываем частоту, исходная частота токена символа уменьшается. и новая частота парных токенов появляется в словаре токенов.

Если вы посмотрите на количество созданных токенов, то сначала оно увеличивается, потому что мы создаем новые пары, но после ряда итераций это число начинает уменьшаться.

Здесь мы начали с 25 токенов, дошли до 31 токена на 14-й итерации, а затем снизились до 16 токенов на 50-й итерации. Интересно, правда?

Алгоритм BPE является жадным алгоритмом, т. е. он пытается найти наилучшую пару на каждой итерации. И у этого жадного подхода есть некоторые ограничения.

Таким образом, у алгоритма BPE тоже есть плюсы и минусы.

Окончательные токены будут различаться в зависимости от количества выполненных вами итераций, что также вызывает другую проблему. Теперь у нас могут быть разные токены для одного текста и, следовательно, разные вложения.

Теперь у нас могут быть разные токены для одного текста и, следовательно, разные вложения.

Для решения этой проблемы было предложено несколько решений, но одним из наиболее примечательных была языковая модель униграмм, которая добавляла обучение регуляризации подслов (новый метод сегментации подслов), которое вычисляет вероятность для каждого токена подслова выбрать лучший вариант с использованием функция потерь. Подробнее об этом в следующих блогах.

Такие модели, как BERT или GPT-2, используют некоторую версию BPE или модель unigram для токенизации входного текста.

BERT включает новый алгоритм под названием WordPiece, который также похож на BPE, но имеет дополнительный уровень расчета правдоподобия, чтобы решить, будет ли объединенный токен окончательным.

Из этого блога вы узнали (если вообще узнали) о том, как машина начинает понимать язык, разбивая текст на очень маленькие части.

Существует много способов разбить текст на части, поэтому важно сравнить один подход с другим.

Мы начали с понимания токенизации путем разделения английского текста пробелами, но не все языки написаны одинаково (т. е. с использованием пробелов для обозначения сегментации), поэтому мы рассмотрели разделение по символам для создания токенов символов.

Проблема с символами заключалась в потере семантических характеристик токенов с риском создания неправильных представлений слов или вложений.

Чтобы получить лучшее из обоих миров, была введена маркировка подслов, которая была более многообещающей, а затем мы рассмотрели алгоритм BPE для реализации маркировки подслов.

Подробнее о следующих шагах и расширенных токенизаторах, таких как WordPiece, SentencePiece, и о том, как работать с токенизатором HuggingFace на следующей неделе.

Мой пост на самом деле является собранием следующих статей и блогов, которые я рекомендую вам прочитать:

- Нейронный машинный перевод редких слов с единицами подслов — Исследовательская статья, в которой обсуждаются различные методы сегментации, основанные на алгоритме сжатия BPE.

Кроме того, без внутреннего смысла обучение с помощью символов похоже на обучение без осмысленной семантики.

Кроме того, без внутреннего смысла обучение с помощью символов похоже на обучение без осмысленной семантики.