Плавное введение в Natural Language Processing (NLP)

Введение в NLP с Sentiment Analysis в текстовых данных.Люди общаются с помощью каких-либо форм языка и пользуются либо текстом, либо речью. Сейчас для взаимодействия компьютеров с людьми, компьютерам необходимо понимать естественный язык, на котором говорят люди. Natural language processing занимается как раз тем, чтобы научить компьютеры понимать, обрабатывать и пользоваться естественными языками.

В этой статье мы рассмотрим некоторые частые методики, применяющиеся в задачах NLP. И создадим простую модель сентимент-анализа на примере обзоров на фильмы, чтобы предсказать положительную или отрицательную оценку.

Что такое Natural Language Processing (NLP)?

NLP — одно из направлений искуственного интеллекта, которое работает с анализом, пониманем и генерацией живых языков, для того, чтобы взаимодействовать с компьютерами и устно, и письменно, используя естественные языки вместо компьютерных.

Применение NLP

- Machine translation (Google Translate)

- Natural language generation

- Поисковые системы

- Спам-фильтры

- Sentiment Analysis

- Чат-боты

… и так далее

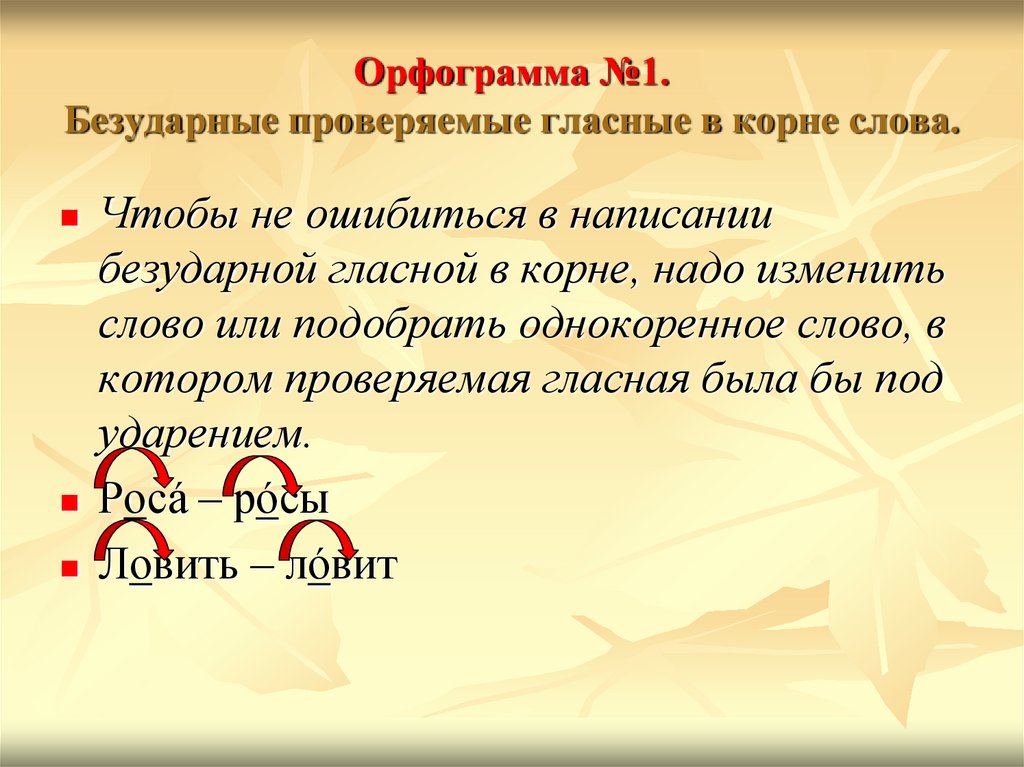

Очистка данных (Data Cleaning):

При Data Cleaning мы удаляем из исходных данных особые знаки, символы, пунктуацию, тэги html <> и т.п., которые не содержат никакой полезной для модели информации и только добавляют шум в данные.

Что удалять из исходных данных, а что нет зависит от постановки задачи. Например, если вы работаете с текстом из сферы экономики или бизнеса, знаки типа $ или другие символы валют могут содержать скрытую информацию, которую вы не хотите потерять. Но в большинстве случаев, мы их удаляем.

Код на Python: Data cleaning

Предварительная обработка данных (Preprocessing of Data)

Preprocessing of Data это этап Data Mining, который включает в себя трансформацию исходных данных в доступный для понимания формат.

Изменение регистра:

Одна из простейших форм предварительной обработки текста — перевод всех символов текста в нижний регистр.

Источник изображения

Код на Python: перевод в нижний регистр

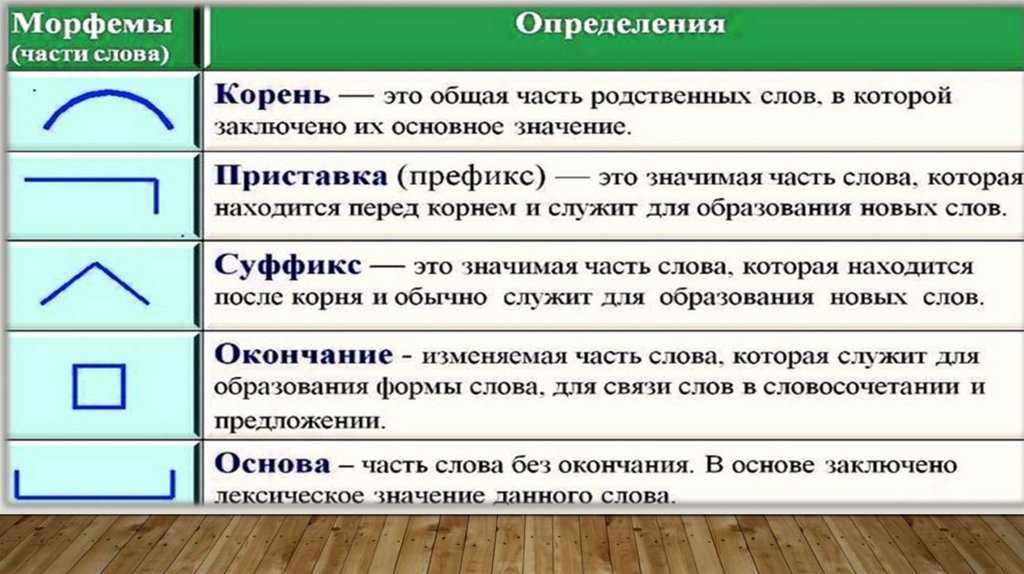

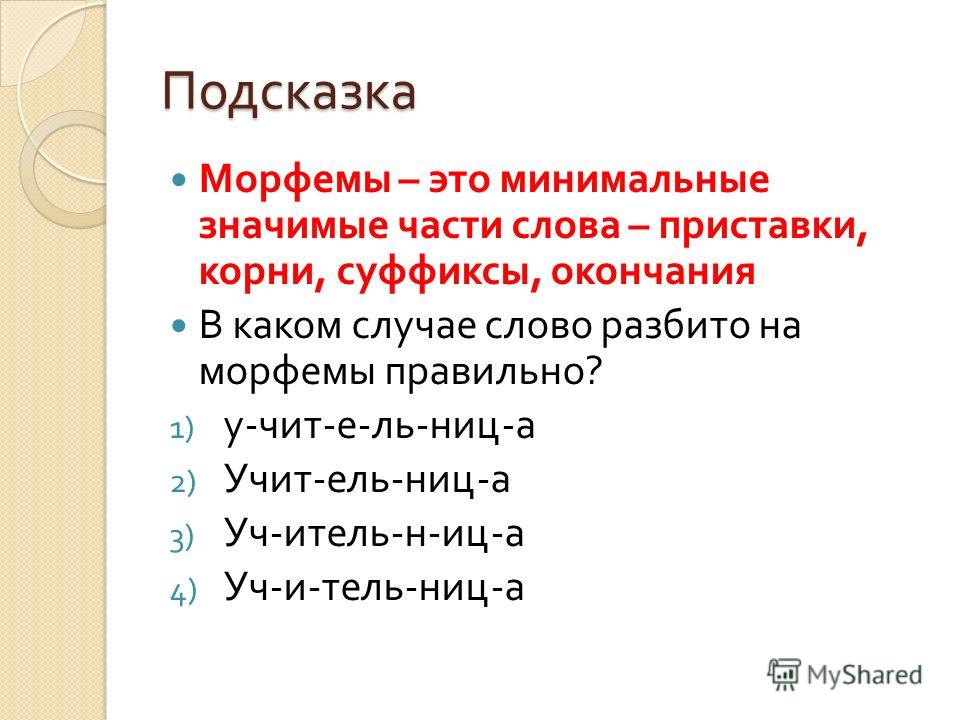

Токенизация:

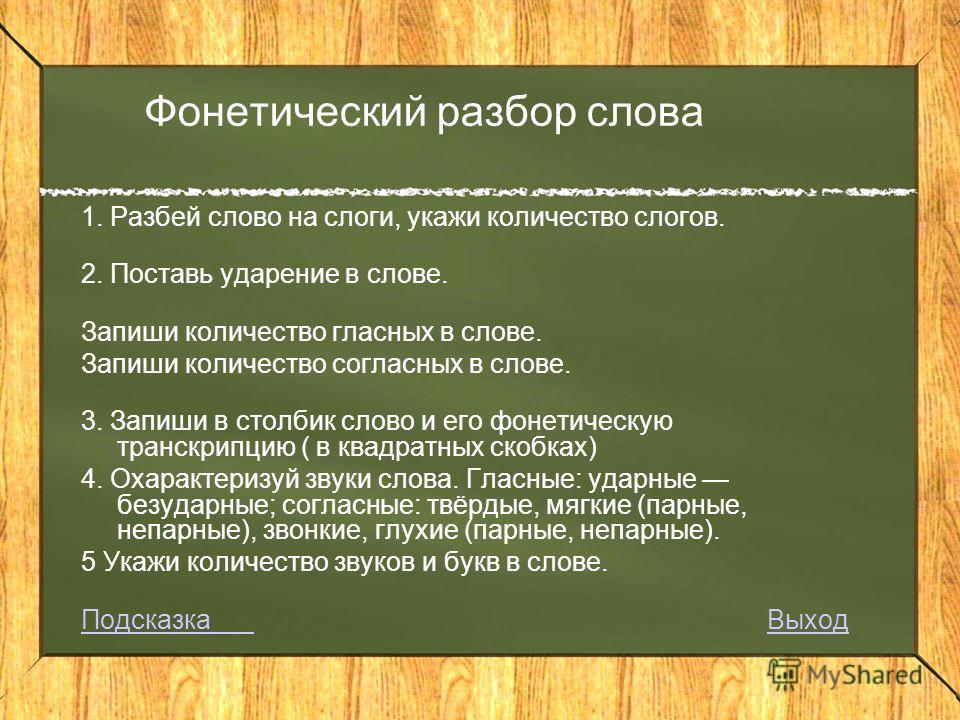

Токенизация — процесс разбиения текстового документа на отдельные слова, которые называются токенами.

Код на Python: Токенизация

Как можно видеть выше, предложение разбито на слова (токены).

Natural language toolkit (библиотека NLTK) — популярный открытый пакет библиотек, используемых для разного рода задач NLP. В этой статье мы будем использовать библиотеку NLTK для всех этапов Text Preprocessing.

Вы можете скачать библиотеку NLTK с помощью pip:

!pip install nltk

Удаление стоп-слов:

Стоп-слова — это часто используемые слова, которые не вносят никакой дополнительной информации в текст. Слова типа «the», «is», «a» не несут никакой ценности и только добавляют шум в данные.

В билиотеке NLTK есть встроенный список стоп-слов, который можно использовать, чтобы удалить стоп-слова из текста. Однако это не универсальный список стоп-слов для любой задачи, мы также можем создать свой собствпнный набор стоп-слов в зависимости от сферы.

Код на Python: Удаление стоп-слов

В библиотеке NLTK есть заранее заданный список стоп-слов. Мы можем добавитьили удалить стоп-слова из этого списка или использовать его в зависимости от конкретной задачи.

Стеммизация:

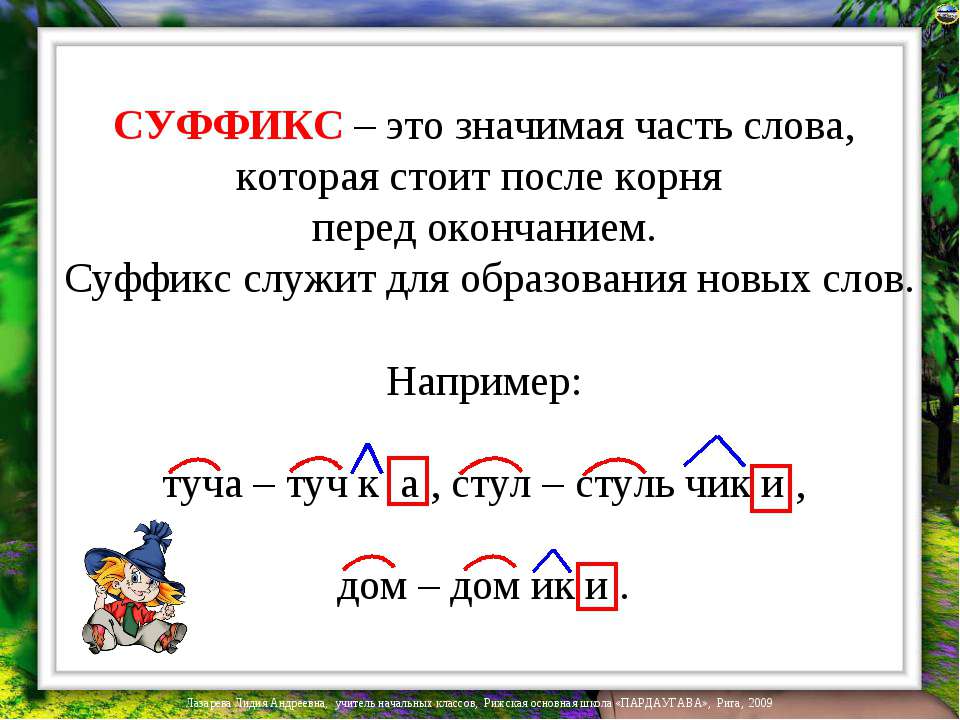

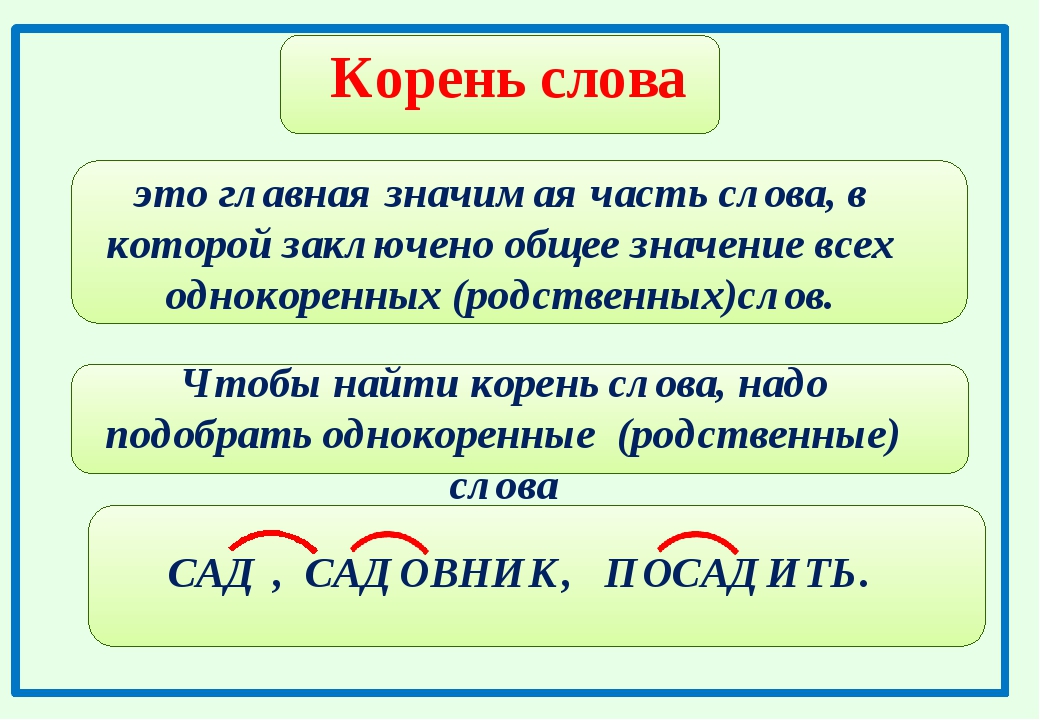

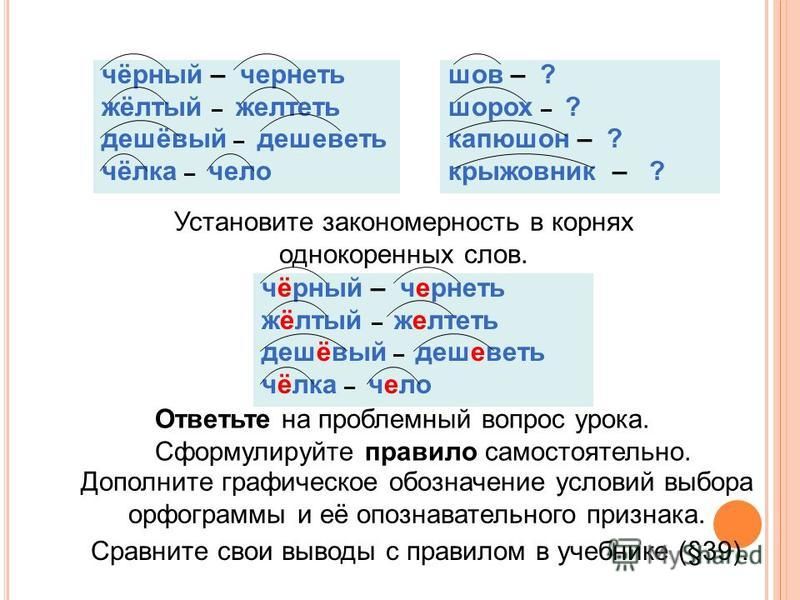

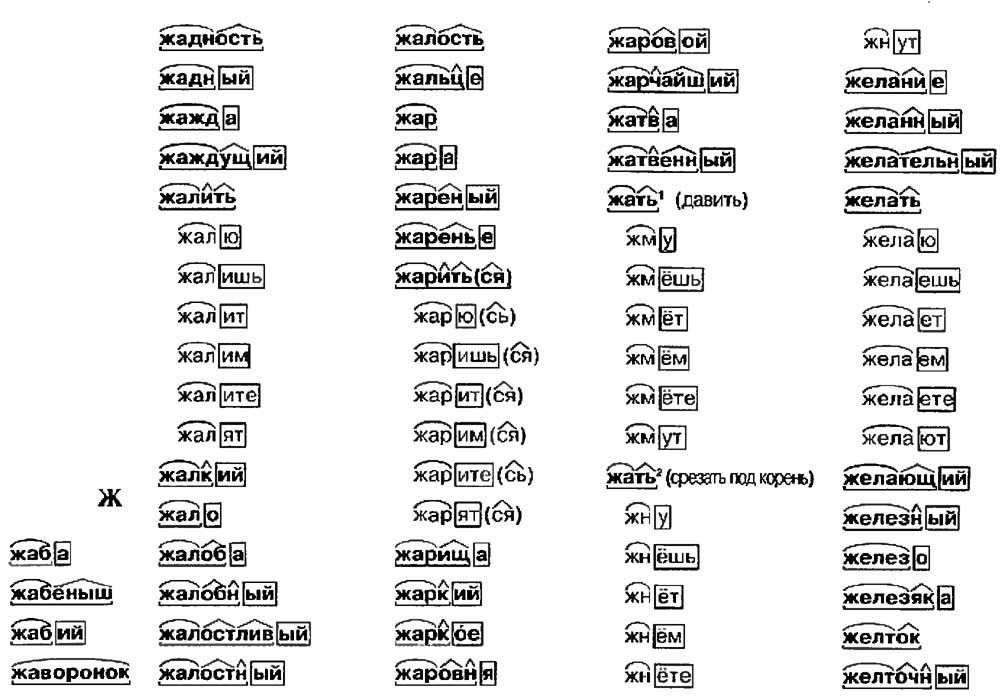

Стеммизация — процесс приведения слова к его корню/основе.

Он приводит различные вариации слова (например, «help», «helping», «helped», «helpful») к его начальной форме (например, «help»), удаляет все придатки слов (приставка, суффикс, окончание) и оставляет только основу слова.

Источник изображения

Код на Python: Стеммизация

Корень слова может быть существующим в языке словом, а может и не быть им. Например, «mov» корень слова «movie», «emot» корень слова «emotion».

Лемматизация:

Лемматизация похожа на стеммизацию в том, что она приводит слово к его начальной форме, но с одним отличием: в данном случае корень слова будет существующим в языке словом. Например, слово «caring» прекратится в «care», а не «car», как в стеммизаци.

Код на Python: Лемматизация

WordNet — это база существующих в английском языке слов. Лемматизатор из NLTK WordNetLemmatizer() использует слова из WordNet.

N-граммы:

Источник изображения

N-граммы — это комбинации из нескольких слов, использующихся вместе, N-граммы, где N=1 называются униграммами (unigrams). Подобным же образом, биграммы (N=2), триграммы (N=3) и дальше можно продолдать аналогичным способом.

N-граммы могут использоваться, когда нам нужно сохранить какую-то последовательность данных, например, какое слово чаще следует за заданным словом. Униграммы не содержат никкой последовательности данных, так как каждое слово берется индивидуально.

Векторизация текстовых данных (Text Data Vectorization):

Процесс конвертации текста в числа называется векторизацией. Теперь после Text Preprocessing, нам нужно представить текст в числовом виде, то есть закодировать текстовые данные в виде чисел, которые в дальнейшем могут использоваться в алгоритмах.

«Мешок слов» (Bag of words (BOW)):

Это одна из самых простых методик векторизации текста. В логике BOW два предложения могут называться одинаковыми, если содержат один и тот же набор слов.

Рассмотрим два предложения:

Источник изображения

В задачах NLP, каждое текстовое предложение называется документом, а несколько таких документов называют корпусом текстов.

BOW создает словарь уникальных d слов в корпусе (собрание всех токенов в данных). Например, корпус на изображении выше состоит из всех слов предложений S1 и S2.

Теперь мы можем создать таблицу, где столбцы соответствуют входящим в корпус уникальным d словам, а строки предложениям (документам). Мы устанавливаем значение 1, если слово в предложении есть, и 0, если его там нет.

Мы устанавливаем значение 1, если слово в предложении есть, и 0, если его там нет.

Источник изображения

Это позволит создать dxn матрицу, где d это общее число уникальных токенов в корпусе и n равно числу документов. В примере выше матрица будет иметь форму 11×2.

TF-IDF:

Источник изображения

Это расшифровывается как Term Frequency (TF)-Inverse Document Frequency (IDF).

Частота слова (Term Frequency):

Term Frequency высчитывает вероятность найти какое-то слово в документе. Ну, например, мы хотим узнать, какова вероятрность найти слово wi в документе dj.

Term Frequency (wi, dj) =

Количество раз, которое wi встречается в dj / Общее число слов в dj

Обратная частота документа (Inverse Document Frequency):

В логике IDF, если слово встречается во всех документах, оно не очень полезно. Так определяется, насколько уникально слово во всем корпусе.

Так определяется, насколько уникально слово во всем корпусе.

IDF(wi, Dc) = log(N/ni)

Здесь Dc = Все документы в корпусе,

N = Общее число документов,

ni = документы, которые содержат слово (wi).

Если wi встречается в корпусе часто, значение IDF снижается.

Если wi используется не часто, то ni снижается и вследствие этого значение IDF возрастает.

TF(wi, dj) * IDF(wi, Dc)

TF-IDF — умножение значений TF и IDF. Больший вес получат слова, которые встречаются в документе чаще, чем во всем остальном корпусе.

Sentiment Analysis: Обзоры фильмов на IMDb

Источник изображения

Краткая информация

Набор данных содержит коллекцию из 50 000 рецензий на сайте IMDb, с равным количеством положительных и отрицательных рецензий. Задача — предсказать полярность (положительную или отрицательную) данных отзывов (тексты).

1. Загрузка и исследование данных

Набор данных IMDB можно скачать здесь.

Обзор набора данных:Положительные рецензии отмечены 1, а отрицательные 0.

Пример положительной рецензии:Пример отрицательной рецензии:

2. Data Preprocessing

На этом этапе мы совершаем все шаги очистки и предварительной обработки данных тем методом, который был описан выше. Мы используем лемматизацию, а не стеммизацию, потому что в процессе тестирования результатов обоих случаев лемматизация дает лучшие результаты, чем стеммизация.

Использовать ли стеммизацию или лемматизацию или и то, и другое — зависит от поставленной задачи, так что нам стоит попробовать и решить, какой способ сработает лучше для данной задачи.

Добавляем новую колонку preprocessed_review в dataframe, применяя data_preprocessing() ко всем рецензиям.

3. Vectorizing Text (рецензии)

Разделяем набор данных на train и test (70–30):Используем train_test_split из sklearn, чтобы разделить данные на train и test. Здесь используем параметр stratify,чтобы иметь равную пропорцию классов в train и test.

Здесь используем параметр stratify,чтобы иметь равную пропорцию классов в train и test.

Здесь мы использовали min_df=10, так как нам нужны были только те слова, которые появляются как минимум 10 раз во всем корпусе.

TF-IDF4. Создание классификаторов ML

Наивный байесовский классификатор (Naive Bayes) с рецензиями, закодированными BOWNaive Bayes c BOW выдает точность 84.6%. Попробуем с TF-IDF.

Наивный байесовский классификатор (Naive Bayes) с рецензиями, закодированными TF-IDF

TF-IDF выдает результат немного лучше (85.3%), чем BOW. Теперь давайте попробуем TF-IDF с простой линеарной моделью, Logistic Regression.

Logistic Regression с рецензиями, закодированными TF-IDF

Logistic Regression с рецензиями, закодированными TF-IDF, выдает результат лучше, чем наивный байемовский — точность 88. 0%.

0%.

Построение матрицы неточностей даст нам информацию о том, сколько точек данных верны и сколько неверны, классифицированную с помощью модели.

Из 7500 отрицательных рецензий 6515 были верно классифицированы как отрицательные и 985 были неверно классифицированы как положительные. Из 7500 положительных рацензий 6696 были верно классифицированы как положительные, и 804 неверно классифицированы как отрицательные.

Итоги

Мы узнали основные задачи NLP и создали простые модели ML для сентимент-анализа рецензий на фильмы. В дальнейшем усоверешенствований можно добиться с помощью Word Embedding с моделями Deep Learning.

Благодарю за внимание! Полный код смотрите здесь.

Ссылки:

- Ultimate guide to deal with Text Data (using Python) – for Data Scientists and Engineers

- All you need to know about text preprocessing for NLP and Machine Learning

- Applied Course

Источник

Разбиение желаний | МЕЖДУНАРОДНАЯ АКАДЕМИЯ КАББАЛЫ

Вы находитесь здесь: КАББАЛА / Библиотека / Издания Академии каббалы / Каббалисты уполномочены сообщить / Глава 12: РАШАШ / Разбиение желаний

Откуда мы

С того момента, когда человек впервые начал задумываться, кто он, что он, откуда он, стали появляться различные теории возникновения нашего мира. Этот процесс продолжается и сегодня. Однако узнать наверняка, как и откуда произошел наш мир, мы не можем, поскольку свидетелей, которые могли бы нам об этом рассказать, нет. Кроме каббалистов. Они не только знают, что предшествовало появлению нашего мира, но и записали свои «свидетельские показания» в каббалистических книгах, чтобы передать их человечеству.

Этот процесс продолжается и сегодня. Однако узнать наверняка, как и откуда произошел наш мир, мы не можем, поскольку свидетелей, которые могли бы нам об этом рассказать, нет. Кроме каббалистов. Они не только знают, что предшествовало появлению нашего мира, но и записали свои «свидетельские показания» в каббалистических книгах, чтобы передать их человечеству.

Мы не будем говорить о том, как каббалисты сумели это сделать. Мы поговорим об устройстве духовных миров.

О причине

Каббала объясняет, что в мироздании существуют всего два объекта: Творец и творение. Между ними – принципиальное отличие: Творец – дает, наполняет, наслаждает, а творение, наоборот, – получает, наполняется, наслаждается.

А теперь представьте себя на месте Творца, который, как радушный хозяин, желает угостить кого-то хорошим обедом.

Вы приготовили изысканные кушанья. Теперь нужен тот, кто бы эти кушанья отведал. Причем его вкусы, привычки, желания должны и качественно, и количественно совпадать с тем, чем ему предстоит насладиться. Еще очень важно, чтобы он хорошенько проголодался, чтобы у него появилось огромное стремление к вашему угощению. Еще одна проблема – наслаждение должно быть абсолютным, ничем не ограниченным. Кроме того, ваш гость стесняется, чувствует неудобство.

Еще очень важно, чтобы он хорошенько проголодался, чтобы у него появилось огромное стремление к вашему угощению. Еще одна проблема – наслаждение должно быть абсолютным, ничем не ограниченным. Кроме того, ваш гость стесняется, чувствует неудобство.

В общем, куча проблем.

Что же сделал Творец? Он Себя скрыл.

О скрытии

Слово алама (скрытие) имеет тот же корень, что и слово олам (мир). Мир, строго говоря, не является творением. Это система, за которой скрывается Творец. Благодаря ей, с одной стороны, Творец может влиять на творение, а с другой стороны, творение способно развиваться, не теряя самостоятельности. Только таким образом можно вывести творение на уровень получения ничем не ограниченного наслаждения, которое желает дать Творец.

Чтобы выполнить эти условия, система под названием «мир» должна включить в себя как свойства творения, так и свойства Творца.

Впервые это случилось в мире Некудим.

Мир Некудим

Устройство мира Некудим напоминает территорию, по которой проходит пограничная линия двух государств. Эта линия делит мир Некудим на две части и называется «парса». Верхняя часть, над парсой, относится к Творцу и называется Гальгальта вэ Эйнаим (ГЭ). Другая часть, под парсой, относится к творению и называется АХАП.

Эта линия делит мир Некудим на две части и называется «парса». Верхняя часть, над парсой, относится к Творцу и называется Гальгальта вэ Эйнаим (ГЭ). Другая часть, под парсой, относится к творению и называется АХАП.

Итак, все готово для того чтобы свойства Творца объединились со свойствами творения. Но как это сделать?

Разбиение

Свет начал наполнять АХАП через ГЭ. И тут происходит непредвиденное. Конечно, непредвиденное для творения, а не для Творца.

Творение не было в состоянии принимать то наслаждение, которое желал дать ему Творец, – ведь оно желало получить его ради себя, и произошло то, что в каббале называется «разбиение».

Это подобно нашему примеру с хозяином и стесняющимся гостем. Пока на столе стоит лишь несколько обычных на вид блюд, гость держится и не показывает вида, что голоден и желает откушать их. Но когда хозяин выставляет перед ним соблазнительные яства, издающие неземной аромат, гость не выдерживает и с жадностью набрасывается на еду, забыв про того, кто ему все это приготовил.

Разбиение – начало исправления

Духовный мир и мир материальный связаны между собой, как корень и ветвь. Поэтому разбиение, произошедшее в мире Некудим, имеет свои следствия в нашем материальном мире.

Разбиение, о котором мы рассказали в сокращенном виде, происходило в два этапа. Они соответствуют разрушению Первого и Второго Храма. Каждый из этих этапов включает в себя еще по два дополнительных, которые соответствует четырем изгнаниям народа Израиля.

Но, как известно, падение всегда предшествует подъему. И сегодня этот подъем начался. В наше время наступил период, о котором так много писали каббалисты, – эпоха исправления всего человечества. Именно поэтому так широко раскрывается сегодня методика исправления – каббала. Хозяин уже заждался своих гостей

Этимология, происхождение и значение слова split по этимонлайну

Реклама

1580s (переходный и непереходный), не встречается в среднеанглийском языке, вероятно, из нижненемецкого источника, такого как среднеголландский splitten, из протогерманского *spleitanan (источник также Датский и фризский splitte, древнефризский splita, немецкий spleißen «расколоть»), от PIE *(s)plei- «расколоть, склеить» (см. кремень).

кремень).

Сленг в США, означающий «уходить, уходить», впервые записан в 1954 году. О парах «разлучиться, развестись» с 1942. На предлагается разделить разницу с 1715; to split (one’s) ticket в политическом смысле США засвидетельствовано с 1842 года. To split hairs «сделать слишком-красивые различия» относится к 1670-м (split a hair; сам образный образ подразумевается у Шекспира). Расщепление изображения «точное подобие» от 1880. К расщепление атома от 1909.

расщепление (сущ.)

1590s, «узкая щель, трещина, трещина», от расщепления (v.). Значение «кусок дерева, образованный раскалыванием» восходит к 1610-м годам. Значение «акт о раздельном проживании, разводе» с 1729 г.. С 1861 г. как название акробатического номера. Значение «напиток, состоящий из двух ликеров» относится к 1882 году; выражение «сладкое блюдо из нарезанных фруктов с мороженым» засвидетельствовано американским английским языком 1920 года. Сленговое значение «доля выручки» относится к 1889 году. Значение «ничья в двойном заголовке» относится к 1920 году. Раздельное решение от 1946 по судебным решениям, 1951 по боксу. Смена разделения происходит с 1904 года. Впервые засвидетельствовано раздвоение личности 189.9.

Сленговое значение «доля выручки» относится к 1889 году. Значение «ничья в двойном заголовке» относится к 1920 году. Раздельное решение от 1946 по судебным решениям, 1951 по боксу. Смена разделения происходит с 1904 года. Впервые засвидетельствовано раздвоение личности 189.9.

updated on February 27, 2022

Advertisement

Advertisement

Dictionary entries near

splitsplice

spliff

spline

splint

splinter

split

split-level

split -экран

доли секунды

брызги

брызги

- A

- B

- C

- D 7 901 G

- 0

- H

- I

- J

- K

- L

- M

- N

- O

- P

- Q

- R

- S

- T

- U

- V

- W

- X

- Y

- Z

Разделение определения и значения — Merriam-Webster

Последние примеры в Интернете

Победа или поражение, многочисленные участники беспорядков 6 января были арестованы по обвинению в подстрекательстве к мятежу — акция, которую сама Грин снова разжигает своим собственным мятежным твитом, призывающим расколоть страну. — Прем Таккер, Новая Республика , 20 февраля 2023 г.

Эта дилемма восходит к решению Macrovision разделить компанию на две части в 2008 году, продав TVGuide.com и TV Guide Network (теперь Pop TV) одной компании, а журнал TV Guide — другой.

—Майкл Шнайдер, 9 лет.0117 Разнообразие , 20 февраля 2023 г.

В 1935 году суд в Тусоне постановил разделить 90 117 прав на воду между 90 118 между пима и неплеменными фермерами.

— Джим Роббинс, Smithsonian Magazine , 15 февраля 2023 г.

Кора сказал, что «Сокс» придется придумать, как разделить на Деверса и Йошиду — обоих левшей — в составе.

— Джулиан Маквильямс, 9 лет.0117 BostonGlobe.com , 15 февраля 2023 г.

Кроме того, дышащие простыни доступны в колоссальных 42 цветах и узорах, таких как кремовый, белый, лавандовый и нежно-голубой, а также в размерах от двойных до разделенных королевских.

— Прем Таккер, Новая Республика , 20 февраля 2023 г.

Эта дилемма восходит к решению Macrovision разделить компанию на две части в 2008 году, продав TVGuide.com и TV Guide Network (теперь Pop TV) одной компании, а журнал TV Guide — другой.

—Майкл Шнайдер, 9 лет.0117 Разнообразие , 20 февраля 2023 г.

В 1935 году суд в Тусоне постановил разделить 90 117 прав на воду между 90 118 между пима и неплеменными фермерами.

— Джим Роббинс, Smithsonian Magazine , 15 февраля 2023 г.

Кора сказал, что «Сокс» придется придумать, как разделить на Деверса и Йошиду — обоих левшей — в составе.

— Джулиан Маквильямс, 9 лет.0117 BostonGlobe.com , 15 февраля 2023 г.

Кроме того, дышащие простыни доступны в колоссальных 42 цветах и узорах, таких как кремовый, белый, лавандовый и нежно-голубой, а также в размерах от двойных до разделенных королевских. — Миа Хюльсбек, Peoplemag , 14 февраля 2023 г.

Пары кварк-антикварк постоянно появляются и исчезают, а глюоны имеют тенденцию к делению 9.0118 и размножаться, особенно когда протон набирает скорость.

— Клара Московиц,

— Миа Хюльсбек, Peoplemag , 14 февраля 2023 г.

Пары кварк-антикварк постоянно появляются и исчезают, а глюоны имеют тенденцию к делению 9.0118 и размножаться, особенно когда протон набирает скорость.

— Клара Московиц,

Тем не менее, во время последней кампании мэра Уэллс набрал 70 процентов голосов против кандидата от Демократической партии, что примечательно в городе, в котором относительно 90 117 человек разделены на 90 118 зарегистрированных демократов и республиканцев.

— Сан-Диего Юнион-Трибьюн , 1 марта 2023 г.

Оба типа кузова имеют раздельную спинку заднего сиденья , поэтому кормовое отделение можно легко превратить в объемный грузовой отсек.

—Чаба Чере, 9 лет0117 Автомобиль и водитель , 1 марта 2023 г.

Есть ли шанс на искупление или это сплит окончательный?

— Элейн Велтерот, Washington Post , 28 февраля 2023 г.

com, al , 27 февраля 2023 г.

Летом школьный совет Rising Star решил, что Джонс и Стутевилль станут опекунами его кампуса , разделенного на : Джонс — здания с шестым по 12-й классы, а Стутевилль — другого, с подготовительным классом по пятый класс.

— Правина Сомасундарам, Anchorage Daily News , 23 февраля 2023 г.

com, al , 27 февраля 2023 г.

Летом школьный совет Rising Star решил, что Джонс и Стутевилль станут опекунами его кампуса , разделенного на : Джонс — здания с шестым по 12-й классы, а Стутевилль — другого, с подготовительным классом по пятый класс.

— Правина Сомасундарам, Anchorage Daily News , 23 февраля 2023 г. Однако после двух лет совместной жизни пара рассталась с в апреле 2020 года.

— Ханна Малах,  — Саманта Дж. Гросс, 9 лет.0117 BostonGlobe.com , 27 февраля 2023 г.

Бывшая пара рассталась с в 2008 году и завершила развод в 2010 году.

— Александра Уртадо, Peoplemag , 23 февраля 2023 г.

Но сначала: на этой неделе был показан первый настоящий разделенный экранный момент очень ранней президентской гонки 2024 года.

— Бен Камисар, NBC News , 23 февраля 2023 г.

Защитник зафиксировал три результативные передачи в 9 матчах прошлых выходных.0117 разделил со штатом Огайо, включая двоих в субботу.

— Марк Стюарт, Journal Sentinel , 23 февраля 2023 г.

По данным AdImpact Politics, отслеживающей рекламу, сторонние группы уже потратили около 9,2 миллиона долларов по состоянию на вторник, примерно поровну 90 117 из 90 118 между двумя сторонами.

— Саманта Дж. Гросс, 9 лет.0117 BostonGlobe.com , 27 февраля 2023 г.

Бывшая пара рассталась с в 2008 году и завершила развод в 2010 году.

— Александра Уртадо, Peoplemag , 23 февраля 2023 г.

Но сначала: на этой неделе был показан первый настоящий разделенный экранный момент очень ранней президентской гонки 2024 года.

— Бен Камисар, NBC News , 23 февраля 2023 г.

Защитник зафиксировал три результативные передачи в 9 матчах прошлых выходных.0117 разделил со штатом Огайо, включая двоих в субботу.

— Марк Стюарт, Journal Sentinel , 23 февраля 2023 г.

По данным AdImpact Politics, отслеживающей рекламу, сторонние группы уже потратили около 9,2 миллиона долларов по состоянию на вторник, примерно поровну 90 117 из 90 118 между двумя сторонами.