Слова «аркадьевич» морфологический и фонетический разбор

Объяснение правил деление (разбивки) слова «аркадьевич» на слоги для переноса.

Онлайн словарь Soosle.ru поможет: фонетический и морфологический разобрать слово «аркадьевич» по составу, правильно делить на слоги по провилам русского языка, выделить части слова, поставить ударение, укажет значение, синонимы, антонимы и сочетаемость к слову «аркадьевич».

Содержимое:

- 1 Слоги в слове «аркадьевич» деление на слоги

- 2 Как перенести слово «аркадьевич»

- 3 Синонимы слова «аркадьевич»

- 4 Ударение в слове «аркадьевич»

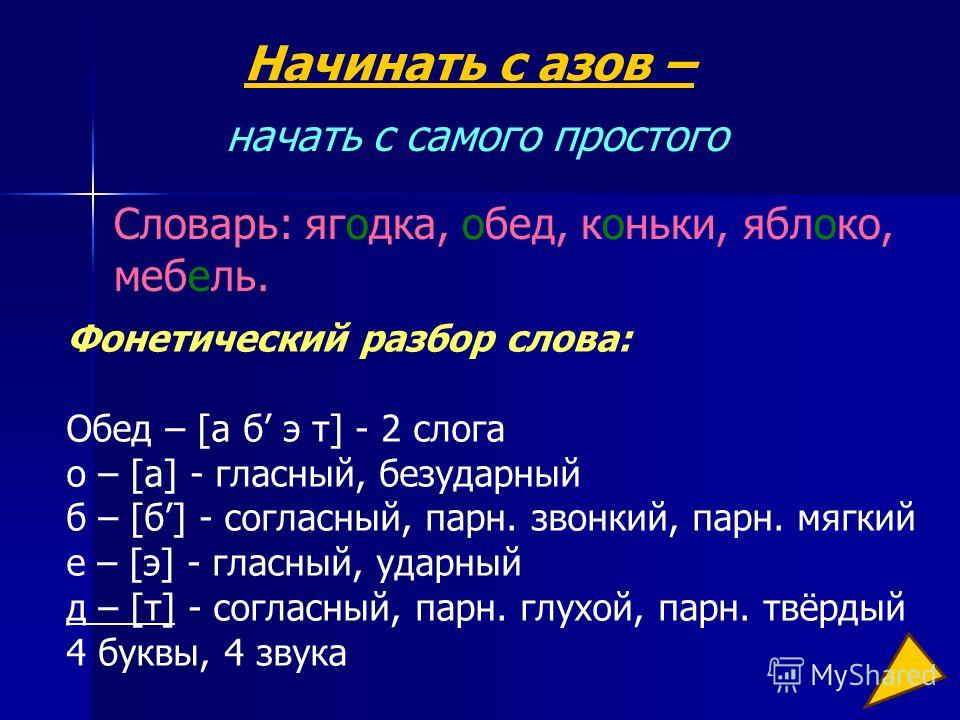

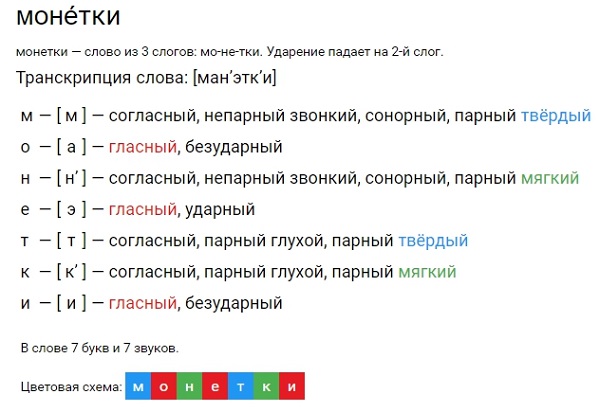

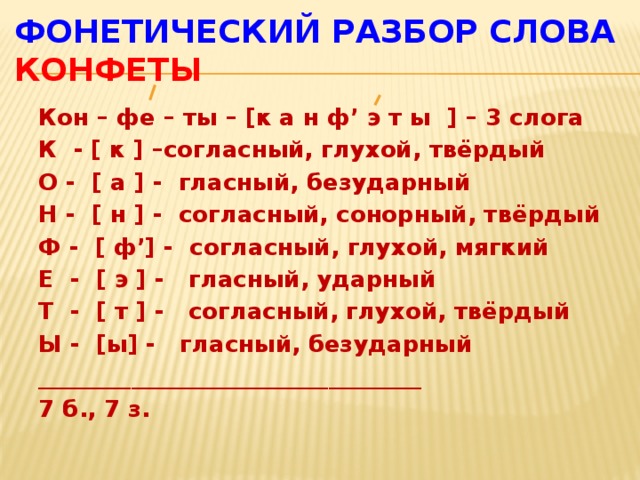

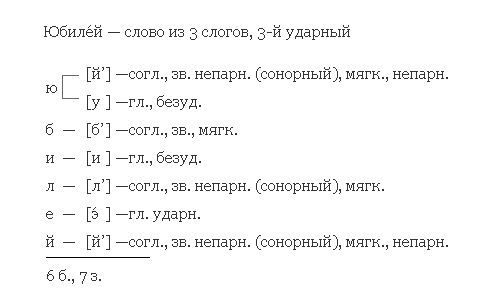

- 5 Фонетическая транскрипция слова «аркадьевич»

- 6 Фонетический разбор слова «аркадьевич» на буквы и звуки (Звуко-буквенный)

- 7 Как правильно пишется слово «аркадьевич»

- 8 Ассоциации к слову «аркадьевич»

Слоги в слове «аркадьевич» деление на слоги

Количество слогов: 4

р — непарная звонкая согласная (сонорная), примыкает к текущему слогу

ь всегда примыкает к предшествующей согласной, смягчая её

Как перенести слово «аркадьевич»

ар—кадьевич

арка—дьевич

аркадь—евич

аркадье—вич

Синонимы слова «аркадьевич»

1. имя

имя

2. аркаша

Ударение в слове «аркадьевич»

арка́дьевич — ударение падает на 2-й слог

Фонетическая транскрипция слова «аркадьевич»

[арк`ад’й’ив’ич’]

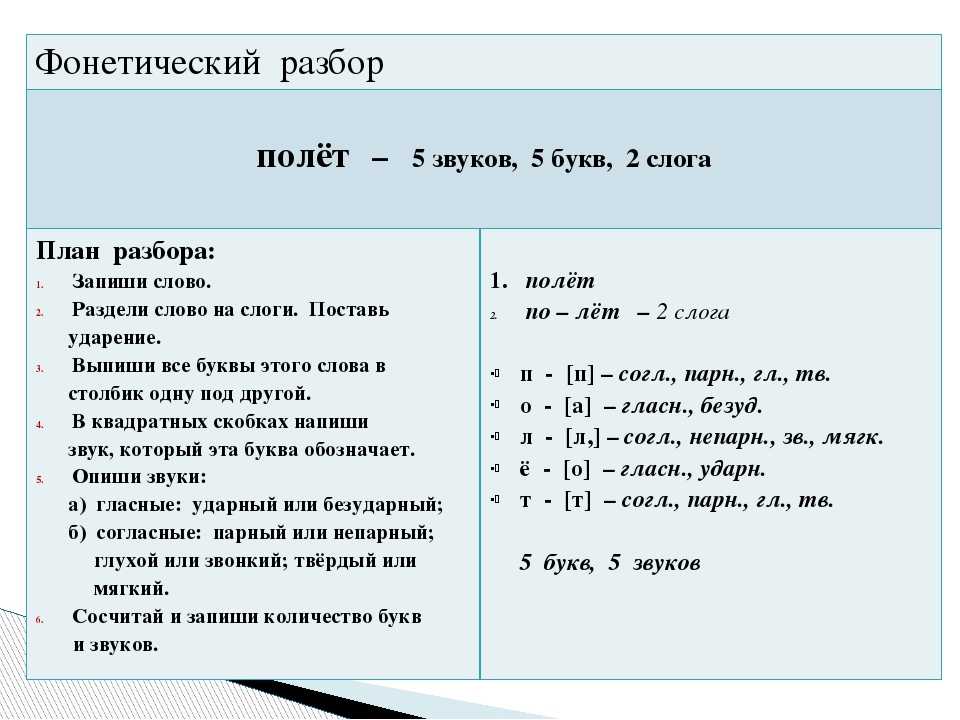

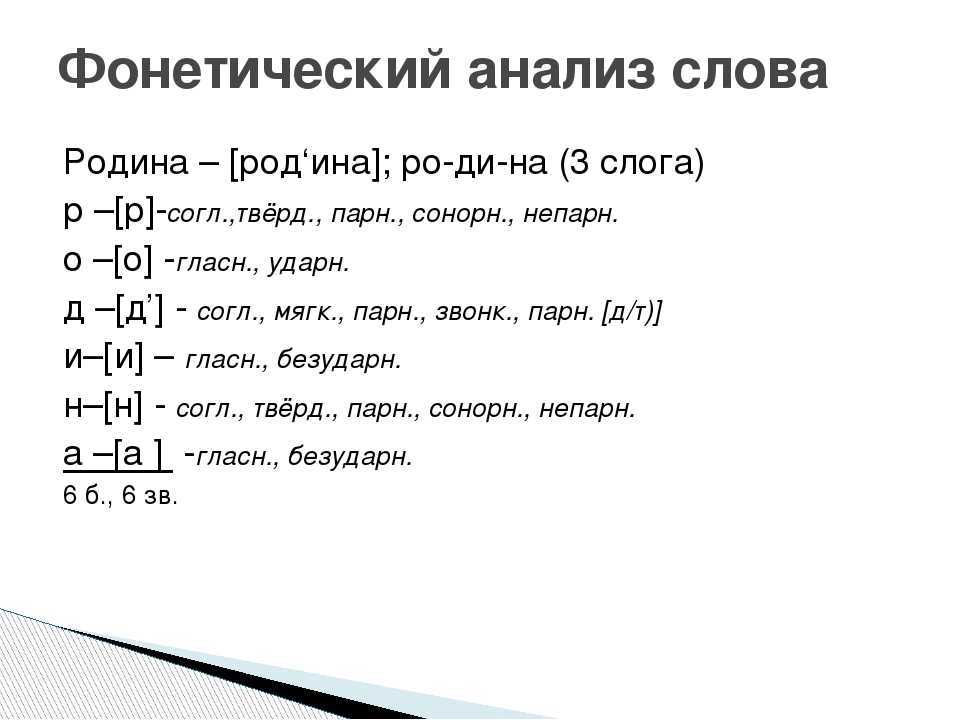

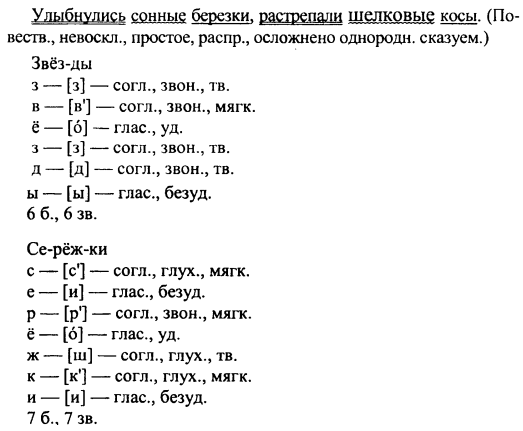

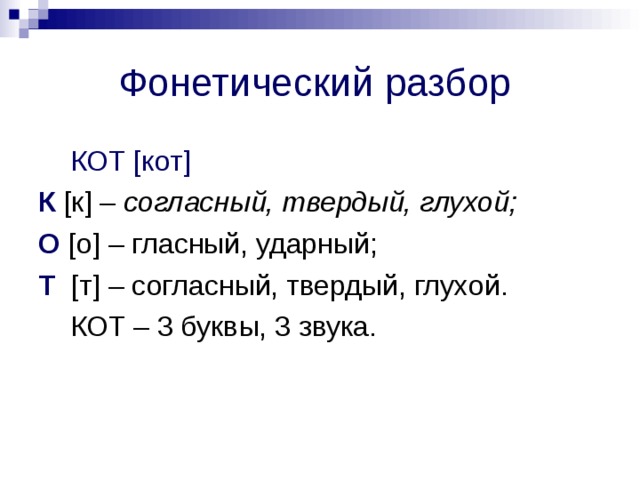

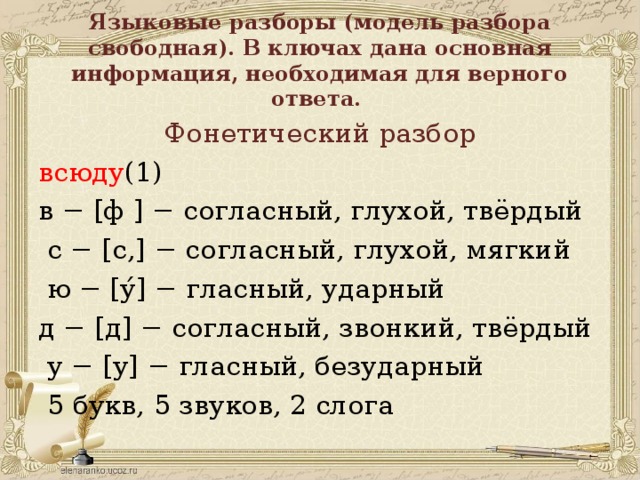

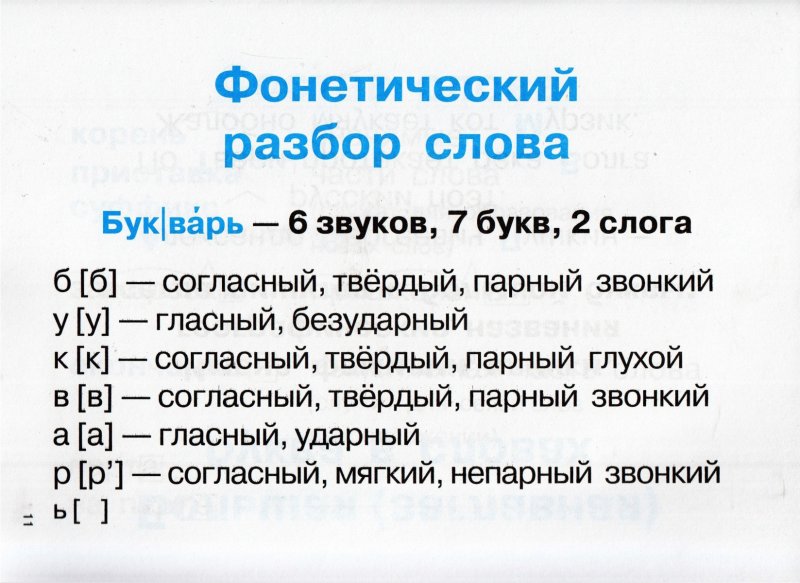

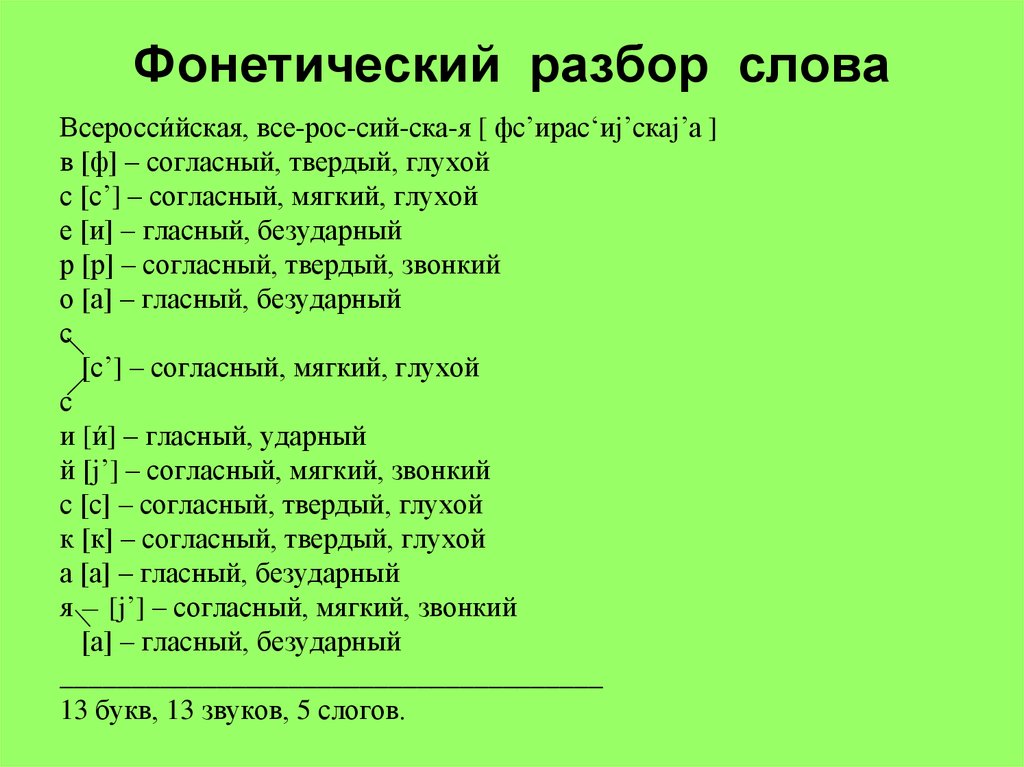

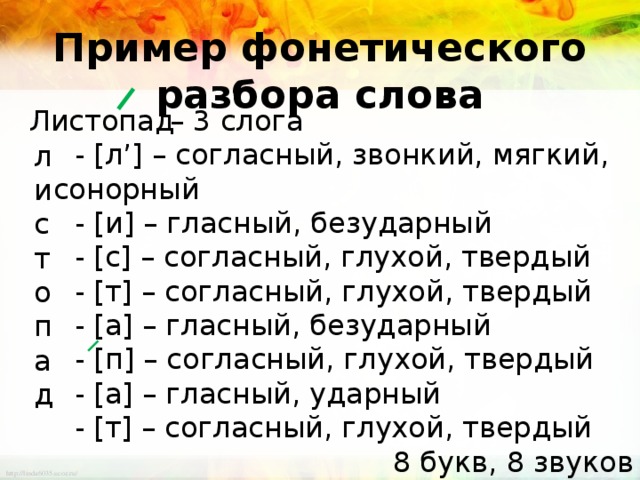

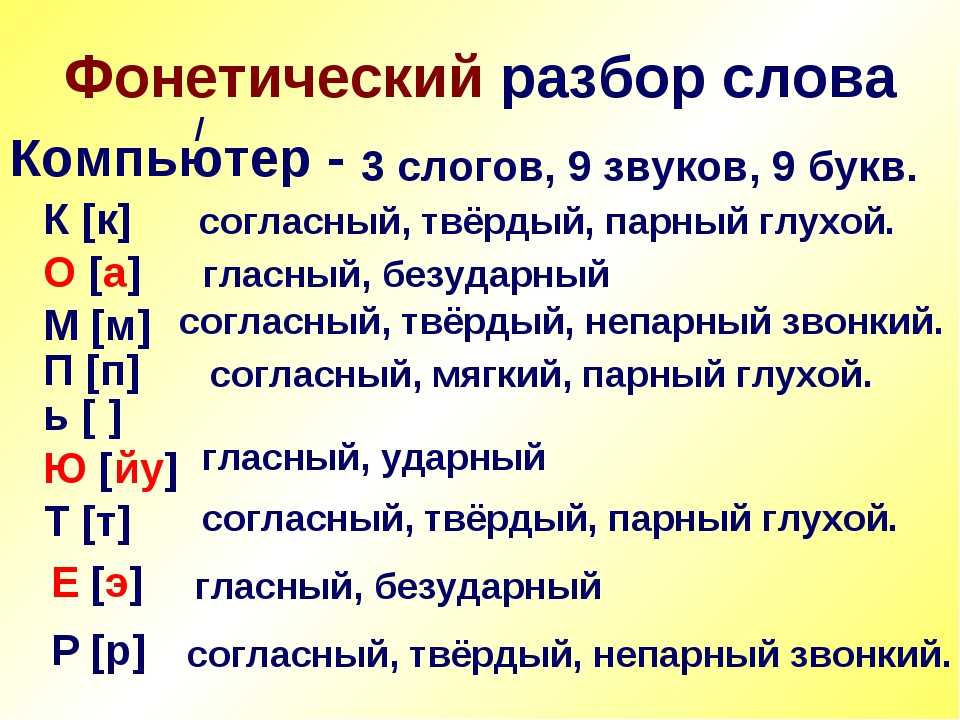

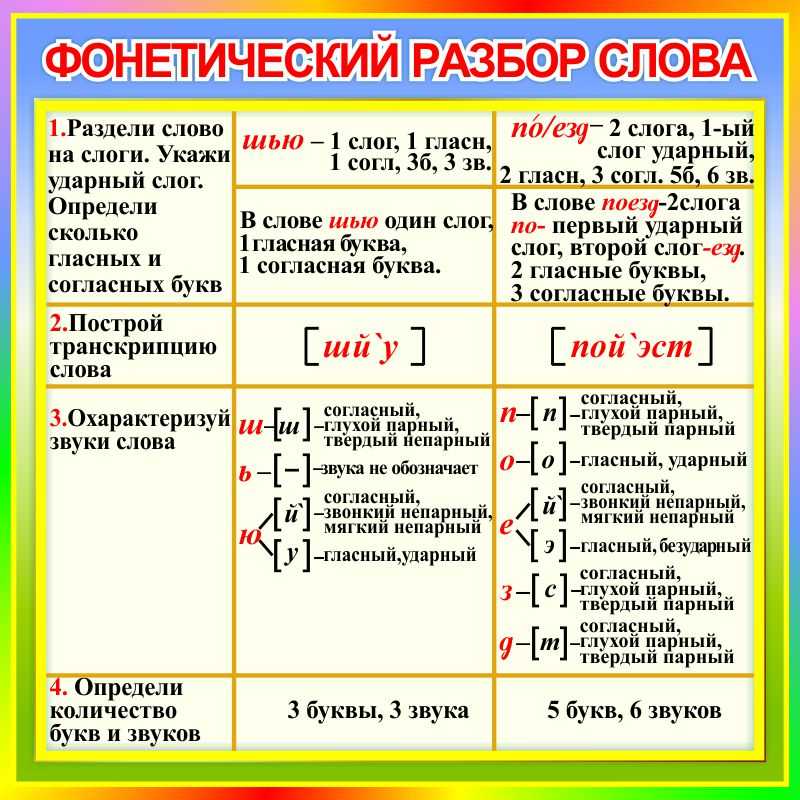

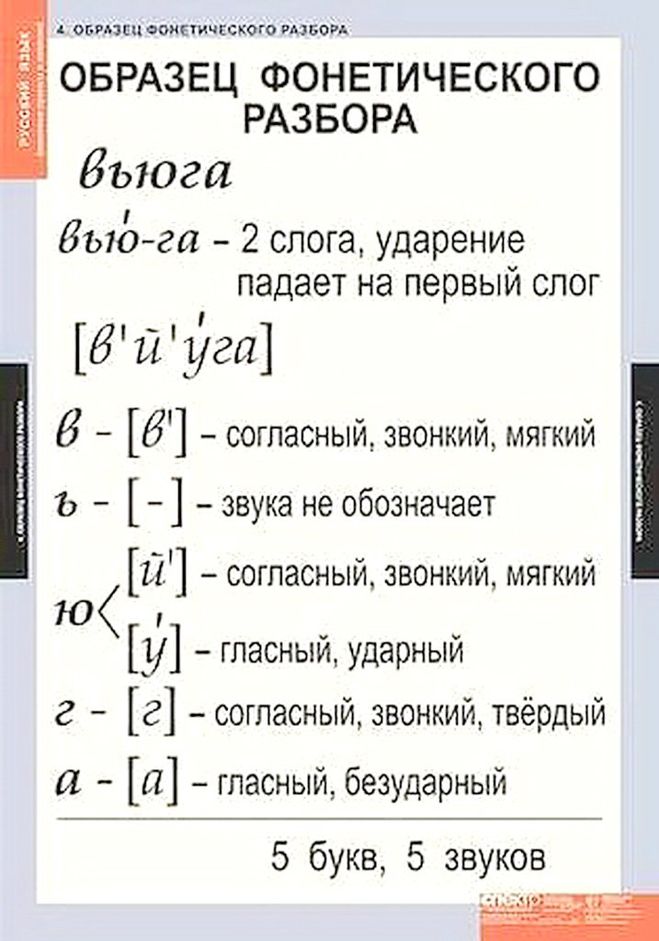

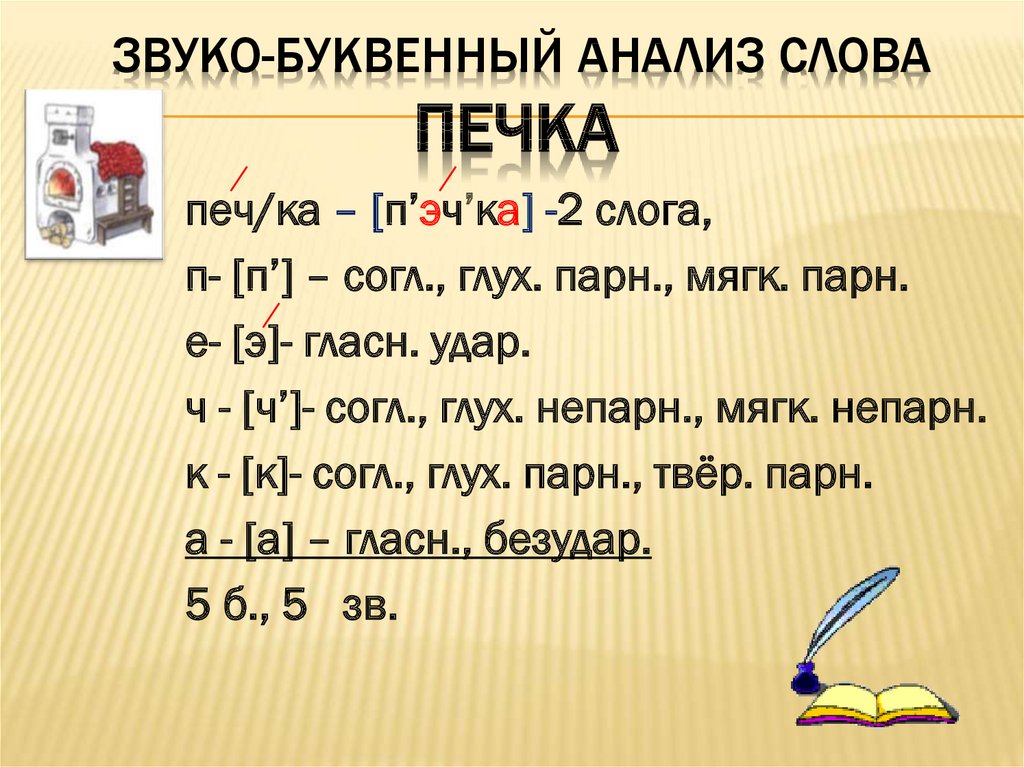

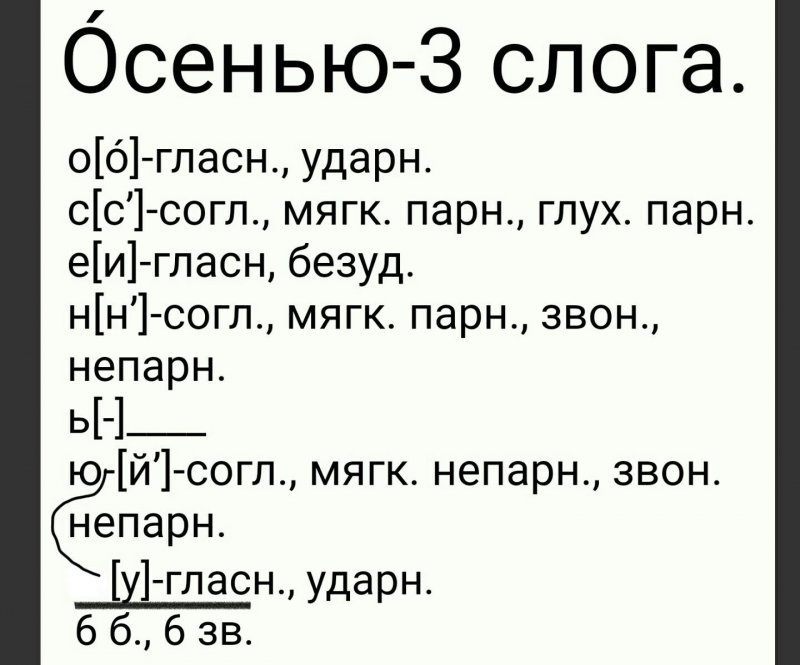

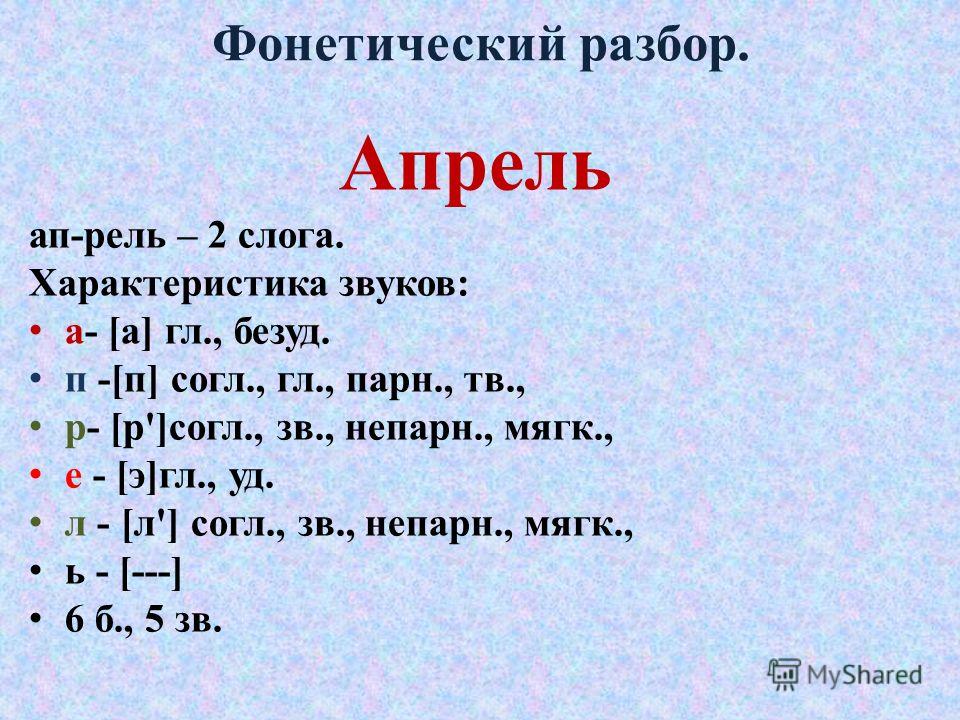

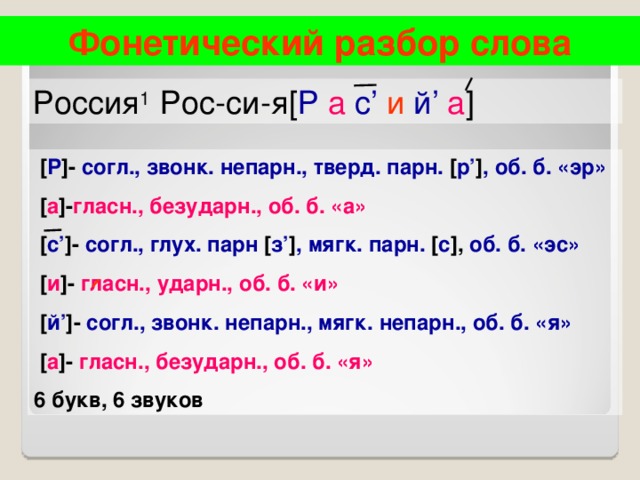

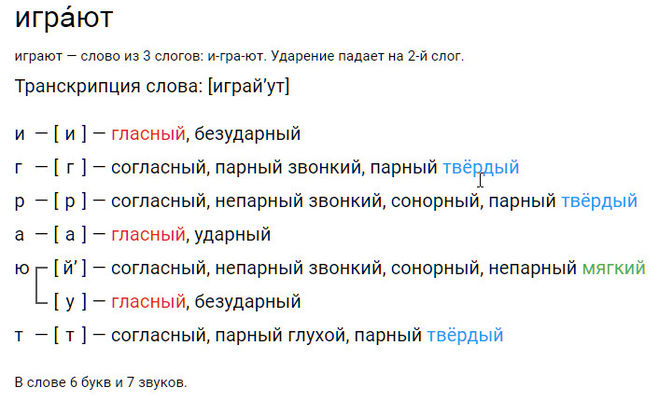

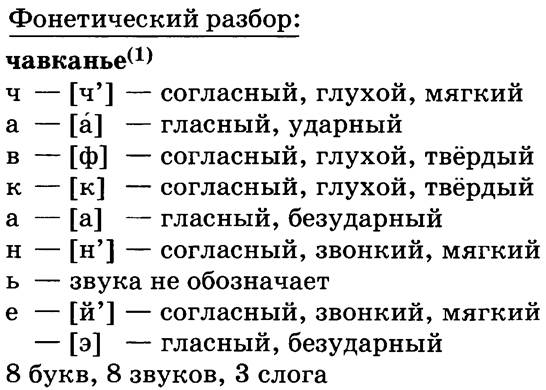

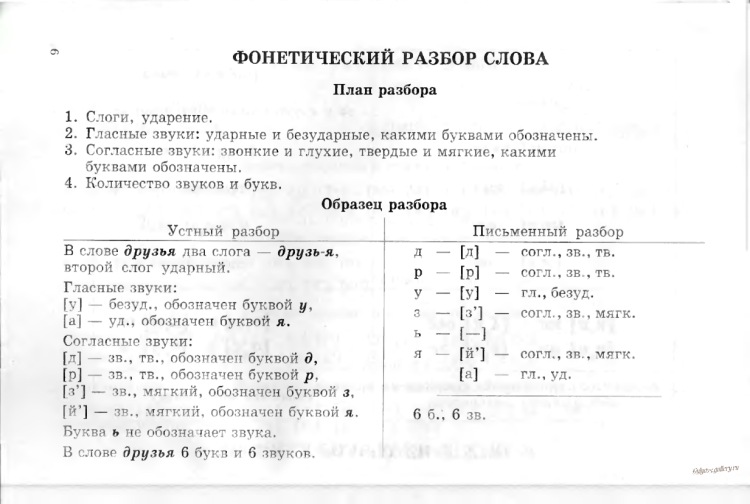

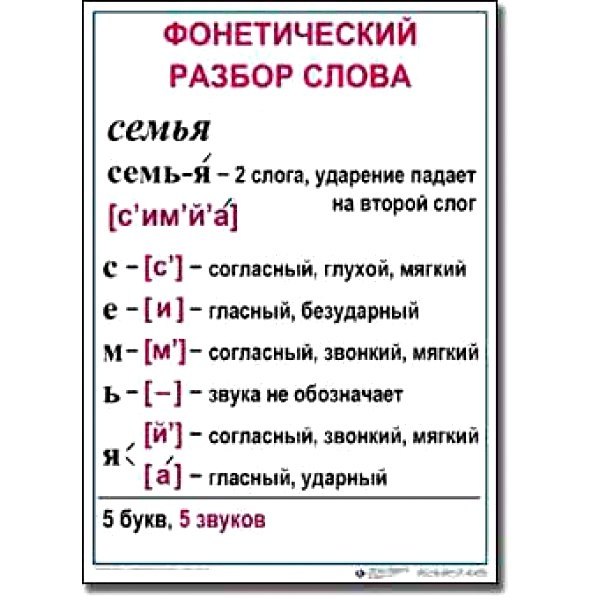

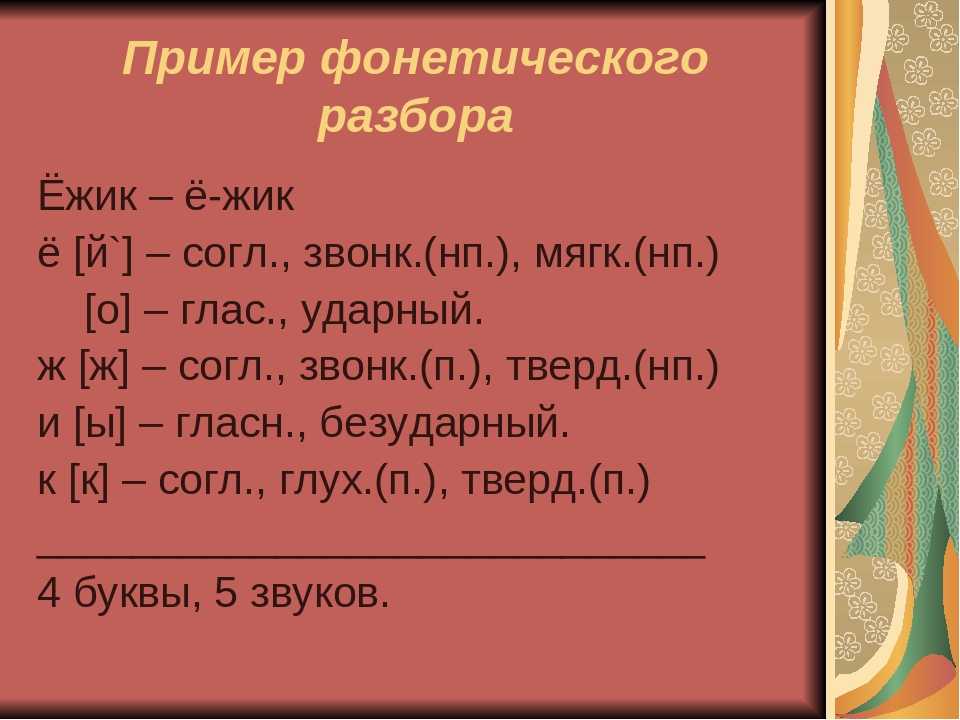

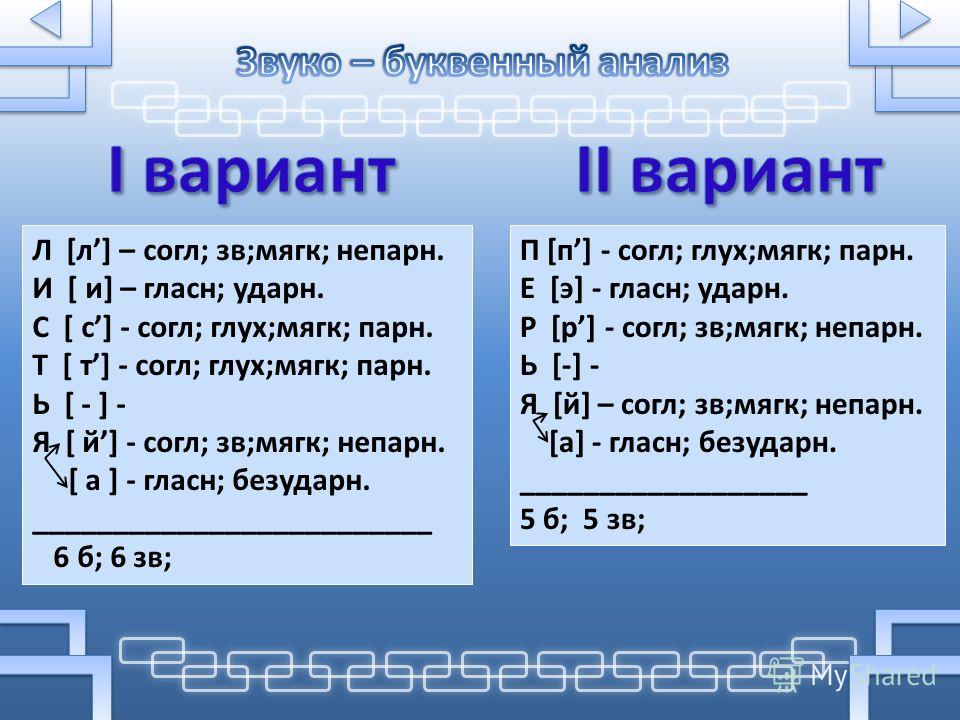

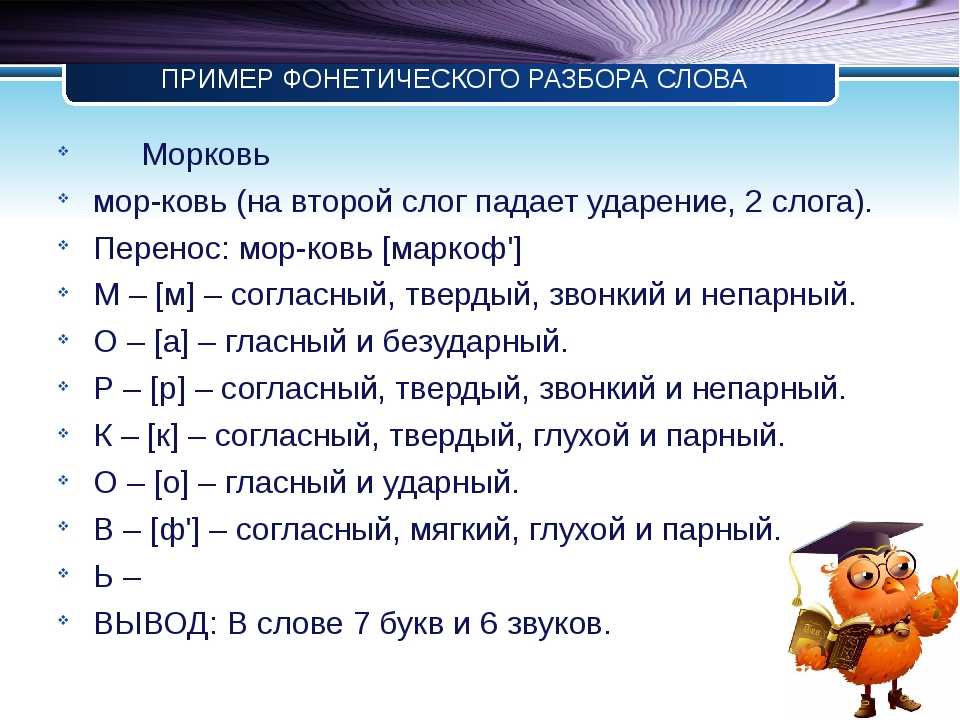

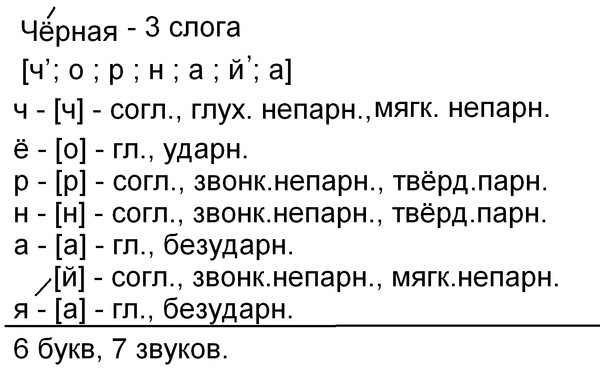

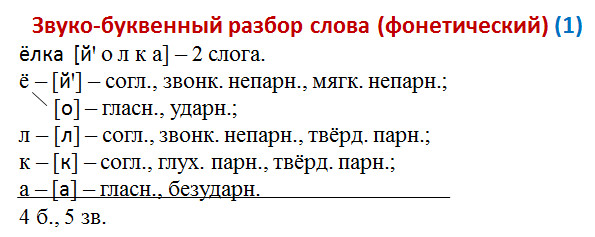

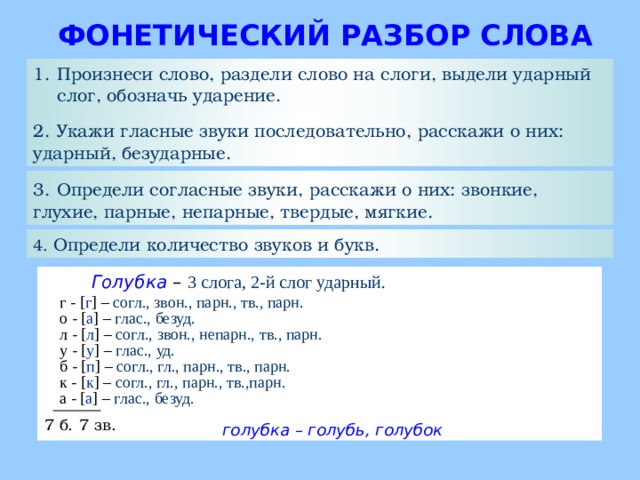

Фонетический разбор слова «аркадьевич» на буквы и звуки (Звуко-буквенный)

| Буква | Звук | Характеристики звука | Цвет |

|---|---|---|---|

| а | [а] | гласный, безударный | а |

| р | [р] | согласный, звонкий непарный (сонорный), твёрдый | р |

| к | [к] | согласный, глухой парный, твёрдый, шумный | к |

| а | [`а] | гласный, ударный | а |

| д | [д’] | согласный, звонкий парный, мягкий | д |

| ь | — | не обозначает звука | ь |

| е | [й’] | согласный, звонкий непарный (сонорный), мягкий | е |

| [и] | гласный, безударный | ||

| в | [в’] | согласный, звонкий парный, мягкий | в |

| и | [и] | гласный, безударный | и |

| ч | согласный, глухой непарный, мягкий, шипящий | ч |

Число букв и звуков:

На основе сделанного разбора делаем вывод, что в слове 10 букв и 10 звуков.

Буквы: 4 гласных буквы, 5 согласных букв, 1 буква не означает звука.

Звуки: 4 гласных звука, 6 согласных звуков.

Как правильно пишется слово «аркадьевич»

Правописание слова «аркадьевич»

Орфография слова «аркадьевич»

Правильно слово пишется:

Нумерация букв в слове

Номера букв в слове «аркадьевич» в прямом и обратном порядке:

Ассоциации к слову «аркадьевич»

Ариадна

Тётя

Вениамин

Аркадия

Наум

Карп

Макар

-

Герасимов

Ефим

Ярослава

Леонид

Аркан

Геннадий

Трусов

Алла

Назаров

Борис

Вячеслав

Леонида

Серафима

Маня

Аркаша

Рудольф

Федоров

Полина

Самуил

Данило

Феодосий

Александрович

Клим

Вадим

Петр

Зинаида

Зина

Изольда

Семен

Исаак

Анатолий

Лаврентий

Людмила

Нина

Спарта

Никитин

Степан

Вадима

Михайло

Сергей

Валерий

Яков

Арон

Высоцкий

Сценарист

Антоно

Эдуард

Данила

Ирина

Галина

Дмитрий

Георги

Марков

Софья

Пастухов

Публицист

Михаил

Поляков

Константин

Денис

Аполлон

Абрам

Брежнев

Светлов

Юлиан

Татьяна

Регина

Виктор

Суворов

Николай

Георгий

Натан

Гермес

Петра

Юлий

Игнатий

Первенец

Протоиерей

Лизавета

Шевченко

Драматург

Евгений

Далила

Кинорежиссёр

Член-корреспондент

Илья

Клава

Вася

Педагог

Васильев

Пастух

Мамонтовый

Долгорукий

Опубликовано: 2020-10-02

Популярные слова

воспитанник , беседами , взбежавшие , взъерошив , выскребу , высчитанною , вытравлявшей , вячеславом , гемолизом , геннадиевичи , гимнастерочку , домоустройство , завибрируют , завинчивающимся , павлиньего , парабеллумами , парковавшемся , перебираемыми , плакатная , подающее , подлетать , подросту , положительнейшего , помпонах , поохотившимся , пражского , прогульном , прокашливаться , проституируя , противогазовые , развернувшее , разделе , раскрутилось , раскусывают , расторгну , резервированного , реорганизовавшем , респонсорною , сильванер , солея

Предложение со словом «мели»

1

Мели, Емеля, – усмехнулся Аркаша, – мели, мели.

Второй после Солнца. Часть вторая, Игорь Белладоннин, 2001г.

2

Мели, мели, Комариха, – устало отмахнулся Кузьма.

Деньги для Марии. Последний срок. Рассказы (сборник), Валентин Распутин, 2018г.

3

Вот только чистота оставляла желать лучшего: видимо, дворники не мели или мели нерегулярно.

Под псевдонимом Серж, Владимир Каржавин, 2018г.

4

Мели не мели, а я чувствую, что пребываю на земле свои последние денечки.

Деревня, хранимая Богом, Валентина Батманова, 2008г.

5

По его бескрайней равнине с мётлами наперевес рыскали курсанты и мели, мели, пока не наступала зима и не начинали

Садгора, Артур Викторович Марьясов, 2020г.

6

Огромные голубовато-серебристые рыбины с шумом заплескались на мели и наперебой запрыгали из воды, пытаясь выскочить из невода.

Амур-батюшка, Николай Задорнов, 1946г.

7

Горбатые, ослабевшие рыбины плескались на мели, хватая друг друга зубастыми пастями.

Амур-батюшка, Николай Задорнов, 1946г.

8

Над его широкими торосистыми просторами мели сухие леденящие юго-западные ветры.

Амур-батюшка, Николай Задорнов, 1946г.

9

На середине реки топорщились глыбы битого льда, нагроможденного на мели и вмерзшего во время рекостава.

Амур-батюшка, Николай Задорнов, 1946г.

10

Еще вчера Фрам сам сидел на мели и не знал, что делать.

Звездный билет (сборник), Василий Аксенов

11

Упражняясь в сведении нашего судна с мели, как то мы думали, мы не приметили, что ветр между тем почти совсем утих.

Путешествие из Петербурга в Москву, Александр Радищев, 1790г.

12

Уже на реке появились песчаные мели, и «Прогресс» маневрировал, чтобы не сесть на них.

Город Эн (сборник), Леонид Добычин

13

там мели и камни таятся на дне морском.

Бедная Лиза (сборник), Николай Карамзин, 1792г.

14

Пустого не мели, – отрезал Патап Максимыч.

В лесах, Павел Мельников-Печерский, 1871-1874г.

15

Не мели пустяков, – молвила Настя.

В лесах, Павел Мельников-Печерский, 1871-1874г.

16

Волгу надо расчистить: мели да перекаты больно народ одолевают…

В лесах, Павел Мельников-Печерский, 1871-1874г.

17

Болтай, болтай, профессор, ничего не будет, мели, знай!

Хозяин, Максим Горький, 1913г.

18

Ты мели да помалывай серячок, а мы белую мучку будем делать, даст бог.

Хлеб, Дмитрий Мамин-Сибиряк, 1895г.

19

Роэна и Элли принимали участие в судьбе молоденькой чахоточной портнихи Мели Скорт, затеяв отправить ее лечиться на морской берег Ахуан-Скапа.

Дорога никуда, Александр Грин, 1929г.

20

Мели явилась незадолго перед тем, как вошел Давенант.

Дорога никуда, Александр Грин, 1929г.

21

Его белый костюм не обманул проницательность Мели Скорт.

Дорога никуда, Александр Грин, 1929г.

22

Познакомьтесь, Тиррей Давенант, с Мели Скорт.

Дорога никуда, Александр Грин, 1929г.

23

Рой стала шептать ей на ухо, и Мели покраснела, а Давенант расслышал окончание шепота: «…раскройте сумочку».

Дорога никуда, Александр Грин, 1929г.

24

Должно быть, перемена погоды, – сказала Мели.

Дорога никуда, Александр Грин, 1929г.

25

Очень неровный климат, – продолжала Мели.

Дорога никуда, Александр Грин, 1929г.

26

Не обращая внимания на ее тревогу, Элли подошла к Мели Скорт и присела.

Дорога никуда, Александр Грин, 1929г.

27

Мели, скажите ей, что когда вы были больны, то не вскакивали в этаком кимоно!

Дорога никуда, Александр Грин, 1929г.

28

Желаю вам быстро поправиться, – сказала Роэна, прощаясь с Мели Скорт.

Дорога никуда, Александр Грин, 1929г.

29

Бледная, белокурая, с усталым счастливым лицом, Мели Скорт сказала Тиррею:

Дорога никуда, Александр Грин, 1929г.

30

Он расстался с Мели на углу, не понимая, что она ему говорит, и тотчас забыв о ней.

Дорога никуда, Александр Грин, 1929г.

31

А ты лишняго-то не мели, сказывай, кто таков?

Княжна Тараканова и принцесса Владимирская (сборник), Павел Мельников-Печерский

32

волна реакции отхлынет, и я не поздравляю тех раков, которые останутся на мели.

Об отцах и детях и о г-не Чехове, Николай Михайловский, 1892г.

33

Яро они, яро копьями потрясали – сугробы мечами мели, мечами.

Кубок метелей, Андрей Белый, 1907г.

34

Карча подплыла к мели, остановилась и странно зашевелилась.

Полное собрание сочинений. Том 6. Казаки, Лев Толстой, 1852-1862г.

35

Пускай поживет сначала у меня, а потом устроим ему место или концерт, стащим его с мели, а там видно будет.»

Полное собрание сочинений. Том 5. Произведения 1856–1859 гг., Лев Толстой, 1856-1859г.

36

Под его руководством сестры послушницы мели двор и дорожки кладбища, а также наблюдали за могилами.

Людоедка, Николай Гейнце, 1898г.

37

А ты, Гриша, пустого-то не мели.

Брынский лес, Михаил Загоскин, 1846г.

38

Здесь также нет пристани, как и на Мадере, шлюпка не подходит к берегу, а остается на песчаной мели, шагов за пятнадцать до сухого места.

Фрегат «Паллада», Иван Гончаров

39

«Мы на мели?» — спросил я деда.

Фрегат «Паллада», Иван Гончаров

40

Вы только подумайте, чего стоит снять с мели одну барку в полую воду, когда по реке идет еще лед?

Уральские рассказы, Дмитрий Мамин-Сибиряк

41

Отчего сплавщики не заведут себе карты Чусовой, чтобы удобнее было запомнить течение, мели, таши и повороты?

Уральские рассказы, Дмитрий Мамин-Сибиряк

42

уговаривал Радунского Розанчук, – опамятуйся, не мели пустого…

Княжна, Александр Амфитеатров, 1896г.

43

да царь тогда поверил ляхам, Богдан и остался як рак на мели, та по самой середине Днепра: ни к русским, ни к ляхам!

Бояре Стародубские. На заре (сборник), А. В. Щепкина, 1896, 1898г.

На заре (сборник), А. В. Щепкина, 1896, 1898г.

44

Тяжелыми, рваными прыжками, топя ноги в твердом снегу, козы мели через протоку прямо на него.

Живи и помни (сборник), Валентин Распутин, 1974, 1976, 1985г.

45

Юнаков принял на себя командование, снял поврежденную лодку с мели и привел ее на базу.

Офицер флота, Александр Крон

46

Немногие такие мели, как вершина Масельгского хребта, выглядывали с поверхности ледникового моря.

В краю непуганых птиц (сборник), Михаил Пришвин, 1907г.

47

Работою подземных сил из воды выдвигались все новые и новые мели, а льдины оставляли на них холмы ледникового наноса.

В краю непуганых птиц (сборник), Михаил Пришвин, 1907г.

48

Иногда вода совершенно размывала остров, и деревья не могли поселиться на голых камнях, – это мели, сухие луды.

В краю непуганых птиц (сборник), Михаил Пришвин, 1907г.

49

Бились долго, но «Орел» продолжал упрямо сидеть на мели.

Цусима, Алексей Новиков-Прибой, 1932г.

50

На рассвете 19 сентября «Орел» снялся с мели и направился в Ревель.

Цусима, Алексей Новиков-Прибой, 1932г.

51

Некоторые корабли, поворачиваясь на канатах, приткнулись к мели.

Цусима, Алексей Новиков-Прибой, 1932г.

52

Мели их, чистили и никому не отдавали даже под самый день праздника.

Неразменный рубль: Повести и рассказы, Николай Лесков

Хотите добавить свое предложение к слову «мели»?

Ваше предложение

- Синонимы к слову «мели»

Arkash Значение, произношение, происхождение и нумерология

To Enlighten, Lighten Up, To Enlighten

Пример: Александр Алекс-ан-дер

Голосовое произношение:

Нажмите и прослушайте несколько раз аудиопроизношение и научитесь произносить имя Аркаш.

Можешь лучше произнести? Или с другим акцентом?

Запись Произношение

| Тип | Мальчик SelectBoyGirlUnisex |

|---|---|

| Происхождение | 1 |

| Используется | индийский индус тамильский |

личность имени Аркаш по астрологии и нумерологии

Анализ талантов

Аркаш по номеру выражения 22 «Ты мастер-строитель. Вы обладаете уникальным даром воспринимать что-то в архетипическом мире — бесконечном и божественном — и делать некое подобие этого проявленным на земле. Вы мечтаете о большом. Каждая ваша цель огромна по своим масштабам. Вы мечтаете создать что-то, что прослужит века. Ваше желание изменить историю. Вы хотите оставить свой след в человеческой цивилизации. Нет предела ни тому, на что вы способны, ни тому, что вы мечтаете сделать. Из всех чисел ваше обладает наибольшим потенциалом для достижений.

Внутренний анализ

Аркаш наизусть число 2«Вы хотите мира и гармонии во всех аспектах своей жизни. Вы хотите посвятить свою жизнь кому-то или чему-то. Вы легко влюбляетесь. Вы чрезвычайно чувствительны и эмоциональны. Вы можете быть сентиментальным и плакать над грустными историями. Вам нужны друзья и общество. Вы цените тонкости жизни. Вы желаете комфорта и безопасности».

Анализ личности

Аркаша по числу личности 2«Вы кажетесь дружелюбным и неприхотливым. У вас мягкая и теплая внешность. Другие воспринимают вас как нежную, безопасную гавань. Люди тянутся к вам, потому что, среди прочего, вы кажетесь теплым и безобидным. Ваше платье опрятное и чистое. Ваша одежда должна быть удобной, мягкой и струящейся. Следует избегать простой и неброской одежды. Постарайтесь быть немного смелее и привлекательнее в своем внешнем виде».

Чтобы получить более подробные показания нумерологии на основе даты вашего рождения, посетите наш нумерологический калькулятор.

Arkash name Lucky analysis

| Lucky Numbers | 6,8 and 9 | ||||||||||||||||||||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Lucky Gemstone | Coral | ||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Lucky Colors | Blue, Blue-green | ||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Счастливые дни | Пятница, вторник и суббота | ||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Личные качества | Первичная энергия. Самоутверждение. Смелость и инициатива. Предприятие и приключения | ||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Совместимый с Zodiac | Gemini, Leo, Sagittarius, Aquarius | ||||||||||||||||||||||||||||||||||||||||||||||||||||||

| . Сложно Zodiac | Taurus, CANCE, Virgo, Scorpio | Taurus, CANCE, Virgo, Scorpio | Taurus, Virgo, Scorpio | , CANCORN.

Хотите новое значение букв в Аркаше? Аркаш Имя Изображение Поделитесь этой страницей с хэштегом #MeaningOfMyName и предложите своим друзьям поделиться значением своего имени. Arkash Name Причудливые стили текстаВы можете использовать эти причудливые стильные тексты для имени своего профиля, статусов, сообщений в большинстве социальных сетей, таких как WhatsApp, Twitter, Facebook, Instagram и других.

Как выше, 30+ модных текстовых стилей, доступных для названия ARKASH . Перейти и проверить все стили для большего удовольствия! Мы запланировали несколько интересных обновлений для нашего веб-сайта и имени Аркаш. Чтобы быть в курсе наших обновлений, следите за нами в Facebook, Twitter и Pinterest Follow NamesLook on Facebook Популярные народы на Аркаше Имя В настоящее время народы не найдены! Вас зовут Аркаш или если вы знаете людей по имени Аркаш, добавьте его в список. Добавить людей по имени АркашВаш адрес электронной почты Имя человека Профессия человека Страна Город-государство О тебе / нем / ней Автоматическая генерация произношения с использованием полуконтролируемых глубоких нейронных сетей1 ВведениеДля разработки автоматического распознавания речи (ASR) на основе фонем обычно требуются три основных ресурса: транскрибированные акустические данные для оценки акустической модели, текстовые данные для оценки языковой модели и словарь произношения для сопоставления слов с последовательностями единиц подслов. Ручная подготовка таких ресурсов требует значительных инвестиций и опыта. Поэтому для многих диалектов и языков явно требуется автоматическое создание словаря произношения на основе данных. Разработка ASR для диалектов и языков с ограниченными ресурсами за последние несколько лет привлекла все большее внимание [1, 2, 3] . Лу и др. [8] предложил генератор словарей, управляемый данными, для включения новых произношений, основанных на новых акустических свидетельствах. Гоэль и др. в [9] использовать подход графемы к фонеме, чтобы угадать произношение и итеративно уточнить акустическую модель и словарь. Однако эти методы по-прежнему требуют наличия качественного словаря исходного произношения, созданного экспертом. В современных ASR слова представлены более мелкими единицами подслов, такими как фонемы, а словарь произношения отображает слова в последовательности единиц подслов. [10] . Например, телефонная речь, в которой отфильтрованы высокочастотные компоненты, требует модифицированного словаря с немного другим набором фрикативов, чем полнополосная речь. За последние несколько лет было предпринято несколько попыток выйти за рамки единиц подслов, основанных на фонемах, путем совместного изучения набора единиц подслов и их соответствующего словаря непосредственно из предоставленных данных [11, 12, 8] .

Баккиани и Остендорф [12] предложил итеративный подход акустической сегментации и кластеризации для построения единиц подслов из речевых сигналов и последующего создания словаря на основе оцененных единиц подслов. Сингх и др. [8] представил стратегию «разделяй и властвуй» для рекурсивного обновления блоков подслов и словаря. Основное внимание в этой статье уделяется разработке ASR на основе автоматически сгенерированного словаря, который превосходит обычно используемые ASR на основе фонем. В то время как большинство решений, предложенных для нахождения произношения, основанного на множественных произнесениях слова, являются эвристиками n-лучших типов [8, 13, 14] , в этой статье мы используем аппроксимацию K-мерного алгоритма Витерби предложенный в наших предыдущих работах [15, 10] . Этот подход дает нам оценки произношения с максимальным правдоподобием. Это высококачественное произношение является одним из ключевых факторов, позволяющих превзойти ASR на основе фонем. Кроме того, чтобы выучить правильные единицы подслов, мы объединяем силу смешанных моделей Гаусса (GMM) и акустического моделирования на основе глубокой нейронной сети (DNN). Напоминание об этой статье организовано следующим образом. Предлагаемая структура и ее компоненты для объединенных подсловных единиц и изучения словаря представлены в Разделе 2. 2 Полууправляемый совместный словарь и изучение акустической модели2.1 ФреймворкВ оставшейся части этой статьи мы называем управляемые данными единицы подслов абстрактными акустическими элементами (ААЭ), в отличие от телефонов. Наша цель — совместно изучить словарь произношений d∗={ω1,⋯,ωL} из L произношений ωi и N моделей AAE λ∗={A1,⋯,AN}, которые максимизируют совместную вероятность:

где X=(X1,⋯,XM) — множество обучающих высказываний, T=(T1,⋯,TM) — множество соответствующих орфографических транскрипций, M — количество высказываний, Λ — вселенная всех возможных наборов N AAE, а D — это совокупность всех словарей, отображающих слова в последовательности AAE.

Сложно найти оптимальное решение задачи оптимизации в (1) из-за ее сложной нелинейной природы.

Поскольку произношение каждого слова можно оценить независимо от других слов, словарную оценку в (2) можно разложить на L оценок максимального правдоподобия следующим образом:

где Ωl — множество индексов произнесений слова Wl, Sj — последовательность ААЕ, а Sω — множество всех возможных последовательностей ААЕ произношения ω. Например, в Sω, если произношение ω=A1A2A3, некоторые образцы в Sω могут быть A1A1A1A2A3, A1A2A2A3A3 и A1A1A2A3A3A3. Ограничение в (4) подразумевает, что все последовательности AAE должны быть образцами одного и того же произношения. Совместный словарь и структура обучения AAE показаны на рис. 1 и вкратце описаны ниже: 1: i=0 // Инициализация моделей ААЭ λ0 (раздел 2.2) 2: Кластеризация акустического пространства. 3: Смоделируйте каждый кластер с помощью GMM и задайте как λ0. 4: в то время как (производительность улучшится) do 5: Данные модели AAE λi, обновите словарь di путем максимизации кратного совместного правдоподобия высказывания (раздел 2.3). 6: По заданному словарю di удвоить количество смесей и обновить модели AAE λi+1 (раздел 2.4). 7: i ←i+1 8: end while 9: Замените GMM на DNN и обучите модель AAE, используя метки, полученные HMM-GMM (раздел 2.4). 10: в то время как (производительность улучшена) do 11: Для моделей AAE λi обновить словарь di, максимизировав совместную вероятность нескольких высказываний. 12: По заданному словарю di повторно обучить модели AAE λi+1 на основе DNN (раздел 2.4). 13: i ←i+1 14: end while Алгоритм 1 Совместные ААЭ с полуучителем и изучение словаря2.2 Инициализация акустической модели Исходные модели ААЭ можно просто получить путем кластеризации акустического пространства. с мерой квадратичной ошибки для кластеризации векторов акустических признаков. Алгоритм кластеризации LBG имеет тенденцию назначать больше векторов кодовой книги областям с высокой плотностью, что является полезным свойством для получения различающих начальных AAE. Затем каждый кластер моделируется с помощью GMM с одним гауссовским компонентом. Эти модели используются в качестве исходных моделей для ААЭ. 2.3 Поколение словаря Решение (4), предложенное в [15] , является расширением стандартного одномерного алгоритма Витерби на K измерений. K-мерный алгоритм Витерби вычисляет наиболее вероятную последовательность состояний HMM, которая является общей для K заданных высказываний. Хотя этот алгоритм является строгим, его сложность растет экспоненциально с увеличением количества высказываний, что, следовательно, делает невозможным его применение к более чем нескольким высказываниям. 2.4 Акустическое моделирование После обновления словаря все высказывания декодируются на основе нового произношения слов в словаре, а AAE повторно оцениваются в соответствии с новыми метками.

AAE можно смоделировать с помощью широко используемых моделей, таких как HMM/GMM или HMM/DNN. Однако в начале обучающей итерации модель и словарь недостаточно точны и с большей вероятностью застрянут в плохом локальном оптимуме, если степень свободы модели слишком высока. L с регуляризацией l1 с использованием обратного распространения:

где xij∈Xi — j-й вектор признаков i-го высказывания, yij — соответствующая метка, а W — набор сетевых параметров соответственно. 3 экспериментаМы провели несколько серий экспериментов на корпусе TIMIT [19] . Корпус TIMIT содержит подготовленный вручную словарь и транскрипции на уровне телефонов с 61 телефоном. В качестве базового уровня была обучена 61 модель телефона с использованием словаря TIMIT и предоставленных транскрипций. В качестве дескрипторов акустического пространства мы использовали 12 мел-частотных кепстральных коэффициентов (ККК) и энергии с их дельтами и дельта-дельтами. Речевые данные анализировали с использованием окна Хэмминга 25 мс со сдвигом кадра на 10 мс. Мы оценили модели DNN-HMM, GMM-HMM и AAE на основе телефонов в качестве базовых. Архитектура DNN состояла из 7 скрытых слоев. Первый скрытый слой имел 2048 узлов, следующие 5 слоев имели 1024 узла, а количество узлов на последнем слое было равно количеству прогнозируемых состояний HMM. Все скрытые слои были снабжены нелинейностью Rectified Linear Unit (ReLU) [20] . 3.1 Изолированное распознавание слов Первая серия экспериментов была посвящена распознаванию отдельных слов, чтобы проверить эффективность предложенных методов и изучить влияние гиперпараметров, таких как количество компонентов смеси и количество AAE.

Для совместной оценки произношения и обучения акустических моделей мы собрали набор для обучения произношению, состоящий из слов с более чем 10 высказываниями из набора для обучения TIMIT. 3.1.1 Сравнение с фонетическим подходом Частота ошибок в словах (WER) для каждого метода показана в таблице 1. Результаты показывают, что предлагаемый метод, основанный на данных, явно превосходит базовые методы. Предложенный метод AAE-DNN достиг улучшений на 10,3% и 2,4% по сравнению с фонетико-акустическими моделями на основе GMM и DNN соответственно. Это говорит о том, что более точный словарь и лучшие акустические модели могут быть получены непосредственно из обучающих данных без участия человека. 3.1.2 Количество AAE Наш второй эксперимент был сосредоточен на влиянии количества AAE, т. е. N. Мы обучили словарь и модели AAE с N = 64 128 192 256 320 384 448. Частота ошибок в словах моделей AAE на основе DNN и GMM показана на рисунке 2. Количество смесей GMM было определено экспериментально, как показано в таблице 2. Для моделей AAE на основе DNN наилучший результат достигается с 384 AAE по сравнению с с 320 AAE для моделей на базе GMM. Интересно, что оптимальное количество состояний AAE намного превышает количество состояний моделей телефонов (61 фонема × 3 состояния = 183 состояния). 3.2 Непрерывное распознавание речи В отличие от ASR на основе фонем, предлагаемый подход на основе AAE не зависит от лингвистических знаний. Поэтому интересно сравнить эти подходы с реальной задачей непрерывного распознавания речи (CSR). Таблица 3 показывает, что предлагаемый подход на основе AAE-DNN значительно превосходит базовые методы в обоих сценариях. Повышение производительности по сравнению с методом HMM-DNN на основе телефона в сценариях с языковой моделью и без нее составило 10,68% и 5,11% соответственно. 4 вывода В этой работе мы предложили новый совместный словарь и структуру обучения единицам подслов для ASR. Предлагаемый метод не требует лингвистических знаний и позволяет автоматически создавать набор подсловных единиц и соответствующий словарь произношений. Каталожные номера

|

Добавить людей по имени Аркаш

Добавить людей по имени Аркаш Основной проблемой разработки ASR для доменов с ограниченными ресурсами является создание надежного словаря произношения из ограниченных доступных ресурсов. Однако для основных языков обычно уже имеется канонический словарь произношения. Однако такие словари могут быть подвержены ошибкам из-за того, что они создаются вручную и в большинстве случаев не охватывают варианты произношения. Было несколько попыток решить эти проблемы [4, 5, 6, 7] .

Основной проблемой разработки ASR для доменов с ограниченными ресурсами является создание надежного словаря произношения из ограниченных доступных ресурсов. Однако для основных языков обычно уже имеется канонический словарь произношения. Однако такие словари могут быть подвержены ошибкам из-за того, что они создаются вручную и в большинстве случаев не охватывают варианты произношения. Было несколько попыток решить эти проблемы [4, 5, 6, 7] . Однако подсловные единицы не обязательно должны быть лингвистически мотивированными элементами.

На самом деле, учитывая набор акустических образцов, лингвистически определенные единицы, скорее всего, не оптимальны для распознавания речи

Однако подсловные единицы не обязательно должны быть лингвистически мотивированными элементами.

На самом деле, учитывая набор акустических образцов, лингвистически определенные единицы, скорее всего, не оптимальны для распознавания речи Вычисление словаря было выполнено с помощью алгоритма типа n-best, который, как известно, дает субоптимальные решения. Хотя их подход демонстрирует некоторые многообещающие результаты, производительность все еще несопоставима с ASR на основе фонем.

Вычисление словаря было выполнено с помощью алгоритма типа n-best, который, как известно, дает субоптимальные решения. Хотя их подход демонстрирует некоторые многообещающие результаты, производительность все еще несопоставима с ASR на основе фонем. Мы формулируем эту проблему как пример полууправляемого процесса самообучения. Воспользовавшись надежностью скрытых марковских моделей (HMM) с распределением вероятности наблюдения на основе GMM по отношению к ошибкам маркировки, мы обучаем первый набор единиц подслов и выводим первый набор произношений. Затем мы используем этот словарь для перемаркировки данных и используем более высокую выразительность DNN для улучшения моделирования единиц подслов и словаря в итеративном процессе. В каждом раунде итерации создается новый словарь, и с помощью этого нового словаря данные перемаркируются. Эти данные снова используются для обучения DNN. Как показали эксперименты, предлагаемые результаты обеспечивают абсолютное улучшение более чем на 10% по сравнению с подходом, основанным на фонемах, на данных TIMIT в задаче непрерывного распознавания речи.

Мы формулируем эту проблему как пример полууправляемого процесса самообучения. Воспользовавшись надежностью скрытых марковских моделей (HMM) с распределением вероятности наблюдения на основе GMM по отношению к ошибкам маркировки, мы обучаем первый набор единиц подслов и выводим первый набор произношений. Затем мы используем этот словарь для перемаркировки данных и используем более высокую выразительность DNN для улучшения моделирования единиц подслов и словаря в итеративном процессе. В каждом раунде итерации создается новый словарь, и с помощью этого нового словаря данные перемаркируются. Эти данные снова используются для обучения DNN. Как показали эксперименты, предлагаемые результаты обеспечивают абсолютное улучшение более чем на 10% по сравнению с подходом, основанным на фонемах, на данных TIMIT в задаче непрерывного распознавания речи. В Разделе 3 демонстрируются экспериментальные результаты, и, наконец, выводы обобщаются в Разделе 4.

В Разделе 3 демонстрируются экспериментальные результаты, и, наконец, выводы обобщаются в Разделе 4. Таким образом, она разбивается на две более простые задачи оптимизации, которые можно решать итеративно.

Таким образом, она разбивается на две более простые задачи оптимизации, которые можно решать итеративно. Для случая, когда λ моделируется HMM слева направо без пропусков, что является наиболее распространенной топологией в ASR на основе HMM, решение (4) было предложено в 9.0281 [15] (Подробности в разделе 2.3.).

В (3), поскольку словарь фиксирован, задача приводит к оценке общей акустической модели с учетом словаря. Однако метки, переназначаемые с использованием оценочного словаря, очень зашумлены, поскольку словарь автоматически оценивается на основе данных без какого-либо контроля со стороны экспертов. Следовательно, на ранней стадии итерации обучения требуется надежная модель, в то время как более выразительная и мощная модель, такая как DNN [16, 17] , может использоваться после получения надежного словаря.

Для случая, когда λ моделируется HMM слева направо без пропусков, что является наиболее распространенной топологией в ASR на основе HMM, решение (4) было предложено в 9.0281 [15] (Подробности в разделе 2.3.).

В (3), поскольку словарь фиксирован, задача приводит к оценке общей акустической модели с учетом словаря. Однако метки, переназначаемые с использованием оценочного словаря, очень зашумлены, поскольку словарь автоматически оценивается на основе данных без какого-либо контроля со стороны экспертов. Следовательно, на ранней стадии итерации обучения требуется надежная модель, в то время как более выразительная и мощная модель, такая как DNN [16, 17] , может использоваться после получения надежного словаря. // Запустите совместные AAE и изучение словаря

// Запустите совместные AAE и изучение словаря Акустическое пространство может быть описано любым признаком, если он достаточно информативен, чтобы различать разные слова.

Мы использовали алгоритм Линде-Бузо-Грея (LBG) [18]

Акустическое пространство может быть описано любым признаком, если он достаточно информативен, чтобы различать разные слова.

Мы использовали алгоритм Линде-Бузо-Грея (LBG) [18]  Эффективная аппроксимация K-мерного алгоритма Витерби была предложена в [10] , где задача найти совместное выравнивание и оптимальную общую последовательность для K высказываний разложена на K−1 приложений двумерного алгоритма Витерби. Это приближение начинается с поиска наилучшего соответствия между двумя высказываниями. Затем, сохраняя выравнивание между уже обработанными высказываниями фиксированным, следующее высказывание выравнивается с этим эталонным высказыванием. Последовательность AAE окончательного мастер-высказывания является аппроксимацией K-мерного произношения Витерби.

Эффективная аппроксимация K-мерного алгоритма Витерби была предложена в [10] , где задача найти совместное выравнивание и оптимальную общую последовательность для K высказываний разложена на K−1 приложений двумерного алгоритма Витерби. Это приближение начинается с поиска наилучшего соответствия между двумя высказываниями. Затем, сохраняя выравнивание между уже обработанными высказываниями фиксированным, следующее высказывание выравнивается с этим эталонным высказыванием. Последовательность AAE окончательного мастер-высказывания является аппроксимацией K-мерного произношения Витерби. Чтобы избежать этой ситуации, начнем обучение с простой модели, а именно с одной гауссовской составляющей для каждого ААЭ с диагональной ковариационной матрицей. С каждой итерацией словарь становится более точным. Таким образом, количество компонентов смеси удваивается, чтобы увеличить мощность моделирования. Как только производительность достигает предела, GMM заменяется DNN, чтобы использовать более выразительные возможности моделирования. Этот процесс делает возможным полуконтролируемое обучение DNN и предотвращает его застревание в плохом локальном оптимуме.

Транскрипция на уровне состояния HMM получается путем принудительного декодирования с оптимизированным HMM-GMM и словарем. Эта транскрипция предоставляет метки для обучения DNN. DNN обучена оценивать апостериорные состояния HMM, минимизируя перекрестную потерю энтропии

Чтобы избежать этой ситуации, начнем обучение с простой модели, а именно с одной гауссовской составляющей для каждого ААЭ с диагональной ковариационной матрицей. С каждой итерацией словарь становится более точным. Таким образом, количество компонентов смеси удваивается, чтобы увеличить мощность моделирования. Как только производительность достигает предела, GMM заменяется DNN, чтобы использовать более выразительные возможности моделирования. Этот процесс делает возможным полуконтролируемое обучение DNN и предотвращает его застревание в плохом локальном оптимуме.

Транскрипция на уровне состояния HMM получается путем принудительного декодирования с оптимизированным HMM-GMM и словарем. Эта транскрипция предоставляет метки для обучения DNN. DNN обучена оценивать апостериорные состояния HMM, минимизируя перекрестную потерю энтропии ρ — постоянный параметр, который в данной работе принимается равным 10−6.

ρ — постоянный параметр, который в данной работе принимается равным 10−6. Входом в сеть было 11 непрерывных кадров MFCC. Сети обучались с использованием мини-пакетного градиентного спуска на основе обратного распространения с импульсом. Мы применили отсев [16] ко всем скрытым слоям с вероятностью отсева 0,5. Размер пакета был установлен на 128. HMM имели топологию слева направо, без пропуска с тремя состояниями для каждой фонемы, а не с одним состоянием для каждого AAE. HMM были обучены с использованием модифицированной версии HTK [21] , а DNN были реализованы с использованием Lasagne 9.0281 [22] .

Входом в сеть было 11 непрерывных кадров MFCC. Сети обучались с использованием мини-пакетного градиентного спуска на основе обратного распространения с импульсом. Мы применили отсев [16] ко всем скрытым слоям с вероятностью отсева 0,5. Размер пакета был установлен на 128. HMM имели топологию слева направо, без пропуска с тремя состояниями для каждой фонемы, а не с одним состоянием для каждого AAE. HMM были обучены с использованием модифицированной версии HTK [21] , а DNN были реализованы с использованием Lasagne 9.0281 [22] . Общее количество высказываний в наборе для тренировки произношения составило 12800.

После исключения слов, содержащих менее 4 символов (например, a и the), 339Отдельные слова были собраны из тестового набора TIMIT для задачи распознавания речи изолированных слов, в результате чего было получено в общей сложности 3900 высказываний.

Базовые модели телефонов на основе GMM были обучены 32 компонентам смеси.

Во время обучения модели AAE на основе GMM количество смесей удваивалось для каждой итерации, пока не достигло 128 смесей, как описано в разделе 2.4.

Общее количество высказываний в наборе для тренировки произношения составило 12800.

После исключения слов, содержащих менее 4 символов (например, a и the), 339Отдельные слова были собраны из тестового набора TIMIT для задачи распознавания речи изолированных слов, в результате чего было получено в общей сложности 3900 высказываний.

Базовые модели телефонов на основе GMM были обучены 32 компонентам смеси.

Во время обучения модели AAE на основе GMM количество смесей удваивалось для каждой итерации, пока не достигло 128 смесей, как описано в разделе 2.4. Более того, метод AAE-DNN повышает производительность на 3,2% по сравнению с методом AAE-GMM. Это указывает на то, что DNN была успешно обучена полуконтролируемым образом, и окончательная модель могла эффективно использовать свои выразительные возможности моделирования.

Более того, метод AAE-DNN повышает производительность на 3,2% по сравнению с методом AAE-GMM. Это указывает на то, что DNN была успешно обучена полуконтролируемым образом, и окончательная модель могла эффективно использовать свои выразительные возможности моделирования. Это указывает на то, что предлагаемый подход, основанный на данных, для совместного создания единиц подслов и словаря моделирует акустическое пространство более точно, чем лингвистически мотивированные фонетические единицы и словарь, разработанный вручную. Также стоит отметить, что оптимальное количество моделей ААЭ на основе DNN было больше, чем моделей на основе GMM.

Возможно, это связано с тем, что DNN обучалась избирательно, что позволяло эффективно моделировать взаимодействие между большим количеством AAE.

Это указывает на то, что предлагаемый подход, основанный на данных, для совместного создания единиц подслов и словаря моделирует акустическое пространство более точно, чем лингвистически мотивированные фонетические единицы и словарь, разработанный вручную. Также стоит отметить, что оптимальное количество моделей ААЭ на основе DNN было больше, чем моделей на основе GMM.

Возможно, это связано с тем, что DNN обучалась избирательно, что позволяло эффективно моделировать взаимодействие между большим количеством AAE. Для этой цели мы использовали

SX записи корпуса TIMIT, который содержит 450 предложений, произнесенных 7 говорящими, то есть всего 3150 высказываний. Мы подготовили тестовый набор, случайным образом выбрав и отложив одного говорящего для каждого предложения из записей SX, и использовали оставшиеся образцы в качестве обучающего набора (450 предложений × 6 говорящих = 2700 высказываний). Мы также включили в обучающую выборку записи SA и SI корпуса TIMIT.

Количество ААЭ составило 384. Количество компонентов смеси в моделях телефонов на базе GMM — 64.

Производительность оценивалась в двух сценариях: с языковой моделью и без нее. Языковая модель, используемая в базовой линии и предлагаемых методах, представляет собой простую биграммную модель.

Для этой цели мы использовали

SX записи корпуса TIMIT, который содержит 450 предложений, произнесенных 7 говорящими, то есть всего 3150 высказываний. Мы подготовили тестовый набор, случайным образом выбрав и отложив одного говорящего для каждого предложения из записей SX, и использовали оставшиеся образцы в качестве обучающего набора (450 предложений × 6 говорящих = 2700 высказываний). Мы также включили в обучающую выборку записи SA и SI корпуса TIMIT.

Количество ААЭ составило 384. Количество компонентов смеси в моделях телефонов на базе GMM — 64.

Производительность оценивалась в двух сценариях: с языковой моделью и без нее. Языковая модель, используемая в базовой линии и предлагаемых методах, представляет собой простую биграммную модель. Результаты показывают, что предлагаемый словарь, управляемый данными, и модели AAE также полезны для CSR, и более точное представление речевых сигналов может быть изучено автоматически.

Мы заметили, что все 384 AAE фактически использовались в обученном словаре, и словарь, как правило, назначал 39На % больше состояний HMM в среднем для каждого слова по сравнению с фонетическим словарем TIMIT. Это означает, что в AAE вероятность пребывания в состоянии меньше, что приводит к более частым переходам между состояниями. Это говорит о том, что с помощью ААЭ моделировалось акустическое пространство с более высоким разрешением. Это, следовательно, повысило точность произношения слов.

Результаты показывают, что предлагаемый словарь, управляемый данными, и модели AAE также полезны для CSR, и более точное представление речевых сигналов может быть изучено автоматически.

Мы заметили, что все 384 AAE фактически использовались в обученном словаре, и словарь, как правило, назначал 39На % больше состояний HMM в среднем для каждого слова по сравнению с фонетическим словарем TIMIT. Это означает, что в AAE вероятность пребывания в состоянии меньше, что приводит к более частым переходам между состояниями. Это говорит о том, что с помощью ААЭ моделировалось акустическое пространство с более высоким разрешением. Это, следовательно, повысило точность произношения слов. В нашем методе надежное произношение оценивается из нескольких произнесений с помощью эффективного приближения K-мерного алгоритма Витерби, который оценивает наиболее вероятную последовательность состояний HMM, общую для нескольких произнесений слова. Экспериментальные результаты показывают, что предлагаемый метод значительно превосходит методы на основе телефона, которые даже используют подготовленный вручную словарь и созданные вручную транскрипции в качестве входных данных. Мы дополнительно исследовали влияние количества единиц подслов, управляемых данными, и показали, что оптимальное количество единиц подслов намного выше, чем общее количество состояний HMM 61 телефона.

Будущие работы будут направлены на применение предложенного метода к распознаванию речи для языков с ограниченными ресурсами и задачам непрерывного распознавания речи с большим словарным запасом.

В нашем методе надежное произношение оценивается из нескольких произнесений с помощью эффективного приближения K-мерного алгоритма Витерби, который оценивает наиболее вероятную последовательность состояний HMM, общую для нескольких произнесений слова. Экспериментальные результаты показывают, что предлагаемый метод значительно превосходит методы на основе телефона, которые даже используют подготовленный вручную словарь и созданные вручную транскрипции в качестве входных данных. Мы дополнительно исследовали влияние количества единиц подслов, управляемых данными, и показали, что оптимальное количество единиц подслов намного выше, чем общее количество состояний HMM 61 телефона.

Будущие работы будут направлены на применение предложенного метода к распознаванию речи для языков с ограниченными ресурсами и задачам непрерывного распознавания речи с большим словарным запасом. Интерспич , 2015, стр. 1–5.

Интерспич , 2015, стр. 1–5.

199–206.

199–206.