Тест Разбор слова по составу по русскому языку онлайн

Последний раз тест пройден более 24 часов назад.

Для учителя

Вопрос 1 из 10

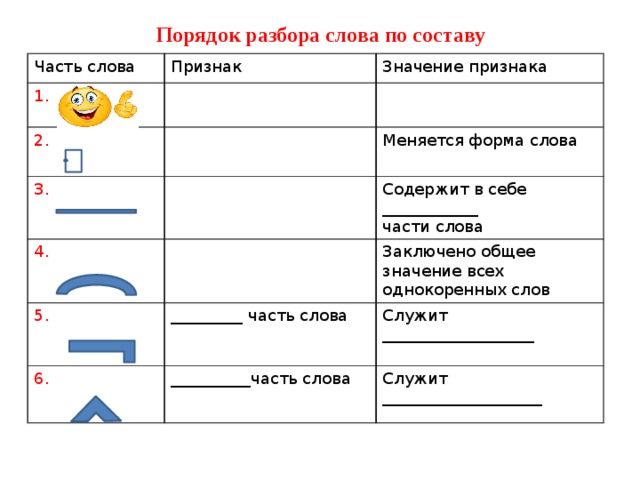

Что из нижеперечисленного не является морфемой (частью слова)

ПодсказкаПравильный ответ

Неправильный ответ

В вопросе ошибка?

Вопрос 2 из 10

При разборе в первую очередь надо найти

Корень

Основу

Окончание

Приставку

Правильный ответ

Неправильный ответ

В вопросе ошибка?

Вопрос 3 из 10

В слове может быть несколько

Корней

Суффиксов

Приставок

Все ответы верны

Неправильный ответ

В вопросе ошибка?

Вопрос 4 из 10

Найдите ошибочное утверждение

Приставка помогает образовывать новые слова

Окончание всегда стоит в самом конце слова

В слове может быть два окончания

Основа – это все слово без окончания

Правильный ответ

Неправильный ответ

В вопросе ошибка?

Вопрос 5 из 10

В слове «начаться» окончание

ПодсказкаПравильный ответ

Неправильный ответ

В вопросе ошибка?

Вопрос 6 из 10

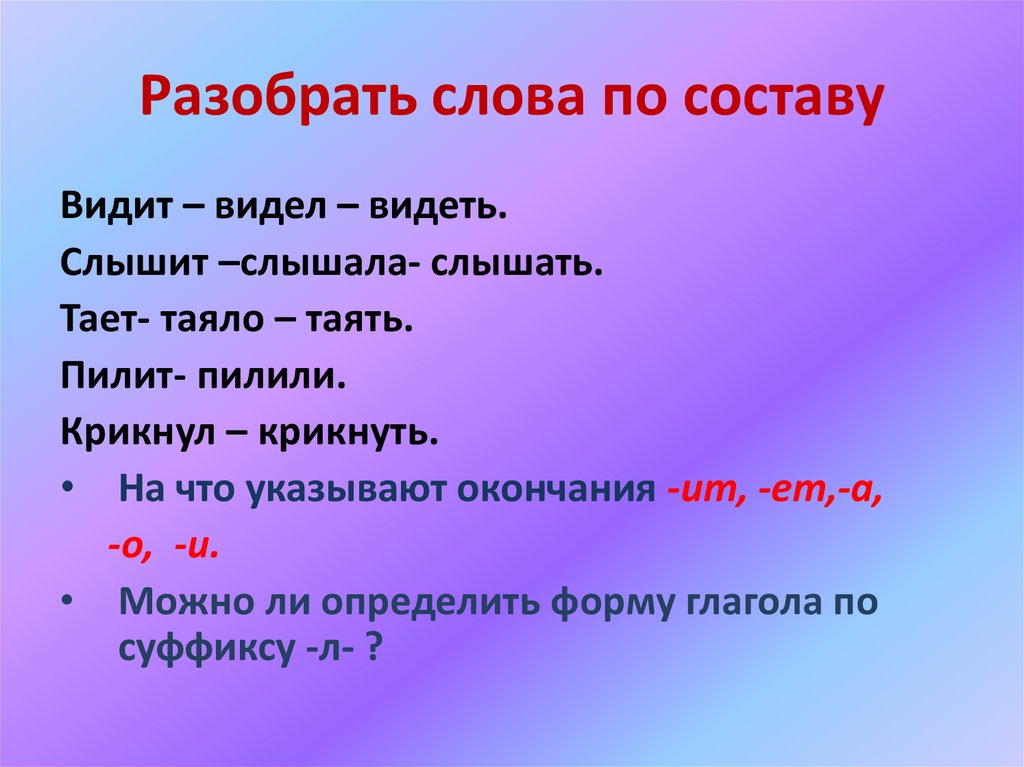

Какой из приведенных ниже суффиксов может быть формообразующим

-а-

-л-

-тель-

-нн-

Правильный ответ

Неправильный ответ

В вопросе ошибка?

Вопрос 7 из 10

Чтобы найти окончание, надо

Поставить ударение

Определить часть речи

Изменить форму слова

Отбросить приставку

Правильный ответ

Неправильный ответ

В вопросе ошибка?

Вопрос 8 из 10

Однокоренное слово к слову «гора» — это

ПодсказкаПравильный ответ

Неправильный ответ

В вопросе ошибка?

Вопрос 9 из 10

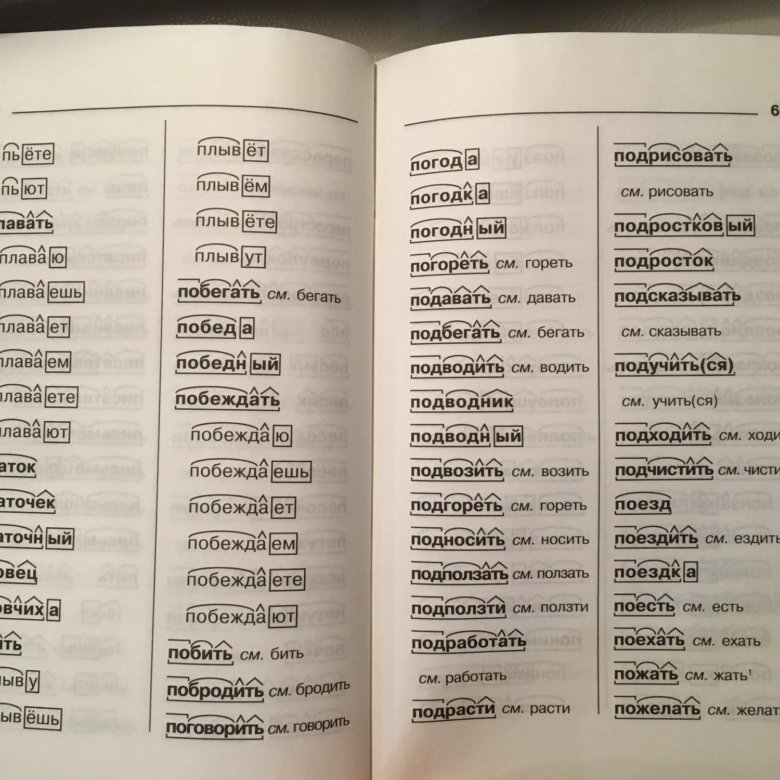

Сколько приставок в слове «побеспокоиться»?

ПодсказкаПравильный ответ

Неправильный ответ

В вопросе ошибка?

Вопрос 10 из 10

Какой суффикс надо выделить в слове «дождинка»?

-ин-

-к-

-инк-

-дин-

Правильный ответ

Неправильный ответ

В вопросе ошибка?

Доска почёта

Чтобы попасть сюда — пройдите тест.

Женя Птушкин

10/10

Sunnat Ishpulatov

10/10

Рейтинг теста

3.4

Средняя оценка: 3.4

Всего получено оценок: 732.

А какую оценку получите вы? Чтобы узнать — пройдите тест.

hyphens — CSS: Каскадные таблицы стилей

Свойство CSS hyphens указывает, как слова должны переноситься через дефис, когда текст переносится через несколько строк. Он может полностью предотвратить расстановку переносов, расставлять переносы в указанных вручную точках в тексте или позволить браузеру автоматически вставлять дефисы там, где это необходимо.

Примечание: В приведенной выше демонстрации строка «Чрезвычайно длинное английское слово!» содержит скрытый (мягкий дефис) символ: Чрезвычайно длинное английское слово!

дефиса: вручную; указан.

Правила расстановки переносов зависят от языка. В HTML язык определяется атрибутом lang , и браузеры будут расставлять переносы только в том случае, если присутствует этот атрибут и доступен соответствующий словарь расстановки переносов. В XML необходимо использовать атрибут xml:lang .

Примечание: Правила, определяющие способ расстановки переносов, не определены явным образом в спецификации, поэтому точные расстановки переносов могут различаться в разных браузерах.

Если поддерживается, символ дефиса может использоваться для указания альтернативного символа дефиса для использования в конце разрываемой строки.

/* Значения ключевых слов */ дефисы: нет; дефисы: ручной; дефисы: авто; /* Глобальные значения */ дефисы: наследовать; дефисы: начальные; дефис: вернуться; дефисы: возвратный слой; дефисы: не установлены;

Свойство дефисов задается как одно значение ключевого слова, выбранное из списка ниже.

Значения

-

нет Слова не разбиваются на разрывы строк, даже если символы внутри слов указывают на точки разрыва строк. Строки будут переноситься только на пробелы.

-

руководство Слова разбиваются для переноса строки только в том случае, если символы внутри слова указывают на возможность разрыва строки. Дополнительные сведения см. в разделе «Предложение вариантов разрыва строки» ниже.

-

авто -

Браузер может автоматически разбивать слова в соответствующих точках переноса, следуя любым правилам, которые он выбирает. Тем не менее, предлагаемые возможности разрыва строки (см. раздел «Предложение возможностей разрыва строки» ниже) переопределяют автоматический выбор точки разрыва, если он присутствует.

Примечание: Поведение параметра auto зависит от правильной маркировки языка для выбора соответствующих правил переноса. Вы должны указать язык, используя

Вы должны указать язык, используя lang HTML-атрибут, гарантирующий применение автоматического переноса на этом языке.

Два символа Unicode используются для ручного указания возможных точек разрыва строки в тексте:

- U+2010 (ДЕФИС)

«Жесткий» дефис указывает на видимую возможность разрыва строки. Даже если в этой точке строка фактически не прерывается, дефис все равно отображается.

- U+00AD (застенчивый)

Невидимый, « s часто» hy phen. Этот символ не отображается визуально; вместо этого он отмечает место, где браузер должен разбить слово, если требуется перенос. В HTML используйте

, чтобы вставить мягкий дефис.

Примечание: Когда элемент HTML ведет к разрыву строки, дефис не добавляется.

| Исходное значение | ручной |

|---|---|

| Применимо к | all elements |

| Inherited | yes |

| Computed value | as specified |

| Animation type | discrete |

hyphens =

none |

руководство |

auto

Задание переноса текста

В этом примере используются три класса, по одному для каждой возможной конфигурации свойства hyphens .

HTML

нет: без дефиса; переполнение при необходимости- Оченьдлинное английское слово <дт>

- Оченьдлинное английское слово

auto: дефисы там, где решает алгоритм (при необходимости)- Оченьдлинное английское слово

manual: дефис только в ‐ или &застенчивый; (если нужно)

CSS

дд {

ширина: 55 пикселей;

граница: 1px сплошной черный;

}

дд.нет {

дефисы: нет;

}

дд.руководство {

дефисы: ручной;

}

дд.авто {

дефисы: авто;

}

Result

| Specification |

|---|

| CSS Text Module Level 3 # hyphens-property |

BCD tables only load in the browser

with JavaScript enabled. Включите JavaScript для просмотра данных.содержание-

overflow-wrap(ранееword-wrap) -

разрыв слова - Руководство по переносу и разрыву текста

Последнее изменение: 000Z»> 27 сентября 2022 г. , участниками MDN

| Темы и видео | Показания |

| 00 Введение | |

| 01 Линейный Двоичный Классификация | Эйзенштейн

2.0–2.5, 4.2–4.4.1 Персептрон и логистическая регрессия |

| 02 Анализ тональности и извлечение основных признаков | Эйзенштейн 4.1 |

| 03 Основы Обучение, градиентный спуск | |

| 04 Персептрон | |

| 05 Персептрон как Минимизация потерь | |

| 06 Логистика Регрессия | Персептрон и соединения LR |

| 07 Настроение Анализ | Недурно? Классификация настроений с использованием

Методы машинного обучения Pang et al. 2002 90 139 Базовые линии и биграммы: просто, хорошо

Классификация настроений и тем Ван и Мэннинг, 2012 г. 2002 90 139 Базовые линии и биграммы: просто, хорошо

Классификация настроений и тем Ван и Мэннинг, 2012 г. Сверточные нейронные сети для приговора Классификация Ким 2014 [Github] Прогресс НЛП в анализе настроений |

| 08 Оптимизация Основы | |

| 09 Мультикласс Классификация | Эйзенштейн

4.2 Конспект лекций для нескольких классов |

| 10 Мультикласс Персептрон и логистическая регрессия | |

| 11 Мультикласс Примеры классификации | Большой аннотированный корпус для обучения

вывод на естественном языке Bowman et al. 2015 Присвоение авторства Микросообщения Schwartz et al. 2013 |

| 11-2 Справедливость в Классификация | 50 лет испытаний (не)справедливости: уроки для

Машинное обучение Hutchinson and Mitchell 2018 Amazon отказывается от секретного рекрутингового инструмента ИИ, который демонстрировал предвзятое отношение к женщинам |

| 12 Невральная Сети | |

| 13 Нейронная сеть Визуализация | Нейронные сети, Коллекторы и топология |

| 14 Упреждение Нейронные сети, обратное распространение | Эйзенштейн

Глава 3. 1-3.3 1-3.3 |

| 15 Нейронная сеть Реализация | |

| 16 Нейронная сеть Обучение, Оптимизация | Dropout: простой способ предотвратить

переобучение Srivastava et al. 2014 Пакетная нормализация: ускорение обучения глубокой сети за счет сокращения Внутренний ковариатный сдвиг Иоффе и Сегеди 2015 Адам: Метод стохастической оптимизации Кингма и Ба 2015 Маргинал Значение адаптивных градиентных методов в машинном обучении Wilson et al. 2017 |

| 17 слов Вложения | |

| 18 Скип-грамм | Распределенный Представления слов и фраз и их композиционность Миколов и др. 2013 |

| 19 Другое слово Методы встраивания | Масштабируемая иерархическая распределенная языковая модель Mnih and Hinton 2008 Нейронное встраивание слов как неявная матричная факторизация Леви и Голдберг 2014 GloVe: Global Vectors for Word Представительство Pennington et al.  2014 2014 Обогащение векторов слов с помощью Информация о подсловах Bojanowski et al. 2016 |

| 20 Предвзятость в Word Вложения | Мужчина для программиста, как женщина для домохозяйки? Разоблачающее слово

Вложения Bolukbasi et al. 2016 Черный для преступника, как кавказец для Полиция: обнаружение и устранение мультиклассовой предвзятости в вложениях Word Manzini et al. 2019 Губная помада на свинье: обложка методов устранения предвзятости Систематические гендерные предубеждения во встраиваниях слов, но не устраняйте их Гонен и Голдберг, 2019 г. |

| 21 Применение Вложения, сети глубокого усреднения | Конкуренты глубокой неупорядоченной композиции Синтаксические методы классификации текстов Iyyer et al. 2015 |

| 22 Часть речи Маркировка | |

| 23 Последовательность Маркировка, маркировка с помощью классификаторов | |

| 24 Скрытый Марков Модели | |

| 25 HMM: оценка параметров | |

| 26 HMM: Алгоритм Витерби | |

| 27 Поиск луча | |

| 28 HMM для маркировки POS | TnT — Статистический анализатор частей речи

Брантс 2000 Обогащение источников знаний, используемых в Максимальная энтропия Тегирование части речи Toutanvoa and Manning 2000 Тегирование части речи от 9От 7% до 100%: не пора ли заняться лингвистикой? Manning 2011 Обработка естественного языка с помощью Small Сети прямого распространения Botha et al.  2017 2017 |

| 29 условных случайных полей | |

| 30 функций для NER | |

| 31 Вывод и обучение в CRF | |

| 32 Прямой-обратный алгоритм | |

| 33 НЭР | Включение неместной информации в

Системы извлечения информации от Gibbs Sampling Finkel et al. 2005 Проблемы проектирования и заблуждения в Распознавание именованных объектов Ratinov and Roth 2009 Нейронные архитектуры для именованных объектов Признание Lample et al. Сверхтонкое типирование сущностей Чой и др. 2018 |

| 34 Анализ избирательных округов | |

| 35 вероятностных контекстно-свободных грамматик | |

| 36 Алгоритм CKY | |

| 37 Уточнение грамматики | Точный нелексикализованный разбор Кляйна и Мэннинг 2003 |

| 38 Зависимости | Поиск оптимального пересечения 1 конечной точки

Деревья Питлер и др. 2013 2013 |

| 39 Анализ зависимостей на основе перехода | |

| 40 современных парсеров | Анализ максимальной маржи Taskar et al.

2004 Меньше грамматики, больше возможностей Hall et al. 2014 Нейронный анализ CRF Дарретта и Кляйна 2015 Анализ избирательного округа с помощью самоконтроля Encoder Kitaev and Klein 2018 Онлайн-обучение зависимостей с большой маржой Парсеры Макдональд и др. 2005 Эффективная зависимость третьего порядка Парсеры Ку и Коллинз 2010 Нейронная зависимость Стэнфорда на основе графов Parser на CoNLL 2017 Shared Task Dozat et al. 2017 Быстрый и точный синтаксический анализатор зависимостей с использованием Нейронные сети Чен и Мэннинг 2014 Глобально нормализованные нейронные сети на основе переходов Сети Andor et al. 2016 |

| 41 н-грамм LM | |

| 42 Сглаживание в n-граммовых LM | |

| 43 модели нейронного языка | |

| 44 базовых RNN, Elman Networks | Понимание LSTM Сети |

| 45 Гейтс и LSTM | Учебник по моделям нейронных сетей для естественных

Обработка языка Goldberg 2015 Понимание LSTM сети |

| 46 приложений RNN | |

| 47 Языковое моделирование RNN | |

| 48 Визуализация LSTM | Визуализация и понимание повторяющихся

Сети Карпаты и др. 2016 2016 |

| 49 ЭЛМО | Глубокое контекстуализированное слово

Представления Peters et al. 2018 Тюнинговать или не тюнинговать? Адаптация Представления для различных задач Peters et al. 2019 |

| 50 Теоретико-модельная семантика | |

| 51 Монтегю Семантика | |

| 52 ГКГ | Учимся сопоставлять предложения к логической форме: структурированная классификация с вероятностными категориальными грамматиками Zettlemoyer and Collins 2005 |

| 53 модели Seq2seq | |

| 54 Модели Seq2seq: обучение и внедрение | Запланированная выборка для прогнозирования последовательности с

Рекуррентные нейронные сети Bengio et al. 2015 2015 |

| 55 Семантический анализ Seq2seq | Рекомбинация данных для нейронной семантики Разбор Цзя и Лян 2016 |

| 56 Внимание: Проблемы с моделями seq2seq | Нейронный машинный перевод путем совместного обучения

Выровнять и перевести Богданау и др. 2015 Решение проблемы с редкими словами в нейронной машине Перевод Luong et al. 2015 |

| 57 Внимание: модель и реализация | Нейронный машинный перевод путем совместного обучения

Выровнять и перевести Богданау и др. 2015 Эффективные подходы к нейронной сети, основанной на внимании Машинный перевод Луонг и др. 2015 |

| 58 Копирование и указатели | Решение проблемы с редкими словами в Neural

Машинный перевод Луонг и др. 2015 2015Рекомбинация данных для нейронной семантики Разбор Цзя и Лян 2016 |

| Кодирование 59 частей слов и пар байтов | Нейронный машинный перевод редких слов с

Единицы подслов Sennrich et al. 2016 Парное кодирование байтов неоптимально для языка Предварительная подготовка моделей Bostrom and Durret 2020 |

| 60 Трансформеров | Внимание — это все, что вам нужно Vaswani et al. 2017 |

| 61 Машинный перевод Введение | |

| 62 MT: Структура и оценка | |

| 63 MT: выравнивание слов | |

| 64 тонны: модели IBM | Выравнивание слов на основе HMM в Статистический перевод Vogel et al. 1996 |

| 65 Машинный перевод на основе фраз | Фараон: А

Декодер поиска луча для моделей статистического машинного перевода на основе фраз Koehn 2004 Минимальная частота ошибок Обучение статистике Машинный перевод Ок 2003 |

| 66 Синтаксический машинный перевод | Что в правиле перевода?

Галлей и др. 2004 2004 |

| 67 Нейронный машинный перевод | Решение проблемы с редкими словами в

Нейронный машинный перевод Луонг и др. 2015 Эффективные подходы к Нейронный машинный перевод Луонг и др. 2015 Нейронная система машинного перевода Google: Преодоление разрыва между человеческим и машинным переводом Wu et al. 2016 Новый взгляд на нейронную машину с низким уровнем ресурсов Перевод: Практический пример Сеннрих и Чжан, 2019 г. |

| 68 BERT: моделирование маскированного языка | BERT: предварительная подготовка глубокого двунаправленного Трансформеры для понимания языка Devlin et al. 2019 |

| 69 BERT: модель и приложения | BERT: предварительная подготовка глубокого двунаправленного

Трансформеры для понимания языка Devlin et al. 2019 Тюнинговать или не тюнинговать? Адаптация Представления для различных задач Peters et al.  2019 2019 GLUE: многозадачный тест и анализ Платформа для понимания естественного языка Wang et al. 2019 RoBERTa: Надежно оптимизированный предварительный тренинг BERT Подход Liu et al. 2019 |

| 70 ГПТ-2 | Языковые модели — это многозадачные учащиеся без присмотра Radford et al. 2018 |

| 70б ГПТ-3 | Языковые модели малоэффективны для изучения Браун и другие. 2020 |

| 71 BART и др. предтренировочные | BART: Шумоподавление от последовательности к последовательности, предварительное обучение

для создания, перевода и понимания естественного языка Льюис и др. 2019 Изучение пределов трансферного обучения с помощью Унифицированный преобразователь текста в текст Raffel et al. 2020 |

| 72 Понимание прочитанного, введение | |

| 73 Понимание прочитанного: подготовка и исходные данные | MCTest: набор данных о вызове для

Машинное понимание текста с открытым доменом Richardson et al. 2013 2013 SQuAD: более 100 000 вопросов для машины Понимание текста Rajpurkar et al. 2016 |

| 74 Внимательный Читатель | Машины для обучения чтению и пониманию

Германн и др. 2015 Читаем Википедию, чтобы ответить на вопросы Open-Domain Вопросы Chen et al. 2017 |

| 75 Улучшение понимания прочитанного | Двунаправленный поток внимания для машины Понимание Seo et al. 2017 |

| 76 BERT для QA | RACE: крупномасштабное понимание прочитанного Набор данных из исследований Lai et al. 2017 |

| 77 Проблемы с пониманием прочитанного | Состязательные примеры для оценки Системы понимания прочитанного Цзя и Лян 2017 |

| 78 QA | с открытым доменом RACE: крупномасштабное понимание прочитанного

Набор данных из исследований Lai et al. 2017 2017Скрытый поиск для слабо контролируемых Ответы на вопросы открытого домена Lee et al. 2019 Естественные вопросы |

| 79 Многоскачковый QA | Понимание вариантов дизайна набора данных для

Multi-hop Reasoning Chen and Durrett 2019 Обучение извлечению путей рассуждений через График Википедии для ответов на вопросы Asai et al. 202 |

| 80 Объяснимость в НЛП | Мифы об интерпретируемости моделей Lipton

2016 Deep Unordered Composition Rivals Syntactic Методы классификации текстов Iyyer et al. 2015 Методы анализа в нейронной языковой обработке: A Обзор Белинков и Гласс 2019 |

| 81 Местные пояснения: основные моменты | «Почему я должен тебе доверять?» Объяснение

Прогнозы любого классификатора Ribeiro et al. 2016 Аксиоматическая атрибуция для Deep Networks Сундарараджан и др.  2017 2017 |

| 82 Пояснения к тексту | Создание визуальных объяснений Хендрикс и др.

др. 2016 Объяснение моделей ответов на вопросы с помощью текста Поколение Латчинник и Берант 2020 |

| 83 Зондирование модели | BERT заново открывает классический конвейер НЛП

Тенни и др. 2019 Что вы узнаете из контекста? Зондирование Структура предложения в контекстуализированных представлениях слов Tenney et al. 2019 |

| 84 Артефакты аннотаций | Артефакты аннотаций на естественном языке

Данные для вывода Gururangan et al. 2018 Гипотезы Только базовые уровни в естественном Языковой вывод Poliak et al. 2018 Модель поняла вопрос? Мудракарта и др. 2018 Понимание вариантов дизайна набора данных для Multi-hop Reasoning Chen and Durrett 2019 Swag: крупномасштабный состязательный набор данных для обоснованного вывода на основе здравого смысла Zellers et al.  2018 2018 |

| 85 Резюме Введение | |

| 86 Извлекательное обобщение | Использование MMR на основе разнообразия

реранжирование для изменения порядка документов и составления резюме Carbonell and Goldstein 1998 LexRank: лексический анализ на основе графа Центральность как значимость в обобщении текста Эркан и Радев 2004 Масштабируемая глобальная модель для Резюме Gillick and Favre 2009 Пересмотр метода на основе центроидов: A Надежная основа для обобщения нескольких документов Галандари, 2017 г. |

| 87 Нейронно-экстрактивные модели | Тонкая настройка BERT для экстрактивного суммирования Лю 2019 |

| 88 Сжатое суммирование | Совместное обучение извлечению и

Компресс Берг-Киркпатрик и др. 2011 2011 Единый документ на основе обучения Суммирование с ограничениями сжатия и анафоричности Durrett et al. 2016 Суммирование нейронного извлечения текста с помощью Синтаксическое сжатие Сюй и Дарретт 2019 |

| 89 Абстрактное обобщение | Обобщение абстрактного предложения с

Внимательные рекуррентные нейронные сети Chopra et al. 2016 Дойти до сути: Подведение итогов с Сети генераторов указателей См. et al. 2017 |

| 90 Предварительно обученное обобщение и фактичность | БАРТ: Шумоподавление

Предварительное обучение от последовательности к последовательности для генерации, перевода и понимания естественного языка Льюис и др.

др. 2019 ПЕГАС: Предварительное обучение с использованием извлеченных предложений-пробелов для абстрактного обобщения Zhang et al. 2020 Оценка фактичности в поколении с Зависимость уровня зависимости Goyal and Durrett 2020 |

| 91 Диалог: Чат-боты | |

| 92 Нейронные чат-боты | Нейросетевой подход к

Контекстно-зависимая генерация диалоговых ответов Sordoni et al. 2015 2015 Целевая функция содействия разнообразию для Модели нейронных разговоров Li et al. 2016 Персонализация диалоговых агентов: у меня есть собака, да у вас тоже есть домашние животные? Чжан и др. 2018 |

| 93 Целенаправленный диалог | Волшебники Википедии: основанные на знаниях Диалоговые агенты Динан и др. 2019 |

| 94 Диалог и QA | QuAC: ответы на вопросы в контексте Choi

и другие. 2018 Интерпретация правил естественного языка в Разговорное машинное чтение Saeidi et al. 2018 |

| 95 Морфология | |

| 96 Морфологический анализ | Контролируемое обучение завершено

Морфологические парадигмы Durrett and DeNero 2013 Перевод в морфологически богатый Языки с синтетическими фразами Chahuneau et al. 2013 |

| 97 Межъязыковая маркировка и синтаксический анализ | Неконтролируемая маркировка части речи с

Двуязычные прогнозы на основе графиков Дас и Петров 2011 Передача из нескольких источников делексикализованного

Анализаторы зависимостей McDonald et al. |