Слова «этаж» морфологический и фонетический разбор

Объяснение правил деление (разбивки) слова «этаж» на слоги для переноса.

Онлайн словарь Soosle.ru поможет: фонетический и морфологический разобрать слово «этаж» по составу, правильно делить на слоги по провилам русского языка, выделить части слова, поставить ударение, укажет значение, синонимы, антонимы и сочетаемость к слову «этаж».

Содержимое:

- 1 Слоги в слове «этаж» деление на слоги

- 2 Как перенести слово «этаж»

- 3 Морфологический разбор слова «этаж»

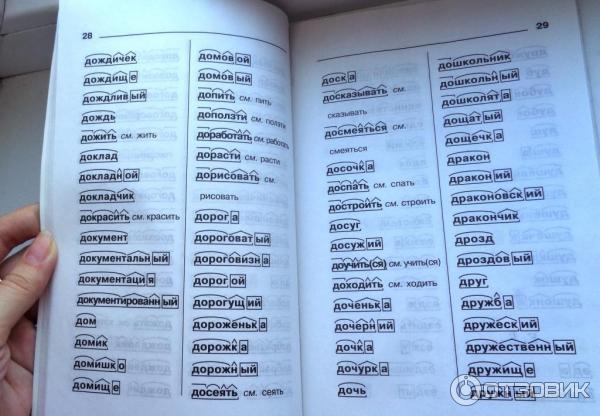

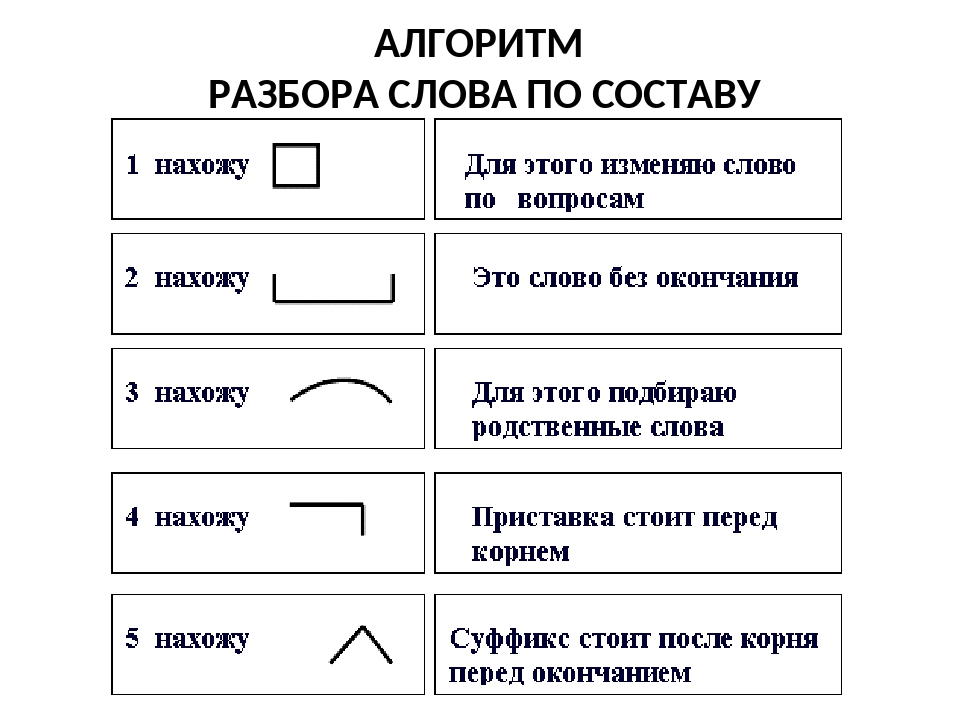

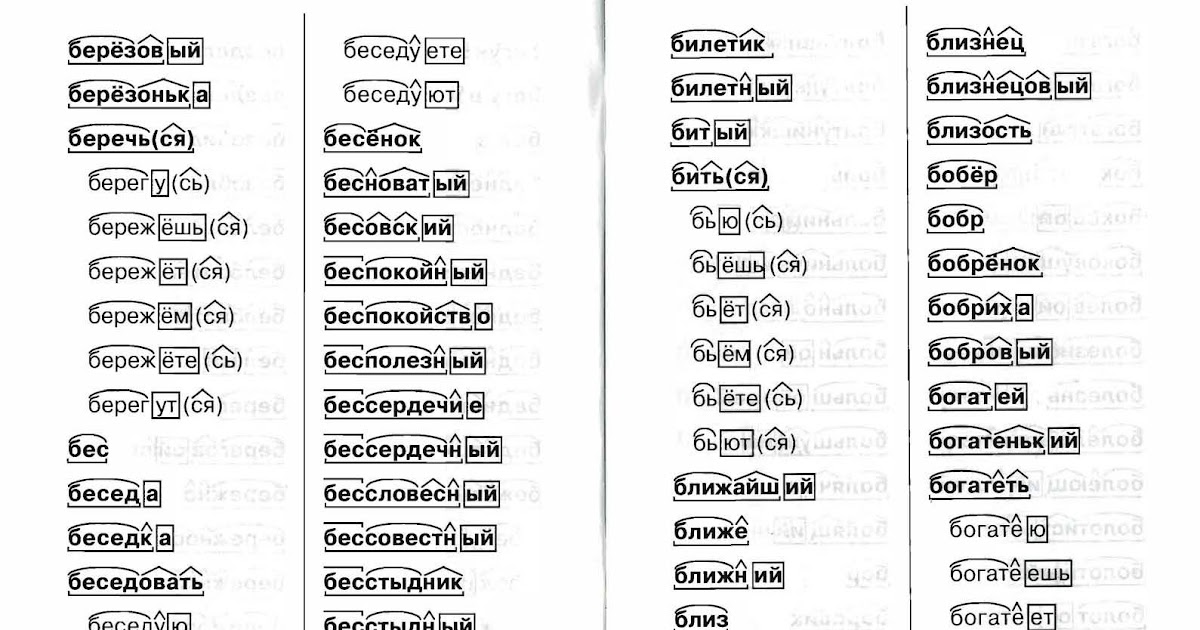

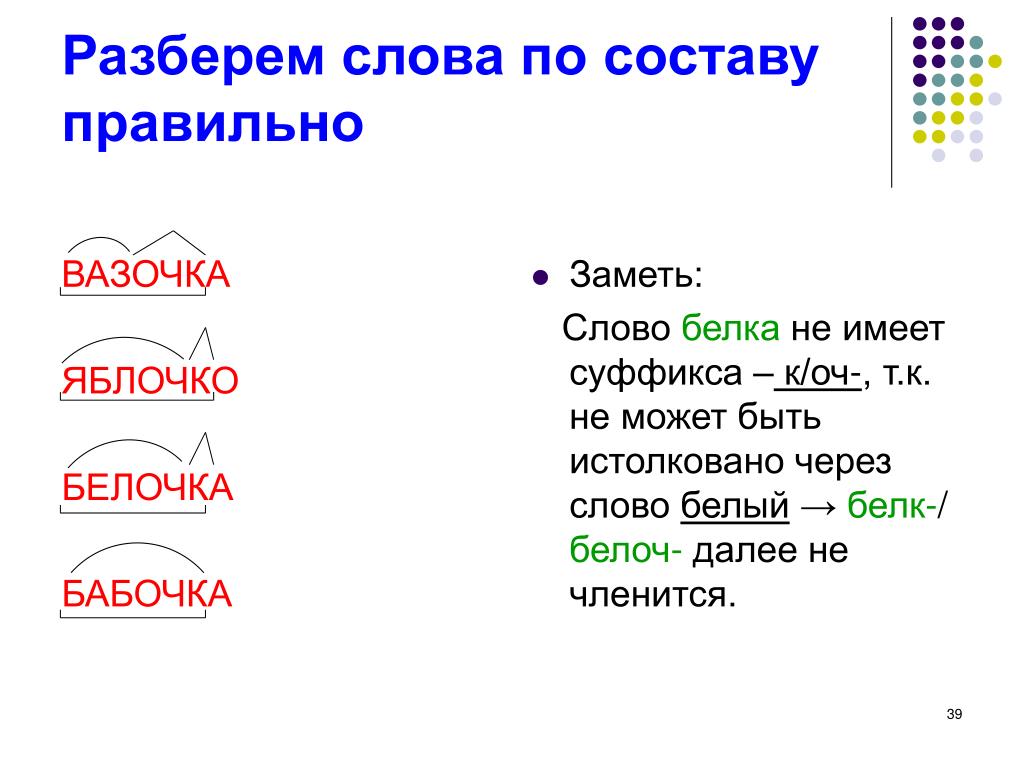

- 4 Разбор слова «этаж» по составу

- 5 Сходные по морфемному строению слова «этаж»

- 6 Синонимы слова «этаж»

- 7 Ударение в слове «этаж»

- 8 Фонетическая транскрипция слова «этаж»

- 9 Фонетический разбор слова «этаж» на буквы и звуки (Звуко-буквенный)

- 10 Предложения со словом «этаж»

- 11 Сочетаемость слова «этаж»

- 12 Значение слова «этаж»

- 13 Склонение слова «этаж» по подежам

- 14 Как правильно пишется слово «этаж»

- 15 Ассоциации к слову «этаж»

Слоги в слове «этаж» деление на слоги

Количество слогов: 2

По слогам: э-таж

Как перенести слово «этаж»

этаж

Морфологический разбор слова «этаж»

Часть речи:

Имя существительное

Грамматика:

часть речи: имя существительное;

одушевлённость: неодушевлённое;

род: мужской;

число: единственное;

падеж: именительный, винительный;

отвечает на вопрос: (есть) Что?, (вижу/виню) Что?

Начальная форма:

этаж

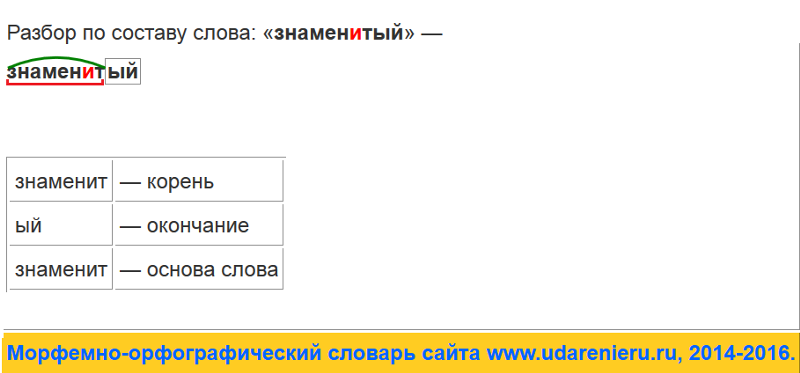

Разбор слова «этаж» по составу

| этаж | корень |

| ø | нулевое окончание |

этаж

Сходные по морфемному строению слова «этаж»

Сходные по морфемному строению слова

Синонимы слова «этаж»

1. подклет

подклет

2. империал

3. ярус

4. бельэтаж

5. аттик

6. бейсмент

7. жилье

Ударение в слове «этаж»

эта́ж — ударение падает на 2-й слог

Фонетическая транскрипция слова «этаж»

[эт`аш]

Фонетический разбор слова «этаж» на буквы и звуки (Звуко-буквенный)

| Буква | Звук | Характеристики звука | Цвет |

|---|---|---|---|

| э | [э] | гласный, безударный | э |

| т | [т] | согласный, глухой парный, твёрдый, шумный | т |

| а | [`а] | гласный, ударный | а |

| ж | [ш] | согласный, глухой парный, твёрдый, шипящий, шумный | ж |

Число букв и звуков:

На основе сделанного разбора делаем вывод, что в слове 4 буквы и 4 звука.

Буквы: 2 гласных буквы, 2 согласных букв.

Звуки: 2 гласных звука, 2 согласных звука.

Предложения со словом «этаж»

Огонь уже начал перебираться на верхние этажи и остановить его могло только чудо.

Источник: Вячеслав Аничкин, Черный Оракул.

Квартирка, в которой я жил, была на втором этаже старого здания — прямо над моей мастерской.

Источник: Джейн Ли, Проникающий в сны.

На последнем этаже, было несколько свободных квартир. Я походил по ним и выбрал большую трёхкомнатную квартиру с двумя огромными лоджиями.

Источник: Григорий Санжаровский, Тинейджерский роман.

Сочетаемость слова «этаж»

1. верхний этаж

2. нижний этаж

3.

4. на верхнем этаже здания

5. на верхнем этаже дома

6. с этажа на этаж

7. окна нижнего этажа

8. кнопку нужного этажа

9. на площадке между этажами

10. подниматься на свой этаж

11. находиться на верхнем этаже

12. жить на последнем этаже

13. (полная таблица сочетаемости)

Значение слова «этаж»

ЭТА́Ж , -а́, м. 1. Часть здания, включающая ряд помещений, расположенных на одном уровне. Шестой этаж. (Малый академический словарь, МАС)

Склонение слова «этаж» по подежам

| Падеж | Вопрос | Единственное числоЕд.ч. | Множественное числоМн.ч. |

|---|---|---|---|

| ИменительныйИм. | что? | этаж | этажи |

| РодительныйРод. | чего? | этажа | этажей |

| ДательныйДат. | чему? | этажу | этажам |

ВинительныйВин. | что? | этаж | этажи |

| ТворительныйТв. | чем? | этажом | этажами |

| ПредложныйПред. | о чём? | этаже | этажах |

Как правильно пишется слово «этаж»

Правописание слова «этаж»

Орфография слова «этаж»

Правильно слово пишется: эта́ж

Нумерация букв в слове

Номера букв в слове «этаж» в прямом и обратном порядке:

- 4

э

1 - 3

т

2 - 2

а

3 - 1

ж

4

Ассоциации к слову «этаж»

Лифт

Второе

Мансарда

Третье

Перекрытие

Лестница

Балкон

Третий

Дежурная

Апартамент

Жильцов

Первое

Квартирка

Эскалатор

Ведущая

Жилец

Фасад

Подъезд

Площадка

Вестибюль

Комнатка

Холл

Флигель

Здание

Лесенка

Комнатушка

Фойе

Карниз

Залом

Перила

Квартира

Пристройка

Ставня

Окно

Чердак

Планировка

Башенка

Табло

Коридор

Особняк

Кнопка

Офис

Портик

Спальня

Галерея

Универмаг

Каморка

Помещение

Форточка

Бойница

Надстройка

Ступенька

Постоялец

Трапезная

Подвал

Жалюзи

Покои

Спортзал

Подвальный

Верхний

Лестничный

Винтовой

Высотный

Нижний

Жилой

Угловой

Ковровый

Гостиный

Просторный

Предпоследний

Гостевой

Сводчатый

Полукруглый

Кирпичный

Парадный

Подсобный

Полутемный

Пожарный

Оконный

Скрипучий

Доходный

Взбежать

Размещаться

Помещаться

Опоясывать

Располагаться

Спуститься

Подняться

Устлать

Обшарпать

Отелить

Разместиться

Подниматься

Перепрыгивать

Обставить

Застроить

Арендовать

Заколотить

Ниже

Выше

Найти текст данного тега с помощью BeautifulSoup

Улучшить статью

Сохранить статью

Нравится Статья

aniketparihar1718

автор

2 опубликованные статьи

Улучшить статью

Сохранить статью

Нравится Статья

Веб-скрапинг — это процесс использования программных ботов, называемых веб-скраперами, для извлечения информации из содержимого HTML или XML веб-страницы.

В этой статье мы обсудим поиск текста по заданному тегу.

Пошаговый подход:

- Сначала импортируйте библиотеку.

Python3

импорт запросы |

- Теперь назначьте URL.

Python3

- Получить исходный HTML-контент из URL-адреса.

Python3

|

- Теперь проанализируйте содержимое.

Python3

|

- После анализа содержимого мы ищем определенный тег и распечатать его текст.

Python3

|

Ниже приведена полная программа.

Python3

9000 3 |

Вывод:

Аналогично, чтобы получить все вхождения данного тега:

Python3 90 043

импорт запросы

9 0049 html_content

|

Вывод:

Последнее обновление : 30 мая, 2022

Нравится статья

Сохранить статью

Как на самом деле работает ChatGPT

ChatGPT — это новейшая языковая модель от OpenAI, представляющая собой значительное улучшение по сравнению со своим предшественником GPT-3. Подобно многим моделям больших языков, ChatGPT способен генерировать текст в широком диапазоне стилей и для различных целей, но с заметно большей точностью, детализацией и согласованностью. Он представляет следующее поколение в линейке больших языковых моделей OpenAI и разработан с упором на интерактивные разговоры.

Создатели использовали комбинацию контролируемого обучения и обучения с подкреплением для точной настройки ChatGPT, , но именно компонент обучения с подкреплением делает ChatGPT уникальным . Создатели используют особую технику под названием «обучение с подкреплением на основе обратной связи с человеком» (RLHF), которая использует обратную связь с человеком в цикле обучения, чтобы свести к минимуму вредные, ложные и / или предвзятые результаты.

Мы собираемся изучить ограничения GPT-3 и то, как они вытекают из его тренировочного процесса, прежде чем узнать, как работает RLHF и понять, как ChatGPT использует RLHF для решения этих проблем . В заключение мы рассмотрим некоторые ограничения этой методологии.

Возможности и выравнивание в больших языковых моделях

«Соответствие и возможности» можно рассматривать как более абстрактный аналог «точности и точности» В контексте машинного обучения термин возможности относится к способности модели выполнять конкретной задачи или набора задач. Возможности модели обычно оцениваются по насколько хорошо он может оптимизировать свою целевую функцию , математическое выражение, определяющее цель модели. Например, модель, предназначенная для прогнозирования цен на фондовом рынке, может иметь целевую функцию, которая измеряет точность прогнозов модели. Если модель способна точно предсказать движение цен акций с течением времени, считается, что она имеет высокий уровень возможностей для этой задачи.

Возможности модели обычно оцениваются по насколько хорошо он может оптимизировать свою целевую функцию , математическое выражение, определяющее цель модели. Например, модель, предназначенная для прогнозирования цен на фондовом рынке, может иметь целевую функцию, которая измеряет точность прогнозов модели. Если модель способна точно предсказать движение цен акций с течением времени, считается, что она имеет высокий уровень возможностей для этой задачи.

Выравнивание, с другой стороны, касается что мы на самом деле хотим, чтобы модель делала по сравнению с тем, чему ее обучают. Он задает вопрос: «Соответствует ли эта целевая функция нашим намерениям?» и относится к степени, в которой цели и поведение модели соответствуют человеческим ценностям и ожиданиям. В качестве простого конкретного примера предположим, что мы обучаем классификатор птиц классифицировать птиц как «воробьи» или «малиновки», и мы используем логарифмических потерь (который измеряет разницу между прогнозируемым распределением вероятностей модели и истинным распределением) как цель обучения, хотя нашей конечной целью является высокая точность классификации. Модель может иметь низкие логарифмические потери, т. е. возможности модели высокие, но низкая точность на тестовом наборе. На самом деле потеря журнала не полностью коррелирует с точностью в задачах классификации. Это пример несоответствия, когда модель способна оптимизировать цель обучения, но плохо соответствует нашей конечной цели.

Модель может иметь низкие логарифмические потери, т. е. возможности модели высокие, но низкая точность на тестовом наборе. На самом деле потеря журнала не полностью коррелирует с точностью в задачах классификации. Это пример несоответствия, когда модель способна оптимизировать цель обучения, но плохо соответствует нашей конечной цели.

Модели, такие как оригинальный GPT-3, смещены

Модели больших языков, такие как GPT-3, обучаются на большом количестве текстовых данных из Интернета и способны генерировать человекоподобный текст , но они не всегда могут давать выходные данные, соответствующие человеческим ожиданиям или желаемым значениям. На самом деле их целевая функция — это распределение вероятностей по последовательностям слов (или последовательностям токенов), которое позволяет им предсказать, какое следующее слово будет в последовательности (подробнее об этом ниже).

Однако в практических приложениях эти модели предназначены для выполнения той или иной формы полезной когнитивной работы , и существует явное расхождение между тем, как эти модели обучаются, и тем, как мы хотели бы их использовать. Несмотря на то, что вычисленное машиной статистическое распределение последовательностей слов может быть, с математической точки зрения, очень эффективным выбором для моделирования языка, мы, люди, создаем язык, выбирая текстовые последовательности, которые лучше всего подходят для данной ситуации, используя наши базовые знания и здравый смысл для руководства. этот процесс. Это может быть проблемой, когда языковые модели используются в приложениях, требующих высокой степени доверия или надежности, таких как диалоговые системы или интеллектуальные персональные помощники.

Несмотря на то, что вычисленное машиной статистическое распределение последовательностей слов может быть, с математической точки зрения, очень эффективным выбором для моделирования языка, мы, люди, создаем язык, выбирая текстовые последовательности, которые лучше всего подходят для данной ситуации, используя наши базовые знания и здравый смысл для руководства. этот процесс. Это может быть проблемой, когда языковые модели используются в приложениях, требующих высокой степени доверия или надежности, таких как диалоговые системы или интеллектуальные персональные помощники.

Хотя эти мощные, сложные модели, обученные на огромных объемах данных, за последние несколько лет стали чрезвычайно функциональными, при использовании в производственных системах для облегчения жизни людей они часто не реализуют свой потенциал. Проблема выравнивания в больших языковых моделях обычно проявляется следующим образом:

- Отсутствие полезности: несоблюдение явных инструкций пользователя.

- Галлюцинации: модель, придумывающая несуществующие или неверные факты.

- Отсутствие интерпретируемости: людям трудно понять, как модель пришла к конкретному решению или прогнозу.

- Генерация предвзятых или токсичных результатов: языковая модель, обученная на предвзятых/токсичных данных, может воспроизвести это в своих выходных данных, даже если она не была явно проинструктирована об этом.

Но откуда конкретно эта проблема выравнивания? Является ли сам способ обучения языковых моделей склонным к рассогласованию?

Как стратегии обучения языковой модели могут привести к рассогласованию0050 являются

основными методами, используемыми для обучения языковых моделей , таких как преобразователи. При первом подходе модели дается последовательность слов (или «токенов», то есть частей слов) в качестве входных данных, и ее просят предсказать следующее слово в последовательности. Например, если модели задано входное предложение«Кошка сидела на»

, она может предсказать следующее слово как «коврик» , «стул» или «пол» , из-за высокой вероятности появления этих слов в предыдущем контексте; языковая модель на самом деле способна оценить вероятность каждого возможного слова (в его словаре) с учетом предыдущей последовательности.

Подход к моделированию маскированного языка — это вариант предсказания следующего токена, при котором некоторые слова во входном предложении заменяются специальным токеном, например [MASK] . Затем модель просят предсказать правильное слово, которое следует вставить вместо маски. Например, если модели задано предложение

« [МАСКА] сидел на»

в качестве входных данных, он может предсказать следующее слово как «кошка» , «собака» или «кролик» .

Одним из преимуществ этих целевых функций является то, что они позволяют модели изучать статистическую структуру языка , такую как общие последовательности слов и модели использования слов. Как правило, это помогает модели генерировать более естественный и плавный текст и является важным шагом на этапе предварительного обучения каждой языковой модели.

Однако эти целевые функции также могут привести к проблемам, главным образом потому, что модель не способна отличить важную ошибку от неважной . Чтобы сделать очень простой пример, если модели задано входное предложение:

Чтобы сделать очень простой пример, если модели задано входное предложение:

«Римская империя [MASK] с правлением Августа».

можно было бы предсказать «начало» или «завершение» , поскольку оба слова имеют высокую вероятность появления (действительно, оба предложения исторически правильны), хотя второй выбор подразумевает совсем другое значение.

В более общем плане эти стратегии обучения могут привести к смещению языковой модели для некоторых более сложных задач, потому что модель, которая обучена только предсказывать следующее слово (или замаскированное слово) в текстовой последовательности, может не обязательно изучать некоторые высокоуровневые представления своего значения . В результате модель изо всех сил пытается обобщить задачи или контексты, которые требуют более глубокого понимания языка.

Исследователи и разработчики работают над различными подходами к решению проблемы выравнивания в больших языковых моделях. ChatGPT основан на исходной модели GPT-3, но был дополнительно обучен с использованием отзывов людей для управления процессом обучения с конкретной целью смягчения проблем несоответствия модели. Используемый конкретный метод, называемый обучением с подкреплением на основе отзывов людей, основан на предыдущих академических исследованиях. ChatGPT представляет первый случай использования этой техники для модели, запущенной в серию .

ChatGPT основан на исходной модели GPT-3, но был дополнительно обучен с использованием отзывов людей для управления процессом обучения с конкретной целью смягчения проблем несоответствия модели. Используемый конкретный метод, называемый обучением с подкреплением на основе отзывов людей, основан на предыдущих академических исследованиях. ChatGPT представляет первый случай использования этой техники для модели, запущенной в серию .

Но как именно создатели ChatGPT используют отзывы людей для решения проблемы выравнивания?

Метод в целом состоит из трех отдельных этапов:

- Контролируемая точная настройка — Предварительно обученная языковая модель настраивается на относительно небольшом количестве демонстрационных данных, отобранных маркировщиками, для изучения контролируемой политики SFT модель ), который генерирует выходные данные из выбранного списка подсказок. Это представляет собой базовую модель.

- «Имитация человеческих предпочтений» — маркировщиков просят проголосовать за относительно большое количество выходных данных модели SFT, таким образом создавая новый набор данных, состоящий из данных сравнения .

На этом наборе данных обучается новая модель. Это называется моделью вознаграждения (RM) .

На этом наборе данных обучается новая модель. Это называется моделью вознаграждения (RM) . - Проксимальная оптимизация политики (PPO) — Модель вознаграждения используется для дальнейшей тонкой настройки и улучшения модели SFT. Результатом этого шага является так называемая модель политики 9.0028 .

Шаг 1 выполняется только один раз, в то время как шаги 2 и 3 могут повторяться непрерывно: для текущей наилучшей модели политики собирается больше данных для сравнения, которые используются для обучения новой модели вознаграждения, а затем новой политики.

Теперь давайте углубимся в детали каждого шага!

Примечание. Остальная часть этой статьи основана на содержании документа InstructGPT. Согласно OpenAI, ChatGPT был обучен «с использованием тех же методов, что и InstructGPT, но с небольшими отличиями в настройке сбора данных» 9.0339 (источник). К сожалению, точные количественные отчеты для ChatGPT еще не опубликованы.

Шаг 1: Модель контролируемой точной настройки (SFT)

Первый шаг состоит в сборе демонстрационных данных для обучения модели контролируемой политики, называемой моделью SFT.

- Сбор данных: выбирается список подсказок и группу людей, которые маркируют, просят записать ожидаемый выходной ответ . Для ChatGPT использовались два разных источника подсказок: некоторые были подготовлены непосредственно от маркировщиков или разработчиков, некоторые были взяты из запросов API OpenAI (т. е. от их клиентов GPT-3). Поскольку весь этот процесс медленный и дорогостоящий, в результате получается относительно небольшой, высококачественный набор данных (предположительно, примерно 12–15 тысяч точек данных), который следует использовать для тонкой настройки предварительно обученной языковой модели.

- Выбор модели: вместо тонкой настройки исходной модели GPT-3 разработчики ChatGPT выбрали предварительно обученную модель в так называемой серии GPT-3.

5. Предположительно, в качестве базовой модели использовалась последняя модель

5. Предположительно, в качестве базовой модели использовалась последняя модель text-davinci-003, модель GPT-3, которая была настроена в основном на программный код.

Весьма интересно, что для создания чат-бота общего назначения, такого как ChatGPT, разработчики решили настроить поверх «кодовой модели» , а не чисто текстовой модели.

Рисунок адаптирован из источникаИз-за ограниченного объема данных для этого шага SFT-модель, полученная после этого процесса, вероятно, будет выводить текст, который все еще (вероятностно) не очень внимателен к пользователю и обычно страдает от смещения, в объясненном смысле. в вышеуказанных разделах. Проблема здесь в том, что этап контролируемого обучения страдает от высокой стоимости масштабируемости .

Чтобы решить эту проблему, вместо того, чтобы просить специалистов по маркировке создать гораздо больший кураторский набор данных, что является медленным и дорогостоящим процессом, стратегия теперь состоит в том, чтобы маркировщики ранжировали различные результаты модели SFT для создания модели вознаграждения — давайте объясним это. более подробно в следующем разделе.

более подробно в следующем разделе.

Шаг 2: Модель вознаграждения (RM)

Цель состоит в том, чтобы изучить целевую функцию (модель вознаграждения) непосредственно из данных . Цель этой функции — дать оценку выходным данным модели SFT, пропорциональную тому, насколько эти выходные данные желательны для людей. На практике это будет сильно отражать специфические предпочтения выбранной группы людей, наносящих ярлыки, и общие принципы, которым они согласились следовать. В конце концов, этот процесс извлечет из данных автоматическую систему, которая должна имитировать человеческие предпочтения .

Вот как это работает:

- Выбирается список подсказок, и модель SFT генерирует несколько выходных данных (от 4 до 9) для каждой подсказки.

- Этикетировщики ранжируют результаты от лучшего к худшему. Результатом является новый помеченный набор данных, где рейтинги являются метками. Размер этого набора данных примерно в 10 раз больше, чем у кураторского набора данных, используемого для модели SFT.

- Эти новые данные используются для обучения модели вознаграждения (RM). Эта модель принимает в качестве входных данных несколько выходных данных модели SFT и ранжирует их в порядке предпочтения.

Что касается этикетировщиков, то ранжировать результаты гораздо проще, чем создавать их с нуля, этот процесс масштабируется гораздо эффективнее . На практике этот набор данных был сгенерирован из выбора 30-40 тыс. подсказок, и переменное количество сгенерированных выходных данных (для каждой подсказки) предоставляется каждому маркировщику на этапе ранжирования.

Шаг 3: тонкая настройка модели SFT с помощью проксимальной оптимизации политики (PPO)

Обучение с подкреплением теперь применяется для тонкой настройки политики SFT, позволяя ей оптимизировать модель вознаграждения. Используемый конкретный алгоритм называется оптимизацией проксимальной политики (PPO), а точно настроенная модель называется моделью PPO.

Что такое РРО? Вот основные выводы этого метода:

- PPO — это алгоритм, который используется для обучения агентов обучению с подкреплением. Он называется алгоритмом «в соответствии с политикой», потому что он учится и обновляет текущую политику напрямую , а не извлекает уроки из прошлого опыта, как в алгоритмах «вне политики», таких как DQN (Deep Q-Network). Это означает, что PPO постоянно адаптирует текущую политику на основе действий, предпринимаемых агентом, и вознаграждений, которые он получает.

- PPO использует метод оптимизации области доверия для обучения политики, что означает, что он ограничивает изменение политики в пределах определенного расстояния от предыдущей политики для обеспечения стабильности. Это отличается от других методов градиента политики, которые иногда могут вносить большие обновления в политику, что может дестабилизировать обучение.

- PPO использует функцию значений для оценки ожидаемого возврата данного состояния или действия .

Функция значения используется для вычисления функции преимущества, которая представляет собой разницу между ожидаемым доходом и текущим доходом. Затем функция преимущества используется для обновления политики путем сравнения действия, предпринятого текущей политикой, с действием, которое было бы предпринято предыдущей политикой. Это позволяет PPO делать более информированные обновления политики на основе предполагаемой ценности предпринимаемых действий.

Функция значения используется для вычисления функции преимущества, которая представляет собой разницу между ожидаемым доходом и текущим доходом. Затем функция преимущества используется для обновления политики путем сравнения действия, предпринятого текущей политикой, с действием, которое было бы предпринято предыдущей политикой. Это позволяет PPO делать более информированные обновления политики на основе предполагаемой ценности предпринимаемых действий.

На этом этапе модель PPO инициализируется из модели SFT, а функция значения инициализируется из модели вознаграждения . Среда представляет собой бандитскую среду, которая представляет случайную подсказку и ожидает ответа на подсказку. Учитывая подсказку и ответ, он производит вознаграждение (определяемое моделью вознаграждения), и эпизод заканчивается. Штраф KL для каждого токена добавляется из модели SFT в каждый токен, чтобы смягчить последствия оптимизации модели вознаграждения.

Оценка производительности

Поскольку модель обучается на вводе данных людьми, основная часть оценки также основана на вводе данных человеком , т. е. это происходит, когда специалисты оценивают качество выходных данных модели. Чтобы избежать переобучения по мнению маркировщиков, участвующих в этапе обучения, в тестовом наборе используются подсказки от клиентов OpenAI, которые не представлены в обучающих данных.

е. это происходит, когда специалисты оценивают качество выходных данных модели. Чтобы избежать переобучения по мнению маркировщиков, участвующих в этапе обучения, в тестовом наборе используются подсказки от клиентов OpenAI, которые не представлены в обучающих данных.

Модель оценивается по трем критериям высокого уровня:

- Полезность: оценка способности модели следовать инструкциям пользователя, а также выводить инструкции.

- Правдивость: оценка склонности модели к галлюцинациям (придумыванию фактов) в задачах с закрытой областью. Модель оценивается в наборе данных TruthfulQA.

- Безвредность: маркировщики оценивают, являются ли выходные данные модели подходящими, очерняющими защищенный класс или содержащими уничижительный контент. Модель также тестируется на наборах данных RealToxicityPrompts и CrowS-Pairs.

Модель также оценивается на предмет нулевой производительности при выполнении традиционных задач НЛП, таких как ответы на вопросы, понимание прочитанного и подведение итогов, на некоторых из которых разработчики наблюдали снижение производительности по сравнению с GPT-3 . Это пример «налога на выравнивание», когда процедура выравнивания на основе RLHF достигается за счет более низкой производительности при выполнении определенных задач.

Это пример «налога на выравнивание», когда процедура выравнивания на основе RLHF достигается за счет более низкой производительности при выполнении определенных задач.

Снижение производительности этих наборов данных можно значительно уменьшить с помощью трюка под названием 9.0027 pre-train mix : во время обучения модели PPO с помощью градиентного спуска обновления градиента вычисляются путем смешивания градиентов модели SFT и модели PPO.

Недостатки методологии

Очень явным ограничением методологии, как обсуждалось в документе InstructGPT (на котором, по словам его создателей, основан ChatGPT), является тот факт, что в процессе согласования языковых моделей с человеческими намерениями, на данные для тонкой настройки моделей влияет множество разнообразных субъективных факторов, в том числе:

- Предпочтения этикетировщиков, производящих демонстрационные данные.

- Исследователи, которые разрабатывают исследование и пишут инструкции по маркировке.

- Выбор подсказок, созданных разработчиками или предоставленных клиентами OpenAI.

- Предвзятость маркировщиков включена как в обучение модели вознаграждения (путем ранжирования выходных данных) , так и в оценку модели .

В частности, авторы отмечают тот очевидный факт, что маркировщики и исследователи, участвующие в процессе обучения, могут не представлять всех потенциальных конечных пользователей языковой модели.

Помимо этого явного «внутреннего» ограничения, мы хотим указать на несколько других возможных недостатков метода, проблемы, не рассмотренные явно, а также некоторые открытые вопросы:

Отсутствие контрольного исследования производительность окончательной модели PPO, взяв за основу модель SFT. Это может ввести в заблуждение: как мы можем знать, что улучшения на самом деле связаны с RLHF? Надлежащее (но дорогое) контрольное исследование будет состоять в том, чтобы вложить точно такое же количество часов маркировщика, которое использовалось для обучения модели вознаграждения, в создание более крупного курируемого набора данных SFT с высококачественными демонстрационными данными. Тогда можно было бы объективно измерить улучшение производительности методологии RLHF по сравнению с контролируемым подходом. Проще говоря, отсутствие такого контрольного исследования оставляет фундаментальный вопрос полностью открытым: действительно ли RLHF хорошо справляется с согласованием языковых моделей?

Тогда можно было бы объективно измерить улучшение производительности методологии RLHF по сравнению с контролируемым подходом. Проще говоря, отсутствие такого контрольного исследования оставляет фундаментальный вопрос полностью открытым: действительно ли RLHF хорошо справляется с согласованием языковых моделей?

Отсутствие оснований для сравнения данных : маркировщики часто могут расходиться во мнениях относительно ранжирования выходных данных модели. С технической точки зрения, риск состоит в том, чтобы добавить высокую потенциальную дисперсию к сравнительным данным без какой-либо достоверной информации.

Человеческие предпочтения просто неоднородны : Метод RLHF рассматривает человеческие предпочтения, как если бы они были однородными и статичными. Предположение, что все люди разделяют одни и те же ценности, было бы очевидным преувеличением, по крайней мере, в отношении большого количества тем человеческих знаний. Некоторые недавние исследования начинают решать эту открытую проблему по-другому.

Тестирование стабильности подсказки для модели вознаграждения (RM) : Кажется, не проводилось экспериментов по изучению чувствительности модели вознаграждения с точки зрения изменений в подсказке ввода. Если две подсказки синтаксически различны, но семантически эквивалентны, может ли RM показать существенные различия в ранжировании выходных данных модели? Проще говоря, насколько качество подсказки имеет значение для RM?

Проблемы типа Wireheading : В подходах RL модель иногда может научиться манипулировать своей собственной системой вознаграждения для достижения желаемого результата, что приводит к «чрезмерно оптимизированной политике». Это может подтолкнуть модель к воссозданию некоторых шаблонов, которые по какой-то неизвестной причине повышают оценку модели вознаграждения (см. Таблицу 29).в этой статье от OpenAI для явного примера такого поведения в языковом моделировании). ChatGPT исправляет это с термином штрафа KL в функции вознаграждения. Обратите внимание, что кто-то пытается оптимизировать ввод RM (то есть вывод PPO), чтобы улучшить его вывод (оценка вознаграждения), , при этом ограничивая сам ввод, чтобы он не был слишком далеко от некоторого эталонного ввода. (выход SFT). Подробнее об ограничениях этого подхода в этом недавнем препринте.

Обратите внимание, что кто-то пытается оптимизировать ввод RM (то есть вывод PPO), чтобы улучшить его вывод (оценка вознаграждения), , при этом ограничивая сам ввод, чтобы он не был слишком далеко от некоторого эталонного ввода. (выход SFT). Подробнее об ограничениях этого подхода в этом недавнем препринте.

Избранные ссылки для дальнейшего чтения

- Наиболее актуальным документом о методологии RLHF, используемой для ChatGPT, является обучение языковых моделей следованию инструкциям с обратной связью человека, в которой фактически подробно описывается модель под названием InstructGPT, которую OpenAI называет «родственной моделью». » в ChatGPT.

- Anthropic опубликовал подробное исследование эффективности методов RLHF для точной настройки языковых моделей, чтобы они служили полезными и безвредными помощниками.

- В документе «Учимся обобщать на основе отзывов людей» описывается RLHF в контексте суммирования текста.

- Проксимальная оптимизация политики: документ по алгоритму PPO.

get(url ).текст

get(url ).текст  parser"

parser"

На этом наборе данных обучается новая модель. Это называется моделью вознаграждения (RM) .

На этом наборе данных обучается новая модель. Это называется моделью вознаграждения (RM) . 5. Предположительно, в качестве базовой модели использовалась последняя модель

5. Предположительно, в качестве базовой модели использовалась последняя модель

Функция значения используется для вычисления функции преимущества, которая представляет собой разницу между ожидаемым доходом и текущим доходом. Затем функция преимущества используется для обновления политики путем сравнения действия, предпринятого текущей политикой, с действием, которое было бы предпринято предыдущей политикой. Это позволяет PPO делать более информированные обновления политики на основе предполагаемой ценности предпринимаемых действий.

Функция значения используется для вычисления функции преимущества, которая представляет собой разницу между ожидаемым доходом и текущим доходом. Затем функция преимущества используется для обновления политики путем сравнения действия, предпринятого текущей политикой, с действием, которое было бы предпринято предыдущей политикой. Это позволяет PPO делать более информированные обновления политики на основе предполагаемой ценности предпринимаемых действий.