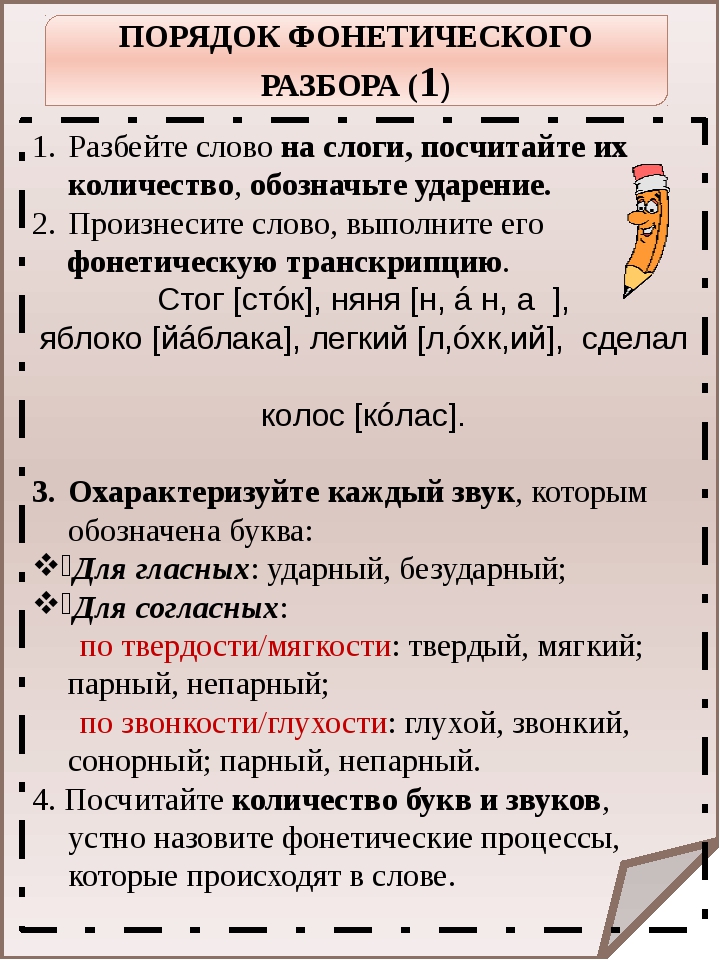

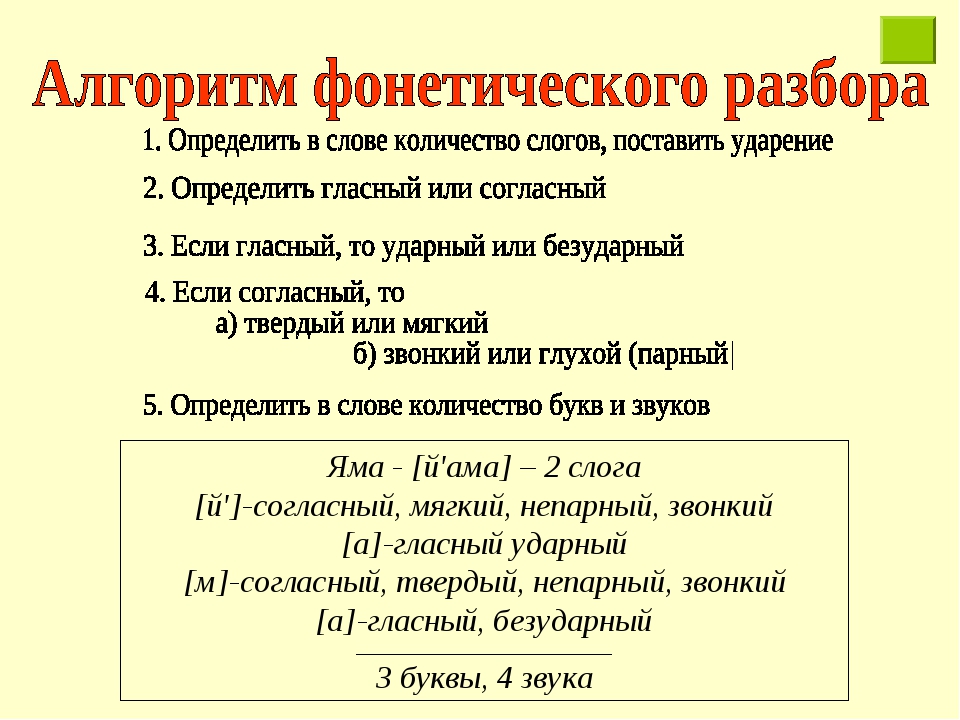

Правила фонетического разбора слов, фонетика гласных и согласных

Перечислим правила, которые нужно учитывать при фонетическом разборе слова: составлении транскрипции и фонетической характеристики. Рассмотрим правила для мягкого и твердого знаков, для гласных и согласных звуков. Существуют отдельные нюансы из списка правил, которым уделяют внимание в средних классах и не изучают в начальной школе, для них приведем примеры. Рассматриваемые на этой странице правила корректны и полны только для школьной программы.

Обозначения

Используемые при фонетическом разборе обозначения:

- Транскрипция слова заключается в квадратные скобки: семья → [с’им’й’а]. Иногда в транскрипции ставят знак ударения: [с’им’й’а ́];

- Каждый звук в фонетическом разборе заключается в квадратные скобки: с — [с], и — [и], м — [м’] и т.д. Напротив мягкого и твёрдого знаков ставят прочерк или прочерк в квадратных скобках: ь — [–];

- Мягкость звука помечается знаком апострофа: м — [м’];

- Долгий звук (долгое звучание) обозначают через двоеточие: теннис → [т’эн’:ис], грузчик → [грущ’:ик];

- В большинстве школьных программ в конце фонетического разбора проводится черта, под которой указывается число букв и звуков в слове.

Детальный план, устный и письменный примеры фонетических разборов представлены на странице план и примеры.

Правила для ь, ъ

- Буквы ь, ъ не обозначают звуков. В транскрипции слова они не могут присутствовать.

- Буква ь делает мягким предыдущий согласный.

- Буква ъ используется только в качестве разделительного знака.

Фонетика гласных

- Не бывает звуков [е], [ё], [ю], [я]. В транскрипции слова они не могут присутствовать.

- Буквы а, о, у, ы, э предыдущий согласный делают твёрдым.

- Буквы я, ё, ю, и, е предыдущий согласный делают мягким. Но в некоторых иноязычных словах согласный перед буквой е остаётся твёрдым.

Кафе → [кафэ], купе → [купэ], отель → [атэл’]. - Буквы я, ю, е, ё после согласных обозначают следующие звуки: я → [а], ю → [у], е → [э], ё → [о].

Мяч → [м’ач’], мел → [м’эл]. - Буквы я, е, э, о после согласных без ударения обозначают следующие звуки: я → [э] или [и], е → [и], э → [э] или [и], о → [а].

Рябина → [р’эб’ина], пятно → [п’итно], весело → [в’эс’ила], корова → [карова]. - Буква ё, я, ю, е после гласных, после ъ, ь и в начале слова обозначают следующие звуки: я → [й’а], ю → [й’у], е → [й’э], ё → [й’о] (под ударением) и я → [й’и], е → [й’и] (без ударения). Их называют йотированными. В некоторых изданиях вместо й пишут j.

- Буква и после ь обозначает звук [й’и].

Ручьи → [руч’й’и]. - Буква и после согласных ж, ш, ц обозначает звук [ы].

Обобщим правила для «преобразования» гласных букв в звуки таблицей:

| а | о | е | у | ю | ё | я | э | ы | ||

|---|---|---|---|---|---|---|---|---|---|---|

| под ударением | а | о | и | э | у | у | о | а | э | ы |

| без ударения | а | а | и | и | у | у | о | э, и | э, и | ы |

| в начале слова | а | о | и | й’э | у | й’у | й’о | й’а | э | ы |

| после гласных | а | о | и | й’э | у | й’у | й’о | й’а | э | ы |

| после ь, ъ | а | о | й’и | й’э | у | й’у | й’о | й’а | э | ы |

| после ж, ш, ц | ы | о | ы | ы | у | у | о | а | э | ы |

Фонетика согласных

- В фонетическом разборе мягкие согласные обознаются знаком апострофа ‘: [л’], [с’], [ч’] и т.

д.

д. - В фонетическом разборе долгий звук (тянущийся) обозначается через двоеточие [ж:], [ц:] или черточкой над звуком [ж], [ц].

- Буквы й, ч, щ всегда обозначают мягкие звуки: [й’], [ч’], [щ’]. Они остаются мягкими, даже если после них следуют гласные а, о, у, ы, э.

- Буквы ж, ц, ш всегда обозначают твёрдые звуки: [ж], [ц], [ш]. Они остаются твёрдыми, даже если после них следуют гласные я, ё, ю, и, е.

- Буква й всегда обозначает звонкий и мягкий звук [й’].

- Буквы л, м, н, р, й всегда обозначают звонкие звуки и называются сонорными.

- Буквы х, ц, ч, щ всегда обозначают глухие звуки.

- Парные по звонкости/глухости согласные в конце слова и перед глухой согласной обозначают глухой звук: б → [п], д → [т], г → [к], з → [с], в → [ф]:

столб → [столп], поезд → [пой’эст]. - Непроизносимые согласные в, д, л, т в корне не обозначают звука:

- Двойные согласные после ударного гласного дают долгий звук:

группа → [груп:а], теннис → [тэн:ис]. - Двойные согласные перед ударным гласным дают согласный одинарный звук:

миллион → [м’ил’ион], аллея → [ал’эй’а].

В некоторых случаях:

- Буква с в начале слова означает звонкий звук [з]:

сделал → [з’д’элал]. - Буква г перед глухой согласной произносится как [к] или [х]:

когти → [кокт’и], мягкий → [м’ах’к’ий’] - Согласные между корнем и суффиксом перед мягкой согласной произносятся мягко:

зонтик → [зон’т’ик]. - Буква н обозначает мягкий звук перед согласными ч, щ:

стаканчик → [стакан’ч’ик], сменщик → [см’эн’щ’ик]. - Сочетание -чн-, -чт- произносится как [ш]:

конечно → [кан’эшна], скучно → [скушна], что → [што].

Сочетание определённых согласных букв в словах дает долгий или непроизносимый звук:

- Сочетание букв -зж- обозначают один звук [ж:]:

изжить → [иж:ыт’], уезжать → [уиж:ат’]. - Сочетание букв -тьс-, -тс- обозначает один звук [ц:]:

купаться → [купац:а].

- Сочетание букв -стн- произносится как [сн], -стл- — [сл], -здн- — [зн]:

звёздный → [зв’озный’], лестница → [л’эс’н’ица]. - В окончаниях прилагательных -ого, -его согласная Г обозначает звук [в]:

золотого → [залатова], синего → [син’эва]. - Сочетания букв -сч-, -зч-, -жч- обозначают звук [щ’]:

счастливый → [щ’асливый’], извозчик → [извощ’ик], перебежчик → [п’ир’иб’эщ’ик].

Это все основные правила фонетического разбора. Для закрепления темы в рамках школьной программы подойдет издание Литневской Е.И. «Русский язык. Краткий теоретический курс для школьников.»

Существует целый ряд правил программы института и углублённого изучения фонетики русского языка. Правила учитывают тонкости современного фонетического произношения и фонетические особенности за последние столетия. Такие правила не рассматриваются в школьной программе, чтобы не усложнить и без того сложную для понимания школьников тему. Так, вне рамок школьной программы рассматриваются варианты с мягким звуком [ж’], в том числе характерного для старомосковского произношения. В корне слова в сочетаниях -жж-, -зж- и -жд- в слове дождь вместо твердого звука [ж:] имеет место быть мягкий [ж’:]. Например, дрожжи – [дрож’:и]. По другому правилу: буква щ перед звонкой согласной получает озвончение и отмечается звонким звуком [ж’:]. Например, в слове вещдок – [в’иж’:док].

Слова с буквой ё обязательно пишите через ё. Фонетические разборы слов «еж» и «ёж» будут разными!

10 правил самостоятельного разбора гардероба

.

«Девушки, устраивайте свой гардероб! После того, как он устроится, личная жизнь устроится сама собой!» — Эвелина Хромченко.Женщины могут все: вести хозяйство, руководить предприятиями и даже летать в космос, но с собственным гардеробом разобраться удается не всегда!

Парадоксальное утверждение «мало места в шкафу, а надеть нечего!» — вовсе не шуточное определение переменчивости настроений прекрасных дам, а реальная проблема, с которой сталкиваются почти все женщины, независимо от материального достатка, образования и наличия вкуса.

Как один раз и навсегда систематизировать вещи и навести порядок в шкафу? Даю 10 правил, следуя которым можно в буквальном смысле разложить все по полочкам!

Прежде всего необходимо выяснить, почему в шкафу мало места? Может, причина неорганизованности гардероба в слишком маленьком пространстве для хранения вещей? Или одежда валяется в нем как попало? Тогда стоит позаботиться о покупке шкафа оптимальных размеров, потому что бессистемное складирование нарядов, обуви и аксессуаров совершенно не способствует умению быстро составлять стильные комплекты.

Более того, подобное отношение к гардеробу портит вкус! Если же одежда хоть как-то систематизирована, например, по ассортименту, цветам или сезонам, ее неоправдано много, а носить все равно нечего, значит, вы оказались в плену сладкой иллюзии большого количества вещей. Что это значит? А то и значит, что одежды фактически много, но использовать ее нельзя, потому что:

— вещи малы или велики

— вышли из моды

— потеряли внешний вид или попросту заношены

Итак, правило №1

Проведите ревизию гардероба!

«Ревизия гардероба — вытащила все вещи, перемерила их, устала и сложила обратно» Народный фольклор

Шутки шутками, а большинство разборов вещей проходят именно так: одежда сваливается в кучу, какое-то время сортируется, а потом накатывают воспоминания: в этом платье познакомилась с будущим мужем, а в той юбке плясала на дискотеке, и все завершается отчаянной попыткой влезть в эталонные джинсы, усталостью и заталкиванием вещей обратно в шкаф.

Правило № 2

Потратьте время, выделенное на ревизию гардероба, с умом!

Для начала отложите в сторону одежду, обувь, сумки и, возможно, аксессуары, которые потеряли внешний вид от частого использования или попросту заношены. Вещи, непригодные даже в качестве одежды для дома: растянутые, полинявшие от стирок или покрывшиеся катышками.

Хранить такую одежду не имеет никакого смысла, однако если внутренний «Плюшкин» вопит и протестует против выбрасывания старого хлама, хотя бы уберите его в коробки и задвиньте подальше с глаз долой!

Далее отложите вещи, которые не подходят по размеру, малы, велики или плохо сидят по фигуре. Иногда платье меньшего размера, висящее в гардеробе, действительно может стать хорошим стимулом правильно питаться и заниматься фитнесом, но, если такой одежды много, ничего, кроме постоянного стресса, она не даст!

Иногда платье меньшего размера, висящее в гардеробе, действительно может стать хорошим стимулом правильно питаться и заниматься фитнесом, но, если такой одежды много, ничего, кроме постоянного стресса, она не даст!

Представьте: женщина открывает шкаф, видит ряд платьев, юбок и жакетов, которые ей малы и понимает, что не какая-то единичная вещь не подходит ей, а она не соответствует большинству вещей своего гардероба!

Правило №3

Будьте честны с собой! Если одежда мала, уберите ее, купите наряды по размеру и живите спокойно! Захотите — похудеете. Кроме того, нет никакой гарантии, что платье или юбка хорошо сядут на похудевшую фигуру, так какой смысл тешиться иллюзиями?

Одежда, которая велика, нуждается в коррекции. Ее можно не убирать, а, например, отнести в ателье и подогнать по размеру и фигуре. Однако если вы понимаете, что не хотите или не успеваете этим заняться, просто отдайте такую одежду тому, кому она подойдет по размеру, чтобы она не отвлекала от реального гардероба и не создавала фантом большого количества вещей.

Следующая категория — одежда, которая устарела или вышла из моды. В первую очередь, если в гардеробе есть одежда старше 7-10 лет, смело убирайте ее подальше, она устарела. К слову, обувь тоже устаревает!

Под исключение могут попасть:

— свитер или водолазка, которые вам идут по цвету (необходимо смотреть качество полотна и вязки, они также могут устаревать)

— прямые темно-синие или черничные джинсы

— рубашки в клетку

— футлярное платье без лишних деталей

— юбка-карандаш, хорошо сидящая по фигуре

Правило №4

Не лучшая идея формировать свой гардероб по принципу «достаем из бабушкиного сундука и становимся модными». Все это пишется исключительно ради красного словца и не имеет отношения к действительности. Мода, даже возвращаясь, никогда не копирует сама себя.

70-е в коллекции Sonia Rykiel pre-fall 2015-2016

И последняя группа вещей, которая, возможно, отправится на выброс — одежда, которую по каким-либо причинам не надевали больше года.

Следует уточнить, что речь сейчас идет о повседневных вещах, а не вечернем платье в пол или расшитом кристаллами жакете-болеро.

Следует уточнить, что речь сейчас идет о повседневных вещах, а не вечернем платье в пол или расшитом кристаллами жакете-болеро.Очевидно, что наряды, которые надеваются «в честь и по поводу», могут использоваться реже, чем раз в год, их и хранить следует в отдельном шкафу или хотя бы секции, а не вместе с повседневной одеждой!

Ну, а тех несчастных, которые подходят по размеру и актуальны времени, но, тем не менее, оказались не у дел целый год, необходимо отложить в сторону и приступить к следующему этапу.

Правило №5

Уберите из шкафа все лишнее, и вы обнаружите одно из двух: носить, оказывается, есть что или надеть действительно нечего!

Оставшиеся вещи необходимо рассортировать на группы по сезонам и сосредоточиться на том периоде, который актуален для вас прямо сейчас. На дворе весна? Работаем с весенне-летним гардеробом. Зима? С осенне-зимним.

Правило №6

Одежда и гардероб в целом — один из немногих сегментов человеческой жизни, который очень сложно планировать надолго вперед. Мода переменчива и скоротечна, универсальных вещей на все случаи жизни мало, и они не могут составлять весь гардероб.

К тому же меняется не только мода, но и мы сами — фигура, возраст, отношение к внешности и т. д. Поэтому старайтесь сосредотачиваться на конкретном моменте, например, одном сезоне. Такое отношение позволит рационально формировать гардероб и, как ни странно, экономить!

Нет смысла покупать весной зимний свитер, потому что скидка/теплый/просто хочется в расчете на то, что будете носить его в следующем году. Купите лучше вещь, необходимую прямо сейчас и надевайте с удовольствием сегодня, а не когда-то в будущем.

И, наконец, оставшиеся вещи одного сезона необходимо проанализировать по следующей схеме:

— определить базовую одежду

— составить полноценные комплекты (одежда, обувь, сумка, аксессуары) из того, что есть в наличии

— попробовать переиграть стандартные комбинации и сочетать вещи по-другому

— обнаружить одежду и обувь, которые не подходят ни к чему из имеющегося

— составить список покупок

Правило №7

Составляя комплекты одежды, помните, что стиль всего аутфита чаще всего задает обувь! Сегодня традиционная юбка-карандаш может сочетаться и с туфлями на каблуке, и с кроссовками. В первом случае удачными получатся образы, где юбку дополняют рубашка, блузка или свитшот, а во втором лучше сочетать низ с футболкой или свитшотом (вещами в спортивном стиле).

В первом случае удачными получатся образы, где юбку дополняют рубашка, блузка или свитшот, а во втором лучше сочетать низ с футболкой или свитшотом (вещами в спортивном стиле).

Какой бы демократичной не была мода, правила есть всегда! Кроссовки в сочетании с юбкой-карандаш диктуют верх в спортивном стиле, туфли допускают разные варианты

Попробуйте собирать аутфит не сверху вниз — блузка/юбка/обувь, а, наоборот, снизу вверх — обувь, юбка, рубашка, тогда ошибок в стиле будет значительно меньше.

«Сочетать вещи по-другому» — вовсе не значит дополнять юбку рубашкой в один день и такой же рубашкой, но иного цвета, в другой.

Современная мода характерна сочетанием разных фактур и многослойностью, поэтому будьте смелее и попытайтесь найти совершенно нетипичные для вас решения, например, соединить в один наряд вечернюю, полупрозрачную юбку и объемный джемпер крупной вязки или кожаную юбку с разрезом и офисный верх — рубашку и жилетку.

Многофактурность и многослойность — основа современной моды

Правило №8

Часто, желая разнообразить свой гардероб, женщины приобретают почти одинаковые блузки, джемперы или рубашки, полагая, что смена однотипного по фасону верха воспринимается окружающими как разнообразие, однако и это заблуждение!

Реальность же такова: юбка с белой рубашкой и та же юбка, но с рубашкой синей, распознается людьми как один и тот же наряд! Чтобы гардероб был действительно разнообразным, необходимо варьировать не только цвета, но и вырезы горловины, и фактуру ткани, и дополнения в виде аксессуаров.

Разнообразие создают действительно разные вещи!

Если и после того, как одежда не раз перетасована между собой, остались вещи без пары, придется оценить их критически и принять решение, стоит ли овчинка выделки? Конечно, можно потратить время, теоретически подобрать к ним недостающие элементы и постараться найти их в магазине, но при этом следует помнить, что на другой чаше весов уже есть год времени, когда вещь не была востребована вообще.

Правило №9

Составляя список покупок, ориентируйтесь на те комплекты одежды, обувь и аксессуары, которые вы уже используете. Например, если в наличии есть базовые брюки, которые вы носите с рубашками, блузками, джемперами и планируете докупить к ним жакет, а также имеется юбка с воланами и цветочным принтом, для которой нет пары в гардеробе, покупать лучше жакет.

Т.е. в приоритете должны быть стратегически важные комплекты и вещи.

И, наконец, правило №10

Для того, чтобы навести порядок в гардеробе, мало прочитать статью с рекомендациями на сайте стилиста, надо пойти и сделать это!

Если хотите проработать свой весенне-летний гардероб под моим контролем — переходите по кнопке ниже.

Хочу проработать весенне-летний гардероб

Автор: Екатерина Малярова

Имиджмейкер, создатель тренингов по имиджу и стилю, автор сайта Гламурненько.ru. С 2007 года свыше 500 клиентов сходили со мной на шоппинги. Более 5000 человек проходили тренинги и семинары по имиджу и стилю.

Правила разбора iPhone 5C | Новости Modmac

Инструкция по разбору iPhone 5C

iPhone 5C – более простая модель, в сравнении с iPhone 5S. Давайте рассмотрим, как правильно разобрать такое устройство, в случае, если вы решите выполнить самостоятельно ремонт iphone 5c. Между этими моделями есть отличия. Разница заметна даже в шурупах «Пенталоб», шапки которых разительно отличаются друг от друга. Исходя из этого, вам потребуются разные отвёртки.Конечно, же ремонт айфона 5C — это очень серьезное дело, которое требует максимум внимания. Кроме того, каждый пользователь должен учитывать, что в ходе самостоятельного ремонта айфона владелец может утерять официальную гарантию «Эппл». Он берет ответственность за все повреждения, которые могут возникнуть в ходе выполнения работ.

Видеоинструкция по разбору iPhone 5C

com/embed/AYrrTdM5Tms» frameborder=»0″ allowfullscreen=»»/>

Подробная пошаговая инструкция разбора iPhone 5C

Очень важно перед началом ремонтных работ обязательно выключите iPhone 5c, а уже после приступайте к демонтажу дисплейного блока Айфона 5ц. Алгоритм, в данном случае, такой же, как и в случае с Айфоном 5s. Выкручиваем винты, берем присоску, отделяем ею экран от корпуса айфона.

Аккумулятор устройства прикреплен к корпусному основанию. Но будьте предельно осторожны, потому что при снятии, батарею можно повредить. Чтобы избежать таких неприятностей, корпус прогревают. Для этого используется обычный бытовой фен. Но не перегревайте, температура не должна превышать шестидесяти градусов по Цельсию.

Далее – работа с материнской платой. На поверхности материнской платы расположен процессор, трансивер и модем. Их необходимо извлечь. Осуществляя ремонт iphone 5c, вы можете заметить, что материнская плата не очень отличается от предыдущей модели. Можно с уверенностью сказать, что в данном случае, отличия только в расположении крепления шлейфа.

Открутив остальные шурупы вы сможете извлечь камеру.

В нижней части телефона вы можете увидеть восьмиконтактный разъём, выход для гарнитуры, а также микрофон. Раскручиваем все винты, расположенные в этой части, достаём плату.

Корпус у представленной модели – прочный, для его создания использовался поликарбонат. Общая масса устройства увеличилась незначительно, всего на девятнадцать граммов.

Общая масса устройства увеличилась незначительно, всего на девятнадцать граммов.

Айфон разобран. Можно начинать ремонт айфон 5ц. Сборку осуществляют в обратной последовательности.

Очистка и разбор текста | BaseGroup Labs

Введение

Возможности машинной обработки информации внутри организации варьируются в зависимости от степени структуризации данных. Чем выше степень структурированности данных, тем больше возможностей для их автоматизированной обработки. Данные можно поделить на 3 части:

- Высоко структурированные. Это такого рода данные, как счета, платежные документы, отчеты и прочее. Для такого рода данных есть четкие форматы, правила, жестко задан внешний вид. Обычно они хранятся в базах данных компании.

- Частично структурированные. Описания деталей и продукции, технологическая документация, сведения о сотрудниках и прочее. Для этих данных определены некоторые правила и форматы, но в самом общем виде.

- Неструктурированные. Это электронные письма, сведения о конкурентах, докладные записки и прочее сведения, которые пишутся в свободной форме.

Очевидно, что механизмы подготовки, фильтрации, анализа и обработки, например, сведений, представленных в виде отчетов, значительно мощнее, чем механизмы обработки произвольного текста. В связи с этим, если мы хотим использовать автоматизированные механизмы обработки, необходимо применять способы повышения уровня структурированности используемых данных.

Значительная часть информации в организации представлена в частично структурированном виде – вот для таких текстов возможно создание механизмов, преобразующих их к четкому (структурированному) виду. Например, у нас есть описание препарата «Инсулин ЛЕНТЕ SPP сусп.40 ЕД/1 мл 10 мл». Необходимо данные очистить от незначимых и искаженных сведений и выделить название препарата, фасовку, дозировку и т. п. Назовем этот процесс стандартизацией. Стандартизованную информацию значительно проще обрабатывать, искать, формировать на их основе буклеты и прайс-листы, делать переводы на другие языки.

п. Назовем этот процесс стандартизацией. Стандартизованную информацию значительно проще обрабатывать, искать, формировать на их основе буклеты и прайс-листы, делать переводы на другие языки.

В статье описан вариант решения задачи очистки и разбора частично структурированных текстов.

Описание проблемы

Возьмем для примера описание клавиатуры: «Клавиатура Defender, Windows-совместимая, разъем PS/2, 124 клавиши». Такого рода описания встречаются практически в любой сфере деятельности.

Необходимо данный текст преобразовать к виду:

| Поле | Значение |

|---|---|

| Тип устройства | Клавиатура |

| Торговая марка | Defender |

| Интерфейс | PS/2 |

| Совместимость | Windows |

Несмотря на то, что в различных предметных областях используются различные термины и понятия, есть то, что объединяет все такие тексты. Во-первых, это неестественный язык, поэтому они пишутся не как предложения, а по совершенно другим правилам; гораздо проще. Во-вторых, описания практически всегда схожи друг с другом по структуре. В-третьих, чаще всего используются один и тот же относительно небольшой, если сравнивать с естественной речью, набор слов. В-четвертых, очень часто встречаются аббревиатуры и сокращения. Используя эту информацию, можно предложить решение, позволяющее автоматизировать работу по очистке и разбору текста.

Вариант решения задачи

Нашей компанией разработана система, позволяющая решать данную задачу. Для этого используется специализированная база знаний, в которую импортируются стандартизируемые материалы. В базе знаний накапливаются сведения о предметных областях, правилах очистки и разбора текстов. Работает это следующим образом.

Перед началом разбора пользователь формирует шаблон разбора для конкретной предметной области, на основе которого в дальнейшем и производится анализ текстов. Например:

| Предметная область | Периферийные устройства ПК |

|---|---|

| Шаблон разбора | Тип устройства |

| Торговая марка | |

| Изготовитель | |

| ГОСТ | |

| Интерфейс | |

| Совместимость | |

| Сертификаты | |

| Цвет |

После подготовки такого шаблона и начинается, собственно, работа по разбору текста.

Первые тексты пользователь разбирает самостоятельно, т.е. указывает, что «клавиатура» – это тип устройства, «серый» – это цвет. При этом он фактически обучает программу, как нужно разбирать данные. По мере того, как программе показывают все больше примеров, она накапливает все больше знаний и начинает угадывать все больше вариантов разбора.

Сильной стороной программы является то, что она использует самообучающиеся алгоритмы, позволяющие на лету обучаться правилам разбора, с учетом особенностей конкретной предметной области. Благодаря такому подходу система, вначале не имея никаких жестко заложенных алгоритмов разбора, по мере работы обучается и начинает помогать пользователю, предлагая правильные варианты разбора. В системе используются оригинальные эффективные алгоритмы, позволяющие корректно анализировать текст с ошибками, пропущенными и/или лишними словами и различными вариантами расположения слов.

Еще одно интересной особенностью системы является то, что если пользователь начинает работать с предметной областью отличной от обрабатываемой до этого, но достаточно близкой к ней, программа в состоянии использовать ранее найденные правила разбора, т.е. если вы перейдете после описания клавиатур к разбору сведений о мониторах, система будет в состоянии использовать «опыт», накопленный при анализе клавиатур.

Результаты

Система на практике демонстрирует хорошие результаты разбора, причем вне зависимости от языка. После начала работы по разбору текста по какой-либо предметной области, обработав буквально нескольких десятков текстов, программа начинает «угадывать», как правильно нужно разбирать и по мере накопления знаний увеличивает точность разбора, достаточно быстро доходя до уровня 80-90% верно обработаных текстов.

В результате использование данной системы позволяет, во-первых, значительно (в разы) увеличить скорость обработки текстов, во-вторых, повысить качество благодаря тому, что одни и те же термины всегда разбираются идентично. При ручной обработке периодически возникают разночтения. В-третьих, после «обучения системы» использовать менее квалифицированные карды для обработки значительной части текстов, т. е. повысить эффективной работы.

При ручной обработке периодически возникают разночтения. В-третьих, после «обучения системы» использовать менее квалифицированные карды для обработки значительной части текстов, т. е. повысить эффективной работы.

В организациях накопились огромные объемы данных, которыми неудобно пользоваться из-за их «нетехнологичности». Конечно, специалист скорее всего разберется с любым грамотно составленным описанием. Но в случае машинной обработки необходимо представить сведения в удобном именно для машинной обработки виде, т.е. в стандартизованном. Описанная система позволяет значительно повысить возможности автоматизированной обработки частично структурированных данных.

Еще одной перспективной областью применения использованных в программе механизмов является поддержка процесса перевода. Дело в том, что система сохраняет данные не только о правилах разбора, но и в том, как до этого разбирался текст. Программа автоматически создает и пополняет словари, поэтому имея переводы слов, возможен автоматический перевод уже стандартизованного текста и генерация на их основе многоязычных прайс-листов, буклетов, описаний и т.п.

Морфологический разбор глагола «правило» онлайн. План разбора.

Для слова «правило» найдено 2 варианта морфологического разбора

- Часть речи. Общее значение

Часть речи слова «правило» — глагол - Морфологические признаки.

- править (инфинитив)

- Постоянные признаки:

- 2-е спряжение

- переходный

- несовершенный вид

- изъявительное наклонение

- единственное число

- прошедшее время

- средний род.

- Может относится к разным членам предложения.

- Часть речи. Общее значение

Часть речи слова «правило» — глагол - Морфологические признаки.

- править (инфинитив)

- Постоянные признаки:

- 2-е спряжение

- непереходный

- несовершенный вид

- изъявительное наклонение

- единственное число

- прошедшее время

- средний род.

- Может относится к разным членам предложения.

Поделитесь страницей с друзьями — это лучшая благодарность

Морфологический разбор другого слова

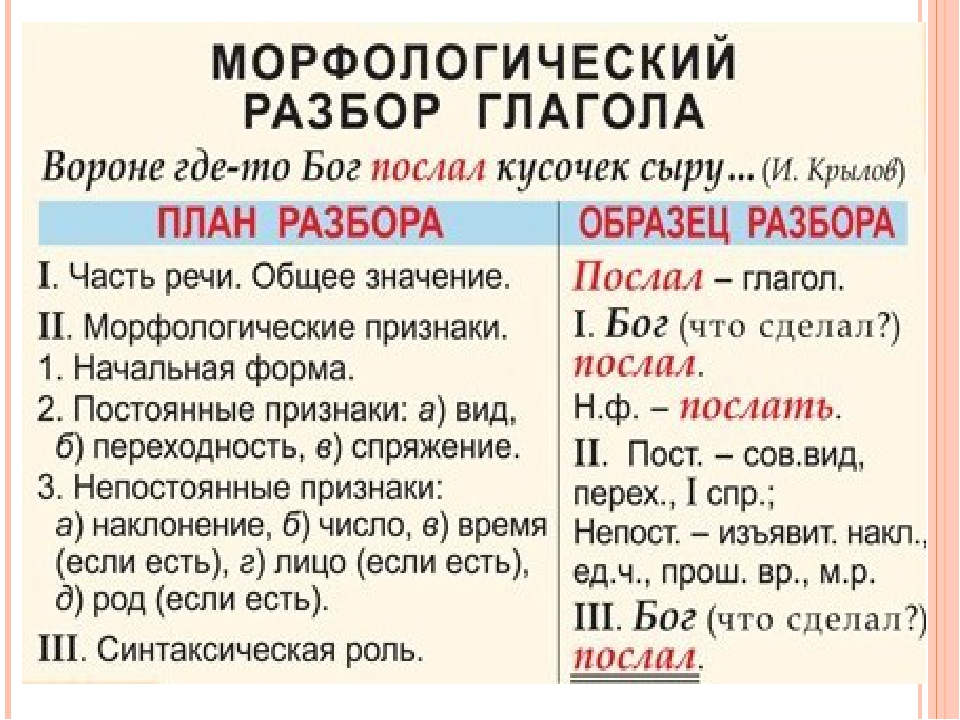

План разбора глагола

- Часть речи. Общее значение

- Морфологические признаки.

- Начальная форма (инфинитив)

- Постоянные признаки:

- Вид (совершенный (что сделать?) или несовершенный (что делать?)

- переходный (употребляется с сущeствительным в винительном падеже без предлога)/ непереходный (не употребляется с существительным в винительном падеже без предлога).

- Спряжение

- Наклонение в зависимости от вопроса:

- Изъявительное — что делал? что делает? что сделает?

- Повелительное — что делай?

- условное — что делал бы? что сделал бы?

- Число

- Время (если есть)

- Лицо (если есть)

- Род (если есть)

- Синтаксическая роль (подчеркнуть как член предложения, является главным или второстепенным членом предложения)

Поделитесь страницей с друзьями — это лучшая благодарность

Оцени материал

11 голосов, оценка 4.545 из 5

План разбора составлен на основе общих правил, в зависимости от класса и предпочтений учителя ответ может отличаться. Если ваш план разбора отличается от представленного, просто сопоставьте его с данными нашего ответа.

Если морфологический разбор глагола «правило» имеет несколько вариантов, то выберите наиболее подходящий вариант разбора исходя из контекста предложения.

Разборы производились исходя из заложенного программного алгоритма, результаты в редких случаях могут быть недостоверны, если вы нашли несоответствие пожалуйста сообщите нам. Представленный результат используется вами на свой страх и риск.

|

[ содержание | предыдущая тема | следующая тема ] Содержание темыНазначение синтаксического разбора. Классификация методов синтаксического разбора. Назначение синтаксического разбораСинтаксический разбор (распознавание) является первым этапом синтаксического анализа. Именно при его выполнении осуществляется подтверждение того, что входная цепочка символов является программой, а отдельные подцепочки составляют синтаксически правильные программные объекты. Вслед за распознаванием отдельных подцепочек осуществляется анализ их семантической корректности на основе накопленной информации. Затем проводится добавление новых объектов в объектную модель программы или в промежуточное представление. Разбор предназначен для доказательства того, что анализируемая входная цепочка, записанная на входной ленте, принадлежит или не принадлежит множеству цепочек порождаемых грамматикой данного языка. Выполнение синтаксического разбора осуществляется распознавателями, являющимися автоматами. Поэтому данный процесс также называется распознаванием входной цепочки. Цель доказательства в том, чтобы ответить на вопрос: принадлежит ли анализируемая цепочка множеству правильных цепочек заданного языка. Ответ «да» дается, если такая принадлежность установлена. В противном случае дается ответ «нет». Получение ответа «нет» связано с понятиям отказа. Единственный отказ на любом уровне ведет к общему отказу. Чтобы получить ответ «да» относительно всей цепочки, надо его получить для каждого правила, обеспечивающего разбор отдельной подцепочки. Так как множество правил образуют иерархическую структуру, возможно с рекурсиями, то процесс получения общего положительного ответа можно интерпретировать как сбор по определенному принципу ответов для листьев, лежащих в основе дерева разбора, что дает положительный ответ для узла, содержащего эти листья. Далее анализируются обработанные узлы, и уже в них полученные ответы складываются в общий ответ нового узла. И так далее до самой вершины. Данный принцип обработки сильно напоминает бюрократическую систему, используемую в организационном управлении любого предприятия. Так поднимается наверх информация, подтверждающая выполнение указания начальника организации. До этого, теми же путями, вниз спускалось и разделялось исходное указание. Классификация методов синтаксического разбораЕсли попытаться формализовать задачу на уровне элементарного метаязыка, то она будет ставиться следующим образом. Дан язык L(G) с грамматикой G, в которой S — начальный нетерминал. Построить дерево разбора входной цепочки a = a1a2a3…an. Естественно, что существует огромное количество путей решения данной задачи, и целью разработчика распознавателя является выделение приемлемых вариантов его реализации. Для того, чтобы понять, что, и каким образом, влияет на принципы функционирования распознавателя, а следовательно, и на организацию разбора, рассмотрим некоторые возможные варианты. Общая классификация рассматриваемых вариантов построения распознавателя представлена на рис. 6.1. На самом верхнем уровне выделяются:

Методы разбораВыделяются два основных метода синтаксического разбора:

Кроме этого можно использовать комбинированный разбор, сочетающий особенности двух предыдущих. Нисходящие и восходящие подходы широко используются в различных областях человеческой деятельности, особенно в тех из них, которые связаны с анализом и синтезом искусственных систем. В частности, можно отметить методы разработки программного обеспечения сверху вниз (нисходящий) и снизу вверх (восходящий). Нисходящий разбор заключается в построении дерева разбора, начиная от корневой вершины. Разбор заключается в заполнении промежутка между начальным нетерминалом и символами входной цепочки правилами, выводимыми из начального нетерминала. Подстановка основывается на том факторе, что корневая вершина является узлом, состоящим из листьев, являющихся цепочкой терминалов и нетерминалов одного из альтернативных правил, порождаемых начальным нетерминалом. Подставляемое правило в общем случае выбирается произвольно. Вместо новых нетерминальных вершин осуществляется подстановка выводимых из них правил. Процесс протекает до тех пор, пока не будут установлены все связи дерева, соединяющие корневую вершину и символы входной цепочки, или пока не будут перебраны все возможные комбинации правил. В последнем случае входная цепочка отвергается. Построение дерева разбора подтверждает принадлежность входной цепочки данному языку. При этом, в общем случае, для одной и той же входной цепочки может быть построено несколько деревьев разбора. Это говорит о том, что грамматика данного языка является недетерминированной. Эти рассуждения иллюстрируются следующим примером. Пусть будет дана грамматика G: G6 = ({S}, {a, +, *}, P, S) ,Где P определяется как:

Цепочки, порождаемые данной грамматикой можно интерпретировать как выражения, состоящие из операндов «a», а также операций «+» и «*».

И так далее. В этом пример число вариантов одной и той же произвольной цепочки вывода настолько велико, что не имеет и смысла говорить о практическом применении данной грамматики. Но в данном случае она позволяет показать, каким образом могут порождаться различные деревья при нисходящем разборе. Пошаговое построение различных деревьев показано на рис. 6.2, 6.3, 6.4. Можно отметить, что процесс построения дерева совпадает с последовательностью шагов вывода входной цепочки.

При восходящем разборе дерево начинает строиться от терминальных листьев путем подстановки правил, применимых к входной цепочке, опять таки, в общем случае, в произвольном порядке. На следующем шаге новые узлы полученных поддеревьев используются как листья во вновь применяемых правилах. Процесс построения дерева разбора завершается, когда все символы входной цепочки будут являться листьями дерева, корнем которого окажется начальный нетерминал. Если, в результате полного перебора всех возможных правил, мы не сможем построить требуемое дерево разбора, то рассматриваемая входная цепочка не принадлежит данному языку. Восходящий разбор также непосредственно связан с любым возможным выводом цепочки из начального нетерминала.

Комбинированный разбор может быть реализован тогда, когда процесс распознавания разбивается на два этапа. На одном из них осуществляется нисходящий, а на другом — восходящий разбор. Этапов может быть и больше, а порядок их применения — произвольным. Комбинированным можно считать разбор в любом трансляторе, если фазу лексического анализа принять за первый этап, а синтаксического — за второй. При этом лексический анализатор нельзя считать истинным распознавателем, так как осуществляется формирование только одного слоя ветвей в дереве разбора, расположенного над символами входной цепочки (рис. 6.8). Прямой лексический анализатор будет являться восходящим распознавателем, который может сочетаться с нисходящим. Непрямой же лексический анализ можно рассматривать как нисходящий разбор некоторой подцепочки (осуществляются проверки версий). Поэтому комбинированный разбор будет при его совместном использовании с восходящим распознавателем. В синтаксическом же анализаторе комбинация различных видов разборов обычно не используются, так как в этом нет особого смысла. Последовательность разбора.Последовательность разбора определяет, каким образом осуществляется формирование фрагмента дерева разбора на каждом шаге подстановки. Эти подстановки могут осуществляться слева направо, справа налево, произвольно. Последовательность разбора непосредственно сочетается с методом разбора. Так, при нисходящем разборе слева направо, подстановка правил вместо самых левых нетерминалов ведет к тому, что входная цепочка распознается с ее начала (рис. 6.2). Нисходящий разбор справа налево ведет к первоначальному подтверждению символов с конца цепочки (рис. 6.3). Наоборот, восходящий разбор слева направо осуществляет замену на нетерминал символов, расположенных в конце цепочки (рис. 6.5). Замена начальных символов производится при восходящем разборе справа налево (рис. 6.6). Произвольный разбор не оговаривает последовательность подстановки правил (рис 6.4, 6.7). Это ведет к большему количеству переборов. Повышение эффективности разбора осуществляется разработкой грамматик, специально поддерживающих согласованные между собой метод и последовательность. Так, например, Грамматики, предназначенные для нисходящего разбора, обычно используются для вывода слева направо. Следовательно, и входная цепочка будет разбираться слева направо. Это позволяет быстрее получать нужные символы, а не ждать конца цепочки и лишь потом осуществлять разбор (можно, конечно, саму цепочку разбирать от конца к началу, но это уже из области симметрии). Грамматики, ориентированные на восходящий разбор, обычно оптимизированы под правый вывод входной цепочки, что позволяет, при синтаксическом разборе, опять-таки осуществлять подстановки нетерминалов слева направо. Использование просмотра вперед.Языки (как и другие системы) бывают различными по сложности. Ряд из них практически невозможно описать с помощью простых грамматик. Поэтому, в грамматиках могут встречаться альтернативные правила, начинающиеся с одинаковых цепочек символов. Возникающая неоднозначность может быть разрешена путем предварительного просмотра правила на n символов вперед до той границы, начиная с которой данное правило можно будет отличить от других. В контекстно свободных (КС) грамматиках число, определяющее количество символов, анализируемых перед выбором подстановки (1, 2…), используется для классификации. По этому критерию КС грамматики, задаются следующим образом: КС(1), КС(2),… Просмотр вперед — это один из возможных вариантов упорядочивания подстановок, обеспечивающий решение проблемы недетерминированности. Наряду с ним используются: преобразование грамматик к детерминированным и анализ с возвратами. Использование возвратовСинтаксический разбор с возвратами выполняется аналогично тому, как осуществляется непрямой лексический анализ. Возвраты производятся для альтернативных правил, начинающихся с одинаковых подцепочек. В этом случае появление отказа при разборе правила ведет к восстановлению входной головки в то положение, в котором она была да входа в данное правило. Использование возвратов может выступать в качестве альтернативы просмотру вперед. Приоритет правил, определяющий порядок их обхода, назначается также как и при лексическом анализе и зависит от того, является ли некоторое правило подмножеством другого. Метод универсален и легок для понимания и реализации. Однако, такой подход замедляет разбор и может вести к дополнительным издержкам во время семантического анализа и построения объектной модели. Резюме.Приведенные варианты организации синтаксического разбора могут встречаться в разнообразных сочетаниях.

Поэтому, от начала процесса разработки языка программирования до его реализации постоянно необходимо обеспечивать баланс между сложностью замысла и простотой реализации. Следует также отметить, что усложнение синтаксиса не всегда обеспечивает более удобное восприятие конструкций языка пользователем. Зачастую можно иметь простой синтаксис и удобный для использования язык, поддерживаемый очень быстрым транслятором. Контрольные вопросы и задания

[ содержание | предыдущая тема | следующая тема ] |

PostgreSQL : Документация: 9.

5: 48.3. Этап разбора : Компания Postgres Professional

5: 48.3. Этап разбора : Компания Postgres Professional48.3. Этап разбора

При разборе проверяется сначала синтаксис строки запроса (поступающей в виде неструктурированного текста). Если он правильный, строится дерево запроса и передаётся дальше, в противном случае возвращается ошибка. Лексический и синтаксический анализ реализован с применением хорошо известных средств Unix bison и flex.

Лексическая структура определяется в файле scan.l и описывает идентификаторы, ключевые слова SQL и т. д. Для каждого найденного ключевого слова или идентификатора генерируется символ языка, который затем передаётся синтаксическому анализатору.

Синтаксис языка определён в файле gram.y в виде набора грамматических правил и действий, которые должны выполняться при срабатывании правил. Для построения дерева разбора используется код действий (это действительно код на C).

Файл scan.l преобразуется в программу на C scan.c с помощью flex, а gram.y — в gram.c с помощью bison. После этих преобразований исполняемый код анализатора создаётся обычным компилятором C. Никогда не вносите коррективы в сгенерированные файлы C, так как они будут перезаписаны при следующем вызове flex или bison.

Примечание

Упомянутые преобразования и компиляция обычно производятся автоматически сборочными файлами Makefile, поставляемыми в составе дистрибутива PostgreSQL.

Подробное описание bison и грамматических правил в gram.y выходит за рамки данной главы. Узнать больше о flex и bison можно из книг и документации. Изучение грамматики, описанной в gram.y, следует начать со знакомства с bison, иначе будет трудно понять, что там происходит.

48.3.2. Преобразование

На этой стадии дерево разбора создаётся только с фиксированными знаниями о синтаксической структуре SQL. При его создании не просматриваются системные каталоги, что не даёт возможность понять конкретную семантику запрошенной операции. После этого выполняется процедура преобразования, которая принимает дерево разбора от анализатора и выполняет семантический анализ, необходимый для понимания, к каким именно таблицам, функциям и операторам обращается запрос. Структура данных, которая создаётся для представления этой информации, называется деревом запроса.

Синтаксический разбор отделён от семантического анализа, потому что обращаться к системным каталогам можно только внутри транзакции, а начинать транзакцию сразу после получения строки с запросом нежелательно. Синтаксического разбора достаточно, чтобы распознать команды управления транзакциями (BEGIN, ROLLBACK и т. д.), поэтому их можно выполнить без дальнейшего анализа. Убедившись, что мы имеем дело с собственно запросом (например, SELECT или UPDATE), можно начинать транзакцию, если она ещё не начата. Только после этого можно переходить к процедуре преобразования.

Дерево запроса, создаваемое процедурой преобразования, по структуре во многом похоже на дерево разбора, но отличается во многих деталях. Например, узел FuncCall в дереве разбора представляет то, что по синтаксису похоже на вызов функции. Этот узел может быть преобразован в узел FuncExpr или Aggref в зависимости от того, какой (обычной или агрегатной) окажется функция с заданным именем. Кроме того, в дерево запроса добавляется информация о фактических типах данных столбцов и результатов выражений.

Глава 23 Правила синтаксического анализа

Глава 23 Правила синтаксического анализаВ этой главе вы узнаете, как: Показать Скрыть

О правилах разбора

Правила синтаксического анализа — это определяемые пользователем токены. Отдельно из стандартного формата определения отчета, модуль отчетов EventTracker предоставляет простой, но мощный журнал Flex Reports, средство отчетности.

Это помогает анализировать и включать части забитого системного журнала, такие как сообщения и Windows описания событий в виде столбцов в отчетах.

Правило синтаксического анализа помогает определить новые токены, привязать это с помощью динамических шаблонов отчетов и создания гибких отчетов. EventTracker отображает проанализированные данные по указанным вами токенам.

При настройке отчетов Flex вы также можете выберите интересующие вас столбцы отчета, примените фильтры, отсортируйте отчет столбцы и измените порядок столбцов, которые должны отображаться в отчеты.

Кому вкратце Правила синтаксического анализа помогает манипулировать данными и составлять понятные отчеты.

Необходимость добавления правил синтаксического анализа во Flex Отчет

Очистка компонентов бревна данные массово время. Данные содержат фрагменты информации.

Так как ценная информация сбрасывается в описании журнала, должен быть способ разбить анализировать данные и превращать их в ценную бизнес-информацию.

Кроме того, не существует стандартизованного формата сообщений, поскольку различные поставщики систем NIX следуйте различным соглашениям.

Для например, значения, разделенные запятыми, текст фиксированной ширины и текст произвольной формы используются администратором для расшифровки сообщений системного журнала.

Использование токенов в EventTracker

А общие вопросы, которые возникают, будут:

· «Разве недостаточно генерировать Flex отчетов с помощью шаблонов, поставляемых с EventTracker? ’

· Является ли EventTracker гибким достаточно для добавления токенов?

· Если да, то не EventTracker предоставить какие-либо предопределенные токены для упрощения моей работы?

· Можно ли определить мои собственные токены?

Если вы озабочены этими вопросами, расслабьтесь!

EventTracker поставляется вместе с точным определенный набор токенов для вашего удобства.Если вы хотите добавить токены если эти предопределенные токены не соответствуют вашим требованиям, EventTracker предоставляет соответствующие возможности для добавления / изменения / удаления токенов. В противном случае по умолчанию токенов достаточно.

FAQ: Если привязать новое значение токена для правила синтаксического анализа, будут ли сохранены эти значения токена постоянно в базе?

Это оставлено на ваше усмотрение. При определении нового значения токена у вас есть роскошь постоянного сохранения значений токенов в базе данных или привязки Token-Value только для одного экземпляра генерации отчета.

Предыдущие знания

Это важно иметь удобное знание и понимание syslog форматы сообщений различных разновидностей систем NIX. Хотя фундаментальный принципы настаивают на простоте, создатели системного журнала пишут сообщения по их прихоти и капризу. Так что подходите к окружающей среде вы работаете, чтобы понять синтаксис и семантику сообщений системного журнала.

Компоненты правил синтаксического анализа

Компоненты из Правила синтаксического анализа — это основные элементы, которые необходимы при создании ваши запросы для извлечения необходимых данных из сообщений журнала.

Жетон

жетон это «ключ», который движок репортера рассматривает как точку отсчета и считает строка, успешно выполненная для синтаксического анализа. Предоставление токена необязательно и может содержать:

· Знаки (a, b, c…)

· Числа (1, 2, 3…)

· Специальные символы (#, $, %), пробел…

· или комбинация всех трех (a1 #)

Вхождения правила синтаксического анализа

Если в описании есть несколько вхождений токена, механизм репортера в качестве ориентира рассматривает только первое вхождение.Итак, будьте конкретны пока вы строите свой запрос.

Отображаемое имя

Дисплей Имя — это временно предполагаемое имя (псевдоним) для запрашиваемой строки. Этот имя будет отображаться в отчете как «токен». Обязательно предоставить отображаемое имя и должно быть уникальным во всем отчете. Вы можете выбрать любое имя и может содержать:

· персонажи

· номера

· или комбинация из этих двух

· специальный символы не принимаются

Сепаратор

Разделитель символ или слово, разделяющее ключ и значение в описании.Необязательно использовать разделитель и может содержать:

· персонажи

· номера

· специальный персонажи

· или комбинация из всех трех

Терминатор

Терминатор — персонаж или слово для определения конца пары ключ-значение в описании. Запрошенная строка извлекается до первого появления терминатора. Это необязательно для обозначения терминатора и может содержать:

· Персонажи

· Номера

· Специальный персонажи

· или комбинация всех трех

Таким образом, правило синтаксического анализа предлагает гибкость для настройки:

· Данные выбор

· Сортировать последовательности

Просмотр правил синтаксического анализа

1 Для просмотра правил синтаксического анализа выберите Admin раскрывающийся список, а затем выберите Правила синтаксического анализа .

Отображение групп Token-Value по умолчанию. EventTracker обеспечивает предопределенный синтаксический анализ правила.

2 Для поиска по значениям токенов щелкните Token-Value в раскрывающемся списке и выберите требуемый вариант.

3 Введите критерии поиска в поле поиска. и щелкните значок Search .

Пример: для поиска токена Значение «доступ», введите слово «доступ» в поле поиска и нажмите значок поиска.Отображается соответствующая информация.

4 Чтобы очистить критерии поиска, выберите Очистить все значок .

Добавить группы значений токенов

По умолчанию Группы значений токена доступны на панели «Значение токена».

1 Чтобы добавить новую группу, щелкните значок.

2 Введите название соответствующей группы, описание а затем нажмите ОК .

А создается новая группа значений токена.

Добавить правило

1 Чтобы добавить новое правило, щелкните Добавить правило кнопка.

2 Введите соответствующие данные и нажмите Добавить .

· Пример: следующие пары «ключ-значение» могут быть добавляется следующим образом.

· Отображаемое имя: Сводка журналов

· Жетон: время записи

· Разделитель: ‘:’

· Терминатор: \ n

· Новое правило отображается на панели Token-Value.

ПРИМЕЧАНИЕ |

В v8.x может быть более одного Token-Value с тем же отображаемым именем, но с одним из токенов, разделителя или терминатор должен быть другим / уникальным. Пример: Отображаемое имя такое же в скриншот приведен ниже, но разделитель другой. |

3 Чтобы изменить значение токена, щелкните Изменить кнопку, внесите необходимые изменения и нажмите Сохранить .

ПРИМЕЧАНИЕ |

Вы может редактировать только одно значение токена за раз. |

4 Чтобы удалить значение токена, нажмите Удалить кнопка.

5 Чтобы передать значение токена в другую группу, щелкните Перейти в группу.

ПРИМЕЧАНИЕ |

Вы может перейти в другую группу, если есть другие группы Token-Value существующий отдельно от Выбранного. |

Мастер значения токена

1 Для просмотра мастера значения токена выберите в раскрывающемся списке Admin выберите Parsing Rules .

по умолчанию Token-Value Отображение групп.

2 Нажмите кнопку Мастер значения токена .

Мастер значения токена отображает окно «Образцы журналов».

3 Нажмите любой из значков Извлечь пары значений токена .

Создать Вкладка Token-Value отображается с Дополнительная информация.

4 Выберите Список значений токена , а затем нажмите кнопку Добавить >> .

Пример: Выберите Имя в списке значений токена и нажмите Добавить .

Токен-Стоимость Отображение деталей.

Вы может вносить изменения в отображаемые значения по умолчанию.

5 Нажмите Проверить, и затем нажмите Сохранить.

Использовать шаблон по умолчанию

1 Выберите раскрывающийся список Admin и затем выберите Parsing Rules .

Отображение групп Token-Value по умолчанию. EventTracker обеспечивает предопределенный синтаксический анализ правила.

2 Выберите вкладку Шаблон .

Группа шаблонов отображается на левой панели, а шаблоны отображаются в правая панель.

3 Для поиска имени группы введите имя в поле поиска и щелкните значок поиска.

4 Для экспорта или импорта конфигурации используйте значок экспорта или значок импорта.

Создать новый шаблон

1. В мастере значения токена щелкните Создать. Вкладка Token Value ,

2. Добавьте описание и нажмите Создать. Шаблон.

На странице ниже отображается:

3.Введите необходимые изменения в Token Значение option и Token .

4. Введите имя шаблона .

5. Чтобы отфильтровать значения, нажмите кнопку икона.

EventTracker: Откроется окно «Определенный шаблон».

6. Введите соответствующие данные и нажмите Добавьте .

Пример: Введите имя токена (например, новый токен), выходное значение (т.е.е. Процесс).

Вы можно выбрать регулярное выражение или разделитель. Используется регулярное выражение чтобы найти конкретный узор.

· Выберите разделитель «-». Это может быть космос, знак равенства ‘=’ и т. д.

· Выберите порядковые значения (т.е. числовые) для дальнейшего разделения правил.

7. Щелкните Добавить в столбец шаблона .

8.Нажмите кнопку Сохранить .

· Теперь в окне «Определить правила синтаксического анализа», созданный новый шаблон отображается на вкладке Шаблон .

Создание отчетов Flex

1 Войдите в EventTracker Enterprise, щелкните меню Reports , а затем выберите Dashboard или Configuration .

2 Нажмите кнопку Новый в приборной панели / Конфигурация .

3 Выберите любой из Соответствие / Безопасность / Операции / Отчеты Flex / По алфавиту вкладка .

4 Разверните дерево отчетов узел и выберите любой отчет. Выберите Report Type как On Demand . Щелкните Далее.

Например: в отчетах Flex вкладка , выберите Журналы , а затем выберите Сводка .

Тип отчета выбран По запросу.

EventTracker отображает Мастер отчетов.

5 Щелкните Далее >>.

6 Выберите необходимые опции (например, сайтов, , группа , системы, показать все сайты, все системы ).

7 Выберите Realtime или Передача файлов , а затем щелкните Далее >>.

8 Выберите требуемый интервал и Опция ограничения временного диапазона.

9 Выберите требуемый Экспорт. Введите (например, файл PDF , документ Word, файл HTML, быстрый просмотр (не сохранено на жестком диске )).

10 Выбрать необходимая опция формата .

————————————————- —————————————————

Пример:

а.Если вы выберете Parsing Правило вариант. Щелкните Далее >>.

Сводка журналов отображается на выберите правило синтаксического анализа.

г. Нажмите Выбрать синтаксический анализ Правило — гиперссылка.

Поиск Откроется окно правила синтаксического анализа.

г. Выберите необходимые параметры а затем нажмите ОК.

журналов Отображается сводка (например, шаг 5).

г. Выберите любую Сводка вариант; выберите соответствующий вариант в раскрывающемся списке Сортировать по .

e. Выберите жетонов карты с тот же «Тег» для отдельного столбца , если требуется.

(ИЛИ)

ф. Если вы выберете Token Template , нажмите Далее >>.

г. Выберите шаблон. (т.е. введите имя шаблона, которое вы ранее настроили в Правилах синтаксического анализа — Мастер значения токена)

ч. Выберите / введите требуемый параметры и нажмите Далее >>.

————————————————- ————————————

11 Нажмите Далее >> кнопка.

12 Введите соответствующий Уточнить и Фильтр подробности.

13 Нажмите Далее >> кнопка.

14 Введите соответствующий заголовок , Заголовок , Нижний колонтитул и Описание данные.

15 Нажмите Далее >> кнопка.

Просмотрите сведения о стоимости и настройте откроется окно параметров публикации.

ПРИМЕЧАНИЕ |

Издательское дело параметры отключены, потому что по запросу (обработка переднего плана) был выбран. |

16 Нажмите Далее >> кнопка.

Последний шаг из Завершение Откроется мастер настройки отчетов .

17 Выбрать Создать отчет.

Парсинг | New Relic Documentation

New Relic анализирует данные журнала в соответствии с правилами.Узнайте, как работает анализ журналов, как использовать встроенные правила и создавать собственные правила.

Почему это важно

Анализ — это процесс разделения неструктурированных данных на пары атрибут / значение. Эти атрибуты можно использовать для фасетирования или фильтрации журналов полезными способами. Это, в свою очередь, помогает вам создавать более качественные диаграммы и оповещения.

Хорошим примером является журнал доступа NGINX по умолчанию, содержащий неструктурированный текст. Это полезно для поиска, но не более того. Вот пример типичной линии:

127.180.71.3 - - [10 / May / 1997: 08: 05: 32 +0000] "GET / downloads / product_1 HTTP / 1.1" 304 0 "-" "Debian APT-HTTP / 1.3 (0.8.16 ~ exp12ubuntu10.21 ) "

В неанализируемом формате вам потребуется выполнить полнотекстовый поиск, чтобы ответить на большинство вопросов. После синтаксического анализа журнал разбивается на атрибуты, такие как , код ответа и URL-адрес запроса :

«remote_addr»: «93.180.71.3»,

«путь»: «/ downloads / product_1»,

"user_agent": "Debian APT-HTTP / 1.3 (0.8.16 ~ exp12ubuntu10.21) "

Анализ упрощает создание настраиваемых запросов, связанных с этими значениями. Это поможет вам понять распределение кодов ответов по URL-адресу запроса и быстро найти проблемные страницы.

Как

Вот обзор того, как New Relic реализует синтаксический анализ журналов:

Анализ журналов | Как это работает |

|---|---|

83 | анализ выполняется по полю сообщения; другие поля не могут быть проанализированы. logtype для сопоставления правил синтаксического анализа с журналами. |

Когда |

|

Как |

|

Конвейер приема журналов New Relic может анализировать данные, сопоставляя событие журнала с правилом, которое описывает, как следует анализировать журнал.Есть два способа анализа событий журнала:

Правила представляют собой комбинацию логики сопоставления и логики синтаксического анализа. Сопоставление выполняется путем определения сопоставления запроса по атрибуту журналов. Правила не имеют обратной силы. Журналы, собранные до создания правила, не анализируются этим правилом.

Самый простой способ упорядочить журналы и способы их анализа — включить поле logtype в событие журнала. Это сообщает New Relic, какой встроенный набор правил применить к журналам.

Важно

Как только правило синтаксического анализа становится активным, данные, анализируемые этим правилом, навсегда изменяются. Это не может быть отменено.

Ограничения

Анализ требует больших вычислительных ресурсов, что сопряжено с риском. Плохо определенные правила могут потреблять огромный объем памяти и ресурсов ЦП, а также занимать очень много времени для выполнения. Во избежание проблем существует два ограничения на синтаксический анализ: ограничение для каждого сообщения на правило и ограничение на учетную запись.

Лимит | Описание |

|---|---|

На каждое сообщение на правило | Ограничение на сообщение на правило предотвращает потраченное время на синтаксический анализ любого отдельного сообщения более 100 мс.Если этот предел будет достигнут, система прекратит попытки проанализировать сообщение журнала с помощью этого правила. Конвейер приема попытается запустить любое другое, применимое к этому сообщению, и сообщение все равно будет проходить через конвейер приема и сохраняться в NRDB. Сообщение журнала будет в исходном, не проанализированном формате. |

Для каждой учетной записи | Ограничение на одну учетную запись существует для предотвращения использования учетными записями ресурсов, превышающих их справедливую долю.Предел учитывает общее время, потраченное на обработку всех сообщений журнала для учетной записи в минуту. Лимит не является фиксированным значением; он масштабируется вверх или вниз пропорционально объему данных, ежедневно хранимых учетной записью, и размеру среды, которая впоследствии выделяется для поддержки этого клиента. |

Подсказка

Чтобы легко проверить, достигнуты ли ваши ограничения скорости, перейдите на страницу вашей системы Limits в пользовательском интерфейсе New Relic.

Встроенные наборы правил синтаксического анализа

Общие форматы журналов содержат хорошо зарекомендовавшие себя правила синтаксического анализа, уже созданные для них. Чтобы воспользоваться преимуществами встроенных правил синтаксического анализа, добавьте атрибут logtype при пересылке журналов. Установите значение, указанное в следующей таблице, и правила для этого типа журнала будут применяться автоматически.

Список встроенных наборов правил

Следующие значения атрибутов logtype отображаются в стандартные наборы правил синтаксического анализа.См. Раздел «Встроенные правила синтаксического анализа», чтобы узнать, какие поля анализируются для каждого правила.

| Пример запроса на сопоставление | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| AWS Application Load Balancer 336 журнал нагрузки | Apache Access | |||||||||||

| CloudFront Web | ||||||||||||

| Журналы ошибок NGINX | ||||||||||||

| Syslog attribute424 При агрегировании журналов важно предоставлять метаданные, которые упрощают организацию, например arch и проанализируйте эти журналы.Один из простых способов сделать это - добавить атрибут Вот несколько примеров того, как добавить Добавьте Добавьте блок фильтра в файл # Добавить тип журнала для запуска встроенного правила синтаксического анализа для журналов доступа nginx # Установить метку времени из значения, содержащегося в поле "время" # Добавить поля имени хоста и тега ко всем записям имя хоста "# {Разъем.gethostname} " Добавьте блок фильтра в файл Запись имени хоста $ {HOSTNAME} Запись имени_службы Sample-App-Name Добавьте блок фильтра в конфигурацию Logstash который использует фильтр мутации "service_name" => "myservicename" Вы можете добавить атрибуты в запрос JSON, отправленный в New Relic. В этом примере мы добавляем атрибут Многие журналы имеют уникальный формат или структуру.Чтобы проанализировать их, необходимо создать и применить настраиваемую логику. Управление журналами New Relic позволяет создавать собственные правила синтаксического анализа и управлять ими. Выберите Управлять синтаксическим анализом в раскрывающемся меню действий. Щелкните Создать правило синтаксического анализа . Выберите атрибут и значение для сопоставления. Напишите свой шаблон Grok и проверьте правило. Включите и сохраните настраиваемое правило синтаксического анализа. Чтобы узнать о Grok и пользовательских правилах синтаксического анализа, прочтите нашу запись в блоге о том, как анализировать журналы с помощью шаблонов Grok. Если вам нужна дополнительная помощь, ознакомьтесь с этими ресурсами поддержки и обучения: Итак, я делаю синтаксический анализатор, где я предпочитаю гибкость скорости, и я хочу, чтобы было легко писать грамматики, например нет сложных обходных правил (поддельные правила для разрешения конфликтов и т. д., как вы должны делать в yacc / bison и т. д.)) Существует вручную закодированный лексер с фиксированным набором токенов (например, PLUS, DECIMAL, STRING_LIT, NAME и т. Д.). Прямо сейчас существует три типа правил: Например, у нас есть TokenRule 'varAccess', которое соответствует ИМЯ токена (примерно / [A-Za-z] [A-Za-z0-9 _] * /), и SequenceRule 'assignment', которое соответствует [выражение, TokenRule (PLUS), выражение]. Expression - это GroupRule, соответствующий либо 'assignment', либо 'varAccess' (фактический набор правил, с которым я тестирую, немного более полный, но для примера подойдет) А теперь скажем, я хочу разобрать И предположим, что синтаксический анализатор начинается с выражения правила (порядок, в котором они определены, не имеет значения - приоритеты будут определены позже). Допустим, выражение GroupRule сначала попробует «присваивать». Затем, поскольку «выражение» является первым правилом, которому нужно сопоставить в «присваивании», он попытается снова проанализировать выражение и так далее, пока стек не заполнится и компьютер - как и ожидалось - просто не откажется от блестящего segfault. Итак, я сделал следующее: SequenceRules добавили себя как «листья» к своему первому правилу и стали некорневыми правилами. Корневые правила - это правила, которые парсер сначала пробует. Когда один из них применяется и совпадает, он пытается применить субприложение к каждому из своих листьев, один за другим, пока не будет найден один из них. Затем он пробует листы соответствующего листа и так далее, пока ничего не перестанет совпадать. Чтобы он мог анализировать выражения вроде В самый раз =) А теперь самое интересное.Этот код: Не будет разбирать. Что происходит, так это то, что var1 анализируется (varAccess), assign применяется подменю, он ищет выражение, пробует 'круглые скобки', начинает, ищет выражение после '(', находит var2, а затем подавляется '+ 'потому что ожидал') '. Почему не соответствует 'var2 + var3'? (и да, есть «добавить» SequenceRule, прежде чем вы спросите). Поскольку 'add' не является корневым правилом (чтобы избежать бесконечной рекурсии с parse-expression-begin-with-expression-etc.) и что листья не тестируются в SequenceRules, иначе он будет анализировать такие вещи, как как (например, '1 = 3' - это выражение, ожидаемое командой add, лист varAccess a) , тогда как мы хотели бы, чтобы он был левоассоциативным, например парсинг как Так или иначе, теперь у нас возникла проблема, заключающаяся в том, что мы должны иметь возможность анализировать выражение, такое как '1 + 2', в SequenceRules.Что делать? Добавьте особый случай, когда SequenceRules начинаются с TokenRule, тогда содержащиеся в нем GroupRules проверяются на наличие листьев? Будет ли это иметь смысл вне этого конкретного примера? Или нужно иметь возможность указывать в каждом элементе SequenceRule, нужно ли его проверять на листья или нет? Скажите мне, что вы думаете (кроме как выбросить всю систему - в любом случае это произойдет через несколько месяцев) P.S: Пожалуйста, милая, пожалуйста, не отвечайте на что-то вроде «иди, прочти эту книгу на 400 страницах, или ты даже не заслуживаешь нашего времени». Если ты чувствуешь необходимость - просто воздержись и займись Reddit.Хорошо? Заранее спасибо. Сформируйте свою стратегию и преобразуйте гибридную ИТ-среду. Помогите вам внедрить безопасность в цепочку создания стоимости ИТ и наладить сотрудничество между ИТ-подразделениями, приложениями и службами безопасности. Помогите вам быстрее реагировать и получить конкурентное преимущество благодаря гибкости предприятия. Ускорьте получение результатов гибридного облака с помощью услуг по консультированию, трансформации и внедрению. Службы управления приложениями, которые позволяют поручить управление решениями экспертам, разбирающимся в вашей среде. Услуги стратегического консалтинга для разработки вашей программы цифровой трансформации. Полнофункциональное моделирование сценариев использования с предварительно созданными интеграциями в портфеле программного обеспечения Micro Focus Software, демонстрирующее реальные сценарии использования Услуги экспертной аналитики безопасности, которые помогут вам быстро спроектировать, развернуть и проверить реализацию технологии безопасности Micro Focus. Служба интеграции и управления услугами, которая оптимизирует доставку, гарантии и управление в условиях нескольких поставщиков. Анализируйте большие данные с помощью аналитики в реальном времени и ищите неструктурированные данные. Анализируйте большие данные с помощью аналитики в реальном времени и ищите неструктурированные данные. Анализируйте большие данные с помощью аналитики в реальном времени и ищите неструктурированные данные. Мобильные услуги, которые обеспечивают производительность и ускоряют вывод продукта на рынок без ущерба для качества. Анализируйте большие данные с помощью аналитики в реальном времени и ищите неструктурированные данные. Комплексные услуги по работе с большими данными для продвижения вашего предприятия. Примечание. Конфигурация файлов cookie применяется только к использованию пользовательских файлов cookie. Консоль не

применять правила синтаксического анализа к файлам cookie, которые он распознает как стандартные файлы cookie, используемые Aspera

продукты. При передаче из командной строки ascp можно указать

передавать cookie с окружением

Переменная. Вы

можно настроить Консоль для сопоставления строки cookie (путем создания правила), а затем

заменить выбранную информацию о передаче. Чтобы настроить правила сопоставления файлов cookie

строка, выберите в меню консоли. На странице "Правила синтаксического анализа файлов cookie" все существующие

перечислены правила. Чтобы создать новое правило, нажмите «Новое правило». Страница «Создание нового правила» включает следующие параметры: По завершении нажмите «Создать», чтобы сохранить правило. setcustomfields :(.+?): (. +?): (. +?): долларов США Например, передача, начатая с файла cookie ниже, будет