Разбор документов с плохим контекстом с помощью ИИ — серьезная проблема для грузовой отрасли | Поль Кутюрье | OVRSEA

Опубликовано в·

Чтение: 10 мин.·

30 июня 2022 г. Изображение 1 : Фотография административных документов Ариса Чаттаса на Unsplash900 04 TL;DR: Freight создает несколько юридических документов для каждой отправки . Они обязательны и полны полезной информации. Возможность автоматического извлечения этих данных сделает процесс перевозки грузов более удобным и информативным для наших клиентов. Мы можем выполнять работу с таможней, проводить анализ транспортных расходов на единицу продукции или прогнозировать запасы, анализируя эти юридические документы, для наших клиентов.Мы изучили общую структуру, необходимую для анализа таких документов с плохим контекстом с помощью машинного обучения. Эта структура фокусируется на трех аспектах этой задачи: распознавание текста на изображении, понимание макета и получение значения каждого слова.

После этого долгого исследования мы очень горды и счастливы в Ovrsea представить нашу первую функцию с автоматическим считыванием коммерческих счетов для видения запасов!

В сфере грузоперевозок вместе с перевозкой часто создается множество документов. Вы будете иметь дело с коносаментом или авианакладной, таможней, упаковочными листами, коммерческими счетами… список довольно длинный. И все эти документы позволят вашему контейнеру или товару проверить все требования, чтобы безопасно прибыть на ваш склад.

Они необходимы и полны полезных данных, так что возможность автоматического извлечения информации сделает процесс перевозки более удобным и эффективным для наших клиентов. Мы могли бы придумать множество вариантов использования, которые принесли бы им пользу:

- Предоставить покупателю обзор запасов, прочитав упаковочный лист

- Упростить таможню, прочитав коды ТН ВЭД каждого продукта пункт, читая коммерческие счета-фактуры

Согласно отзывам, полученным нашей командой по продуктам от наших клиентов, автоматическое извлечение этих фрагментов информации из грузовых документов — замечательная функция!

Изображение 2: Коносамент из Википедии Но если это обязательные данные, когда фрахт будет полностью цифровым, мы могли бы избавиться от всех этих документов, верно? Ну, это не так просто. Или, по крайней мере, не произойдет в ближайшее время.

Или, по крайней мере, не произойдет в ближайшее время.

Как описано в большинстве статей, которые мы читали на эту тему, вся экосистема грузоперевозок все еще очень поздно оцифровывается, и хотя многие игроки пытаются наверстать упущенное, мы не можем ожидать, что рынок перестанет использовать документ в формате pdf скоро [1] [2].

Понятие документа с плохим контекстом

Но что это за документы? На самом деле грузовые документы в формате pdf часто хранятся в виде изображений. Они не написаны полными предложениями, и их структура часто строится вокруг приблизительных таблиц или форм, содержащих минимальную полезную информацию. Таким образом, каждое слово не окружено другими, которые объясняли бы, что оно на самом деле означает, вопреки стандартному предложению. И таблицы могут быть очень сложными с несколькими записями, как показано на Рисунке 2. Вот почему мы называем их документами с плохим контекстом.

Итак, как мы можем извлекать информацию из различных документов с различными шаблонами и структурировать эту информацию в базе данных, чтобы наши клиенты могли ее использовать?

Допустим, мы можем преобразовать изображение в текст — об этом мы поговорим позже. Поскольку большая часть данных, которые мы хотим получить, находится в таблице, мы можем подумать, что это должно быть детской игрой. Ну… не совсем так. Из-за того, как развились технологии машинного обучения, получить информацию из нескольких таблиц на самом деле гораздо сложнее, чем из текста с семантикой. Попробуем немного популяризировать!

Поскольку большая часть данных, которые мы хотим получить, находится в таблице, мы можем подумать, что это должно быть детской игрой. Ну… не совсем так. Из-за того, как развились технологии машинного обучения, получить информацию из нескольких таблиц на самом деле гораздо сложнее, чем из текста с семантикой. Попробуем немного популяризировать!

Искусственный интеллект в тексте

Обработка естественного языка (NLP) — это одна из областей ИИ, целью которой является понимание семантики текста. За последние 10 лет Google и OpenAI (при поддержке Microsoft) сделали в этой области два крупных прорыва соответственно с преобразователем BERT и GPT [3] [4]. Опираясь на огромное количество данных, они строят модели, которые в некотором роде понимают наши языки.

Я не буду углубляться в эту тему, но если вы хотите взглянуть, вы можете попробовать OpenAI API или даже … просто напишите запрос в поиске Google! Вот как Google может понять, когда вы вводите свой поисковый запрос, поскольку это был вопрос, который вы задали бы другу.

Искусственный интеллект в документах с плохим контекстом

В нашем случае мы не можем напрямую полагаться на такие технологии. Действительно, документы с плохим контекстом не содержат предложений, основанных на семантическом синтаксисе. Информация гораздо более размыта по трем основным факторам:

- Сам текст как слово без контекста

- Географическое положение текста в документе

- Линии и геометрия, определяющие макет

Теперь, когда мы поняли, почему синтаксический анализ документа является сложной задачей, давайте объясним, как мы пытались чтобы решить это!

Поскольку эта проблема сложная, нам нужно полагаться на несколько технологий. Как объяснялось в нашей предыдущей статье, наша цель в команде данных Ovrsea — определить правильный уровень исследований и разработок между самодельными и готовыми технологиями. Работая над таможенными решениями, мы также обменивались информацией с различными стартапами, чтобы определить наше собственное решение.

Мы собираемся представить вам общие инструменты для решения такой задачи. Обратите внимание, что есть много способов решить эту проблему, и эта структура может не охватывать каждый из них!

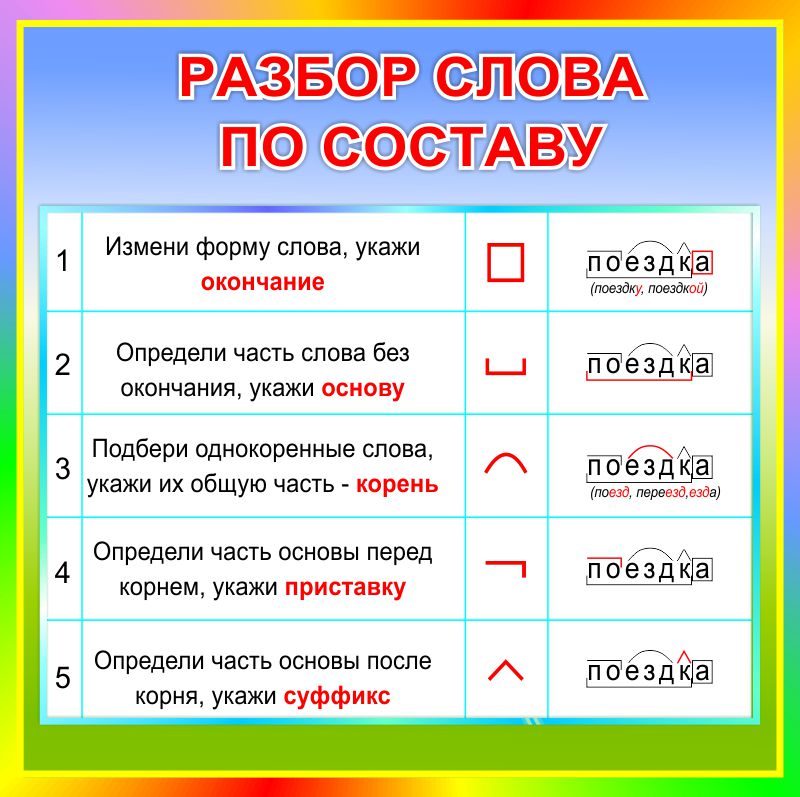

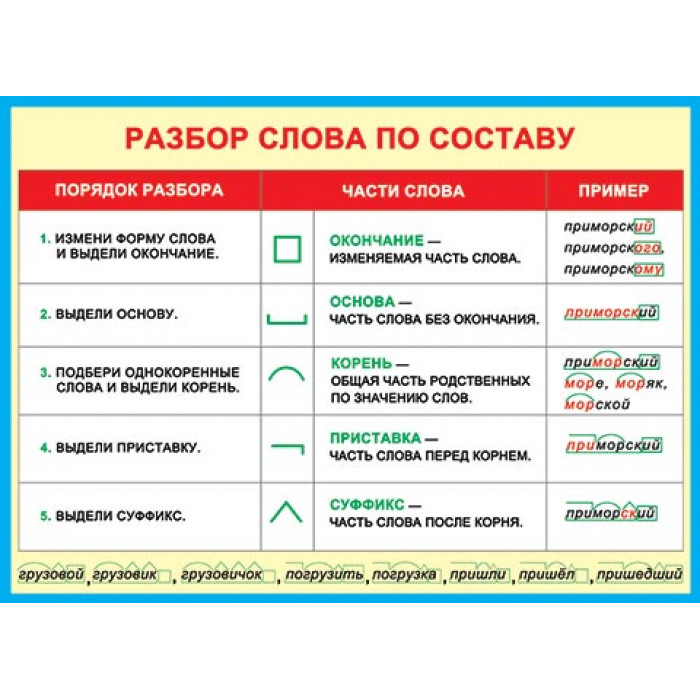

1. Распознавание текста с помощью оптического распознавания символов (OCR)

Первым элементом любого возможного решения должно быть OCR. Действительно, вход здесь — это изображение . В зависимости от типа pdf, некоторые из них могут быть прочитаны непосредственно как файл xml, но большинство из них будут загружены только как изображения, такие как png или jpg, которые затем должны быть преобразованы в фактический текст. OCR, что означает Оптическое распознавание символов — это технология, позволяющая обнаруживать и автоматически считывать текст с изображения . На рынке существует множество решений OCR, как бесплатных, так и платных, таких как Amazon Textract или Tesseract (при поддержке Google). Судя по тесту OCR, который мы проводили, они по-прежнему в значительной степени сосредоточены на латинских языках.

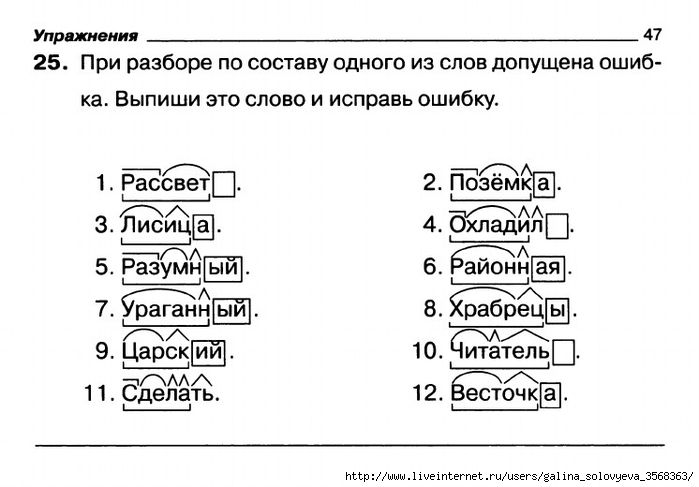

Анализируя документ и символы, они могут воссоздать текст и указать его абсолютное положение в документе. Результат OCR часто представляет собой ограничивающую рамку, в которую встроен текст документа (9).0040 см. ограничивающую рамку на изображении 4 ). Но OCR нуждается в обучении, чтобы уметь распознавать связные группы слов как один токен. Например, он не должен смешивать заголовок с первым предложением текста и иметь возможность создавать две ограничивающие рамки.

Изображение 4: выходные данные алгоритма компоновки DiT, примененного к научной статье с помощью Hugging Face, с 4 распознанными метками: таблица, текст, заголовок, другое [10] (слева) выходные данные алгоритма LayoutLM V2, примененного к счету с помощью Hugging Face с распознанными 4 метками: вопрос/ответ, заголовок и заголовок [8] (справа).Однако, даже если у вас есть текст и его положение, это еще не поможет вам полностью понять его. Для этого вам нужно получить базовую структуру.

2. Понимание макета с помощью глубокого обучения и статистики

В документе с плохим контекстом понимание макета является одной из ключевых сведений, которые нам нужны для получения . Здесь мы будем определять анализ макета как любую информацию, которая помогает нам понять структуру документа и взаимосвязь между токенами слова, распознанными, кроме OCR.

Здесь мы будем определять анализ макета как любую информацию, которая помогает нам понять структуру документа и взаимосвязь между токенами слова, распознанными, кроме OCR.

Общий желаемый результат для понимания макета часто состоит в том, чтобы иметь возможность пометить поле, окружающее каждый токен текста , чтобы определить его возможный тип — см. Изображение 4. Является ли это ответом на вопрос? Общая информация о документе (дата, номер ссылки и т.д.)? Таблица интереса?

Если документ не содержит слишком много разнообразных шаблонов, то простой анализ статистики с помощью базового алгоритма машинного обучения, такого как случайный лес, может помочь нам получить нужную информацию. Например, просматривая определенные слова в заранее определенной позиции документа, мы могли бы получить конкретную информацию, такую как, например, срок выполнения.

Однако во многих случаях этого недостаточно, поскольку структуры документов очень сложны и разнообразны. Статистический анализ может быть не в состоянии понять это в достаточной мере. Здесь в игру вступает глубокое обучение. За последние два года в этой области было сделано много огромных прорывов. Эта тема, известная как анализ макета документа, все еще сильно отстает от традиционного НЛП, но, полагаясь на тот же механизм, алгоритмы глубокого обучения почти способны понять структуру документа.

Статистический анализ может быть не в состоянии понять это в достаточной мере. Здесь в игру вступает глубокое обучение. За последние два года в этой области было сделано много огромных прорывов. Эта тема, известная как анализ макета документа, все еще сильно отстает от традиционного НЛП, но, полагаясь на тот же механизм, алгоритмы глубокого обучения почти способны понять структуру документа.

Основы анализа макета документа с глубоким обучением: преобразователи и внимание

Эти алгоритмы глубокого обучения часто основаны на архитектуре преобразователя, которая была создана с выпуском алгоритма BERT в 2017 году компанией Google. Эта архитектура обучена кодировать и декодировать информацию (это могут быть изображения, тексты и т. д.) с использованием «внимания», которое является механизмом, позволяющим вашему алгоритму понять связь между вашими входными данными. Мы не будем углубляться в эту технологию, так как это не является целью данной статьи, но если вам интересно, советую прочитать «Внимание — это все, что вам нужно» [5].

Первоначальная архитектура трансформатора была адаптирована с 2017 года и очень часто используется для понимания компоновки. Вот несколько примеров:

- Microsoft в настоящее время работает над алгоритмом LayoutLM, который использует OCR и компьютерное зрение для понимания изображений [6] [7] [8]. Просто чтобы дать вам общее представление, схема его архитектуры показана ниже.

- Другим алгоритмом, разработанным Microsoft, является DiT (Document image Transformer), который основан на Google Bert и в гораздо большей степени полагается на компьютерное зрение, чем на OCR [9].] [10].

Эти технологии являются современными, так как документы LayoutLM v3 и DiT были выпущены несколько недель назад. Будучи очень мощными, эти алгоритмы все еще нуждаются в настройке для наших собственных документов и задач. Действительно, как вы можете видеть на изображении 4 выше, DiT был обучен классифицировать визуальный токен только между четырьмя метками: «текст», «рисунок», «таблица» и «заголовок». Точно так же LayoutLM v2 обучен распознавать метки: «Вопрос/Ответ», а также «название» или «другое». Таким образом, чтобы применить их к определенным грузовым документам вам нужно будет определить информацию, которую вы хотите восстановить, и пометить ее в полях для точной настройки вашей модели трансформатора .

Точно так же LayoutLM v2 обучен распознавать метки: «Вопрос/Ответ», а также «название» или «другое». Таким образом, чтобы применить их к определенным грузовым документам вам нужно будет определить информацию, которую вы хотите восстановить, и пометить ее в полях для точной настройки вашей модели трансформатора .

3. Понимание значения слов с помощью встраивания

Когда у нас есть текст и метки для токенов, нам все равно может понадобиться понять, что означает каждый токен слова. В зависимости от точности, которую вы требуете от своих меток, это может быть информация для выбора между двумя выбранными токенами слова.

Из-за плохого контекста мы не можем полагаться на выдающиеся техники прямого НЛП , и на этот раз нам нужно сделать шаг назад и рассмотреть менее современную технику, но все же очень эффективную: встраивание слов. Идея, лежащая в основе этого, проста: кодирует любое слово в математическое векторное пространство , так что разница двух векторов (обычно косинусное сходство) определяет отношение между ними [11]. Этот метод, например, поможет нам найти синонимы, что полезно, когда мы хотим найти ту же информацию, но представленную под другим именем .

Этот метод, например, поможет нам найти синонимы, что полезно, когда мы хотим найти ту же информацию, но представленную под другим именем .

Чтобы получить такие отношения между словами, нам нужно тренировать их на смысловых предложениях, которые должны соответствовать интересующей нас теме. Однако после завершения обучения мы можем применять встраивание слов, даже если у нас есть только слова, а не предложения. Для выполнения этой задачи существует множество библиотек Python, таких как Spacy или NLTK со словарем WordNet [12] [13].

После этого долгого исследования мы очень горды и счастливы представить нашу первую функцию чтения коммерческих счетов для просмотра запасов. Нам удалось разработать функцию, которая способна определять большинство продуктов и их характеристики из коммерческого счета, чтобы иметь лучшее представление о запасах! Поскольку это тема исследований и разработок, мы будем работать над улучшением этой первой бета-функции. Тестируя новые алгоритмы и архитектуры, мы можем еще больше раскрыть тему синтаксического анализа документов с плохим контекстом!

Если вы являетесь клиентом, заинтересованным в этой новой технологии, свяжитесь с нашей командой разработчиков, чтобы узнать больше об этой функции! И если вы любите технологии, жаждете данных и хотите стать частью этого потрясающего путешествия, подайте заявку в нашу замечательную команду! Мы нанимаем!

#DataEngineer #DataAnalyst

[PDF] Незнающий подход к поверхностному анализу: вклад неконтролируемой индукции части речи

- Идентификатор корпуса: 974670

@inproceed ings{Gugan2011KnowledgePoorAT,

title={Плохой подход к поверхностному анализу: вклад неконтролируемой индукции части речи},

автор = {Мари Гюган и Клод де Лупи},

booktitle={Последние достижения в области обработки естественного языка},

год = {2011}

} В этой статье исследуется вклад полностью неконтролируемой индукции части речи в общую задачу обработки естественного языка и демонстрируется большой потенциал индукции POS для поверхностного синтаксического анализа, который может быть применен к языкам с ограниченными ресурсами.

Посмотреть на ACL

aclanthology.orgПодходы с недостаточным и богатым знанием подходов к извлечению многоязычной терминологии

- B. Daille, Helena Blancafort

- 2013

Res. вычисл. науч.

Извлечение терминологии и закономерности изменения терминов: изучение данных французского и немецкого языков

- Марион Веллер, Хелена Бланкафорт, Анита Годюн, У. Хейд

- 2011

Информатика

Список литературы для оценки инструментов извлечения терминов

- Елизавета Логинова Клуэ, Анита Годжун, Хелена Бланкафор, Мари Геган, Татьяна Горностай, У. Хейд

- 2012

Информатика

TKE

Сокращение семантических признаков при кластеризации текстовых документов с обработкой естественного языка

- И. С. Чуб, А. Сингх

- 2014

Информатика

Автоматическое определение составляющих терминов: сегментация, перевод и вариации. (Обработка сложных терминов: сегментация, перевод и варьирование)

- Елизавета Логинова Клуэ

- 2014

Информатика, философия

Сравнение ронгоронго и последовательности слогов древних песнопений с острова Пасхи

- Фумихико Ямагути

- 2013

Науки об окружающей среде

Рез. вычисл. науч.

Неконтролируемое тегирование частей речи в больших объемах

- Крис Биманн

- 2009

Информатика

Тегирование неконтролируемой части речи, поддерживающее контролируемые методы

- Chris Biemann, C. Giuliano, A. Gliozzo

- 2007

Компьютерные науки

Поверхностный синтаксический анализ только на основе слов: практический пример

- Антал ван ден Бош, С. Бухгольц

- 2002

Информатика

ACL

Два десятилетия неконтролируемой POS-индустрии: как далеко мы продвинулись?

- Христос Христодулопулос, С.

- 2010

Голдуотер, Марк Стидман

Голдуотер, Марк СтидманИнформатика

EMNLP

Неконтролируемая маркировка частей речи с использованием эффективной кластеризации графов

- Крис Биманн

- 2006

Информатика

ACL

О роли лексических признаков в маркировке последовательностей

- Йоав Голдберг, Майкл Эльхадад

- 2009

Информатика, лингвистика

EMNLP

Полностью байесовский подход к неконтролируемой маркировке частей речи

- S. Goldwater, T. Griffiths

- 2007

Информатика

ACL

Надежная многоязычная портативная система фрагментации фраз

- Юэ-Ши Ли, Ю-Чие Ву

- 2007

Информатика

Expert Syst. заявл.

Поверхностный анализ с условными случайными полями

- Fei Sha, Fernando C Pereira Информатика

- 2003

NAACL

Тегирование английского текста вероятностной моделью

- B.